kafka安装使用及解惑

kafka安装及解惑

- 一、搜索安装kafka的文章有的需要安装zookeeper有的需要安装scala,为什么,区别在哪(chitGPT 回答)?

- 二、windows下kafka2.61安装使用(chitGPT 回答)

- 三、kafka二进制版和源码版区分及各自安装下载步骤(chitGPT 回答)

- 四、安装实践

- 五、kafka在正式环境配合项目运行,所需的配置及操作步骤(chitGPT回答)

- 六、多个Java客户端集成Kafka之后,需要在做什么操作使所有项目都能互相访问到消息(chitGPT回答)

- 七、kafka整合Java项目(chat机器人回答)

- 八、Java项目关于Kafka的配置文件(chat机器人回答)

- 九、实践

一、搜索安装kafka的文章有的需要安装zookeeper有的需要安装scala,为什么,区别在哪(chitGPT 回答)?

Kafka 可以通过 ZooKeeper 来实现分布式系统的管理和协调,而 Scala 是 Kafka 的编程语言。因此,安装 ZooKeeper 和安装 Scala 都是为了支持 Kafka 运行的必要组件。

ZooKeeper 是 Apache 的一个开源项目,它提供了一个分布式服务框架,可以用于管理和协调分布式系统。Kafka 通过 ZooKeeper 来实现分布式系统的管理和协调,比如跟踪 broker 的状态,监控 topic 的创建和删除等。因此,如果要在 Kafka 中使用分布式功能,就需要安装和启动 ZooKeeper。

Scala 是一种基于 JVM 的编程语言,Kafka 的代码是使用 Scala 编写的。因此,在编译和运行 Kafka 的时候,需要安装对应版本的 Scala。

需要注意的是,Scala 和 ZooKeeper 都是 Kafka 的依赖项,如果你使用 Kafka 的二进制分发版,它们已经被打包在 Kafka 中了,你不需要单独安装。但是,如果你使用 Kafka 的源码版,你需要自己安装 Scala 和 ZooKeeper,并在编译和运行 Kafka 时指定相关的路径和配置文件。

二、windows下kafka2.61安装使用(chitGPT 回答)

1、下载 Kafka 2.6.1

在 Kafka 的官方网站(https://kafka.apache.org/downloads)上下载 Kafka 2.6.1 的压缩包,选择 Scala 2.13 版本。

2、解压压缩包

将 Kafka 压缩包解压到你希望安装的目录。

3、启动 ZooKeeper

Kafka 依赖于 ZooKeeper,因此需要先启动 ZooKeeper。在 Kafka 的解压目录下,进入 bin/windows 目录,执行以下命令启动 ZooKeeper:

zookeeper-server-start.bat ../../config/zookeeper.properties

4、启动 Kafka

在同一个 bin/windows 目录下,执行以下命令启动 Kafka:

kafka-server-start.bat ../../config/server.properties

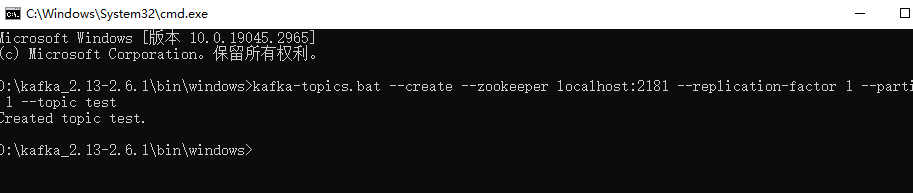

5、创建主题

在 bin/windows 目录下,执行以下命令创建一个名为 test 的主题:

kafka-topics.bat --create --zookeeper localhost:2181 --replication-factor 1 --partitions 1 --topic test

6、发布消息

在 bin/windows 目录下,执行以下命令发布一条消息到 test 主题:

kafka-console-producer.bat --broker-list localhost:9092 --topic test

在命令行中输入消息内容,按回车键发送消息。

7、消费消息

在 bin/windows 目录下,执行以下命令消费 test 主题的消息:

kafka-console-consumer.bat --bootstrap-server localhost:9092 --topic test --from-beginning

你应该可以看到之前发布的消息。

以上就是在 Windows 系统下安装和使用 Kafka 2.6.1 的步骤。

三、kafka二进制版和源码版区分及各自安装下载步骤(chitGPT 回答)

Kafka 的二进制版和源码版主要区别在于安装方式和编译过程。二进制版已经经过编译打包,可以直接使用,而源码版需要进行编译和打包,安装过程较为复杂。

官网下载网址截图:

一、Kafka 二进制版安装下载步骤:

1、下载 Kafka 二进制包

在 Kafka 的官网上下载相应版本的二进制包,下载地址为:https://kafka.apache.org/downloads。

2、解压 Kafka 二进制包

使用命令 tar -xzf kafka_2.13-2.8.0.tgz 解压 Kafka 二进制包。

3、启动 Kafka 服务

进入 Kafka 解压后的目录,使用以下命令启动 Kafka 服务:

bin/kafka-server-start.sh config/server.properties

4、创建主题

使用以下命令创建主题:

bin/kafka-topics.sh --create --topic test --bootstrap-server localhost:9092

5、发送和接收消息

使用以下命令发送和接收消息:

bin/kafka-console-producer.sh --topic test --bootstrap-server localhost:9092

bin/kafka-console-consumer.sh --topic test --from-beginning --bootstrap-server localhost:9092

二、Kafka 源码版安装下载步骤:

1、下载 Kafka 源码包

在 Kafka 的官网上下载相应版本的源码包,下载地址为:https://kafka.apache.org/downloads。

2、解压 Kafka 源码包

使用命令 tar -xzf kafka_2.13-2.8.0-src.tgz 解压 Kafka 源码包。

3、编译 Kafka

进入 Kafka 解压后的目录,使用以下命令编译 Kafka:

./gradlew

4、打包 Kafka

使用以下命令打包 Kafka:

./gradlew jar -PscalaVersion=2.13.5

5、启动 Kafka 服务

进入 Kafka 解压后的目录,使用以下命令启动 Kafka 服务:

bin/kafka-server-start.sh config/server.properties

6、创建主题

使用以下命令创建主题:

bin/kafka-topics.sh --create --topic test --bootstrap-server localhost:9092

7、发送和接收消息

使用以下命令发送和接收消息:

bin/kafka-console-producer.sh --topic test --bootstrap-server localhost:9092

bin/kafka-console-consumer.sh --topic test --from-beginning --bootstrap-server localhost:9092

注意:在源码版的安装过程中,需要先安装 Gradle 和 Scala 环境。

四、安装实践

1、下载kafka_2.13-2.6.1.tgz即二进制版

2、解压到D盘

3、查看此版本的配置文件,路径:D:\kafka_2.13-2.6.1\config

截图:

可以看到关于zookeeper的配置文件,说明此版本已经内置了zookeeper。

4、查看zookeeper配置及修改

原版:

添加log日志打印:

5、到D:\kafka_2.13-2.6.1\bin\windows目录下,在地址栏输入cmd打开控制台,然后输入启动zookeeper命令zookeeper-server-start.bat ../../config/zookeeper.properties

6、在zookeeper启动窗口不关闭的情况下,重新在同一地址栏输入cmd打开新的控制台窗口,输入启动Kafka的命令kafka-server-start.bat ../../config/server.properties

7、在保持以上窗口不关闭的情况下,重新在同一地址栏输入cmd打开新的控制台窗口,输入创建主题的命令kafka-topics.bat --create --zookeeper localhost:2181 --replication-factor 1 --partitions 1 --topic test

8、在保持以上窗口不关闭的情况下,重新在同一地址栏输入cmd打开新的控制台窗口,输入发布消息的命令kafka-console-producer.bat --broker-list localhost:9092 --topic test,然后输入测试消息this is a new topic for test并回车:

9、在保持以上窗口不关闭的情况下,重新在同一地址栏输入cmd打开新的控制台窗口,输入消费消息的命令kafka-console-consumer.bat --bootstrap-server localhost:9092 --topic test --from-beginning并回车:

测试完成。

五、kafka在正式环境配合项目运行,所需的配置及操作步骤(chitGPT回答)

为了在正式环境中使用Kafka,你需要进行以下配置和操作步骤:

1、安装和配置Kafka服务器:首先你需要在你的服务器上安装Kafka,并对其进行配置。你可以参考Kafka官方文档或者其他资源来完成这个步骤。

2、创建Kafka topic:在Kafka中,你需要先创建一个topic来存储消息。你可以使用Kafka自带的命令行工具或者编程语言中的Kafka客户端来创建一个topic。

3、集成Kafka到你的项目中:在你的项目中,你需要使用Kafka客户端来连接到Kafka服务器,并发送和接收消息。你可以使用Kafka提供的Java、Python、Go、.NET等客户端库来完成这个步骤。

4、配置Kafka集群:如果你的项目需要处理大量的消息,你可能需要将Kafka部署在一个集群中。为了实现这个目标,你需要在Kafka服务器上创建多个broker,并将它们组织成一个集群。你可以使用Apache ZooKeeper来进行broker的管理和协调。

5、监控和优化Kafka性能:最后,为了确保Kafka能够在正式环境下稳定运行,你需要实时监控Kafka的性能指标,并进行必要的调整和优化。你可以使用Kafka提供的工具或者第三方监控工具来完成这个步骤。

以上就是在正式环境中使用Kafka所需的配置和操作步骤。

六、多个Java客户端集成Kafka之后,需要在做什么操作使所有项目都能互相访问到消息(chitGPT回答)

要使多个Java客户端集成Kafka之后互相访问到消息,你需要确保以下几点:

1、所有的客户端都使用相同的Kafka集群地址,并且都能够连接到该集群。

2、所有的客户端都使用相同的topic名称,这样它们就可以访问到同一个topic中的消息。

3、如果你的Kafka集群启用了认证和授权机制,那么你需要为每一个客户端配置相应的认证信息,以确保它们能够成功连接到Kafka集群,并获取到相应的权限。

4、最后,在编写客户端代码时,你需要使用相同的序列化/反序列化方式,以确保消息的格式在各个客户端之间是一致的

如果你能够满足以上几点,那么你就可以保证所有的Java客户端都能够互相访问到Kafka集群中的消息了。

七、kafka整合Java项目(chat机器人回答)

chitGPT使用次数用完了,然后借助chat机器人来。

问:kafka整合Java项目 答:chat机器人回答

将 Kafka 整合到 Java 项目中,需要进行以下步骤:

(1).添加 Maven 依赖

在 pom.xml 文件中添加 Kafka 相关的依赖,例如:

<dependency>

<groupId>org.apache.kafka</groupId>

<artifactId>kafka-clients</artifactId>

<version>2.8.0</version>

</dependency>

(2).创建 Kafka Producer

使用 Kafka Producer 将消息发送到 Kafka 集群。例如,创建一个 KafkaProducer 实例,并发送一条消息:

Properties props = new Properties();

props.put("bootstrap.servers", "localhost:9092");

props.put("key.serializer", "org.apache.kafka.common.serialization.StringSerializer");

props.put("value.serializer", "org.apache.kafka.common.serialization.StringSerializer");

Producer<String, String> producer = new KafkaProducer<>(props);

producer.send(new ProducerRecord<>("my-topic", "my-key", "my-value"));

producer.close();

(3).创建 Kafka Consumer

使用 Kafka Consumer 消费 Kafka 集群中的消息。例如,创建一个 KafkaConsumer 实例,并订阅一个 topic:

Properties props = new Properties();

props.put("bootstrap.servers", "localhost:9092");

props.put("group.id", "my-group-id");

props.put("key.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");

props.put("value.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");

Consumer<String, String> consumer = new KafkaConsumer<>(props);

consumer.subscribe(Collections.singletonList("my-topic"));

while (true) {

ConsumerRecords<String, String> records = consumer.poll(Duration.ofMillis(100));

for (ConsumerRecord<String, String> record : records) {

System.out.printf("offset = %d, key = %s, value = %s%n", record.offset(), record.key(), record.value());

}

}

以上就是将 Kafka 整合到 Java 项目中的基本步骤,当然还有很多高级用法需要学习和掌握。

八、Java项目关于Kafka的配置文件(chat机器人回答)

在 Java 项目中使用 Kafka,需要在配置文件中指定 Kafka 的相关参数。下面是一个典型的 Kafka 配置文件示例:

# Kafka 服务器地址

bootstrap.servers=localhost:9092

# 消费者组 ID,同一组内的消费者共享消息

group.id=my-group

# 序列化器和反序列化器,用于将消息转换为字节数组或字符串

key.serializer=org.apache.kafka.common.serialization.StringSerializer

value.serializer=org.apache.kafka.common.serialization.StringSerializer

key.deserializer=org.apache.kafka.common.serialization.StringDeserializer

value.deserializer=org.apache.kafka.common.serialization.StringDeserializer

# 自动提交偏移量的时间间隔,单位是毫秒

auto.commit.interval.ms=1000

# 是否启用自动提交偏移量

enable.auto.commit=true

解释如下:

bootstrap.servers:Kafka 服务器地址,可以指定多个地址,用逗号分隔。

group.id:消费者组 ID,同一组内的消费者共享消息。

key.serializer 和 value.serializer:生产者使用的序列化器,将消息转换为字节数组。

key.deserializer 和 value.deserializer:消费者使用的反序列化器,将字节数组转换为消息。

auto.commit.interval.ms:自动提交偏移量的时间间隔,单位是毫秒。

enable.auto.commit:是否启用自动提交偏移量。

除了上述常用配置项外,还有很多其他的配置项,例如消息压缩、消息重试、分区分配等。需要根据具体业务需求进行配置。

在 Java 项目中,可以通过在代码中读取配置文件的方式来加载 Kafka 配置参数。例如:

Properties props = new Properties();

try (InputStream input = getClass().getResourceAsStream("/kafka.properties")) {

props.load(input);

} catch (IOException e) {

e.printStackTrace();

}

KafkaProducer<String, String> producer = new KafkaProducer<>(props);

以上代码使用 InputStream 读取类路径下的 kafka.properties 文件,并将其作为 Kafka Producer 的配置参数。

九、实践

1、项目场景:两个项目本身都使用springboot框架,配置文件都采用了yml格式,双方配置相同配置如下:

kafka:

#kafka集群ip

bootstrap-servers: localhost:9092

#生产者

producer:

#同步失败生产者没有收到ack后的重试次数

retries: 3

#客户端缓冲区大小

buffer-memory: 32MB

#向服务端一次发送的消息量

batch-size: 16KB

#ack

acks: 1

#消息key和消息value的序列化方式

key-serializer: org.apache.kafka.common.serialization.StringSerializer

value-serializer: org.apache.kafka.common.serialization.StringSerializer

#消费者

consumer:

#消费组

group-id: default-group

#偏移量offset自动提交

enable-auto-commit: true

#当一个消费者启动后默认从哪个位置开始消费

auto-offset-reset: earliest

#一次最多拉取多少条消息

max-poll-records: 500

#反序列化方式

key-deserializer: org.apache.kafka.common.serialization.StringDeserializer

value-deserializer: org.apache.kafka.common.serialization.StringDeserializer

listener:

missing-topics-fatal: false

2、生产者:

@Component

public class KafkaProducer {

@Resource

private KafkaTemplate<String, Object> kafkaTemplate;

public void sendData(String key,String value) {

//把消息放入对列中

kafkaTemplate.send("topic1forTest", key,value);

}

}

3、消费者:

@Slf4j

@Component

public class KafkaConsumer {

@KafkaListener(topics = "topic1forTest")

public void queueLight(ConsumerRecord<String,String> record){

try {

String key=record.key();

log.info("=======",key)

} catch (Exception e) {

e.printStackTrace();

}

}

}

4、到D:\kafka_2.13-2.6.1\bin\windows目录下,在地址栏输入cmd打开控制台,然后启动zookeeper,命令zookeeper-server-start.bat ../../config/zookeeper.properties

5、在zookeeper启动窗口不关闭的情况下,重新在同一地址栏输入cmd打开新的控制台窗口,启动Kafka,命令kafka-server-start.bat ../../config/server.properties

6、生产者调用问题

生产者在实际应用中不太可能在启动类中,使用时一般与其它工具类相似,例如监听redis时调用kafka生产者

import org.springframework.data.redis.connection.Message;

import org.springframework.data.redis.core.RedisTemplate;

import org.springframework.data.redis.listener.adapter.KeyExpirationEventMessageListener;

import org.springframework.stereotype.Component;

@Component

public class RedisKeyExpirationListener extends KeyExpirationEventMessageListener {

//KeyExpirationEventMessageListener 是 Redis 的一个 Key Space Notification 监听器接口,用于监听 Redis 中键的过期

//事件。当 Redis 中的一个键过期时,这个监听器可以捕获到事件并执行一些预先定义好的操作。通常情况下,这个监听器用于清理过期的

//缓存数据或者执行一些其他的定时任务。这个接口可以被实现为一个 Spring Bean 来使用。

private RedisTemplate redisTemplate;

@Autowired

KafkaProducer kafkaProducer;

public RedisKeyExpirationListener(RedisTemplate redisTemplate) {

super(redisTemplate);

}

@Override

public void onMessage(Message message, byte[] pattern) {

// 过期的key

String expiredKey = message.toString();

//得到过期的key,实现约定此时key过期需要进行什么操作,比如记录数据:insert,1等标识,删除数据:del,2等标识

//确保处理方式一一对应无歧义

kafkaProducer.sendData(expiredKey,'del');

}

}