Similarity Preserving Adversarial Graph Contrastive Learning-相似性保持对抗图对比学习-图神经网络精读论文(1)

Similarity Preserving Adversarial Graph Contrastive Learning-论文框架

相似性保持对抗图对比学习-题目

看不懂,啥意思-》下一步,看看摘要。

Introduction

第一段大体含义逻辑:

首先介绍图出现在了各种领域,人们也对图神经网络开启广泛研究,但是标签难搞,都是大规模的数据,很昂贵,因此无监督的图表示学习受到了广泛关注。------>引入了图对比学习框架,然后介绍什么是图对比学习框架。

第二段大体含义逻辑:

尽管取得了不错的成果,但是,最近的研究表明,图神经网络容易受到对抗性攻击

(又不懂了,什么是对抗性攻击?)这里提到一个新名词,对抗性攻击!不懂,所以需要介绍。

介绍了图的对抗性攻击的的内容。

In other words!

当作转折点来介绍!也就是图结构(例如,添加/删除一些边)和节点特征发生轻微变化,GNN 模型也会失去其预测能力。也就是强调了 对抗性攻击的重要性!

转折介绍现有模型的做法

介绍了现有模型的主要集中在增强GNN模型的鲁棒性,To this end,为此引入了新颖的GNN架构或来学习图结构。

转折介绍即使有一些效果,但是。。。

尽管有一定的效果,它们大多依赖于节点和图的标签信息(即,有监督的设置),因此在没有标签信息(即,无监督设置)的情况下并不适用。

(说白了,还是说:你要用对比学习才好!其实上面就是为了引入对比学习)

强调真实世界中的数据大部分都是没有标签的,也是为了衬托对比学习!!

衬托了对比学习之后,又说了对比学习中存在的问题

有人强调图的无监督方法也容易受到对抗性攻击 ,并且一些方法通过对 GCL 框架采用对抗性训练(AT)来解决无监督 GNN 的鲁棒性问题.你要说明他们是怎么做的,这么做的结果是什么

说明他们的方法的做法

通过将对抗性观点视为 GCL 框架下的增强,他们实现了针对对抗性攻击的对抗性鲁棒性。

他们的方法不错,然后,怎么怎么样什么弊端提出来,然后再去提出来自己的模型

然而,怎么则呢,虽然用了对抗性,大致意思就是:对抗攻击太过分了,让本来相似的根本不相似了,那就没啥意义了

因为,官方的解释听不懂,又用了另一种说法说了一遍,更容易理解了。

换了种说法,并且解释了为什么会导致这种结果。(现象+结果+原因)

介绍了保留节点特征的重要性。对于这种原因。因此,我们提出了什么什么,开始引出我们的模型

More precisely,更准确的说SP-AGCL 将(原始)干净图与不同属性的两个辅助视图(即节点相似性保留视图和对抗视图)进行对比。

介绍了进行节点相似性保留的意义。

此外,为了保留节点信息,还干了什么。所以整体是有逻辑的要连贯起来。

最后对自己的贡献进行了总结。

2Related Works

2.1Graph Contrastive Learning

首先介绍了对比学习。

介绍了最近一些人的研究,提出了将两种不同增强视图相互对比的方法,其中不同视图是通过对边和节点特征的各种增强生成的。

然后提出了In this Papaer的工作。

2.2Adversarial Attacks on Graph

首先引入,图的深度模型容易受到对抗性攻击,然后介绍了几个例子。

然而,上面的那些例子是有监督模型,不适合无监督

最近,CLGA [35]引入了一种无监督图结构攻击方法,该方法根据 GCL 目标的最大梯度翻转边缘。

最后,介绍我们的工作,我们专注于开发一个基于 AT 的 GCL 框架,其中此类对抗性攻击图被用作增强以获得对抗性鲁棒性。

2.3Adversarial Defense on Graph

通过对抗攻击引入对抗防御,然后介绍了对抗防御研究,一个相关例子,但是这个例子只适用于有监督信号的。

然后引入了在无监督学习中,也就是对比学习中!这样的操作可能不会提供有用的监督。

然而,介绍了AT引入到无监督中

介绍了虽然有一些引入了到了无监督学习,但是还是不能保留节点的相似性。

3PRELIMINARY-准备工作

Notations

Graph Contrastive Learning.

介绍了对比学习,图上的对比学习怎么进行的。

4 ANALYSIS ON ADVERSARIAL GCL

4.1Applying AT on GCL models

从多角度进行理论分析和实证研究。

Adversarial Attack on GCL:对 GCL 的对抗性攻击

简单而言就是,公式二。

Training Adversarially Robust GCL.Training Adversarially Robust GCL.

简单来说就是对比损失。

4.2Characteristic of Adversarial Attacks on GCL:GCL对抗性攻击的特点

攻击导致GCL模型性能下降,无论是在有无监督情况下。

Analyses on effective graph attacks.

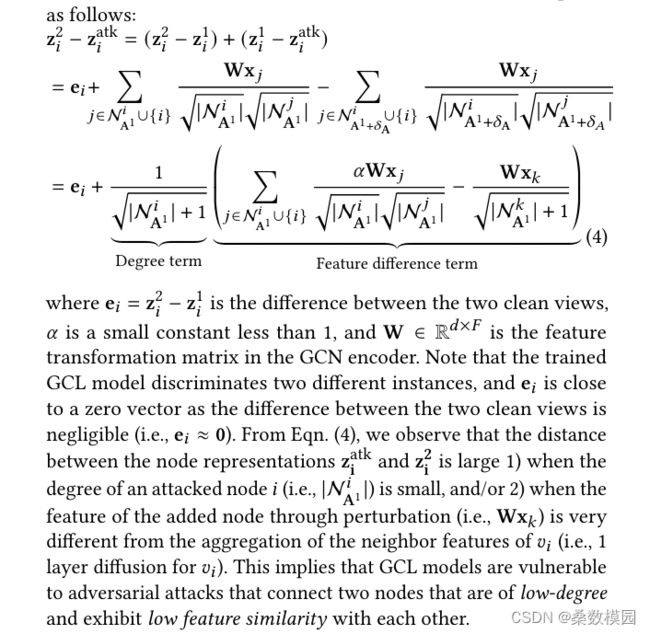

在这里介绍了 GCL 模型很容易受到连接两个低度节点且彼此表现出低特征相似性的对抗性攻击。请注意自己分析一下公式,为什么会受到攻击。

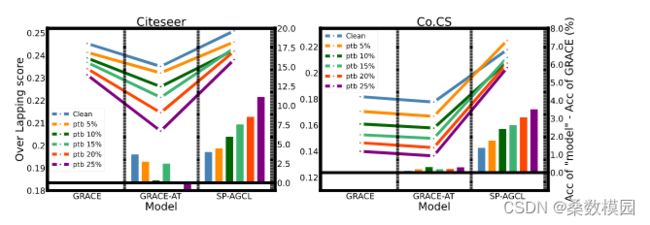

采用小实验,验证这种扰动是否确实能够有效地攻击 GCL 模型。

4.3Limitation of Existing Adversarial GCL

现有的局限性!

通过构建k邻近来对比clean图和对抗图的相似度,看看是否还保留相似性。

通过分析结果表示,我们对最近的几个对抗性 GCL 模型进行了实证研究,以研究 AT 是否确实无法保留节点特征相似性。

因此,我们提出了我们的框架,SP-AGCL。

5 PROPOSED METHOD: SP-AGCL

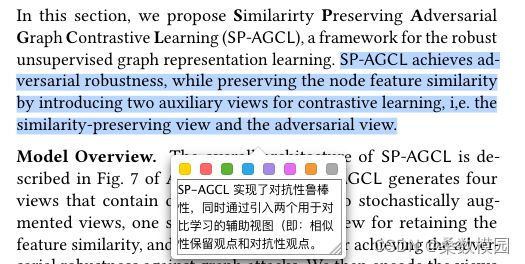

在本节中,我们提出了什么SPAGCL,并且这个模型怎么怎么样。

这个是模型的框架。two stochastically augmented views, one similarity preserving view for retaining the feature similarity, and one adversarial view for achieving the adversarial robustness against graph attacks.

5.1 View Generation

给定一个图(A,X),我们首先生成两个随机增强视图(A1,X1)和(A2,X2),这两个视图都是通过随机丢弃边和节点特征来处理的,如[38]中所示。然后,我们构造辅助视图,即相似性保留视图和对抗性视图。

5.1.1 Similarity-preserving view.相似视图

首先介绍了相似性保留,然后介绍了我们的方法,说一下其他的弊端,最后。。

5.1.2 Adversarial view.对抗视图

Structural Perturbations.

请注意,要添加和删除的边数在扰动预算之内。

Adversarial Feature Mask.

直接掩码操作行为可能会让干净视图和对抗视图差距太远。。这种行为可能会使干净视图和对抗视图彼此距离太远,从而对 AT 产生不利影响。

通过屏蔽在对比学习中起重要作用的节点特征,并将其用作GCL框架中的另一个视图,我们期望学习对屏蔽特征不变的节点表示,这鼓励GCL模型充分利用节点特征信息。设置重要性梯度

Adversarial View Generation.

说明了实现了对抗扰动

5.2 Cross-view Training for Robust GCL

基于从不同视图获得的表示,我们使用跨视图对比目标来训练 SP-AGCL。

其中 λ1 和 λ2 是超参数。第一项训练 GCL 模型,第二项将干净视图与对抗性视图进行对比,最后一项将干净视图与相似性进行对比,用 Z2 替换 L (Z1, Zadv) 和 L (Z1, ZkNN(X) ) 中的 Z1 不会对模型性能产生显着差异。