【论文翻译】ADVIO: An Authentic Dataset for Visual-Inertial Odometry

ADVIO: An Authentic Dataset for Visual-Inertial Odometry

该数据集的特点:使用iPhone手机采集、真实复杂场景、对比现有商用和学术研究VIO系统性能

【摘要】对于行人场景的VIO的研究,由于缺少真实和公开的基准数据集,很难准确比较各公开算法的不同点。已有的数据集缺少六自由度的真值,或由于选用光学跟踪系统构建真值,因此受限于很小的空间。我们利用的纯惯性导航的优势,针对VIO开发了一套多用途、有挑战性的计算机视觉基准数据集。为了实现这个目标,我们建造了一个包括iPhone、Google Pixel、Android phone、 Google Tango等硬件的试验平台。提供范围广泛的传感器原始数据,几乎可以在任何智能手机上得到,并且具有高质量的跟踪真值(ground-truth)。我们还对Google Tango、ARCore、 Apple ARKit,以及两个最近发布的学术方法进行了视觉-惯导跟踪结果对比。数据集包括室内室外场景,包括楼梯、手扶梯、升降梯、办公环境、商场和地铁站。

【关键词】VIO、导航、基准数据集

数据集下载链接:https://github.com/AaltoVision/ADVIO

1、引言

最近出现了各种系统和方法来跟踪基于摄像机和惯性测量单元(IMUS)的手持或可穿戴移动设备的运动。同时存在开源的方法和非公开的专用系统(Google的ARCore,Apple的ARKit在各自制造商的旗舰智能手机型号上运行)。移动设备的其他例子包括谷歌Tango平板设备和微软HoloLens增强现实眼镜。开发智能移动设备的里程计算法的主要动机是支持需要精确实时跟踪自我运动的增强现实应用。这些应用在很多领域具有重要的价值,比如建筑和设计,游戏和娱乐,远程呈现,教育和培训。

虽然VIO有着重要的学术和商业价值,该领域的发展受限于缺少公开的数据集和基准,并用来对提出的算法进行公平的比较,推动现有最好系统的不断提升和进一步发展。例如,由于每个系统的性能取决于所使用的算法和传感器,很难公平地比较方法的进步和算法的贡献,因为来自硬件和软件的因素可能是混合的。此外,由于许多现有的数据集要么是在较小的空间中捕获的,要么是利用了比低成本消费设备更好的传感器硬件,很难评估现有的方法在手机端上能否实现中远距测距或大尺度SLAM。

此外,使用智能手机传感器采集的真实感传感器数据,再加上足够精确的真值,将有助于加快学术研究的进展,并降低新研究人员进入该领域的门槛。许多计算机视觉问题清楚地证明了公共数据集和基准作为推动快速发展的动力的重要性,如图像分类[9,19],目标检测[13],立体重建[10]和语义分割[13,6]等等。然而,对于视觉惯性里程计(VIO),没有公开可用的数据集或基准,可以在典型的智能手机环境中评估最近的方法。此外,由于开源软件文化在这一研究领域并不像在图像分类和目标检测方面那样普遍,因此研究环境对于促进快速发展并不是最理想的。此外,由于上述原因,这一领域有一种危险,即只有大公司资助的大型研究小组才能进入这一领域,这将减缓进展,使开放的学术研究走向衰败。

在这项工作中,我们提出了一个数据集,旨在促进智能手机或其他带有低成本传感器(卷帘相机、MEMS惯性器件)的移动终端上的VIO和SLAM方法的发展。我们的传感器数据通过iPhone 6s手机采集,包括真值位姿轨迹和从传感器采集的原始数据流(RGB视频相机、加速度计、陀螺仪、磁力计、平台提供的地理坐标、气压计)。总共采集了4.5Km的序列,包括在室内室外各种环境下的手持运动。数据集是在公共场所收集的,符合当地关于拍摄和出版的法律规定。真值的计算方法是将最近的纯惯性导航系统(INS)[24]与基于精密地面平面图的频繁手动定位相结合,验证了地面真实值的质量,并对其精度进行了估计。除了基准数据集外,我们还对视觉惯性进行了比较。

除了基准数据集,我们比较了VIO算法,包括三个最近的专有平台:ARCore on a Google Pixel device, Apple ARKit on the iPhone, and Tango odometry on a Google Tango tablet device,以及两个最近发布的VIO算法:ROVIO和PIVO。比较数据由捕获设备上的三个设备采集,图1进行了介绍说明。数据采集的常用应用也应用到每个设备中。

我们工作的主要贡献概述如下:

(1)一个带有6自由度的iphone传感器数据的公开数据集,可为现实生活应用场景中的单目VIO提供基准,这些场景包括各种环境中的运动,还包括楼梯、电梯和自动扶梯;

(2)比较最新的VIO平台和算法;

(3)提出一种在真实使用场景中,将纯惯性导航与手动定位相结合的智能手机里程计的真值采集方法;

2、相关工作

尽管视觉惯性里程计(VIO)是对手持设备和可穿戴设备进行实时跟踪的最有希望的方法之一,但目前还缺乏用于对不同方法进行基准测试的良好的公共数据集。相关基准应该包括带有同步时间戳的视频和惯性传感器记录,最好是用消费类智能手机传感器捕获。此外,数据集应该是真实的,并说明实际的应用场景。也就是说,它应该包含具有稀有视觉特征的具有挑战性的环境,无论是室内还是室外,以及各种不同的运动,还包括快速旋转而不进行平移,因为它们对于单目视觉测量来说是有问题的。我们的工作是第一个解决这一需求的。

关于纯视觉测径或SLAM,有几个数据集和基准可用[23,6,8,26],但它们缺少惯性传感器数据。此外,其中许多数据集是有限的,因为它们:

(1)使用地面车辆记录,因此没有快速旋转[23,6];

(2)不包含低纹理室内场景[23,6];

(3)用定制硬件(如鱼眼镜头或全球快门照相机)拍摄[8];

(4)缺乏充分的6自由度真值[8];

(5)限制在较小的环境,因此是SLAM系统的理想场景,但不适用于中远距离导航基准里程计[26]。

然而,除了纯视觉数据集外,还有一些含有惯性传感器数据的公共数据集,例如[10、5、4、3、18]。大部分这些数据集都是用传感器严格地连接到轮式地面车辆上记录的。例如,广泛使用的Kitti数据集[10]包含从一辆移动汽车上激光雷达扫描和多个摄像机录制的视频。真值使用一个非常精确的GPS/IMU定位单元与RTK校正信号。但是IMU采集频率只有10Hz,这对于剧烈运动的手持设备来说是不够的。进一步讲,即便高频率的IMU数据可用,KITTI数据集也受到上面提到的(1)(2)(3)限制,使得它对于智能手机里程计来说是没有用的。

与KITTI的另一个相似之处是,我们也使用带有外部定位的纯惯性导航来确定地面真值。在我们的例子中,由于GPS在室内是不准确或不可用的,所以GPS校正将被手动定位校正所取代。此外,与Kitti相反,通过利用最近惯性导航[24]的进展,我们能够使用iphone的惯性传感器进行真值计算,因此不依赖高级别的IMU,过去这对于手持式的设备来说很难达到。在我们的情况下,手动定位修复是从参考视频确定的(图3a),通过查看视频进行视觉识别地标,从精确的建筑平面图或航空图像中准确地定位地标。不使用光学方法建立真值的好处是,我们可以很容易地记录长序列,并且记录设备的相机可以收到暂时的遮挡。这使得我们的基准也适用于评估VIO方法的遮挡鲁棒性[25]。和KITTI一样,Rawseeds[5]和NCLT[4]数据集也是用轮式地面车辆记录的。它们都使用自定义传感器(例如全向摄像机或工业级IMU)。这些数据集用于评估缓慢移动车辆的测向和自我定位,而不适合于手持设备和增强现实的VIO方法的基准测试。

与我们最相关的数据集是Euroc[3]和PennCOSYVIO[18]。Euroc提供用全域快门立体相机和战术级IMU在微型飞行器(MAV)上捕获的视觉和惯性数据[17]。这些序列记录在两个不同的房间,其中配备了运动捕捉系统或激光跟踪器,以获得准确的运动真值。在 PennCOSYVIO中,数据采集是使用一个手持平台进行的,它包含两个Google Tango平板电脑、三个Gopro 4摄像头和一个类似于Euroc的视觉惯性传感器单元。这些数据是通过在大学校园几次步行150米的路径收集到的,真值是通过光学标记获取的。由于需要光学定位来确定真值,Euroc和 PennCOSYVIO都只包含少数几个相对小规模的环境的数据。此外,这两个数据集都使用相同的高质量定制传感器和宽视场立体相机[17]。相反,我们的数据集包含大约4.5公里的序列,这些序列是在几个不同的建筑和不同的室外环境中,用普通智能手机传感器记录的。此外,我们的数据集包含楼梯、电梯和自动扶梯的运动,如图2所示,还包括临时遮挡和缺乏视觉特征。我们不知道有任何类似的公共数据集。表1总结了不同数据集的性质。我们灵活的数据收集过程的有利因素是利用纯惯性导航的最新进展和人工定位修正[24]。事实上,确定真值的方法是我们工作的贡献之一。此外,作为第三个贡献,基于我们的挑战性数据集,比较了最近的VIO方法和专用的最先进的平台。

3、数据采集

数据是用三个设备(iPhone6s,Pixel,Tango)严格地连接到一个铝架上记录的(图1)。此外,我们使用一个额外的相机视频拍摄记录人并记录下采集过程(图3)。

对于2D地图(即结构平面图或航空图像/地图),手动定位是从外部摄像机的角度确定的。由于设备是手持的,在大多数固定位置,高度是以高于地面水平的恒定距离(具有合理的不确定性估计)给出的,这样优化后的轨迹才能最佳地平衡固定位置和IMU信号的信息(第4节详细介绍)。

使用网络提供的时间同步来自所有四个设备的数据流。也就是说,在捕获会话开始时,设备时钟通过网络时间协议(NTP)请求进行同步。在记录过程中,所有设备都连接到4G网络上,并且为了能够在同一坐标系下对数据进行分析,我们通过捕获棋盘的多个视图来校准所有相机的内外参数。这是在每次步骤之前进行的,以解释运输和储存过程中的微小运动。记录的数据流列于表2中。

3.1 Raw iPhone Sensor Capture

基于Swift 4开发了一个iOS数据采集应用程序,它保存了与苹果Arkit姿态估计同步的惯性和视觉数据。所有单个数据点都在内部加盖时间戳,然后同步到全局时间。全局时间是使用Kronos Swift NTP client获取的。这些数据是用运行iOS 11.0.3的iPhone6S采集的。同样的软件和相同的iPhone被用来收集参考视频。之所以选择这款手机,是因为iphone 6s(2015年发布)在硬件上更接近于普通智能手机,而不是最新的旗舰iPhone,而且与谷歌像素硬件也很匹配。

在捕捉过程中,相机由ARKit服务控制,它执行通常的自动曝光和白平衡,但焦距保持固定(ARkit返回的相机矩阵存储在捕获过程中)。分辨率也由ARKIT控制,为1280*720。帧被打包成一个H.264/MPEG-4视频文件。全球导航卫星系统/网络定位数据是通过协同定位方案收集的,请求的位置精度为“kCLLocationAccuracyBest”。定位服务提供纬度和经度、水平精度、高度、垂直精度和速度。加速度计、陀螺仪、磁强计和气压计数据通过CoeMotion API收集,并以最大速率记录。表2给出了多个数据流的近似捕获率。磁强计值没有校准,气压计采样值既包含气压,又包含相关的相对高度读数。

3.2 Apple ARKit Data

捕获原始数据的应用程序运行ARKit框架。它提供了与每个视频帧相关联的姿态估计。将姿态保存为平移向量和以欧拉角表示的旋转。每个姿态相对于手机创建的全局坐标帧。

3.3 Google ARCore Data

我们根据谷歌的ARCore示例编写了一个应用程序,用于捕获ARCore跟踪结果。与ARKit一样,姿态数据包含到捕获的第一帧的转换和到全局坐标框架的旋转。与ARKIT不同的是,方向被存储为单位四元数。注意捕获速率比ARKit慢。我们不保存视频帧或传感器数据在Pixel上。数据采集使用Google Pixel device 运行ndroid 8.0.0,并使用Tango Core AR developer preview得到。

3.4 Google Tango Data

基于Paraview Project,[11]开发和发布了一个数据采集APP,在此基础上进行了修改以收集相关数据。捕获数据包括设备相对于第一帧的位置、全局坐标中的方位、鱼眼灰度图像和深度传感器产生的点云。Tango service 运行在基于Android 4.4.2 and 使用 Tango Core Argentine的Project Tango tablet 上。 Tango service输出两组位姿,Raw odometry(不带回环) 和 Area learning(带回环)。 Raw odometry是在没有长期内存的情况下建立帧的,而 Area learning使用正在进行的地图构建来封闭回环和减少漂移。这两个轨迹都被捕获和保存。

3.5 Reference Video and Locations

本文的一个重要贡献是灵活的数据采集框架,它使我们能够在大型环境中捕获实际的场景。在这种情况下,使用视觉标记、运动捕捉或激光扫描器获取真值是不可行的。相反,我们的工作利用了纯惯性导航和手动定位修复,如4.1节所述。为了获得定位修复,我们记录了一个额外的参考视频,这是由一个辅助人员在离实际采集人很短的距离处采集得到的。图3a举例说明了这类视频的一个示例框架,参考视频使我们能够确定数据收集设备相对于环境的位置,并获得纯惯性导航方法的手动定位固定装置(受测量噪声影响)[24]。

在实践中,使用为本文开发的位置标记工具作为后处理步骤,可以浏览视频,并在相应的平面图图像上标记手动位置修复。在容易确定相对于平面图图像的设备位置的场合(例如,在自动扶梯的开始和结束、进入和退出电梯、通过门或走过建筑物的拐角处),插入位置校正(location fixes)。在我们所有的记录数据中,很容易找到足够的这样的实例来建立一个准确的真值。请注意,它足够手动确定设备的位置,而不是定位。

初始位置的确定必须从平面图的像素坐标进一步转换为公制的世界坐标,这首先是通过使用人工测量的参考距离(例如柱子之间的距离)将像素转换成米来完成的。然后,使用手动确定的地标点(例如柱子或楼梯)和地面高度测量来相互注册平面图图像。

4 方法

4.1 Ground-Truth

真值是在[24 ]中提出的纯惯性里程计算法的一种实现,其中使用外部参考视频记录了人工固定点(见3.5节)。用于获取真值的纯惯性导航系统中使用的IMU数据来自iphone,并且该部分数据共享为数据集的一部分。此外,还为iPhone IMU获取了额外的校准数据,包括加性陀螺仪偏差、加性加速度计偏差和乘性加速度计比例尺偏差。

iPhone姿态轨迹(位置和方向)的推断如[24]所述,增加了状态估计、附加校准数据和手动定点的融合。姿态轨迹对应的INS估计值与固定校正点和外部校准有关。

考虑到固定点位置的不确定性和不精确性,不强制要求手机的跟踪与这些固定点完全匹配,而是在固定位置点包括一个高斯测量噪声项,其标准偏差为25厘米(在所有方向)。这允许估计轨迹与固定点不同。在楼层间上下时,位置固定点被给定为未知高度的三维位置或2D点。

推理问题最终用扩展卡尔曼滤波器(前通)和扩展的Ruch-Ton-Striebel平滑器(后传,见[24]中的技术细节)解决。由于这里不需要实时计算,我们也可以使用批处理优化,但这不会导致结果发生明显的变化。手工逐帧检查计算出的轨迹,并通过额外的固定点对姿态轨迹进行改进,直到轨道与所有三个摄像机和平面图图像中所看到的运动相匹配为止。图2c显示了估计的估计的真值轨迹的例子。垂直线是在乘坐电梯(停在每一层)。如果放大,可以看到人行走的周期性运动,从补充材料中的示例视频中也可以查看所获得的精度。

4.2 Evaluation Metrics 评估方法

对于在采集数据的过程中动态采集到的里程计结果,我们提出了以下评价方法:所有数据首先临时对齐同一个全局时钟(由NTP请求在捕获数据时获取),使得时间对齐精确到1-2秒。通过最大限度地减小装置偏航和横滚角之间的中位误差来确定一个恒定的时间偏移,从而进一步改进了时间对准。这种对齐兼顾了设备间的时间配准误差和测向方法中的内部延迟。

在时间对齐之后,三个设备提供的轨迹被切成相同的长度,覆盖相同的时间跨度,因为不同设备的录音的启动和停止时间可能有几秒的差异。垂直方向已经与重力对齐。考虑到设备、估计位姿和真值之间的相对姿态,我们估计了估计轨迹和地面之间的平面刚性变换(2d旋转和平移)-基于每种方法中估计值的前60s的真值(使用整个路径对结果没有明显的影响)。不使用校准的相对姿态的原因是,特别是ARCore(ARKit偶尔)在轨道的开始处显示了剧烈跳变,这将对该方法产生相当大的影响并破坏了这些数据集。

所有对齐轨迹都从原点开始,我们测量每一种方法给出的估计输出与真值的绝对误差,并将绝对位置误差的经验累积分布函数定义为:

其中,1e是事件e的指示函数,e是相对于真值的绝对位置误差的向量,n是位置的个数。

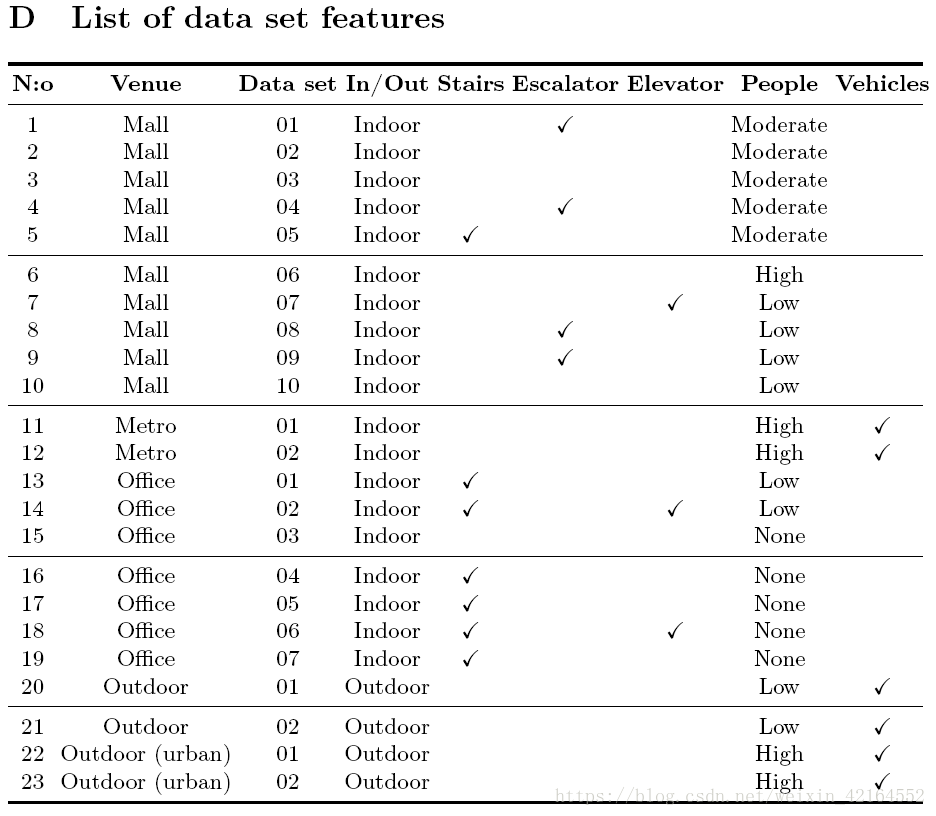

5 Data and Results 数据和结果

该数据集包含在6个不同位置拍摄的23个单独的序列,所有序列的总长度为4.47公里,总持续时间为1小时8分钟。有19个室内和4个室外序列。在室内序列中,平均每3.7米(或3.8秒)有一个手动固定点,而在每14.7米(或10秒)室外有一个手动固定点。所有序列的三维轨迹真值在补充材料中得到了说明,并给出了更多的细节。此外,补充视频还说明了其中一个序列及其真值,并简要介绍了数据集序列和环境的主要特征。

我们的数据集主要是针对中、长程里程计设计。最明显的用例是在大空间内的室内导航,但我们也包含了户外路径以保证完整性。在一个7层高的购物中心(135,000平方米)、一个地铁站和两个不同的办公大楼中获得了室内序列。购物中心和车站位于同一建筑综合体中。地铁和公交车站位于底层,采集到的视频中有大量的移动人员和偶尔可以看到的大型车辆,这对于纯视觉里程计具有挑战性。此外,商场较低的楼层包含大量的移动人员。图2显示了购物中心的总体视图,以及地面真相路径示例和Tango点云(图2B)。图4b展示了商场和车站的实例框架。用例尽可能逼真,包括楼梯、电梯和自动扶梯上的动作,以及暂时遮挡和缺乏视觉特征的区域。购物中心有10个序列,车站有两个序列。

在大厅和两栋办公楼的走廊里进行了数据采集。它们包含了一些静止的人和几个移动的人。顺序包括楼梯攀登和乘坐电梯。有封闭和开放的(玻璃)电梯序列,示例框架如图4a所示。

室外序列记录在市中心(城市,两个序列)和大学校园(郊区,两个序列)。图4c和4d显示了两个地点的示例帧。城市户外数据采集是城市街区进行的,它们包括开放的空间、人和车辆。郊区的户外数据采集是在人口稀少的地区进行的。序列中有少数人步行和一些车辆。大部分空间是开放的。室外序列的平均长度为334.6米,从133米到514米不等。室外序列是在一天中不同的时间获得的,说明了几种日光条件。

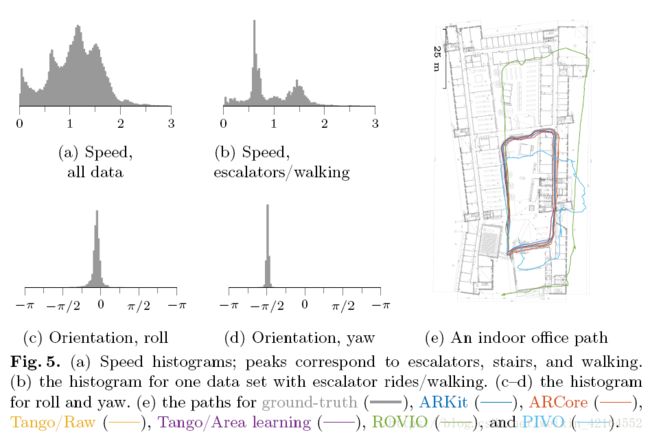

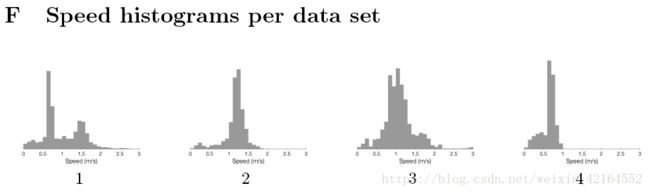

图5a显示从地面提取的不同运动度量的直方图。图5a显示速度直方图,它有三个峰值,反映三个主要的运动模式。

从慢到快,它们是自动扶梯、楼梯和步行。图5b显示了仅包含自动扶梯和正常步行的一个序列的速度直方图。定位直方图显示,手机通常保持在与载体相同的位置(纵向方向,略微向下)。俯仰角反映了航向的均匀分布。

5.1 Benchmark Results

我们使用原始的iPhone数据对两个研究级别的VIO系统进行评估,并在各自设备上运行的三种专有解决方案(Pixel上的ARcore、iPhone上的ARKit和平板电脑上的Tango)。所使用的研究系统是ROVIO[2,1,20]和PIVO[25]。ROVIO是一种相当新的方法,它已经被证明在高质量的IMU和大视场相机数据上能很好地工作。Pivo是最近的一种方法,与使用智能手机数据的Google探戈[25]相比,它显示出了有希望的结果。对于这两种方法,都使用了原始作者的实现(ROVIO作为maplab 7的一部分)(在仅限里程计模式下,没有地图构建或循环闭包)。我们使用了精确的摄像机参数和从摄像机到imu的刚性变换,并对过程和测量噪声尺度参数进行了预估计。

为了测试目的,我们还对原始数据(dso[7]和orb-slam 2[15])进行了两种仅用视觉测量的方法,这两种方法都能够跟踪路径的子集,但小视场、旋转的快速运动和具有挑战性的环境使它们在所有路径上都无法成功。

一般来说,专有系统比研究方法工作得更好,如图7所示。在室内序列中,所有专有系统一般都工作得很好(如图7a所示)。Tango有最好的性能,ARKit表现良好和强劲,只有少数明确的失败案例(95th percentile _10 meters),而Arcore偶尔失败,显然由于不正确的视觉回环检测。包括室外序列稍微改变了度量(图7b)。ARKit在室外序列有严重的漂移问题。在方位误差方面,所有系统都是精确的,平均误差小于2度,这是由于陀螺仪在校准良好的情况下,通过对陀螺进行积分跟踪而实现的。如图7所示,我们的iPhone数据具有窄视场和低成本的IMU,基于研究的方法面临挑战。有许多序列,这两种方法完全发散(例如图6)。另一方面,也有一些序列可以很好地工作。这可能部分是因为ROVIO和PIVO在内部动态估计IMU的校准参数(例如加速度计和陀螺仪偏差),而且两个系统都没有直接支持提供预先校准的IMU参数作为输入。ROVIO只考虑加性加速度计的偏差,它在许多序列中显示为指数爬行,我们用我们的数据提供真值的IMU校准参数,因此也可以用预先校准的值来评估它们的性能。或者,部分序列可用于自校准,其他用于测试。专有系统可能从工厂校准的参数中受益。图5e和图6显示了结果的示例。在这些情况下,所有商业解决方案都运行良好。尽管如此,ARCore在户外路径开始时仍然存在一些问题。此外,在多层楼的情况下,漂移通常更为严重,而且有一些序列显示,专有系统也有明显的故障。

一般来说,ROVIO在处理视觉数据和惯性数据之间的存在的长期遮挡和不一致方面存在问题。此外,在图5e中,它的标度很明显不准确,这很可能是由于加速度中没有建模的尺度偏差(scale bias),而这种偏差显然不足以满足消费者级传感器的要求,这些传感器也表现出乘性的偏差(multiplicative biases)[22]。另一方面,PIVO采用了加性和乘性加速度计偏差的模型。然而,使用PIVO,主要的挑战似乎是,如果没有适当的运动,从零开始在线校准各种IMU参数需要相当长的时间,从而减缓收敛到正确的轨道上。

6 Discussion and Conclusion 讨论和总结

我们提出了第一个使用标准智能手机传感器的手持设备远距离视觉惯性里程计的公共基准数据集。该数据集包含23条记录在不同真实环境中多层楼内的23个序列。序列的总长度为4.5km。此外,我们还提供了三种专用VIO平台和两种最新的学术VIO方法的定量比较,其中我们使用了原始的传感器数据。据我们所知,这是第一次背靠背比较ARKit, ARCore, and Tango。

苹果的ARKit在大多数场景中表现很好。只有在一个较难的室外序列中,ARKit出现了典型的惯性推算失败,估计的位置失去控制完全错误。与ARKit相比,Google的ARCore表现出更积极的视觉回环功能,而ARKit则出现在假阳性的“跳跃”,散落在轨道上(在视觉上相似的区域之间)。Tango中的专用硬件给了它优势,这也可以在图7中看到。区域学习( 带回环)是测试的最鲁棒和准确的系统。然而,所有的系统在开放的电梯中都表现得比较好,玻璃墙让摄像机看到电梯运动时打开的大厅。在关闭电梯的情况下,没有一个系统能够将惯性运动与静态视觉场景相协调。从ROVIO和PIVO的结果来看,这种数据集的需求是显而易见的。该研究领域需要挑战狭隘的视野和低性能IMU的数据,以开发和测试新的VIO方法,这些方法可以推广到消费级硬件。

数据采集过程可以很好地扩展到新的环境。因此,将来可以用相当小的努力来扩展数据集。数据集的目的是使视觉惯性测定仪的方法能够进行公平的比较,并加快这一研究领域的发展。这是相关的,因为VIO是用于增强现实中对移动设备的实时跟踪,目前最常用的方法。

有关数据集和下载链接的更多细节可以在网页上找到:https:/github.com/aaltovision/advio。

References

1. Bloesch, M., Burri, M., Omari, S., Hutter, M., Siegwart, R.: Iterated extended Kalman filter based visual-inertial odometry using direct photometric feedback. International Journal of Robotics Research 36(10), 1053–1072 (2017) 3, 12

2. Blösch, M., Omari, S., Hutter, M., Siegwart, R.: Robust visual inertial odometry using a direct EKF-based approach. In: Proceedings of the International Conference on Intelligent Robots and Systems (IROS). pp. 298–304. Hamburg, Germany (2015) 1, 3, 12

3. Burri, M., Nikolic, J., Gohl, P., Schneider, T., Rehder, J., Omari, S., Achtelik, M.W., Siegwart, R.: The EuRoC micro aerial vehicle datasets. International Journal of Robotics Research 35, 1157–1163 (2016) 4, 5

4. Carlevaris-Bianco, N., Ushani, A.K., Eustice, R.M.: University of Michigan North Campus long-term vision and LIDAR dataset. International Journal of Robotics Research 35, 1023–1035 (2015) 4, 5

5. Ceriani, S., Fontana, G., Giusti, A., Marzorati, D., Matteucci, M., Migliore, D., Rizzi, D., Sorrenti, D.G., Taddei, P.: Rawseeds ground truth collection systems for indoor self-localization and mapping. Autonomous Robot 27(4), 353–371 (2009) 4, 5

6. Cordts, M., Omran, M., Ramos, S., Rehfeld, T., Enzweiler, M., Benenson, R., Franke, U., Roth, S., Schiele, B.: The Cityscapes dataset for semantic urban scene understanding. In: Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR). pp. 3213–3223. Las Vegas, USA (2016) 2, 4

7. Engel, J., Koltun, V., Cremers, D.: Direct sparse odometry. IEEE Transactions on Pattern Analysis and Machine Intelligence 40(3), 611–625 (2018) 12

8. Engel, J., Usenko, V.C., Cremers, D.: A photometrically calibrated benchmark for monocular visual odometry. arXiv preprint arXiv:1607.02555 (2016) 4

9. Everingham, M., Eslami, A., Van Gool, L., Williams, I., Winn, J., Zisserman, A.: The PASCAL visual object classes challenge: A retrospective. International Journal of Computer Vision (IJCV) 111(1), 98–136 (2015) 2

10. Geiger, A., Lenz, P., Urtasun, R.: Are we ready for autonomous driving? The KITTI vision benchmark suite. In: Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR). pp. 3354–3361. Providence, Rhode Island (2012) 2, 4

11. Laskar, Z., Huttunen, S., Herrera, D., Rahtu, E., Kannala, J.: Robust loop closures for scene reconstruction by combining odometry and visual correspondences. In: Proceedings of the International Conference on Image Processing (ICIP). pp. 2603– 2607. Phoenix, AZ, USA (2016) 8

12. Li, M., Kim, B.H., Mourikis, A.I.: Real-time motion tracking on a cellphone using inertial sensing and a rolling-shutter camera. In: Proceedings of the International Conference on Robotics and Automation (ICRA). pp. 4712–4719 (2013) 1

13. Lin, T., Maire, M., Belongie, S.J., Hays, J., Perona, P., Ramanan, D., Dollár, P., Zitnick, C.L.: Microsoft COCO: Common objects in context. In: Proceedings of the European Conference on Computer Vision (ECCV). pp. 740–755. Zurich, Switzerland (2014) 2

14. Mourikis, A.I., Roumeliotis, S.I.: A multi-state constraint Kalman filter for visionaided inertial navigation. In: Proceedings of the International Conference on Robotics and Automation (ICRA). pp. 3565–3572. Rome, Italy (2007) 1

15. Mur-Artal, R., Tardós, J.D.: ORB-SLAM2: An open-source SLAM system for monocular, stereo and RGB-D cameras. IEEE Transactions on Robotics 33(5), 1255–1262 (2017) 12

16. Mur-Artal, R., Tardós, J.D.: Visual-inertial monocular SLAM with map reuse. Robotics and Automation Letters 2(2), 796–803 (2017) 1

17. Nikolic, J., Rehder, J., Burri, M., Gohl, P., Leutenegger, S., Furgale, P.T., Siegwart,R.: A synchronized visual-inertial sensor system with FPGA pre-processing for accurate real-time SLAM. In: Proceedings of the IEEE International Conference on Robotics and Automation (ICRA). pp. 431–437. Hong-Kong, China (2014) 5

18. Pfrommer, B., Sanket, N., Daniilidis, K., Cleveland, J.: PennCOSYVIO: A challenging visual inertial odometry benchmark. In: Proceedings of the IEEE International Conference on Robotics and Automation (ICRA). pp. 3847–3854. Singapore (2017) 4, 5

19. Russakovsky, O., Deng, J., Su, H., Krause, J., Satheesh, S., Ma, S., Huang, Z., Karpathy, A., Khosla, A., Bernstein, M., Berg, A., Fei-Fei, L.: ImageNet Large Scale Visual Recognition Challenge. International Journal of Computer Vision (IJCV) 115(3), 211–252 (2015) 2

20. Schneider, T., Dymczyk, M.T., Fehr, M., Egger, K., Lynen, S., Gilitschenski, I.,Siegwart, R.: Maplab: An open framework for research in visual-inertial mapping and localization. IEEE Robotics and Automation Letters 3(3), 1418–1425 (2018) 12

21. Schöps, T., Engel, J., Cremers, D.: Semi-dense visual odometry for AR on a smartphone. In: Proceedings of the International Symposium on Mixed and Augmented Reality (ISMAR). pp. 145–150 (2014) 1

22. Shelley, M.A.: Monocular Visual Inertial Odometry on a Mobile Device. Master’s thesis, Technical University of Munich, Germany (2014) 13

23. Smith, M., Baldwin, I., Churchill, W., Paul, R., Newman, P.: The New College vision and laser data set. International Journal of Robotics Research 28(5), 595– 599 (2009) 4

24. Solin, A., Cortes, S., Rahtu, E., Kannala, J.: Inertial odometry on handheld smartphones. In: Proceedings of the International Conference on Information Fusion (FUSION). Cambridge, UK (2018) 3, 5, 8, 9

25. Solin, A., Cortes, S., Rahtu, E., Kannala, J.: PIVO: Probabilistic inertial-visual odometry for occlusion-robust navigation. In: Proceeding of the IEEE Winter Conference on Applications of Computer Vision (WACV). Lake Tahoe, NV, USA (2018) 3, 5, 12

26. Sturm, J., Engelhard, N., Endres, F., Burgard, W., Cremers, D.: A benchmark for the evaluation of RGB-D SLAM systems. In: Proceedings of the International Conference on Intelligent Robot Systems (IROS). pp. 573–580 (2012) 4

补充材料

A Description of supplementary video

所附的补充视频显示了数据集序列16的真值轨迹(在这两幢办公楼中的一幢采集)。可视化轨迹是从整个IMU数据序列中计算出的真值轨迹。用于轨迹计算的固定点由dots可视化。当前地板上的轨道显示为红色。视频已被加速。

B Details on collected data

B.1 Ground-truth

Ground-truth poses:根据原始的IMU数据和一组已知的固定点计算相机的姿态(平移和方位)。在100 Hz处采样真值轨迹。

Fix points:一组以视觉编辑为标志的真值点。这些要点是基于系统存储的三个视频(主要是iphone和第二部iphone,其中记录了记录捕获者的参考轨迹)和平面图布局。

B.2 iPhone

Camera frames:相机帧在60fps(1280*720,纵向)时被捕获。平台获取的准确帧采集时间被存储。这些帧被打包到一个H.264/MPEG-4视频文件中。

Platform location: 通过核心定位收集的数据。更新速度取决于设备及其功能。所要求的位置具有所需的kCLLocationAccuracyBest。将时间戳转换为与其他传感器相同的时钟(自设备启动以来的时间间隔)。

Accelerometer: 通过CoreMotion/CMMotionManager采集,100Hz(最大采集速率)

Gyroscope: 通过CoreMotion/CMMotionManager采集,100Hz(最大采集速率),请注意,读数在苹果设备坐标系中(这里没有任何改变)。

Magnetometer: 通过CoreMotion/CMMotionManager采集,100Hz(最大采集速率),值是三轴磁强计的读数。所有的数值都是未校准的。

Barometric altimeter: CoreMotion/CMAltimeter采集,以不均匀的采样率(1Hz)获取的。采样数据回调到达时被存储。实际气压值为0,推断的相对高度(用苹果magic计算)储存在Value 1中。

ARKit poses: 苹果ARKit的位姿(平移和旋转)是在60Hz采集的。ARKit在iPhone上报告的相机参数也被存储在iPhone上。

B.3 Tango

Tango poses (raw): 谷歌Tango原始姿态(平移和旋转)在60Hz捕获。

Tango poses (area learning): 60Hz。

Camera frames: 视频从Tango广角(鱼眼)摄像机上 在5 fps/640*480捕获。这些帧被打包成一个MPEG-4视频文件。

Tango point clouds: Tango装置采集的 Tango点云数据,与设备的当前姿态对齐。采样率不均匀。

B.4 Pixel

ARCore poses: The Google ARCore poses (translation and orientation) are captured at 30 Hz.

C Dataset structure

为了最大限度地兼容,所有数据都以开放和简单的文件格式发布。逗号分隔值(CSV)文件在第一列中保存时间戳,并在后面的列中保存相应的数据。所有时间戳在传感器类型和设备之间同步。

摄像机帧存储为H.264/MPEG视频,相关的帧时间戳可在单独的CSV文件中使用。一个数据集的文件夹结构如下所示:

E Data set paths

下表列出了每个路径形状(顶部/侧面视图)和汇总信息。