Evaluation and Analysis of Hallucination in Large Vision-Language Models----大视觉语言模型中幻觉的评估与分析

Abstract

大视觉语言模型(LVLM)最近取得了显著的成功。然而,LVLM仍然受到幻觉问题的困扰,这限制了在许多场景下的实用性。幻觉是指视觉输入中不存在的LVLM反应信息,存在造成重大后果的潜在风险。研究 LVLM 幻觉评估的工作有限。在本文中,我们提出了基于大型语言模型(HaELM)的幻觉评估,这是一种基于LLM的幻觉评估框架。 HaELM 实现了与 ChatGPT 相当的约 95% 的性能,并具有低成本、可重复性、隐私保护和本地部署等额外优势。利用 HaELM,我们评估了当前 LVLM 中的幻觉。此外,我们分析了 LVLM 中产生幻觉的因素,并提供了缓解幻觉问题的有用建议。我们的数据和代码可在 https://github.com/junyangwang0410/HaELM 获取。

1 简介

以 ChatGPT 为代表的大型语言模型(LLM)的成功引起了广泛的关注(Zhang et al., 2022; Chowdhery et al., 2022; Touvron et al., 2023; Scao et al., 2022) 。最近,大视觉语言模型(LVLM)扩展了 LLM 来理解视觉输入,并以零样本的方式展示令人印象深刻的多模态能力(Zhu et al., 2023;Liu et al., 2023b;Ye et al., 2023;Gong)等,2023;Wang 等,2023;Li 等,2023a;Mu 等,2023;Su 等,2023;Liu 等,2020)。这些努力推动了多模态通用人工智能的发展。

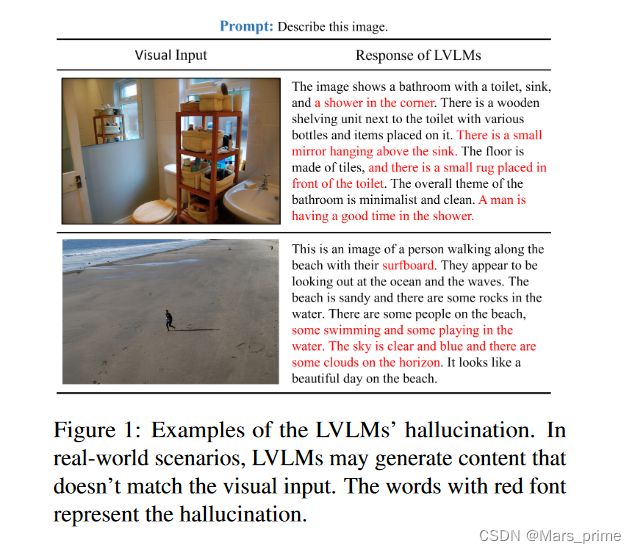

然而,LVLM 仍然遭受幻觉的困扰,幻觉指的是生成与视觉输入不一致的错误信息(Liu et al., 2023a)。之前的工作主要集中在研究llm和视觉语言预训练模型(VLPM)中的幻觉。对于 LLM 来说,幻觉主要源于训练数据中存在的不正确知识(Zhang 等人,2023;Li 等人,2023b),而对于 VLPM 来说,挑战在于在抽象视觉编码中准确表示视觉信息(Shen 等人) ., 2021; Biten 等人, 2022)。尽管 LVLM 结合了 LLM 和 VLPM 的优点,但它们本质上继承了两种幻觉生成途径。在这种情况下,法学硕士框架内对视觉信息的错误识别可能会导致看似合理但最终荒谬的反应,如图1所示。幻觉带来了潜在的重大后果风险,需要解决和纠正(Li等人) ., 2023d)。

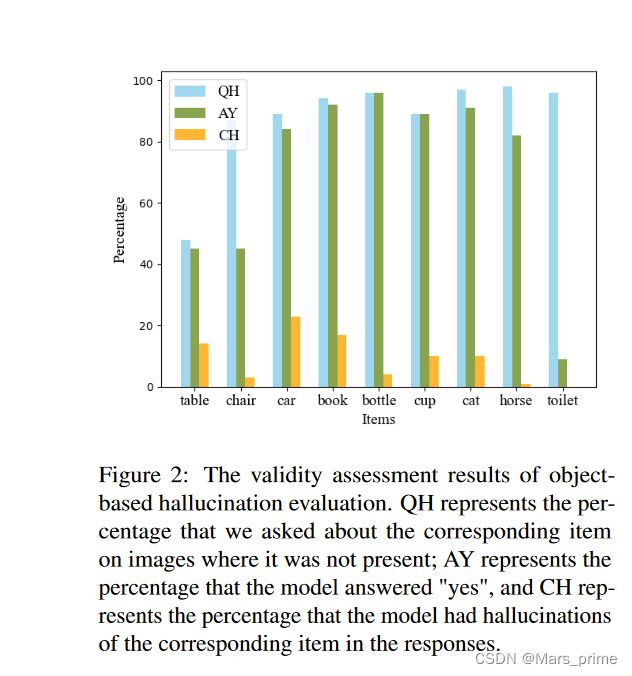

为了解决LVLM中的幻觉问题,幻觉评估框架。 POPE 最初使用对象检测器来识别图像中的所有对象,然后使用预定义的提示(例如“此图像中是否有 {object}?”)来查询模型是否存在图像中不存在的对象。图像。模型的回答“是”被视为出现幻觉的迹象。尽管如此,我们的调查(如图 2 所示)表明,LVLM 往往对超过 80% 的有关不存在对象的查询表现出“是”的响应。相比之下,当采用“描述图像”提示时,不到 10% 的结果响应包含幻觉对象。这种差异强调了基于物体的幻觉评估与 LVLM 的实际幻觉之间的弱相关性。

上述分析表明,在理想化的幻觉评估场景中,LVLM极易受到提示的影响,导致反应出现偏差,无法作为幻觉评估的依据。因此,我们主张在现实场景中进行幻觉评估,以避免提示对评估结果的负面影响。然而,一个挑战是 LVLM 在现实场景中的响应往往很复杂,这意味着传统的基于匹配的评估方法将不再适用。这意味着评估工具需要了解 LVLM 的复杂响应。

我们注意到LLM展示了强大的文本理解能力。基于此,我们提出了一种创新框架,称为基于大型语言模型的幻觉评估(HaELM)。首先,我们识别 LVLM 表现出的幻觉模式并系统地收集他们的幻觉反应。随后,我们精心设计提示,引出 ChatGPT 与这些模式一致的响应,以收集相关的训练数据。最后,我们通过基于 LoRA 的方法(Hu 等人,2021)对 LLaMA(Touvron 等人,2023)进行微调。因此,HaELM 能够熟练地评估幻觉,利用图像的参考描述作为评估的基础。实验结果证明 HaELM 和 ChatGPT 具有相当的性能,与人类注释保持一致。此外,HaELM 还具有低成本、可重复性、隐私保护和本地部署等优势。最后,我们对当前 LVLM 中导致幻觉产生的因素进行了全面分析,最终提出了一套减轻幻觉的建议。

我们将贡献总结如下:

- 通过分析,我们发现LVLM很容易受到理想化幻觉场景中提示的影响,使得结果与现实场景不相关。

- 据我们所知,我们是第一个在 LVLM 内利用法LLM进行幻觉评估的人。我们提出基于大型语言模型(HaELM)的幻觉评估。与 ChatGPT 相比,HaELM 具有强大的性能,并具有低成本、可重复性、隐私保护和本地部署等额外优势。

- 利用 HaELM,我们开始评估当前 LVLM 中是否存在幻觉。我们分析影响幻觉的因素并提供有用的建议。

2 Background

----

2 背景

本节我们主要介绍了现有的大型语言模型(LLM)和大型视觉语言模型(LVLM),以及LLM和LVLM中存在的幻觉问题。

2.1 大语言模型

GPT-3(Brown et al., 2020)证明,具有大量参数的语言模型具有强大的零样本能力,并且能够出色地完成以前从未见过的任务。由于 GPT-3 的成功,现在LLM(Zhang et al., 2022;Chowdhery et al., 2022;Touvron et al., 2023;Scao et al., 2022)获得了极大的关注。为了使LLM对人类指令更加敏感,InstructGPT(Ouyang et al., 2022)引入了指令跟随微调范式。它利用人类反馈的强化学习来训练LLM遵循人类指令并产生所需的输出。

2.2 大视觉语言模型

随着LLM的成功,许多研究人员一直在扩展语言模型以理解现实世界的图像。例如,一些方法(Yang et al., 2023; Shen et al., 2023)基于视觉专家,并以 ChatGPT 为核心工作。另一方面,最近的一些开源工作,例如(Zhu et al., 2023; Liu et al., 2023b; Ye et al., 2023; Kong et al., 2023; Wang et al., 2023; Li et al. ., 2023a; Mu et al., 2023; Su et al., 2023)通过将从视觉编码器中提取的视觉标记与预训练的 LLM 对齐并指示对其进行调整来实现统一的 LVLM。为了进一步提高 LVLM 的性能,(Liu et al., 2023a; Li et al., 2023c)提出增加指令的多样性并构建更大的指令微调数据集。

2.3 LLM 和 LVLM 中的幻觉

幻觉问题在传统 NLP 领域已被广泛研究。尽管最新且广受好评的LLM取得了进步,但它们仍然受到幻觉的持续挑战的困扰。因此,大量旨在减轻这些幻觉影响的作品应运而生。然而,值得注意的是,人们对解决 LVLM 中的幻觉的关注有限(Zhou 等人,2023;Liu 等人,2023a)。

与LLM中观察到的幻觉相反,LVLM 中的幻觉是由于视觉和文本模式之间的不匹配而产生的。目前,唯一专门关注利用对象检测和查询指令的 LVLM 幻觉的工作(Li et al., 2023d)。通过细致的实证实验,他们证实了 LVLM 中幻觉的严重程度,特别是在生成提供的图像中不存在但在训练数据中频繁出现的对象时。现有的LLM通过采用指令调整,使其目标输出遵循人类指令,但这可能会导致训练和目标分布出现偏差(Tian et al., 2023)。此外,视觉约束不足导致 LVLM 中出现严重的错觉问题。

幻觉的存在会导致模型不可靠,从而可能对人类社会造成危害,例如模型输出的误导性信息导致人类决策错误或输出有毒信息。

3 Motivation

目前现有的幻觉评估方法是基于对象的幻觉评估(Li et al., 2023d)。它通过查询 LVLM 对“物品”存在的反应来测量 LVLM 的幻觉程度。 “项目”是从图像中不存在的常见幻觉单词列表中选择的。如果模型认为某个项目存在于图像中,而该项目并不存在,则表明模型对该项目产生了幻觉。

为了验证可行性,我们设计了基于对象的幻觉评估方法的实验。我们使用了提示“这张照片中有 {item} 吗?”查询 mPLUG-Owl 从 MS-COCO 2014 数据集中随机选择的 100 个图像(Lin 等人,2014 年;Chen 等人,2015 年)。附录中提供了其他模型的详细结果。提示中的 {item} 被替换为(Li et al., 2023d)提出的前十个最常产生幻觉的单词,这些单词在给定图像中不存在。结果如图 2 所示。“QH”和“AY”表明 LVLM 对该提示中超过 80% 的查询回答“是”,即使提示中的所有项目都不在图像中。

图2:基于对象的幻觉评估的有效性评估结果。 QH 代表我们询问图像上不存在相应项目的百分比; AY 代表模型回答“是”的百分比,CH 代表模型对回答中相应项目产生幻觉的百分比。

上述现象可以用 LVLM 在用“是”回答回答判断型查询时倾向于肯定描述来解释。我们推测这种偏差是由于指令微调数据造成的,其中包含大量迎合人类请求的响应,这导致 LVLM 对判断型查询的响应存在偏差。为了验证 LVLM 对此类查询的响应与相应幻觉之间的关系,我们在现实场景中进行了手动评估。我们使用提示“描述此图像”,并检查生成的描述是否确实包含收到“是”响应的项目的幻觉。图 2 中的“AY”和“CH”表明,只有 10% 的回答包含对特定项目的幻觉。这表明幻觉测量的基于对象的评估仅仅利用了 LVLM 中存在的判断偏差,而不是反映他们的幻觉。

4 方法

本节主要介绍幻觉的定义以及我们基于大语言模型的幻觉评估方法。

4.1 问题定义

LVLM 在现实场景中的幻觉评估被定义为,在人类可能发起的潜在请求下,确定图像内容与 LVLM 生成的响应之间是否存在差异。在本文中,我们关注图像描述的现实场景。

4.2 HaELM

数据采集

为了感知 LVLM 反应中的幻觉,评估非幻觉和幻觉反应至关重要。为了解决这个问题,我们首先分析 LVLM 的幻觉模式。随机选择图像,我们使用“描述此图像”指令查询 LVLM,并手动注释幻觉响应以获得真实的幻觉集合,如图 3 左所示。

图 3:HaELM 数据收集过程图示。左图展示了手动收集真实幻觉反应的过程,右图展示了使用ChatGPT批量生成数据的过程。人类相似性评估旨在将模拟幻觉数据的模式与现实数据的模式保持一致。

随后,我们的目标是批量获取大量幻觉数据。我们考虑使用 ChatGPT 根据所提供图像的参考标题手动构建提示来生成幻觉。我们通过人类相似性评估将 ChatGPT 生成的幻觉数据与现实幻觉数据进行比较。我们反复修改提示,使两者的模式紧密对齐,如图 3 右侧所示。我们的幻觉数据收集格式如图 4 所示。

图4:生成模拟幻觉样本的提示示例,其中红色字体的文字代表幻觉描述。

最后,我们收集非幻觉数据。通过请求ChatGPT根据参考标题生成详细描述,我们可以轻松获得所需的数据。然而,重要的是要强调生成的描述应严格遵守参考标题中存在的对象,

训练和推理

在训练阶段,我们采用与LLM的数据分布和指令微调相对应的一致格式提示。上一步收集的数据无缝集成到提示中,作为通过自回归训练过程微调 LLM 的训练数据。在推理阶段,我们将评估中的 LVLM 的参考标题和响应合并到提示中。然后将这些输入输入到经过精心训练的评估模型中以获得判断。

数据收集和训练完成后,HaELM 可以多次重复使用,这比 ChatGPT 具有成本优势,同时确保可重复性。此外,HaELM基于开源LLM构建,允许本地部署,从而无需上传数据并保证数据隐私。

5 实验

数据集

我们的图像数据集仅包含来自 MS-COCO 2014 的图像(Lin 等人,2014 年;Chen 等人,2015 年),遵循(Karpathy 和 Fei-费,2015)。为了收集数据,我们从训练集中随机选择 10,000 个样本,并分别收集 10,000 个幻觉和 10,000 个非幻觉模拟反应。此外,我们从测试集中获取了全部 5,000 个样本,专门用于评估 LVLM 的幻觉。为了确保我们的数据收集和幻觉评估的一致性和准确性,我们使用数据集中提供的手动注释的标题作为参考标题。

实现细节

我们采用 LLaMA(Touvron 等人,2023)作为基础模型,并利用 LoRA(Hu 等人,2021)进行微调。我们的超参数如附录表 8 所示。使用单个 Tesla V100 GPU 的训练过程需要 2 小时。对于评估模型,我们选择了当前可用的开源 LVLM:mPLUG-Owl (Ye et al., 2023)、MiniGPT-4 (Zhu et al., 2023) 和 LLaVA (Liu et al., 2023b)。参数设置见附录表7。我们选择最先进的LLM ChatGPT 作为我们的基准。

为了确保模型专注于幻觉评估,我们禁用了输入的梯度计算,以防止学习不相关的信息。此外,我们的训练数据输出明确限于“是”或“否”响应,有效地有利于自动化评估。

在使用ChatGPT评估幻觉时,我们通过手动提示编辑进一步提高了准确性,确保了比较的公平基础。值得注意的是,我们在训练过程中避免使用手动注释的真实幻觉数据,以维护我们实验结果的完整性和可靠性。

5.1 HaELM 评价

在本小节中,我们首先评估 HaELM 的性能。由于我们是第一个利用LLM进行幻觉评估的,所以我们选择竞争激烈的ChatGPT作为我们比较分析的基线。由于缺乏既定基准,我们使用数据收集阶段从 LVLM 得出的真实幻觉反应作为评估基准,并使用注释作为基本事实。