目标检测——Fast R-CNN算法解读

论文:Fast R-CNN

作者:Ross Girshick

链接:https://arxiv.org/abs/1504.08083

代码:https://github.com/rbgirshick/fast-rcnn

目录

- 1、算法概述

- 2、Fast R-CNN细节

-

- 2.1The RoI pooling layer

- 2.2 Fine-tuning for detection

- 2.3 Fast R-CNN detection

- 3、实验结果

- 4、创新点和不足

1、算法概述

先说R-CNN的不足之处:

1、训练方式不是端到端的,必须先微调CNN网络,然后用CNN网络得到的特征训练SVMs,最后学习bounding-box回归器。

2、训练起来耗时且耗磁盘空间,用于训练SVMs和bounding-box的区域候选框的特征必须提取好后存储在磁盘中。

3、检测速度很慢,通过重复提取每个区域候选框的特征进行SVM分类加回归,用VGG16的backbone,即使在GPU上推理速度也要47s/image。

同年的SPPNet针对R-CNN也做了改进,除了将用于提取特征的CNN网络替换成ZF5,主要改进点就是用SPP(空间金字塔池化)层替换了网络最后一个池化层,这使得原本R-CNN的2000次CNN前向传播用于提取候选框区域特征得以仅通过一次就可以全部做完,这一改进大大减少了训练和推理时间。但它还是没有解决上面提到的R-CNN第1、第2两个不足点。

Fast R-CNN相对于之前的R-CNN工作做了如下改进:1、将CNN网络由AlexNet替换成了VGG16,能提取到更深层次特征;2、利用多任务损失函数,使得训练一步到位;3、训练阶段网络全部层都可以更新(相对于SPPNet而言,论文中说SPPNet在SPP层之前的卷积层无法更新,我在知乎上搜到的回答如下,回答来自知乎@可以啊,其实论文2.3节也解释了原因);4、不需要额外的磁盘空间用于存储特征。

2、Fast R-CNN细节

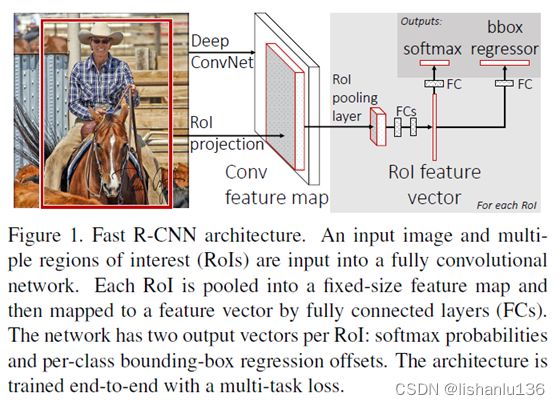

Fast R-CNN的结构如上图所示,网络接收的输入为一整张图片和一组区域候选框坐标,图片经过几组连续的conv+pooling层后得到特征图,然后,针对每个区域候选框,都将通过感兴趣区域池化层(ROI Pooling Layer)从特征图中提取一个固定长度的特征向量。每个特征向量被送到全连接层,最终连接到两个分支作为网络输出层:一个产生softmax概率估计,类别数为K个对象类加一个“背景”类;另一个为K个对象类输出的四个实数预测。每组4个值为K个类对应的预测box位置(反映在原图中需解码)。

2.1The RoI pooling layer

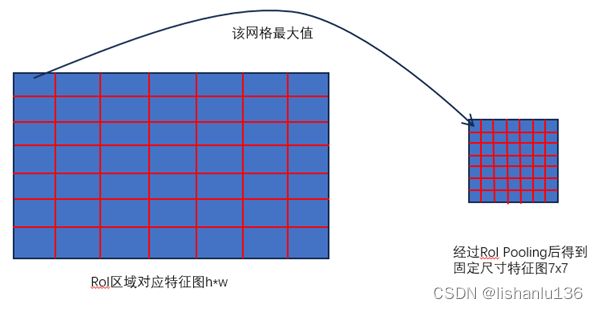

RoI池化层使用最大池化将任何有效感兴趣区域内的特征转换成具有固定尺寸HxW (例如,7x7)的小特征图。假设某个区域候选框对应特征图上的RoI区域窗口为(r,c,h,w),(r,c)代表矩形左上点,(h,w)代表矩形高,宽。RoI最大池化的工作原理是将h * w大小的RoI窗口划分为H * W个网格,每个网格的大小近似为h/H * w/W,然后将每个网格中的值最大池化到相应的输出网格单元中。RoI Pooling层可看作是单个尺度的SPP层(single-level SPP),如下图所示:

2.2 Fine-tuning for detection

在微调之前,先调整网络结构,将VGG16的最后一层maxpooling层替换成RoIpooling层,设置输出的固定尺寸为H=W=7;调整输出层为softmax和bounding-box回归,softmax类别为K+1,bounding-box输出为4K;调整输入为图片加上图片对应的区域候选框坐标。

样本采样采用分层采样,Fast R-CNN使用了一个训练过程,共同优化softmax分类器和bounding-box回归器,而不是在三个单独的阶段训练softmax分类器、SVM和回归器推理阶段。

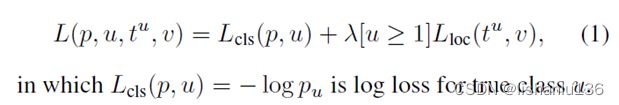

多任务损失

作者通过在每个标记的RoI上使用一个多任务损失L来联合训练分类和bounding-box回归,联合损失公式如下:

其中,u为ROI对应的类别真实标签,v为ROI对应的矩形框坐标真实标注。因为背景类的标注为u=0,可见背景类不参与坐标框回归损失计算。这里坐标框回归用的是smoothL1损失:

Mini-batch采样

Batchsize设置为128,是从两张图片采样得到,每张图片包含64个ROI区域,25%的是正样本,正样本为IOU(ROI区域与groundtruth交并比)大于等于0.5的,类别u>=1;其余IOU为0.1到0.5的视为背景样本,类别u=0,IOU小于0.1的视为困难样本挖掘的参考例子。训练中只做了概率为0.5的水平翻转数据增强。

尺度不变性

作者也采用类似于SPPNet同样的方式进行多尺度训练,通过图像金字塔为网络提供近似的尺度不变性。在测试阶段,也采用在图像金字塔上进行区域候选框选择。

2.3 Fast R-CNN detection

在推理阶段,网络接收一张图片或者是一张图片的图像金字塔列表及对应的R个目标区域候选框坐标。在测试阶段R取值为2000。当用图像金字塔作为输入时,2000个ROI区域也被按比例分配到图像的每个尺度上,这些ROI区域接近224x224的大小。最终会在类别分支得到K+1个分数,在回归分支得到4个坐标点(取类别分数最大的类别对应的4个坐标值),然后按类别应用nms消除多余的框。

3、实验结果

实验设置:作者使用了三种模型(S,M,L)用于对比,AlexNet(model S),VGG_CNN_M_1024(model M,与S有相同的深度,但是通道数更宽),VGG16(model L),作者在VOC2007,VOC2010,VOC2012上测试结果如下:

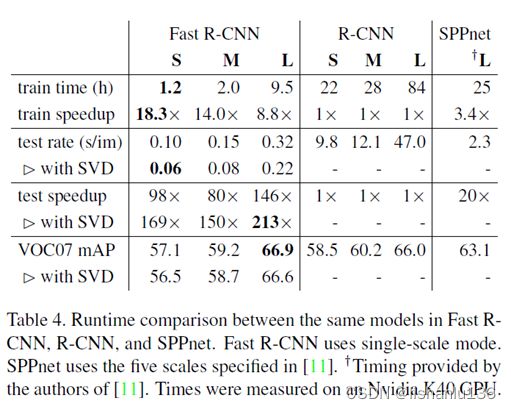

和R-CNN,SPPNet训练时间及推理时间对比结果如下:

4、创新点和不足

- 创新点:

1、利用多任务损失函数,使得训练一步到位;

2、提出RoIPooling层,使得训练阶段网络全部层都可以更新;

3、Fast R-CNN消除了存储特征的磁盘空间消耗。 - 不足:

1、候选框区域生成还是用selective search,不仅耗时且与后面的训练过程是独立的;