elk日志分析系统:

elk日志分析系统:

elk是一套完整的日志集中处理方案,由三个开源的软件简称组成;

E:Easticsearch 简称ES是一个开源的,分布式的存储检索引擎,(索引型的非关系数据库)存储日志

由java代码开发的,基于Lucene结构开发的一套全文检索引擎,他也拥有一个web接口

用户可以通过浏览器的形式和ES组件进行通信

作用;存储,允许全文搜索,也可以结构化搜索(也可以根据索引点来进行搜索),索引点可以支持大容量的日志数据,也可以搜索不同类型的文档。

k:kiabana图形化界面,可以更好的分析存储在ES上的日志数据,提供了一个图形化的界面,来浏览ES上的日志数据。汇总分析,搜索。

l:Logstash 数据收集引擎。可以支持动态的(实时)从各种服务应用收集日志资源,还可以对收集到日志数据进行过滤,分析,丰富收集的到日志数据,统一格式。然后把数据同步到es存储引擎。

RUBY语言编写的,运行在java虚拟机上的一个强大的数据处理工具,数据传输,格式化输出,格式化处理,主要用来处理日志

数据收集工具:

filebeat:轻量级的开源的,日志收集工具,收集的速度比较快,但是没有数据分析和过滤的能力,一般是结合logstash一块使用

kafka

RabbitMQ 中间件消息队列

总结:elk作用当我们管理一个大集群式,需要分析和定位的日志就会很多,每一台服务器分别去分析,将会耗时耗力

所以我们应运而生了一个集中的统一的日志管理和分析系统,极大的挺高了定位问题的效率

1、收集,可以收集基本上市面上常用的软件日志

2、传输:收集到的日志需要发送到es上

3、存储:es负责存储数据、

4、ui:图形化界面(kiabana)

需要3台服务器

需要两台

es1:

es2 :

logstash,kiabana(4核,8g)

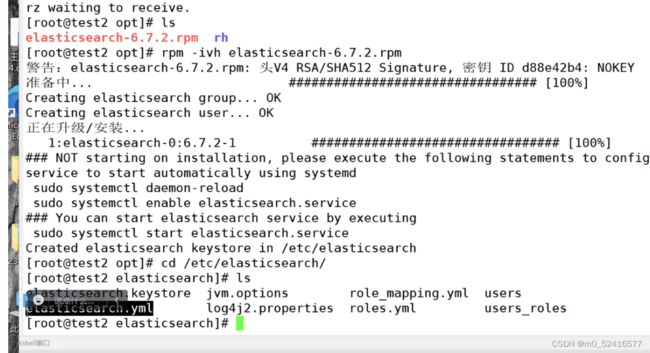

vim /etc/security/limits.conf

*soft nofile 65536

*hard nofile 65536

*soft nproc 32000

*hard nproc 32000

*soft memlock unlimited

*hard memlock unlimited

vim /etc/systemd/system.conf

DefaultLimitNOFILE=65536

一个用户会话的默认最大文件描述符的限制量

文件描述符:用于标识打开文件或者i/o资源限制的整数。

DefaultLimitNPROC=32000

一个用户可以打开的最大进程数量的限制32000,一个用户终端可以运行多少个进程

DefaultLimitMEMLOCK=infinity

一个用户的终端默认锁定内存的限制,不限制

内核优化

ES是基于lucene架构,实现的一款索引型数据库,lucene可以利用操作系统的内存来缓存ES的索引数据。

提供个更快的查询速度,在工作中我们会把系统的一半内存留给lucene

机器内存小于64G,50%给es,50%给操作系统,供lucene使用

机器内存大于64G,ES分配4-32G即可,其他的都给操作系统,供lucene

vm.max_map_count=262144

一个进程可以拥有的最大内存映射区的参数。

内存映射:将文件或者其他设备映射进程地址空间的方法。允许进程直接读取或写入文件,无需 常规的I/O方式。

映射空间越大,ES和lucene的速度越快

2g/262144

4g/4194304

8g/8388608

systemctl enable

netstat -antp | grep 9200

http://192.168.233.12:9200/_cluster/health?pretty

查询健康状态

yum install gcc gcc-c++ make -y

tar zxvf node-v8.2.1.tar.gz

cd node-v8.2.1

./configure

make -j 2 && make install

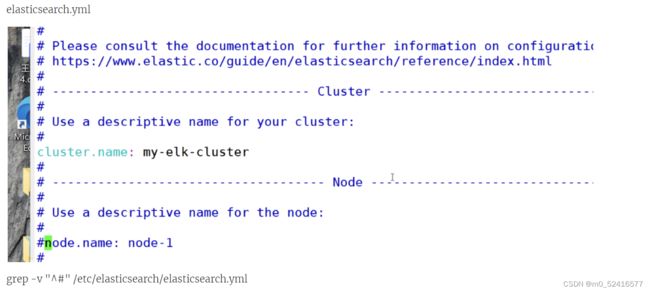

http.cors.enabled: true

开启隽语访问支持

http.cors.allow-origin: "*"

开启跨域访问之后,允许访问的域名的地址*:所有

npm run start &

9100是可视化工具的访问端口 9200还是es数据库的访问端口

logstash的命令常用选项

-f 指定配置文件,根据配置文件识别输入和输出流

-e;一般用于测试,从命令行当中获取输入,然后传送到,经过logstash加工之后形成一个标准输出

-t:检测配置文件是否正确,然后退出。

所有的键盘输出命令行输出,转化成标准输出(rubydebug的模式),6.0之后,logstash的默认输出格式就啊是rubydebug格式的标准输出

logstash -e 'input { stdin{} } output { stdout{} }'

logstash -e 'input' { stdin{} } output { elasticsearch { hosts=>["20.0.0.77:9200","20.0.0.121:9200"]}} --path.data /opt/test1

vim /etc/kibana/kibana.yml

touch /var/log/kibana.log

chowm kibana:kibana /var/log/kibana.log

systemctl restart kibana

cd /etc.logstash/conf.d

mkdir /opt/log

vim system.conf

input {

file{

path=>" /var/log/messages"

type =>"system"

start_position =>"beginning"

}

}

output {

elasticsearch{

hosts => ["20.0.0.77:9200","20.0.0.121"]

index =>"system-%{+YYYY.MM.dd}"

}

}

logstash -f system.conf --path.data /opt/test1

http的

vim /httpd.conf

input {

file{

path => " /etc/httpd/logs/access_log"

type =>"access"

start_postion =>"beginning"

file{

path => " /etc/httpd/logs/error_log"

type =>"error"

start_postion =>"beginning"

}

}

output {

if [type] == "access" {

elasticsearch{

hosts => ["20.0.0.77:9200","20.0.0.121:9200"]

index => "http_access-%{+YYYY.MM.dd}"

}

}

if [type] == "error" {

elasticsearch{

hosts => ["20.0.0.77:9200","20.0.0.121:9200"]

index => "http_error]-%{+YYYY.MM.dd}"

}

}

}

elk

es存储数据,索引型的数据库

logstatsh:收集日志,然后按照标准化格式发送给ES (RUBYDEBUG的格式)

k:可视化工具,更人性化的显示用户信息,方便用户检索查询

http的日志收集写一个nginx的logstash的配置文件。

要使用json格式

logstash -f nginx.conf --path.data /opt/test2 &

-f指定配置文件