Filebeat使用指南

-

- Filebeat介绍

- 主要优势

- 主要功能

- 配置日志的解析

- Kibana中设置日志解析

- 安装步骤

-

- 安装Filebeat

- 安装监控

- 通过prometheus监控

- Filebeat和Logstash的主要区别

Filebeat介绍

Filebeat是使用Golang实现的轻量型日志采集器,也是Elasticsearch stack的一员。它可以作为一个agent安装在各个节点上,根据配置读取对应位置的日志,并上报到相应的地方去。Filebeat的可靠性很强,可以保证日志至少一次的上报,同时也考虑了日志搜集中的各类问题,例如日志断点续读、文件名更改、日志截断等。Filebeat并不依赖于Elasticsearch,可以单独存在。其内置了常用的Output组件,例如Kafka、Elasticsearch、Redis等,也可以输出到console和file,我们还可以利用现有的Output组件将日志进行上报。

主要优势

- 轻量级 :Filebeat采用Go语言编写,具有非常小的二进制文件大小和低的资源占用率,可以快速部署和运行。

- 可靠性高 :Filebeat采用多线程机制和断点续传技术,在网络不稳定或者服务器宕机等情况下也能够保证数据的完整性和可靠性。

- 灵活 :Filebeat支持多种输入源,包括日志文件、系统日志、网络流量等,并且可以通过插件扩展支持更多输入源。

- 易扩展 :Filebeat支持动态添加或删除输入源,并且可以通过插件扩展支持更多输出目标。

- 支持实时解析 :Filebeat可以实时解析多种类型的日志文件,包括但不限于系统日志、应用程序日志、Web服务器日志等。

- 自定义过滤规则 :Filebeat允许用户自定义过滤规则,以提高日志收集的精度和效率。

- 日志轮转支持 :Filebeat支持日志轮转,可以自动处理日志文件的切割和归档。

- 支持SSL/TLS加密 :Filebeat支持使用SSL/TLS加密来保护日志数据在传输过程中的安全性。

- 强大的错误处理能力 :Filebeat在遇到错误时具有较高的容错性,可以自动尝试重新连接或重新发送数据。

- 易于管理和监控 :Filebeat提供了易于管理和监控的界面和API,方便用户进行配置、监控和维护。

Filebeat具有轻量级、可靠、灵活、易扩展、实时解析、自定义过滤规则、日志轮转支持、SSL/TLS加密和强大的错误处理能力等优势,使其成为一种高效、实用的日志收集工具。

主要功能

Filebeat的主要功能是监控文件或日志目录,将数据发送到指定的目的地,例如Elasticsearch、Logstash等,以进行集中存储和分析。它适用于实时监控日志场景,可以实时收集日志数据,并进行解析、过滤和发送。Filebeat支持多种格式的日志解析,包括JSON、Apache、Nginx、Syslog等。同时,它也支持SSL/TLS加密,确保日志数据在传输过程中的安全性。总的来说,Filebeat是一个非常实用的日志搜集工具,可以帮助用户实现日志的集中式存储和分析,方便用户进行故障排除、性能优化等工作。

配置日志的解析

在Filebeat中配置日志的解析方式主要涉及到两个部分:一个是Filebeat的配置文件,另一个是log input部分的配置。

首先,需要在Filebeat的配置文件中指定日志文件的路径。例如:

filebeat:

inputs:

- type: log

paths:

- '/var/log/myapp/*.log'

在这个例子中,Filebeat将会监控/var/log/myapp/目录下所有以.log结尾的文件。

其次,需要在log input部分配置Filebeat如何解析这些日志。例如,如果日志是JSON格式的,可以这样配置:

filebeat:

inputs:

- type: log

paths:

- '/var/log/myapp/*.log'

processors:

- decode_json_fields:

fields: ["message"]

在这个例子中,Filebeat将会尝试将message字段的内容解析为JSON。如果解析成功,解析后的数据将会被发送到Filebeat的输出部分。如果解析失败,原始的日志数据也会被发送到输出部分。

以上是基本的配置方式,具体的配置可能会因日志格式、需求等因素而有所不同。更多详细信息可以参考Filebeat的官方文档。

Kibana中设置日志解析

在Kibana中设置日志解析主要涉及到以下几个步骤:

- 打开Kibana并导航到“Management”选项卡。

- 在“Management”界面中,找到并点击“Index Patterns”选项。

- 在“Index Patterns”界面中,点击“Create Index Pattern”按钮。

- 在“Create Index Pattern”界面中,输入索引模式的名称,并选择正确的索引类型。通常情况下,对于日志数据,我们选择“Logstash”作为索引类型。

- 在“Field Format”选项中,可以选择适当的日期和时间格式,以确保日志时间戳能够正确显示。

- 在“Fields”选项中,可以查看并编辑索引模式中的字段。在这里,你可以根据需要添加、删除或修改字段。如果日志数据包含JSON对象,你还可以在“Fields”选项中配置JSON字段解析。

- 配置完成后,点击“Save Index Pattern”按钮保存设置。

现在,你已经在Kibana中成功设置了日志解析。当你的日志数据被索引到Elasticsearch并加载到Kibana时,它们将根据你设置的解析规则进行解析和显示。你可以使用Kibana的查询和过滤功能进一步筛选和分析日志数据。

安装步骤

安装Filebeat

- 下载和安装key文件。使用以下命令:

sudo rpm --import https://packages.elastic.co/GPG-KEY-elasticsearch。 - 创建yum源文件。使用以下命令:

sudo vim /etc/yum.repos.d/elastic.repo。然后在该文件中添加以下内容:[elastic-6.x],name=Elastic repositoryfor6.x packages,baseurl=https://artifacts.elastic.co/packages/6.x/yum,gpgcheck=1,gpgkey=https://artifacts.elastic.co/GPG-KEY-elasticsearch,enabled=1,autorefresh=1,type=rpm-md。 - 安装Filebeat。使用以下命令:

sudo yum install filebeat。安装路径为/usr/share。 - 解压并重命名目录(如果需要)。

- 创建配置文件。使用以下命令:

vim /home/filebeat/filebeat_nginx.yml。然后将以下内容添加到该文件中:

filebeat:

inputs:

setup.template.settings:

index.number_of_shards: 3

filebeat.config.modules:

path: ${path.config}/modules.d/*.yml

reload.enabled: false

output.elasticsearch:

hosts: ["192.168.2.246:9200"]

setup.kibana:

hosts: ["192.168.2.246:5601"]

注意将IP地址部分改成Elasticsearch服务器的IP地址。

6. 进入filebeat目录。使用以下命令:cd /home/filebeat/。

7. 开启nginx模块。执行以下命令:sudo filebeat modules enable nginx。

8. 编辑nginx模块配置文件。使用以下命令:sudo vim /etc/filebeat/modules/nginx/nginx.yml。然后添加以下内容:

filebeat:

inputs:

- type: log

paths:

- '/var/log/nginx/*.log'

- 重启Filebeat服务。使用以下命令:

sudo systemctl restart filebeat。现在,Filebeat应该已经配置完毕并正在运行。

安装监控

要监控Filebeat,可以使用以下方法:

- 查看Filebeat日志:Filebeat的日志输出通常包括错误消息和警告,可以帮助你了解Filebeat的运行状态。默认情况下,Filebeat日志输出到标准输出(stdout),你可以通过查看其日志文件或使用命令行工具(如

cat或tail)来查看日志内容。 - 使用Filebeat的status API:Filebeat提供了一个HTTP API,可以用来获取Filebeat的运行状态和配置信息。你可以使用

curl或类似的工具来发送HTTP请求并查看返回的状态信息。例如,你可以使用以下命令来获取Filebeat的状态信息:

curl localhost:9673/status

- 使用监控工具:如果你使用的是具有日志监控功能的系统或平台,例如ELK Stack(Elasticsearch、Logstash、Kibana)或Prometheus等,你可以将Filebeat与这些工具集成,并使用它们提供的监控和报警功能来监控Filebeat的运行状态和性能指标。

综上所述,你可以通过查看Filebeat日志、使用Filebeat的status API和使用监控工具来监控Filebeat的运行状态和性能指标。

通过prometheus监控

Prometheus是一个开源的监控工具,可以用于收集和存储各种系统和服务的数据,并且提供实时的监控和报警功能。要使用Prometheus监控Filebeat,可以按照以下步骤进行设置:

- 安装和配置Prometheus:首先,你需要从Prometheus的官方网站下载并安装Prometheus。然后,你需要配置Prometheus的监听端口和数据存储路径等信息。

- 创建Filebeat的配置文件:在Filebeat的配置文件中,你需要指定要监控的目标和输出方式。例如,你可以使用以下配置来将Filebeat的数据输出到Prometheus:

output.prometheus:

hosts: ["localhost:9673"]

- 启动Filebeat:启动Filebeat后,它将开始收集指定的日志数据,并将其发送到Prometheus。

- 配置Prometheus的抓取器:Prometheus使用抓取器(scrape)来收集数据。你需要配置一个抓取器来指定要收集的指标和目标地址。在Prometheus的配置文件中,你可以添加以下内容来配置抓取器:

scrape_configs:

- job_name: 'filebeat'

static_configs:

- targets: ['localhost:9673']

- 启动Prometheus:启动Prometheus后,它将开始运行抓取器并收集Filebeat的数据。你可以使用Prometheus的Web界面或命令行工具来查看收集到的数据和监控结果。

需要注意的是,以上步骤仅提供了一个基本的示例,实际设置可能因系统环境和需求而有所不同。你可以根据自己的实际情况进行调整和配置。

Filebeat和Logstash的主要区别

Filebeat和Logstash都是用于日志收集的工具,但有以下区别:

- 语言:Logstash是基于JVM的,而Filebeat是使用Golang编写的。

- 轻量级:与Logstash相比,Filebeat更轻量级,占用资源更少。

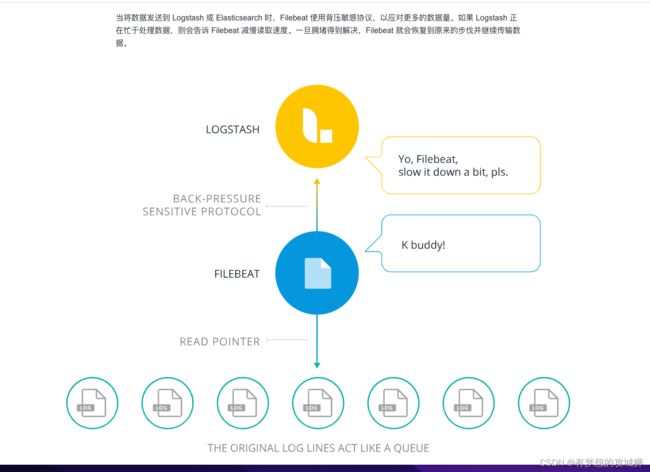

- 过滤能力:Logstash具有filter功能,能过滤分析日志。Filebeat可以把数据传输给Logstash进行数据过滤处理,这个机制被称为背压机制。

Filebeat和Logstash都具有日志收集功能,但在语言、资源占用和过滤能力方面存在区别。