大数据技术学习笔记(四)—— HDFS

目录

- 1 HDFS 概述

-

- 1.1 HDFS 背景与定义

- 1.2 HDFS 优缺点

- 1.3 HDFS 组成架构

- 1.4 HDFS 文件块大小

- 2 HDFS的shell操作

-

- 2.1 上传

- 2.2 下载

- 2.3 HDFS直接操作

- 3 HDFS的客户端操作

-

- 3.1 Windows 环境准备

- 3.2 获取 HDFS 的客户端连接对象

- 3.3 HDFS文件上传

- 3.4 HDFS文件下载

- 3.5 HDFS删除文件和目录

- 3.6 HDFS文件更名和移动

- 3.7 HDFS文件详情查看

- 3.8 HDFS文件和文件夹判断

- 4 HDFS的数据流

-

- 4.1 HDFS写数据流程

-

- 4.1.1 剖析文件写入流程

- 4.1.2 机架感知(副本存储节点选择)

- 4.1.3 网络拓扑-节点距离计算

- 4.2 HDFS读数据流程

- 5 NameNode、SecondaryNameNode

-

- 5.1 NN与2NN工作机制

- 5.2 Fsimage和Edits解析

- 5.3 CheckPonit时间设置

- 5.4 NameNode故障处理

- 5.5 集群安全模式

- 5.6 NameNode多目录配置

- 6 DataNode

-

- 6.1 DataNode 工作机制

- 6.2 数据完整性

- 6.3 掉线时限参数设置

- 6.4 服役新数据节点

- 6.5 退役旧数据节点

-

- 6.5.1 添加白名单和黑名单

- 6.5.2 黑名单退役

- 6.6 DataNode多目录配置

1 HDFS 概述

1.1 HDFS 背景与定义

随着数据量越来越大,在一个操作系统中存不下所有的数据,那么就分配到更多的操作系统管理的磁盘中,但是这样不方便管理和维护,迫切需要一种系统来管理多台机器上的文件,这就是分布式文件管理系统。HDFS只是分布式管理系统中的一种。

HDFS(Hadoop Distributed File System),是一个文件系统,用于存储文件,通过目录树来定位文件;其次,其是分布式的,由很多服务器联合起来实现其功能,集群中的服务器有各自的角色。

HDFS 的使用场景:适合一次写入,多次读出的场景,且不支持文件的修改(但可追加)。适合用来做数据分析,并不适合用来做网盘应用。

1.2 HDFS 优缺点

(1)优点

- 高容错性

- 数据自动保存多个副本,通过增加副本的方式,提高容错性

- 某一个副本丢失后,它可以自动恢复

- 适合处理大数据

- 数据规模:能够处理数据规模达到GB、TB,甚至PB级别的数据

- 文件规模 :能够处理百万规模以上的文件数量,数量相当之大

- 可构建在廉价的机器上,通过多副本机制,提高可靠性

(2)缺点

- 不适合低延时的数据访问,如毫秒级的存储数据是做不到的

- 无法高效的对大量小文件进行存储

- 无法存储大量小文件的话,它会占用 NameNode 大量的内存来存储文件目录和块信息,这样是不可取的,因为NameNode的内存总是有限的

- 小文件存储的寻址时间会超过读取时间,它违反了HDFS的设计目标

- 不支持并发写入、文件的随机修改

- 一个文件只能有一个写,不允许多个线程同时写

- 仅支持数据的追加(append),不支持文件的随机修改

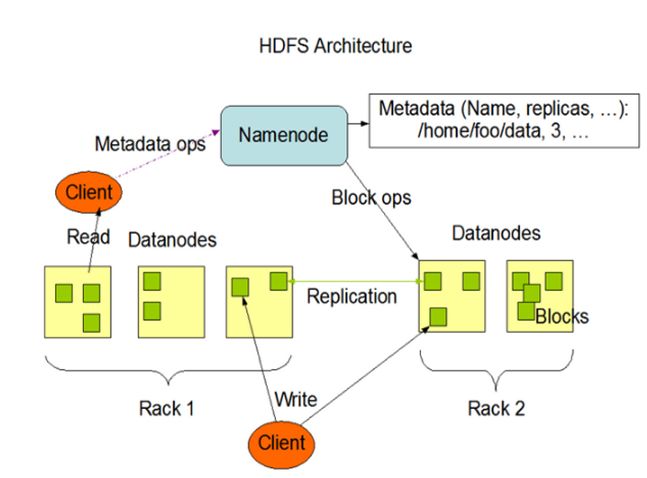

1.3 HDFS 组成架构

NameNode(nn):就是Master,它是一个主管、管理者

- 管理HDFS的名称空间

- 配置副本策略

- 管理数据块(Block)映射信息

- 处理客户端读写请求

DataNode(dn):就是Slave,NameNode下达的命令,DataNode执行实际的操作

- 存储实际的数据块

- 执行数据块的读/写操作

SecondaryNameNode:并非NameNode的热备,当NameNode挂掉的时候,它并不能马上替换NameNode并提供服务。

- 辅助NameNode,分担其工作量,比如定期合并Fsimage和Edits,并推送给NameNode

- 在紧急情况下,可辅助恢复NameNode

Client:客户端

- 文件切分,文件上传HDFS时候,Clinet将文件切分成一个个Block,然后进行上传

- 与NameNode交互,获取文件的位置信息

- 与DataNode交互,读取或写入数据

- Clinet提供一些命令来管理HDFS,比如NameNode的格式化

- Clinet提供一些命令来访问HDFS,比如对HDFS增删改查操作

1.4 HDFS 文件块大小

思考:为什么块的大小不能设置太小,也不能设置太大?

- 如果块设置太小,会增加寻址时间,程序一直在找块的开始位置

- 如果块设置太大,从磁盘传输数据的时间会明显大于定位这个块开始位置所需的时间,导致程序在处理这块数据时,会非常慢

HDFS块的大小设置主要取决于磁盘传输速率

2 HDFS的shell操作

hadoop fs 具体命令ORhdfs dfs 具体命令

启动 Hadoop 集群

[huwei@hadoop101 ~]$ start-dfs.sh

[huwei@hadoop102 ~]$ start-yarn.sh

Web 端查看 HDFS 的 NameNode

- 浏览器中输入:

http://hadoop101:9870

2.1 上传

首先在HDFS根目录下手动创建/sanguo/shuguo的文件夹,如下图所示

(1)-moveFromLocal:从本地 剪切 粘贴到 HDFS

[huwei@hadoop101 ~]$ touch kongming.txt

[huwei@hadoop101 ~]$ hdfs dfs -moveFromLocal ./kongming.txt /sanguo/shuguo

(2) -copyFromLocal:从本地文件系统中 拷贝 文件到 HDFS 路径去

-put:等同于 copyFromLocal

[huwei@hadoop101 ~]$ touch liubei.txt

[huwei@hadoop101 ~]$ hdfs dfs -copyFromLocal ./liubei.txt /sanguo/shuguo

(3) -appendToFile:追加 一个本地文件到HDFS已经存在的文件末尾

[huwei@hadoop101 ~]$ vim liubei.txt

三顾茅庐

[huwei@hadoop101 ~]$ hdfs dfs -appendToFile liubei.txt /sanguo/shuguo/liubei.txt

2.2 下载

(1) -copyToLocal:从HDFS拷贝到本地

-get:等同于copyToLocal,就是从HDFS下载文件到本地

[huwei@hadoop101 ~]$ hdfs dfs -copyToLocal /sanguo/shuguo/kongming.txt ./

(2) -getmerge:合并下载多个文件(将HDFS中多个文件内容合并在一个文件中,并下载)

[huwei@hadoop101 ~]$ hdfs dfs -getmerge /sanguo/shuguo/liubei.txt /sanguo/shuguo/kongming.txt ./kongliu.txt

也可以这样写

[huwei@hadoop101 ~]$ hdfs dfs -getmerge /sanguo/shuguo/* ./kongliu.txt

查看合并文件内容

[huwei@hadoop101 ~]$ cat kongliu.txt

三顾茅庐

2.3 HDFS直接操作

(1) -ls: 显示目录信息

[huwei@hadoop101 ~]$ hdfs dfs -ls /sanguo/shuguo

Found 2 items

-rw-r--r-- 3 huwei supergroup 0 2023-10-23 16:20 /sanguo/shuguo/kongming.txt

-rw-r--r-- 3 huwei supergroup 13 2023-10-23 16:28 /sanguo/shuguo/liubei.txt

(2)-mkdir:在HDFS上创建目录

[huwei@hadoop101 ~]$ hdfs dfs -mkdir /sanguo/weiguo

注意上述命令没有加参数

-p不会报错,是因为sanguo文件夹已经存在了,但若父目录不存在,一定需要加上参数-p

[huwei@hadoop101 ~]$ hdfs dfs -mkdir -p /xiyou/suwukong

(3) -cat:显示文件内容

[huwei@hadoop101 ~]$ hdfs dfs -cat /sanguo/shuguo/liubei.txt

三顾茅庐

(4) -chgrp 、-chmod、-chown:Linux文件系统中的用法一样,修改文件所属权限

[huwei@hadoop101 ~]$ hdfs dfs -chmod 666 /sanguo/shuguo/kongming.txt

[huwei@hadoop101 ~]$ hdfs dfs -ls /sanguo/shuguo

也可以在Web端界面手动修改

(5) -cp :从HDFS的一个路径拷贝到HDFS的另一个路径

[huwei@hadoop101 ~]$ hdfs dfs -cp /sanguo/shuguo/kongming.txt /xiyou

(6) -mv:在HDFS目录中移动文件

[huwei@hadoop101 ~]$ hdfs dfs -mv /sanguo/shuguo/liubei.txt /xiyou

同样,mv也可以对文件重命名

[huwei@hadoop101 ~]$ hdfs dfs -mv /sanguo/shuguo/kongming.txt /sanguo/shuguo/guanyu.txt

(7) -tail:显示一个文件的末尾 1kb 的数据

我们上传一个稍大点的文件 xiaoaojianghu.txt

[huwei@hadoop101 ~]$ hdfs dfs -tail /xiaoaojianghu.txt

查看前10行

[huwei@hadoop101 ~]$ hdfs dfs -head /xiaoaojianghu.txt

注意这里的 head 不支持指定

-n

(8) -rm:删除文件或文件夹

[huwei@hadoop101 ~]$ hdfs dfs -rm /xiyou/kongming.txt

[huwei@hadoop101 ~]$ hdfs dfs -rm -r /xiyou

注意 HDFS 中删除文件夹中

-r与-f不能写成-rf,要写必须单独写,而且也没必要写-f,因为也不会有删除确认

(9)-rmdir:删除空目录

[huwei@hadoop101 ~]$ hdfs dfs -rmdir /sanguo/weiguo

(10) -du:统计文件夹的大小信息

[huwei@hadoop101 ~]$ hdfs dfs -du /

0 0 /sanguo

3041059 9123177 /xiaoaojianghu.txt

两列文件大小是三倍的关系,因为副本数有三个

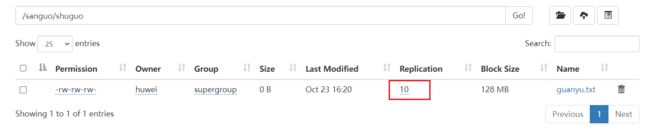

(11) -setrep:设置HDFS中文件的副本数量

[huwei@hadoop101 ~]$ hdfs dfs -setrep 10 /sanguo

Replication 10 set: /sanguo/shuguo/guanyu.txt

这里设置的副本数只是记录在NameNode的元数据中,是否真的会有这么多副本,还得看DataNode的数量。因为目前只有3台设备,最多也就3个副本,只有节点数的增加到10台时,副本数才能达到10。

3 HDFS的客户端操作

3.1 Windows 环境准备

hadoop下载地址,将压缩包解压到安装目录,注意安装目录的路径中不要有空格。

(1) 配置 HADOOP_HOME 环境变量

(2) 配置Path环境变量

(3) cmd 终端输入hadoop version 测试

(4) 创建一个Maven工程,并导入相应的依赖坐标+日志添加

在pom.xml文件中添加

<dependencies>

<dependency>

<groupId>junitgroupId>

<artifactId>junitartifactId>

<version>4.12version>

dependency>

<dependency>

<groupId>org.apache.logging.log4jgroupId>

<artifactId>log4j-slf4j-implartifactId>

<version>2.12.0version>

dependency>

<dependency>

<groupId>org.apache.hadoopgroupId>

<artifactId>hadoop-clientartifactId>

<version>3.1.3version>

dependency>

dependencies>

在项目的 src/main/resources目录下,新建一个文件,命名为log4j2.xml,在文件中填入

<Configuration status="error" strict="true" name="XMLConfig">

<Appenders>

<Appender type="Console" name="STDOUT">

<Layout type="PatternLayout"

pattern="[%p] [%d{yyyy-MM-dd HH:mm:ss}][%c{10}]%m%n" />

Appender>

Appenders>

<Loggers>

<Logger name="test" level="info" additivity="false">

<AppenderRef ref="STDOUT" />

Logger>

<Root level="info">

<AppenderRef ref="STDOUT" />

Root>

Loggers>

Configuration>

(3)创建包名和类

3.2 获取 HDFS 的客户端连接对象

public class hdfsTest {

private FileSystem fs;

/**

* 获取 hdfs的客户端连接对象

*/

@Before

public void init() throws URISyntaxException, IOException, InterruptedException {

Configuration configuration = new Configuration();

configuration.set("dfs.replication", "2");

URI uri = new URI("hdfs://hadoop101:9820");

String user = "huwei";

fs = FileSystem.get(uri, configuration, user);

}

/**

* 关闭资源

*/

@After

public void close() throws IOException {

fs.close();

}

/* @Test

public void testMkdirs() throws IOException, InterruptedException, URISyntaxException {

// 获取文件系统对象

Configuration configuration = new Configuration();

configuration.set("dfs.replication", "2");

URI uri = new URI("hdfs://hadoop101:9820");

String user = "huwei";

FileSystem fs = FileSystem.get(uri, configuration, user);

// 在 Java 中,每个对象都有一个 getClass() 方法,它返回对象所属的类的 Class 对象。

// 然后,可以调用 Class 对象的 getName() 方法来获取类的全限定名(包括包名和类名)。

System.out.println(fs.getClass().getName());

// 关闭资源

fs.close();

}*/

}

ClassPath下的用户自定义配置文件

参数优先级排序:(1)客户端代码中设置的值 >(2)ClassPath下的用户自定义配置文件 >(3)然后是服务器的自定义配置(xxx-site.xml) >(4)服务器的默认配置(xxx-default.xml)

3.3 HDFS文件上传

/**

* 上传文件

*/

@Test

public void testCopyToLocalFile() throws IOException {

//参数1 是否删除原文件

//参数2 若HDFS中已存在同名文件,是否覆盖

//参数3 本地原文件路径

//参数4 hdfs目标路径

fs.copyFromLocalFile(false, true, new Path("E:\\googleFile\\image.png"),new Path("/"));

}

3.4 HDFS文件下载

/**

* 下载文件

*/

@Test

public void testCopyToLocalFile() throws IOException {

//参数1 是否删除原文件

//参数2 hdfs原文件路径

//参数3 本地目标路径

//参数4 是否开启文件校验(false 同时下载校验文件,true 仅下载原文件)

fs.copyToLocalFile(false, new Path("/sanguo"), new Path("E:\\googleFile"), false);

}

3.5 HDFS删除文件和目录

/**

* 删除文件或目录

*/

@Test

public void testDelete() throws IOException {

//参数1 要删除文件的路径

//参数2 是否递归删除

// fs.delete(new Path("/sanguo/hello.txt"), true);// 仅删除hello.txt这个文件

fs.delete(new Path("/sanguo"), true);// 删除sanguo文件夹以及其下的文件

}

3.6 HDFS文件更名和移动

/**

* 文件的更名或移动

*/

@Test

public void testRename() throws IOException {

// 移动文件

// fs.rename(new Path("/hello.txt"), new Path("/sanguo"));

// 更改文件名

fs.rename(new Path("/sanguo/hello.txt"), new Path("/sanguo/hi.txt"));

}

3.7 HDFS文件详情查看

/**

* 查看文件详情

*/

@Test

public void testListFiles() throws IOException {

//参数1 文件的路径

//参数2 是否递归查看

RemoteIterator<LocatedFileStatus> listFiles = fs.listFiles(new Path("/"), true);

while(listFiles.hasNext()){

LocatedFileStatus fileStatus = listFiles.next();

System.out.println("文件名:"+fileStatus.getPath().getName());

System.out.println("块大小:"+fileStatus.getBlockSize());

System.out.println("副本数:"+fileStatus.getReplication());

System.out.println("权限信息:"+fileStatus.getPermission());

}

}

3.8 HDFS文件和文件夹判断

/**

* 判断是文件还是目录

*/

@Test

public void testListStatus() throws IOException {

FileStatus[] listStatus = fs.listStatus(new Path("/"));

for (FileStatus status : listStatus) {

if (status.isDirectory()) {

System.out.println("DIR:" + status.getPath().getName());

} else {

System.out.println("FILE:" + status.getPath().getName());

}

}

}

4 HDFS的数据流

4.1 HDFS写数据流程

4.1.1 剖析文件写入流程

- 客户端通过

Distributed FileSystem模块向NameNode请求上传文件,NameNode检查目标文件是否已存在,操作用户是否有权限。 NameNode返回是否可以上传。- 客户端请求上传第一个

Block并请求上传到哪几个DataNode服务器上。 NameNode返回3个DataNode节点,分别为dn1、dn2、dn3。- 客户端通过

FSDataOutputStream模块请求dn1上传数据,dn1收到请求会继续调用dn2,然后dn2调用dn3,将这个通信管道建立完成。 dn3、dn2、dn1逐级应答客户端。- 客户端开始往

dn1上传第一个Block(先从磁盘读取数据放到一个本地内存缓存),以Packet(64KB)为单位,dn1收到一个Packet就会传给dn2,dn2传给dn3;dn1每传一个Packet会放入一个应答队列等待应答。(每个packet又分为多个chunk) - 当一个

Block传输完成之后,客户端再次请求NameNode上传第二个Block。(重复执行 3-7 步)。

4.1.2 机架感知(副本存储节点选择)

步骤 4 中,

NameNode根据请求返回DataNode节点的策略是什么?

- 如果当前客户端所在机器有

DataNode节点,那就返回当前机器DN1,否则从集群中随机一台。根据第一台机器的位置,然后再其他机架上随机一台,在第二台机器所在机架上再随机一台。- 目的是为了提高数据的可靠性,同时一定程度也保证数据传输的效率

机架:存放服务器的架子,也叫机柜。一般来说一个机房有很多机柜,每个机柜有很多服务器。

4.1.3 网络拓扑-节点距离计算

步骤 5 中,客户端为什么要串行建立通信管道?

- 在 Hadoop 中,最珍惜的资源莫过于 内存 和 IO。客户端串行建立通信管道,本质上就是为了降低客户端的IO开销。

步骤 5 中,客户端建立通信通道的时候如何确定和哪一台

DataNode先建立连接?数据传输的时候如何保证数据成功?

- 客户端建立通信通道的时候会找离客户端 最近 (网络拓扑距离)的一台机器先建立通道。

- 数据传输的时候,采用了 ack 回执的策略保证了数据完整成功上传。

在 HDFS 写数据的过程中,NameNode 会选择距离待上传数据最近距离的 DataNode 接收数据。那么这个最近距离怎么计算呢?

节点距离:两个节点到达最近的共同祖先的距离总和。

例如,假设有数据中心 d1 机架 r1 中的节点 n1 。该节点可以表示为 /d1/r1/n1。利用这种标记,这里给出四种距离描述。

4.2 HDFS读数据流程

- 客户端通过

Distributed FileSystem向NameNode请求下载文件,NameNode通过查询元数据,找到文件块所在的DataNode地址。 - 挑选一台

DataNode(就近原则,然后随机)服务器,请求读取数据。 DataNode开始传输数据(以块为单位)给客户端(从磁盘里面读取数据输入流,以Packet为单位来做校验)。- 客户端以

Packet为单位接收,先在本地缓存,然后写入目标文件。

5 NameNode、SecondaryNameNode

5.1 NN与2NN工作机制

-

第一阶段:

NameNode启动

(1)第一次启动NameNode格式化后,创建Fsimage和Edits文件。如果不是第一次启动,直接加载Fsimage和Edits文件到内存。

(2)客户端对元数据进行增删改的请求。

(3)NameNode记录操作日志,更新滚动日志。

(4)NameNode在内存中对元数据进行增删改。 -

第二阶段:

Secondary NameNode工作

(1)Secondary NameNode询问NameNode是否需要CheckPoint。直接带回NameNode是否检查结果。

(2)Secondary NameNode请求执行CheckPoint。

(3)NameNode滚动正在写的Edits日志。

(4)将滚动前的Fsimage和Edits文件拷贝到Secondary NameNode。

(5)Secondary NameNode加载Fsimage和Edits文件到内存,并合并。

(6)生成新的镜像文件fsimage.chkpoint。

(7)拷贝fsimage.chkpoint到NameNode。

(8)NameNode将fsimage.chkpoint重新命名成fsimage。

NN和2NN工作机制详解:

NameNode 启动时,先滚动 Edits 并生成一个空的 edits.inprogress,然后加载 Edits 和 Fsimage 到内存中,此时 NameNode 内存就持有最新的元数据信息。Client 开始对 NameNode 发送元数据的增删改的请求,这些请求的操作首先会被记录到edits.inprogress 中(查询元数据的操作不会被记录在 Edits 中,因为查询操作不会更改元数据信息),如果此时 NameNode 挂掉,重启后会从 Edits 中读取元数据的信息。然后,NameNode会在内存中执行元数据的增删改的操作。

由于Edits中记录的操作会越来越多,Edits文件会越来越大,导致NameNode在启动加载Edits时会很慢,所以需要对Edits和Fsimage进行合并(所谓合并,就是将Edits和Fsimage加载到内存中,照着Edits中的操作一步步执行,最终形成新的Fsimage)。SecondaryNameNode的作用就是帮助NameNode进行Edits和Fsimage的合并工作。

SecondaryNameNode首先会询问NameNode是否需要CheckPoint(触发CheckPoint需要满足两个条件中的任意一个,定时时间到和Edits中数据写满了)。直接带回NameNode是否检查结果。SecondaryNameNode执行CheckPoint操作,首先会让NameNode滚动Edits并生成一个空的edits.inprogress,滚动Edits的目的是给Edits打个标记,以后所有新的操作都写入edits.inprogress,其他未合并的Edits和Fsimage会拷贝到SecondaryNameNode的本地,然后将拷贝的Edits和Fsimage加载到内存中进行合并,生成fsimage.chkpoint,然后将fsimage.chkpoint拷贝给NameNode,重命名为Fsimage后替换掉原来的Fsimage。NameNode在启动时就只需要加载之前未合并的Edits和Fsimage即可,因为合并过的Edits中的元数据信息已经被记录在Fsimage中。

5.2 Fsimage和Edits解析

Fsimage:NameNode内存中元数据序列化后形成的文件。

Edits:记录客户端更新元数据信息的每一步操作(可通过Edits运算出元数据)

NameNode中的元数据是存储在哪里的?

首先,我们做个假设,如果存储在 NameNode 节点的磁盘中,因为经常需要进行随机访问,还有响应客户请求,必然是效率过低。因此,元数据需要存放在内存中。但如果只存在内存中,一旦断电,元数据丢失,整个集群就无法工作了。最终的解决方案: 磁盘 + 内存。因此,产生在磁盘中备份元数据的 FsImage。

内存中的元数据和磁盘中的元数据如何进行同步?(元数据的维护策略)

这样又会带来新的问题,当在内存中的元数据更新时,如果同时更新 FsImage,就会导致效率过低,但如果不更新,就会发生一致性问题,一旦NameNode节点断电,就会产生数据丢失。因此,引入Edits文件(只进行追加操作,效率很高)。每当元数据有更新或者添加元数据时,修改内存中的元数据并追加到Edits中。这样,一旦NameNode节点断电,可以通过FsImage和Edits的合并,合成元数据。

谁负责

FsImage和Edits的合并?

SecondaryNamenode会检测本地时间,每隔1个小时会主动对NameNode的FsImage和Edits文件进行一次合并(定期进行FsImage和Edits的合并)。合并的时候,首先会通知NameNode,这时候NameNode就会停止对正在使用的Edits文件的追加,同时会新建一个新的Edits日志文件,保证NameNode的正常工作。接下来SecondaryNamenode 会把NameNode本地的FsImage和Edits文件拉取SecondaryNamenode的本地,在内存中对二者进行合并,最后产生最新FsImage文件。把最新的FsImage文件再发送给NameNode的本地。注意还有一个情况,当NameNode的Edits文件中的操作次数累计达到100万次,即便还没到1小时,SecondaryNamenode(每隔60秒会检测一次NameNode的Edits文件的操作次数)也会进行合并。 SecondaryNamenode 也会自己把最新的FsImage文件备份一份。

找到NameNode元数据的存放位置

[huwei@hadoop101 ~]$ cd /opt/module/hadoop-3.1.3/data/dfs/name/current/

[huwei@hadoop101 current]$ ll

找到SecondaryNamenode 元数据的存放位置

[huwei@hadoop103 ~]$ cd /opt/module/hadoop-3.1.3/data/dfs/namesecondary/current/

[huwei@hadoop103 current]$ ll

可以发现,

NameNode元数据和SecondaryNamenode元数据信息基本一致,但SecondaryNamenode没有正在使用编辑日志文件以及seen_txid文件,所以当元数据丢失,通过SecondaryNamenode去恢复,是不能保证万无一失的恢复过来的(尤其是当NameNode正在使用编辑日志文件已经记录了一些操作)

主要文件介绍:

Fsimage文件:HDFS文件系统元数据的一个永久的检查点,其中会包含HDFS文件系统所有的目录和文件 inode 的序列化信息;Edits文件:存放HDFS文件系统的所有更新操作的路径,文件系统客户端执行的所有写操作首先会被记录到该文件中seen_txid文件:文件中保存的是一个数字,就是最后一个edits_的数字

oiv 查看 Fsimage 文件

基本语法

hdfs oiv -p 文件类型 -i 镜像文件 -o 转换后文件输出路径

将 Fsimage 文件转为 xml 文件

[huwei@hadoop101 current]$ hdfs oiv -p XML -i fsimage_0000000000000000252 -o fsimage.xml

oev 查看Edits文件

基本语法

hdfs oev -p 文件类型 -i 编辑日志 -o 转换后文件输出路径

[huwei@hadoop101 current]$ hdfs oev -p XML -i edits_inprogress_0000000000000000269 -o edits.xml

5.3 CheckPonit时间设置

[hdfs-default.xml]文件中设置了 CheckPonit

(1) 通常情况下,SecondaryNameNode每隔一小时执行一次。

<property>

<name>dfs.namenode.checkpoint.periodname>

<value>3600svalue>

property>

(2) 一分钟检查一次操作次数,当操作次数达到1百万时,SecondaryNameNode执行一次。

<property>

<name>dfs.namenode.checkpoint.txnsname>

<value>1000000value>

<description>操作动作次数description>

property>

<property>

<name>dfs.namenode.checkpoint.check.periodname>

<value>60svalue>

<description> 1分钟检查一次操作次数description>

property >

5.4 NameNode故障处理

NameNode 故障后,可以采用如下方法恢复数据。

将SecondaryNameNode中数据拷贝到NameNode存储数据的目录

(1)杀死NameNode进程

kill -9 NameNode进程号

(2)删除NameNode存储的数据(/opt/module/hadoop-3.1.3/data/dfs/name/current)

[huwei@hadoop101 ~]$ rm -rf /opt/module/hadoop-3.1.3/data/dfs/name/current/*

(3)拷贝SecondaryNameNode中数据到原NameNode存储数据目录

[huwei@hadoop103 current]$ scp -r ./* huwei@hadoop101:/opt/module/hadoop-3.1.3/data/dfs/name/current

(4)重新启动NameNode

[huwei@hadoop101 ~]$ hdfs --daemon start namenode

5.5 集群安全模式

5.6 NameNode多目录配置

NameNode的本地目录可以配置成多个,且每个目录存放内容相同,增加了可靠性

(1) 在 hdfs-site.xml 文件中添加如下内容

[huwei@hadoop101 ~]$ cd /opt/module/hadoop-3.1.3/etc/hadoop

<property>

<name>dfs.namenode.name.dirname>

<value>file://${hadoop.tmp.dir}/dfs/name1,file://${hadoop.tmp.dir}/dfs/name2value>

property>

(2) 停止集群,删除三台节点的data和logs中所有数据

[huwei@hadoop101 hadoop-3.1.3]$ rm -rf data/ logs/

[huwei@hadoop102 hadoop-3.1.3]$ rm -rf data/ logs/

[huwei@hadoop103 hadoop-3.1.3]$ rm -rf data/ logs/

(3) 格式化集群并启动

[huwei@hadoop101 hadoop-3.1.3]$ hdfs namenode –format

[huwei@hadoop101 hadoop-3.1.3]$ start-dfs.sh

(4) 查看结果

[huwei@hadoop101 dfs]$ ll

drwx------. 3 huwei huwei 4096 10月 25 19:28 data

drwxrwxr-x. 3 huwei huwei 4096 10月 25 19:28 name1

drwxrwxr-x. 3 huwei huwei 4096 10月 25 19:28 name2

6 DataNode

6.1 DataNode 工作机制

DataNode 工作机制:

- 一个数据块在DataNode上以文件形式存储在磁盘上,包括两个文件,一个是数据本身,一个是元数据包括数据块的长度,块数据的校验和,以及时间戳。

- DataNode 启动后向 NameNode 注册,通过后,周期性(1小时)的向NameNode上报所有的块信息。

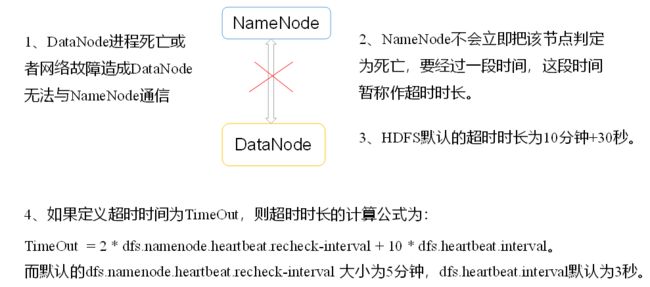

- 心跳是每 3秒 一次,心跳返回结果带有 NameNode 给该DataNode的命令如复制块数据到另一台机器,或删除某个数据块。如果超过10分钟30秒没有收到某个DataNode的心跳,则认为该节点不可用。

- 集群运行中可以安全加入和退出一些机器。

6.2 数据完整性

思考:如果电脑磁盘里面存储的数据是控制高铁信号灯的红灯信号(1)和绿灯信号(0),但是存储该数据的磁盘坏了,一直显示是绿灯,是否很危险?同理DataNode节点上的数据损坏了,却没有发现,是否也很危险,那么如何解决呢?

如下是DataNode节点保证数据完整性的方法。

(1)当DataNode读取Block的时候,它会计算CheckSum。

(2)如果计算后的CheckSum,与Block创建时值不一样,说明Block已经损坏。

(3)Client读取其他DataNode上的Block。

(4)常见的校验算法 crc(32),md5(128),sha1(160)

(5)DataNode在其文件创建后周期验证CheckSum。

6.3 掉线时限参数设置

需要注意的是`hdfs-site.xml` 配置文件中的`heartbeat.recheck.interval`的单位为**毫秒**,`dfs.heartbeat.interval`的单位为**秒**。

<property>

<name>dfs.namenode.heartbeat.recheck-intervalname>

<value>300000value>

property>

<property>

<name>dfs.heartbeat.intervalname>

<value>3value>

property>

6.4 服役新数据节点

随着公司业务的增长,数据量越来越大,原有的数据节点的容量已经不能满足存储数据的需求,需要在原有集群基础上动态添加新的数据节点。

环境准备

- 在hadoop103主机上再克隆一台hadoop104主机

- 修改IP地址和主机名称(重启生效)

- 删除原来HDFS文件系统留存的文件(

/opt/module/hadoop-3.1.3/data和logs)- 不删的话, 持续刷新HDFS的web界面时可以发现hadoop103和hadoop104交替出现,因为hadoop104是通过hadoop103克隆出来的

[huwei@hadoop104 hadoop-3.1.3]$ rm -rf data logs

在 hadoop104 上启动 datanode,此时要么重新配置 etc/hadoop/workers添加hadoop104 ,要么在hadoop104单独启动 datanode,数据信息都是一样的,NameNode会认为二者是同一个

[huwei@hadoop104 ~]$ hdfs --daemon start datanode

此时在HDFS的web界面可以看到4个datanode

6.5 退役旧数据节点

6.5.1 添加白名单和黑名单

白名单和黑名单是 hadoop 管理集群主机的一种机制。

添加到白名单的主机节点,都允许访问 NameNode,不在白名单的主机节点,都会被退出。添加到黑名单的主机节点,不允许访问 NameNode,会在数据迁移后退出。

实际情况下,白名单用于确定允许访问 NameNode的 DataNode节点,内容配置一般与workers文件内容一致。 黑名单用于在集群运行过程中退役 DataNode节点。

配置白名单和黑名单的具体步骤如下:

(1)在NameNode节点的/opt/module/hadoop-3.1.3/etc/hadoop目录下分别创建whitelist 和blacklist文件

[huwei@hadoop101 ~]$ cd /opt/module/hadoop-3.1.3/etc/hadoop

[huwei@hadoop101 hadoop]$ touch whitelist

[huwei@hadoop101 hadoop]$ touch blacklist

在whitelist中添加如下主机名称,假如集群正常工作的节点为 101 102 103 104

hadoop101

hadoop102

hadoop103

hadoop104

黑名单暂时为空。

(2) 在当前目录下的 hdfs-site.xml 配置文件中增加 dfs.hosts和 dfs.hosts.exclude配置参数

<property>

<name>dfs.hostsname>

<value>/opt/module/hadoop-3.1.3/etc/hadoop/whitelistvalue>

property>

<property>

<name>dfs.hosts.excludename>

<value>/opt/module/hadoop-3.1.3/etc/hadoop/blacklistvalue>

property>

(3) 分发配置文件whitelist,blacklist,hdfs-site.xml (注意:104节点也要发一份)

[huwei@hadoop101 hadoop]$ xsync ./

[huwei@hadoop101 hadoop]$ rsync -av ./ huwei@hadoop104:/opt/module/hadoop-3.1.3/etc/hadoop/

(4) 重新启动集群(注意:104节点没有添加到workers,因此要单独起停)

[huwei@hadoop101 ~]$ stop-dfs.sh

[huwei@hadoop101 ~]$ start-dfs.sh

[huwei@hadoop104 ~]$ hdfs --daemon start datanode

(5) 在web浏览器上查看目前正常工作的DN节点

6.5.2 黑名单退役

(1)编辑/opt/module/hadoop-3.1.3/etc/hadoop目录下的blacklist文件

[huwei@hadoop101 hadoop]$ vim blacklist

添加如下主机名称(要退役的节点)

hadoop104

(2) 分发blacklist到所有节点

[huwei@hadoop101 hadoop]$ xsync ./

[huwei@hadoop101 hadoop]$ rsync -av ./ huwei@hadoop104:/opt/module/hadoop-3.1.3/etc/hadoop/

(3) 刷新NameNode

[huwei@hadoop101 hadoop]$ hdfs dfsadmin -refreshNodes

(4) 检查Web浏览器,退役节点的状态为Decommissioning(退役中),说明数据节点正在复制块到其他节点

(5)等待退役节点状态为decommissioned(已退役,所有块已经复制完成),停止该节点及节点资源管理器。

注意:如果副本数是3,服役的节点小于等于3,是不能退役成功的,需要修改副本数后才能退役

注意:不允许白名单和黑名单中同时出现同一个主机名称,既然使用了黑名单blacklist成功退役了hadoop104节点,因此要将白名单whitelist里面的hadoop104去掉。

6.6 DataNode多目录配置

DataNode可以配置成多个目录,每个目录存储的数据不一样。即:数据不是副本

(1) 在hdfs-site.xml文件中添加如下内容

<property>

<name>dfs.datanode.data.dirname>

<value>file://${hadoop.tmp.dir}/dfs/data1,file://${hadoop.tmp.dir}/dfs/data2value>

property>

(2) 停止集群,删除三台节点的data和logs中所有数据。

[huwei@hadoop101 hadoop-3.1.3]$ rm -rf data/ logs/

[huwei@hadoop102 hadoop-3.1.3]$ rm -rf data/ logs/

[huwei@hadoop103 hadoop-3.1.3]$ rm -rf data/ logs/

(3) 格式化集群并启动

[huwei@hadoop101 hadoop-3.1.3]$ hdfs namenode –format

[huwei@hadoop101 hadoop-3.1.3]$ start-dfs.sh

(4)查看结果

[huwei@hadoop101 dfs]$ ll

drwx------. 3 huwei huwei 4096 10月 25 19:57 data1

drwx------. 3 huwei huwei 4096 10月 25 19:57 data2

drwxrwxr-x. 3 huwei huwei 4096 10月 25 19:28 name1

drwxrwxr-x. 3 huwei huwei 4096 10月 25 19:28 name2