自动驾驶学习笔记(十三)——感知基础

#Apollo开发者#

学习课程的传送门如下,当您也准备学习自动驾驶时,可以和我一同前往:

《自动驾驶新人之旅》免费课程—> 传送门

《Apollo Beta宣讲和线下沙龙》免费报名—>传送门

文章目录

前言

传感器

测距原理

坐标系

标定

同步

融合

部署

总结

前言

见《自动驾驶学习笔记(八)——路线规划》

见《自动驾驶学习笔记(九)——车辆控制》

见《自动驾驶学习笔记(十)——Cyber通信》

见《自动驾驶学习笔记(十一)——高精地图》

见《自动驾驶学习笔记(十二)——定位技术》

传感器

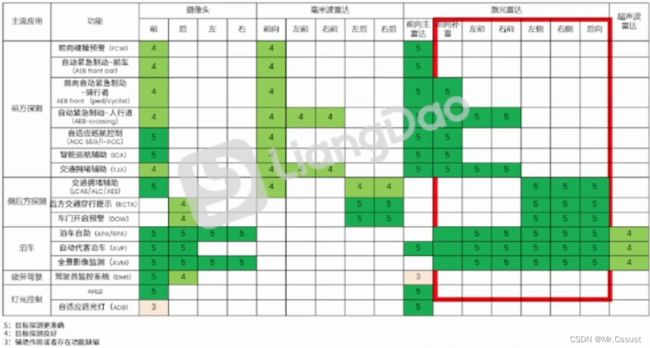

相机、毫米波雷达、激光雷达和超声波雷达这几种传感器的性能对比如下图:

事件相机是近年出现的新型应用,事件相机只观测场景中的“运动”,确切地说是观察场景中的“亮度的变化”。event camera只会在有亮度变化时,输出对应pixel的亮度变化(1或0),具有响应快、动态范围宽、无motion blur等优势,其成像结果如下图所示:

测距原理

时间飞行法(TOF)是主流方案,通过脉冲在目标与雷达之间的飞行时间差计算距离。优势:原理简单,技术及产业链成熟探测距离长,响应快。劣势:计时器精确度要求高,易受环境影响雷达间串扰。

调频连续波法(FMCW)是主流替代方案,通过多普勒效应测量频率差。优势:信噪比高,分辨率高,速度信息,可编码,抗雷达互扰,功耗低,人眼安全。劣势:前沿技术,成熟方案少,产业链初期。

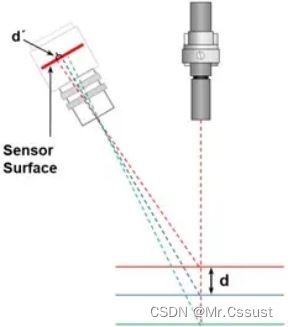

三角测量法,通过将光源与相机配对来捕获三维测量数据。优势:结构简单、测量速度快、具有实时处理能力、使用灵活、适应力强。劣势:在精度以及分辨率上仍然有不足。

坐标系

自动驾驶中各个坐标系的应用如下图所示:

数据坐标系:根据传感器原理不同,每种传感器都会有自己的数据坐标系,如相机将三维世界中的坐标点映射到二维图像平面的像素坐标系。

传感器坐标系:以传感器为中心的三维笛卡尔坐标系。

车辆坐标系:Apollo中采用右-前-天定义。原点:后轴中心为坐标系中点。X:面向车辆前方,右手方向为正。Y:车辆前进方向为正。Z:垂直地面,车顶方向为正。

EUN坐标系的原点在地球表面,x和y轴在当地水平面内,分别指向东和北,z轴朝上,在局部范围不是很大的情况,比如几十km内,我们认为每一个原点的东北天坐标系是平行的。

UTM投影坐标系全称为“通用横轴墨卡托投影”UNIVERSAL TRANSVERSE MERCATOR PROJECTION,是种“等角横轴割圆柱投影”,圆柱割地球于南纬80度、北纬84度两条等高圈,投影后两条相割的经线上没有变形,而中央经线上长度比0.9996。该投影方法按经度分为60个带,每带6度,从西经180度起算。如下图所示为全球的UTM投影,北京所在的区域在第50个投影带上。每个投影带上的一个坐标(x,y,z)可以唯-地表示地球上一个点,高度使用WGS84坐标系统中的大地高度。

Frenet坐标系下,车辆运动可以分解为沿中心线运动和垂直于道路中心线运动两个部分。因此,我们可以使用变量 s和d描述车辆在道路上的位置。s坐标表示沿道路的距离(也称为纵向位移),d坐标表示道路上的左右位置(也称为横向位移)。

标定

传感器标定的目的即是把感知到的周围环境统一到车身坐标系下。

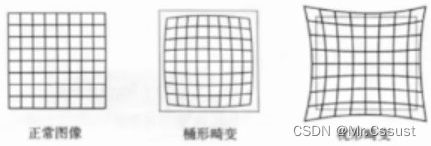

不同模型的传感器后造成不同的数据畸变,例如:小孔模型( Pinhole ),全向相机( Onknidirectional )。畸形的数据如下图所示:

去畸变:校正光线在经过透镜边缘后发生弯折,造成的图像边缘弯曲。

内参标定:图像坐标系到相机坐标系的映射,供应商可提供,或者通过棋盘标定板测定

外参标定:传感器相对于车身或其他传感器坐标系的位姿Rt

同步

各个传感器采样的频率不一致,还需要同步到一个节拍上来使用,如下图所示:

融合

融合是将多传感器检测到的目标在时间和空何两个尺度上达成同一。

时间:每个传感器的频率不一致,如LiDAR是10Hz,Camera是30Hz,Radar是10Hz。

空间:各传感器的感知结果投影到车身坐标系。

融合的的策略有三种,如下图所示:

前融合:原始信号融合,一般用于同类传感器融合,原始信息不损失,计算量大,融合难度大。

特征融合:传感器信号进行独立特征提取后进行融合,最近比较流行BEV。

后融合:每种传感器独立进行感知检测,在结果层进行融合,原始信息损失较大,计算量小,难度低。

部署

不同的自动驾驶功能,应用的传感器部署方案如下图所示:

外资车企的感知部署方案:

自主品牌车企的感知部署方案:

总结

以上就是本人在学习自动驾驶时,对所学课程的一些梳理和总结。后续还会分享另更多自动驾驶相关知识,欢迎评论区留言、点赞、收藏和关注,这些鼓励和支持都将成文本人持续分享的动力。

另外,如果有同在小伙伴,也正在学习或打算学习自动驾驶时,可以和我一同抱团学习,交流技术。

版权声明,原创文章,转载和引用请注明出处和链接,侵权必究!

文中部分图片来源自网络,若有侵权,联系立删。