微机总线地址物理内存地址虚拟内存地址简介

硬件地址的相关概念

Raspberry Pi 发布适用于 ARM 外设的 BCM2835 数据表

地址映射

总线地址

物理地址

虚拟地址

页表和内存管理单元MMU

《 Linux内核设计与实现(第三版)》

树莓派博通BCM2835芯片手册

硬件地址的相关概念

总线地址

32位的操作系统 ,cpu最多只能访问2^32bit,即只能访问4G的内存

64位的操作系统 ,cpu最多只能访问2^64bit,即只能访问8G的内存

物理地址

物理地址又叫硬件的实际地址或绝对地址

虚拟地址

是逻辑地址,有了虚拟地址cpu访问的内存可完全大于8g。程序大都跑在由物理地址映射成的逻辑地址上。

Raspberry Pi 发布适用于 ARM 外设的 BCM2835 数据表

如果您一直在关注 Raspberry Pi 项目,您可能已经注意到与 Broadcom 处理器相关的文档的缺乏。 对于 BCM2835(Raspberry Pi 板中使用的处理器),Broadcom 只有一个简洁的网页。

但 Raspberry Pi 的“超级团队”已经成功获得了 SoC 的(部分)数据表,其中显示了 BCM2835 ARM 外设的详细信息,这正是我们可能需要的。 这仅对使用 Linux(和 u-boot)驱动程序的人有用。

该文档包含有关处理器内存映射的详细信息,如下所示。

它还包含有关以下 ARM 外设的详细信息(寄存器、实现细节等):

- Timers (定时器)

- Interrupt controller (中断控制器)

- GPIO (通用输入输出接口)

- USB

- PCM / I2S

- DMA controller (DMA控制器)

- I2C master (I2C主控)

- I2C / SPI slave (I2C/SPI 从机)

- SPI0, SPI1, SPI2

- PWM (脉宽调制)

- UART0, UART1 (串口)

您可以下载 BCM2835 数据表以获取完整文档。

地址映射

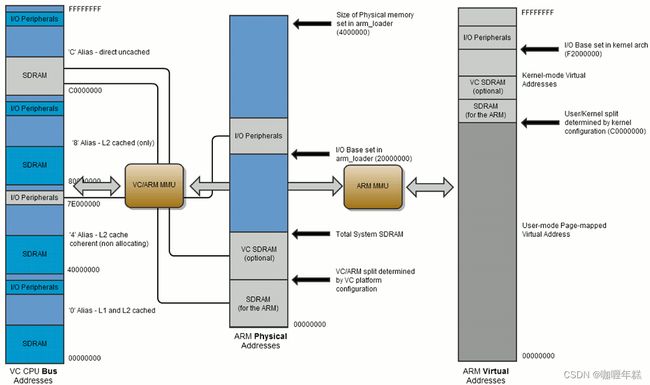

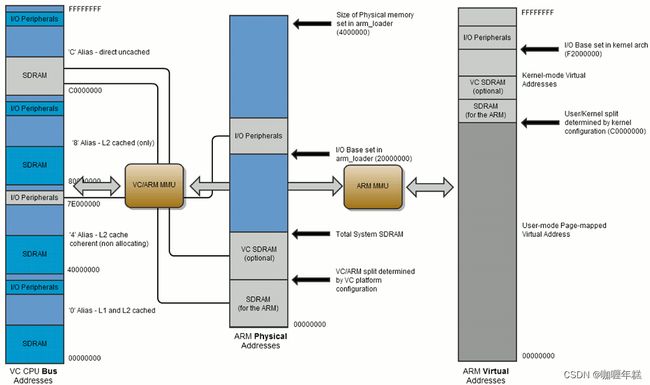

除了 ARM 的内存管理单元( MMU )之外,BCM2835 还增加了一个粗颗粒的 MMU,用于将 ARM 的物理地址映射到系统总线地址。下面这幅图片展示了与之相关的地址空间。

在 ARM Linux 中的地址如下:

- 首先是 ARM 内核规定的虚拟地址

- 之后是 ARM MMU 映射的物理地址

- 之后是 ARM mapping MMU 映射的总线地址

- 最后为适当的外设和 RAM 地址

ARM 虚拟地址 (标准 Linux 内核)

一般情况下,BCM2835 标准的 Linux 内核在存储单元的头部对整个可使用的 RAM 进行了连续的地址映射。该内核被配置为在内核和用户使用的存储空间中分割了 1GB/3GB 的空间。

在 ARM 和 GPU 之间分割的区域用于存放一个支持的 start*.elf 文件,该文件被用作 SD 卡 FAT32 boot 区域的 start.elf。分配给 GPU 的最小存储量为 32MB,但是这将影响其多媒体性能;例如,32MB 的空间小于让 GPU 进行 1080p30 解码所需的缓存空间。

在内核模式下,虚拟地址为 0xC0000000 到 0xEFFFFFFF。

在用户模式下,即在运行 ARM Linux 时,虚拟内存为0x00000000 到 0xBFFFFFFF。

外设(物理地址为0x20000000)被映射到从地址 0xF20000000 处开始的内核虚拟地址空间。因此,在总线地址 0x7Ennnnnn 处的外设在 ARM 内核的虚拟地址为 0xF2nnnnnn。

ARM 物理地址

RAM 的物理地址从 0x00000000 处开始。

- ARM 定义的 RAM 地址从 0x00000000 开始

- 只有在系统被配置为支持内存映射显示时,RAM 中的 VideoCore 部分才会被映射(这是常见情况)

VideoCore MMU 通过 VideoCore (和 VideoCore 外设)将 ARM 物理地址空间映射到总线地址空间。RAM 的总线地址被设置为映射到 VideoCore 内 uncache[^1] 总线地址 0xC0000000 处开始。

外设的物理地址是从 0x20000000 到0x20FFFFFF。外设的总线地址被映射到外设地址总线 0x7E000000 处开始。因此访问地址 0x7Ennnnnn 实际上是在访问物理地址 0x20nnnnnn。

总线地址

在本文中将外设地址称为总线地址。软件直接访问外设时,需要用如上所示的方式将地址转换位物理地址或虚拟地址。软件使用 DMA 访问外设时必须使用总线地址。

软件直接访问 RAM 时,必须使用物理地址(从0x00000000开始)。软件使用 DMA 访问 RAM 时,必须使用总线地址(从0xC0000000开始)。

外设访问内存的正确顺序

BCM2835 系统使用 AMBA AXI 兼容的接口结构。为了保证较低的系统复杂性和较高的数据吞吐量,BCM2835 的 AXI 系统并没有始终按照次序地返回数据[^2]。GPU 具有特殊的逻辑可以不按次序的拷贝数据,但是 ARM 内核并不支持这个逻辑。因此在使用 ARM 访问外设时必须予以警惕。

在访问同一个外设时,数据总是按照次序地返回。但当访问是从一个外设到另一个外设时,数据就可能会错乱。为了确保数据具有正确的顺序,最简单的方法是在代码的临界区域设置内存隔离指令(memory barrier instructions)。如下两点:

- 在首次写外设前设置一个内存写屏障

- 在最后一次读外设之后设置一个内存读屏障

并不是每一次读或写操作之后都需要设置一个内存隔离指令,仅在代码对一个外设读或写操作是跟在对另一不同外设执行读或写操作之后时才需要,这通常是在进入或者退出外设服务函数时。

在代码的任何位置都有可能产生中断,因此你需要有如下防护措施。如果在读一个外设时发生中断,则需要先设置一个内存读屏障,如果在写一个外设时发生中断,则需要在之后设置一个内存写屏障。

[1] BCM2835 上具有一个 128KB 的 L2 cache,主要用于 GPU。访问内存时是经过还是绕过 L2 cache 由总线地址的高两位决定。

[2] 一般来说,在执行两次读操作时,处理器假定数据是按序返回的。所以先从 X 位置处读数据再从 Y 位置处读取数据时,应先返回 X 位置的数据。返回数据的顺序发生错乱将导致错误的结果。例如:

a_status = *pointer_to_peripheral_a;

b_status = *pointer_to_peripheral_b;

没有采取预防措施时,a_status 和 b_status 的数值可能会发生交换。

理论上这可能会导致错误,但实际上这种情况很难发生,因为 AXI 系统可以确保数据始终被按序地送到目的地。因此:

*pointer_to_peripheral_a = value_a;

*pointer_to_peripheral_b = value_b;

一直是正确的。唯一可能出现错误的时候是不同的外设被连接到了相同的外部设备。

内存屏障

内存屏障,也称内存栅栏,内存栅障,屏障指令等,是一类同步屏障指令,是CPU或编译器在对内存随机访问的操作中的一个同步点,使得此点之前的所有读写操作都执行后才可以开始执行此点之后的操作。

大多数现代计算机为了提高性能而采取乱序执行,这使得内存屏障成为必须。

语义上,内存屏障之前的所有写操作都要写入内存;内存屏障之后的读操作都可以获得同步屏障之前的写操作的结果。因此,对于敏感的程序块,写操作之后、读操作之前可以插入内存屏障。

VideoCore

VideoCore 是一个由Alphamosaic Ltd开发并且现在被Broadcom拥有的低功耗移动多媒体指令集架构。二维的DSP架构使其在软件中可以灵活且高效地编解码多媒体数据的同时保持低功耗。该IP核目前仅在Broadcom的SoC中被使用。

总线地址

总线地址(Bus Address)通常是指在计算机体系结构中,硬件设备或内存区域在系统总线上的地址。在不同的硬件架构和操作系统中,总线地址的表示方式可能会有所不同。一般而言,总线地址用于唯一标识系统中的硬件设备或内存位置。

在嵌入式系统或计算机体系结构中,总线地址通常与物理地址或虚拟地址相关联,具体取决于系统的内存管理方案。以下是一些常见的总线地址的相关情境:

-

物理内存地址: 在物理内存中,总线地址通常直接映射到硬件设备或内存位置。在某些嵌入式系统中,设备寄存器的地址可能与物理内存地址相同。

-

虚拟内存地址: 在使用虚拟内存的系统中,总线地址可能会通过页表映射到虚拟地址空间。这允许操作系统灵活地管理内存,但硬件设备可能需要通过特殊的访问方式(例如内存映射 I/O)来与虚拟地址通信。

总线地址通常是硬件文档中提供的关键信息,用于编写驱动程序或与硬件交互的应用程序。在 Linux 等操作系统中,设备驱动程序通常需要知道硬件设备的总线地址,以便正确地访问设备寄存器或内存区域。

CPU能够访问内存的范围

物理地址

物理地址是计算机系统中主存(RAM)或其他硬件设备在物理内存中的唯一标识。它是硬件层面上的地址,直接对应于计算机系统的物理硬件。物理地址空间的大小取决于计算机的体系结构和硬件设计。

在典型的计算机系统中,物理地址是一个用于寻址主存的二进制值。CPU 通过物理地址直接访问主存中的数据,而无需进行额外的转换。物理地址的范围通常从零开始,到系统的最大物理内存地址。

对于 x86 架构的计算机,物理地址通常是一个32位或64位的值,具体取决于操作系统和硬件。在 32 位系统中,物理地址范围为 0x00000000 到 0xFFFFFFFF(4 GB),而在 64 位系统中,物理地址范围非常广泛。

物理地址的使用场景包括:

- 主存寻址: CPU 通过物理地址直接寻址主存中的数据和指令。

- 设备寻址: 某些硬件设备可能通过物理地址空间进行访问,例如外围设备寄存器。

- DMA(直接内存访问): DMA 控制器使用物理地址来直接访问主存,而无需 CPU 的干预。

物理地址和虚拟地址之间的映射是由操作系统的内存管理单元(MMU)进行管理的。虚拟地址在用户程序中使用,而 MMU 负责将虚拟地址翻译成相应的物理地址。这种映射提供了对主存的抽象,使得每个进程都认为它拥有自己的私有地址空间。

虚拟地址

虚拟地址(Virtual Address)是在计算机系统中用于访问虚拟内存的地址。每个运行的进程都拥有其独立的虚拟地址空间,这使得每个进程感觉自己独占整个计算机系统的内存。虚拟地址与物理地址之间的映射关系由操作系统和硬件共同管理。

关键点:

-

每个进程有独立的虚拟地址空间: 每个运行的进程都认为它在使用整个地址空间,从0到最大地址。这种隔离使得每个进程无法直接访问其他进程的内存。

-

虚拟地址与物理地址映射: 虚拟地址通过操作系统的地址翻译机制(例如页表)映射到物理内存地址。这个映射关系是动态的,可以随着进程的执行而改变。

-

虚拟地址空间的组成部分:

- 代码段: 存放执行代码的部分。

- 数据段: 存放全局和静态变量的部分。

- 堆: 用于动态内存分配的区域,可以动态扩展和收缩。

- 栈: 存放局部变量和函数调用信息的区域,是一个后进先出(LIFO)结构。

-

地址空间大小: 虚拟地址的位数决定了进程能够寻址的虚拟内存空间的大小。例如,32位系统可以寻址的虚拟地址空间为 2 32 2^{32} 232,而64位系统可以提供更大的虚拟地址范围。

-

用户空间和内核空间: 虚拟地址空间通常被分为用户空间和内核空间。用户空间用于存放应用程序代码和数据,而内核空间用于存放操作系统内核的代码和数据。用户空间和内核空间之间有一个分界线,通常由操作系统维护。

虚拟地址为多任务处理、内存隔离和动态内存管理提供了灵活性和抽象性。在程序执行时,操作系统负责将虚拟地址映射到实际的物理内存地址,以满足程序对内存的访问需求。

页表和内存管理单元MMU

页表(Page Table)和内存管理单元(Memory Management Unit,MMU)是计算机系统中用于实现虚拟内存的关键组成部分。

页表(Page Table):

-

定义: 页表是一个数据结构,用于存储虚拟地址到物理地址的映射关系。每个进程都有自己的页表,它将进程的虚拟地址映射到实际的物理内存地址。

-

工作原理: 当程序访问虚拟地址时,MMU使用页表将虚拟地址翻译为物理地址。页表以页面(通常大小为4 KB)为单位进行映射,将虚拟地址空间划分为页面,并将这些页面映射到物理内存中的相应页面。

-

层次结构: 为了支持大型地址空间,页表通常采用多级层次结构,例如两级或三级页表。这种结构允许灵活地组织和管理大量的映射关系,而不需要占用过多的内存。

内存管理单元(Memory Management Unit,MMU):

-

定义: MMU是计算机体系结构中的硬件组件,负责执行虚拟地址到物理地址的转换。它是一个关键的硬件模块,用于支持虚拟内存和提供内存隔离。

-

工作原理: MMU通过查找页表的内容,将程序产生的虚拟地址映射到实际的物理内存地址。这个过程是在硬件级别完成的,不需要程序员手动介入。

-

地址翻译: 当程序访问虚拟地址时,MMU将虚拟地址的各个部分进行解析,并根据页表中的映射关系计算出相应的物理地址。这个过程是透明的,对于应用程序而言,它感觉自己在使用整个地址空间。

总体而言,页表和MMU的组合允许操作系统和硬件协同工作,提供了虚拟内存的抽象层,使得每个进程都可以使用其独立的地址空间,而不必担心实际的物理内存布局。这种机制提高了内存的利用率,并为操作系统提供了更大的灵活性。