NLP论文阅读记录-EMNLP 2023 | 03 Citance-Contextualized Summarization of Scientific Papers

文章目录

- 前言

- 0、论文摘要

- 一、Introduction

-

- 1.1 目标问题

- 1.2相关的工作

-

- 1.2.1概括总结Generic Summarization

-

- Abstract-based summarization

- TL;DR summarization

- Comprehensive summarization

- 1.2.2基于引文的摘要Citation-based Summarization

- 1.3本文贡献

- 二.本文方法

-

- 3.1 情境总结

-

- 3.1.1引文上下文的提取

- 3.1.2引文语境检索

- 3.1.3 引文语境概括

- 3.2 WEBIS-CONTEXT-SCISUMM-2023:用于科学论文情境化概括的大型语料库

-

- 3.2.1Data Source and Preprocessing

- 3.2.2引文上下文和检索模型

- 3.2.3语料库统计

- 3.2.4抽象概括

-

- Prompt Formulation

- 三 实验效果

-

- 实验结果

-

- 内容检索评估

- Summarization Evaluation

-

- **Evaluation Data**

- **Automatic Evaluation**

- **Human Evaluation**

- **IAA and Results**

- 四 总结

-

- 局限性

前言

科学论文的引用语境摘要 (2311)

code

paper

0、论文摘要

当前科学论文自动摘要的方法以摘要的形式生成信息丰富的摘要。

然而,摘要并不旨在显示论文与其中引用的参考文献之间的关系。

我们提出了一种新的情境化摘要方法,可以根据包含参考文献引用(所谓的“引用”)的给定句子生成内容丰富的摘要。

此摘要概述了与引用位置相关的被引用论文的内容。

因此,我们的方法提取论文的引用并对其进行建模,从引用的论文中检索相关段落,并生成针对每个引用的抽象摘要。我们使用 WEBIS-CONTEXT-SCISUMM-2023 评估我们的方法,这是一个包含 54 万篇计算机科学论文和 460 万次引用的新数据集。

一、Introduction

1.1 目标问题

自动摘要的最初任务是科学论文的摘要,这是计算机科学中最早研究的任务之一(Luhn,1958;Baxendale,1958)。自动生成的摘要用于为特定科学领域创建“索引卷”,以帮助研究人员获取数量不断增加的出版物。如今,论文作者通常自己撰写摘要。然而,作者生成的摘要通常提供不完整或有偏见的科学论文覆盖(Elkiss 等,2008)。因此,自动论文摘要的目的已经演变为生成信息更丰富的摘要,通常使用抽象摘要方法(Cohan 等人,2018 年;Cachola 等人,2020 年;Mao 等人,2022 年)。

生成摘要的一个实际应用是增强论文阅读。例如,Rachatasumrit 等人的 CITEREAD。 (2022) 是 Allen AI 语义阅读器 (Lo et al., 2023) 的一部分,可按需显示摘要,作为正在阅读的论文中引用论文的摘要。

虽然这些摘要提供了被引用论文的简明和一般性概述,但它们不能满足读者试图理解论文在其引用背景下的相关性的信息需求。生成的摘要不适合引用上下文,让读者直接查阅引用的作品。

1.2相关的工作

1.2.1概括总结Generic Summarization

科学论文的通用摘要方法基于各种真实摘要,包括摘要(Luhn,1958;Cohan 等人,2018)、作者撰写的亮点(Collins 等人,2017)、作者撰写的宣传简介(Chen)等人,2020),以及同行评审摘要的简明版本(Cachola 等人,2020)。

Abstract-based summarization

柯林斯等人。 (2017) 提出了一种基于 10,148 篇计算机科学论文训练的提取摘要监督模型。该模型使用基于 LSTM 的具有词汇特征的神经编码器对值得总结的句子进行分类,其中作者撰写的要点和摘要作为参考。科汉等人。 (2018) 提出了一种话语感知注意力模型,用于对 arXiv 和 PubMed 馆藏中的科学论文进行抽象总结。分层编码器集成部分信息以生成连贯的摘要。古普塔等人。 (2021) 研究了用于提取摘要的预训练和调整基于 BERT 的模型。

TL;DR summarization

超短指示性 TL;DR 摘要简洁,通常是一两句话,旨在突出论文的主要发现。卡乔拉等人。 (2020) 开发了 SCITLDR 语料库,由 3.2K 篇论文组成,并附有来自同行评审和论文作者的手写 TL;DR 摘要(15-25 个单词)。使用控制代码和多任务学习来生成摘要;该模型还使用论文标题作为额外的训练信号。

Comprehensive summarization

LongSumm 是一项任务,旨在生成约 600 个单词的综合摘要,提供足够的信息来代替阅读目标论文,并克服摘要和 TL;DR 摘要的局限性 Chandrasekaran 等人。 (2020)。 LongSumm 语料库包含 2236 篇带有抽象和提取摘要的论文。索图德等人。 (2021) 从 arXiv 和 PubMed 创建了两个语料库,分别包含 11,149 和 88,035 个论文摘要对。为了指导长摘要的生成,Sotudeh 和 Goharian(2022)用引言、概述和动机部分的句子扩展了摘要。

1.2.2基于引文的摘要Citation-based Summarization

在基于引文的摘要中,源论文中的引用被用作查询,以从目标论文中提取相关内容,并生成摘要。 Qazvinian 和 Radev (2008) 分析了目标论文的引用网络并收集了不同来源的引用。这些引用被聚集在一起,中心句子被确定为摘录摘要。 Mei and Zhai (2008) 重点关注基于句子的影响摘要,反映论文集中引文的权威性和接近性。目标论文对相关工作的影响是通过引用源论文来确定的。为了提高可读性和连贯性,Abu-Jbara 和 Radev(2011)引入了预处理步骤来过滤掉不相关的文本片段。然后,进行提取阶段,从背景、问题陈述、方法、结果和局限性等部分中选择重要的句子。在后处理步骤中,生成的摘要的整体可读性得到提高,替换了代词并解决了共同引用问题。

与我们的工作密切相关的是,Cohan 和 Goharian(2015)使用了引用上下文,定义为反映源论文引用的目标论文的文本段落。为了总结目标论文,他们首先收集了多个引用上下文,根据 tf-idf 向量的余弦相似度构建了基于它们的内部连接性的图。该图中的句子按其重要性(连接数)进行排名。检索到的句子与目标论文中的话语信息相结合,生成内容丰富的摘要。 Cohan 和 Goharian (2017) 使用词嵌入和领域知识进一步改进了该模型,以增强引文上下文。

我们的工作还侧重于使用引文上下文对引文进行语境化,但有很大不同:我们识别不同类型的引文上下文,并使用它们为给定的引文生成多个上下文相关的摘要。我们不是仅仅依赖文字引用作为查询(它仅代表一种类型的引用上下文),而是使用多个上下文来派生查询。

我们的语料库是最大的一个包含特定引用上下文的科学论文摘要的语料库,包含约 540,000 篇论文和 460 万次引用。相比之下,Mao 等人的 CITESUM 语料库。 (2022) 仅包含 93,000 篇论文,其中引用源论文相关工作部分作为目标论文的超简短摘要。我们的语料库包括源论文所有部分的引用,并包含多种类型的引用上下文,以及每个上下文的多个摘要。因此,我们的语料库为研究科学论文摘要提供了全面且多样化的资源。

1.3本文贡献

在本文中,我们研究了与通用摘要相比专门针对个别引文上下文定制的上下文摘要的适用性。

我们提出了一种通过操作引用上下文来生成上下文摘要的新方法。

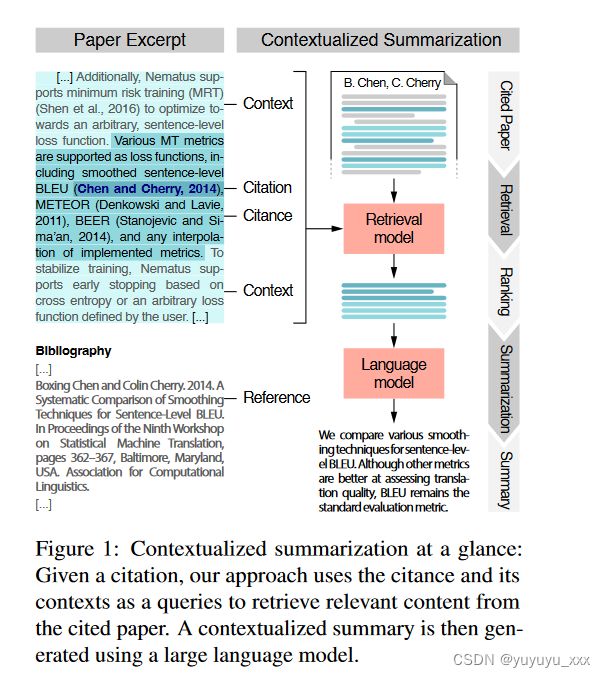

图 1 说明了我们的方法,该方法由三个步骤组成(第 3 节):

(1)从引用文档中提取包含引文(the citance)的句子及其上下文并对其进行建模,

(2)从使用基于这些引用上下文的查询来引用论文,

以及 (3) 生成引用论文的抽象的、引用上下文化的摘要。

为了解决这项新任务,我们创建了 WEBIS-CONTEXT-SCISUMM-2023(Sec-化4),一个大规模、高质量的语料库,由54万篇计算机科学论文和460万次引用组成。在使用我们的语料库进行的广泛比较评估中,我们与引用论文的摘要进行比较,探索了我们方法的不同变体(第 5 节)。我们发现,虽然摘要在覆盖范围和重点方面略有优势,但当引文未能与被引论文的中心主题保持一致时,上下文摘要被证明是比摘要更有利的替代方案。附录 D 中显示了我们的方法的上下文摘要示例以及摘要。

二.本文方法

3.1 情境总结

我们的情境化总结方法涉及在源论文中使用多个引用上下文。除了引文本身(包含引文的单个句子)之外,我们还考虑几种类型的周围上下文。如图 1 所示,我们的方法涉及三个主要步骤:(1) 提取引用,

(2) 从被引用的论文中检索相关内容,

以及 (3) 生成基于引用的上下文的抽象摘要。

3.1.1引文上下文的提取

首先,所有字面上引用其他论文的引用都是从给定的论文中提取的。然后我们考虑引用的两个附加上下文。第一个包括紧接引用之前和之后的句子。第二个包含同一段落中引用的两个语义上最相似的句子。这会产生三个引用上下文:(1) 引用本身,(2) 引用及其邻居,以及 (3) 引用和语义相似的句子。通过考虑这些背景,我们的目标是改进从被引用论文中相关内容的检索。

3.1.2引文语境检索

我们使用上述三个引用上下文作为检索的查询。此外,我们探索使用从每个引用上下文中提取的关键字来改进查询(Carpineto 和 Romano,2012)。对于检索,我们使用浅层和密集检索模型(第 4.2 节)。我们以两个粒度级别检索相关内容:句子和段落。具体来说,我们从引用的论文中提取前 5 个相关句子和前 2 个相关段落。这使得能够评估哪种粒度更适合上下文摘要任务。

前 5 个最相关的句子提供了被引用论文的更广泛覆盖范围,其中包括与引用相关的信息。相反,前 2 个最相关的段落提供了更高程度的关注,其中摘要句子是相互关联的。因此,我们对这两种粒度进行实验,以研究它们在我们的方法中的有效性。在检索过程之后,我们对检索到的内容进行定性评估。该评估有助于我们为后续摘要步骤(第 5.1 节)选择查询和检索模型的最佳组合。

3.1.3 引文语境概括

从引用的论文中检索相关内容后,我们将其用作摘要模型的输入。这确保了生成的摘要与引用的上下文相关,并专门关注被引用论文中与其相关的部分。在我们的方法中,我们探索大型语言模型 (LLM) 的有效性,因为它们具有强大的多任务能力(Bommasani 等人,2021)。我们使用基于提示的指令调整模型,可以理解并执行用户的自然语言指令来完成特定任务。对不同领域的灵活性和适应性使我们的方法有别于特定领域的监督方法。

由于我们对摘要模型有两种输入粒度(前 5 个句子和前 2 个段落),因此我们设计了两个针对这两种粒度的提示。对于前 5 个句子,我们使用释义提示,旨在将句子转化为连贯的摘要。对于前 2 段,我们使用抽象摘要提示来生成连贯的摘要。有关提示的更多详细信息,请参阅第 4.4 节。

3.2 WEBIS-CONTEXT-SCISUMM-2023:用于科学论文情境化概括的大型语料库

以前用于总结科学论文的数据集没有考虑不同类型的引用上下文,也没有评估用于提取相关内容的多个检索模型(第 2 节)。因此,这些数据集不适合研究引文语境化摘要。为了解决这一差距,我们引入了 WEBIS-CONTEXT-SCISUMM-2023,这是一个使用我们第 3 节中描述的方法创建的新的大型数据集。

3.2.1Data Source and Preprocessing

我们使用公开的语义学者开放研究语料库 (S2ORC)(Lo 等人,2020)。3 该语料库包含 1.36 亿份科学文档,其中 1200 万份提供全文。我们重点关注计算机科学领域的 870,000 份文档的子集(第 5.2 节)。删除没有引用的文件后,剩下约 540,000 份文件。然后,我们通过识别每个文档中包含引文的句子来提取引文。总共有 460 万次引用。与毛等人不同。 (2022)只考虑了相关工作部分的引用,我们考虑了所有论文部分的引用,从而产生了更加多样化的集合。

3.2.2引文上下文和检索模型

如第 3.1 节所述,我们使用三种类型的引用上下文作为查询来从被引用的论文中检索相关内容。直接提取引用和邻居上下文。对于相似的上下文,SciBERT(Beltagy 等人,2019)的上下文嵌入用于使用余弦相似度来识别引用中两个语义上最相似的句子。4我们还使用 KeyBERT(Grootendorst)从上下文中提取关键字作为查询,2020)。

作为检索模型,我们使用 **BM25(**Robertson 等人,1994)5 以及查询(引文上下文)和文档(被引论文的句子或段落)之间 SciBERT 嵌入的余弦相似度来对比浅层检索范式和密集检索范式。三种类型的查询(包括关键字变体)和两种检索模型的组合总共产生了 12 个检索设置,如表 3 所示,以及我们内部评估的平均 NDCG@5 分数(第 5.1 节)。我们索引了 1.51 亿个句子和 4000 万个段落,以分别检索每个查询的前 5 个句子和前 2 个段落。对于关键词查询,我们使用加权聚合来融合个体排名:每个排名的权重对应于查询与其引用的余弦相似度;由此产生的排名通过加权总和进行合并。

3.2.3语料库统计

编译的语料库包含 537,155 篇计算机科学论文,总共引用了 4,619,552 次。平均每篇论文被引用 8.6 次。引用的平均长度为 31 个标记,中位数为 27 个标记。此外,该语料库包含 346,450 篇论文,这些论文多次引用同一目标论文,促进了情境化摘要方法的研究。表 1 将我们的语料库与其他数据集进行了比较。

3.2.4抽象概括

使用从被引用论文中检索到的内容,我们使用表 2 中列出的基于提示的指令调整的LLM对每个引用进行抽象总结。对于检索内容的两种粒度(前 5 个句子和前 2 个段落),我们使用零样本设置中的模型生成单独的摘要。对于前 5 个句子,我们将它们解释为连贯的文本,因为它们已经作为提取摘要。对于前 2 段,我们进行了抽象总结。在整个任务中,我们尝试了不同的指令和提示公式。

Prompt Formulation

为了根据特定指令生成文本,上述模型需要定制提示。我们用不同的指令和提示表述进行了实验以进行释义并总结。手动评估所有模型的 10 个示例生成的摘要。基于此评估,为每个模型选择了最佳的说明和提示配方组合。图 2 显示了所选的组合,附录 A 提供了更多详细信息。

三 实验效果

实验结果

内容检索评估

表 3 中所示的 12 种检索设置是通过对从被引论文检索的内容与施引论文相应的引用上下文(查询)进行手动相关性评估来进行评估的。使用 10 个查询来检索 12 个设置中每一个被引论文的前 5 个句子,总共得到 600 个句子。句子相关性按分级等级进行评估:相关、有些相关和不相关。表 3 显示了 NDCG@5 的结果(Järvelin 和 Kekäläinen,2002)。基于它们,我们选择了类似的上下文作为 BM25 的查询,将 citance 上下文作为 SciBERT 的查询作为浅层和密集检索的最佳设置,以评估后续的摘要步骤。前者使用与引文语义最相似的前 2 个句子(以及引文本身)作为查询,而后者仅使用引文。

Summarization Evaluation

使用定量和定性方法对第 4.4 节中列出的模型的上下文摘要进行了评估。对于定量评估,我们使用了 ROUGE (Lin, 2004) 和 BERTScore (Zhang et al., 2020) 指标。对于定性评估,我们手动对覆盖率和焦点方面排名前两位的模型进行评分。

Evaluation Data

从 2016 年至 2020 年发表的 ACL 文集中选取了 15 篇文章。我们从这些文章中提取了 363 次引用,并随机选择了其中 25 篇。使用被引论文全文和表3中排名前2的检索模型,检索排名前5的句子和排名前2的段落,总共得到100篇文本。为了创建真实的参考摘要,我们在零样本设置中使用 GPT4(Bubeck 等人,2023),使用图 2 中所示的提示来解释/总结这些文本。然后手动审核每个摘要,以确保准确性和准确性。以排除幻觉或事实错误。我们的参考文献集包含 100 个摘要(= 25 个引用 × 2 个检索模型 × 2 个摘要类型)。

Automatic Evaluation

参考摘要用于自动评估生成的上下文摘要。结果如表4所示。根据 ROUGE 的说法,Vicuna 的表演在总结前 2 个段落方面表现最好,而 LLaMA-CoT 在将前 5 个句子解释为摘要方面表现最好。此外,它还在 top-2 段落设置中实现了最高的 BERTScore。因此,我们手动评估了它的覆盖范围和焦点。

Human Evaluation

招募了三名领域专家,包括两名学生和一名博士后,来评估摘要的有用性。注释者被要求对两个标准的覆盖范围和重点的摘要进行评分。评级采用李克特 5 分制,1 表示最差,5 表示最好。覆盖范围反映了摘要如何很好地捕获与特定引用相关的被引用论文中的基本信息,而焦点则指摘要中句子的连贯性和衔接性。总共评估了 25 篇被引论文的 125 篇摘要。每个样本都包含显示在左侧的引文(及其上下文)

右侧有五个摘要:被引论文的摘要、两个参考摘要(前 5 个句子和前 2 个段落)以及由两个最佳模型为前 5 个句子和前 2 个段落生成的摘要。 2段。摘要的顺序是随机的,以减轻顺序效应(Mathur 等人,2017)。

IAA and Results

注释者一致性是使用 Cohen 加权 kappa 计算的(Cohen,1960)。我们获得的覆盖范围和焦点的 κ 值分别为 0.42 和 0.40。虽然这些结果表明注释者之间存在一定的一致性,但它们也暗示了该注释任务固有的主观性。评估摘要的有用性受到几个上下文因素的影响,例如注释者审阅引文的目标、他们对被引用论文的先验知识以及摘要的呈现(Jones,2007)。

在未来的工作中,我们计划进一步研究这些因素。如表 5 所示,摘要作为摘要获得了最高的覆盖率得分 (3.67),紧随其后的是 Vicuna 生成的摘要 (3.01)。摘要也被评为最佳焦点摘要(4.50),而 GPT4 的参考摘要仅排名第二(3.83)。

就检索内容的粒度而言,基于前 2 个段落的摘要在覆盖范围和焦点方面均优于基于前 5 个句子的摘要。然而,尽管人们普遍偏爱摘要而不是生成的上下文摘要,但注释者提供的反馈表明,当引文不明确且与论文的整体思想无关时,我们的摘要会更有效。在这种情况下,他们更喜欢我们基于检索的摘要胜于摘要。表 6 显示了独立和模糊引用以及注释者偏好的示例。为了证实这一结果,我们计划在未来的工作中将我们的评估扩展到更多的引用。

LLM-based Evaluation

为了调查使用LLM评估摘要质量的可靠性,我们使用了 G-Eval (Liu et al., 2023),它使用 GPT4 根据某些标准评估摘要质量。我们使用提示来评估覆盖率、连贯性和相关性,并从 1 到 5 打分。G-Eval 首先让底层模型生成一系列思想,以确保它理解任务。图 3 说明了评估说明以及每个标准的(手动)校正思路。表 5 显示了结果,表明 G-Eval 反映了对顶级模型的人类评估,对排名较低的模型略有偏差那些。值得注意的是,GPT4 的参考摘要在相关性方面与摘要的得分相似。

四 总结

我们研究了通用论文摘要与定制的上下文摘要的使用情况,以提高读者对个别论文引用相关性的理解。为此,我们开发了一种新的摘要方法来生成引用上下文摘要。通过WEBIS-CONTEXT-SCISUMM-2023,我们编制了一个大型语料库来促进这一方向的研究。使用法学硕士进行的零样本摘要实验表明,在覆盖范围和焦点方面,摘要略优于上下文摘要,而当引用不涉及论文的主要贡献时,使用我们的方法生成的摘要更受青睐。

局限性

我们提出的科学论文情境化总结方法基于标准检索模型和法学硕士。应该指出的是,与引用相关的内容是主观的,取决于读者对被引用论文的先验知识。因此,检索模型可能并不总是检索到最相关的上下文,这可能会影响后续摘要的质量。这可以解释为什么旨在为广大受众提供信息的摘要在人类评估中比上下文摘要得分更高。

我们的方法依赖于研究界不断改进的法学硕士。我们的实验结果可能会随着新法学硕士的引入而有所不同。然而,底层方法本身很直观,并且可以很容易地适应新的法学硕士(当它们可用时)。同样重要的是要认识到任何摘要技术的一个重要但经常被忽视的局限性,即鉴于其目的,缺乏对什么构成良好摘要的明确定义。在我们的例子中,摘要的目的是帮助读者理解引文的相关性,而无需查找被引用的论文。虽然我们使用摘要作为比较的参考,但我们的评估方法并没有引发与此目的相关的真实信息需求。这使得摘要和上下文摘要之间的公平比较变得困难。此外,专家注释者的可用性迫使我们集中精力在 NLP 领域,这意味着我们的结果可能无法推广到其他领域的科学论文。我们希望我们的工作能够鼓励研究界针对不同类型摘要的具体目的开发更强大的摘要评估方法。