MySQL数据库 索引

目录

索引概述

索引结构

二叉树

B-Tree

B+Tree

Hash

索引分类

索引语法

慢查询日志

索引概述

索引 (index)是帮助MySQL高效获取数据的数据结构(有序)。在数据之外,数据库系统还维护着满足特定查找算法的数据结构,这些数据结构以某种方式引用(指向)数据,这样就可以在这些数据结构上实现高级查找算法,这种数据结构就是索引。

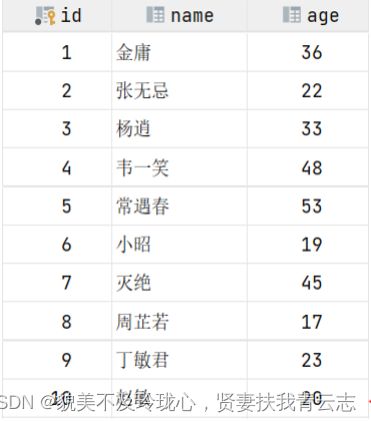

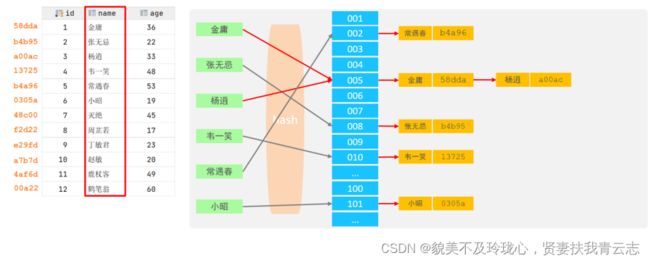

演示:表结构数据如下

假如我们要执行的sor语句为: select * from user where age = 45;、

无索引i情况:

在无索引情况下,就需要从第一行开始扫描,一直扫描到最后一行,我们称之为全表扫描,性能很低。

有索引情况:

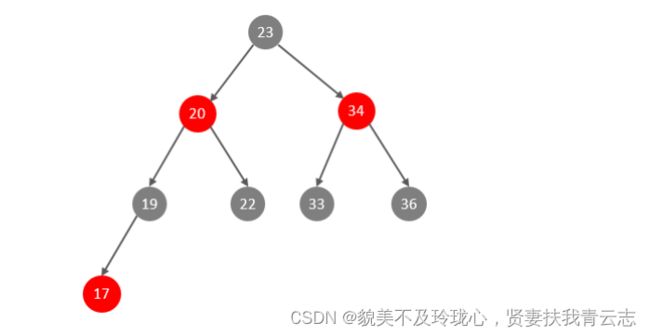

如果我们针对于这张表建立了索引,假设索引结构就是二叉树,那么也就意味着,会对age这个字段建立一个二叉树的索引结构。

此时我们在进行查询时,只需要扫描三次就可以找到数据了,极大的提高的查询的效率。

备注:这里我们只是假设索引的结构是二叉树,介绍一下索引的大概原理,只是一个示意图,并不是索引的真实结构,索引的真实结构,后面会详细介绍。

特点:

索引结构

MysQL的索引是在存储引擎层实现的,不同的存储引擎有不同的索引结构,主要包含以下几种:

上述是MysQL中所支持的所有的索引结构,接下来,我们再来看看不同的存储引擎对于索引结构的支持情况。

二叉树

假如说MySQL的索引结构采用二叉树的数据结构,比较理想的结构如下:

如果主键是顺序插入的,则会形成一个单向链表,结构如下:

所以,如果选择二叉树作为索引结构,会存在以下缺点:

- 顺序插入时,会形成一个链表,查询性能大大降低。

- 大数据量情况下,层级较深,检索速度慢。

此时大家可能会想到,我们可以选择红黑树,红黑树是一颗自平衡二叉树,那这样即使是顺序插入数据,最终形成的数据结构也是一颗平衡的二叉树,结构如下:

但是,即使如此,由于红黑树也是一颗二叉树,所以也会存在一个缺点:

大数据量情况下,层级较深,检索速度慢。

所以,在MySQL的索引结构中,并没有选择二叉树或者红黑树,而选择的是B+Tree,那么什么是B+Tree呢?在详解B+Tree之前,先来介绍一个B-Tree。

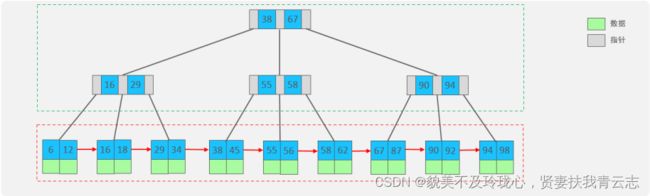

B-Tree

B一Tree,z树是一种多叉路衡查找树,相对于二叉树,z树每个节点可以有多个分支,即多叉。

以一颗最大度数(max-degree)为5 (5阶)的b-tree为例,那这个B树每个节点最多存储4个key,5个指针:

树的度数指的是一个节点的子节点个数。

插入一组数据: 100 65 169 368 900 556 780 35 215 1200 234 888 158 90 1000 88120 268 250 然后观察一些数据插入过程中,节点的变化情况。

特点:

- 5阶的B树,每一个节点最多存储4个key,对应5个指针。

- 一旦节点存储的key数量到达5,就会裂变,中间元素向上分裂。

- 在B+树中,非叶子节点和叶子节点都会存放数据。

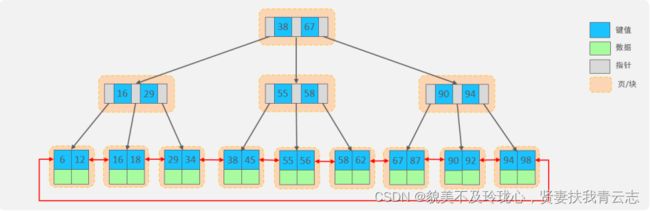

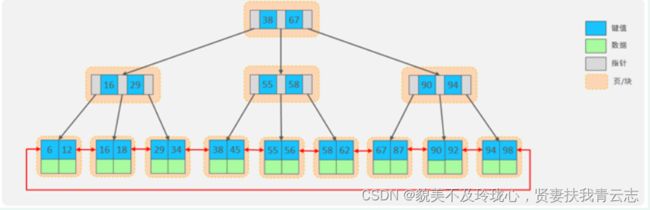

B+Tree

B+Tree是B-Tree的变种,我们以一颗最大度数(max-degree)为4(4阶)的b+tree为例,来看一下其结构示意图:

我们可以看到,两部分:

- 绿色框框起来的部分,是索引部分,仅仅起到索引数据的作用,不存储数据。

- 红色框框起来的部分,是数据存储部分,在其叶子节点中要存储具体的数据。

插入一组数据: 100 65 169 368 900 556 780 35 215 1200 234 888 158 90 1000 88120 268 250 。然后观察一些数据插入过程中,节点的变化情况。

最终我们看到,B+Tree 与B一Tree相比,主要有以下三点区别:

- 所有的数据都会出现在叶子节点。

- 叶子节点形成一个单向链表

- 非叶子节点仅仅起到索引数据作用,具体的数据都是在叶子节点存放的。

上述我们所看到的结构是标准的B+Tree的数据结构,接下来,我们再来看看MysQL中优化之后的

B+Tree。

MySQL索引数据结构对经典的B+Tree进行了优化。在原B+Tree的基础上,增加一个指向相邻叶子节点的链表指针,就形成了带有顺序指针的B+Tree,提高区间访问的性能,利于排序。

Hash

MySQL中除了支持B+Tree索引,还支持一种索引类型---Hash索引。

结构:哈希索引就是采用一定的hash算法,将键值换算成新的hash值,映射到对应的槽位上,然后存储在hash表中。

如果两个(或多个)键值,映射到一个相同的槽位上,他们就产生了hash冲突(也称为hash碰撞),可以通过链表来解决。

特点

- Hash索引只能用于对等比较(=, in),不支持范围查询(between,>,< ,...)

- 无法利用索引完成排序操作

- 查询效率高,通常(不存在hash冲突的情况)只需要一次检索就可以了,效率通常要高于B+tree索引

存储引擎支持:在MySQL中,支持hash索引的是Memory存储引擎。而InnoDB中具有自适应hash功能,hash索引是InnoDB存储引擎根据B+Tree索引在指定条件下自动构建的。

为什么InnoDB存储引擎选择使用B+tree索引结构?

- 相对于二叉树,层级更少,搜索效率高;

- 对于B-tree,无论是叶子节点还是非叶子节点,都会保存数据,这样导致一页中存储的键值减少,指针跟着减少,要同样保存大量数据,只能增加树的高度,导致性能降低;

- 相对Hash索引,B+tree支持范围匹配及排序操作;

索引分类

在MySQL数据库,将索引的具体类型主要分为以下几类:主键索引、唯一索引、常规索引、全文索引。

而在在InnoDB存储引擎中,根据索引的存储形式,又可以分为以下两种

聚集索引选取规则:

- 如果存在主键,主键索引就是聚集索引。

- 如果不存在主键,将使用第一个唯一(UNIQUE)索引作为聚集索引。

- 如果表没有主键,或没有合适的唯一索引,则InnoDB会自动生成一个rowid作为隐藏的聚集索引。

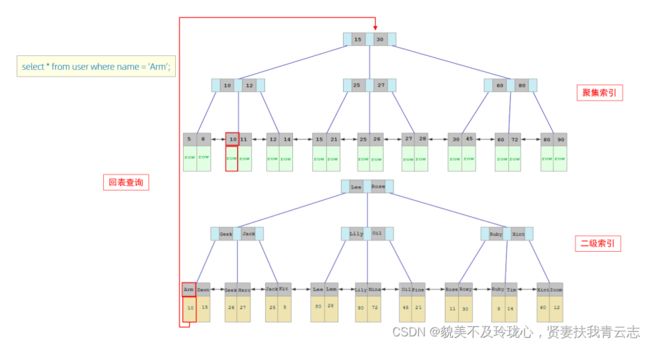

聚集索引和二级索引的具体结构如下:

- 聚集索引的叶子节点下挂的是这一行的数据。

- 二级索引的叶子节点下挂的是该字段值对应的主键值。

接下来,我们来分析一下,当我们执行如下的 SQL 语句时,具体的查找过程是什么样子的。

接下来,我们来分析一下,当我们执行如下的soz语句时,具体的查找过程是什么样子的

具体过程如下:

- 由于是根据name字段进行查询,所以先根据name='Arm '到name字段的二级索引中进行匹配查找。但是在二级索引中只能查找到Arm对应的主键值10。

- 由于查询返回的数据是*,所以此时,还需要根据主键值10,到聚集索引中查找10对应的记录,最终找到1o对应的行row。

- 最终拿到这一行的数据,直接返回即可。

回表查询:这种先到二级索引中查找数据,找到主键值,然后再到聚集索引中根据主键值,获取数据的方式,就称之为回表查询。

InnoDB主键索引的B+tree高度为多高呢?

一行数据大小为1k,一页中可以存储16行这样的数据。工nnoDB的指针占用6个字节的空间,主键即使为bigint,占用字节数为8。

高度为2:

n *8 +(n + 1)* 6= 16*1024,算出n约为1170 ; 1171* 16= 18736

也就是说,如果树的高度为2,则可以存储18000多条记录。

高度为3:

1171 *1171 *16=21939856

也就是说,如果树的高度为3,则可以存储 2200w左右的记录。

索引语法

创建索引

CREATE [ UNIQUE | FULLTEXT ] INDEX index_name ON table_name (index_col_name,... ) ;查看索引

SHOW INDEX FROM table_name ;删除索引

DROP INDEX index_name ON table_name ;先来创建一张表 tb_user,并且查询测试数据。

create table tb_user(

id int primary key auto_increment comment '主键',

name varchar(50) not null comment '用户名',

phone varchar(11) not null comment '手机号',

email varchar(100) comment '邮箱',

profession varchar(11) comment '专业',

age tinyint unsigned comment '年龄',

gender char(1) comment '性别 , 1: 男, 2: 女',

status char(1) comment '状态',

createtime datetime comment '创建时间'

) comment '系统用户表';

INSERT INTO tb_user (name, phone, email, profession, age, gender, status,createtime) VALUES ('吕布', '17799990000', '[email protected]', '软件工程', 23, '1','6', '2001-02-02 00:00:00');

INSERT INTO tb_user (name, phone, email, profession, age, gender, status,createtime) VALUES ('曹操', '17799990001', '[email protected]', '通讯工程', 33,'1', '0', '2001-03-05 00:00:00');

INSERT INTO tb_user (name, phone, email, profession, age, gender, status,createtime) VALUES ('赵云', '17799990002', '[email protected]', '英语', 34, '1','2', '2002-03-02 00:00:00');

INSERT INTO tb_user (name, phone, email, profession, age, gender, status,createtime) VALUES ('孙悟空', '17799990003', '[email protected]', '工程造价', 54,'1', '0', '2001-07-02 00:00:00');

INSERT INTO tb_user (name, phone, email, profession, age, gender, status,createtime) VALUES ('花木兰', '17799990004', '[email protected]', '软件工程', 23,'2', '1', '2001-04-22 00:00:00');

INSERT INTO tb_user (name, phone, email, profession, age, gender, status,createtime) VALUES ('大乔', '17799990005', '[email protected]', '舞蹈', 22, '2','0', '2001-02-07 00:00:00');

INSERT INTO tb_user (name, phone, email, profession, age, gender, status,createtime) VALUES ('露娜', '17799990006', '[email protected]', '应用数学', 24,'2', '0', '2001-02-08 00:00:00');

INSERT INTO tb_user (name, phone, email, profession, age, gender, status,createtime) VALUES ('程咬金', '17799990007', '[email protected]', '化工', 38,'1', '5', '2001-05-23 00:00:00');

INSERT INTO tb_user (name, phone, email, profession, age, gender, status,createtime) VALUES ('项羽', '17799990008', '[email protected]', '金属材料', 43,'1', '0', '2001-09-18 00:00:00');

INSERT INTO tb_user (name, phone, email, profession, age, gender, status,createtime) VALUES ('白起', '17799990009', '[email protected]', '机械工程及其自动化', 27, '1', '2', '2001-08-16 00:00:00');

INSERT INTO tb_user (name, phone, email, profession, age, gender, status,createtime) VALUES ('韩信', '17799990010', '[email protected]', '无机非金属材料工程', 27, '1', '0', '2001-06-12 00:00:00');

INSERT INTO tb_user (name, phone, email, profession, age, gender, status,createtime) VALUES ('荆轲', '17799990011', '[email protected]', '会计', 29, '1','0', '2001-05-11 00:00:00');

INSERT INTO tb_user (name, phone, email, profession, age, gender, status,createtime) VALUES ('兰陵王', '17799990012', '[email protected]', '工程造价',44, '1', '1', '2001-04-09 00:00:00');

INSERT INTO tb_user (name, phone, email, profession, age, gender, status,createtime) VALUES ('狂铁', '17799990013', '[email protected]', '应用数学', 43,'1', '2', '2001-04-10 00:00:00');

INSERT INTO tb_user (name, phone, email, profession, age, gender, status,createtime) VALUES ('貂蝉', '17799990014', '[email protected]', '软件工程', 40,'2', '3', '2001-02-12 00:00:00');

INSERT INTO tb_user (name, phone, email, profession, age, gender, status,createtime) VALUES ('妲己', '17799990015', '[email protected]', '软件工程', 31,'2', '0', '2001-01-30 00:00:00');

INSERT INTO tb_user (name, phone, email, profession, age, gender, status,createtime) VALUES ('芈月', '17799990016', '[email protected]', '工业经济', 35,'2', '0', '2000-05-03 00:00:00');

INSERT INTO tb_user (name, phone, email, profession, age, gender, status,createtime) VALUES ('嬴政', '17799990017', '[email protected]', '化工', 38, '1','1', '2001-08-08 00:00:00');

INSERT INTO tb_user (name, phone, email, profession, age, gender, status,createtime) VALUES ('狄仁杰', '17799990018', '[email protected]', '国际贸易',30, '1', '0', '2007-03-12 00:00:00');

INSERT INTO tb_user (name, phone, email, profession, age, gender, status,createtime) VALUES ('安琪拉', '17799990019', '[email protected]', '城市规划', 51,'2', '0', '2001-08-15 00:00:00');

INSERT INTO tb_user (name, phone, email, profession, age, gender, status,createtime) VALUES ('典韦', '17799990020', '[email protected]', '城市规划', 52,'1', '2', '2000-04-12 00:00:00');

INSERT INTO tb_user (name, phone, email, profession, age, gender, status,createtime) VALUES ('廉颇', '17799990021', '[email protected]', '土木工程', 19,'1', '3', '2002-07-18 00:00:00');

INSERT INTO tb_user (name, phone, email, profession, age, gender, status,createtime) VALUES ('后羿', '17799990022', '[email protected]', '城市园林', 20,'1', '0', '2002-03-10 00:00:00');

INSERT INTO tb_user (name, phone, email, profession, age, gender, status,createtime) VALUES ('姜子牙', '17799990023', '[email protected]', '工程造价', 29,'1', '4', '2003-05-26 00:00:00');数据准备好了之后,接下来,我们就来完成如下需求:

# name字段为姓名字段,该字段的值可能会重复,为该字段创建索引。

1CREATE INDEX idx_user_name ON tb_user (name ) ;

# phone手机号字段的值,是非空,且唯一的,为该字段创建唯一索引。

CREATE UNIQUE INDEX idx_user_phone ON tb_user(phone);

# 为profession、age、status创建联合索引。

CREATE 工NDEX idx_user_pro_age_sta 0N tb_user(profession, age,status);

# 为email建立合适的索引来提升查询效率。

CREATE 工NDEX idx_email ON tb_user (email);

完成上述的需求之后,我们再查看tb_user表的所有的索引数据。

show index from tb_user;

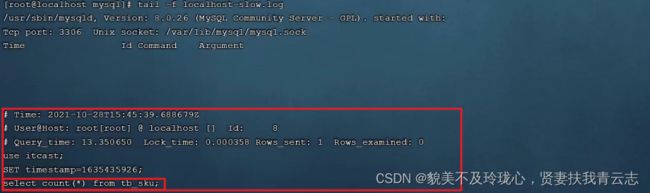

慢查询日志

慢查询日志记录了所有执行时间超过指定参数(long_query_time,单位:秒,默认10秒)的所有

SQL语句的日志。MySQL的慢查询日志默认没有开启,我们可以查看一下系统变量slow_query_log。

如果要开启慢查询日志,需要在MySQL的配置文件(/etc/my.cnf)中配置如下信息:

# 开启MySQL慢日志查询开关

slow_query_log=1

# 设置慢日志的时间为2秒,SQL语句执行时间超过2秒,就会视为慢查询,记录慢查询日志

long_query_time=2配置完毕之后,通过以下指令重新启动MySQL服务器进行测试,查看慢日志文件中记录的信息 /var/lib/mysql/localhost-slow.log。

systemctl restart mysqld然后,再次查看开关情况,慢查询日志就已经打开了。

测试:

执行如下SQL语句 :

select * from tb_user; -- 这条SQL执行效率比较高, 执行耗时 0.00sec

select count(*) from tb_sku; -- 由于tb_sku表中, 预先存入了1000w的记录, count一次,耗时

13.35sec检查慢查询日志 :

最终我们发现,在慢查询日志中,只会记录执行时间超多我们预设时间(2s)的SQL,执行较快的SQL 是不会记录的。

那这样,通过慢查询日志,就可以定位出执行效率比较低的SQL,从而有针对性的进行优化。