- Python基于深度学习的动物图片识别技术的研究与实现

Java老徐

Python毕业设计python深度学习开发语言深度学习的动物图片识别技术Python动物图片识别技术

博主介绍:✌程序员徐师兄、7年大厂程序员经历。全网粉丝12w+、csdn博客专家、掘金/华为云/阿里云/InfoQ等平台优质作者、专注于Java技术领域和毕业项目实战✌文末获取源码联系精彩专栏推荐订阅不然下次找不到哟2022-2024年最全的计算机软件毕业设计选题大全:1000个热门选题推荐✅Java项目精品实战案例《100套》Java微信小程序项目实战《100套》感兴趣的可以先收藏起来,还有大家

- 【深度学习与大模型基础】第7章-特征分解与奇异值分解

lynn-66

深度学习与大模型基础算法机器学习人工智能

一、特征分解特征分解(EigenDecomposition)是线性代数中的一种重要方法,广泛应用于计算机行业的多个领域,如机器学习、图像处理和数据分析等。特征分解将一个方阵分解为特征值和特征向量的形式,帮助我们理解矩阵的结构和性质。1.特征分解的定义对于一个n×n的方阵A,如果存在一个非零向量v和一个标量λ,使得:则称λ为矩阵A的特征值,v为对应的特征向量。特征分解将矩阵A分解为:其中:Q是由特征

- 《当人工智能遇上广域网:跨越地理距离的通信变革》

程序猿阿伟

人工智能

在数字化时代,广域网作为连接全球信息的纽带,让数据能够在不同地区的网络之间流动。然而,地理距离给广域网数据传输带来诸多挑战,如高延迟、低带宽、信号衰减和不稳定等问题。幸运的是,飞速发展的人工智能技术为解决这些难题提供了新的方向,开启了广域网传输的新篇章。广域网传输面临的地理挑战广域网覆盖范围极为广泛,可连接不同城市、国家甚至跨越洲际,这使得数据传输要跨越漫长的地理距离。以跨国公司的广域网为例,其总

- 【论文阅读】Persistent Homology Captures the Generalization of Neural Networks Without A Validation Set

开心星人

论文阅读论文阅读

将神经网络表征为加权的无环图,直接根据模型的权重矩阵构造PD。计算相邻batch的权重矩阵PD之间的距离。比较同调收敛性与神经网络的验证精度变化趋势摘要机器学习从业者通常通过监控模型的某些指标来估计其泛化误差,并在训练数值收敛之前停止训练,以防止过拟合。通常,这种误差度量或任务相关的指标是通过一个验证集(holdoutset)来计算的。因为这些数据没有直接用于更新模型参数,通常假设模型在验证集上的

- 震惊! “深度学习”都在学习什么

扉间798

深度学习学习人工智能

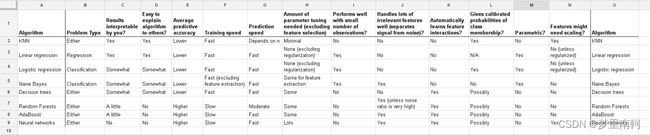

常见的机器学习分类算法俗话说三个臭皮匠胜过诸葛亮这里面集成学习就是将单一的算法弱弱结合算法融合用投票给特征值加权重AdaBoost集成学习算法通过迭代训练一系列弱分类器,给予分类错误样本更高权重,使得后续弱分类器更关注这些样本,然后将这些弱分类器线性组合成强分类器,提高整体分类性能。(一)投票机制投票是一种直观且常用的算法融合策略。在多分类问题中,假设有多个分类器对同一数据进行分类判断。每个分类器

- 【论文阅读】Availability Attacks Create Shortcuts

开心星人

论文阅读论文阅读

还得重复读这一篇论文,有些地方理解不够透彻可用性攻击通过在训练数据中添加难以察觉的扰动,使数据无法被机器学习算法利用,从而防止数据被未经授权地使用。例如,一家私人公司未经用户同意就收集了超过30亿张人脸图像,用于构建商业人脸识别模型。为解决这些担忧,许多数据投毒攻击被提出,以防止数据被未经授权的深度模型学习。它们通过在训练数据中添加难以察觉的扰动,使模型无法从数据中学习太多信息,从而导致模型在未见

- NLP高频面试题(十)——目前常见的几种大模型架构是啥样的

Chaos_Wang_

NLP常见面试题自然语言处理架构人工智能

深入浅出:目前常见的几种大模型架构解析随着Transformer模型的提出与发展,语言大模型迅速崛起,已经成为人工智能领域最为关注的热点之一。本文将为大家详细解析几种目前常见的大模型架构,帮助读者理解其核心差异及适用场景。1.什么是LLM(大语言模型)?LLM通常指参数量巨大、能够捕捉丰富语义信息的Transformer模型,它们通过海量的文本数据训练而成,能够实现高度逼真的文本生成、复杂的语言理

- 深度学习 | pytorch + torchvision + python 版本对应及环境安装

zfgfdgbhs

深度学习pythonpytorch

目录一、版本对应二、安装命令(pip)1.版本(1)v2.5.1~v2.0.0(2)v1.13.1~v1.11.0(3)v1.10.1~v1.7.02.安装全过程(1)选择版本(2)安装结果参考文章一、版本对应下表来自pytorch的github官方文档:pytorch/vision:Datasets,TransformsandModelsspecifictoComputerVisionpytor

- 机器学习 Day01人工智能概述

山北雨夜漫步

机器学习人工智能

1.什么样的程序适合在gpu上运行计算密集型的程序:此类程序主要运算集中在寄存器,寄存器读写速度快,而GPU拥有强大的计算能力,能高效处理大量的寄存器运算,因此适合在GPU上运行。像科学计算中的数值模拟、密码破解等场景的程序,都属于计算密集型,在GPU上运行可大幅提升运算速度。易于并行的程序:GPU采用SIMD架构,有众多核心,同一时间每个核心适合做相同的事。易于并行的程序能充分利用GPU这一特性

- 《今日AI-人工智能-编程日报》-源自2025年3月20日

小亦编辑部

每日AI-人工智能-编程日报人工智能大数据

一、AI行业动态英伟达新一代AI芯片Rubin发布计划英伟达宣布其新一代AI芯片Rubin将于2026年下半年推出,下下一代AI芯片架构命名为Feynman,计划于2028年登场。同时,英伟达还推出了RTXPRO6000系列Blackwell专业卡,拥有24064核心、96GB显存和最高600W功耗。OpenAI星际之门数据中心建设进展OpenAI的首个数据中心“星际之门”预计于2026年中在德克

- 机器学习:让计算机学会思考的艺术

平凡而伟大.

机器学习机器学习人工智能

目录什么是机器学习?机器学习的基本步骤常见的机器学习算法机器学习的实际应用如何入门机器学习?结语在当今数字化时代,机器学习(MachineLearning,ML)已经成为一个炙手可热的话题。从推荐系统到自动驾驶汽车,再到语音助手,机器学习的应用无处不在。然而,对于许多人来说,机器学习仍然是一个神秘而复杂的领域。本文将用通俗易懂的语言,带你走进机器学习的世界,了解它的基本原理和应用。什么是机器学习?

- 机器学习中的 K-均值聚类算法及其优缺点

平凡而伟大.

机器学习机器学习算法均值算法

K-均值聚类是一种常用的无监督学习算法,用于将数据集中的样本分成K个簇。其基本原理是将所有样本点划分到K个簇使得簇内样本点之间的距离尽可能接近,而不同簇之间的距离尽可能远。算法流程如下:随机选择K个样本点作为初始的聚类中心。将每个样本点分配到与其最近的聚类中心所在的簇。更新每个簇的聚类中心为该簇所有样本点的平均值。重复第2步和第3步,直到聚类中心不再变化或者达到最大迭代次数。优点:简单且易于实现。

- 一文讲清楚深度学习和机器学习

平凡而伟大.

机器学习人工智能深度学习机器学习人工智能

目录1.定义机器学习(MachineLearning,ML)深度学习(DeepLearning,DL)2.工作原理机器学习深度学习3.应用场景机器学习深度学习4.主要区别5.为什么选择深度学习?6.总结深度学习和机器学习是人工智能(AI)领域中两个密切相关但有所区别的概念。要清楚地解释它们之间的关系,我们可以从定义、工作原理、应用场景以及两者的主要区别等方面进行探讨。1.定义机器学习(Machin

- AIOps:解决企业IT挑战的智能利器

雅菲奥朗

认证培训AIOpsSRE可观测性

前言:在当今数字化的时代,企业IT基础设施和应用程序规模不断扩大,面临着日益复杂的挑战。在这种情况下,AIOps人工智能运维成为解决企业IT运维困境的智能利器。AIOps与可观测性密切相关,可观测性是实现AIOps的基础。通过收集、监视和理解系统数据,AIOps能够自动化运维任务、实时监控系统状态、预测潜在问题,从而提高效率和稳定性。AIOps尤其适用于IT运维部门,这是一个迫切需要此类技术的群体

- 使用AIOps进行更好的事件管理

茵赛飞3D CAD数据转换软件

pagerdutydevops人工智能运维

DevOps为科技界带来了更加协作和高效的工作流程。随着AIOps的集成,自动化更进一步,使用人工智能为团队提供更快的根本原因分析和算法降噪。主要从采用AIOps中受益的主要领域之一是事件管理。AIOps可以帮助DevOps团队自动化工作流程,以实现更智能、更高效的事件管理,从而腾出时间让IT运营团队成员专注于创新以改善用户体验。在本文中,我们将了解AIOps如何从检测和识别到响应改进事件管理,以

- AI大模型编程能力对比:Deepseek&Claude&Gemini

黑夜路人(heiyeluren)

AI人工智能人工智能aiAIGC语言模型

在当今快速发展的技术领域,人工智能(AI)模型在编程和数据处理方面的应用越来越广泛。不同的AI模型因其独特的设计理念和技术优势,适用于不同的编程任务和场景。本文将对三种主流的AI模型——DeepSeekv3、GeminiFlash2.0和Claude3.5Sonnet的编程能力进行详细对比,帮助读者根据具体需求选择最合适的工具。同时对DeepSeekv3、GeminiFlash2.0和Claude

- DeepSeek:智能搜索与分析的新纪元

XRC2231

学习

在人工智能浪潮席卷全球的今天,DeepSeek如同一颗璀璨的新星,以其独特的魅力和强大的功能,在AI领域脱颖而出。DeepSeek,这一基于深度学习和数据挖掘技术的智能搜索与分析系统,不仅重新定义了搜索引擎的边界,更以其卓越的性能和广泛的应用场景,为全球用户带来了前所未有的智能体验。本文将从DeepSeek的定义、特点、应用场景、优势等方面进行全面而深入的介绍,带您领略这一新兴技术的独特魅力。一、

- 哈尔滨工业大学DeepSeek公开课人工智能:大模型原理 技术与应用-从GPT到DeepSeek|附视频下载方法

你觉得205

人工智能机器学习大数据ai知识图谱python运维

导读INTRODUCTION今天继续哈尔滨工业大学车万翔教授带来了一场主题为“DeepSeek技术前沿与应用”的报告。本报告深入探讨了大语言模型在自然语言处理(NLP)领域的核心地位及其发展历程,从基础概念出发,延伸至语言模型在机器翻译、拼音输入法、语音识别等任务中的关键作用。强调了语言模型不仅辅助其他NLP任务,本身也蕴含大量知识,如地理信息、语义理解和推理能力。随着技术的发展,尤其是trans

- 机器学习knnlearn1

XW-ABAP

机器学习机器学习人工智能

importmatplotlib.pyplotaspltimportnumpyasnpimportoperator#定义一个函数用于创建数据集defcreateDataSet():#定义特征矩阵,每个元素是一个二维坐标点,代表不同策略数据点的坐标group=np.array([[20,3],[15,5],[18,1],[5,17],[2,15],[3,20]])#定义每个数据点对应的标签,用于区分

- 基于 MySQL 和 Spring Boot 的在线论坛管理系统设计与实现

城南|阿洋-计算机从小白到大神

mysqlspringboot数据库

markdownCopy✌全网粉丝20W+,csdn特邀作者、博客专家、CSDN[新星计划]导师、java领域优质创作者,博客之星、掘金/华为云/阿里云/InfoQ等平台优质作者、专注于Java、pyhton、机器学习技术领域和毕业项目实战✌哈喽兄弟们,好久不见哦~最近整理了一下之前写过的一些小项目/毕业设计。发现还是有很多存货的,想一想既然放在电脑里面也吃灰,那么还不如分享出去,没准还可以帮助到

- 零基础入门机器学习:用Scikit-learn实现鸢尾花分类

藍海琴泉

机器学习scikit-learn分类

适合人群:机器学习新手|数据分析爱好者|需快速展示案例的学生一、引言:为什么要学这个案例?目的:明确机器学习解决什么问题,建立学习信心。机器学习定义:让计算机从数据中自动学习规律(如分类鸢尾花品种)。为什么选鸢尾花数据集:数据量小、特征明确,适合教学演示。Scikit-learn优势:提供现成算法和工具,无需从头写数学公式。二、环境准备:5分钟快速上手目的:搭建可运行的代码环境,避免卡在工具安装环

- 机器学习--DBSCAN聚类算法详解

2201_75491841

机器学习算法聚类人工智能

目录引言1.什么是DBSCAN聚类?2.DBSCAN聚类算法的原理3.DBSCAN算法的核心概念3.1邻域(Neighborhood)3.2核心点(CorePoint)3.3直接密度可达(DirectlyDensity-Reachable)3.4密度可达(Density-Reachable)3.5密度相连(Density-Connected)4.DBSCAN算法的步骤5.DBSCAN算法的优缺点5

- 【机器学习】机器学习工程实战-第3章 数据收集和准备

腊肉芥末果

机器学习工程实战机器学习人工智能

上一章:第2章项目开始前文章目录3.1关于数据的问题3.1.1数据是否可获得3.1.2数据是否相当大3.1.3数据是否可用3.1.4数据是否可理解3.1.5数据是否可靠3.2数据的常见问题3.2.1高成本3.2.2质量差3.2.3噪声(noise)3.2.4偏差(bias)3.2.5预测能力低(lowpredictivepower)3.2.6过时的样本3.2.7离群值3.2.8数据泄露/目标泄漏3

- 机器学习实战 第一章 机器学习基础

LuoY、

MachineLearning机器学习算法人工智能

第一章机器学习1.1何谓机器学习1.2关键术语1.3机器学习的主要任务1.4如何选择合适的算法1.5开发机器学习应用程序的步骤1.6Python语言的优势1.1何谓机器学习 1、简单地说,机器学习就是把无序的数据转换成有用的信息; 2、机器学习能让我们自数据集中受启发,我们会利用计算机来彰显数据背后的真实含义; 3、机器学习横跨计算机科学、工程技术和统计学等多个学科,需要多学科的

- 数据挖掘实战-基于机器学习的垃圾邮件检测模型

艾派森

数据挖掘实战合集数据挖掘机器学习人工智能python

♂️个人主页:@艾派森的个人主页✍作者简介:Python学习者希望大家多多支持,我们一起进步!如果文章对你有帮助的话,欢迎评论点赞收藏加关注+目录1.项目背景2.数据集介绍

- 集成学习(随机森林)

herry57

数学建模大数据随机森林集成学习

目录一、集成学习概念二、Bagging集成原理三、随机森林四、例子(商品分类)一、集成学习概念集成学习通过建⽴⼏个模型来解决单⼀预测问题。它的⼯作原理是⽣成多个分类器/模型,各⾃独⽴地学习和作出预测。这些预测最后结合成组合预测,因此优于任何⼀个单分类的做出预测。只要单分类器的表现不太差,集成学习的结果总是要好于单分类器的二、Bagging集成原理分类圆形和长方形三、随机森林在机器学习中,随机森林是

- 【机器学习】朴素贝叶斯入门:从零到垃圾邮件过滤实战

吴师兄大模型

0基础实现机器学习入门到精通机器学习人工智能朴素贝叶斯深度学习pytorchsklearn开发语言

Langchain系列文章目录01-玩转LangChain:从模型调用到Prompt模板与输出解析的完整指南02-玩转LangChainMemory模块:四种记忆类型详解及应用场景全覆盖03-全面掌握LangChain:从核心链条构建到动态任务分配的实战指南04-玩转LangChain:从文档加载到高效问答系统构建的全程实战05-玩转LangChain:深度评估问答系统的三种高效方法(示例生成、手

- 【机器学习】机器学习工程实战-第2章 项目开始前

腊肉芥末果

机器学习工程实战机器学习人工智能

上一章:第1章概述文章目录2.1机器学习项目的优先级排序2.1.1机器学习的影响2.1.2机器学习的成本2.2估计机器学习项目的复杂度2.2.1未知因素2.2.2简化问题2.2.3非线性进展2.3确定机器学习项目的目标2.3.1模型能做什么2.3.2成功模型的属性2.4构建机器学习团队2.4.1两种文化2.4.2机器学习团队的成员2.5机器学习项目为何失败2.5.1缺乏有经验的人才2.5.2缺乏领

- 机器学习怎么做特征工程

全栈你个大西瓜

人工智能机器学习人工智能特征工程数据预处理特征变换特征降维特征构造

一、特征工程通俗解释特征工程就像厨师做菜前的食材处理:原始数据是“生肉和蔬菜”,特征工程是“切块、腌制、调料搭配”,目的是让机器学习模型(食客)更容易消化吸收,做出更好预测(品尝美味)。二、为什么要做特征工程?数据质量差:原始数据常有缺失、噪声、不一致问题(如年龄列混入“未知”)。模型限制:算法无法直接理解原始数据(如文本、日期需要数值化)。提升效果:好特征能显著提升模型性能(准确率提升10%~5

- 【机器学习】机器学习四大分类

藓类少女

机器学习机器学习分类人工智能

机器学习的方法主要可以分为四大类,根据学习方式和数据标注情况进行分类:1.监督学习(SupervisedLearning)特点:有标注数据(即训练数据有明确的输入(X)和输出(Y))。学习目标是找到一个映射(f(X)\approxY)。适用于分类和回归问题。主要算法:分类(Classification):逻辑回归(LogisticRegression)支持向量机(SVM)朴素贝叶斯(NaïveBa

- 用MiddleGenIDE工具生成hibernate的POJO(根据数据表生成POJO类)

AdyZhang

POJOeclipseHibernateMiddleGenIDE

推荐:MiddlegenIDE插件, 是一个Eclipse 插件. 用它可以直接连接到数据库, 根据表按照一定的HIBERNATE规则作出BEAN和对应的XML ,用完后你可以手动删除它加载的JAR包和XML文件! 今天开始试着使用

- .9.png

Cb123456

android

“点九”是andriod平台的应用软件开发里的一种特殊的图片形式,文件扩展名为:.9.png

智能手机中有自动横屏的功能,同一幅界面会在随着手机(或平板电脑)中的方向传感器的参数不同而改变显示的方向,在界面改变方向后,界面上的图形会因为长宽的变化而产生拉伸,造成图形的失真变形。

我们都知道android平台有多种不同的分辨率,很多控件的切图文件在被放大拉伸后,边

- 算法的效率

天子之骄

算法效率复杂度最坏情况运行时间大O阶平均情况运行时间

算法的效率

效率是速度和空间消耗的度量。集中考虑程序的速度,也称运行时间或执行时间,用复杂度的阶(O)这一标准来衡量。空间的消耗或需求也可以用大O表示,而且它总是小于或等于时间需求。

以下是我的学习笔记:

1.求值与霍纳法则,即为秦九韶公式。

2.测定运行时间的最可靠方法是计数对运行时间有贡献的基本操作的执行次数。运行时间与这个计数成正比。

- java数据结构

何必如此

java数据结构

Java 数据结构

Java工具包提供了强大的数据结构。在Java中的数据结构主要包括以下几种接口和类:

枚举(Enumeration)

位集合(BitSet)

向量(Vector)

栈(Stack)

字典(Dictionary)

哈希表(Hashtable)

属性(Properties)

以上这些类是传统遗留的,在Java2中引入了一种新的框架-集合框架(Collect

- MybatisHelloWorld

3213213333332132

//测试入口TestMyBatis

package com.base.helloworld.test;

import java.io.IOException;

import org.apache.ibatis.io.Resources;

import org.apache.ibatis.session.SqlSession;

import org.apache.ibat

- Java|urlrewrite|URL重写|多个参数

7454103

javaxmlWeb工作

个人工作经验! 如有不当之处,敬请指点

1.0 web -info 目录下建立 urlrewrite.xml 文件 类似如下:

<?xml version="1.0" encoding="UTF-8" ?>

<!DOCTYPE u

- 达梦数据库+ibatis

darkranger

sqlmysqlibatisSQL Server

--插入数据方面

如果您需要数据库自增...

那么在插入的时候不需要指定自增列.

如果想自己指定ID列的值, 那么要设置

set identity_insert 数据库名.模式名.表名;

----然后插入数据;

example:

create table zhabei.test(

id bigint identity(1,1) primary key,

nam

- XML 解析 四种方式

aijuans

android

XML现在已经成为一种通用的数据交换格式,平台的无关性使得很多场合都需要用到XML。本文将详细介绍用Java解析XML的四种方法。

XML现在已经成为一种通用的数据交换格式,它的平台无关性,语言无关性,系统无关性,给数据集成与交互带来了极大的方便。对于XML本身的语法知识与技术细节,需要阅读相关的技术文献,这里面包括的内容有DOM(Document Object

- spring中配置文件占位符的使用

avords

1.类

<?xml version="1.0" encoding="UTF-8"?><!DOCTYPE beans PUBLIC "-//SPRING//DTD BEAN//EN" "http://www.springframework.o

- 前端工程化-公共模块的依赖和常用的工作流

bee1314

webpack

题记: 一个人的项目,还有工程化的问题嘛? 我们在推进模块化和组件化的过程中,肯定会不断的沉淀出我们项目的模块和组件。对于这些沉淀出的模块和组件怎么管理?另外怎么依赖也是个问题? 你真的想这样嘛? var BreadCrumb = require(‘../../../../uikit/breadcrumb’); //真心ugly。

- 上司说「看你每天准时下班就知道你工作量不饱和」,该如何回应?

bijian1013

项目管理沟通IT职业规划

问题:上司说「看你每天准时下班就知道你工作量不饱和」,如何回应

正常下班时间6点,只要是6点半前下班的,上司都认为没有加班。

Eno-Bea回答,注重感受,不一定是别人的

虽然我不知道你具体从事什么工作与职业,但是我大概猜测,你是从事一项不太容易出现阶段性成果的工作

- TortoiseSVN,过滤文件

征客丶

SVN

环境:

TortoiseSVN 1.8

配置:

在文件夹空白处右键

选择 TortoiseSVN -> Settings

在 Global ignote pattern 中添加要过滤的文件:

多类型用英文空格分开

*name : 过滤所有名称为 name 的文件或文件夹

*.name : 过滤所有后缀为 name 的文件或文件夹

--------

- 【Flume二】HDFS sink细说

bit1129

Flume

1. Flume配置

a1.sources=r1

a1.channels=c1

a1.sinks=k1

###Flume负责启动44444端口

a1.sources.r1.type=avro

a1.sources.r1.bind=0.0.0.0

a1.sources.r1.port=44444

a1.sources.r1.chan

- The Eight Myths of Erlang Performance

bookjovi

erlang

erlang有一篇guide很有意思: http://www.erlang.org/doc/efficiency_guide

里面有个The Eight Myths of Erlang Performance: http://www.erlang.org/doc/efficiency_guide/myths.html

Myth: Funs are sl

- java多线程网络传输文件(非同步)-2008-08-17

ljy325

java多线程socket

利用 Socket 套接字进行面向连接通信的编程。客户端读取本地文件并发送;服务器接收文件并保存到本地文件系统中。

使用说明:请将TransferClient, TransferServer, TempFile三个类编译,他们的类包是FileServer.

客户端:

修改TransferClient: serPort, serIP, filePath, blockNum,的值来符合您机器的系

- 读《研磨设计模式》-代码笔记-模板方法模式

bylijinnan

java设计模式

声明: 本文只为方便我个人查阅和理解,详细的分析以及源代码请移步 原作者的博客http://chjavach.iteye.com/

import java.sql.Connection;

import java.sql.DriverManager;

import java.sql.PreparedStatement;

import java.sql.ResultSet;

- 配置心得

chenyu19891124

配置

时间就这样不知不觉的走过了一个春夏秋冬,转眼间来公司已经一年了,感觉时间过的很快,时间老人总是这样不停走,从来没停歇过。

作为一名新手的配置管理员,刚开始真的是对配置管理是一点不懂,就只听说咱们公司配置主要是负责升级,而具体该怎么做却一点都不了解。经过老员工的一点点讲解,慢慢的对配置有了初步了解,对自己所在的岗位也慢慢的了解。

做了一年的配置管理给自总结下:

1.改变

从一个以前对配置毫无

- 对“带条件选择的并行汇聚路由问题”的再思考

comsci

算法工作软件测试嵌入式领域模型

2008年上半年,我在设计并开发基于”JWFD流程系统“的商业化改进型引擎的时候,由于采用了新的嵌入式公式模块而导致出现“带条件选择的并行汇聚路由问题”(请参考2009-02-27博文),当时对这个问题的解决办法是采用基于拓扑结构的处理思想,对汇聚点的实际前驱分支节点通过算法预测出来,然后进行处理,简单的说就是找到造成这个汇聚模型的分支起点,对这个起始分支节点实际走的路径数进行计算,然后把这个实际

- Oracle 10g 的clusterware 32位 下载地址

daizj

oracle

Oracle 10g 的clusterware 32位 下载地址

http://pan.baidu.com/share/link?shareid=531580&uk=421021908

http://pan.baidu.com/share/link?shareid=137223&uk=321552738

http://pan.baidu.com/share/l

- 非常好的介绍:Linux定时执行工具cron

dongwei_6688

linux

Linux经过十多年的发展,很多用户都很了解Linux了,这里介绍一下Linux下cron的理解,和大家讨论讨论。cron是一个Linux 定时执行工具,可以在无需人工干预的情况下运行作业,本文档不讲cron实现原理,主要讲一下Linux定时执行工具cron的具体使用及简单介绍。

新增调度任务推荐使用crontab -e命令添加自定义的任务(编辑的是/var/spool/cron下对应用户的cr

- Yii assets目录生成及修改

dcj3sjt126com

yii

assets的作用是方便模块化,插件化的,一般来说出于安全原因不允许通过url访问protected下面的文件,但是我们又希望将module单独出来,所以需要使用发布,即将一个目录下的文件复制一份到assets下面方便通过url访问。

assets设置对应的方法位置 \framework\web\CAssetManager.php

assets配置方法 在m

- mac工作软件推荐

dcj3sjt126com

mac

mac上的Terminal + bash + screen组合现在已经非常好用了,但是还是经不起iterm+zsh+tmux的冲击。在同事的强烈推荐下,趁着升级mac系统的机会,顺便也切换到iterm+zsh+tmux的环境下了。

我为什么要要iterm2

切换过来也是脑袋一热的冲动,我也调查过一些资料,看了下iterm的一些优点:

* 兼容性好,远程服务器 vi 什么的低版本能很好兼

- Memcached(三)、封装Memcached和Ehcache

frank1234

memcachedehcachespring ioc

本文对Ehcache和Memcached进行了简单的封装,这样对于客户端程序无需了解ehcache和memcached的差异,仅需要配置缓存的Provider类就可以在二者之间进行切换,Provider实现类通过Spring IoC注入。

cache.xml

<?xml version="1.0" encoding="UTF-8"?>

- Remove Duplicates from Sorted List II

hcx2013

remove

Given a sorted linked list, delete all nodes that have duplicate numbers, leaving only distinct numbers from the original list.

For example,Given 1->2->3->3->4->4->5,

- Spring4新特性——注解、脚本、任务、MVC等其他特性改进

jinnianshilongnian

spring4

Spring4新特性——泛型限定式依赖注入

Spring4新特性——核心容器的其他改进

Spring4新特性——Web开发的增强

Spring4新特性——集成Bean Validation 1.1(JSR-349)到SpringMVC

Spring4新特性——Groovy Bean定义DSL

Spring4新特性——更好的Java泛型操作API

Spring4新

- MySQL安装文档

liyong0802

mysql

工作中用到的MySQL可能安装在两种操作系统中,即Windows系统和Linux系统。以Linux系统中情况居多。

安装在Windows系统时与其它Windows应用程序相同按照安装向导一直下一步就即,这里就不具体介绍,本文档只介绍Linux系统下MySQL的安装步骤。

Linux系统下安装MySQL分为三种:RPM包安装、二进制包安装和源码包安装。二

- 使用VS2010构建HotSpot工程

p2p2500

HotSpotOpenJDKVS2010

1. 下载OpenJDK7的源码:

http://download.java.net/openjdk/jdk7

http://download.java.net/openjdk/

2. 环境配置

▶

- Oracle实用功能之分组后列合并

seandeng888

oracle分组实用功能合并

1 实例解析

由于业务需求需要对表中的数据进行分组后进行合并的处理,鉴于Oracle10g没有现成的函数实现该功能,且该功能如若用JAVA代码实现会比较复杂,因此,特将SQL语言的实现方式分享出来,希望对大家有所帮助。如下:

表test 数据如下:

ID,SUBJECTCODE,DIMCODE,VALUE

1&nbs

- Java定时任务注解方式实现

tuoni

javaspringjvmxmljni

Spring 注解的定时任务,有如下两种方式:

第一种:

<?xml version="1.0" encoding="UTF-8"?>

<beans xmlns="http://www.springframework.org/schema/beans"

xmlns:xsi="http

- 11大Java开源中文分词器的使用方法和分词效果对比

yangshangchuan

word分词器ansj分词器Stanford分词器FudanNLP分词器HanLP分词器

本文的目标有两个:

1、学会使用11大Java开源中文分词器

2、对比分析11大Java开源中文分词器的分词效果

本文给出了11大Java开源中文分词的使用方法以及分词结果对比代码,至于效果哪个好,那要用的人结合自己的应用场景自己来判断。

11大Java开源中文分词器,不同的分词器有不同的用法,定义的接口也不一样,我们先定义一个统一的接口:

/**

* 获取文本的所有分词结果, 对比

![]()