Docker容器-cgroups资源配置

目录

Cgroup的概述

使用stress工具测试CPU和内存

CPU周期限制

CPU Core控制

对内存限额

对-Block IO的限制

bps 和iops 的限制

Cgroups如何工作的?

cgroup对cpu限制小结

cgroup对内存的限制小结

资源限制的主要类型

资源限制的几种方式

资源限制的状态查询

Cgroup的概述

Cgroup是Control Groups的缩写,是Linux内核提供的一种可以限制、记录、隔离进程组所使用的物理资源(如CPU、 内存、磁盘I0等等)的机制。

被LXC. docker等很多项目用于实现进程资源控制。Cgroup本身是提供将进程进行分组化管理的功能和接口的基础结构, I/O或内存的分配控制等具体的资源管理是通过该功能来实现的,这些具体的资源管理功能称为Cgroup子系统,有以下几大子系统实现:

使用stress工具测试CPU和内存

使用Dockerfile来创建一个基于Centos的stress工具镜像。

[root@localhost ~]# mkdir /opt/stress

[root@localhost ~]# vim /opt/stress/Dockerfile

FROM centos:7

MAINTAINER abc

RUN yum install wget -y && \

wget -O /etc/yum.repos.d/epel.repo http://mirrors.aliyun.com/repo/epel-7.repo && \

yum -y install stress

[root@localhost ~]# cd /opt/stress/

[root@localhost stress]# docker build -t centos:stress .

[root@localhost stress]# docker run -itd --cpu-shares 100 centos:stress

命令中的--Cpu- shares 参数值不能保证可以获得1个vcpu或者多少GHz的CPU资源,它仅是一个弹性的加权值。默认情况下,每个Docker容器的CPU份额都是1024。单独一个容器的份额是没有意义的。只有在同时运行多个容器时,容器的CPU加权的效果才能体现出来。

例如,两个容器A、B的CPU份额分别为1000和500,在CPU进行时间片分配的时候,容器A比容器B多一倍的机会获得CPU的时间片。但分配的结果取决于当时主机和其他容器的运行状态,实际上也无法保证容器A一定能获得CPU时间片。比如容器A的进程一直是空闲的,那么容器B是可以获取比容器A更多的CPU时间片的。极端情况下,例如主机上只运行了一个容器,即使它的CPU份额只有50,它也可以独占整个主机的CPU资源。

Cgroups只在容器分配的资源紧缺时,即在需要对容器使用的资源进行限制时,才会生效。因此,无法单纯根据某个容器的CPU份额来确定有多少CPU资源分配给它,资源分配结果取决于同时运行的其他容器的CPU分配和容器中进程运行情况。

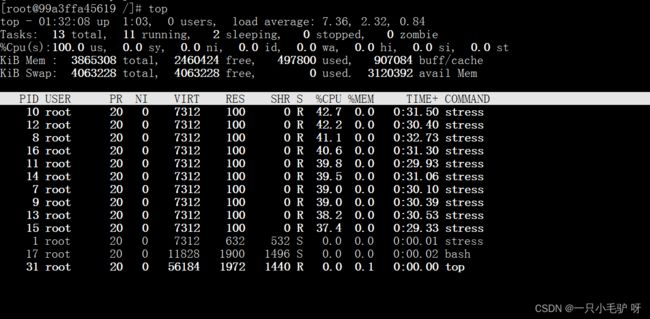

可以通过cpu share可以设置容器使用CPU的优先级,比如启动了两个容器及运行查看CPU使用百分比。

[root@localhost opt]# docker run -tid --name cpu512 --cpu-shares 512 centos:stress stress -c 10

99a3ffa45619a30febc538dde072a533d0efeb1ffb353c227ddeadb070154273

[root@localhost opt]# docker ps -a

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

99a3ffa45619 centos:stress "stress -c 10" 20 seconds ago Up 20 seconds cpu512

[root@localhost opt]# docker exec -it 99a3ffa45619 bash

//进入容器使用top查看cpu使用情况

[root@99a3ffa45619 /]# top

//再开启一个容器做比较

[root@localhost stress]# docker run -tid --name cpu1024 --cpu-shares 1024 centos:stress stress -c 10

[root@localhost stress]# docker exec -it 39e4fcb2cb0d bash //进容器使用top对比两个容器的%CPU,比例是1:2CPU周期限制

Docker提供了–cpu-period、 --cpu-quota两个参数控制容器可以分配到的CPU时钟周期。

–cpu-period是用来指定容器对CPU的使用要在多长时间内做一次重新分配。

–cpu-quota是用来指定在这个周期内,最多可以有多少时间用来跑这个容器。

与–cpu-shares不同的是,这种配置是指定一个绝对值,容器对CPU资源的使用绝对不会超过配置的值。

cpu-period和cpu-quota的单位为微秒(μs) 。cpu-period的最小值为1000微秒,最大值为1秒(10^6 μs) ,默认值为0.1秒(100000 μs)。

cpu-quota的值默认为-1, 表示不做控制。cpu-period和cpu-quota参数一般联合使用。

例如:容器进程需要每1秒使用单个CPU的0.2秒时间,可以将cpu-period设置为1000000 (即1秒) , cpu-quota设置为200000 (0.2秒)。

当然,在多核情况下,如果允许容器进程完全占用两个CPU,则可以将cpu-period设置为100000 (即0.1秒),cpu-quota设置为200000 (0.2秒)。

[root@localhost stress]# docker run -tid --cpu-period 100000 --cpu-quota 200000 centos:stress

[root@localhost stress]# docker exec -it d1ac159e55cf bash

[root@98daa50019 /# cat /sys/fs/cgroup/cpu/cpu.cfs_period_us

100000

[root@98d2aaa50019 /# cat /sys/fs/cgroup/cpu/cpu.cfs_quota_us

200000CPU Core控制

对多核CPU的服务器,Docker 还可以控制容器运行使用哪些CPU内核,即使用 --cpuset-cpus 参数。

这对具有多CPU的服务器尤其有用,可以对需要高性能计算的容器进行性能最优的配置。

[root@localhost stress]# docker run -tid --name cpu1 --cpuset-cpus 0-1 centos:stress

执行以上命令需要宿主机为双核,表示创建的容器只能用0、1两个内核。最终生成的cgroup的CPU内核配置如下:

[root@localhost stress]# docker exec -it 631eea630b21 bash

[root@631eea630b21 /]# cat /sys/fs/cgroup/cpuset/cpuset.cpus

0-1

通过下面指令可以看到容器中进程与CPU内核的绑定关系,达到绑定CPU内核的目的。

[root@localhost stress]# docker exec 631eea630b21 taskset-c-p 1 //容器内部第- 个进程号pid为1被绑定到指定CPU上运行

pid 1's current affinity list: 0,1对内存限额

-

与操作系统类似,容器可使用的内存包括两部分:物理内存和 Swap

-

-m 或 --memory:设置内存的使用限额

-

–memory-swap:设置内存+swap 的使用限额

docker run -itd -m 200M --memory-swap=300M progrium/stress --vm 1 --vm-bytes 280M

#--vm 1:启动1个内存工作线程

#--vm-bytes 280M:每个线程分配280M内存

#默认情况下,容器可以使用主机上的所有空闲内存。

#与 CPU 的cgroups 配置类似,Docker会自动为容器在目录/sys/fs/cgroup/memory/docker/<容器完整的 ID>/memory.limit_in_bytes

docker run -itd -m 200M --memory-swap=300M progrium/stress --vm 1 --vm-bytes 280M

#如果让工作线程分配的内存超过300M,分配的内存超过了限额,stress线程会报错,容器退出

'注意!一旦容器Cgroup使用的内存超过了限制的容量,Linux内核就会尝试收回这些内存'

'如果仍旧无法控制内存使用在这个设置的范围之内,就会杀死该进程!对-Block IO的限制

- 默认情况下,所有容器能平等地读写磁盘,可以通过设置–blkio-weight参数来改变容器 block IO的优先级。

- –blkio-weight 与–cpu-shares类似,设置的是相对权重值,默认为500。

例:

#容器A

docker run -it --name container_A --blkio-weight 600 centos:stress

cat /sys/fs/cgroup/blkio/blkio.weight

#容器B

docker run -it --name container_B --blkio-weight 300 centos:stress

cat /sys/fs/cgroup/blkio/blkio.weightbps 和iops 的限制

-

bps 是byte per second,每秒读写的数据量。

-

iops是io per second,每秒IO的次数。

-

可通过以下参数控制容器的bps 和iops:

- –device-read-bps,限制读菜个设备的bps。

- –device-write-bps,限制写某个设备的bps。

- –device-read-iops,限制读某个设备的iops。

- –device-write-iops,限制写某个设备的iops。

#下面的示例是限制容器写/dev/sda 的速率为5MB/s

docker run -it --device-write-bps /dev/sda:5MB centos:stress

dd if=/dev/zero of=test bs=1M count=100 oflag=direct

100+0 records in

100+0 records out

104857600 bytes (105 MB) copied, 20.0018 s, 5.2 MB/s

#通过dd命令测试在容器中写磁盘的速度。因为容器的文件系统是在 host /dev/sda 上的。

#在容器中写文件相当子对host /dev/sda进行写操作。另外,oflag=direct指定用direct IO 方式写文件,这样--device-write-bps才能生效。

#结果表明限速 5MB/s左右。作为对比测试,如果不限速,结果如下。

docker run -it centos:stress

dd if=/dev/zero of=test bs=1M count=100 oflag=direct

100+0 records in

100+0 records out

104857600 bytes (105 MB) copied, 0.0470107 s, 2.2 GB/s

1Cgroups如何工作的?

CPU —>VCPU–>以进程的方式体现在workstation环境(docker环境中) —》docker表现形式是容器,–>Vcpu以进程的方式控制容器–》容器中的应用需要的是服务进程支持–》宿主机内核中cpu可以被cgroup管理(通过分配资源手段)–》linux内核中的cgroup可以直接控制VCPU的资源分配,而VCPU在workstation中是以进程的方式管理docker容器的,所以,也可以认为Cgroups在直接/间接管理docker容器中的应用

cgroup对cpu限制小结

Cgroups 控制的是内核资源—》间接控制vw中vcpu的资源—》控制着vwM中进程资源—》docker容器的资源—》docker容器内应用的资源

控制的主体包括:CPU、内存、I/O

主要介绍的是CPU资源的控制而CPU资源控制的方式主要有:

①cpu-shares权重指的是多个容器使用同一个CPU的情况下,被分配到CPU资源的机会占比

②cpu-period周期指的是,CPU在给于当前管理、控制的容器分配资源时,CPU的分配周期,默认是1s,此项配置,可以在运行时直接指定

③cpuset-cpus指定容器,仅能使用指定的CPU,按照CPU的下标来表示

cgroup对内存的限制小结

Cgroups 对于内存的限制,主要体现在以下两个部分:

①内存使用上限(硬限制)

②内存+swap使用上限(硬限制)

类比于K8s中的资源限制手段,也是使用的cgroups的技术,体现为limit

respones:

request: #分配的初始资源

cpu:100m

memory:100m

limits:

cpu:300m

memory:200m

资源限制的主要类型

- CPU权重shares、 quota、 cpuset

- 磁盘BPS、 TPS限制, 指定使用哪个磁盘、磁盘分区

- 内存 -m - swap 内存、交换分区

大部分做的是上限的限制

资源限制的几种方式

- build构建镜像时,可以指定该镜像的资源限制

- run将镜像跑为容器的时候,可以指定容器的资源限制

- 容器启动之后可以在宿主机对应容器的目录下,修改资源限制,然后重载

- /sys/ fs/cgroup/* (cpu、b1k、 mem) /docker/容 器ID/ ——>修改对应的资源限制文件参数就可以

资源限制的状态查询

-

docker inspect 镜像ID/容器ID

-

直接查看宿主机对应容器ID资源限制的文件

cgroup资源docker 原理之一, namespaces 6个名称空间