k8s学习 — (实践)第二章 搭建k8s集群

k8s学习 — (实践)第二章 搭建k8s集群

- 学习资料

- 1 搭建方案

-

- 1.1 minikube【推荐学习时使用】

- 1.2 kubeadm【推荐使用】

-

- 1.2.0 提示(步骤调整)

- 1.2.1 安装Docker(所有节点)

- 1.2.2 初始操作(所有节点)

- 1.2.3 安装基础软件 kubeadm、kubelet、kubectl(所有节点)

- 1.2.4 部署 Kubernetes Master(在 Master 节点下执行)

- 1.2.5 加入 Kubernetes Node(分别在 k8s-node1 和 k8s-node2 执行)

- 1.2.6 部署 CNI 网络插件

-

- 1.2.6.1 下载相关镜像(所有节点)

- 1.2.6.2 构建应用(在 master 节点上执行)

- 1.2.7 测试 kubernetes 集群

- 1.3 二进制安装

- 1.4 命令行工具

- 2 命令行工具 kubectl

-

- 2.1 在任意节点使用 kubectl

- 2.2 资源操作

-

- 2.2.1 创建对象

- 2.2.2 显示和查找资源

- 2.2.3 更新资源

- 2.2.4 修补资源

- 2.2.5 编辑资源

- 2.2.6 scale 资源

- 2.2.7 删除资源

- 2.3 Pod 与集群

-

- 2.3.1 与运行的 Pod 交互

- 2.3.2 与节点和集群交互

- 2.4 资源类型与别名

- 2.5 格式化输出

- 3 API 概述

-

- 3.1 类型

-

- 3.1.1 Alpha

- 3.1.2 Beta

- 3.1.3 Stable

- 3.2 访问控制

-

- 3.2.1 认证

- 3.2.1 授权

- 3.3 废弃 api 说明

学习资料

学习视频:完整版Kubernetes(K8S)全套入门+微服务实战项目,带你一站式深入掌握K8S核心能力

学习资料:k8s配套资料

1 搭建方案

1.1 minikube【推荐学习时使用】

推荐学习时使用,轻量化的k8s集群,可以在个人电脑上使用。

minikube 是一个工具, 能让你在本地运行 Kubernetes。 minikube 在你的个人计算机(包括 Windows、macOS 和 Linux PC)上运行一个一体化(all-in-one)或多节点的本地 Kubernetes 集群,以便你来尝试 Kubernetes 或者开展每天的开发工作。

官方安装文档

1.2 kubeadm【推荐使用】

你可以使用 kubeadm 工具来创建和管理 Kubernetes 集群。 该工具能够执行必要的动作并用一种用户友好的方式启动一个可用的、安全的集群。

安装 kubeadm 展示了如何安装 kubeadm 的过程。一旦安装了 kubeadm, 你就可以使用它来创建一个集群。

服务器要求:3 台服务器(虚拟机)

- k8s-master:192.168.3.241

- k8s-node1:192.168.3.242

- k8s-node2:192.168.3.243

最低配置:2核、2G内存、20G硬盘,最好能联网,不能联网的话需要有提供对应镜像的私有仓库。

软件环境:

- 操作系统:CentOS 7

- Docker:20+

- k8s:1.23.6

安装步骤

1.2.0 提示(步骤调整)

这里将1.2.3 中 安装的Docker的步骤先放到了1.2.1 安装Docker(所有节点),这个不影响整体的步骤。

1.2.1 安装Docker(所有节点)

安装 Docker:Centos7安装docker

1.2.2 初始操作(所有节点)

# 关闭防火墙

systemctl stop firewalld

# 禁用防火墙

systemctl disable firewalld

# 关闭selinux

sed -i 's/enforcing/disabled/' /etc/selinux/config # 永久

# 或

setenforce 0 # 临时

# 关闭swap

sed -ri 's/.*swap.*/#&/' /etc/fstab # 永久

# 或

swapoff -a # 临时

# 关闭完swap后,一定要重启一下虚拟机!!!

# 根据规划重新设置各节点的主机名,设置完后记得重启虚拟机!!!

hostnamectl set-hostname <hostname>(k8s-master、k8s-node1、k8s-node2)

# 在各个节点的hosts加入配置后的主机名

cat >> /etc/hosts << EOF

192.168.3.241 k8s-master

192.168.3.242 k8s-node1

192.168.3.243 k8s-node2

EOF

# 将桥接的IPv4流量传递到iptables的链

cat > /etc/sysctl.d/k8s.conf << EOF

net.bridge.bridge-nf-call-ip6tables = 1

net.bridge.bridge-nf-call-iptables = 1

EOF

sysctl --system # 生效

# 时间同步

yum install ntpdate -y

ntpdate time.windows.com

1.2.3 安装基础软件 kubeadm、kubelet、kubectl(所有节点)

- 添加阿里云 yum 源

cat > /etc/yum.repos.d/kubernetes.repo << EOF

[kubernetes]

name=Kubernetes

baseurl=https://mirrors.aliyun.com/kubernetes/yum/repos/kubernetes-el7-x86_64

enabled=1

gpgcheck=0

repo_gpgcheck=0

gpgkey=https://mirrors.aliyun.com/kubernetes/yum/doc/yum-key.gpg https://mirrors.aliyun.com/kubernetes/yum/doc/rpm-package-key.gpg

EOF

- 安装 kubeadm、kubelet、kubectl

yum install -y kubelet-1.23.6 kubeadm-1.23.6 kubectl-1.23.6

systemctl enable kubelet

配置关闭 Docker 的 cgroups,修改 /etc/docker/daemon.json:

# 加入以下内容

"exec-opts": ["native.cgroupdriver=systemd"]

完整配置:

{

"registry-mirrors": ["https://almtd3fa.mirror.aliyuncs.com","http://hub-mirror.c.163.com","http://mirrors.ustc.edu.cn"],

"exec-opts": ["native.cgroupdriver=systemd"]

}

# 使配置生效

systemctl daemon-reload

# 重启docker

systemctl restart docker

1.2.4 部署 Kubernetes Master(在 Master 节点下执行)

kubeadm init \

--apiserver-advertise-address=192.168.3.241 \

--image-repository registry.aliyuncs.com/google_containers \

--kubernetes-version v1.23.6 \

--service-cidr=10.96.0.0/12 \

--pod-network-cidr=10.244.0.0/16

可能耗时有一点长,看网络情况,如下显示则安装成功:

Your Kubernetes control-plane has initialized successfully!

To start using your cluster, you need to run the following as a regular user:

mkdir -p $HOME/.kube

sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

sudo chown $(id -u):$(id -g) $HOME/.kube/config

Alternatively, if you are the root user, you can run:

export KUBECONFIG=/etc/kubernetes/admin.conf

You should now deploy a pod network to the cluster.

Run "kubectl apply -f [podnetwork].yaml" with one of the options listed at:

https://kubernetes.io/docs/concepts/cluster-administration/addons/

Then you can join any number of worker nodes by running the following on each as root:

kubeadm join 192.168.3.241:6443 --token f9v1xg.4vqoarsfo0zfrhge \

--discovery-token-ca-cert-hash sha256:54795fb6e9ee1ae628549bf9ae2fad9245aa5b25f62dd3e6af8995cdc4e5b69f

注意最后有生成token的命令,这个在下一步会用到。

# 安装成功后,复制如下配置并执行

mkdir -p $HOME/.kube

sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

sudo chown $(id -u):$(id -g) $HOME/.kube/config

# 查看节点情况

kubectl get nodes

# 显示结果

[root@k8s-master ~]# kubectl get nodes

NAME STATUS ROLES AGE VERSION

k8s-master NotReady control-plane,master 12m v1.23.6

1.2.5 加入 Kubernetes Node(分别在 k8s-node1 和 k8s-node2 执行)

# 下方命令可以在 k8s master 控制台初始化成功后复制 join 命令

kubeadm join 192.168.3.241:6443 --token f9v1xg.4vqoarsfo0zfrhge \

--discovery-token-ca-cert-hash sha256:54795fb6e9ee1ae628549bf9ae2fad9245aa5b25f62dd3e6af8995cdc4e5b69f

# 结果:

This node has joined the cluster:

* Certificate signing request was sent to apiserver and a response was received.

* The Kubelet was informed of the new secure connection details.

Run 'kubectl get nodes' on the control-plane to see this node join the cluster.

在master节点查看集群情况:

kubectl get nodes

[root@k8s-master ~]# kubectl get nodes

NAME STATUS ROLES AGE VERSION

k8s-master NotReady control-plane,master 51m v1.23.6

k8s-node1 NotReady <none> 48m v1.23.6

k8s-node2 NotReady <none> 48m v1.23.6

重新生成token:

# 如果初始化的 token 不小心清空了,可以通过如下命令获取或者重新申请

# 如果 token 已经过期,就重新申请

kubeadm token create

# token 没有过期可以通过如下命令获取

kubeadm token list

# 获取 --discovery-token-ca-cert-hash 值,得到值后需要在前面拼接上 sha256:

openssl x509 -pubkey -in /etc/kubernetes/pki/ca.crt | openssl rsa -pubin -outform der 2>/dev/null | \

openssl dgst -sha256 -hex | sed 's/^.* //'

1.2.6 部署 CNI 网络插件

1.2.6.1 下载相关镜像(所有节点)

- 创建相关目录

# 在/opt/下创建k8s,即:/opt/k8s/

-

(可跳过)选择 calico 配置文件(calico.yaml)下载地址

地址1:https://docs.projectcalico.org/manifests/calico.yaml可在浏览器上访问地址1,如果地址1无法访问,访问:https://docs.projectcalico.org,会发现地址会跳转到

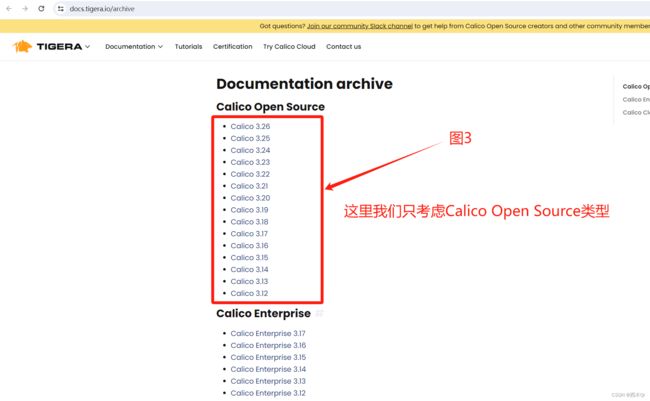

https://docs.tigera.io,然后点击Calico Open Source,进入:图2所示页面,继续点击 All versions 可以查看Calico的版本情况(图3),根据需要选择对应版本。

地址2:https://docs.tigera.io/archive/{version}/manifests/calico.yaml,注意要把{version}替换为对应的版本,例如:https://docs.projectcalico.org/v3.25/manifests/calico.yaml、https://docs.tigera.io/archive/v3.24/manifests/calico.yaml

- 下载 calico 配置文件(calico.yaml)

# 在/opt/k8s/路径下面下载 calico 配置文件(calico.yaml),可能会网络超时

wget https://docs.projectcalico.org/v3.25/manifests/calico.yaml --no-check-certificate

- 修改下载的 calico.yaml

# 修改下载的 calico.yaml 文件中的 CALICO_IPV4POOL_CIDR 配置。

# 如果 CALICO_IPV4POOL_CIDR 是注释掉的,也就是没有启用的,可以不修改。

# 如果要启用,先把前面的注释去掉,然后修改为与初始化时,--pod-network-cidr=10.244.0.0/16中的相同,即改为:

- name: CALICO_IPV4POOL_CIDR

value: "10.244.0.0/16"

# 修改 IP_AUTODETECTION_METHOD 下的网卡名称,没有该配置则不用修改

- 去除下载地址的

docker.io/前缀

# 查看有docker.io/前缀的地址

grep image calico.yaml

[root@k8s-master k8s]# grep image calico.yaml

image: docker.io/calico/cni:v3.25.0

imagePullPolicy: IfNotPresent

image: docker.io/calico/cni:v3.25.0

imagePullPolicy: IfNotPresent

image: docker.io/calico/node:v3.25.0

imagePullPolicy: IfNotPresent

image: docker.io/calico/node:v3.25.0

imagePullPolicy: IfNotPresent

image: docker.io/calico/kube-controllers:v3.25.0

imagePullPolicy: IfNotPresent

# 删除镜像 docker.io/ 前缀,避免下载过慢导致失败,命令如下:

sed -i 's#docker.io/##g' calico.yaml

- 在master、node1、node2节点下载好相关镜像,以免影响构建进度或导致构建失败

# 如果构建时下载镜像比较慢,可使用docker单独下载镜像后重新构建

docker pull calico/cni:v3.25.0

docker pull calico/node:v3.25.0

docker pull calico/kube-controllers:v3.25.0

1.2.6.2 构建应用(在 master 节点上执行)

# 在/opt/k8s/执行构建命令

kubectl apply -f calico.yaml

# 查看应用信息

kubectl get po -n kube-system

[root@k8s-master k8s]# kubectl get po -n kube-system

NAME READY STATUS RESTARTS AGE

calico-kube-controllers-cd8566cf-sn2fz 1/1 Running 0 3m37s

calico-node-7h4nl 1/1 Running 0 3m37s

calico-node-b5wkj 1/1 Running 0 3m37s

calico-node-kpmr8 1/1 Running 0 3m37s

coredns-6d8c4cb4d-rr77x 1/1 Running 0 26m

coredns-6d8c4cb4d-wt8pf 1/1 Running 0 26m

etcd-k8s-master 1/1 Running 1 (20m ago) 26m

kube-apiserver-k8s-master 1/1 Running 1 (20m ago) 26m

kube-controller-manager-k8s-master 1/1 Running 1 (20m ago) 26m

kube-proxy-msxz4 1/1 Running 2 (5m16s ago) 21m

kube-proxy-w96nz 1/1 Running 1 (20m ago) 26m

kube-proxy-zq98q 1/1 Running 2 (5m10s ago) 21m

kube-scheduler-k8s-master 1/1 Running 1 (20m ago) 26m

# 查看某个Pod的运行情况

kubectl describe po calico-node-7h4nl(Pod名称) -n kube-system

# 查看集群信息

kubectl get nodes

[root@k8s-master k8s]# kubectl get nodes

NAME STATUS ROLES AGE VERSION

k8s-master Ready control-plane,master 27m v1.23.6

k8s-node1 Ready <none> 22m v1.23.6

k8s-node2 Ready <none> 21m v1.23.6

1.2.7 测试 kubernetes 集群

# 创建部署nginx

kubectl create deployment nginx --image=nginx

# 暴露端口

kubectl expose deployment nginx --port=80 --type=NodePort

# 查看 pod 以及服务信息

kubectl get pod,svc

[root@k8s-master k8s]# kubectl get pod,svc

NAME READY STATUS RESTARTS AGE

pod/nginx-85b98978db-p5r5z 0/1 ContainerCreating 0 15s

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

service/kubernetes ClusterIP 10.96.0.1 <none> 443/TCP 29m

service/nginx NodePort 10.111.11.157 <none> 80:31906/TCP 8s

这里可以发现pod/nginx-85b98978db-p5r5z的状态是容器创建中,可通过如下命令进一步查看原因:

kubectl describe pod nginx-85b98978db-p5r5z

# 在最下面的事件中,可以看到是在拉取nginx镜像中

Events:

Type Reason Age From Message

---- ------ ---- ---- -------

Normal Scheduled 63s default-scheduler Successfully assigned default/nginx-85b98978db-p5r5z to k8s-node2

Normal Pulling 63s kubelet Pulling image "nginx"

可以稍等一会儿查看 pod 以及服务信息,因为k8s会有相关机制保证服务的运行,所以不用再重新下载nginx镜像部署:

# 查看 pod 以及服务信息

kubectl get pod,svc

[root@k8s-master k8s]# kubectl get pod,svc

NAME READY STATUS RESTARTS AGE

pod/nginx-85b98978db-p5r5z 1/1 Running 0 29m

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

service/kubernetes ClusterIP 10.96.0.1 <none> 443/TCP 58m

service/nginx NodePort 10.111.11.157 <none> 80:31906/TCP 29m

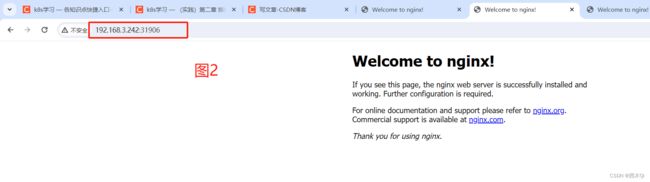

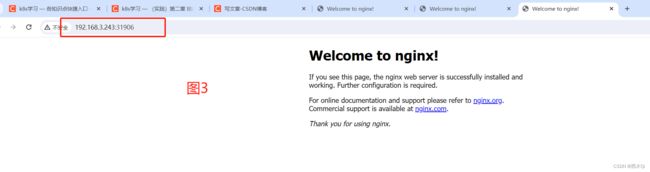

访问nginx服务时,注意对外的端口不是80,而是31906,完整地址:192.168.3.241:31906,通过node1、node2的IP加端口也可以访问到。

1.3 二进制安装

利用 k8s 官方 github 仓库下载二进制包安装,安装过程较复杂,但相对较为稳定,推荐生产环境使用。

1.4 命令行工具

2 命令行工具 kubectl

Kubernetes 提供 kubectl 是使用 Kubernetes API 与 Kubernetes 集群的 控制面 进行通信的命令行工具。

这个工具叫做 kubectl。

更多命令

2.1 在任意节点使用 kubectl

# 1. 将 master 节点中 /etc/kubernetes/admin.conf 拷贝到需要运行的服务器的 /etc/kubernetes 目录中

scp /etc/kubernetes/admin.conf root@k8s-node1:/etc/kubernetes

# 2. 在对应的服务器上配置环境变量

echo "export KUBECONFIG=/etc/kubernetes/admin.conf" >> ~/.bash_profile

source ~/.bash_profile

2.2 资源操作

2.2.1 创建对象

$ kubectl create -f ./my-manifest.yaml # 创建资源

$ kubectl create -f ./my1.yaml -f ./my2.yaml # 使用多个文件创建资源

$ kubectl create -f ./dir # 使用目录下的所有清单文件来创建资源

$ kubectl create -f https://git.io/vPieo # 使用 url 来创建资源

$ kubectl run nginx --image=nginx # 启动一个 nginx 实例

$ kubectl explain pods,svc # 获取 pod 和 svc 的文档

# 从 stdin 输入中创建多个 YAML 对象

$ cat <<EOF | kubectl create -f -

apiVersion: v1

kind: Pod

metadata:

name: busybox-sleep

spec:

containers:

- name: busybox

image: busybox

args:

- sleep

- "1000000"

---

apiVersion: v1

kind: Pod

metadata:

name: busybox-sleep-less

spec:

containers:

- name: busybox

image: busybox

args:

- sleep

- "1000"

EOF

# 创建包含几个 key 的 Secret

$ cat <<EOF | kubectl create -f -

apiVersion: v1

kind: Secret

metadata:

name: mysecret

type: Opaque

data:

password: $(echo "s33msi4" | base64)

username: $(echo "jane" | base64)

EOF

2.2.2 显示和查找资源

# Get commands with basic output

$ kubectl get services # 列出所有 namespace 中的所有 service

$ kubectl get pods --all-namespaces # 列出所有 namespace 中的所有 pod

$ kubectl get pods -o wide # 列出所有 pod 并显示详细信息

$ kubectl get deployment my-dep # 列出指定 deployment

$ kubectl get pods --include-uninitialized # 列出该 namespace 中的所有 pod 包括未初始化的

# 使用详细输出来描述命令

$ kubectl describe nodes my-node

$ kubectl describe pods my-pod

$ kubectl get services --sort-by=.metadata.name # List Services Sorted by Name

# 根据重启次数排序列出 pod

$ kubectl get pods --sort-by='.status.containerStatuses[0].restartCount'

# 获取所有具有 app=cassandra 的 pod 中的 version 标签

$ kubectl get pods --selector=app=cassandra rc -o \

jsonpath='{.items[*].metadata.labels.version}'

# 获取所有节点的 ExternalIP

$ kubectl get nodes -o jsonpath='{.items[*].status.addresses[?(@.type=="ExternalIP")].address}'

# 列出属于某个 PC 的 Pod 的名字

# “jq”命令用于转换复杂的 jsonpath,参考 https://stedolan.github.io/jq/

$ sel=${$(kubectl get rc my-rc --output=json | jq -j '.spec.selector | to_entries | .[] | "\(.key)=\(.value),"')%?}

$ echo $(kubectl get pods --selector=$sel --output=jsonpath={.items..metadata.name})

# 查看哪些节点已就绪

$ JSONPATH='{range .items[*]}{@.metadata.name}:{range @.status.conditions[*]}{@.type}={@.status};{end}{end}' \

&& kubectl get nodes -o jsonpath="$JSONPATH" | grep "Ready=True"

# 列出当前 Pod 中使用的 Secret

$ kubectl get pods -o json | jq '.items[].spec.containers[].env[]?.valueFrom.secretKeyRef.name' | grep -v null | sort | uniq

2.2.3 更新资源

$ kubectl rolling-update frontend-v1 -f frontend-v2.json # 滚动更新 pod frontend-v1

$ kubectl rolling-update frontend-v1 frontend-v2 --image=image:v2 # 更新资源名称并更新镜像

$ kubectl rolling-update frontend --image=image:v2 # 更新 frontend pod 中的镜像

$ kubectl rolling-update frontend-v1 frontend-v2 --rollback # 退出已存在的进行中的滚动更新

$ cat pod.json | kubectl replace -f - # 基于 stdin 输入的 JSON 替换 pod

# 强制替换,删除后重新创建资源。会导致服务中断。

$ kubectl replace --force -f ./pod.json

# 为 nginx RC 创建服务,启用本地 80 端口连接到容器上的 8000 端口

$ kubectl expose rc nginx --port=80 --target-port=8000

# 更新单容器 pod 的镜像版本(tag)到 v4

$ kubectl get pod mypod -o yaml | sed 's/\(image: myimage\):.*$/\1:v4/' | kubectl replace -f -

$ kubectl label pods my-pod new-label=awesome # 添加标签

$ kubectl annotate pods my-pod icon-url=http://goo.gl/XXBTWq # 添加注解

$ kubectl autoscale deployment foo --min=2 --max=10 # 自动扩展 deployment “foo”

2.2.4 修补资源

$ kubectl patch node k8s-node-1 -p '{"spec":{"unschedulable":true}}' # 部分更新节点

# 更新容器镜像; spec.containers[*].name 是必须的,因为这是合并的关键字

$ kubectl patch pod valid-pod -p '{"spec":{"containers":[{"name":"kubernetes-serve-hostname","image":"new image"}]}}'

# 使用具有位置数组的 json 补丁更新容器镜像

$ kubectl patch pod valid-pod --type='json' -p='[{"op": "replace", "path": "/spec/containers/0/image", "value":"new image"}]'

# 使用具有位置数组的 json 补丁禁用 deployment 的 livenessProbe

$ kubectl patch deployment valid-deployment --type json -p='[{"op": "remove", "path": "/spec/template/spec/containers/0/livenessProbe"}]'

2.2.5 编辑资源

$ kubectl edit svc/docker-registry # 编辑名为 docker-registry 的 service

$ KUBE_EDITOR="nano" kubectl edit svc/docker-registry # 使用其它编辑器

2.2.6 scale 资源

$ kubectl scale --replicas=3 rs/foo # Scale a replicaset named 'foo' to 3

$ kubectl scale --replicas=3 -f foo.yaml # Scale a resource specified in "foo.yaml" to 3

$ kubectl scale --current-replicas=2 --replicas=3 deployment/mysql # If the deployment named mysql's current size is 2, scale mysql to 3

$ kubectl scale --replicas=5 rc/foo rc/bar rc/baz # Scale multiple replication controllers

2.2.7 删除资源

$ kubectl delete -f ./pod.json # 删除 pod.json 文件中定义的类型和名称的 pod

$ kubectl delete pod,service baz foo # 删除名为“baz”的 pod 和名为“foo”的 service

$ kubectl delete pods,services -l name=myLabel # 删除具有 name=myLabel 标签的 pod 和 serivce

$ kubectl delete pods,services -l name=myLabel --include-uninitialized # 删除具有 name=myLabel 标签的 pod 和 service,包括尚未初始化的

$ kubectl -n my-ns delete po,svc --all # 删除 my-ns namespace 下的所有 pod 和 serivce,包括尚未初始化的

2.3 Pod 与集群

2.3.1 与运行的 Pod 交互

$ kubectl logs my-pod # dump 输出 pod 的日志(stdout)

$ kubectl logs my-pod -c my-container # dump 输出 pod 中容器的日志(stdout,pod 中有多个容器的情况下使用)

$ kubectl logs -f my-pod # 流式输出 pod 的日志(stdout)

$ kubectl logs -f my-pod -c my-container # 流式输出 pod 中容器的日志(stdout,pod 中有多个容器的情况下使用)

$ kubectl run -i --tty busybox --image=busybox -- sh # 交互式 shell 的方式运行 pod

$ kubectl attach my-pod -i # 连接到运行中的容器

$ kubectl port-forward my-pod 5000:6000 # 转发 pod 中的 6000 端口到本地的 5000 端口

$ kubectl exec my-pod -- ls / # 在已存在的容器中执行命令(只有一个容器的情况下)

$ kubectl exec my-pod -c my-container -- ls / # 在已存在的容器中执行命令(pod 中有多个容器的情况下)

$ kubectl top pod POD_NAME --containers # 显示指定 pod 和容器的指标度量

2.3.2 与节点和集群交互

$ kubectl cordon my-node # 标记 my-node 不可调度

$ kubectl drain my-node # 清空 my-node 以待维护

$ kubectl uncordon my-node # 标记 my-node 可调度

$ kubectl top node my-node # 显示 my-node 的指标度量

$ kubectl cluster-info # 显示 master 和服务的地址

$ kubectl cluster-info dump # 将当前集群状态输出到 stdout

$ kubectl cluster-info dump --output-directory=/path/to/cluster-state # 将当前集群状态输出到 /path/to/cluster-state

# 如果该键和影响的污点(taint)已存在,则使用指定的值替换

$ kubectl taint nodes foo dedicated=special-user:NoSchedule

2.4 资源类型与别名

- pods:po

- deployments:deploy

- services:svc

- namespace:ns

- nodes:no

2.5 格式化输出

- 输出 json 格式:

-o json - 仅打印资源名称:

-o name - 以纯文本格式输出所有信息:

-o wide - 输出 yaml 格式:

-o yaml

3 API 概述

官网文档:https://kubernetes.io/zh-cn/docs/reference/using-api

REST API 是 Kubernetes 系统的重要部分,组件之间的所有操作和通信均由 API Server 处理的 REST AP I调用,大多数情况下, API 定义和实现都符合标准的 HTTP REST 格式,可以通过 kubectl 命令管理工具或其他命令行工具来执行。

3.1 类型

3.1.1 Alpha

- 包含 alpha 名称的版本(例如v1alpha1)。

- 该软件可能包含错误。启用一个功能可能会导致 bug。默认情况下,功能可能会被禁用。

- 随时可能会丢弃对该功能的支持,恕不另行通知。

- API 可能在以后的软件版本中以不兼容的方式更改,恕不另行通知。

- 该软件建议仅在短期测试集群中使用,因为错误的风险增加和缺乏长期支持。

3.1.2 Beta

- 包含 beta 名称的版本(例如 v2beta3)。

- 该软件经过很好的测试。启用功能被认为是安全的。默认情况下功能是开启的。

- 细节可能会改变,但功能在后续版本不会被删除

- 对象的模式或语义在随后的 beta 版本或 Stable 版本中可能以不兼容的方式发生变化。如果这种情况发生时,官方会提供迁移操作指南。这可能需要删除、编辑和重新创建API对象。

- 该版本在后续可能会更改一些不兼容地方,所以建议用于非关键业务,如果你有多个可以独立升级的集群,你也可以放宽此限制。

- 大家使用过的 Beta 版本后,可以多给社区反馈,如果此版本在后续更新后将不会有太大变化。

3.1.3 Stable

- 该版本名称命名方式:vX 这里 X 是一个整数。

- Stable 版本的功能特性,将出现在后续发布的软件版本中。

3.2 访问控制

3.2.1 认证

3.2.1 授权

3.3 废弃 api 说明

https://kubernetes.io/zh-cn/docs/reference/using-api/deprecation-guide