《大数据》第1期“研究”——大数据管理系统评测基准的挑战与研究进展(下)...

![]()

4 BSMA:面向社交媒体数据分析型查询的基准评测

4.1 BSMA框架

BSMA是一个社交媒体数据分析型查询评测基准[8,9],它包含了社交媒体数据的形式化描述规范和一个真实的社交媒体数据集,定义了24个测试查询,提供了评测系统查询性能的工具以及用于产生社交媒体时间轴(timeline)的数据生成器BSMA-Gen[10]。BSMA的系统结构如图3所示[9],BSMA所针对的数据定义如图4所示[9]。其自带的真实数据集和数据生成器所产生的模拟数据都符合这一数据定义。

图3 BSMA框架

图4 BSMA数据定义

社交媒体数据分析具有典型的大数据应用的特征:首先,社交媒体数据并非传统的关系数据,具有时序数据、文本和多媒体数据、图数据和结构化数据的多重特征;其次,社交媒体数据量大、更新速度快;第三,社交媒体数据分析通常分析任务复杂、具有较高的实时性要求。BSMA的研究是BDMS评测基准研究的一项初期工作,从中可以体现研究问题和难点所在。

4.2 数据生成

为了完成模拟社交媒体时间线的生成任务,BSMA-Gen完成2个基本工作:模拟真实的社交媒体数据分布和高效产生时间线[10]。

BSMA-Gen产生时间轴,即消息数据流,每一条消息可表示为一个元组:m=

BSMA-Gen将每个用户发布信息的过程模拟成非齐次泊松过程(nonhomogeneousPoisson process),从而可根据不同配置参数产生带有相应分布的社交媒体时间轴数据。

社交媒体时间线中的元组间转发相关性随着时间间隔变大而衰减。BSMA-Gen采用衰退函数模拟这一关系,并通过维护历史元组缓冲池和待产生元组缓冲池实现了元素的流式产生。同时,为了进一步加快时间线的产生速度,BSMA-Gen采用主从(master-slave)结构,由主节点进行发布者社交网络划分。每个从节点负责一个分区中所有发布者所发布的消息组成的部分时间线的生成。当一个从节点需要从其他分区获取发布者和社交网络信息以确定一个元素的f指针时,该元素的输出会被推迟,以等待远程从节点的信息到来。采用这种异步传输、延时生成的策略,每个元素的生成都不需要等待网络通信。实验表明,BSMA-Gen可以确保生成的时间线在转发结构、时序分布、用户消息数等方面符合预先给定的分布和参数,且吞吐率(即单位时间生成的元素数)与从节点个数呈线性增长关系。

4.3 负载

BSMA提供了24个典型社交媒体数据分析型查询负载。每个负载反映了一种或多种社交媒体数据分析的特性。BSMA负载主要覆盖了以下3类查询特性。

● 社交网络查询(socialnetwork query,SNQ):社交网络的查询围绕消息发布者的关系展开。它的目标是查询社交网络的某个特定模式或子图。

● 时间线查询(timelinequery,TQ):在社交媒体中,时间线(timeline)是指以时间逆序排列的消息序列,序列中消息的条数即时间线的长度。时间线广义上可分全局时间线(globaltimeline)和局部时间线(local timeline)两种,全局时间线中的消息来自社交媒体中的任意用户,而局部时间线则限制了用户范围。时间线查询的本质是对于时间序列的查询。

● 热点查询(hotspotquery,HQ):热点是指在某个特定的时间线内消息中满足某些过滤条件且统计值最大的某类元素的集合。由于社交媒体中数据的统计值分布常符合幂律(power-law)分布,对热点的查询在进行数据连接(join)和聚集(aggregation)计算时往往需要远超出查询其他元素的存储和计算开销。

处理这些负载可能需要对两个大的集合(关系)进行连接操作、对大集合进行多属性查询或对大集合进行聚集计算,而这些操作的处理通常是耗时、耗存储资源的。因此,这些负载能够测试数据管理系统在社交媒体数据分析这一特定应用中的性能表现。

4.4 评测指标与评测方法

BSMA使用以下3个性能评判指标。对于24个典型负载的组合,计算出这3个指标的值,以此来衡量查询处理性能。当然,查询执行的正确性是性能度量的基本前提。

● 吞吐率指标:吞吐率指单位时间内完成的查询数。在这里,吞吐率指标度量的是在不同线程数设置下能达到的吞吐率最高值,这个值越高意味着性能越好。

● 延时指标:延时指一个查询从发起请求到返回结果所需的时间。在这里,延时指标度量的是在不同线程数设置下所达到的次高吞吐率下(即系统未过载时)的查询延时,这个值越低意味着性能越好。

● 扩展性指标:扩展性指随着吞吐率的提高系统维持延时的能力。在这里,扩展性指标度量的是用最小二乘法拟合多个数据点的直线斜率。这些数据点对应不同线程数设置下的吞吐量(横坐标)和延时(纵坐标),拟合直线越平滑意味着扩展性越好。

5 相关工作

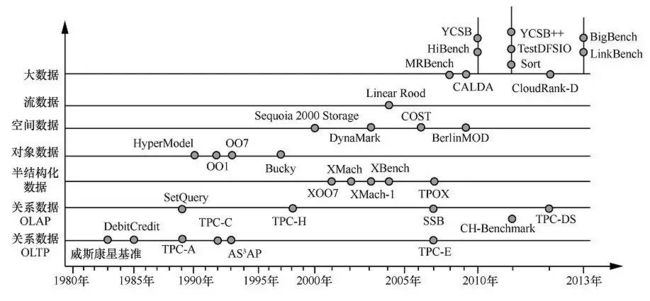

数据库评测基准研究在关系数据管理和非关系型数据管理方面均取得较大进展。针对大数据管理领域的基准评测工作则刚起步。图5概要地展示了数据管理系统评测基准的发展过程[11]。

图5 数据管理系统评测基准的发展

5.1 面向关系模型的数据库系统评测基准

早期数据库评测基准主要针对RDBMS,相关研究持续至今。事务处理委员会(TPC)是事实上的工业化标准组织,已经提出多个基准来评测RDBMS[12]。现有RDBMS评测基准可被划分为3类:面向联机事务处理(OLTP)、面向联机分析处理(OLAP)以及同时支持OLAP和OLTP的评测基准。

● 面向OLTP的基准:面向OLTP的基准评测包括威斯康星基准[2]、DebitCredit[13]、AS3AP[14]、TPC-C和TPC-E等。其中,TPC-C和TPC-E目前仍在使用。它们分别仿真仓库订单管理应用和证券交易应用。

● 面向OLAP的基准:此类基准的负载包含大量聚集查询,包括SetQuery[15]、SSB[16]、TPC-H和TPC-DS等。其中TPC-H和TPC-DS目前仍在使用,分别模拟商务采购应用和决策支持应用。

● 同时支持OLAP和OLTP的基准:部分新兴数据管理技术支持同时具有OLAP和OLTP需求的应用。CH-Benchmark基准有效融合了TPC-C和TPC-H两个基准,同时支持OLAP和OLTP评测。CBTR则提供了OLAP/OLTP复合负载[17]。

5.2 面向非关系型数据的基准设计

数据管理技术发展的过程是不断地将非结构化数据结构化,纳入DBMS,从而降低管理成本、提高利用效率的过程。针对各种非关系型数据,有不同的基准对相关技术和系统进行评测,见表1。

5.3 面向大数据管理技术的基准

不同的BDMS的功能和接口各不相同。当前的BDMS基准评测研究工作从以下3个方面展开。

● 评测MapReduce功能的基准:MapReduce是大数据处理中最常用的编程模式(paradigm)。此类基准主要评测MapReduce实现的性能。面向特定功能的此类基准包括:模拟TPC-H的MRBench[33]、评测HDFS文件系统的TestDFSIO[34]、Hadoop自带的Sort[34]和用于测试Pig的PigMix[35]等。此外,一些基准可同时评测多种功能,如评测Hadoop整体性能的GridMix、混合功能基准IntelHiBench以及涵盖了常用数据挖掘和数据仓库操作的CloudRank-D[36]。

● BDMS基准评测:CALDA基准可比较不同BDMS的性能[4]。YCSB[37]及其扩展YCSB++[38]可从性能和可扩展性两个层面评测云服务系统。Floratou等人对面向文档的NoSQL系统、面向决策支持的系统以及商用的DBMS进行了性能评测[39]。Rabl等人则比较了6种开源数据存储系统在不同负载下的性能[40]。

● 面向应用的大数据基准评测:BigBench是一种面向商品零售业的基准,扩展了TPC-DS[41]。LinkBench是一个由Facebook提出,基于真实社交网络应用的大规模图数据评测基准[42]。而LDBC则是由欧盟资助的链接数据管理基准评测组织,并已发布多个评测基准[43]。

5.4 国内的相关工作

针对新型计算机系统的基准评测、新型DBMS的性能测试、新型数据库基准评测等问题,国内学者也开展了广泛而深入的研究。

在新型计算机系统的基准评测方面,中国科学院计算技术研究所提出了ICTBench,包含面向数据仓库负载的DCBench[44,45]、面向BDMS的BigDataBench[46,47]和面向云计算系统的CloudRank[36]3个部分。中国人民大学孟小峰等人提出了CloudBM基准来评测云数据管理系统[48]。清华大学郑纬民等人利用代表性的基准测试对NAS存储系统进行了研究、比较和分析[49]。

大数据应用中广泛使用了包括内存数据库、NoSQL/NewSQL系统在内的大量新型DBMS。中国人民大学王珊等人利用TPC-H评测了多款内存数据库的性能[50];杜小勇等人使用TPC-DS基准,在100个节点的集群上,对5种主流的开源BDMS进行了全面深入的测试与分析,并在2013年的中国大数据技术大会上报告。华东师范大学金澈清等人提出了MemTest,以评测内存DBMS的主要性能特性[51]。清华大学王建民团队在NoSQL数据库基础上,实现了MOLAP引擎,并使用TPC-DC基准进行了测试[52]。此外,他们在OLAP系统的性能测试[53]、DBMS性能测试[54]等方面做了重要的基础性工作。上海交通大学使用BigDataBench来评测数据中心上的资源共享策略[55];西安交通大学则使用这一基准来诊断大数据系统中的性能瓶颈[56]。

在BDMS的评测基准开发方面,BigDataBench包含了6个应用场景的数据集合和19类负载[46,47]。华东师范大学提出了一种面向社交媒体数据分析型查询处理的评测基准BSMA[8,9];提出了一种并行社交媒体数据生成方法,以仿真微博等社交媒体数据[10]。周敏奇等人则设计了一种更为通用的可扩展的高仿真数据生成器框架[57]。而清华大学则针对工作流数据管理系统的负载生成开展了研究[58]。

6 结束语

在“大数据”热潮下,大数据管理系统的研发和应用进展迅速,而相应的评测基准理论和方法研究则刚刚起步。针对大数据应用,特别是我国金融、电信、电子商务等具有鲜明应用特点的大数据应用的特点,遵循“同类适用”原则,从数据生成、负载生成、性能指标体系和测量方法这3个角度入手,解决应用环境适配和仿真、科学和公平评测、评测结果比较与分析等问题,是大数据管理系统评测基准研究的重要问题。现有的工作从应用和系统建模、数据仿真、数据和负载的高效生成、多维度性能指标设计等角度开展了研究。但对于设计和实现具有良好仿真能力、高适配能力的评测基准而言,非结构化数据仿真、超高负载环境模拟与评测方法、兼顾分析效果和性能的度量指标、开放环境下的性能评测和评测结果分析等问题仍是具有挑战性的研究问题。

参考文献

[1] GrayJ. Benchmark handbook for database and transaction system (2nd edition). SanFrancisco: Morgan Kaufmann, 1993

[2] BittonD, DeWitt D J, Turbyfil C. Benchmarking database systems: a systematicapproach. Proceedings of the 9th VLDB Conference, Florence, Italy, 1983

[3] LaneyD. 3D Data Management: Controlling Data Volume, Velocity and Variety. TechnicalReport, Meta Group, 2001

[4] PavloA, Paulson E, Rasin A, et al. A comparison of approaches to large-scale dataanalysis. Proceedings of ACM SIGMOD/PODS Conference, Providence, Rhode Island,USA, 2009

[5] CareyM J. BDMS performance evaluation: practices, pitfalls, and possibilities.Proceedings of the 4th TPC Technology Conference, Istanbul, Turkey, 2012

[6] VolkerMarkl. Big Data. VLDB Database Summer School (China) Slides, 2013

[7] StonebrakerM. Technical perspective one size fits all: an idea whose time has come andgone. Communications of the ACM, 2008, 51(12)

[8] MaH X, Wei J X, Qian W N, et al. On benchmarking online social media analyticalqueries. Proceedings of Graph Data-management Experiences & Systems, NewYork, USA, 2013

[9] XiaF, Li Y, Yu C C, et al. BSMA: A benchmark for analyticalqueries over social media data. Proceedings of the VLDB Endowment, 2014, 7(13):1573~1576

[10] YuC C, Fan X, Qian W N, et al. BSMA-Gen: a parallel synthetic data generator forsocial media timeline structures. Proceedings of the 19th InternationalConference on Database Systems for Advanced Applications, Bali, Indonesia, 2014

[11] 金澈清, 钱卫宁, 周敏奇等. 数据管理系统评测基准: 从传统数据库到新兴大数据. 计算机学报. 2015, 38(1): 18~34

JinC Q, Qian W N, Zhou M Q, et al. Benchmarking data management systems: fromtraditional database to emergent big data. Chinese Journal of Computers, 2015,38(1): 18~34

[12] Nambiar R, Wakou N, Masland A, et al. Shaping the landscape of industrystandard benchmarks: contributions of the transaction processing performancecouncil (TPC). Proceedings of the 3rd TPC Technology Conference, Seattle, Wa,USA, 2011

[13] BittonD, Brown M, Catell R, et al. A measure of transaction processing power.Datamation, 1985, 31(7): 112~118

[14] TurbyfillC, Orji C, Bitton D. AS3AP-An ANSI SQL Standard Scalable and Portable Benchmarkfor Relational Database Systems. Chapter 5, Benchmark handbook for database andtransaction system (2nd edition). San Francisco: Morgan Kaufmann, 1993

[15] O’Neil. RevisitingDBMS benchmarks. Datamation, 1989, 35(9): 47~52

[16] O’Neil P, O’Neil B, Chen X D. The Star Schema Benchmark (SSB). University ofMassachusetls, Boston, 2007

[17] BogA. Benchmarking Transaction and Analytical Processing Systems: The Creation ofa Mixed Workload Benchmark and Its Application. Berlin: Springer, 2013

[18] CattellR G G, Skeen J. Object operations benchmark. ACM Transactions on DatabaseSystems, 1992, 17(1): 1~31

[19] CareyM J, DeWitt D J, Naughton J F. The OO7 benchmark. Proceedings of ACM SIGMODInternational Conference on Management of Data, Washington, DC, USA, 1993

[20] AndersonT L, Berre A J, Mallison M, et al. The HyperModel benchmark. Proceedings of the 2ndInternational Conference on Extending Database Technology: Advances in DatabaseTechnology, Venice, Italy, 1990

[21] Carey M J, DeWitt D J, Naughton J F, et al. The BUCKY object-relationalbenchmark. Proceedings of ACM SIGMOD International Conference on Management ofData, Tucson, Arizona, USA, 1997

[22] RunapongsaK, Patel J M, Jagadish H V, et al. The Michigan benchmark: towards XML queryperformance diagnostics. Information Systems, 2006, 31(2): 73~97

[23] YaoB, Ozsu M T, Khandelwal N. XBench benchmark and performance testing of XMLDBMSs. Proceedings of the 30th IEEE International Conference on DataEngineering, Chicago, IL, USA, 2004

[24] Bōhme T, Rahm E.Multi-user evaluation of XML data management systems with XMach-1. Proceedingsof the Workshop on Efficiency and Effectiveness of XML Tools and Techniques(EEXTT), Heidelberg, Germany, 2002

[25] SchmidtA, Waas F, Kersten M, et al. XMark: a benchmark for XML data management.Proceedings of the 28th International Conference on Very Large Data Bases, HongKong, China, 2002

[26] LiY, Bressan S, Dobbie G, et al. XOO7: applying OO7 benchmark to XML queryprocessing tools. Proceedings of Conference on Information and KnowledgeManagement, Washington, DC, USA, 2001

[27] NicolaM, Kogan I, Schiefer B. An XML transaction processing benchmark. Proceedings ofthe 26th ACM SIGMOD-SIGACT-SIGART Symposium on Principles of Database Systems,Beijing, China, 2007

[28] WersteinP. A performance benchmark for spatiotemporal databases. Proceedings of the10th Annual Colloquium of the Spatial Information Research Centre, Dunedin, NewZealand, 1998

29 MyllymakiJ, Kaufman J. DynaMark: a benchmark for dynamic spatial indexing. Proceedingsof the 4th International Conference on Mobile Data Management, Melbourne,Australia, 2003

]30] JensenC, Tiesyte D, Tradisauskas N. The COST benchmark-comparison and evaluation ofspatio-temporal indexes. Proceedings of the 11th International Conference onDatabase Systems for Advanced Applications, Singapore, 2006

[31] Düntgen C, Behr T, Güting R H. BerlinMOD: a benchmark for moving object databases. TheVLDB Journal, 2009, 18(6): 1335~1368

[32] ArasuA, Cherniack M, Galvez E, et al. Linear road: a stream data management benchmark.Proceedings of the 30th International Conference on Very Large Data Bases,Toronto, Canada, 2004

[33] KimK, Jeon K, Han H, et al. MRBench: a benchmark for MapReduceframework. Proceedings of the 14th IEEE International Conference on Paralleland Distributed Systems, Melbourne, Victoria, Australia, 2008

[34] WhiteT. Hadoop权威指南(第二版). 周敏奇, 王晓玲,金澈清等译. 北京: 清华大学出版社, 2011

WhiteT. Hadoop: The Definitive Guide. Translated by Zhou M Q, Wang X L, Jin C Q, et al. Beijing: Tsinghua University Press,2011

[35] Daniel.Pig mix. https://cwiki.apache.org/confluence/display/PIG/PigMix, 2013

[36] LuoC, Zhan J, Jia Z, et al. CloudRank-D: benchmarking andranking cloud computing systems for data processing applications. Frontiers ofComputer Science, 2012, 6(4): 347~362

[37] CooperB, Silberstein A, Tam E, et al. Benchmarking cloud serving systems with YCSB.Proceedings of ACM Symposium on Cloud Computing, Indianapolis, IN, USA, 2010

[38] PatilS, Polte M, Ren K, et al. YCSB++: benchmarking andperformance debugging advanced features in scalable table stores. Proceedingsof ACM Symposium on Cloud Computing, Cascais, Portugal, 2011

[39] Floratou A, Teletia N, DeWitt D J, et al. Can the elephants handle the NoSQLonslaught. Proceedings of the VLDB Endowment, 2012, 5(12): 1712~1723

[40] RablT, Gómez-Villamor S, Sadoghi M, et al. Solving big data challenges forenterprise application performance management. Proceedings of the VLDBEndowment, 2012, 5(12): 1724~1735

[41] GhazalA, Rabl T, Hu M, et al. BigBench: towards an industrystandard benchmark for big data analytics. Proceedings of ACM SIGMOD/PODSConference, New York, USA, 2013

[42] ArmstrongT G , Ponnekanti V, Borthakur D, et al. LinkBench: a database benchmark based on theFacebook social graph. Proceedings of the ACM SIGMOD/PODS Conference, New York,USA, 2013

[43] Boncz P A, Fundulaki I, Gubichev A, et al.The linked data benchmark councilproject. Datenbank-Spektrum, 2013, 13(2):121~129

[44] JiaZ, Wang L, Zhan J, et al. Characterizing data analysisworkloads indata centers. Proceedings of IEEE International Symposium on WorkloadCharacterization, Portland, OR, USA, 2013

[45] Xi H F, Zhan J F, Zhen J, et al. Characterization of Real Workloads of Web Search Engines. Proceedings ofIEEE International Symposium on Workload Characterization, Austin, TX , USA,2011

[46] WangL, Zhan J F, Luo C J, et al. BigDataBench: a big data benchmark suite frominternet services. Proceedings of the 24th IEEE International Symposium on HighPerfornance Computer Architecture, Orlando, Florida, USA, 2014

[47] ZhuY, Zhan J. BigOP: generating comprehensive big data workloads as a benchmarkingframework. Proceedings of the 19th International Conference on Database Systemsfor Advanced Applications, Bali, Indonesia, 2014

[48] 刘兵兵,孟小峰,史英杰. CloudBM:云数据管理系统测试基准. 计算机科学与探索, 2012, 6(6): 504~512

LiuB B, Meng X F, Shi Y J. CloudBM: a benchmark for cloud data management systems.Journal of Frontiers of Computer Science and Technology, 2012, 6(6): 504~512

[49] 付长冬, 舒继武, 沈美明等. 网络存储系统性能基准的研究、评价与发展. 小型微型计算机系统, 2004, 25(12): 2049~2054

Fu C D, Shu J W, Shen M M, et al. Evaluation, research anddevelopment of performance benchmark on network storage system. Journal ofChinese Computer Systems, 2004, 25(12): 2049~2054

[50] 刘大为,栾华,王珊等. 内存数据库在TPC-H负载下的处理器性能. 软件学报, 2008, 19(10): 2574~2584

LiuD W, Luan H, Wang S, et al. Main memory database TPC-H workloadcharacterization on modern processor. Journal of Software, 2008, 19(10):2574~2584

[51] KangQ Q, Jin C Q, Zhang Z, et al. MemTest: a novel benchmark for in-memory database.Proceedings of the 5th Workshop on Big Data Benchmarks, PerformanceOptimization, and Emerging Hardware, Hangzhou, China, 2014

[52] ZhaoH W, Ye X J. A practice of TPC-DS multidimensional implementation on NoSQLdatabase systems. Proceedings of the 5th TPC Technology Conference, Trento,Italy, 2013

[53] 赵博,叶晓俊. OLAP性能测试方法研究与实现. 计算机研究与发展, 2011, 48(10): 1951~1959

ZhaoB, Ye X J. Study and implementation of OLAP performance benchmark. Journal ofComputer Research and Development, 2011, 48(10): 1951~1959

[54] 叶晓俊,王建民. DBMS性能评价指标体系. 计算机研究与发展, 2009, 46(增刊): 313~318

YeX J, Wang J M. DBMS performance evaluation indicators. Journal of ComputerResearch and Development, 2009, 46(suppl.): 313~318

[55] NingF F, Weng C L, Luo Y. Virtualization I/O optimization based on shared memory.Proceedings of the IEEE International Conference on Big Data, Santa Clara, USA,2013

[56] ChenP, Qi Y, Li X, et al. An ensemble MIC-based approach forperformance diagnosis in big data platform. Proceedings of the IEEEInternational Conference on Big Data, Santa Clara, USA, 2013

[57] GuL, Zhou M Q, Zhang Z J, et al. Chronos: an elastic parallel framework for streambenchmark generation and simulation. Proceedings of the 31st IEEE InternationalConference on Data Engineering, Seoul, Korea, 2015

[58] Du N Q, Ye X J, Wang J M. Towardsworkflow-driven database system workload modeling. Proceedings of the 2ndInternational Workshop on Testing Database Systems, Providence, Rhode Island,USA, 2009

![]()