【视频超分辨率】视频超分辨率的介绍(定义,评价指标,分类)

视频超分辨率

视频超分辨率简单介绍

视频超分率起源于图像超分率,旨在根据已有的低分辨率视频序列生成具有真实细节和内容连续的高分辨率视频序列。视频超分辨率技术可以将低分辨率(低清晰度)视频转换为高分辨率(高清晰度)视频,以提供更多的细节和清晰度。

视频超分辨率技术主要分为传统方法和基于深度学习的方法两类。

视频超分辨率评价标准主要为峰值信噪比(PSNR)和结构相似性(SSIM)。

接下来,我将展开详细介绍视频超分的两个方法和评价标准。

传统方法

首先注意,传统方法实现效果与深度学习相差甚远,本文仅简单介绍。

优点:

实现简单,无需训练,可直接使用。

缺点:

这些算法受限于特定假设,在满足条件的情况下能够获得较好的仿真结果。但由于实际场景无法满足所有假设条件,因此 此类算法在实际应用中的效果并不理想,并且无法满足 4 倍放大因子的需求。

传统方法包括基于插值的超分辨率方法,Harris Goodman频谱外推法,傅里叶变换来实现高分辨率图像和使用贝叶斯方法来实现高分辨率图像等等。

基于插值的超分辨率方法

最邻近插值法,双线性插值法和双三次插值法

优点:实现简单—利用周围像素点的像素值估计丢失的像素值

缺点:线性模型限制了恢复高频能力的细节

这里介绍一下双线性插值法

双线性插值法

已知Q11(x1,y1)、Q12(x1,y2)、Q21(x2,y1)、Q22(x2,y2),求其中点P(x,y)的值。

双线性插值是分别在两个方向计算了共3次单线性插值,如图所示,先在x方向求2次单线性插值,获得R1(x, y1)、R2(x, y2)两个临时点,再在y方向计算1次单线性插值得出P(x, y)(实际上调换2次轴的方向先y后x也是一样的结果)。

1.x方向单线性插值 直接带入前一步单线性插值最后的公式

f ( R 1 ) = x 2 − x x 2 − x 1 f ( Q 11 ) + x − x 1 x 2 − x 1 f ( Q 21 ) f(R_1)=\frac{x_2-x}{x_2-x_1}f(Q_{11})+\frac{x-x_1}{x_2-x_1}f(Q_{21}) f(R1)=x2−x1x2−xf(Q11)+x2−x1x−x1f(Q21)

f ( R 2 ) = x 2 − x x 2 − x 1 f ( Q 12 ) + x − x 1 x 2 − x 1 f ( Q 22 ) f(R_2)=\frac{x_2-x}{x_2-x_1}f(Q_{12})+\frac{x-x_1}{x_2-x_1}f(Q_{22}) f(R2)=x2−x1x2−xf(Q12)+x2−x1x−x1f(Q22)

2.y方向单线性插值

f ( R 2 ) = y 2 − y y 2 − y 1 f ( R 1 ) + y − y 1 y 2 − y 1 f ( R 2 ) f(R_2)=\frac{y_2-y}{y_2-y_1}f(R_1)+\frac{y-y_1}{y_2-y_1}f(R_2) f(R2)=y2−y1y2−yf(R1)+y2−y1y−y1f(R2)

Harris Goodman频谱外推法

频率域方法就是指通过在频率域消除频谱混叠而改善图像的空间分辨率的方法。由于图像的细节靠高频信息来表现,而通过消除频谱混叠,就可以获得更多的被淹没掉的高频。

贝叶斯方法

使用贝叶斯方法来估计帧间运动,进而重建高分辨率视频。

基于深度学习的视频超分辨率技术

基于深度学习的视频超分辨率技术通常使用已经训练好的神经网络模型,通过学习从低分辨率视频到高分辨率视频的映射关系来实现超分辨率重建。

定义 I l I_l Il为低分辨率视频序列, I I I为原始高分辨率视频序列,低分辨率视频的获取过程可表示为

I l = φ ( I ; α ) ( 1 ) I_l=\varphi (I;\alpha)\quad(1) Il=φ(I;α)(1)

式中, φ \varphi φ 函数表示原始高分辨率视频退化成低分辨率视频的退化映射函数。 α \alpha α表示在退化过程中影响该过程的各种参数,如噪声因子、下采样因子和运动模糊因子等。

利用视频超分辨率网络重建高分辨率帧的过程可视为式(1)的逆过程,表示为

I − = φ − 1 ( I l ; θ ) ( 2 ) \overset{-}I=\varphi^{-1} (I_l;\theta)\quad(2) I−=φ−1(Il;θ)(2)

式中, I − \overset {-} I I−表示估计的高分辨率视频, θ \theta θ 为该过程中的各项训练参数。在视频超分辨率网络的训练过程中,需要对退化过程进行重新建模,一般采用增加模糊核的双线性插值下采样,具体为

I l = ( I ⊗ k ) ↓ s + n ( 3 ) I_l=(I⊗k)\downarrow_s+n\quad(3) Il=(I⊗k)↓s+n(3)

式中,k表示模糊核,n为高斯白噪声,⊗为原始高分辨率视频图像与模糊核的卷积运算, ↓ s \downarrow_s ↓s表示比例为s 的下采样。视频超分辨率的重建目标为

θ ^ = a r g m i n M ( I − , I ) + λ Φ ( θ ) ( 4 ) \hat\theta=arg \space min\space M(\overset{-}I,I)+\lambda\Phi(\theta)\quad(4) θ^=arg min M(I−,I)+λΦ(θ)(4)

式中, M ( I − , I ) M(\overset{-}I,I) M(I−,I)为高分辨率视频图像的估计值与原始高分辨率视频帧之间的损失。λ为权衡参数, Φ \Phi Φ函数为正则化项, θ ^ \hat\theta θ^ 为优化的网络参数。

评价指标

峰值信噪比(PSNR)

PSNR 是信号的最大可能功率与影响信号质量的噪声功率之间的比率。PSNR值越大,表示图像的质量越好,一般来说:

(1)高于40dB:说明图像质量极好(即非常接近原始图像)

(2)30—40dB:通常表示图像质量是好的(即失真可以察觉但可以接受)

(3)20—30dB:说明图像质量差

(4)低于20dB:图像质量不可接受

给定一个大小为m×n的干净图像I和噪声图像K,均方误差(MSE)定义为

M S E = 1 m n ∑ i = 0 m − 1 ∑ j = 0 n − 1 [ I ( i , j ) − K ( i , j ) ] 2 MSE=\frac{1}{mn}\sum_{i=0}^{m-1}\sum_{j=0}^{n-1}[I(i,j)-K(i,j)]^2 MSE=mn1i=0∑m−1j=0∑n−1[I(i,j)−K(i,j)]2

PSNR(dB)定义为

P S N R = 10 ⋅ l o g 10 ( M A X I 2 M S E ) PSNR=10\cdot log_{10}(\frac{MAX_I^2}{MSE}) PSNR=10⋅log10(MSEMAXI2)

其中 M A X I 2 MAX_I^2 MAXI2为图片可能的最大像素值。如果每个像素都由 8 位二进制来表示,那么就为 255。通常,如果像素值由B位二进制来表示,那么 M A X I 2 = 2 B − 1 MAX_I^2=2^B-1 MAXI2=2B−1。

上面是针对灰度图像的计算方法,如果是彩色图像,通常有三种方法来计算。

- 分别计算 RGB 三个通道的 PSNR,然后取平均值。

- 计算 RGB 三通道的 MSE ,然后再除以 3 。

- 将图片转化为 YCbCr 格式,然后只计算 Y 分量也就是亮度分量的 PSNR。

结构相似性(SSIM)

SSIM 是 一 种 衡 量 两 幅 图 像 相 似 度 的 指 标 。SSIM 的计算基于两图的亮度(均值)、对比度(标准差)和结构相似度(协方差)等 3个角度。SSIM 值越高,视频帧的重建质量越趋近于真实高分辨率帧,在 一定程度上证明视频超分辨率算法的设计越高效。

计算这里不再展开叙述。

视频超分辨率数据集

视频超分辨率算法的分类

视频与图像的区别在于**视频帧间存在运动信息,**如果将视频转换为多个单帧的图像进行超分辨率重建,处理后的视频存在波浪效果以及大量伪影。 因此,帧间时空信息的利用对生成的视频质量有决定性影响。

基于深度学习的视频超分辨率方法存在两大关键技术挑战,即相邻帧的配准和多帧信息的融合重建。图像配准模块的选用与否是区分现有方法的主要因素,从基于图像配准的方法和非图像配准方法两个方面,介绍一下近年来视频超分辨率方法。

图像配准是使用某种方法,基于某种评估标准,将一副或多副图片(局部)最优映射到目标图片上的方法。

基于图像配准的视频超分辨率算法

由于不同视频帧之间存在运动差异,直接将多帧图像融合重建会导致生成的视频出现边缘模糊、 细节混淆等影响视觉效果的现象。因此,研究人员往往先对相邻帧与目标帧进行配准。 传统的配准方法包括过平移、翻转和旋转等预处理操作,而这些方式包含复杂的计算过程且达不到好的配准效果。现在基于深度学习的视频帧配准方法可分为基于光流的配准方法、基于卷积核估计的配准方法和基于可变形卷积的配准方法3种。

基于光流的配准方法

为了充分利用帧间时空信息,研究人员提出了 各种方法进行运动估计与运动补偿,将相邻帧与目标帧对齐,然后在此基础上融合特征,重建高分辨率 视频。在视频超分辨率领域,光流法是最常用的运动估计与运动补偿方法。

介绍一下光流:

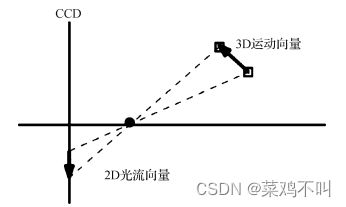

光流是空间运动物体在观测成 像面上像素运动的瞬时速度。如下图所示,利用二 维图像上特定坐标点灰度瞬时变化率来定义物体的 3D运动效果,灰度瞬时变化率也称为光流矢量。

到目前为此,光流配准的视频超分辨率方法数量占比最多,可以将其细粒度地划分为基于常规卷积的方法、基于循环神经网络的方法、基于 GAN 的方法和基于 Transformer 的方 法,并进行详细阐述

光流估计是视频超分辨率研究中最常用的技术之一,光流网络经过多年研究,架构成熟且效果稳健。但光流法对于复杂的运动难以建模,使用错误 的运动估计方法会在基于常规光流对齐后的视频帧中引入伪影,这些伪影会传播到后续的高分辨率视频重建步骤,并影响视频质量,难以保证生成的高分辨率视频的时间连续性。基于光流的视频超分辨率技术性能取决于估计的光流的质量。当相邻帧之间存在遮挡、模糊等问题时,计算的光流则会不准确,错误累计进而导致视频超分辨率网络性能低下。如何更为精准地估计光流以及设计效果更加出色的运动补偿方法,是未来的重要研究方向。

基于卷积核估计的图像配准方法

利用动态卷积核进行运动估计与运动补偿。

由于卷积核大小限制运动估计的范围,这种方法的视频超分辨率重建效果相对较差。 因此,单独使用卷积核估计来实现相邻帧对齐的方 法相对较少。联合多种运动估计方法又会不可避免地带来昂贵的计算开销。

基于可变形卷积的配准方法

与以前基于光流法的视频超分辨率不同,可变 形卷积可以在特征级别自适应地对齐参考帧和相邻帧,而无需显式地进行运动估计和图像配准。对齐的低分辨率视频图像将具有较少的伪影,进而改善 了重构的高分辨率视频质量。然而,可变形卷积本 质是一种抽样改进,学习到的额外信息较少,且需要 更多地关注偏移量的学习与优化。同时,如很多基 于图像配准来进行视频超分辨率的技术一样,需要 考虑如何利用对齐帧,以构建可以生成高质量、连续 以及细节真实视频的超分重建网络。

非图像配准的视频超分辨率方法

目前的图像配准模块无法适应实时性需求。相对地,许多研究不使用额外的图像配准模块,而是直接利用神经网络学习帧间的运动信息,融合重建时空信息的非图像配准的视频超分辨率方法。这些方法利用不同的网络结构隐式地利用视频帧间的关联性,从而更好地融合和重建出更清晰的纹理和丰富的细节

基于3D卷积的非图像配准方法

3D卷积是一种提取时空特征的有效手段,在视频分类和动作识别等领域有巨大的优势。在视频超分辨率问题上,3D-CNN 采用立体式的卷积核对整个视频序列进行卷积运算,可在时间维度上共享权重。

将3D卷积利用于视频超分辨率技术中,可以充分融合相邻帧与目标帧的时空信息,相对地,也会存在参数量大、运算速率慢的问题。如何提高3D卷积的计算效率并更好地提取与利用帧间运动信息是主 要研究方向之一

基于GAN的非图像配准方法

基于GAN进行视频超分辨率方法的研究非常少。因为鉴别器需要判断视频帧之间的连续性,因 而难度较大。且在设计视频超分辨率网络时,生成 器的结构过于简单,仅使用 ResNet和 DenseNet难以 达到其他视频超分辨率方法的性能

基于循环神经网络的非图像配准方法

循环神经网络可以充分利用帧间互补信息,对 视频的时序信息进行建模,以实现有效的视频超分 辨率。目前基于循环神经网络的模型参数量都较为 适中,计算负担普遍小于基于运动估计、运动补偿的 方法和基于3D卷积的方法。OVSR证明了循环神经 网络在视频超分辨率领域的潜能,因此可以更多地 尝试调整隐藏层网络,引入更合适的注意力融合机 制,实现更出色的视频超分辨率效果。

参考

深度学习视频超分辨率技术综述_江俊君.pdf

一篇文章为你讲透双线性插值 - 知乎 (zhihu.com)

图像质量评价指标之 PSNR 和 SSIM - 知乎 (zhihu.com)