基于学习的机械臂抓取研究综述

1.基于学习的机械臂抓取研究综述

Kleeberger, K., Bormann, R., Kraus, W. et al. A Survey on Learning-Based Robotic Grasping. Curr Robot Rep 1, 239–249 (2020). https://doi.org/10.1007/s43154-020-00021-6

下文删掉了引用链接,在文末展示了论文作者认为机械臂抓取领域比较重点的文章。

1.1 概述

由于训练基于 AI 的方法需要大量数据,因此模拟是机器人学习的一个有吸引力的选择。

人类看到新奇的物体,几乎可以立即决定如何挑选它们。机器人的能力远远落后。机器人抓取和操作是一项关键挑战 。几十年来,人们一直在努力创造可以与人类一样灵巧的认知机器人。尽管对研究和工业感兴趣,但它仍然是一个未解决的问题。

更短的产品生命周期和不断增长的定制需求需要更灵活和多变的生产系统,从而需要机器人系统的自动配置(即插即用)。开发可以在动态和非结构化环境中运行的机器人(即,垃圾箱拣选、家庭或日常环境、专业服务)具有极大的兴趣。机器人抓取方法利用基于学习的方法自动配置给定任务,无需任何人工干预,从而显着减少编程工作。由于对新物体的泛化能力,机器学习尤其是一种很有前途的机器人抓取方法。

1.2 分类

1.2.1 分析方法与数据驱动方法

基于视觉的机器人抓取方法可以按照多个不同的标准进行分类。一般来说,方法可以分为分析方法或数据驱动方法。分析(或有时称为几何)方法通常分析目标对象的形状以识别合适的抓握姿势。数据驱动(或有时称为经验)方法基于机器学习,近年来已广受欢迎。由于增加了数据可用性、更好的计算资源和算法改进,它们取得了重大进展。

1.2.2 Model Based与Model Free

此外,方法可以分类为基于模型或无模型,这取决于是否使用关于对象的特定知识(例如,CAD 模型或先前扫描的模型)来解决所考虑的任务。他们可以进一步区分他们是否专注于抓取和操纵刚性、铰接或灵活/可变形的物体,以及该方法是否能够处理已知、熟悉或未知的物体。已知刚性物体的基于模型的方法通常包括姿势估计步骤,并允许精确放置物体。无模型方法直接提出抓取候选者,通常旨在泛化到新对象。

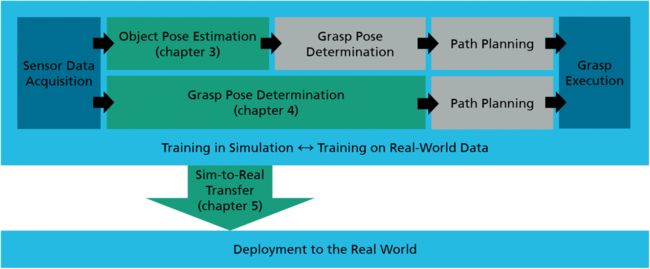

上图为机器人抓取的典型流程:基于模型的方法(顶行)通常估计对象姿势,确定对象上合适的抓取姿势,规划路径,最后执行抓取。无模型方法(底行)根据传感器给出的观察结果直接确定抓取姿势。在接受模拟训练时,需要模拟到真实的技术来实现稳健的迁移。

1.2.3 监督学习与强化学习

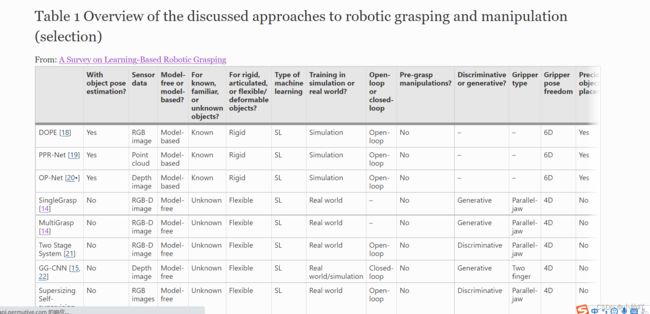

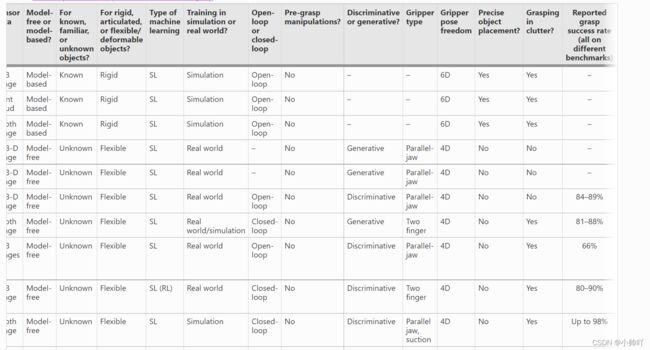

另一个标准是机器学习的类型,即系统是使用监督学习 (SL) 还是强化学习 (RL) 进行训练的。标签可以由人提供或以自我监督的方式(即标签是自动生成的)获得。方法通常要么对抓取候选者进行采样并使用神经网络(判别方法) 对它们进行排名,姿势(生成方法)。此外,方法在它们是在模拟环境中、在现实世界中还是在两者中进行训练以及利用各种传感器数据(RGB 图像、深度图像、RGB-D 图像、点云、潜在的多个传感器等)方面有所不同。此外,方法以开环(即,没有任何反馈)或闭环方式。使用基于视觉特征的连续反馈通常被称为视觉伺服。除了机器人硬件外,抓手类型(双指抓手、吸力抓手……)和抓手自由度(4D、6D……)也可以区分不同的方法。此外,一些方法只专注于抓取单个分离的物体,而另一些则专注于在密集的杂波中抓取。此外,一些方法能够执行预抓取操作,以便以更好的配置移动对象以进行抓取。表提供了所讨论方法的概述,并显示了从文献中可用的各种方法中进行的小型示例性选择。除了上述标准外,还指出了报告的抓取成功率,尽管是在不同的基准上确定的。

机械臂抓取的准确率概况

https://link.springer.com/article/10.1007/s43154-020-00021-6/tables/1

1.3 有模型的机械臂抓取

这里不介绍,可以参看论文

1.4 无模型的机械臂抓取

无模型方法很有吸引力,因为它们能够泛化到看不见的物体,并在机器人抓取研究中占据主导地位。它们不使用关于对象的先验知识,因此在没有姿态估计步骤的情况下工作,这与“机器人抓取的对象姿态估计”部分中讨论的方法形成对比。方法通常在对新对象的泛化能力方面显示出有希望的结果,并且模型通常以端到端的方式进行训练。主要不考虑拾取后对象的放置,并且不知道被拾取的对象类型。

1.4.1 监督学习方法

监督学习涉及基于标记的训练数据学习(非线性)映射。在本章中,我们根据抓取配置是输入还是输出,将这些方法分类为判别式或生成式。

判别方法

判别方法样本抓取候选者(例如,使用 CEM])并使用神经网络对它们进行排名。对于抓取执行,机器人选择得分最高的抓取。这些方法通常具有很高的运行时间,因为它们需要神经网络的多次前向传递才能获得高质量的抓取。尽管如此,这些方法的优点是可以评估任意多个抓取姿势,并且这些方法不受抓取图元/输出空间离散化的限制。此外,可以应用/采用基于梯度的细化过程来提高抓取成功率。

谢尔盖莱文等人提出了一种基于学习的手眼协调方法,用于基于RGB图像的机器人抓取。在他们的工作中,他们使用多达 14 个机器人在 2 个月内为 800,000 次抓取收集了成功标签。训练有素的卷积神经网络可以基于箱的 RGB 图像预测给定候选者的抓取成功,并用于伺服抓手以实现成功抓取。虽然这种方法展示了基于学习的机器人抓取方法的潜力,但硬件设置的变化需要收集新数据以重新训练系统。

Dex-Net 使用物理模拟来抓取平面上随机姿势的物体。抓取的结果与抓取所在的深度图像的对齐裁剪一起记录,从而形成数据集的一个样本。他们的 Grasp Quality 卷积神经网络 (GQ-CNN) 是通过使用该数据集进行训练的。训练后的模型可以预测给定抓取候选对象和深度图像的抓取成功,并推广到训练期间看不到的不同刚性、关节或柔性对象。Dex-Net 框架已扩展到吸盘和双臂机器人其中政策推断是否使用平行爪或吸盘来清空杂乱的垃圾箱。此外,已经提出了一种生成抓取的全卷积网络架构,以避免对抓取候选者进行昂贵的采样和排名。

生成方法

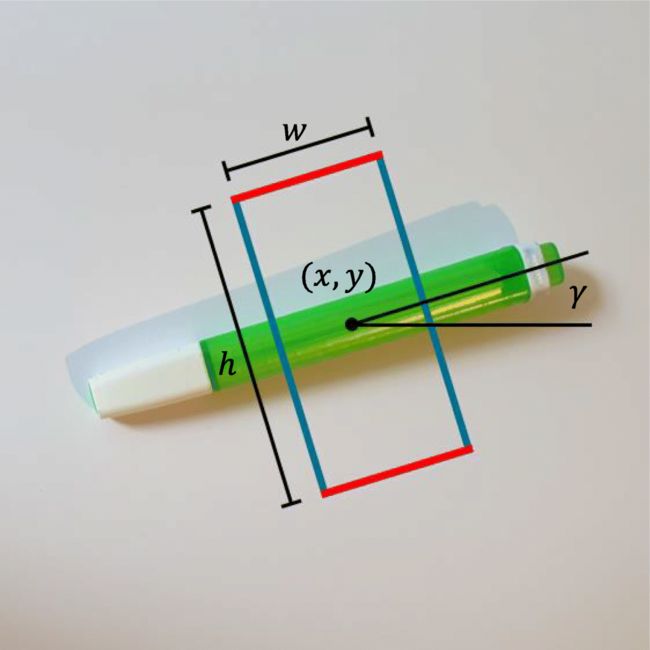

生成方法输出一个抓取配置。一种称为机器人抓取检测的方法是检测图像平面中的定向矩形 ,它们代表了平行下颚夹持器的有希望的抓取候选者。该参数化包括夹具的位置、方向和开口宽度,如图所示。机器人抓取检测的问题类似于计算机视觉中的对象检测 ,唯一的区别是增加了一个用于抓取器方向的术语。

对于将单个对象放置在平面上的场景,Redmon 等人提出了一个称为 SingleGrasp 的系统,该系统可以预测一个定向矩形,并使用神经网络同时对给定 RGB-D 图像的对象进行分类。由于可以通过多种不同的方式抓取对象,因此他们还引入了 MultiGrasp,它可以预测每个图像的多个抓取姿势。这种方法导致了用于对象检测的 You Only Look Once (YOLO) 方法。伦茨等人提出了一种基于学习的两阶段系统,该系统对候选者进行采样并使用第二个神经网络对其进行排名。在他们的工作中,他们证明了他们的方法可以用于现实世界的机器人抓取任务。通过利用更复杂的网络架构 可以获得更高的性能。

用于机器人抓取检测的公共数据集是康奈尔抓取数据集,它包含来自 280 个物体的 1035 张图像,并带有人工标注的抓取。由于样本数量少,数据集已被大量扩充以获得良好的性能。Jacquard 数据集包含超过 11,000 个物体的 50,000 多个合成样本,这些样本是从模拟中的抓取试验中获得的,并且由于多样性增加而能够更好地泛化。

利用这些公共数据集,GG-CNN 使用小型全卷积架构输出抓取配置以及图像中每个像素的质量估计。由于其计算需求低,该方法可用于动态/非静态环境中的闭环抓取。此外,尽管该模型仅在单个孤立图像上进行训练,但这种方法可以在混乱中掌握,这是由于卷积是局部操作。

TossingBot学习将任意物体扔到给定的目标位置,从而增加机械臂的物理可达性。作者提出了一种端到端的公式,通过反复试验,共同学习推断控制参数,以便从垃圾箱中的物体图像中抓取和投掷。结果,系统通过自我监督学会选择导致可预测投掷的抓握。投掷问题被简化为仅预测释放速度。使用基于物理的控制器估计释放速度,并根据神经网络的残差估计进行调整。

生成方法很快,因为它们只需要一次前向传递。它们通常同时提供多个抓取候选者,并且由机器人执行最高质量的抓取。

1.4.2 深度强化学习方法

深度强化学习已经成为一种很有前途的强大技术,可以通过反复试验自动获取控制策略。通过处理原始的感官输入,例如图像,可以执行复杂的行为。

诸如推动或移动之类的预抓取操作对于重新排列杂乱的对象并确保可以完全或更牢固地抓取对象也非常重要。使用强化学习,经过训练的策略还展示了对新对象的泛化。

2018年的这篇论文Deep Reinforcement Learning for Vision-Based Robotic Grasping:A Simulated Comparative Evaluation of Off-Policy Methods中提供了基于深度强化学习的多种抓取任务方法的比较。2018年CoRL机械臂抓取里程碑的一篇论文QT-Opt 展示了一组丰富的操作策略,并对干扰和扰动做出动态响应。机器人观察到成功举起物体的奖励为 1,抓取失败则为 0。他们基于闭环视觉的控制框架在与 [ 24 , 25 , 64 ] 中类似的设置中运行, 展示了96%的抓取成功率在没看过的物体上通过优化long-horizon grasp success用共计800个robot hours收集了四个月用七个机器人。

“在野外抓取” 允许基于人类演示对新物体进行闭环 6D 抓取,并且可以在具有移动物体的动态场景中操作,达到一定的速度限制。

1.5 仿真到现实的迁移

尽管有性能和鲁棒性方面的所有优势,但深度学习的缺点是需要大量数据进行训练。这在机器人技术中尤其成问题,在现实世界系统上生成训练数据可能既昂贵又耗时。例如,平托等人。[ 23 ] Levine 等人通过在 700 多个小时内收集 50,000 次试验来训练机器人抓取新物体。[ 24 , 25 ] 需要在 2 个月内对 14 台机器人进行 800,000 次并行抓取,以获得强大的抓取性能,以及 QT-Opt [ 29] 在几周内收集了 7 个机器人的超过 560,000 次抓取。此外,这些系统对于硬件设置的更改(例如更改夹具、工作台高度或移动相机)并非一成不变。为了避免需要设置“手臂农场”来学习强大的机器人抓取和操作策略,使用模拟是一种有吸引力的选择。

常用的物理模拟有 V-REP/CoppeliaSim [ 65 ]、PyRep [ 66 ]、MoJuCo [ 67 ]、Blender [ 68 ] 和 Gazebo [ 69 ]],仅举几例。为了克服上述这些限制,可以使用模拟,因为它们提供了丰富的数据源和完美的注释。此外,模拟速度很快,并且可以在多台机器上并行进行,以实现快速学习或数据生成。物理模拟允许在不磨损组件和不中断现场生产的情况下训练机器人。除了这些优势之外,模拟还需要对所需应用程序进行显式编程,可能需要许可成本,并且不能完美地捕捉现实世界的属性。

一般来说,由于“现实差距”,在模拟中训练的模型往往不会直接很好地转移到现实世界。本节讨论了不同的方法来弥补模拟与现实之间的差距。通过提供更好的模拟、域随机化或域自适应可以将模型转移到现实世界。

1.6 总结

基于学习的机器人抓取方法能够拾取不同的对象集,并且即使在杂乱的场景和非静态环境中也能够展示高抓取成功率。由于基于模型的解决方案的自动配置和对无模型方法的新对象的泛化能力,机器学习和模拟允许快速和轻松的部署。

尽管取得了令人印象深刻的结果,但机器人抓取和操作仍未解决。所有讨论的无模型方法都执行自上而下的抓取,并且在夹持器方向上的灵活性有限。只有有限数量的作品专注于基于学习的机器人抓取方法,用于 6D 中的单个对象或杂乱的。虽然在研究中得到越来越多的关注,但 6D 中的无模型抓取对于从杂乱的垃圾箱 或更稳健的抓取中拾取物体尤其相关。

通常,机器人的任务是“抓住任何东西”。一些作品侧重于定向抓取,以从杂乱的场景中挑选特定对象。无模型方法不允许精确放置对象。许多实际应用需要对组件进行至少半精确或温和的放置,而不是简单地放下拾取的对象,而这已经很少解决。虽然存在避免物体纠缠的解决方案,但尚未提出通用解决方案来解开复杂的物体几何形状。

本论文部分参考文献:

很重要:

1.Kalashnikov D, Irpan A, Pastor P, Ibarz J, Herzog A, Jang E, et al. QT-Opt: scalable deep reinforcement learning for vision-based robotic manipulation. In: Conference on Robot Learning (CoRL); October 29–31, 2018; Zürich, Switzerland: PMLR; 2018. Setting a milestone in robotic grasping and manipulation.

2.Song S, Zeng A, Lee J, Funkhouser T. Grasping in the Wild:learning 6DoF closed-loop grasping from low-cost demonstrations. In: IEEE, editor. IEEE International Conference on Robotics and Automation (ICRA); May 31 – June 4, 2020; Palais des Congrès de Paris, France; 2020. Addresses closed-loop model-free grasping in 6D and in cluttered scenes.

3.Tobin J, Fong R, Ray A, Schneider J, Zaremba W, Abbeel P. Domain randomization for transferring deep neural networks from simulation to the real world. In: IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS); September 24–28, 2017; Vancouver, BC, Canada: IEEE; 2017. Highly influential work regarding sim-to-real transfer.

一般重要:

1.Kleeberger K, Huber MF. Single shot 6D object pose estimation. In: IEEE, editor. IEEE International Conference on Robotics and Automation (ICRA); May 31 – June 4, 2020; Palais des Congrès de Paris, France; 2020. Provides state-of-the-art results for 6D object pose estimation in highly cluttered scenes.

2.Levine S, Pastor P, Krizhevsky A, Ibarz J, Quillen D. Learning hand-eye coordination for robotic grasping with deep learning and large-scale data collection. In: The International Journal of Robotics Research (IJRR); 2018. Highly influential work demonstrating the potential of deep learning for robotic grasping.

3.Mousavian A, Eppner C, Fox D. 6-DOF GraspNet: variational grasp generation for object manipulation. In: IEEE, editor. IEEE International Conference on Computer Vision (ICCV); October 27 – November 2, 2019; Seoul, Korea; 2019. Addresses model-free grasping in 6D.

4.Bousmalis K, Irpan A, Wohlhart P, Bai Y, Kelcey M, Kalakrishnan M, et al. Using simulation and domain adaptation to improve efficiency of deep robotic grasping. In: IEEE, editor. IEEE International Conference on Robotics and Automation (ICRA); May 21–25, 2018; Brisbane, QLD, Australia. Piscataway, NJ: IEEE; 2018. Highly influential work regarding sim-to-real transfer for robotic grasping.

本文总结的有很多不足,还是希望大家看论文原文

Kleeberger, K., Bormann, R., Kraus, W. et al. A Survey on Learning-Based Robotic Grasping. Curr Robot Rep 1, 239–249 (2020). https://doi.org/10.1007/s43154-020-00021-6