论文笔记(二):DenseFusion: 6D Object Pose Estimation by Iterative Dense Fusion

DenseFusion: 6D Object Pose Estimation by Iterative Dense Fusion

- 文章概括

- 1. 摘要

- 2. 介绍

- 3. 相关工作

-

- 3.1 来自RGB图像的姿势:

- 3.2 来自深度/点云的姿势:

- 3.3来自RGB-D数据的姿势:

- 4. 模型

-

- 4.1 结构概括

- 4.2 语义分割

- 4.3 Dense 特征提取

-

- 4.3.1 密集的3D点云特征嵌入

- 4.3.2 密集的彩色图象特征嵌入

- 4.4 Pixel-wise密集融合

-

- 4.4.1 Pixel-wise密集融合

- 4.4.2 Per-pixel自我监督置信度

- 4.5 6D物体姿势评估

- 4.6 迭代细化

- 5. 结论

文章概括

作者:Chen Wang,Danfei Xu,Yuke Zhu,Roberto Mart´ın-Mart´ın,Cewu Lu,Li Fei-Fei,Silvio Savarese

来源:CVPR 2019

原文:https://openaccess.thecvf.com/content_CVPR_2019/papers/Wang_DenseFusion_6D_Object_Pose_Estimation_by_Iterative_Dense_Fusion_CVPR_2019_paper.pdf

代码、数据和视频:https://sites.google.com/view/densefusion/

系列文章目录:

上一篇:

论文笔记(一):se(3)-TrackNet: Data-driven 6D Pose Tracking by … in Synthetic Domains

下一篇:

1. 摘要

本文中,作者们提出了DenseFusion,是一个从RGB-D图像估计一组已知物体的6D姿势的通用框架。DenseFusion是一个异构架构,它分别处理两个数据源,并使用新颖的密集融合网络提取像素级密集特征嵌入,从中估算出姿势。除此之外,作者们还集成了一个端到端迭代的姿势细化过程,进一步改善姿势估计,同时实现近乎实时的推理。

2. 介绍

本文中,作者们提出了一种端到端的深度学习方法,用于从RGB-D的输入中估计已知对象的6-DoF姿势。方法的核心是在每个像素层面嵌入和融合RGB值和点云,与之前使用图像裁剪来计算全局特征或二维边界框的工作不同。这种每像素融合方案使模型能够明确地推理局部的外观和几何信息,这对于处理重度遮挡是必不可少的。此外,他们还提出了一种迭代方法,在端到端学习框架内进行姿势改进。这种方法在保持推理速度实时性的同时,大大提升了模型的性能。

本文的两个贡献:

- 提出了一种从RGB-D的输入中结合颜色和深度信息的原则性方法。作者们用为任务学习的嵌入空间中的2D信息来增强每个3D点的信息,并使用这个新的色深空间来估计6D姿势。

- 其次,作者们在神经网络架构中集成了一个迭代细化程序,消除了以往方法对ICP后处理步骤的依赖性。

3. 相关工作

3.1 来自RGB图像的姿势:

经典方法依赖于检测和匹配已知对象模型的关键点。较新的方法通过学习预测2D关键点,并通过PnP来解决这个挑战。但这些方法在低纹理或低分辨率输入的情况下,变得不可靠。其他方法提出使用基于CNN的架构从图像中直接估计物体姿态,许多这样的方法集中在方向估计上。本文的方法是利用图像和3D数据,在端到端架构中估计物体的3D姿势。(找到一篇不错的PnP学习笔记,大家感兴趣的可以看一下PNP(pespective-n-point)算法学习笔记)

3.2 来自深度/点云的姿势:

最近的研究提出在离散的3D体素空间中直接处理3D物体检测问题。但这些方法耗费的时间非常长。最近的3D深度学习架构已经实现了对3D点云数据直接执行6D姿势估计的方法。但是,像YCBVideo数据集这样的通用物体姿势估计任务需要对几何和外观信息进行推理。本文通过提出一种新型的2D-3D传感器融合架构来解决这样的问题。

3.3来自RGB-D数据的姿势:

经典方法从输入的RGB-D数据中提取3D特征,并进行对应分组和假设验证。但是,这些特征要么是硬编码,要么是通过优化重建等代用目标来学习,而不是6D姿势估计的真正目标。新的方法,比如PoseCNN直接从图像数据中估计6D姿势。然而,这些方法依靠昂贵的后处理步骤来充分利用3D输入。相比之下,作者们的方法在保留输入空间几何结构的前提下,将3D数据融合到2D外观特征中,并且表明它在没有后处理步骤的情况下,在YCB-Video数据集上表现出色。

4. 模型

目标:估计一组已知物体在杂乱场景的RGB-D图像中的6D姿态。

在不失通用性的前提下,我们将6D姿态表示为均质变换矩阵, p ∈ S E ( 3 ) p∈SE(3) p∈SE(3)。 换句话说,6D姿态由旋转 R ∈ S O ( 3 ) R∈SO(3) R∈SO(3)和平移 t ∈ R 3 , p = [ R ∣ t ] t∈R3,p=[R|t] t∈R3,p=[R∣t]组成。由于要从相机图像中估算出物体的6D姿势,所以姿势的定义是相对于相机坐标框而言的。从异构数据源中提取特征并适当融合是该领域的关键技术挑战。

作者通过一个异构架构来解决这一问题,该结构保留每个数据源的原生结构,并通过利用数据源之间的内在映射来执行颜色-深度融合的密集像素智能融合网络。最后,通过可分化迭代细化模块进一步完善姿势估计。与post-hoc refinement steps相比,作者们的模块可以和主架构联合训练并且耗费的时间变少。

4.1 结构概括

有两个重要的阶段:

- 第一阶段以彩色图像为输入,对每个已知的物体类别进行语义分割。然后,对于每个分割后的对象,我们将掩蔽的深度像素(转换为3D点云)以及由掩蔽的边界框裁剪的图像补丁送入第二阶段。

- 第二阶段对分割结果进行处理,并估计物体的6D姿态。(分为四个部分)

(1)一个完全卷积网络,处理颜色信息,并将图像裁剪中的每个像素映射到颜色特征嵌入。(图2)

(2)基于PointNet的网络,将遮蔽的3D点云中的每个点处理成几何特征嵌入。(图2)

(3)像素级融合网络,将两种嵌入结合起来,并基于无监督的置信度打分,输出物体的6D姿态估计。(图2)

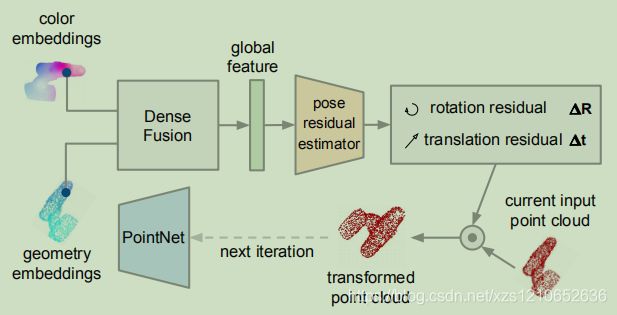

(4)以课程学习的方式训练网络并迭代完善估计结果的迭代自研方法。(图3)

图2:

图3:

4.2 语义分割

作者的的语义分割网络是一个encoderdecoder架构,它将图像作为输入,并生成一个N+1通道的语义分割图。每个通道都是一个二进制掩码,其中活跃的像素描述了N个可能的已知类中的每个类的对象。

4.3 Dense 特征提取

挑战:正确提取颜色通道和深度通道的信息,并对其进行协同融合。

颜色和深度在RGB-D中有着相似的格式,但是他们的信息是在不同的空间中。所以要从数据源内在结构的嵌入空间中生成颜色和几何特征。

4.3.1 密集的3D点云特征嵌入

本文首先利用已知的相机内在结构将分割后的深度像素转换为3D点云,然后使用类似PointNet的架构来提取几何特征。

作者提出了一个几何嵌入网络,通过将每个P分割点映射到一个 d g e o d_{geo} dgeo-dimensional特征空间来生成密集的每点特征。我们实现了PointNet架构的一个变体,使用平均池化而不是常用的max-pooling作为对称还原函数。

4.3.2 密集的彩色图象特征嵌入

颜色嵌入网络的目标是提取per-pixel特征,这样我们就可以在三维点特征和图像特征之间形成密集的对应关系。图像嵌入网络是一种基于CNN的编码器-解码器架构,它将大小为 H × W × 3 H×W×3 H×W×3的图像映射到一个 H × W × d r g b H×W×d_{rgb} H×W×drgb的嵌入空间中。嵌入的每个像素都是一个 d r g b d_{rgb} drgb维向量,代表输入图像在相应位置的外观信息。

4.4 Pixel-wise密集融合

现在要进行信息的融合。一个天真的方法是从分割区域的密集颜色和深度特征中生成一个全局特征。然而,由于严重的遮挡和分割误差,来自上一步的特征集可能包含其他物体或背景部分上的点/像素的特征。因此,盲目地全局融合颜色和几何特征会降低估计的性能。在下文中,我们描述了一种新型的Pixel-wise密集融合网络,它能有效地结合所提取的特征,特别是在重度遮挡和不完美分割的情况下进行姿态估计。

4.4.1 Pixel-wise密集融合

本文的关键思想是进行局部的 per-pixel融合而不是全局融合,这样就可以根据每个融合后的特征进行预测。通过这种方式,可以潜在地根据对象的可见部分选择预测,并最大限度地减少遮挡和分割噪声的影响。具体来说,致密融合过程首先利用已知的相机固有参数,基于投影到图像平面上,将每个点的几何特征关联到其对应的图像特征像素上。然后将得到的特征对进行串联,并将其送入另一个网络,利用对称还原函数生成一个固定大小的全局特征向量。虽然本文避免使用单一的全局特征进行估计,但在这里,用全局密集融合的特征来丰富每个密集像素特征,以提供全局背景。本文将得到的每一个像素特征输入到一个最终的网络中,预测物体的6D姿势。换句话说,训练这个网络,从每个密集融合的特征中预测一个姿势。结果是一组P个预测姿势,每个特征一个。

4.4.2 Per-pixel自我监督置信度

我们希望训练我们的姿势估计网络,以根据具体的上下文决定哪种姿势估计可能是最佳假设。为此,我们对网络进行修改,除了姿势估计预测之外,还要为每个预测输出一个置信度分数ci。我们必须将这第二个学习目标反映在整体学习目标中,我们将在下一节的最后看到。

4.5 6D物体姿势评估

在定义了整体网络结构后,我们现在来仔细研究一下学习目标。我们将姿态估计损失定义为物体模型上采样的点在地面真实姿态下与同一模型上经预测姿态变换后的对应点之间的距离。具体来说,每一个密集像素的预测损失要最小化,定义为:

L i p = 1 M ∑ j ∣ ∣ ( R x j + t ) − ( R i ^ x j + t i ^ ) ∣ ∣ L_i^p=\frac{1}{M}\sum_{j} ||(Rx_j+t)-(\hat{R_i}{x_j}+\hat{t_i})|| Lip=M1j∑∣∣(Rxj+t)−(Ri^xj+ti^)∣∣

其中 x j x_j xj表示从对象的三维模型中随机选取的 M M M个三维点中的第 j j j个点。 p = [ R ∣ t ] p = [R|t] p=[R∣t]为地面真实姿势, p i ^ = [ R i ^ ∣ t i ^ ] \hat{p_i} = [ \hat{R_i}|\hat{t_i}] pi^=[Ri^∣ti^]为第 i i i个密集像素的融合嵌入生成的预测姿势。

上述损失函数只对不对称物体有很好的定义,其中物体形状和/或纹理决定了唯一的规范框架。对称对象有不止一个,而且可能有无数个规范的框架,这就导致学习目标模糊不清。因此,对于对称物体,作者反而将估计模型方向上的每个点与地面真相模型上最近的点之间的距离最小化。损失函数变成:

L i p = 1 M ∑ j min 0 < k < M ∣ ∣ ( R x j + t ) − ( R i ^ x j + t i ^ ) ∣ ∣ L_i^p=\frac{1}{M}\sum_{j} \min_{0

对所有预测的每一个密集像素姿态进行优化,就是将每一个密集像素损失的平均值降到最低:

L = 1 N ∑ i min i ( L i p c i − w log ( c i ) ) L=\frac{1}{N}\sum_{i} \min_{i}(L_i^pc_i-w\log(c_i)) L=N1i∑imin(Lipci−wlog(ci))

其中N为从段的P元素中随机抽取的密集像素特征数,w为平衡超参数。直观地讲,低置信度会导致较低的姿态估计损失,但会招致第二项的高惩罚,反之亦然。作者使用置信度最高的姿态估计作为最终输出。

4.6 迭代细化

本文提出了一种基于神经网络的迭代细化模块,该模块基于密集融合的嵌入,可以在不需要额外渲染技术的情况下,快速且稳健地改善最终的姿势估计结果。

目标是使网络能够以迭代的方式纠正自己的姿势估计误差。这里的挑战是训练网络完善之前的预测,而不是做出新的预测。所以作者将上一次迭代中做出的预测作为下一次迭代的输入的一部分。本文的关键思想是将之前预测的姿势视为目标物体的规范帧的估计,并将输入点云转化为这个估计的规范帧。这样一来,转换后的点云就隐含了估计姿势的编码。然后,将转换后的点云反馈到网络中,并根据之前的估计姿势预测一个残余姿势。这个过程可以迭代应用,每次迭代都能产生潜在的更精细的姿势估计。

过程在图3中有介绍。具体来说,本文训练了一个专门的姿态残差估计器网络,以执行给定的主网络初始姿态估计的细化。在每次迭代时,作者重新使用主网络中的图像特征嵌入,并与为新变换的点云计算的几何特征进行密集融合。姿势残差估计器使用融合像素特征集的全局特征作为输入。经过K次迭代后,我们得到最终的姿势估计值,作为每次迭代估计值的连接:

p ^ = [ R k ∣ t K ] ⋅ [ R k − 1 ∣ t K − 1 ] ⋅ ⋅ ⋅ ⋅ ⋅ [ R 0 ∣ t 0 ] \hat{p}=[R_k|t_K] ·[R_{k-1}|t_{K-1}]· · · · ·[R_0|t_0] p^=[Rk∣tK]⋅[Rk−1∣tK−1]⋅⋅⋅⋅⋅[R0∣t0]

在本文的实验中,只有在K=2次迭代后,细化的姿势已经能够超越之前作品的ICP细化结果。

5. 结论

本文提出了一种从RGB-D图像中估计已知物体的6D姿势的新方法。作者们的方法融合了一个密集的特征表示,其中包括基于其预测的信心的颜色和深度信息。通过这种密集的融合方法,在几个数据集中的表现优于之前的方法,并且对遮挡物的鲁棒性显著提高。此外,作者们还演示了机器人可以使用他们提出的方法来抓取和操纵物体。