32个Java面试必考点-09(上)消息队列Kafka架构与原理

本课时主要讲解消息队列与数据库相关的知识,重点讲解三部分知识点:

1.Kafka 的架构与消息交互流程;

2.数据库事务的 4 大特性和分类;

3.MySQL 相关的内容,比如索引、MySQL 调优等。

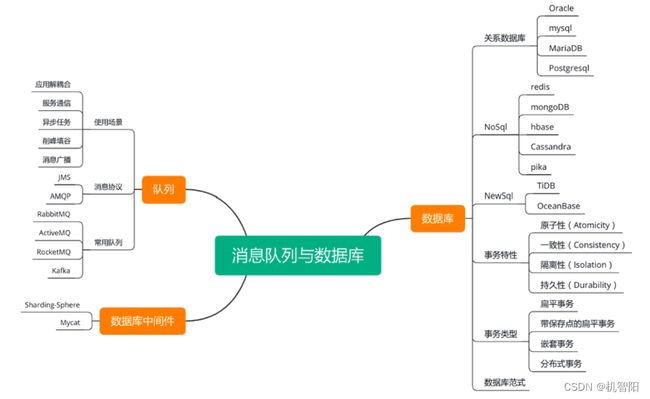

消息队列与数据库知识点

先来看看相关知识点汇总,如下图。首先为了防止歧义进行说明,本课时中提到的“队列“就是指“消息队列“。

消息队列

来看消息队列的应用场景,也就是队列能解决哪些问题。

& 队列可以对应用进行解耦合,应用之间不用直接调用。

& 可以通过队列来传递消息,完成通信。

& 队列也可以用来执行异步任务,任务提交方无需等待结果。

& 队列的另一个作用是削峰填谷,在突发流量时,可以通过队列做缓冲,不会对后端服务产生较大压力,当峰值过去时,可以逐渐消费堆积的数据,填平流量低谷。

& 消息队列一般还提供了一写多读的能力,可以用来做消息的多播与广播。

关于队列还需要知道两个主要的消息协议。

& JMS 是 Java 的消息服务,规定了 Java 使用消息服务的 API,在前面 Spring 的课时提到过,Spring 提供了支持 JMS 的组件。

& AMQP 是高级消息队列协议,是应用层协议的一个开放标准,AMQP 不从 API 层进行限定,而是直接定义网络交换的数据格式,因此支持跨语言的能力,例如 RabbitMQ 就使用了 AMQP 实现。

再来对比几个常用的消息队列。

& RabbitMQ

使用 Erlang 开发的开源消息队列,通过 Erlang 的 Actor 模型实现了数据的稳定可靠传输。支持 AMQP、XMPP、SMTP 等多种协议,因此也比较重量级。由于采用 Broker 代理架构,发送给客户端时先在中心队列排队,疑似 RabbitMQ 的单机吞吐量在万级,不算很高。

& ActiveMQ

可以部署于代理模式和 P2P 模式,支持多种协议,单机吞吐量在万级,但是 ActiveMQ 不够轻巧,对于队列较多的情况支持不是很好。并且有较低概率丢失消息。

& RocketMQ

阿里开源的消息中间件,单机能够支持 10w 级的吞吐量,使用 Java 开发,具有高吞吐量、高可用性的特点、适合在大规模分布式系统中应用。

& Kafka

由 Scala 开发的高性能跨语言分布式消息队列,单机吞吐量可以到达 10w 级,消息延迟在 ms 级。Kafka 是完全的分布式系统,Broker、Producer、Consumer 都原生自动支持分布式,依赖于 ZooKeeper 做分布式协调。Kafka 支持一写多读,消息可以被多个客户端消费,消息有可能会重复,但是不会丢失。本课时后面会对 Kafka 的架构进行详细介绍。

数据库中间件

数据库中间件一般提供了读写分离、数据库水平扩展的能力。下面主要介绍两个中间件。

一是 Sharding-Sphere,它是一个开源的分布式数据库中间件解决方案,由 Sharding-JDBC、Sharding-Proxy、Sharding-Sidecar 这几个独立产品组成,适用不同使用场景。这几个产品都提供标准化的数据分片、读写分离、柔性事务和数据治理功能,可适用于如 Java 同构、异构语言、容器、云原生等各种多样化的应用场景。 目前 Sharding-Sphere 已经进入 Apache 孵化,发展速度很快,可以重点关注。

二是 Mycat,它也提供了分库分表等能力,Mycat 基于 Proxy 代理模式,后端可以支持 MySQL、Oracle、DB2 等不同数据库实现,不过代理方式对性能会有一定影响。

其他还有一些数据库中间件例如 Vitess 等,使用不算广泛,了解即可。

数据库

对于数据库相关知识点,首先需要知道不同类型的数据库。

& 关系型数据库

常用的关系型数据库主要是 Oracle 和 MySQL。Oracle 功能强大,主要缺点就是贵。MySQL 是互联网行业中最流行的数据库,这不仅仅是因为 MySQL 免费,可以说关系数据库场景中你需要的功能,MySQL 都能很好得满足。后面的详解部分会详细介绍 MySQL 的一些知识点。

MariaDB 是 MySQL 的分支,由开源社区维护,MariaDB 虽然被看作 MySQL 的替代品,但与 MySQL 相比,它在扩展功能、存储引擎上都有非常好的改进,后续可以关注。

PostgreSQL也叫 PGSQL,PGSQL 类似于 Oracle 的多进程框架,可以支持高并发的应用场景。PG 几乎支持所有的 SQL 标准,支持类型相当丰富。PG 更加适合严格的企业应用场景,而 MySQL 更适合业务逻辑相对简单、数据可靠性要求较低的互联网场景。

NoSQL

NoSQL,就是 Not only SQL,一般指非关系型数据库。

上一课介绍的 Redis 就是非关系型数据库,它提供了持久化能力,支持多种数据类型。Redis 适用于数据变化快且数据大小可预测的场景。

MongoDB 是一个基于分布式文件存储的数据库,将数据存储为一个文档,数据结构由键值对组成。MongoDB 比较适合表结构不明确,且数据结构可能不断变化的场景,不适合有事务和复杂查询的场景。

HBase 是建立在 HDFS,也就是 Hadoop 文件系统之上的分布式面向列的数据库,类似于谷歌的大表设计,HBase 可以快速随机访问海量结构化数据。在表中它由行排序,一个表有多个列族以及每一个列族可以有任意数量的列。 HBase 依赖 HDFS 可以实现海量数据的可靠存储,适用于数据量大,写多读少,不需要复杂查询的场景。

Cassandra 是一个高可靠的大规模分布式存储系统。支持分布式的结构化 key-value 存储,以高可用性为主要目标。适合写多的场景,适合做一些简单查询,不适合用来做数据分析统计。

Pika 是一个可持久化的大容量类 Redis 存储服务, 兼容五种主要数据结构的大部分命令。Pika 使用磁盘存储,主要解决 Redis 大容量存储的成本问题。

NewSQL

NewSQL 数据库也越来越被大家关注,NewSQL 是指新一代关系型数据库。比较典型的有TiDB。

TiDB 是开源的分布式关系数据库,几乎完全兼容 MySQL,能够支持水平弹性扩展、ACID 事务、标准 SQL、MySQL 语法和 MySQL 协议,具有数据强一致的高可用特性。既适合在线事务处理,也适合在线分析处理。

另外一个比较著名的 NewSQL 是蚂蚁金服的 OceanBase。OB 是可以满足金融级的可靠性和数据一致性要求的数据库系统。需要使用事务,并且数据量比较大的时候,就比较适合使用 OB。不过目前 OB 已经商业化,不再开源。

最后来看数据库的范式。目前关系数据库有六种范式:第一范式、第二范式、第三范式、巴斯-科德范式(BCNF)、第四范式和第五范式。范式级别越高对数据表的要求越严格。

& 要求最低的第一范式只要求表中字段不可用在拆分。

& 第二范式在第一范式的基础上要求每条记录由主键唯一区分,记录中所有属性都依赖于主键。

& 第三范式在第二范式的基础上,要求所有属性必须直接依赖主键,不允许间接依赖。

一般说来,数据库只需满足第三范式就可以了。

详解 Kafka

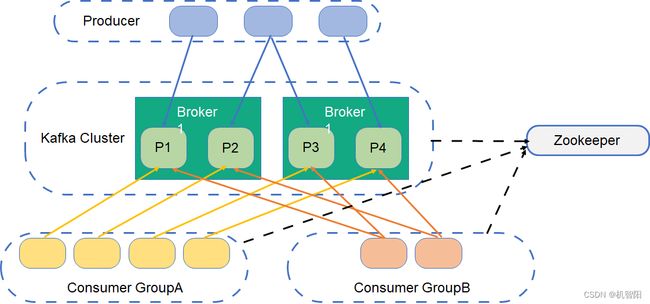

架构

下面来学习 Kafka 的架构。先结合如下的架构图来了解 Kafka 中的几个概念。

首先 Kafka 消息队列由三个角色组成,左面的是消息的生产方 Producer;中间是 Kafka 集群, Kafka 集群由多台 Kafka server 组成,每个 Server 称为一个 Broker,也就是消息代理;右面的是消息的消费方 Consumer。

Kafka 中消息是按照 Topic 进行划分的,一个 Topic 就是一个 Queue。在实际应用中,不同业务数据就可以设置为不同的 Topic。一个 Topic 可以有多个消费方,当生产方在某个 Topic 发出一条消息后,所有订阅了这个 Topic 的消费方都可以收到这条消息。

为了提高并行能力,Kafka 为每个 Topic 维护了多个 Partition 分区,每个分区可以看作一份追加类型的日志。 每个分区中的消息保证 ID 唯一且有序,新消息不断追加到尾部。Partition 实际存储数据时,会对按大小进行分段(Segment),来保证总是对较小的文件进行写操作,提高性能,方便管理。

如图中间部分,Partition 分布于多个 Broker 上。图中绿色的模块表示 Topic1 被分为了 3 个 Partition。每个 Partition 会被复制多份存在于不同的 Broker 上,如图中红色的模块,这样可以保证主分区出现问题时进行容灾。每个 Broker 可以保存多个 Topic 的多个 Partition。

Kafka 只保证一个分区内的消息有序,不能保证一个 Topic 的不同分区之间的消息有序。为了保证较高的处理效率,所有的消息读写都是在主 Partition 中进行,其他副本分区只会从主分区复制数据。Kafka 会在 ZooKeeper 上针对每个 Topic 维护一个称为 ISR(in-sync replica),就是已同步的副本集。如果某个主分区不可用了,Kafka 就会从 ISR 集合中选择一个副本作为新的主分区。

消息发布/消费流程

Kafka 通过对消费方进行分组管理来支持消息一写多读,流程如下图所示。

来看图中的例子,这个 Topic 分为 4 个 Partition,就是图中绿色的 P1到 P4,上部的生产方根据规则选择一个 Partition 进行写入,默认规则是轮询策略。也可以由生产方指定 Partition 或者指定 key 来根据 Hash 值选择 Partition。

消息的发送有三种方式:同步、异步以及 oneway。

& 同步模式下后台线程中发送消息时同步获取结果,这也是默认模式。

& 异步的模式允许生产者批量发送数据,可以极大的提高性能,但是会增加丢失数据的风险。

& oneway 模式只发送消息不需要返回发送结果,消息可靠性最低,但是低延迟、高吞吐,适用于对可靠性要求不高的场景。

来看消息的消费,Consumer 按照 Group 来消费消息,Topic 中的每一条消息可以被多个 Consumer Group 消费,如上图中的 GroupA 和 GroupB。Kafka 确保每个 Partition 在一个 Group 中只能由一个 Consumer 消费。Kafka 通过 Group Coordinator 来管理 Consumer 实际负责消费哪个 Partition,默认支持 Range 和轮询分配。

Kafka 在 ZK 中保存了每个 Topic 中每个 Partition 在不同 Group 的消费偏移量 offset,通过更新偏移量保证每条消息都被消费。

注意:用多线程来读取消息时,一个线程相当于一个 Consumer 实例。当 Consumer 的数量大于分区的数量的时候,有的 Consumer 线程会读取不到数据。

详解数据库事务

特性

数据库的特性是面试时考察频率非常高的题目,来看看数据库的 ACID 四大特性,如下图。

第一个原子性,指事务由原子的操作序列组成,所有操作要么全部成功,要么全部失败回滚。

第二个事务的一致性,指事务的执行不能破坏数据库数据的完整性和一致性,一个事务在执行之前和执行之后,数据库都必须处以一致性状态。比如在做多表操作时,多个表要么都是事务后新的值,要么都是事务前的旧值。

第三个事务的隔离性,指多个用户并发访问数据库时,数据库为每个用户执行的事务,不能被其他事务的操作所干扰,多个并发事务之间要相互隔离。事务的隔离级别在后文中介绍。

第四个事务的持久性,指一个事务一旦提交并执行成功,那么对数据库中数据的改变就是永久性的,即便是在数据库系统遇到故障的情况下也不会丢失提交事务的操作。

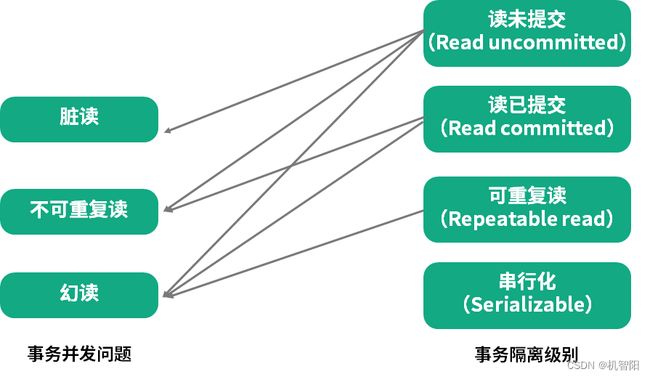

并发问题

在介绍数据的隔离级别之前,先看看没有隔离性的情况下数据库会出现哪些并发问题,如下图左侧部分所示。

脏读是指在一个事务处理过程里读取了另一个未提交的事务中的数据,例如,账户 A 转帐给 B 500元,B 余额增加后但事务还没有提交完成,此时如果另外的请求中获取的是 B 增加后的余额,这就发生了脏读,因为事务如果失败回滚时,B 的余额就不应该增加。

不可重复读是指对于数据库中某个数据,一个事务范围内多次查询返回了不同的数据值,这是由于在多次查询之间,有其他事务修改了数据并进行了提交。

幻读是指一个事务中执行两次完全相同的查询时,第二次查询所返回的结果集跟第一个查询不相同。与不可重复读的区别在于,不可重复读是对同一条记录,两次读取的值不同。而幻读是记录的增加或删除,导致两次相同条件获取的结果记录数不同。

隔离级别

事务的四种隔离级别可以解决上述几种并发问题。如上图右侧内容所示,由上到下,四种隔离级别由低到高。

第一个隔离级别是读未提交,也就是可以读取到其他事务未提交的内容,这是最低的隔离级别,这个隔离级别下,前面提到的三种并发问题都有可能发生。

第二个隔离级别是读已提交,就是只能读取到其他事务已经提交的数据。这个隔离级别可以解决脏读问题。

第三个隔离级别是可重复读,可以保证整个事务过程中,对同数据的多次读取结果是相同的。这个级别可以解决脏读和不可重复读的问题。MySQL 默认的隔离级别就是可重复读。

最后一个隔离级别是串行化,这是最高的隔离级别,所有事务操作都依次顺序执行。这个级别会导致并发度下降,性能最差。不过这个级别可以解决前面提到的所有并发问题。

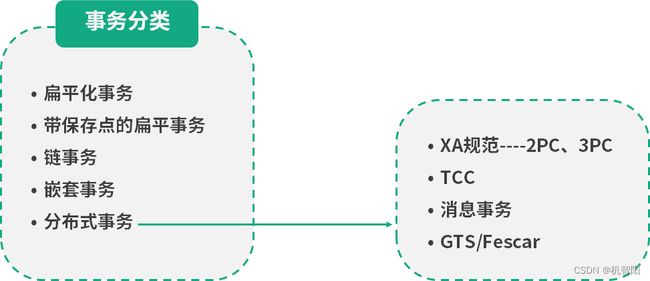

事务分类

接下来看事务的分类,如下图。

第一个是扁平化事务,在扁平事务中,所有的操作都在同一层次,这也是我们平时使用最多的一种事务。它的主要限制是不能提交或者回滚事务的某一部分,要么都成功,要么都回滚。

为了解决第一种事务的弊端,就有了第二种带保存点的扁平事务。它允许事务在执行过程中回滚到较早的状态,而不是全部回滚。通过在事务中插入保存点,当操作失败后,可以选择回滚到最近的保存点处。

第三种事务是链事务,可以看做是第二种事务的变种。它在事务提交时,会将必要的上下文隐式传递给下一个事务,当事务失败时就可以回滚到最近的事务。不过,链事务只能回滚到最近的保存点,而带保存点的扁平化事务是可以回滚到任意的保存点。

第四种事务是嵌套事务,由顶层事务和子事务构成,类似于树的结构。一般顶层事务负责逻辑管理,子事务负责具体的工作,子事务可以提交,但真正提交要等到父事务提交,如果上层事务回滚,那么所有的子事务都会回滚。

最后一种类型是分布式事务。是指分布式环境中的扁平化事务。

常用的分布式事务解决方案如上图右侧所示,下面进行简要介绍。

第一个分布式事务解决方案是 XA 协议,是保证强一致性的刚性事务。实现方式有两段式提交和三段式提交。两段式提交需要有一个事务协调者来保证所有的事务参与者都完成了第一阶段的准备工作。如果协调者收到所有参与者都准备好的消息,就会通知所有的事务执行第二阶段提交。一般场景下两段式提交已经能够很好得解决分布式事务了,然而两阶段在即使只有一个进程发生故障时,也会导致整个系统存在较长时间的阻塞。三段式提交通过增加 pre-commit 阶段来减少前面提到的系统阻塞的时间。三段式提交很少在实际中使用,简单了解就可以了。

第二个分布式解决方案是 TCC,是满足最终一致性的柔性事务方案。TCC 采用补偿机制,核心思想是对每个操作,都要注册对应的确认和补偿操作。它分为三个阶段:Try 阶段主要对业务系统进行检测及资源预留;Confirm 阶段对业务系统做确认提交;Cancel 阶段是在业务执行错误,执行回滚,释放预留的资源。

第三种方案是消息一致性方案。基本思路是将本地操作和发送消息放在一个事务中,保证本地操作和消息发送要么都成功要么都失败。下游应用订阅消息,收到消息后执行对应操作。

第四种方案可以了解一下阿里云中的全局事务服务 GTS,对应的开源版本是 Fescar。Fescar 基于两段式提交进行改良,剥离了分布式事务方案对数据库在协议支持上的要求。使用 Fescar 的前提是分支事务中涉及的资源,必须是支持 ACID 事务的关系型数据库。分支的提交和回滚机制,都依赖于本地事务来保障。 Fescar 的实现目前还存在一些局限,比如事务隔离级别最高支持到读已提交级别。