使用yolo训练自己的模型

YOLO(You Only Look Once)是一种用于目标检测的深度学习模型,旨在实时检测图像或视频中的多个对象。与传统的目标检测方法不同,YOLO一次性处理整个图像,而不是通过滑动窗口或区域提议进行多次检测。这种方法使得YOLO在速度上具有显著优势,能够实现实时目标检测。

以下是YOLO的一些关键特点:

-

One-shot Detection: YOLO的主要特点是一次性完成整个图像的目标检测,而不是像其他方法那样需要多次扫描图像。

-

实时性能: YOLO被设计为高效实时运行,尤其适用于需要快速处理大量数据的应用,如视频监控、自动驾驶等。

-

Anchor Boxes: YOLO使用先验框(Anchor Boxes)来预测目标的位置和大小。这些锚框表示了模型预测的目标的一些常见形状,有助于提高检测准确性。

-

分组预测: YOLO将图像分为较小的网格,每个网格负责预测一个或多个目标。这有助于提高模型对多尺度和多类别目标的检测能力。

-

多尺度特征图: YOLO通过使用多个尺度的特征图来捕捉图像中不同层次的语义信息,这有助于提高对小目标和远距离目标的检测性能。

-

全卷积网络: YOLO采用全卷积网络结构,使得模型可以接受任意大小的输入图像,并在输出中产生相应大小的目标框。

-

多类别检测: YOLO可以同时检测多个类别的目标,每个目标框附带一个置信度得分,表示该框中存在目标的置信水平。

YOLO的最新版本可能有一些改进和变化,因此在组会中最好使用最新的文档或论文进行参考。

-

训练过程: YOLO的训练过程通常包括两个主要阶段:首先,通过预训练的卷积神经网络(如Darknet)进行特征学习;然后,通过调整网络参数以适应目标检测任务。训练过程中需要使用标记好的包含目标边界框和类别信息的训练集。

-

非极大值抑制(NMS): 为了排除冗余的检测框,YOLO使用非极大值抑制。在多个检测框重叠的情况下,NMS算法会选择具有最高置信度得分的框,并抑制其他重叠框。

-

适用领域: YOLO广泛应用于计算机视觉领域,包括物体检测、行人检测、交通标志检测、医学图像分析等。其快速的实时性能使其成为许多实际应用的首选。

-

版本演进: YOLO模型有多个版本,每个版本都对算法和性能进行了改进。YOLOv4和YOLOv5是其中较新的版本,它们通过引入新的技术和优化提高了检测精度和速度。

-

开源: YOLO是一个开源项目,使得研究人员和开发者能够自由使用、修改和扩展该模型。YOLO的开源性质促进了社区合作和在不同领域的广泛应用。

-

YOLO模型结构: YOLO的网络结构通常由多个卷积层、池化层和全连接层组成。这些层构成了一个端到端的神经网络,负责提取输入图像的特征并输出目标框的坐标和类别信息。YOLO的网络结构是相对简洁的,这有助于实现高效的目标检测。

-

损失函数: YOLO使用多任务学习,其损失函数包括位置损失、对象置信度损失和类别置信度损失。位置损失衡量了目标框位置的精确度,对象置信度损失评估了模型对目标存在的置信度,而类别置信度损失则衡量了目标类别的分类准确度。这些损失函数的综合作用有助于优化模型,使其能够准确地检测和定位目标。

-

训练策略: YOLO的训练通常需要使用大规模的标记数据集,其中包含了各种目标和场景。训练时,模型通过反向传播和梯度下降等优化算法来不断调整权重,使得预测结果更加接近真实标签。合适的学习率调度和数据增强等策略也是训练中常用的技巧。

-

硬件加速: 为了在实际应用中提高YOLO的推理速度,一些版本的YOLO模型支持在不同硬件上进行加速,如GPU和NPU。这些硬件加速方法有助于满足实时性要求,特别是在需要处理大规模图像或视频流的场景中。

-

应用案例: YOLO已经在多个领域取得了成功应用,包括智能监控、自动驾驶、医学影像分析、无人机技术等。其高效的实时检测性能使得它在许多实际应用中成为首选的目标检测算法。

训练与训练数据输入部分:

-

数据准备: 准备标注好的训练数据集,其中每个样本都包含目标的边界框坐标和类别信息。确保数据集的多样性,涵盖了模型可能在实际应用中遇到的各种场景和目标。

-

数据预处理: 对训练数据进行预处理,包括图像大小的标准化、归一化、数据增强等操作。数据增强可以通过随机旋转、翻转、裁剪等方式增加训练数据的多样性,有助于提升模型的泛化能力。

-

模型配置: 选择合适的YOLO模型版本(如YOLOv4、YOLOv5等)和相应的配置文件。配置文件中包含了网络结构的参数、训练参数、学习率、锚框等信息。

-

权重初始化: 使用预训练的卷积神经网络权重初始化模型。通常可以使用在大规模图像分类任务上预训练的权重,以加速模型收敛。

-

模型训练: 利用标注好的训练数据集进行模型训练。通过反向传播和梯度下降等优化算法,不断调整模型的权重,使其能够准确地检测目标。训练过程中,监控模型在验证集上的性能以及损失函数的变化,确保模型在训练过程中逐渐收敛。

-

学习率调度: 使用合适的学习率调度策略,如学习率衰减或学习率周期性调整,以优化模型的收敛速度和稳定性。

模型评估方式与具体实现方法:

-

评估指标: YOLO模型的性能通常通过目标检测任务中常用的指标进行评估,包括准确率(Precision)、召回率(Recall)、F1分数等。除此之外,可以使用均方误差(Mean Squared Error,MSE)来评估目标框坐标的精度。

-

验证集评估: 在训练过程中,使用预留的验证集进行定期的模型性能评估。验证集上的评估结果可以帮助确定模型是否过拟合或欠拟合,并指导是否需要调整模型架构或超参数。

-

非极大值抑制(NMS): 在模型输出目标框后,使用NMS算法来抑制冗余的检测框,以提高模型的检测精度。NMS的实现通常涉及设置一个阈值来确定是否合并相邻的检测框。

-

可视化分析: 利用可视化工具分析模型在测试集上的预测结果,查看模型是否成功检测出目标、框的位置是否准确,以及对不同类别的检测效果如何。

-

指标曲线: 绘制学习曲线、损失函数曲线以及评估指标随训练次数的变化曲线,以更全面地了解模型的训练过程和性能。

-

模型保存与部署: 在满足性能要求后,保存训练好的模型权重。随后,可以将模型部署到实际应用中,例如嵌入式系统、服务器端或移动端,实现目标检测的实时应用。

实现方式

实现一个YOLO项目通常涉及以下步骤:

-

准备工作:

- 安装深度学习框架:确保你已经安装了你选择的深度学习框架,如TensorFlow或PyTorch。

- 安装YOLO模型:下载或克隆YOLO模型的代码库,例如Darknet(YOLO官方实现)或YOLOv5的代码库。

-

数据集准备:

- 收集或获取目标检测任务的标注好的数据集,确保数据集包含了目标类别的图像以及相应的标签信息。

- 数据预处理:对数据集进行预处理,包括图像大小的调整、归一化、数据增强等,以提高模型的泛化能力。

-

配置模型:

- 配置模型参数:根据你的任务需求,选择合适的YOLO模型版本(如YOLOv3、YOLOv4、YOLOv5等),并设置相应的超参数,如学习率、批量大小等。

- 配置模型结构:修改网络结构的配置文件,定义模型的层数、锚框、类别数等。

-

权重初始化:

- 使用预训练权重:在模型训练之前,可以使用在大规模图像分类任务上预训练的权重来初始化模型。这有助于模型更快速地学习目标检测任务。

-

模型训练:

- 输入训练数据:将预处理过的训练数据输入模型。

- 定义损失函数:YOLO模型通常使用多任务学习,需要定义位置损失、对象置信度损失和类别置信度损失。

- 反向传播和优化:使用梯度下降等优化算法进行反向传播,不断调整模型权重以减小损失函数。

- 监控训练过程:通过查看训练损失、验证集性能等,监控模型在训练过程中的表现。

-

模型评估:

- 使用验证集:在训练过程中,使用预留的验证集评估模型性能。调整模型结构和超参数,以提高模型的准确性和泛化能力。

- 调整阈值:根据具体的应用需求,调整目标检测的阈值,以平衡准确率和召回率。

-

模型保存与部署:

- 保存模型权重:在满足性能要求后,保存训练好的模型权重。

- 模型部署:将训练好的模型部署到实际应用中,可以是服务器端、嵌入式系统或移动端。

-

测试与应用:

- 使用测试数据:使用测试集验证模型在新数据上的性能。

- 应用到实际场景:将训练好的模型应用到实际场景中,进行目标检测。

-

维护与更新:

- 模型监控:定期监控模型在实际应用中的性能,根据需要进行更新和调整。

- 社区贡献:参与社区,了解最新的YOLO模型版本和优化,及时更新项目以保持最新性能。

具体操作

具体操作方法会取决于你选择的YOLO版本和深度学习框架。以下是一个基于YOLOv5和PyTorch的具体操作示例,供参考:

步骤:

-

安装依赖:

- 安装PyTorch:根据你的CUDA版本和操作系统选择合适的PyTorch版本,并按照PyTorch官方文档进行安装。

- 安装其他依赖:运行

pip install -U -r requirements.txt安装项目所需的其他依赖项。

-

获取YOLOv5代码:

- 克隆YOLOv5仓库:运行以下命令获取YOLOv5的代码。

git clone https://github.com/ultralytics/yolov5.git cd yolov5

- 克隆YOLOv5仓库:运行以下命令获取YOLOv5的代码。

-

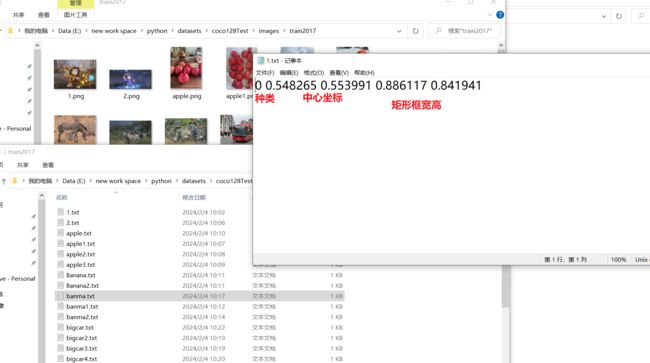

数据准备:

- 准备数据集:将你的目标检测数据集准备好,确保每个图像都有相应的标签文件,标签文件包含目标的类别、边界框坐标等信息。

- 配置数据路径:在

data.yaml文件中设置数据集的路径和类别信息。

-

训练配置:

- 修改训练配置:在

yolov5/models/yolov5s.yaml中可以调整模型的参数,例如学习率、迭代次数等。 - 准备预训练权重:下载并准备一个预训练权重文件,可以从YOLOv5的发布页面或其他来源获取。

- 修改训练配置:在

-

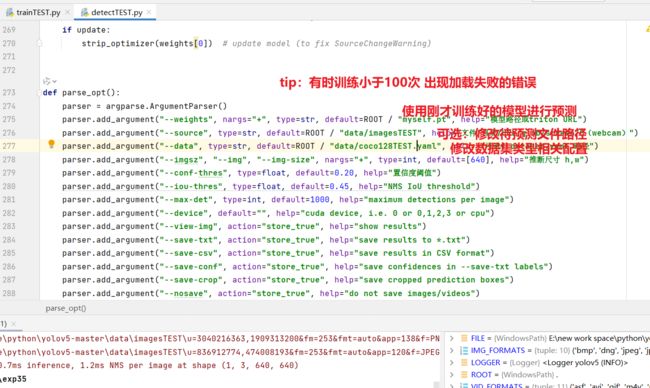

模型训练:

- 运行训练命令:使用以下命令开始模型训练。

python train.py --img-size 640 --batch-size 16 --epochs 50 --data data.yaml --cfg models/yolov5s.yaml --weights '' --name your_experiment_name - 请根据实际情况调整命令中的参数。

- 运行训练命令:使用以下命令开始模型训练。

-

模型评估:

- 运行测试命令:使用以下命令在验证集上评估模型性能。

python test.py --weights runs/train/your_experiment_name/weights/best.pt --data data.yaml - 检查评估指标,如Precision、Recall、mAP等。

- 运行测试命令:使用以下命令在验证集上评估模型性能。

-

模型部署:

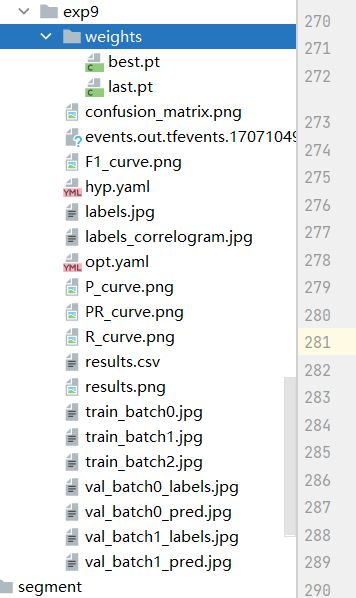

- 保存权重:在训练结束后,你可以使用训练生成的权重文件进行推理。

- 部署到实际应用:将模型集成到你的应用程序中,确保输入图像经过预处理后可以被模型识别。

详细实现

1. 安装依赖项:

确保你已经安装了Python,然后运行以下命令安装必要的依赖项:

pip install torch torchvision

pip install -U -r requirements.txt

2. 获取YOLOv5代码:

git clone https://github.com/ultralytics/yolov5.git

cd yolov5

3. 数据准备:

- 创建一个数据目录,将你的训练图像和标签文件(通常是

.txt文件,每个文件对应一个图像)放入其中。 - 创建一个

data.yaml文件,指定数据集的相关信息,例如类别数、训练集和验证集的路径等。

4. 配置训练:

- 打开

yolov5/models/yolov5s.yaml文件,你可以调整模型的参数,如学习率、迭代次数等。此文件也包含有关锚框和类别的信息。

5. 准备预训练权重:

在YOLOv5的发布页面或官方仓库的 weights 目录中,你可以找到各种不同大小的预训练权重文件,选择一个合适的文件并下载。

6. 模型训练:

python train.py --img-size 640 --batch-size 16 --epochs 50 --data data.yaml --cfg models/yolov5s.yaml --weights 'path/to/your/pretrained_weights.pt' --name your_experiment_name

确保替换 path/to/your/pretrained_weights.pt 为你下载的预训练权重文件路径。

训练 状态结果.cvs

| epoch | train/box_loss | train/obj_loss | train/cls_loss | metrics/precision | metrics/recall |

|---|---|---|---|---|---|

| 0 | 0.045448 | 0.065364 | 0.016448 | 0.71383 | 0.64427 |

| metrics/mAP_0.5 | metrics/mAP_0.5:0.95 | val/box_loss | val/obj_loss | val/cls_loss | x/lr0 | x/lr1 | x/lr2 | |

|---|---|---|---|---|---|---|---|---|

| 0.71969 | 0.47919 | 0.040641 | 0.03663 | 0.009494 | 0.0937 | 0.0007 | 0.0007 |

每轮训练指标

epoch: # 当前训练轮数

train/box_loss: # 训练阶段的边界框定位损失

train/obj_loss: # 训练阶段的目标对象损失

train/cls_loss: # 训练阶段的类别分类损失

metrics/precision: # 训练集上的精度指标

metrics/recall: # 训练集上的召回率指标

metrics/mAP_0.5: # 在IoU阈值为0.5时的平均精度(mAP)

metrics/mAP_0.5:0.95: # 在IoU阈值从0.5到0.95范围内的平均精度

val/box_loss: # 验证阶段的边界框定位损失

val/obj_loss: # 验证阶段的目标对象损失

val/cls_loss: # 验证阶段的类别分类损失

x/lr0: # 学习率调整,可能表示当前的学习率或学习率变化

x/lr1: # 另一个学习率变化点记录

x/lr2: # 第三个学习率变化点记录

训练过程信息

Epoch GPU_mem box_loss obj_loss cls_loss Instances Size

2/2 0G 0.04473 0.07081 0.01642 250 640: 100%|██████████| 8/8 [02:19<00:00, 17.45s/it]

模型性能评估结果

Class Images Instances P R mAP50 mAP50-95: 100%|██████████| 4/4 [00:43<00:00, 10.92s/it]

all 128 929 0.751 0.651 0.737 0.484

总结信息

3 epochs completed in 0.164 hours.

Optimizer stripped from runs\train\exp6\weights\last.pt, 14.9MB

Optimizer stripped from runs\train\exp6\weights\best.pt, 14.9MB

Validating runs\train\exp6\weights\best.pt…

模型融合及参数统计

Fusing layers…

Model summary: 157 layers, 7225885 parameters, 0 gradients, 16.4 GFLOPs

各类别详细评估结果

(略,包含每个类别的准确率、召回率以及mAP50和mAP50-95等指标)

结果保存路径

Results saved to runs\train\exp6

验证权重文件:Validating runs\train\exp6\weights\best.pt…

模型融合(优化性能):Fusing layers…

模型结构概览:

层数:157层

参数数量:7,225,885个参数

当前梯度数量:0

计算量 (GFLOPs):16.4

模型在不同类别上的评估指标汇总(包括精度P、召回率R、mAP50和mAP50-95等):

总体表现:

图片总数:128张

实例总数:929个

精度(P):0.752

召回率(R):0.65

[email protected]:0.737

[email protected]:0.95:0.484

各类别详细评估结果,例如:

类别“person”:在128张图片中共有254个实例,其准确率为0.866,召回率为0.72,[email protected]为0.803,[email protected]:0.95为0.534

每个类别的详细评估结果显示了模型对各类目标的检测能力。

7. 模型评估:

python test.py --weights runs/train/your_experiment_name/weights/best.pt --data data.yaml

在这里,your_experiment_name 是你之前定义的实验名称。

8. 模型部署:

- 训练完成后,你可以使用

export.py脚本将训练好的模型导出为TorchScript格式,以便更容易在其他环境中部署。

python export.py --img-size 640 --batch-size 1 --include pb # 生成TorchScript模型

- 然后,可以将导出的模型集成到自己的应用程序中

大体过程

YOLOv5 使用的是一个基于卷积神经网络(CNN)的实时目标检测模型。YOLOv5 的模型结构继承了 YOLO 系列的特点,并在此基础上进行了优化和改进。

模型结构特点:

为什么这么快:

yolo中采用你只看一次的策略,简化了中间复杂的处理过程。

滑动窗口和YOLO(You Only Look Once)是两种不同的目标检测方法。

-

滑动窗口传统算法:

- 工作原理: 滑动窗口算法是一种传统的目标检测方法。它通过在图像上滑动一个固定大小的窗口,然后在每个窗口上应用分类器来判断是否包含目标。窗口的大小和步幅是预先定义的参数。

- 优点: 简单直观,易于理解和实现。可以使用各种分类器,如SVM或神经网络。

- 缺点: 需要在不同尺度和位置上尝试许多窗口,计算开销大。在多尺度情况下容易漏掉小目标,而且在大尺度上可能导致计算复杂度增加。

-

YOLO(You Only Look Once):

- 工作原理: YOLO是一种基于深度学习的目标检测算法。它将整个图像划分为固定大小的网格单元,并在每个单元格上预测目标的边界框和类别概率。YOLO在单个前向传递中同时完成了定位和分类,因此相对于滑动窗口方法,速度更快。

- 优点: 高效,因为一次前向传递就可以获得整个图像中的目标信息。对于小目标和相互重叠的目标有较好的检测性能。

- 缺点: 对于小目标的检测可能不如一些特定于小目标的方法。在处理密集目标布局时,可能存在定位精度较低的问题。

比较:

- 速度: YOLO通常比滑动窗口方法更快,因为它可以在整个图像上执行一次前向传递,而不是尝试多个窗口。

- 精度: YOLO在大目标和密集目标布局方面通常比滑动窗口方法更强大。但是,对于小目标,一些特定于小目标的方法可能会取得更好的效果。

- 计算复杂度: 滑动窗口方法的计算复杂度取决于尝试的窗口数量,而YOLO则在整个图像上进行一次前向传递,因此通常计算复杂度相对较低。

选择使用滑动窗口还是YOLO取决于具体的应用场景、性能需求和对目标检测的精度要求。

比如滑动窗口传统算法

多尺度特征提取:

YOLOv5 采用 CSPDarknet 架构作为其主干网络,它结合了 Cross Stage Partial Network (CSPNet) 和 Darknet-53 的优点,以提高特征提取效率并减少计算量。

模型包含多个不同尺度的输出层,分别对应于小、中、大三种尺寸的目标检测。

Anchor Boxes:

继续使用锚框机制来预测目标框的位置和大小,每个网格单元会预测一组预先设定的锚框尺寸。

SPP(空间金字塔池化)模块:

在某些版本的 YOLOv5 中引入了 Spatial Pyramid Pooling 层,用于捕获多尺度信息。

PanopticFPN(全景特征金字塔网络):

针对实例分割任务,YOLOv5x 版本引入了 PanopticFPN 来整合前景和背景的分割预测。

优化后的后处理步骤:

预测出的边界框经过非极大值抑制(NMS)进行过滤,保留高置信度且重叠较小的框。

对于边界框的坐标预测,YOLOv5 进行了坐标回归变换,比如使用 sigmoid 函数对中心偏移进行归一化处理,用指数函数对宽高进行缩放。

图形预测处理过程:

预处理阶段:

图像首先被调整到模型所需的输入尺寸(例如640×640),并进行标准化(减去均值、除以标准差)。

可能利用 CUDA 内核函数进行高效的图像缩放和色彩空间转换等操作。

模型推断阶段:

输入图片通过 CNN 进行前向传播,得到多个不同尺度的特征图。

每个特征图上的网格单元都会生成一系列边界框预测及其对应的类别概率和对象性得分。

解码预测结果:

将预测出的边界框偏移量、宽度高度调整参数以及类别的条件概率应用到对应的锚框上,从而得到最终预测的边界框位置和类别。

根据阈值筛选掉低置信度的边界框。

应用 NMS 删除冗余的预测框。

后处理:

输出最终经过 NMS 后筛选过的边界框以及它们的分类标签。

YOLOv5 在整个预测过程中高效地从输入图像中提取特征,预测目标的位置与类别,并通过一系列优化策略保证了模型在实时性与精度之间的平衡

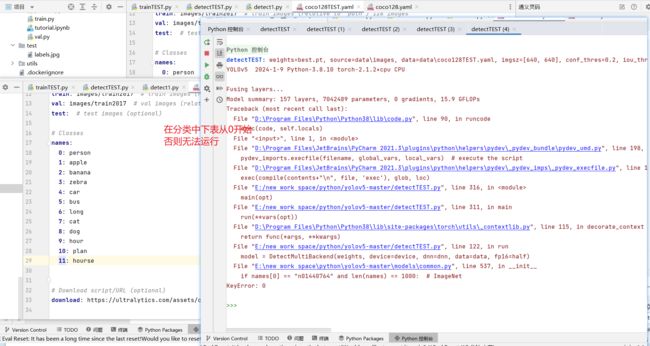

win10下Pycharm运行代码配置

初次训练100次结果

“D:\Program Files\Python\Python38\python.exe” “D:\Program Files\JetBrains\PyCharm 2021.3\plugins\python\helpers\pydev\pydevconsole.py” --mode=client --port=50075

import sys; print(‘Python %s on %s’ % (sys.version, sys.platform))

sys.path.extend([‘E:\new work space\python\yolov5-master’, ‘E:/new work space/python/yolov5-master’])

PyDev console: starting.

Python 3.8.10 (tags/v3.8.10:3d8993a, May 3 2021, 11:48:03) [MSC v.1928 64 bit (AMD64)] on win32

runfile(‘E:/new work space/python/yolov5-master/trainTEST.py’, wdir=‘E:/new work space/python/yolov5-master’)

trainTEST: weights=yolov5s.pt, cfg=, data=data\coco128TEST.yaml, hyp=data\hyps\hyp.scratch-low.yaml, epochs=100, batch_size=16, imgsz=640, rect=False, resume=False, nosave=False, noval=False, noautoanchor=False, noplots=False, evolve=None, evolve_population=data\hyps, resume_evolve=None, bucket=, cache=None, image_weights=False, device=, multi_scale=False, single_cls=False, optimizer=SGD, sync_bn=False, workers=8, project=runs\train, name=exp, exist_ok=False, quad=False, cos_lr=False, label_smoothing=0.0, patience=100, freeze=[0], save_period=-1, seed=0, local_rank=-1, entity=None, upload_dataset=False, bbox_interval=-1, artifact_alias=latest, ndjson_console=False, ndjson_file=False

github: skipping check (not a git repository), for updates see https://github.com/ultralytics/yolov5

YOLOv5 2024-1-9 Python-3.8.10 torch-2.1.2+cpu CPU

hyperparameters: lr0=0.01, lrf=0.01, momentum=0.937, weight_decay=0.0005, warmup_epochs=3.0, warmup_momentum=0.8, warmup_bias_lr=0.1, box=0.05, cls=0.5, cls_pw=1.0, obj=1.0, obj_pw=1.0, iou_t=0.2, anchor_t=4.0, fl_gamma=0.0, hsv_h=0.015, hsv_s=0.7, hsv_v=0.4, degrees=0.0, translate=0.1, scale=0.5, shear=0.0, perspective=0.0, flipud=0.0, fliplr=0.5, mosaic=1.0, mixup=0.0, copy_paste=0.0

Comet: run ‘pip install comet_ml’ to automatically track and visualize YOLOv5 runs in Comet

TensorBoard: Start with ‘tensorboard --logdir runs\train’, view at http://localhost:6006/

Overriding model.yaml nc=80 with nc=12

from n params module arguments

0 -1 1 3520 models.common.Conv [3, 32, 6, 2, 2]

1 -1 1 18560 models.common.Conv [32, 64, 3, 2]

2 -1 1 18816 models.common.C3 [64, 64, 1]

3 -1 1 73984 models.common.Conv [64, 128, 3, 2]

4 -1 2 115712 models.common.C3 [128, 128, 2]

5 -1 1 295424 models.common.Conv [128, 256, 3, 2]

6 -1 3 625152 models.common.C3 [256, 256, 3]

7 -1 1 1180672 models.common.Conv [256, 512, 3, 2]

8 -1 1 1182720 models.common.C3 [512, 512, 1]

9 -1 1 656896 models.common.SPPF [512, 512, 5]

10 -1 1 131584 models.common.Conv [512, 256, 1, 1]

11 -1 1 0 torch.nn.modules.upsampling.Upsample [None, 2, ‘nearest’]

12 [-1, 6] 1 0 models.common.Concat [1]

13 -1 1 361984 models.common.C3 [512, 256, 1, False]

14 -1 1 33024 models.common.Conv [256, 128, 1, 1]

15 -1 1 0 torch.nn.modules.upsampling.Upsample [None, 2, ‘nearest’]

16 [-1, 4] 1 0 models.common.Concat [1]

17 -1 1 90880 models.common.C3 [256, 128, 1, False]

18 -1 1 147712 models.common.Conv [128, 128, 3, 2]

19 [-1, 14] 1 0 models.common.Concat [1]

20 -1 1 296448 models.common.C3 [256, 256, 1, False]

21 -1 1 590336 models.common.Conv [256, 256, 3, 2]

22 [-1, 10] 1 0 models.common.Concat [1]

23 -1 1 1182720 models.common.C3 [512, 512, 1, False]

24 [17, 20, 23] 1 45849 models.yolo.Detect [12, [[10, 13, 16, 30, 33, 23], [30, 61, 62, 45, 59, 119], [116, 90, 156, 198, 373, 326]], [128, 256, 512]]

Model summary: 214 layers, 7051993 parameters, 7051993 gradients, 16.0 GFLOPs

Transferred 343/349 items from yolov5s.pt

optimizer: SGD(lr=0.01) with parameter groups 57 weight(decay=0.0), 60 weight(decay=0.0005), 60 bias

train: Scanning E:\new work space\python\datasets\coco128Test\labels\train2017.cache… 44 images, 0 backgrounds, 0 corrupt: 100%|██████████| 44/44 [00:00 val: Scanning E:\new work space\python\datasets\coco128Test\labels\train2017.cache… 44 images, 0 backgrounds, 0 corrupt: 100%|██████████| 44/44 [00:00 AutoAnchor: 3.99 anchors/target, 1.000 Best Possible Recall (BPR). Current anchors are a good fit to dataset

Plotting labels to runs\train\exp9\labels.jpg…

Image sizes 640 train, 640 val

Using 8 dataloader workers

Logging results to runs\train\exp9

Starting training for 100 epochs…

Epoch GPU_mem box_loss obj_loss cls_loss Instances Size

0/99 0G 0.123 0.03793 0.07844 66 640: 100%|██████████| 3/3 [01:20<00:00, 26.87s/it]

Class Images Instances P R mAP50 mAP50-95: 0%| | 0/2 [00:00 Class Images Instances P R mAP50 mAP50-95: 50%|█████ | 1/2 [00:14<00:14, 14.95s/it]WARNING NMS time limit 1.100s exceeded

Class Images Instances P R mAP50 mAP50-95: 100%|██████████| 2/2 [00:20<00:00, 10.26s/it]

all 44 117 0 0 0 0

Epoch GPU_mem box_loss obj_loss cls_loss Instances Size

17/99 0G 0.07482 0.03235 0.03232 47 640: 100%|██████████| 3/3 [00:55<00:00, 18.60s/it]

Class Images Instances P R mAP50 mAP50-95: 50%|█████ | 1/2 [00:13<00:13, 13.55s/it]WARNING NMS time limit 1.100s exceeded

Class Images Instances P R mAP50 mAP50-95: 100%|██████████| 2/2 [00:18<00:00, 9.34s/it]

all 44 117 0.276 0.341 0.302 0.129

Epoch GPU_mem box_loss obj_loss cls_loss Instances Size

36/99 0G 0.07347 0.02879 0.01845 86 640: 100%|██████████| 3/3 [00:45<00:00, 15.21s/it]

Class Images Instances P R mAP50 mAP50-95: 100%|██████████| 2/2 [00:17<00:00, 8.51s/it]

all 44 117 0.454 0.625 0.432 0.197

Epoch GPU_mem box_loss obj_loss cls_loss Instances Size

69/99 0G 0.04048 0.02377 0.01117 80 640: 100%|██████████| 3/3 [00:48<00:00, 16.22s/it]

Class Images Instances P R mAP50 mAP50-95: 100%|██████████| 2/2 [00:16<00:00, 8.01s/it]

all 44 117 0.772 0.82 0.93 0.666

Epoch GPU_mem box_loss obj_loss cls_loss Instances Size

80/99 0G 0.03914 0.0196 0.01344 64 640: 100%|██████████| 3/3 [00:48<00:00, 16.22s/it]

Epoch GPU_mem box_loss obj_loss cls_loss Instances Size

90/99 0G 0.03442 0.02564 0.008466 58 640: 100%|██████████| 3/3 [00:52<00:00, 17.55s/it]

Epoch GPU_mem box_loss obj_loss cls_loss Instances Size

99/99 0G 0.036 0.02346 0.009882 74 640: 100%|██████████| 3/3 [00:51<00:00, 17.20s/it]

Class Images Instances P R mAP50 mAP50-95: 100%|██████████| 2/2 [00:16<00:00, 8.26s/it]

all 44 117 0.762 0.918 0.934 0.699

100 epochs completed in 1.932 hours.

Optimizer stripped from runs\train\exp9\weights\last.pt, 14.5MB

Optimizer stripped from runs\train\exp9\weights\best.pt, 14.5MB

Validating runs\train\exp9\weights\best.pt…

Fusing layers…

Model summary: 157 layers, 7042489 parameters, 0 gradients, 15.9 GFLOPs

Class Images Instances P R mAP50 mAP50-95: 100%|██████████| 2/2 [00:14<00:00, 7.50s/it]

all 44 117 0.766 0.94 0.935 0.708

person 44 18 0.601 0.778 0.81 0.387

apple 44 40 0.858 1 0.994 0.757

banana 44 2 0.903 1 0.995 0.846

zebra 44 6 0.915 1 0.995 0.747

car 44 23 0.457 0.957 0.887 0.524

bus 44 7 0.862 0.857 0.857 0.743

long 44 4 0.897 1 0.995 0.796

cat 44 3 0.67 1 0.913 0.797

dog 44 4 0.616 0.809 0.912 0.705

hourse 44 10 0.88 1 0.995 0.782

Results saved to runs\train\ex

训练过程评估 一些参数的含义

| 训练轮次 | 训练阶段的边界框损失.衡量模型预测的边界框位置与真实边界框位置之间的差距 | 训练阶段的目标损失.判断图像中的每个像素点是否包含对象。 | 训练阶段的类别损失。评估模型对每个物体类别预测准确性的能力。 | 评估指标:精度。 | 评估指标:召回率。表示被正确识别为正类别的样本占所有实际为正类别的样本的比例。 | 在IoU阈值为0.5时的平均精度均值(mAP)。平均精度均值(mAP),这是目标检测任务中的关键评估指标,它综合考虑了精度和召回率,在IoU阈值为0.5和0.5至0.95范围内的表现。 | 在IoU阈值从0.5到0.95范围内的平均精度均值(mAP) | val/box_loss、val/obj_loss 和 val/cls_loss:这些是在验证集上计算的相应损失,用于监控模型在未见过数据上的泛化能力。验证阶段的边界框损失 | 验证阶段的目标损失 | 验证阶段的类别损失 | 学习率参数1(可能表示当前学习率或某个学习率组的初始学习率) | 学习率参数2(类似地,可能是另一个学习率或调整后的学习率) | 学习率参数3(学习率是训练神经网络中的一个重要超参数,它决定了梯度下降过程中权重更新的步长。合适的初始学习率及动态调整策略可以显著影响模型收敛速度和最终性能。 |

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| epoch | train/box_loss | train/obj_loss | train/cls_loss | metrics/precision | metrics/recall | metrics/mAP_0.5 | metrics/mAP_0.5:0.95 | val/box_loss | val/obj_loss | val/cls_loss | x/lr0 | x/lr1 | x/lr2 |

| 0 | 0.12299 | 0.037928 | 0.078438 | 0 | 0 | 0 | 0 | 0.12971 | 0.03307 | 0.082694 | 0.0982 | 0.0002 | 0.0002 |

| 1 | 0.12427 | 0.038864 | 0.074718 | 0 | 0 | 0 | 0 | 0.12759 | 0.03265 | 0.080175 | 0.095495 | 0.00049505 | 0.00049505 |

| 2 | 0.12153 | 0.03549 | 0.076419 | 0 | 0 | 0 | 0 | 0.1242 | 0.032311 | 0.07614 | 0.092784 | 0.00078416 | 0.00078416 |

| 3 | 0.11785 | 0.037789 | 0.071315 | 0.00081438 | 0.035833 | 0.00065194 | 6.52E-05 | 0.11821 | 0.03271 | 0.070499 | 0.090067 | 0.0010673 | 0.0010673 |

| 4 | 0.11359 | 0.043884 | 0.067013 | 0.0038199 | 0.079467 | 0.0028691 | 0.00075284 | 0.10969 | 0.034451 | 0.064379 | 0.087345 | 0.0013446 | 0.0013446 |

| 5 | 0.10583 | 0.039396 | 0.063288 | 0.007389 | 0.2327 | 0.010755 | 0.0030059 | 0.10386 | 0.03576 | 0.060628 | 0.084616 | 0.0016158 | 0.0016158 |

| 6 | 0.10093 | 0.047912 | 0.059314 | 0.041519 | 0.0525 | 0.05821 | 0.020251 | 0.097258 | 0.036518 | 0.056698 | 0.081881 | 0.0018812 | 0.0018812 |

| 7 | 0.097509 | 0.047785 | 0.057612 | 0.40986 | 0.050269 | 0.074319 | 0.031796 | 0.093109 | 0.036247 | 0.054215 | 0.079141 | 0.0021406 | 0.0021406 |

| 8 | 0.093569 | 0.037552 | 0.059465 | 1 | 0.051469 | 0.11104 | 0.047186 | 0.085903 | 0.035041 | 0.049312 | 0.076394 | 0.0023941 | 0.0023941 |

| 9 | 0.08879 | 0.050717 | 0.052817 | 0.84288 | 0.087089 | 0.16973 | 0.072653 | 0.082375 | 0.03436 | 0.046335 | 0.073642 | 0.0026416 | 0.0026416 |

| 10 | 0.086876 | 0.048716 | 0.049783 | 0.7687 | 0.15108 | 0.20259 | 0.089311 | 0.076461 | 0.033028 | 0.041666 | 0.070883 | 0.0028832 | 0.0028832 |

| 11 | 0.078214 | 0.047236 | 0.043394 | 0.81763 | 0.15618 | 0.21849 | 0.097379 | 0.076613 | 0.031232 | 0.039297 | 0.068119 | 0.0031189 | 0.0031189 |

| 12 | 0.079453 | 0.035891 | 0.045946 | 0.78016 | 0.22201 | 0.30069 | 0.15756 | 0.076691 | 0.029397 | 0.035272 | 0.065349 | 0.0033486 | 0.0033486 |

| 13 | 0.078896 | 0.034106 | 0.041316 | 0.31746 | 0.33717 | 0.29193 | 0.13308 | 0.07723 | 0.029123 | 0.033103 | 0.062572 | 0.0035723 | 0.0035723 |

| 14 | 0.079636 | 0.036924 | 0.035217 | 0.28962 | 0.33123 | 0.27692 | 0.13567 | 0.081913 | 0.029603 | 0.029622 | 0.05979 | 0.0037902 | 0.0037902 |

| 15 | 0.080307 | 0.042419 | 0.033434 | 0.29683 | 0.39238 | 0.32998 | 0.15215 | 0.075046 | 0.029994 | 0.027948 | 0.057002 | 0.0040021 | 0.0040021 |

| 16 | 0.073743 | 0.041208 | 0.033508 | 0.44534 | 0.27184 | 0.27164 | 0.11011 | 0.075941 | 0.033857 | 0.025613 | 0.054208 | 0.004208 | 0.004208 |

| 17 | 0.074816 | 0.032347 | 0.032321 | 0.27585 | 0.34136 | 0.3024 | 0.12942 | 0.079848 | 0.031904 | 0.024102 | 0.051408 | 0.004408 | 0.004408 |

| 18 | 0.076078 | 0.032265 | 0.032488 | 0.51202 | 0.33145 | 0.34473 | 0.14271 | 0.074968 | 0.02975 | 0.022965 | 0.048602 | 0.0046021 | 0.0046021 |

| 19 | 0.06954 | 0.035606 | 0.027102 | 0.46451 | 0.32659 | 0.27689 | 0.10459 | 0.077629 | 0.028266 | 0.021712 | 0.04579 | 0.0047902 | 0.0047902 |

| 20 | 0.073976 | 0.036596 | 0.025114 | 0.5356 | 0.40639 | 0.35394 | 0.17119 | 0.072846 | 0.025964 | 0.020447 | 0.042972 | 0.0049724 | 0.0049724 |

| 21 | 0.071463 | 0.039068 | 0.024317 | 0.62139 | 0.39063 | 0.35739 | 0.185 | 0.072424 | 0.023688 | 0.019549 | 0.040149 | 0.0051487 | 0.0051487 |

| 22 | 0.074215 | 0.043787 | 0.023634 | 0.63573 | 0.46231 | 0.39708 | 0.20882 | 0.071895 | 0.023449 | 0.018635 | 0.037319 | 0.005319 | 0.005319 |

| 23 | 0.070416 | 0.034926 | 0.025821 | 0.60646 | 0.43253 | 0.41227 | 0.19615 | 0.070133 | 0.022474 | 0.017786 | 0.034483 | 0.0054833 | 0.0054833 |

| 24 | 0.073444 | 0.036924 | 0.02404 | 0.45432 | 0.48939 | 0.38869 | 0.17959 | 0.075923 | 0.022032 | 0.016864 | 0.031642 | 0.0056418 | 0.0056418 |

| 25 | 0.07491 | 0.027147 | 0.026965 | 0.5134 | 0.49633 | 0.39608 | 0.20392 | 0.073932 | 0.021114 | 0.015936 | 0.028794 | 0.0057942 | 0.0057942 |

| 26 | 0.073574 | 0.032233 | 0.022391 | 0.47896 | 0.49867 | 0.40351 | 0.18379 | 0.071741 | 0.020273 | 0.015376 | 0.025941 | 0.0059408 | 0.0059408 |

| 27 | 0.066087 | 0.026038 | 0.022399 | 0.53908 | 0.52585 | 0.46392 | 0.24143 | 0.070024 | 0.020047 | 0.014552 | 0.023081 | 0.0060814 | 0.0060814 |

| 28 | 0.067538 | 0.029716 | 0.020895 | 0.53908 | 0.52585 | 0.46392 | 0.24143 | 0.070024 | 0.020047 | 0.014552 | 0.020216 | 0.0062161 | 0.0062161 |

| 29 | 0.067907 | 0.027077 | 0.023982 | 0.57991 | 0.54127 | 0.54094 | 0.28925 | 0.071234 | 0.018989 | 0.014011 | 0.017345 | 0.0063448 | 0.0063448 |

| 30 | 0.074032 | 0.027322 | 0.023408 | 0.59678 | 0.53444 | 0.5172 | 0.27999 | 0.080461 | 0.018092 | 0.013504 | 0.014468 | 0.0064676 | 0.0064676 |

| 31 | 0.077423 | 0.025216 | 0.022837 | 0.57733 | 0.569 | 0.57123 | 0.30604 | 0.074122 | 0.017398 | 0.013005 | 0.011584 | 0.0065844 | 0.0065844 |

| 32 | 0.068081 | 0.027872 | 0.024415 | 0.57733 | 0.569 | 0.57123 | 0.30604 | 0.074122 | 0.017398 | 0.013005 | 0.0086954 | 0.0066954 | 0.0066954 |

| 33 | 0.066399 | 0.027062 | 0.019377 | 0.6147 | 0.57131 | 0.6309 | 0.36617 | 0.072501 | 0.016576 | 0.012557 | 0.006733 | 0.006733 | 0.006733 |

| 34 | 0.064146 | 0.030654 | 0.018575 | 0.51272 | 0.63424 | 0.62166 | 0.38046 | 0.071372 | 0.017452 | 0.011975 | 0.006733 | 0.006733 | 0.006733 |

| 35 | 0.069845 | 0.031533 | 0.016869 | 0.4535 | 0.62545 | 0.43161 | 0.19661 | 0.079442 | 0.017964 | 0.011489 | 0.006634 | 0.006634 | 0.006634 |

| 36 | 0.07347 | 0.028788 | 0.018445 | 0.4535 | 0.62545 | 0.43161 | 0.19661 | 0.079442 | 0.017964 | 0.011489 | 0.006535 | 0.006535 | 0.006535 |

| 37 | 0.072893 | 0.025823 | 0.019031 | 0.46416 | 0.64489 | 0.56036 | 0.30361 | 0.077149 | 0.017278 | 0.011093 | 0.006436 | 0.006436 | 0.006436 |

| 38 | 0.074249 | 0.030124 | 0.016469 | 0.43548 | 0.6535 | 0.60979 | 0.32277 | 0.071095 | 0.016847 | 0.010756 | 0.006337 | 0.006337 | 0.006337 |

| 39 | 0.067215 | 0.031275 | 0.01778 | 0.42329 | 0.68563 | 0.59983 | 0.32912 | 0.071152 | 0.016041 | 0.010608 | 0.006238 | 0.006238 | 0.006238 |

| 40 | 0.074237 | 0.026014 | 0.018078 | 0.42329 | 0.68563 | 0.59983 | 0.32912 | 0.071152 | 0.016041 | 0.010608 | 0.006139 | 0.006139 | 0.006139 |

| 41 | 0.067051 | 0.027238 | 0.017875 | 0.44777 | 0.6622 | 0.62079 | 0.37878 | 0.063891 | 0.015774 | 0.010369 | 0.00604 | 0.00604 | 0.00604 |

| 42 | 0.066091 | 0.019703 | 0.019487 | 0.40682 | 0.66619 | 0.62027 | 0.35553 | 0.064764 | 0.015641 | 0.010095 | 0.005941 | 0.005941 | 0.005941 |

| 43 | 0.065018 | 0.02616 | 0.019013 | 0.37048 | 0.67893 | 0.60372 | 0.35897 | 0.061666 | 0.015468 | 0.0099145 | 0.005842 | 0.005842 | 0.005842 |

| 44 | 0.063783 | 0.02236 | 0.019386 | 0.37048 | 0.67893 | 0.60372 | 0.35897 | 0.061666 | 0.015468 | 0.0099145 | 0.005743 | 0.005743 | 0.005743 |

| 45 | 0.062465 | 0.024555 | 0.021721 | 0.48627 | 0.68265 | 0.63452 | 0.38601 | 0.059548 | 0.015197 | 0.0097055 | 0.005644 | 0.005644 | 0.005644 |

| 46 | 0.063303 | 0.025314 | 0.017046 | 0.51613 | 0.68511 | 0.65535 | 0.38001 | 0.06326 | 0.014959 | 0.0094237 | 0.005545 | 0.005545 | 0.005545 |

| 47 | 0.061278 | 0.026321 | 0.016091 | 0.5354 | 0.65253 | 0.61543 | 0.39677 | 0.069116 | 0.015039 | 0.009078 | 0.005446 | 0.005446 | 0.005446 |

| 48 | 0.060375 | 0.025796 | 0.013051 | 0.5354 | 0.65253 | 0.61543 | 0.39677 | 0.069116 | 0.015039 | 0.009078 | 0.005347 | 0.005347 | 0.005347 |

| 49 | 0.062624 | 0.024501 | 0.015242 | 0.60555 | 0.64322 | 0.7025 | 0.4417 | 0.063331 | 0.014483 | 0.0089962 | 0.005248 | 0.005248 | 0.005248 |

| 50 | 0.059173 | 0.026989 | 0.013133 | 0.58881 | 0.72561 | 0.70793 | 0.44616 | 0.069601 | 0.015409 | 0.0087293 | 0.005149 | 0.005149 | 0.005149 |

| 51 | 0.068282 | 0.022703 | 0.014708 | 0.55504 | 0.80794 | 0.76858 | 0.45522 | 0.059066 | 0.014242 | 0.0088518 | 0.00505 | 0.00505 | 0.00505 |

| 52 | 0.056198 | 0.021574 | 0.01774 | 0.55504 | 0.80794 | 0.76858 | 0.45522 | 0.059066 | 0.014242 | 0.0088518 | 0.004951 | 0.004951 | 0.004951 |

| 53 | 0.062854 | 0.025972 | 0.015321 | 0.6494 | 0.75116 | 0.81347 | 0.49659 | 0.056215 | 0.014285 | 0.0088638 | 0.004852 | 0.004852 | 0.004852 |

| 54 | 0.055535 | 0.020615 | 0.019888 | 0.53052 | 0.76854 | 0.74414 | 0.38338 | 0.055501 | 0.014419 | 0.0088026 | 0.004753 | 0.004753 | 0.004753 |

| 55 | 0.062703 | 0.022354 | 0.015584 | 0.70668 | 0.72746 | 0.80389 | 0.48158 | 0.049904 | 0.01433 | 0.0086304 | 0.004654 | 0.004654 | 0.004654 |

| 56 | 0.050799 | 0.024358 | 0.0174 | 0.70668 | 0.72746 | 0.80389 | 0.48158 | 0.049904 | 0.01433 | 0.0086304 | 0.004555 | 0.004555 | 0.004555 |

| 57 | 0.050793 | 0.023357 | 0.015585 | 0.64496 | 0.73683 | 0.80188 | 0.49922 | 0.048317 | 0.014311 | 0.0085001 | 0.004456 | 0.004456 | 0.004456 |

| 58 | 0.049967 | 0.030136 | 0.013972 | 0.57078 | 0.77222 | 0.75112 | 0.44532 | 0.052031 | 0.014533 | 0.0081923 | 0.004357 | 0.004357 | 0.004357 |

| 59 | 0.054492 | 0.027286 | 0.011904 | 0.68277 | 0.69081 | 0.78608 | 0.48051 | 0.051604 | 0.014505 | 0.0080633 | 0.004258 | 0.004258 | 0.004258 |

| 60 | 0.05492 | 0.033981 | 0.011256 | 0.68277 | 0.69081 | 0.78608 | 0.48051 | 0.051604 | 0.014505 | 0.0080633 | 0.004159 | 0.004159 | 0.004159 |

| 61 | 0.049166 | 0.019693 | 0.013192 | 0.6472 | 0.77416 | 0.81043 | 0.48583 | 0.047706 | 0.014461 | 0.0079913 | 0.00406 | 0.00406 | 0.00406 |

| 62 | 0.047687 | 0.021256 | 0.013094 | 0.6377 | 0.80493 | 0.80752 | 0.50535 | 0.049371 | 0.014843 | 0.0076105 | 0.003961 | 0.003961 | 0.003961 |

| 63 | 0.054949 | 0.025656 | 0.013873 | 0.55389 | 0.81637 | 0.83539 | 0.48351 | 0.047709 | 0.014371 | 0.0073928 | 0.003862 | 0.003862 | 0.003862 |

| 64 | 0.047754 | 0.025269 | 0.013463 | 0.55389 | 0.81637 | 0.83539 | 0.48351 | 0.047709 | 0.014371 | 0.0073928 | 0.003763 | 0.003763 | 0.003763 |

| 65 | 0.043924 | 0.023887 | 0.0116 | 0.67851 | 0.84044 | 0.88925 | 0.52677 | 0.045107 | 0.014083 | 0.0072219 | 0.003664 | 0.003664 | 0.003664 |

| 66 | 0.047061 | 0.023484 | 0.013043 | 0.64079 | 0.76791 | 0.8349 | 0.48222 | 0.051417 | 0.015042 | 0.0070877 | 0.003565 | 0.003565 | 0.003565 |

| 67 | 0.05251 | 0.026138 | 0.010952 | 0.7529 | 0.8087 | 0.92102 | 0.64458 | 0.041686 | 0.013767 | 0.0070284 | 0.003466 | 0.003466 | 0.003466 |

| 68 | 0.045216 | 0.023835 | 0.013298 | 0.7529 | 0.8087 | 0.92102 | 0.64458 | 0.041686 | 0.013767 | 0.0070284 | 0.003367 | 0.003367 | 0.003367 |

| 69 | 0.040478 | 0.023766 | 0.011171 | 0.77183 | 0.81979 | 0.92971 | 0.66643 | 0.041801 | 0.01357 | 0.0069671 | 0.003268 | 0.003268 | 0.003268 |

| 70 | 0.052163 | 0.023097 | 0.013481 | 0.7376 | 0.79372 | 0.90621 | 0.5233 | 0.045408 | 0.013392 | 0.0069202 | 0.003169 | 0.003169 | 0.003169 |

| 71 | 0.046673 | 0.021435 | 0.016221 | 0.78259 | 0.81307 | 0.92137 | 0.65409 | 0.039893 | 0.01293 | 0.0068422 | 0.00307 | 0.00307 | 0.00307 |

| 72 | 0.045714 | 0.024559 | 0.012998 | 0.78259 | 0.81307 | 0.92137 | 0.65409 | 0.039893 | 0.01293 | 0.0068422 | 0.002971 | 0.002971 | 0.002971 |

| 73 | 0.044098 | 0.020013 | 0.013674 | 0.79811 | 0.80966 | 0.91776 | 0.6386 | 0.042118 | 0.013077 | 0.0068104 | 0.002872 | 0.002872 | 0.002872 |

| 74 | 0.045096 | 0.023927 | 0.011444 | 0.65041 | 0.96791 | 0.89071 | 0.58924 | 0.042157 | 0.013026 | 0.0067435 | 0.002773 | 0.002773 | 0.002773 |

| 75 | 0.045549 | 0.023675 | 0.012262 | 0.65478 | 0.97409 | 0.91227 | 0.61153 | 0.041356 | 0.013289 | 0.0066727 | 0.002674 | 0.002674 | 0.002674 |

| 76 | 0.038089 | 0.022027 | 0.012737 | 0.65478 | 0.97409 | 0.91227 | 0.61153 | 0.041356 | 0.013289 | 0.0066727 | 0.002575 | 0.002575 | 0.002575 |

| 77 | 0.043355 | 0.022965 | 0.013188 | 0.65725 | 0.96786 | 0.90953 | 0.60484 | 0.040344 | 0.013215 | 0.0066158 | 0.002476 | 0.002476 | 0.002476 |

| 78 | 0.040923 | 0.020855 | 0.01271 | 0.66526 | 0.95715 | 0.88192 | 0.57699 | 0.041936 | 0.013002 | 0.0065406 | 0.002377 | 0.002377 | 0.002377 |

| 79 | 0.044237 | 0.023389 | 0.011025 | 0.73397 | 0.94515 | 0.92446 | 0.66212 | 0.038324 | 0.012906 | 0.0064858 | 0.002278 | 0.002278 | 0.002278 |

| 80 | 0.039139 | 0.019602 | 0.013445 | 0.73397 | 0.94515 | 0.92446 | 0.66212 | 0.038324 | 0.012906 | 0.0064858 | 0.002179 | 0.002179 | 0.002179 |

| 81 | 0.039778 | 0.020843 | 0.010079 | 0.74547 | 0.93265 | 0.92521 | 0.67382 | 0.036814 | 0.012893 | 0.0064391 | 0.00208 | 0.00208 | 0.00208 |

| 82 | 0.03787 | 0.025493 | 0.0092306 | 0.74887 | 0.94095 | 0.92593 | 0.6275 | 0.034978 | 0.012647 | 0.0063524 | 0.001981 | 0.001981 | 0.001981 |

| 83 | 0.036213 | 0.025583 | 0.011687 | 0.77772 | 0.92649 | 0.92946 | 0.69429 | 0.033738 | 0.012632 | 0.0062845 | 0.001882 | 0.001882 | 0.001882 |

| 84 | 0.042275 | 0.027451 | 0.011355 | 0.77772 | 0.92649 | 0.92946 | 0.69429 | 0.033738 | 0.012632 | 0.0062845 | 0.001783 | 0.001783 | 0.001783 |

| 85 | 0.04055 | 0.024409 | 0.011893 | 0.76147 | 0.92424 | 0.92892 | 0.70233 | 0.033598 | 0.012701 | 0.0062196 | 0.001684 | 0.001684 | 0.001684 |

| 86 | 0.037115 | 0.026761 | 0.012531 | 0.75421 | 0.93251 | 0.92856 | 0.69335 | 0.033488 | 0.012603 | 0.0061444 | 0.001585 | 0.001585 | 0.001585 |

| 87 | 0.039802 | 0.026821 | 0.011184 | 0.76595 | 0.93997 | 0.93513 | 0.70838 | 0.03272 | 0.012684 | 0.0060751 | 0.001486 | 0.001486 | 0.001486 |

| 88 | 0.042453 | 0.021794 | 0.013027 | 0.76595 | 0.93997 | 0.93513 | 0.70838 | 0.03272 | 0.012684 | 0.0060751 | 0.001387 | 0.001387 | 0.001387 |

| 89 | 0.037363 | 0.021278 | 0.010984 | 0.77377 | 0.94032 | 0.93533 | 0.67413 | 0.03229 | 0.012609 | 0.0060058 | 0.001288 | 0.001288 | 0.001288 |

| 90 | 0.034418 | 0.02564 | 0.0084658 | 0.77135 | 0.94492 | 0.92678 | 0.68011 | 0.032636 | 0.012694 | 0.0059476 | 0.001189 | 0.001189 | 0.001189 |

| 91 | 0.036829 | 0.019619 | 0.012182 | 0.76728 | 0.94633 | 0.93454 | 0.68204 | 0.031226 | 0.012658 | 0.0058628 | 0.00109 | 0.00109 | 0.00109 |

| 92 | 0.03765 | 0.022224 | 0.012277 | 0.76728 | 0.94633 | 0.93454 | 0.68204 | 0.031226 | 0.012658 | 0.0058628 | 0.000991 | 0.000991 | 0.000991 |

| 93 | 0.038075 | 0.023386 | 0.010426 | 0.78724 | 0.95111 | 0.93807 | 0.68684 | 0.030846 | 0.012685 | 0.0058153 | 0.000892 | 0.000892 | 0.000892 |

| 94 | 0.034119 | 0.02364 | 0.0094436 | 0.78739 | 0.94689 | 0.9404 | 0.70102 | 0.031092 | 0.012751 | 0.0057656 | 0.000793 | 0.000793 | 0.000793 |

| 95 | 0.035869 | 0.019692 | 0.010439 | 0.76219 | 0.9221 | 0.93382 | 0.70147 | 0.030162 | 0.012575 | 0.0057276 | 0.000694 | 0.000694 | 0.000694 |

| 96 | 0.036403 | 0.022168 | 0.011782 | 0.76219 | 0.9221 | 0.93382 | 0.70147 | 0.030162 | 0.012575 | 0.0057276 | 0.000595 | 0.000595 | 0.000595 |

| 97 | 0.035108 | 0.023123 | 0.012981 | 0.76522 | 0.91965 | 0.93296 | 0.70291 | 0.030147 | 0.012534 | 0.005701 | 0.000496 | 0.000496 | 0.000496 |

| 98 | 0.036187 | 0.02151 | 0.011854 | 0.76256 | 0.91824 | 0.93294 | 0.70424 | 0.03018 | 0.012517 | 0.0056739 | 0.000397 | 0.000397 | 0.000397 |

| 99 | 0.035997 | 0.023463 | 0.0098816 | 0.76249 | 0.91764 | 0.93402 | 0.69939 | 0.029954 | 0.012428 | 0.0056608 | 0.000298 | 0.000298 | 0.000298 |

模型在验证集上的mAP以及损失函数的表现会作为衡量模型性能好坏的主要依据。而学习率则是调整模型训练过程的关键参数。

使用训练好的参数进行进项预测处理数据

用训练集数据验证的结果

| 0.76249 | 0.91764 | 0.93402 | 0.69939 | 0.029954 | 0.012428 | 0.0056608 | 0.000298 | 0.000298 | 0.000298 |

模型在验证集上的mAP以及损失函数的表现会作为衡量模型性能好坏的主要依据。而学习率则是调整模型训练过程的关键参数。

使用训练好的参数进行进项预测处理数据

使用自己的权重文件预测

用训练集数据验证的结果