计算机视觉的应用23-OpenAI发布的文本生成视频大模型Sora的原理解密

大家好,我是微学AI,今天给大家介绍一下计算机视觉的应用23-OpenAI发布的文本生成视频大模型Sora的原理解密。本文概况性地将Sora模型生成视频主要分为三个步骤:视频压缩网络、空间时间潜在补丁提取以及视频生成的Transformer模型。

文章目录

- 一、Sora模型的发布

- 二、Sora模型生成视频的原理

-

- 文本提示生成内容

- 空间时间补丁

- 视频生成过程

-

- 步骤1:视频压缩网络

- 步骤2:空间时间潜在补丁提取

- 步骤3:视频生成的Transformer模型

- 三、Sora模型技术特点与创新点

-

- Sora支持多种视频格式

- Sora改进的视频构图和框架

- 语言理解与视频生成

- 多模态输入处理

一、Sora模型的发布

Sora模型是OpenAI发布的人工智能文生视频大模型(但OpenAI并未单纯将其视为视频模型,而是叫做“世界模拟器” ),Sora模型于2024年2月15日(美国当地时间)正式对外发布。

Sora模型实现了输入文本生成高质量的视频功能,Sora对于需要制作视频的艺术家、电影制片人或学生带来无限可能,再一次的震撼到我们。

对于我们这些普通人如何了解Sora呢?我们可以想象一下,你在浏览一本展示世界各地名胜的图片集,里面收录了来自不同国家的风景照片。有的展示了一望无际的海景,有的呈现了狭窄的小巷,还有的描绘了夜晚灯火辉煌的城市景观。尽管这些照片在内容和风格上各有千秋,但你能够轻而易举地识别每一张照片所代表的地点和情感,因为你的大脑能够将这些不同的视觉信息整合并理解。

与此类似,Sora面对的挑战在于处理和分析来自全球各地、由不同设备拍摄的数以百万计的图片和视频。这些视觉数据在分辨率、宽高比、色彩深度等方面存在差异。为了使Sora能够像人类大脑那样理解和生成如此丰富的视觉内容,OpenAI开发了一套方法,将这些不同类型的视觉数据转换为统一的表示形式。

二、Sora模型生成视频的原理

首先,Sora利用一种称为“视频压缩网络”的技术,将输入的图像或视频数据转换成一个更简洁的、低维度的表达方式。这个过程类似于将不同尺寸和分辨率的图片进行“标准化”,以便于进行后续的处理和存储。这种转换并不是要摒弃原始数据的特点,而是将其转换成一种对Sora来说更易于理解和操作的形态。

然后,Sora将这些压缩过的数据进一步细分为所谓的“空间时间补丁”(Spacetime Patches),这些补丁可以被视作视觉内容的基本单元,就像我们之前提到的相册中的每一张照片都可以被拆分成包含独特景观、颜色和纹理的小块。这样,无论原始视频的长度、分辨率或风格如何,Sora都能将它们转化为一种一致的格式。

通过这种方式,Sora能够在保持原始视觉信息多样性的同时,将来自不同来源和风格的视觉数据整合成一种统一的内部表达形式。这就像你在翻阅世界名胜相册时,尽管照片各不相同,但你依然能够以相同的方式去理解和欣赏它们。

文本提示生成内容

Sora是如何根据文本提示生成内容的。这个过程主要依赖于一种称为“文本条件化的Diffusion模型”的技术。为了解释这个技术的运作原理,我们可以用一个日常生活的例子来说明:设想你手中有一本充满随意涂鸦的草图本,起初,本子上满是随机的墨迹,看起来毫无意义。但如果你按照一个特定的主题,比如“花园”,逐渐地去修改和细化这些墨迹,最终,这些杂乱的线条将逐渐演变成一幅描绘花园的美丽画面。在这个例子中,你的“特定主题”就是文本提示,而你逐步改善草图本的过程,就类似于Diffusion模型的工作机制。

具体到Sora的应用,这个过程始于一段与目标视频长度相同但内容完全是随机噪声的视频,可以将其想象成草图本上的那些无意义的墨迹。然后,Sora根据给定的文本提示(例如“一只猫坐在窗台上看日落”)开始“编辑”这段视频。在这个过程中,Sora利用了从大量视频和图片数据中学习到的知识,以决定如何逐步消除噪声,将这段噪声视频转变为接近文本描述的内容。

这个“编辑”过程是通过数百个连续的步骤逐渐完成,每一步都使得视频更接近最终的目标。这种方法的一个显著优势在于其灵活性和创新性:即使是相同的文本提示,通过不同的初始噪声状态或者在转换步骤中进行微调,也能够产生视觉上各具特色、但都与文本提示相契合的视频内容。这就像是多位艺术家根据同一主题创作出风格迥异的画作。

利用这种基于文本条件的Diffusion模型,Sora不仅能够创造出具有极高创意性的视频和图像,还能够确保所生成的内容与用户的文本提示高度吻合。无论是重现真实场景还是构建幻想世界,Sora都能够根据文本提示“绘制”出令人惊叹的视觉作品。

空间时间补丁

空间时间补丁:我们可以理解为将视频或图片分解成许多小块或“补丁”,每个小块都携带着一定的时间和空间信息。这种方法的灵感来自于处理静态图片的技术,其中图片被分割成小块以便更高效地进行分析。在视频处理的背景下,这个概念被扩展到了时间维度上,不仅涉及空间(即图片的特定区域),还包括这些区域随时间的变化。

为了让大家更好地理解空间时间补丁是如何运作的,我们可以用一个简单的日常例子来说明:想象你在观看一部动画片。如果我们把这部电影切割成单帧的静态画面,并且把这些画面进一步分割成更小的区块(即“补丁”),那么每个小区块都会含有画面的一部分信息。随着时间的前进,这些小区域的信息会随着角色动作或场景转换而改变,这样就加入了时间维度上的动态内容。在Sora中,这样的“空间时间补丁”使得模型能够更精确地处理视频内容的每一个小部分,并且同时考虑到它们随时间的变化。

在Sora处理视觉内容的流程中,空间时间补丁最初是通过视频压缩网络生成的。这个网络的任务是将原始视频数据转换成更低的维度表示,也就是由众多小块组成的密集网络。这些小块就是我们所称的“补丁”,每个补丁都携带着视频的一部分空间和时间信息。

生成这些空间时间补丁之后,Sora便可以开始它们的转换过程。利用已经预先训练好的转换器(Transformer模型),Sora能够分析每个补丁的内容,并根据输入的文本提示进行必要的调整。例如,如果文本提示是“海边奔跑的马儿”,Sora将定位到与“海边”和“奔跑的马儿”相关的补丁,并对它们进行相应的修改,以创造出与文本提示相符的视频内容。

这种基于空间时间补丁的处理手段具有几个明显的优点。首先,它使Sora能够以非常细致的粒度操作视频内容,因为它可以独立处理视频中的每一个小部分。其次,这种方法极大地增强了处理视频的灵活性,让Sora能够生成具有复杂动态的高质量视频,这对于传统的视频生成技术来说是一项艰巨的任务。此外,通过对这些补丁进行有效的管理和转换,Sora能够在保持视频内容连贯性的同时,制作出多种多样的视觉效果,满足用户的多样化需求。

视频生成过程

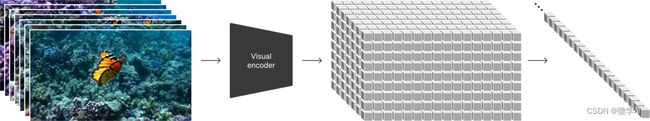

我们将Sora在视频生成过程分成三个步骤:视频压缩网络、空间时间潜在补丁提取以及视频生成的Transformer模型。

步骤1:视频压缩网络

想象一下,你正在整理一间混乱的房间,你的目标是以最少的盒子来收拾所有的物品,并且保证以后能够迅速找到需要的物品。在这个过程中,你可能会把小物品放入小盒子,然后再把这些小盒子放入更大的箱子。这样,你就能够用更少、更有条理的空间来存放同样数量的物品。视频压缩网络的工作原理与此类似。它将视频内容“整理”成一个更加紧凑、高效的形式(即降低维度)。这样,Sora在处理视频时能够更加高效,也能够保留足够的信息来重建原始视频。

步骤2:空间时间潜在补丁提取

继续上面的比喻,如果你想详细记录每个盒子里放置了哪些物品,你可能会为每个盒子制作一个清单。这样,当你需要找到某个特定的物品时,只需要查阅相应的清单,就能迅速知道它存放在哪个盒子里。在Sora的处理过程中,与之类似的“清单”就是空间时间潜在补丁。通过视频压缩网络的处理,Sora将视频分割成许多小块,每个小块都包含了视频中的一小部分空间和时间信息,这就像是视频内容的详细“清单”。这样的处理使得Sora能够在后续的步骤中精确地处理视频的每一个部分。

步骤3:视频生成的Transformer模型

最后,想象你和朋友们一起玩一个特殊的拼图游戏,这个游戏的规则就是根据一个故事来拼出一幅完整的画面。你们首先将故事分成了几个部分,每个人负责一部分。接着,你们根据自己负责的那部分故事内容选择或者绘制出相应的拼图碎片。最后,你们将各自的拼图碎片拼接在一起,形成了一幅完整的图像,展现了整个故事的内容。在Sora生成视频的过程中,Transformer模型就扮演了这样的角色。它接收空间时间潜在补丁(即视频内容的“拼图片”)和文本提示(即“故事”),然后决定如何调整或组合这些拼图碎片以创造出最终的视频,从而呈现出文本提示中的故事情节。

三、Sora模型技术特点与创新点

Sora支持多种视频格式

Sora模型对多种视频格式的强大兼容性。比如说,不管是宽屏的1920x1080p视频、垂直的1080x1920视频,还是其他任何比例的视频,Sora都能够轻松处理。这种兼容性使得Sora能够直接为不同设备生成相应比例的内容,满足各种不同的观看需求。此外,Sora还能够先在低分辨率下快速制作内容原型,然后再以全分辨率生成最终产品,这一切都可以在同一个模型内完成。这样的特性不仅增强了内容创作的灵活性,而且极大地简化了视频内容的制作过程。

Sora改进的视频构图和框架

Sora模型在视频构图和画面框架方面也有了显著的提升。由于模型是在原始比例上进行训练的,Sora能够更精准地理解和设计视频的构图和框架。与那些将所有训练视频裁剪成方形格式的模型不同,Sora能够更有效地保持视频主题的完整性。例如,在处理宽屏视频时,Sora能够确保主要的内容始终位于观众的视野中心,而不是像其他模型那样只展示主题的一部分。这样的能力不仅增强了生成视频的视觉品质,也优化了观众的观看体验。

语言理解与视频生成

Sora对文本的深入理解是其一项显著特性。借助先进的文本转化为词向量的技术,能够精确解读用户的文本指令,并基于这些指令创造出充满细节和情感的角色以及栩栩如生的场景。这种功能使得从简短的文本提示到复杂视频内容的转变更加顺畅和自然,无论是复杂的动作序列还是微妙情感的表现,Sora都能够精准把握并呈现出来。

多模态输入处理

Sora还能够接收静态图像或现有视频作为输入,进行内容的扩展、填充缺失的帧或进行风格转换等任务。这种多功能性极大地拓宽了Sora的应用领域,它不仅能够用于从头开始创作视频内容,还能够用于对现有内容的二次加工,为用户提供了更多的创作灵活性和想象空间。