摘要

我们报告了 GPT-4 的开发,这是一个大规模、多模态的模型,可以接受图像和文本输入,并生成文本输出。虽然在许多现实场景中不如人类,但 GPT-4 在各种专业和学术基准测试中表现出与人类水平相当的性能,包括在模拟的律师资格考试中取得了约前10%的考生得分。

GPT-4 是基于 Transformer 架构的模型,经过预训练以预测文档中的下一个标记。后训练对齐过程导致在事实性和符合所需行为方面的性能得到改善。该项目的核心组成部分是开发基础设施和优化方法,这些方法在各种规模上都能可预测地运行。

这使我们能够根据使用的计算资源不超过 GPT-4 1/1,000 的模型准确预测 GPT-4 的某些性能方面。

1. 介绍

本技术报告介绍了 GPT-4,这是一个大型多模态模型,能够处理图像和文本输入,并生成文本输出。这类模型是研究的重要领域,因为它们有潜力在各种应用中使用,例如对话系统、文本摘要和机器翻译。因此,近年来它们受到了广泛关注和进展(Brown 等,2020年;Hoffmann 等,2022年;Chowdhery 等,2022年;Rae 等,2021年;Dai 等,2019年;Liu 等,2019年;Devlin 等,2018年;Raffel 等,2019年;Shazeer 和 Stern,2018年;Ba 等,2016年;Wei 等,2022a年;Huang 等,2022年;Kojima 等,2022年;Kaplan 等,2020年;Henighan 等,2020年;Yang 等,2022年;Shazeer 等,2017年;Zoph 等,2022年;Wei 等,2022b年;Dehghani 等,2019年;Su 等,2021年;Alayrac 等;Chen 等,2022a年;Wang 和 Komatsuzaki,2021年;Black 等,2021年;Scao 等,2022年;Zhang 等,2022年;Touvron 等,2023年;Radford 等,2017年;Lample 和 Conneau,2019年;Dao 等,2022年;Child 等,2019年;Rabe 和 Staats,2021年;Gray 等,2017年)。

开发这类模型的主要目标之一是提高它们理解和生成自然语言文本的能力,特别是在更复杂和微妙的情景中。为了测试其在这种情景下的能力,GPT-4 在多个原本设计用于人类的考试上进行了评估。在这些评估中,它表现相当出色,并经常超过绝大多数人类考生。例如,在模拟的律师资格考试中,GPT-4 获得了高达前10%的考生得分。这与 GPT-3.5 相比形成了鲜明对比,后者在前10%考生中得分偏低。

在一系列传统的自然语言处理基准测试中,GPT-4 的表现超越了先前的大型语言模型和大多数最先进的系统(这些系统通常具有特定基准测试的训练或手工工程)。在 MMLU 基准测试(Hendrycks 等,2021a, b)上,这是一个涵盖了57个科目的英语多项选择题套件,在英语方面,GPT-4 不仅在现有模型中大幅领先,还在其他语言上表现出色。在 MMLU 的翻译变体中,GPT-4 在考虑的26种语言中有24种超过了英语的最新水平。我们将在后面的章节中更详细地讨论这些模型能力结果以及模型安全性改进和结果。

本报告还讨论了项目的一个关键挑战,即开发深度学习基础设施和优化方法,以便在各种规模上都能可预测地运行。这使我们能够根据以类似方式进行训练的小规模运行的预测来测试预期的 GPT-4 性能,以增加我们的训练信心。

尽管具备能力,但 GPT-4 与先前的 GPT 模型(Brown 等,2020年;Radford 等,2019年,2018年)具有相似的局限性:它不是完全可靠的(例如可能遭受“幻觉”),具有有限的上下文窗口,并且不从经验中学习。在使用 GPT-4 的输出时应当注意,特别是在可靠性重要的情境中。

GPT-4 的能力和局限性带来了重大而新颖的安全挑战,我们认为仔细研究这些挑战是一个重要的研究领域,考虑到其潜在的社会影响。本报告包括一个广泛的系统卡(见附录后),描述了我们预见的关于偏见、虚假信息、过度依赖、隐私、网络安全、扩散等风险。它还描述了我们采取的干预措施,以减轻部署 GPT-4 带来的潜在危害,包括与领域专家进行的对抗测试和模型辅助的安全管道。

2. 本技术报告的范围和限制

本报告侧重于 GPT-4 的能力、局限性和安全性质。

GPT-4 是一种 Transformer 风格的模型(Vaswani 等,2017年),经过预训练以预测文档中的下一个标记,使用了公开可用的数据(如互联网数据)和从第三方提供商获得的数据进行许可。然后,使用人类反馈的强化学习(RLHF)(Christiano 等,2017年)对模型进行了微调。

考虑到竞争格局和诸如 GPT-4 这样的大规模模型的安全影响,本报告不包含有关架构(包括模型大小)、硬件、训练计算、数据集构建、训练方法或类似内容的进一步细节。

我们致力于对我们的技术进行独立审计,并在此次发布的系统卡中分享了一些初步步骤和想法。我们计划向其他第三方提供进一步的技术细节,以便他们可以就如何权衡上述竞争和安全考虑与进一步透明度的科学价值向我们提供建议。

3可预测的扩展

GPT-4 项目的一个主要焦点是构建一个可预测扩展的深度学习堆栈。主要原因是对于像 GPT-4 这样的非常大规模的训练运行,进行广泛的模型特定调整是不可行的。为了解决这个问题,我们开发了在多个规模上具有非常可预测行为的基础设施和优化方法。这些改进使我们能够可靠地从使用的计算资源比 GPT-4 小 1,000× - 10,000× 的较小模型中预测出 GPT-4 的某些性能方面。

3.1 损失预测 Loss Prediction

据认为,适当训练的大型语言模型的最终损失可以很好地近似为训练模型所使用的计算量的幂律关系(Hestness 等,2017年;Thompson 等,2020年;Hoffmann 等,2022年;Kaplan 等,2020年;Henighan 等,2020年)。

为了验证我们优化基础设施的可扩展性,我们通过拟合带有不可约损失项的缩放定律(如 Henighan 等(2020年))来预测在我们的内部代码库上(不包括在训练集中)的 GPT-4 的最终损失:L(C) = aC^b + c,其中使用了相同方法进行训练的模型,但使用的计算资源最多比 GPT-4 少 10,000×。这个预测是在运行开始后不久进行的,没有使用任何部分结果。拟合的缩放定律高度准确地预测了 GPT-4 的最终损失(图1)。

图1:GPT-4 和较小模型的性能。度量标准是从我们的内部代码库衍生的数据集上的最终损失。这是一个方便的大型代码标记数据集,不包含在训练集中。我们选择关注损失,因为它在不同数量的训练计算上通常比其他指标更少噪音。对较小模型(不包括 GPT-4)进行的幂律拟合显示为虚线;该拟合准确地预测了 GPT-4 的最终损失。x 轴是训练计算的归一化,使得 GPT-4 为 1。

3.2 在 HumanEval 数据集上的能力扩展

在训练模型之前了解模型的能力可以提高对齐、安全性和部署方面的决策。

除了预测最终损失之外,我们还开发了一种方法来预测更可解释的能力指标。其中一种指标是在 HumanEval 数据集(Chen 等,2021年)上的通过率,该数据集衡量了合成不同复杂度 Python 函数的能力。我们成功地通过从使用最多 1,000× 较少计算资源训练的模型进行外推,预测了 HumanEval 数据集的一个子集上的通过率(图2)。

图2:GPT-4 和较小模型的性能。度量标准是 HumanEval 数据集的一个子集上的平均对数通过率。对较小模型(不包括 GPT-4)进行的幂律拟合显示为虚线;该拟合准确地预测了 GPT-4 的性能。x 轴是训练计算的归一化,使得 GPT-4 为 1。

在 HumanEval 中的一个个体问题上,性能可能会随规模的增加而偶尔下降。尽管存在这些挑战,但我们发现一个近似的幂律关系 −E[log(pass_rate(C))] = α * C^(-β),其中 α 和 β 是正常数,而 C 是数据集中的问题的一个子集。我们假设这种关系适用于数据集中的所有问题。在实践中,非常低的通过率很难或不可能估计,因此我们限制在问题 P 和模型 M 上,以便在给定一些大样本预算的情况下,每个模型至少解决每个问题一次。

我们在训练完成之前,仅使用训练前可用的信息,为 GPT-4 在 HumanEval 上的性能进行了预测。除了最困难的 15 个 HumanEval 问题之外,其他问题都根据较小模型的表现被分成了 6 个难度桶。图 2 显示了第 3 个最容易桶上的结果,显示了在我们可以准确估计多个较小模型的 log(pass_rate) 的 HumanEval 子集中,所得到的预测非常准确的情况。对其他五个桶的预测几乎同样好,主要例外是 GPT-4 在最容易的桶上表现不及我们的预测。

某些能力仍然很难预测。例如,Inverse Scaling Prize(McKenzie 等,2022a年)提出了几个任务,其中模型的性能随着规模的增加而降低。与 Wei 等(2022c年)最近的一个结果类似,我们发现 GPT-4 扭转了这种趋势,如图 3 中称为 Hindsight Neglect(McKenzie 等,2022b年)的任务所示。

图3:GPT-4 和较小模型在 Hindsight Neglect 任务上的性能。准确率显示在 y 轴上,数值越高越好。ada、babbage 和 curie 是通过 OpenAI API(Brockman 等,2020年)可用的模型。

我们认为准确预测未来的能力对安全至关重要。在未来,我们计划完善这些方法,并在大型模型训练开始之前注册各种能力的性能预测,我们希望这成为该领域的共同目标。

4 能力 Capabilities

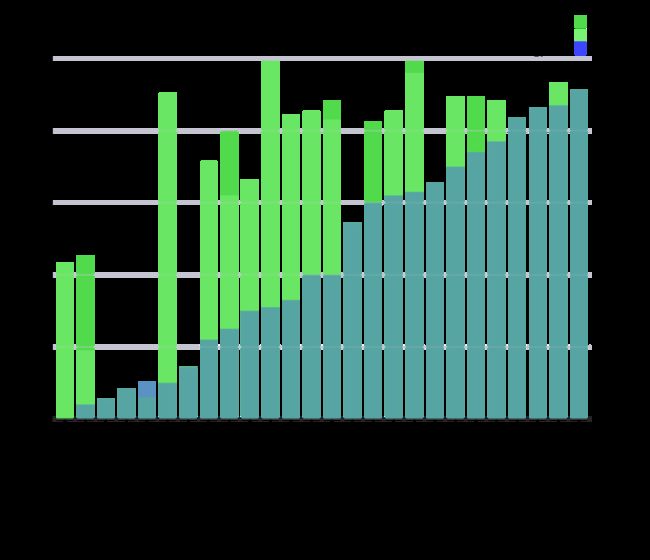

图4:GPT 在学术和专业考试中的表现。在每种情况下,我们模拟真实考试的条件和评分。考试根据 GPT-3.5 的表现从低到高排序。GPT-4 在大多数测试的考试中表现优于 GPT-3.5。为了保守起见,我们报告了百分位数范围的下限,但这在具有非常宽广评分区间的 AP 考试中会产生一些人为的影响。例如,尽管 GPT-4 在 AP 生物学考试中获得了最高可能的分数(5/5),但在图中仅显示为第85百分位数,因为有15%的考生达到了该分数。

- 表1

| 考试 | GPT-4 | GPT-4 (无视觉) | GPT-3.5 |

|---|---|---|---|

| 统一律师考试(MBE+MEE+MPT) | 298 / 400 (~90th) | 298 / 400 (~90th) | 213 / 400 (~10th) |

| LSAT | 163 (~88th) | 161 (~83rd) | 149 (~40th) |

| SAT 阅读与写作 | 710 / 800 (~93rd) | 710 / 800 (~93rd) | 670 / 800 (~87th) |

| SAT 数学 | 700 / 800 (~89th) | 690 / 800 (~89th) | 590 / 800 (~70th) |

| 研究生入学考试(GRE)定量 | 163 / 170 (~80th) | 157 / 170 (~62nd) | 147 / 170 (~25th) |

| 研究生入学考试(GRE)口语 | 169 / 170 (~99th) | 165 / 170 (~96th) | 154 / 170 (~63rd) |

| 研究生入学考试(GRE)写作 | 4 / 6 (~54th) | 4 / 6 (~54th) | 4 / 6 (~54th) |

| USABO 半决赛考试 2020 | 87 / 150 (99th - 100th) | 87 / 150 (99th - 100th) | 43 / 150 (31st - 33rd) |

| USNCO 地方段考试 2022 | 36 / 60 | 38 / 60 | 24 / 60 |

| 医学知识自我评估计划 | 75 % | 75 % | 53 % |

| Codeforces 评级 | 392 (低于第5位) | 392 (低于第5位) | 260 (低于第5位) |

| AP 艺术史 | 5 (86th - 100th) | 5 (86th - 100th) | 5 (86th - 100th) |

| AP 生物学 | 5 (85th - 100th) | 5 (85th - 100th) | 4 (62nd - 85th) |

| AP 微积分 BC | 4 (43rd - 59th) | 4 (43rd - 59th) | 1 (0th - 7th) |

| AP 化学 | 4 (71st - 88th) | 4 (71st - 88th) | 2 (22nd - 46th) |

| AP 英语语言和写作 | 2 (14th - 44th) | 2 (14th - 44th) | 2 (14th - 44th) |

| AP 英语文学和写作 | 2 (8th - 22nd) | 2 (8th - 22nd) | 2 (8th - 22nd) |

| AP 环境科学 | 5 (91st - 100th) | 5 (91st - 100th) | 5 (91st - 100th) |

| AP 宏观经济学 | 5 (84th - 100th) | 5 (84th - 100th) | 2 (33rd - 48th) |

| AP 微观经济学 | 5 (82nd - 100th) | 4 (60th - 82nd) | 4 (60th - 82nd) |

| AP 物理学 2 | 4 (66th - 84th) | 4 (66th - 84th) | 3 (30th - 66th) |

| AP 心理学 | 5 (83rd - 100th) | 5 (83rd - 100th) | 5 (83rd - 100th) |

| AP 统计学 | 5 (85th - 100th) | 5 (85th - 100th) | 3 (40th - 63rd) |

| AP 美国政府 | 5 (88th - 100th) | 5 (88th - 100th) | 4 (77th - 88th) |

表1:GPT 在学术和专业考试中的表现。在每种情况下,我们模拟真实考试的条件和评分。我们报告了根据考试特定评分标准对 GPT-4 的最终得分,并报告了达到 GPT-4 得分的考生百分位数。

我们在各种基准测试中对GPT-4进行了测试,包括模拟最初设计供人类参加的考试。我们对这些考试没有进行特定的训练。模型在训练期间只看到了少数考试中的问题;对于每个考试,我们运行了一个变体,去除了这些问题,并报告了两者中较低的分数。我们相信结果具有代表性。有关污染情况的更多细节(方法和每个考试的统计数据),请参阅附录C。

考试来源于公开可用的资料。考试问题包括多项选择题和自由回答题;我们为每种格式设计了单独的提示,并在需要时将图像包含在问题的输入中。评估设置是根据验证考试集的性能设计的,并且我们报告了在保留的测试考试上的最终结果。总体分数是通过使用每个考试的公开可用方法组合多项选择和自由回答问题的分数来确定的。我们估计并报告了每个总体分数对应的百分位数。有关考试评估方法的更多详细信息,请参见附录A。

GPT-4在大多数专业和学术考试中表现出人类水平的性能。值得注意的是,它在模拟的统一律师考试中的得分位于前10%的考生中(表1,图4)。

模型在考试中的能力主要来源于预训练过程,并且并不受RLHF的显著影响。在我们测试的所有考试中,基本的GPT-4模型和RLHF模型在平均情况下都表现出相同的多项选择题答题能力(请参见附录B)。

我们还对预训练的基本GPT-4模型在传统的用于评估语言模型的基准测试中进行了评估。对于我们报告的每个基准测试,我们都对出现在训练集中的测试数据进行了污染检查(有关每个基准测试的污染情况的完整详情,请参见附录D)。在评估GPT-4时,我们对所有基准测试都使用了少样本提示(Brown等,2020)。

GPT-4在很大程度上优于现有的语言模型,以及先前的最先进(SOTA)系统,这些系统通常具有特定于基准测试的精心设计或额外的训练协议(表2)。

- 表2

| 评估指标 | GPT-4 | GPT-3.5 | 语言模型最先进(SOTA) | 最先进模型 |

|---|---|---|---|---|

| MMLU Hendrycks et al. (2020) | 86.4% | 70.0% | 70.7% | 75.2% |

| HellaSwag Zellers et al. (2019) | 95.3% | 85.5% | 84.2% | 85.6% |

| AI2 Reasoning Challenge (ARC) Clark et al. (2018) | 96.3% | 85.2% | 85.2% | 86.5% |

| WinoGrande Sakaguchi et al. (2019) | 87.5% | 81.6% | 85.1% | 85.1% |

| HumanEval (Chen et al., 2021) | 67.0% | 48.1% | 26.2% | 65.8% |

| DROP Dua et al. (2019) (F1 score) | 80.9 | 64.1 | 70.8 | 88.4 |

| GSM-8K Cobbe et al. (2021) | 92.0% | *57.1% | 58.8% | 87.3% |

表2:GPT-4在学术基准测试上的表现。我们将GPT-4与最佳SOTA(具有特定基准训练)和最佳的用于少量样本评估的LM进行比较。GPT-4在所有基准测试中均表现优异,并且在除了DROP数据集以外的所有数据集上均击败了具有基准特定训练的SOTA。对于每个任务,我们报告了GPT-4的性能以及用于评估的少量样本方法。对于GSM-8K,我们在GPT-4的预训练混合中包含了部分训练集(见附录E),并且在评估时使用了链式思维提示(Wei等人,2022a)。对于多项选择题,我们向模型呈现所有答案(ABCD)并要求其选择答案的字母,类似于人类解决此类问题的方式。

许多现有的机器学习基准测试都是用英语编写的。为了初步了解GPT-4在其他语言中的能力,我们使用Azure Translate将MMLU基准测试(Hendrycks等人,2021a,b)——一个涵盖了57个学科的一套多项选择问题——翻译成了多种语言(请参阅附录F以获取示例翻译和提示)。

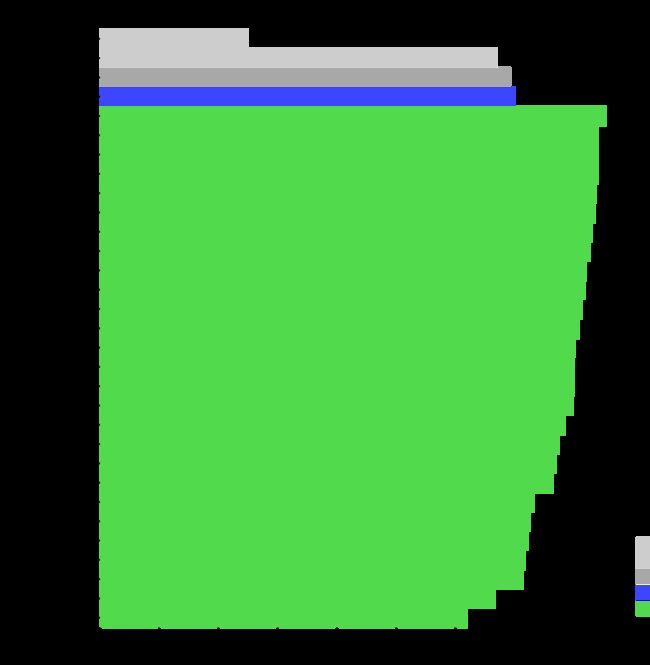

我们发现,在我们测试的大多数语言中,包括拉脱维亚语、威尔士语和斯瓦希里语等资源稀缺语言,GPT-4的表现优于GPT 3.5和现有的语言模型(如Chinchilla(Hoffmann等人,2022)和PaLM(Chowdhery等人,2022))的英语表现(图5)。

图5:GPT-4在多种语言上的表现与英语上先前模型在MMLU上的比较。对于绝大多数经过测试的语言,包括拉脱维亚语、威尔士语和斯瓦希里语等资源稀缺语言,GPT-4的表现优于现有语言模型(Hoffmann等人,2022;Chowdhery等人,2022)的英语表现。

GPT-4在跟随用户意图方面显著改进了先前模型的能力(Ouyang等人,2022)。在提交给ChatGPT OpenAI(2022)和OpenAI API Brockman等人(2020)的5214个提示的数据集上,GPT-4生成的回应优于GPT-3.5生成的回应,比例达到70.2%。

我们正在开源OpenAI Evals,这是我们创建和运行用于评估像GPT-4这样的模型的基准测试的框架,同时逐个样本检查性能。Evals与现有的基准测试兼容,并可用于跟踪模型在部署中的性能。我们计划随着时间的推移增加这些基准测试的多样性,以代表更广泛的失效模式和更难的任务。

4.1 视觉输入

GPT-4接受由图像和文本组成的提示,这与仅文本设置平行,使用户能够指定任何视觉或语言任务。

具体来说,模型在输入由任意交织的文本和图像组成的情况下生成文本输出。在包括具有文本和照片、图表或屏幕截图的各种领域中,GPT-4表现出与仅文本输入相似的能力。GPT-4的视觉输入示例可见于表3。

对于使用图像和文本的情况,针对语言模型开发的标准测试技术(例如少量提示、链式思考等)同样有效 - 有关示例,请参见附录G。

Q: What is funny about this image? Describe it panel by panel.

这张图片展示了一个“闪电数据线”适配器的包装,有三个面板。

面板1:一部智能手机,其充电口插着一个VGA连接器(一个通常用于计算机显示器的大型、蓝色的15针连接器)。

面板2:标有VGA连接器图片的“闪电数据线”适配器的包装。

面板3:VGA连接器的特写,末端有一个小型的闪电连接器(用于充电iPhone和其他苹果设备)。

这张图片的幽默来自于将一个大而过时的VGA连接器插入一个小而现代的智能手机充电口的荒谬性。Table 3: 示例提示展示了GPT-4的视觉输入能力。提示包括一个关于具有多个面板的图像的问题,GPT-4能够回答。**

Note: "示例提示展示了GPT-4的视觉输入能力。

提示包括一个关于具有多个面板的图像的问题,GPT-4能够回答。" translates to "Example prompt demonstrating GPT-4’s visual input capability. The prompt consists of a question about an image with multiple panels which GPT-4 is able to answer."*

5. 限制

尽管具有出色的功能,GPT-4仍然存在与早期GPT模型类似的限制。

最重要的是,它仍然不是完全可靠的(会“产生幻觉”事实,并做出推理错误)。在使用语言模型输出时应特别小心,特别是在高风险情境下,应根据特定应用的需求选择确切的协议(例如人工审查、与额外上下文联系、或完全避免高风险用途)。

有关详细信息,请参阅我们的系统卡。

相对于之前的GPT-3.5模型(这些模型本身也随着持续迭代而改进) ,GPT-4大大降低了幻觉现象。在我们内部针对事实准确性设计的对抗性评估中,GPT-4的得分比我们最新的GPT-3.5高出19个百分点(见图6)。

Note: "Figure 6" translates to "图6".

图6:GPT-4在九个内部对抗性设计的事实准确性评估中的表现。准确率显示在y轴上,数值越高越好。准确率为1.0意味着模型的答案被判断与人类理想答案在所有评估问题上一致。我们将GPT-4与基于GPT-3.5的三个较早版本的ChatGPT进行比较;GPT-4相比最新的GPT-3.5模型提高了19个百分点,对所有主题都有显著的提升。

GPT-4在像TruthfulQA Lin等人(2022)这样的公共基准上取得了进展,该基准测试了模型将事实与对抗性选择的一组不正确的陈述区分开来的能力(见图7)。这些问题与事实不正确的答案配对,这些答案在统计上具有吸引力。GPT-4基础模型在这项任务上只比GPT-3.5稍好一点;然而,在RLHF后训练之后,我们观察到相对于GPT-3.5有了很大的改进。表4显示了一个正确答案和一个错误答案。GPT-4避免选择常见的说法(老狗学不了新把戏),但仍可能忽略细微的细节(埃尔维斯·普雷斯利并不是一个演员的儿子,因此Perkins才是正确答案)。

图7:GPT-4在TruthfulQA上的表现。准确率显示在y轴上,数值越高越好。我们比较了GPT-4在零提示、少样本提示和RLHF微调后的表现。GPT-4在准确性上明显优于GPT-3.5和Anthropic-LM(Bai等人,2022)。

GPT-4通常缺乏对其预训练数据绝大部分截止于2019年9月之后发生事件的了解,也不会从自身的经验中学习。有时候,它可能会做出简单的推理错误,这些错误似乎与在如此多领域中的能力不符,或者在接受用户明显错误的陈述时过于轻信。它可能会在像人类一样在难题上失败,比如在其生成的代码中引入安全漏洞。**

**当有可能出错时,GPT-4在其预测中也可能会自信地做出错误的预测,而不会在工作中仔细检查。有趣的是,预训练模型的校准性很高(其对答案的预测置信度通常与正确概率相匹配)。然而,在后训练过程中,这种校准性会降低(见图8)。

Note: "Figure 8" translates to "图8".

图8:左侧:预训练的GPT-4模型在MMLU数据集子集上的校准图。x轴是模型对每个问题的A/B/C/D选择的置信度(对数概率)的分段;y轴是每个分段内的准确率。虚线对角线代表完美的校准。右侧:同一MMLU子集上后训练的GPT-4模型的校准图。后训练显著损害了校准性。

GPT-4在输出中存在各种偏见,我们已经在努力纠正,但需要一些时间来充分描述和管理。我们的目标是使GPT-4和其他我们构建的系统具有反映广泛用户价值观的合理默认行为,并允许在某些广泛范围内定制这些系统,并征求公众对这些范围应该是什么的意见。有关更多详细信息,请参阅OpenAI(2023b)。

Note: "Figure 8" translates to "图8".

6风险与缓解措施

我们投入了大量精力改进GPT-4的安全性和对齐性。在这里,我们强调了我们利用领域专家进行对抗测试和红队测试的方法,以及我们的模型辅助安全管道(Leike等,2022年)以及相对于先前模型的安全度量的改进。

通过领域专家进行对抗测试:GPT-4存在与较小语言模型类似的风险,例如生成有害建议、错误代码或不准确信息。然而,GPT-4的额外功能导致了新的风险面。为了了解这些风险的程度,我们邀请了来自长期AI对齐风险、网络安全、生物风险和国际安全等领域的50多位专家进行对抗测试。他们的发现具体帮助我们测试模型在需要具有专业知识才能评估的高风险领域中的行为,以及评估将对非常先进的AI(如寻求权力的AI)产生影响的风险。从这些专家那里收集到的建议和培训数据为我们的缓解措施和模型的改进提供了支持;例如,我们收集了额外的数据来提高GPT-4拒绝合成危险化学品请求的能力(见表5)。

Note: "Table 5" translates to "表5".

模型辅助安全管道:与先前的GPT模型一样,我们使用人类反馈进行强化学习fine-tune模型的行为(RLHF)(Christiano等人,2017年;Ouyang等人,2022年),以产生与用户意图更加对齐的响应。然而,在RLHF之后,我们的模型仍然可能对不安全的输入过于脆弱,有时甚至在安全和不安全的输入上表现出不希望出现的行为。这些不希望出现的行为可能是在RLHF管道的奖励模型数据收集阶段,给标注者的指令过于模糊或不足的情况下产生的。当给出不安全的输入时,模型可能会生成不良内容,例如提供犯罪建议。此外,模型在安全输入上也可能变得过于谨慎,拒绝无害请求或过度保守。为了在更细粒度的级别上引导我们的模型朝着适当的行为方向发展,我们在很大程度上依赖于我们的模型本身作为工具。我们的安全方法由两个主要组件组成,即额外一组与安全相关的RLHF训练提示和基于规则的奖励模型(RBRM)。

我们的基于规则的奖励模型(RBRMs)是一组零-shot GPT-4分类器。这些分类器在RLHF fine-tuning期间为GPT-4策略模型提供了额外的奖励信号,以针对正确的行为,例如拒绝生成有害内容或不拒绝无害请求。RBRM接收三个输入:提示(可选)、策略模型的输出以及人工编写的评分标准(例如,一组多选题式的规则),用于评估这个输出应该如何被评估。然后,RBRM根据评分标准对输出进行分类。例如,我们可以提供一个规则,指示模型将响应分类为:(a)以期望的方式拒绝、(b)以不期望的方式拒绝(例如,回避或支离破碎)、(c)包含不允许的内容,或(d)安全的非拒绝响应。然后,在请求有害内容(例如违法建议)的安全相关训练提示集上,我们可以奖励GPT-4拒绝这些请求。相反,我们可以奖励GPT-4在一些可以保证安全和可回答的提示子集上不拒绝请求。这项技术与Glaese等人(2022年)和Perez等人(2022年)的工作相关。这个方法,结合其他改进,比如计算最佳的RBRM权重并提供额外的针对我们想要改进的领域的SFT数据,使我们能够将模型引导更接近期望的行为。

安全指标的改进:我们的缓解措施显著提高了GPT-4的许多安全性能。与GPT-3.5相比,我们已经将模型对于请求不允许内容的倾向减少了82%(见表6),而GPT-4对于敏感请求(例如,医疗建议和自我伤害,见表7)的响应频率按照我们的政策增加了29%(见图9)。在RealToxicityPrompts数据集(Gehman等人,2020年)上,GPT-4生成的有毒内容仅占0.73%,而GPT-3.5的毒性内容占比达到6.48%。

- F9

图9:对敏感和不允许的提示的错误行为率。数值越低越好。相比以往的模型,GPT-4的RLHF有着更低的错误行为率。

总的来说,我们在模型级别的干预增加了引发不良行为的难度,但这仍然是可能的。例如,仍然存在“越狱”(例如,对抗性系统消息,请参阅系统卡中的图10以了解更多详情),可以生成违反我们使用准则的内容。只要存在这些限制,重要的是要与部署时的安全技术相结合,例如监控滥用以及快速迭代模型改进的流程。

GPT-4和后续模型有可能在社会中产生重大影响,既有益处也有害处。我们正在与外部研究人员合作,改进我们对潜在影响的理解和评估方法,以及为未来系统可能出现的危险能力建立评估。我们将很快发布建议,指导社会应该采取哪些步骤来应对人工智能的影响,并初步提出了关于预测人工智能可能的经济影响的初步想法。

我们对GPT-4进行了描述,这是一个具有人类水平性能的大型多模态模型,在某些困难的专业和学术基准测试中表现出色。GPT-4在一系列自然语言处理任务中优于现有的大型语言模型,并超越了绝大多数报告的最新技术系统(这些系统通常包括任务特定的微调)。我们发现,改进的能力虽然通常以英语为衡量标准,但也可以在许多不同的语言中得到证明。我们强调了可预测的扩展如何使我们能够准确预测GPT-4的损失和能力。

由于能力增强,GPT-4带来了新的风险,我们讨论了一些了解和改进其安全性和对齐性所采取的方法和结果。尽管还有许多工作要做,但GPT-4代表着朝着广泛有用且安全部署的人工智能系统迈出了重要的一步。

参考资料

https://arxiv.org/abs/2303.08774

本文由博客一文多发平台 OpenWrite 发布!