神经网络的学习 Neural Networks learing

1.一些基本符号

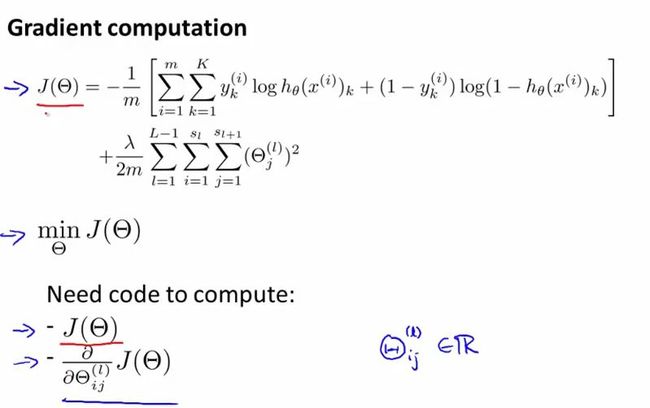

2.COST函数

================Backpropagation Algorithm=============

1.要计算的东西

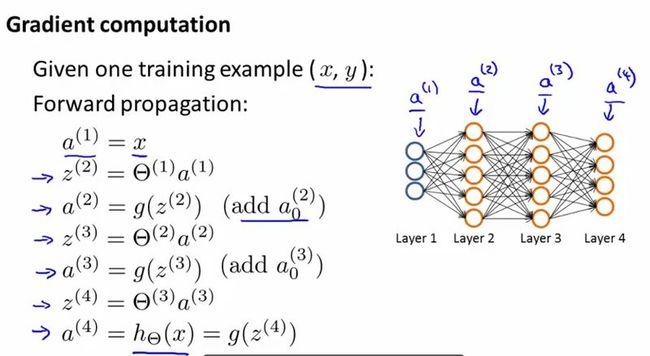

2.向前传递向量图,但为了计算上图的偏导,要用到后向传递算法

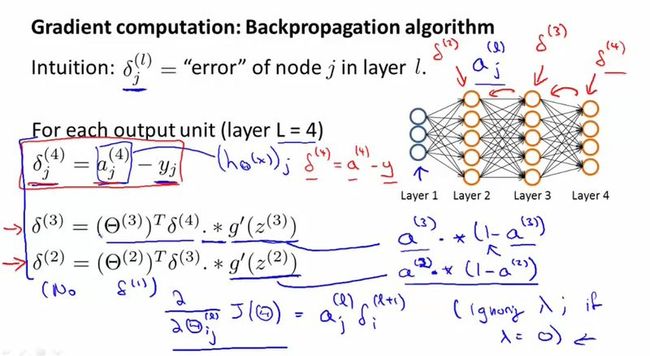

3.后向传递算法

4.小题目

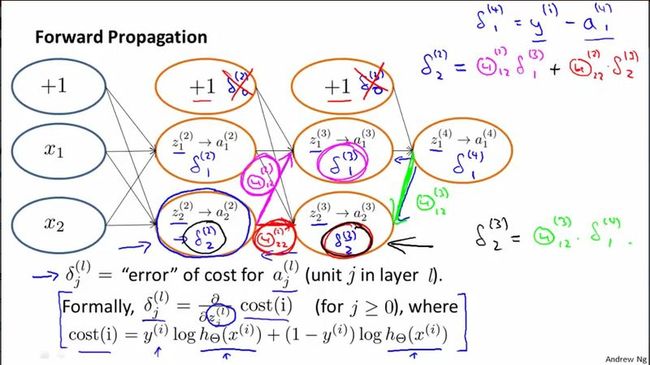

==============Backpropagation Intuition==============

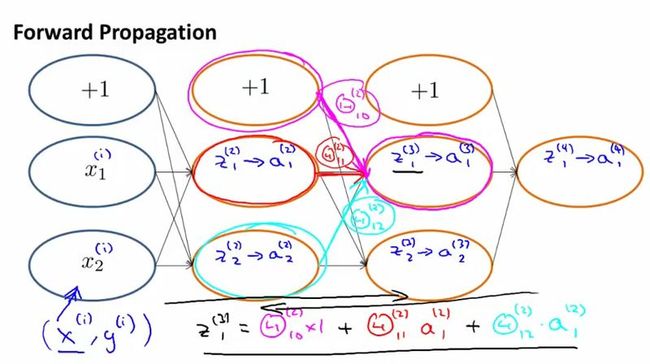

1.前向计算与后向计算很类似

2.仅考虑一个例子,COST函数化简

3.倒着算theta

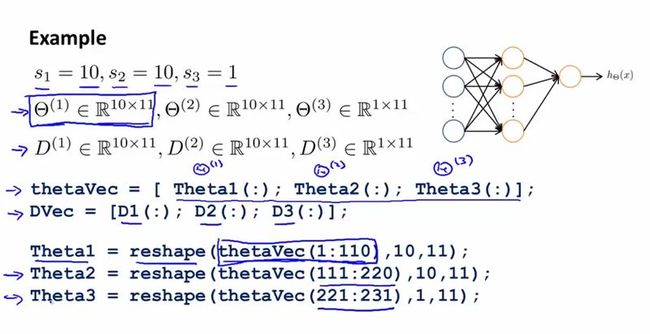

=======Implementation Note: Unrolling Parameters=======

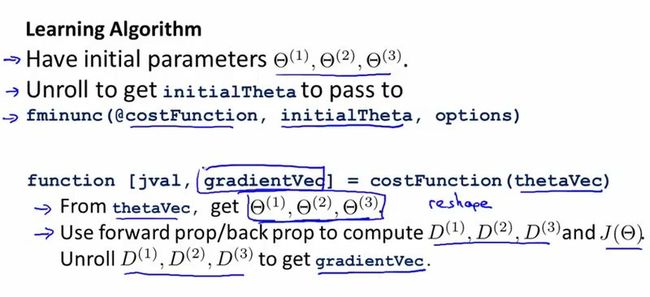

1.参数的展开

2.学习算法

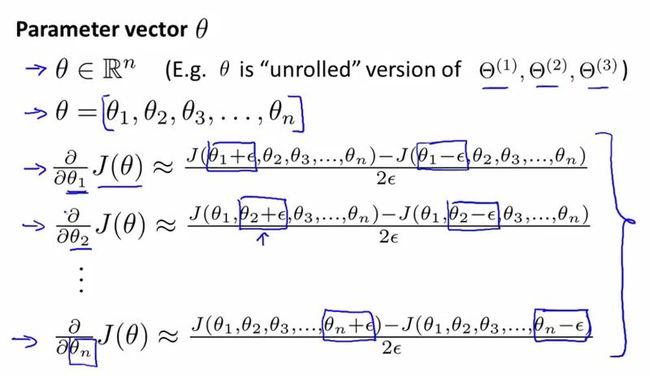

============Gradient Checking====================

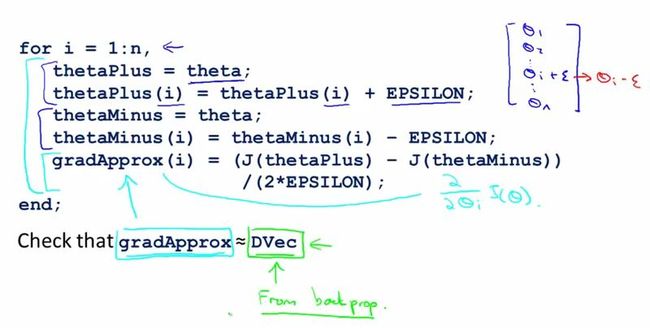

1.梯度的数字计算

2.所有的梯度的近似计算

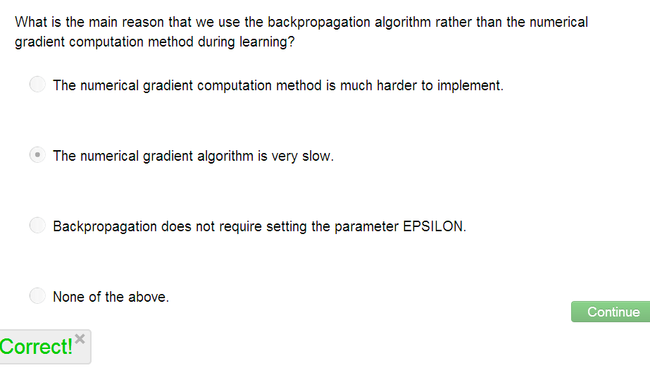

3.回退计算而不是梯度计算的本质原因

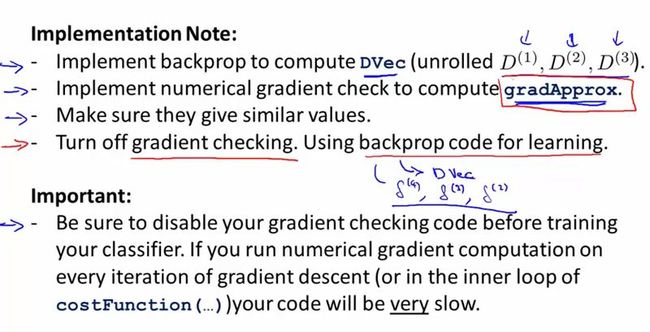

4.实现注意点

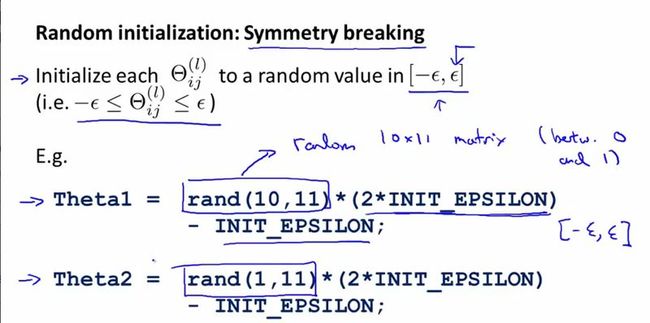

============Random Initialization=============

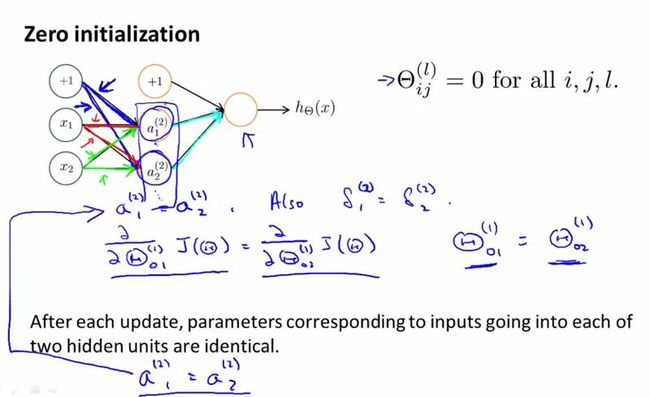

1.zero initial 对神经网络不适合

2.随机对称初始化

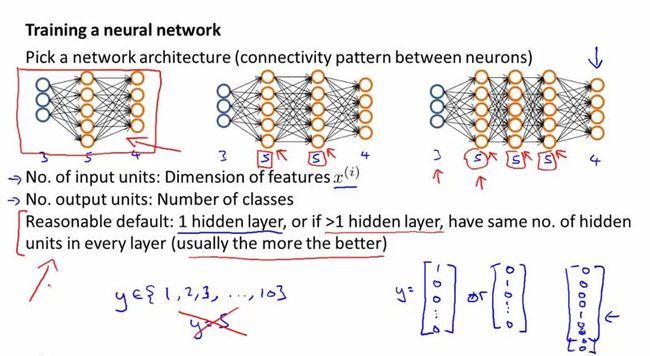

==========Putting It Together==============

1.隐含层越多,则计算量越大。隐含层节点相同比较好。

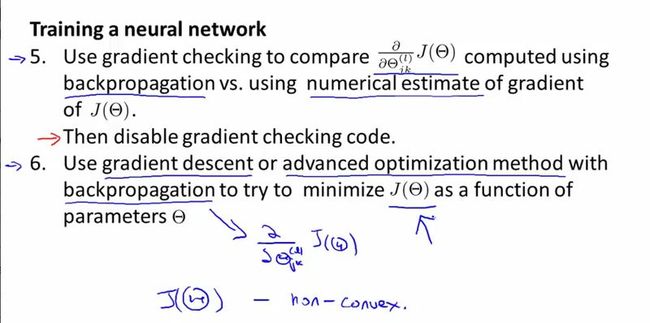

2.训练神经网络的步骤,其实跟回归很像。关键是用后退算偏导。