深度探索:决策树算法在机器学习中的原理与应用

引言与背景

决策树算法作为机器学习领域的一种基础而重要的监督学习方法,以其直观易理解、解释性强以及能处理离散和连续属性等特点,在数据挖掘、数据分析和预测建模等诸多领域占有不可或缺的地位。决策树通过学习训练数据集构建一棵树状结构模型,模拟从根节点到叶节点的决策路径,以此进行样本分类或回归预测。

定义

决策树算法是一种非参数模型,其核心思想是通过递归地划分数据空间,形成一系列if-then规则,最终构成一棵反映数据内在规律的树形结构。每一个内部节点表示一个特征测试,分支代表该特征的不同取值,而叶节点则对应着分类或回归的结果。

决策树算法原理

数学基础

决策树构建过程中,主要涉及信息熵、基尼指数等衡量数据纯度的指标,以及信息增益、增益率等用于选择最优分割属性的方法。通过最大化信息增益(ID3算法)或最小化基尼不纯度(CART算法),决定每个节点的最佳分割特征。

算法描述

决策树的构建流程包括训练阶段和预测阶段。在训练阶段,算法首先选择最优特征进行分割,然后递归地对子集重复此过程,直至达到预定的停止条件(如所有节点满足纯度阈值、节点样本数量低于一定限制或树的最大深度到达)。预测阶段,则通过沿着树的路径遍历,根据测试样本的特征值向下匹配,直到抵达叶节点得到预测结果。

决策树类型与应用场景

决策树家族包括ID3、C4.5(改进的ID3,引入信息增益比)、CART(分类与回归树)等多种算法变体。其中,CART既可以用于分类也可用于回归任务。在文本分类、信用评分、医疗诊断、市场营销策略制定等场景中,决策树均发挥了重要作用。

算法实现

数据预处理

在实现决策树算法前,一般需要对数据进行预处理,包括缺失值填充、数据标准化或离散化等操作,以确保模型训练的稳定性和准确性。

参数估计

决策树算法中的关键参数包括树的最大深度、叶子节点最少样本数、分裂时考虑的特征数等,通过合理调整这些参数,可以在防止过拟合与欠拟合之间找到平衡。

构建与剪枝流程

决策树的构建主要包括生长和剪枝两个阶段。生长阶段主要是通过递归分割数据构建初始树,而剪枝阶段则是通过降低复杂度,减少过拟合风险,提升模型泛化能力。

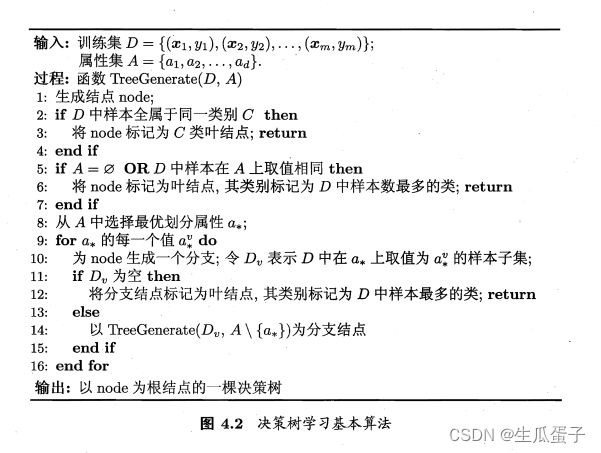

决策树学习基本算法

这张图是一个决策树学习的基本算法流程。以下是该算法的详细步骤:

输入:

- 训练集 $D = \{ (x_1, y_1), (x_2, y_2), ..., (x_m, y_m) \}$;

- 属性集 $A = \{a_1, a_2, ..., a_d\}$。

过程:函数 TreeGenerate($D$, $A$)

1. 如果训练集中样本全属于同一类别 $C$,则:

- 将节点标记为 $C$ 类叶结点;return

2. 否则(即存在不同类别的样本):

- 如果属性集为空或训练集中样本在属性集上取值相同,则:

- 将节点标记为叶结点,其类别标记为训练集中样本数最多的类;return

3. 否则(即属性集不为空且训练集中样本在属性集上的取值有差异),从属性集 $A$ 中选择最优划分属性 $a^*$。

4. 对于 $a^*$ 的每一个值 $a^*_v$,执行以下操作:

- 生成一个分支,令 $D_v$ 表示训练集中在属性 $a^*$ 上取值为 $a^*_v$ 的样本子集。

- 如果 $D_v$ 为空,则将分支结点标记为叶结点,其类别标记为训练集中样本数最多的类;return

- 否则,以 TreeGenerate($D_v$, $A \setminus {a^*}$) 作为分支结点

5. 结束循环。

输出:以 node 为根结点的一棵决策树。

这个算法用于构建决策树模型,通过递归地对数据进行分割来寻找最佳的特征和阈值,从而形成一棵决策树。

Python代码实现

以下是一个使用Python的scikit-learn库实现决策树分类器的基本示例:

from sklearn.datasets import load_iris

from sklearn.model_selection import train_test_split

from sklearn.tree import DecisionTreeClassifier

from sklearn.metrics import accuracy_score

# 加载数据集

iris = load_iris()

X = iris.data

y = iris.target

# 划分训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# 创建决策树分类器,此处使用默认参数

clf = DecisionTreeClassifier()

# 使用训练集数据训练模型

clf.fit(X_train, y_train)

# 在测试集上进行预测

y_pred = clf.predict(X_test)

# 计算预测准确率

accuracy = accuracy_score(y_test, y_pred)

print(f"Accuracy: {accuracy}")

# 如果你想手动实现决策树算法,以下是一个基础版本的伪代码(并未提供完整实现):

# 定义数据结构表示决策树节点

class TreeNode:

def __init__(self, feature=None, threshold=None, left=None, right=None, class_label=None):

self.feature = feature

self.threshold = threshold

self.left = left

self.right = right

self.class_label = class_label

# 计算信息增益/基尼指数等指标选择最优分割特征

def choose_best_feature(X, y):

pass # 这里应实现具体的计算逻辑

# 递归构建决策树

def build_tree(X, y):

if ... # 判断是否达到停止条件(如所有样本属于同一类别或无特征可分)

return TreeNode(class_label=...) # 返回叶节点

else:

best_feature = choose_best_feature(X, y)

split_value = ... # 获取最优特征的分割值

# 根据最优特征分割数据,并递归构建左右子树

left_X, right_X, left_y, right_y = ..., ...

left subtree = build_tree(left_X, left_y)

right_subtree = build_tree(right_X, right_y)

return TreeNode(feature=best_feature, threshold=split_value, left=left_subtree, right=right_subtree)

# 对新的样本进行预测

def predict(tree_node, sample):

if tree_node.is_leaf: # 如果当前节点是叶节点

return tree_node.class_label

else:

if sample[tree_node.feature] <= tree_node.threshold:

return predict(tree_node.left, sample)

else:

return predict(tree_node.right, sample)

# 使用自己实现的决策树算法进行训练和预测

tree = build_tree(X_train, y_train)

predictions = [predict(tree, sample) for sample in X_test]需要注意的是,手工实现完整的决策树算法相当复杂,涉及数据预处理、特征选择、树的构建与剪枝等多个步骤,而在实际应用中,我们更倾向于使用成熟的机器学习库如scikit-learn提供的DecisionTreeClassifier类,因为它已经包含了众多优化和改进措施。

优缺点分析

优点

- 直观易懂,方便解释,有助于业务理解;

- 能够处理离散和连续型数据,无需进行特征标准化;

- 能够自动检测到特征间的交互作用。

缺点

- 容易过拟合,特别是对于复杂数据集和深树结构;

- 对于有大量冗余特征的数据集,决策树容易偏向于选择那些拥有较多属性值的特征;

- 当类别不平衡时,决策树可能过于关注占主导地位的类别。

案例应用

决策树在信用卡欺诈检测、电商产品推荐、客户流失预警、疾病诊断等多个实际问题中获得了广泛应用,并展现出强大的实用性。

对比与其他算法

相较于KNN、朴素贝叶斯、支持向量机等算法,决策树在构建模型时不需要进行复杂的数学运算,但在面对大规模数据集时,其训练效率可能较低。同时,决策树模型的泛化能力相比神经网络等复杂模型稍显不足,但在解释性上却有明显优势。

结论与展望

决策树算法因其独特的优势在实际应用中广受欢迎,然而,为了进一步提升性能和解决过拟合问题,研究人员不断探索改进算法,如集成学习方法(如随机森林、梯度提升决策树GBDT等),以及引入深度学习等先进技术增强决策树模型的能力。未来,决策树算法将持续演进,更好地服务于复杂多样的数据科学应用场景。