Java 大视界 -- 基于 Java 的大数据机器学习模型的多模态融合技术与应用(143)

![]()

亲爱的朋友们,热烈欢迎来到 青云交的博客!能与诸位在此相逢,我倍感荣幸。在这飞速更迭的时代,我们都渴望一方心灵净土,而 我的博客 正是这样温暖的所在。这里为你呈上趣味与实用兼具的知识,也期待你毫无保留地分享独特见解,愿我们于此携手成长,共赴新程!

一、欢迎加入【福利社群】

点击快速加入: 青云交灵犀技韵交响盛汇福利社群

点击快速加入2: 2024 CSDN 博客之星 创作交流营(NEW)

二、本博客的精华专栏:

- 大数据新视界专栏系列:聚焦大数据,展技术应用,推动进步拓展新视野。

- Java 大视界专栏系列(NEW):聚焦 Java 编程,细剖基础语法至高级框架。展示 Web、大数据等多领域应用,精研 JVM 性能优化,助您拓宽视野,提升硬核编程力。

- Java 大厂面试专栏系列:提供大厂面试的相关技巧和经验,助力求职。

- Python 魅力之旅:探索数据与智能的奥秘专栏系列:走进 Python 的精彩天地,感受数据处理与智能应用的独特魅力。

- Java 虚拟机(JVM)专栏系列:深入剖析 JVM 的工作原理和优化方法。

- Java 学习路线专栏系列:为不同阶段的学习者规划清晰的学习路径。

- JVM 万亿性能密码:在数字世界的浩瀚星海中,JVM 如神秘宝藏,其万亿性能密码即将开启奇幻之旅。

- AI(人工智能)专栏系列:紧跟科技潮流,介绍人工智能的应用和发展趋势。

- 智创 AI 新视界专栏系列(NEW):深入剖析 AI 前沿技术,展示创新应用成果,带您领略智能创造的全新世界,提升 AI 认知与实践能力。

- 数据库核心宝典:构建强大数据体系专栏系列:专栏涵盖关系与非关系数据库及相关技术,助力构建强大数据体系。

- MySQL 之道专栏系列:您将领悟 MySQL 的独特之道,掌握高效数据库管理之法,开启数据驱动的精彩旅程。

- 大前端风云榜:引领技术浪潮专栏系列:大前端专栏如风云榜,捕捉 Vue.js、React Native 等重要技术动态,引领你在技术浪潮中前行。

三、【青云交技术圈福利社群】和【架构师社区】的精华频道:

- 福利社群:无论你是技术萌新还是行业大咖,这儿总有契合你的天地,助力你于技术攀峰、资源互通及人脉拓宽之途不再形单影只。 点击快速加入【福利社群】 和 【CSDN 博客之星 创作交流营(NEW)】

- 今日看点:宛如一盏明灯,引领你尽情畅游社区精华频道,开启一场璀璨的知识盛宴。

- 今日精品佳作:为您精心甄选精品佳作,引领您畅游知识的广袤海洋,开启智慧探索之旅,定能让您满载而归。

- 每日成长记录:细致入微地介绍成长记录,图文并茂,真实可触,让你见证每一步的成长足迹。

- 每日荣登原力榜:如实记录原力榜的排行真实情况,有图有真相,一同感受荣耀时刻的璀璨光芒。

- 每日荣登领军人物榜:精心且精准地记录领军人物榜的真实情况,图文并茂地展现,让领导风采尽情绽放,令人瞩目。

- 每周荣登作者周榜:精准记录作者周榜的实际状况,有图有真相,领略卓越风采的绽放。

展望未来,我誓做前沿技术的先锋,于人工智能、大数据领域披荆斩棘。持续深耕,输出独家深度专题,为你搭建通往科技前沿的天梯,助你领航时代,傲立潮头。

即将开启技术挑战与代码分享盛宴,以创新形式激活社区,点燃技术热情。让思维碰撞,迸发智慧光芒,照亮探索技术巅峰的征途。

珍视你的每一条反馈,视其为前行的灯塔。精心雕琢博客内容,精细优化功能体验,为你打造沉浸式知识殿堂。拓展多元合作,携手行业巨擘,汇聚海量优质资源,伴你飞速成长。

期待与你在网络空间并肩同行,共铸辉煌。你的点赞,是我前行的动力;关注,是对我的信任;评论,是思想的交融;打赏,是认可的温暖;订阅,是未来的期许。这些皆是我不断奋进的力量源泉。

衷心感谢每一位支持者,你们的互动,推动我勇攀高峰。诚邀访问 【我的博客主页】 或 【青云交技术圈福利社群】 或 【架构师社区】 ,如您对涨粉、技术交友、技术交流、内部学习资料获取、副业发展、项目外包和商务合作等方面感兴趣,欢迎在文章末尾添加我的微信名片 【QingYunJiao】 (点击直达) ,添加时请备注【CSDN 技术交流】。更多精彩内容,等您解锁。

让我们携手踏上知识之旅,汇聚智慧,打造知识宝库,吸引更多伙伴。未来,与志同道合者同行,在知识领域绽放无限光彩,铸就不朽传奇!

![]()

Java 大视界 -- 基于 Java 的大数据机器学习模型的多模态融合技术与应用(143)

- 引言:

- 正文:

-

- 一、多模态融合技术基础

-

- 1.1 多模态数据概述

- 1.2 多模态融合的概念与意义

- 二、基于 Java 的多模态数据处理技术

-

- 2.1 多模态数据的采集与预处理

-

- 2.1.1 文本数据采集

- 2.1.2 图像数据采集

- 2.1.3 音频数据采集

- 2.1.4 文本数据预处理

- 2.1.5 图像数据预处理

- 2.1.6 音频数据预处理

- 2.2 多模态数据的特征提取与融合

-

- 2.2.1 文本数据特征提取

- 2.2.2 图像数据特征提取

- 2.2.3 音频数据特征提取

- 2.2.4 早期融合

- 2.2.5 晚期融合

- 2.2.6 混合融合

- 三、基于 Java 的多模态融合机器学习模型构建与训练

-

- 3.1 常见多模态融合机器学习模型介绍

-

- 3.1.1 多模态多层感知机

- 3.1.2 多模态卷积神经网络

- 3.1.3 循环神经网络(RNN)及其变体长短期记忆网络(LSTM)、门控循环单元(GRU)的多模态扩展

- 3.2 基于 Java 的多模态融合模型构建实例

-

- 3.2.1 图像数据加载与预处理

- 3.2.2 文本数据加载与预处理

- 3.3 模型训练过程优化与调参

-

- 3.3.1 优化算法

- 3.3.2 调参方法

- 四、多模态融合模型的评估与应用

-

- 4.1 多模态融合模型的评估指标

-

- 4.1.1 准确率(Accuracy)

- 4.1.2 精确率(Precision)、召回率(Recall)和 F1 值(F1 - score)

- 4.1.3 均方误差(Mean Squared Error, MSE)

- 4.2 多模态融合模型在实际场景中的应用案例

-

- 4.2.1 智能医疗诊断

- 4.2.2 智能安防监控

- 4.2.3 智能交通管理

- 结束语:

- ️参与投票和与我联系:

引言:

亲爱的 Java 和 大数据爱好者们,大家好!在大数据与 Java 技术深度融合的广阔天地里,我们已通过一系列精彩篇章,领略了其在多个前沿领域的非凡魅力。《Java 大视界 – Java 大数据在智能体育赛事直播数据分析与观众互动优化中的应用(142)》深入剖析了 Java 大数据如何为智能体育赛事直播注入活力,借助详实的代码示例与鲜活的真实案例,助力读者精准掌握核心技术,有力推动体育直播行业迈向创新升级之路。《Java 大视界 – Java 大数据中的知识图谱可视化与交互分析技术(141)》则聚焦于知识图谱领域,全面解读 Java 大数据在知识图谱可视化与交互分析方面的技术精髓,从原理阐释到代码实操,再到案例呈现,引领读者深度挖掘大数据在此领域的巨大应用潜力。

此外,《Java 大视界 – Java 大数据在智能家居设备联动与场景自动化中的应用(140)》展示了 Java 大数据赋能智能家居的奇妙应用;《Java 大视界 – 基于 Java 的大数据分布式存储系统的数据备份与恢复策略(139)》为数据安全存储与恢复提供了关键技术支撑;《Java 大视界 – Java 大数据在智能政务舆情引导与公共危机管理中的应用(138)【双热榜】》彰显了大数据在智能政务领域的重要价值。这些文章从不同维度揭示了 Java 大数据的强大功能与无限可能。

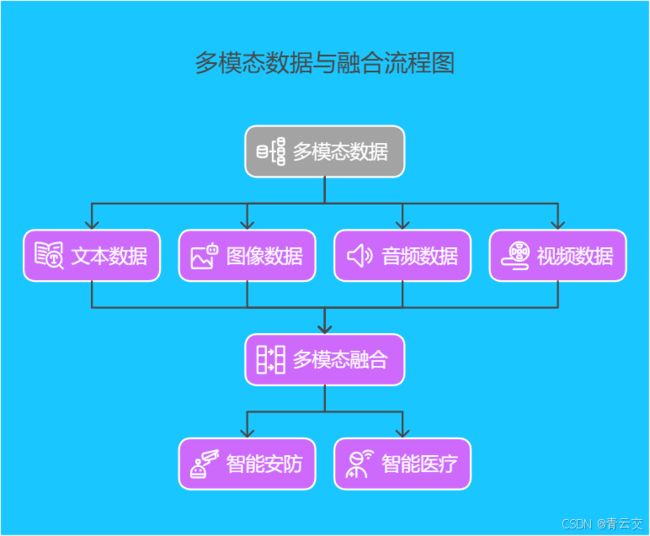

如今,我们将目光转向大数据机器学习领域的前沿技术 —— 多模态融合技术。在大数据时代,数据来源丰富多样,文本、图像、音频、视频等多模态数据蕴含着海量信息。基于 Java 的大数据机器学习模型的多模态融合技术,旨在整合这些多元数据,深度挖掘其潜在价值,为机器学习模型赋予更强性能,开拓更为广阔的应用前景。

正文:

一、多模态融合技术基础

1.1 多模态数据概述

多模态数据是指来自不同类型传感器或数据源的信息,它们以不同的形式呈现,各自携带独特的信息。常见的多模态数据包括文本数据,如新闻报道、社交媒体评论、产品描述等,其通过文字传递语义信息;图像数据,像照片、视频帧、医学影像等,以直观的视觉形式展现场景和物体特征;音频数据,例如语音、音乐、环境声音等,包含了声音的频率、振幅等特征,可用于情感识别、语音指令识别等;以及视频数据,它综合了图像和音频信息,能够动态地描述事件过程。

在实际应用中,多模态数据相互补充,提供更全面的信息。例如在智能安防领域,摄像头采集的视频图像数据可以直观显示场景画面,而麦克风收集的音频数据能捕捉到异常声音,两者结合可以更准确地判断是否存在安全威胁。

1.2 多模态融合的概念与意义

多模态融合是指将多种不同模态的数据进行有机整合,以提高机器学习模型的性能和泛化能力。传统的机器学习模型往往只处理单一模态的数据,这限制了模型对复杂现实场景的理解和分析能力。多模态融合技术打破了这种局限,通过融合不同模态数据的优势,使模型能够从多个角度学习和理解数据,从而更全面、准确地捕捉数据中的模式和规律。

以智能医疗诊断为例,将患者的病历文本(症状描述、诊断记录等)、医学影像(X 光、CT 等)以及生理指标监测数据(心率、血压等)进行融合分析,医生和机器学习模型能够更精准地判断病情,提高诊断的准确性和可靠性。多模态融合技术在提升模型性能的同时,也增强了模型对复杂环境的适应性,使其在实际应用中表现更加出色。

二、基于 Java 的多模态数据处理技术

2.1 多模态数据的采集与预处理

在 Java 中,针对不同模态的数据,有丰富的库和工具用于采集和预处理。

2.1.1 文本数据采集

可使用 Jsoup 库从网页中提取文本内容。以下是一个简单的示例代码,用于从指定网页获取文本信息:

import org.jsoup.Jsoup;

import org.jsoup.nodes.Document;

import org.jsoup.nodes.Element;

import org.jsoup.select.Elements;

import java.io.IOException;

public class TextDataCollector {

public static void main(String[] args) {

try {

// 要访问的网页URL

String url = "https://example.com";

// 连接到指定网页并获取文档对象

Document doc = Jsoup.connect(url).get();

// 选择网页中的所有段落元素

Elements paragraphs = doc.select("p");

// 遍历段落元素并打印其文本内容

for (Element para : paragraphs) {

System.out.println(para.text());

}

} catch (IOException e) {

// 捕获并打印异常信息

e.printStackTrace();

}

}

}

2.1.2 图像数据采集

可利用 Java 的图像处理库,如 OpenCV - Java。首先需要在项目中引入 OpenCV 的依赖(以 Maven 项目为例,在 pom.xml 中添加):

<dependency>

<groupId>org.openpnpgroupId>

<artifactId>opencv - javaartifactId>

<version>4.5.5version>

dependency>

然后可以通过以下代码读取并显示一张图片:

import org.opencv.core.Core;

import org.opencv.core.Mat;

import org.opencv.highgui.HighGui;

import org.opencv.imgcodecs.Imgcodecs;

public class ImageDataCollector {

public static void main(String[] args) {

// 加载OpenCV的本地库

System.loadLibrary(Core.NATIVE_LIBRARY_NAME);

// 图像文件路径

String imagePath = "path/to/your/image.jpg";

// 读取图像文件到Mat对象中

Mat image = Imgcodecs.imread(imagePath);

// 检查图像是否成功读取

if (image.empty()) {

System.out.println("Could not open or find the image");

return;

}

// 显示图像窗口

HighGui.imshow("Image", image);

// 等待按键按下

HighGui.waitKey(0);

// 关闭所有图像窗口

HighGui.destroyAllWindows();

}

}

2.1.3 音频数据采集

可以借助 Java Sound API。以下代码实现了简单的音频录制功能:

import javax.sound.sampled.*;

import java.io.File;

public class AudioRecorder {

// 采样率

private static final int SAMPLE_RATE = 16000;

// 每个样本的位数

private static final int SAMPLE_SIZE_IN_BITS = 16;

// 声道数

private static final int CHANNELS = 1;

// 是否有符号

private static final boolean SIGNED = true;

// 字节序

private static final boolean BIG_ENDIAN = false;

// 目标数据行,用于音频输入

private TargetDataLine line;

// 音频输入流

private AudioInputStream audioInputStream;

// 保存音频的文件

private File audioFile;

public AudioRecorder() {

try {

// 创建音频格式对象

AudioFormat format = new AudioFormat(SAMPLE_RATE, SAMPLE_SIZE_IN_BITS, CHANNELS, SIGNED, BIG_ENDIAN);

// 创建数据行信息对象

DataLine.Info info = new DataLine.Info(TargetDataLine.class, format);

// 获取目标数据行实例

line = (TargetDataLine) AudioSystem.getLine(info);

// 打开目标数据行

line.open(format);

} catch (LineUnavailableException e) {

e.printStackTrace();

}

}

public void startRecording() {

// 开始音频录制

line.start();

// 创建音频输入流

audioInputStream = new AudioInputStream(line);

// 设置保存音频的文件

audioFile = new File("recorded_audio.wav");

try {

// 将音频输入流写入文件

AudioSystem.write(audioInputStream, AudioFileFormat.Type.WAVE, audioFile);

} catch (IOException e) {

e.printStackTrace();

}

}

public void stopRecording() {

// 停止音频录制

line.stop();

// 关闭目标数据行

line.close();

}

}

采集到的数据通常需要进行预处理。

2.1.4 文本数据预处理

常见的预处理步骤包括去除噪声(如 HTML 标签、特殊字符)、分词、词干提取、停用词过滤等。以使用 Stanford CoreNLP 进行分词为例:

import edu.stanford.nlp.pipeline.*;

import edu.stanford.nlp.ling.CoreAnnotations;

import edu.stanford.nlp.ling.CoreLabel;

import java.util.List;

import java.util.Properties;

public class TextPreprocessing {

public static void main(String[] args) {

// 待处理的文本

String text = "This is an example sentence for tokenization.";

// 创建属性对象,设置注释器为分词

Properties props = new Properties();

props.setProperty("annotators", "tokenize");

// 创建StanfordCoreNLP管道对象

StanfordCoreNLP pipeline = new StanfordCoreNLP(props);

// 创建注释对象

Annotation annotation = new Annotation(text);

// 使用管道对注释对象进行处理

pipeline.annotate(annotation);

//获取分词后的结果

List<CoreLabel> tokens = annotation.get(CoreAnnotations.TokensAnnotation.class);

// 遍历分词结果并打印每个词

for (CoreLabel token : tokens) {

System.out.println(token.word());

}

}

}

2.1.5 图像数据预处理

包括灰度化、降噪、尺寸归一化等操作。使用 OpenCV - Java 进行图像灰度化的代码如下:

import org.opencv.core.*;

import org.opencv.imgcodecs.Imgcodecs;

import org.opencv.imgproc.Imgproc;

public class ImagePreprocessing {

public static void main(String[] args) {

// 加载OpenCV的本地库

System.loadLibrary(Core.NATIVE_LIBRARY_NAME);

// 图像文件路径

String imagePath = "path/to/your/image.jpg";

// 读取图像文件到Mat对象中

Mat image = Imgcodecs.imread(imagePath);

// 创建用于存储灰度图像的Mat对象

Mat grayImage = new Mat();

// 将彩色图像转换为灰度图像

Imgproc.cvtColor(image, grayImage, Imgproc.COLOR_BGR2GRAY);

// 将灰度图像保存为新的文件

Imgcodecs.imwrite("gray_image.jpg", grayImage);

}

}

2.1.6 音频数据预处理

可能涉及去噪、归一化、特征提取等。例如,使用 Librosa 库(通过 Jython 在 Java 中调用)进行音频特征提取:

# 假设在Jython环境下

import librosa

import numpy as np

# 音频文件路径

audio_path = "path/to/your/audio.wav"

# 加载音频文件,返回音频数据和采样率

audio, sr = librosa.load(audio_path)

# 提取梅尔频率倒谱系数(MFCC),设置MFCC数量为13

mfccs = librosa.feature.mfcc(y = audio, sr = sr, n_mfcc = 13)

# 对MFCC进行缩放,计算每帧MFCC的均值

mfccs_scaled = np.mean(mfccs.T, axis = 0)

print(mfccs_scaled)

2.2 多模态数据的特征提取与融合

不同模态的数据需要提取合适的特征,以便后续融合。

2.2.1 文本数据特征提取

常用的特征提取方法有词袋模型(Bag of Words)、TF - IDF(Term Frequency - Inverse Document Frequency)等。使用 Apache Commons Math 库实现 TF - IDF 特征提取的示例代码如下:

import org.apache.commons.math3.linear.Array2DRowRealMatrix;

import org.apache.commons.math3.linear.RealMatrix;

import java.util.ArrayList;

import java.util.HashMap;

import java.util.List;

import java.util.Map;

public class TextFeatureExtraction {

// 存储文本数据集

private List<String> documents;

// 存储词汇表,将单词映射到索引

private Map<String, Integer> vocabulary;

// 词频矩阵

private RealMatrix tfMatrix;

// 逆文档频率向量

private RealMatrix idfVector;

// TF-IDF矩阵

private RealMatrix tfIdfMatrix;

public TextFeatureExtraction(List<String> documents) {

this.documents = documents;

// 构建词汇表

buildVocabulary();

// 构建词频矩阵

buildTFMatrix();

// 构建逆文档频率向量

buildIDFVector();

// 构建TF-IDF矩阵

buildTFIDFMatrix();

}

private void buildVocabulary() {

vocabulary = new HashMap<>();

int index = 0;

for (String doc : documents) {

String[] words = doc.split(" ");

for (String word : words) {

if (!vocabulary.containsKey(word)) {

vocabulary.put(word, index++);

}

}

}

}

private void buildTFMatrix() {

int numDocs = documents.size();

int numWords = vocabulary.size();

tfMatrix = new Array2DRowRealMatrix(numDocs, numWords);

for (int i = 0; i < numDocs; i++) {

String[] words = documents.get(i).split(" ");

for (String word : words) {

int wordIndex = vocabulary.get(word);

tfMatrix.setEntry(i, wordIndex, tfMatrix.getEntry(i, wordIndex) + 1);

}

}

}

private void buildIDFVector() {

int numDocs = documents.size();

int numWords = vocabulary.size();

idfVector = new Array2DRowRealMatrix(1, numWords);

for (int j = 0; j < numWords; j++) {

int docCount = 0;

for (int i = 0; i < numDocs; i++) {

if (tfMatrix.getEntry(i, j) > 0) {

docCount++;

}

}

idfVector.setEntry(0, j, Math.log(numDocs / (double) docCount));

}

}

private void buildTFIDFMatrix() {

tfIdfMatrix = tfMatrix.copy();

for (int i = 0; i < tfMatrix.getRowDimension(); i++) {

for (int j = 0; j < tfMatrix.getColumnDimension(); j++) {

tfIdfMatrix.setEntry(i, j, tfMatrix.getEntry(i, j) * idfVector.getEntry(0, j));

}

}

}

public RealMatrix getTFIDFMatrix() {

return tfIdfMatrix;

}

}

2.2.2 图像数据特征提取

可采用卷积神经网络(CNN)的预训练模型,如 VGG16、ResNet 等。使用 Deeplearning4j 库在 Java 中加载 VGG16 模型进行图像特征提取的示例如下:

import org.deeplearning4j.nn.modelimport.keras.KerasModelImport;

import org.deeplearning4j.nn.multilayer.MultiLayerNetwork;

import org.deeplearning4j.optimize.listeners.ScoreIterationListener;

import org.nd4j.evaluation.classification.Evaluation;

import org.nd4j.linalg.api.ndarray.INDArray;

import org.nd4j.linalg.dataset.DataSet;

import org.nd4j.linalg.dataset.api.iterator.DataSetIterator;

import org.nd4j.linalg.factory.Nd4j;

import org.nd4j.linalg.learning.config.Nesterovs;

import org.nd4j.linalg.lossfunctions.LossFunctions;

import org.slf4j.Logger;

import org.slf4j.LoggerFactory;

import java.io.File;

import java.io.IOException;

public class ImageFeatureExtraction {

private static final Logger log = LoggerFactory.getLogger(ImageFeatureExtraction.class);

// 图像行数

private static final int numRows = 224;

// 图像列数

private static final int numColumns = 224;

// 图像通道数

private static final int channels = 3;

// 输出类别数

private static final int outputNum = 10;

// 批次大小

private static final int batchSize = 32;

// 训练轮数

private static final int nEpochs = 1;

public static void main(String[] args) throws IOException {

// VGG16模型文件路径

File modelFile = new File("vgg16.h5");

// 从Keras模型文件导入并加载VGG16模型

MultiLayerNetwork model = KerasModelImport.importKerasSequentialModelAndWeights(modelFile);

// 设置模型训练时每1次迭代打印1次分数

model.setListeners(new ScoreIterationListener(1));

// 初始化模型

model.init();

// 设置优化器为Nesterovs,学习率为0.001,动量为0.9

model.setUpdater(new Nesterovs(0.001, 0.9));

// 假设已有图像数据集迭代器,这里调用自定义方法获取,实际需根据数据情况实现

DataSetIterator dataIter = getDataSetIterator(numRows, numColumns, channels, batchSize);

for (int i = 0; i < nEpochs; i++) {

model.fit(dataIter);

dataIter.reset();

Evaluation eval = new Evaluation(outputNum);

while (dataIter.hasNext()) {

DataSet ds = dataIter.next();

INDArray output = model.output(ds.getFeatures());

eval.eval(ds.getLabels(), output);

}

log.info(eval.stats());

}

}

private static DataSetIterator getDataSetIterator(int height, int width, int channels, int batchSize) {

try {

// 这里假设图像数据存储在"data"目录下,且按照类别分文件夹存放

String dataDir = "data";

// 使用ImageRecordReader读取图像数据,设置图像尺寸和通道数

org.deeplearning4j.datasets.iterator.impl.ImageRecordReader recordReader = new org.deeplearning4j.datasets.iterator.impl.ImageRecordReader(height, width, channels);

// 使用FileSplit将数据目录按文件进行分割

recordReader.initialize(new org.deeplearning4j.datasets.filters.impl.FileSplit(new File(dataDir)));

// 数据归一化,将像素值缩放到0-1范围

org.nd4j.linalg.dataset.api.preprocessor.DataNormalization scaler = new org.nd4j.linalg.dataset.api.preprocessor.ImagePreProcessingScaler(0, 1);

// 创建数据集迭代器,设置标签索引为1,输出类别数为3(假设)

DataSetIterator dataIter = new org.deeplearning4j.datasets.iterator.impl.RecordReaderDataSetIterator(recordReader, batchSize, 1, 3);

dataIter.setPreProcessor(scaler);

return dataIter;

} catch (IOException | InterruptedException e) {

e.printStackTrace();

return null;

}

}

}

2.2.3 音频数据特征提取

可提取梅尔频率倒谱系数(MFCC)、频谱质心等特征。如前所述,通过 Librosa 库(在 Jython 环境下)可方便地提取 MFCC 特征。

多模态数据融合方法主要有早期融合、晚期融合和混合融合。

2.2.4 早期融合

是在特征提取阶段将不同模态的数据进行融合,例如将文本的 TF - IDF 特征向量和图像的 CNN 提取的特征向量直接拼接成一个新的特征向量。以下是一个简单的早期融合示例代码,将文本的 TF - IDF 特征和图像的 VGG16 提取的特征进行拼接:

import org.apache.commons.math3.linear.RealMatrix;

import org.nd4j.linalg.api.ndarray.INDArray;

import org.nd4j.linalg.factory.Nd4j;

public class MultimodalFusion {

public static INDArray earlyFusion(RealMatrix textFeatures, INDArray imageFeatures) {

//将文本特征矩阵转换为ND4j的INDArray

double[][] textArray = textFeatures.getData();

INDArray textNd4j = Nd4j.create(textArray);

//按水平方向拼接文本特征和图像特征

INDArray fusedFeatures = Nd4j.hstack(textNd4j, imageFeatures);

return fusedFeatures;

}

}

2.2.5 晚期融合

则是在模型预测阶段,将不同模态数据训练的模型预测结果进行融合,比如通过投票法、加权平均法等确定最终预测结果。例如,假设有两个模型,一个基于文本数据训练,另一个基于图像数据训练,在晚期融合时:

//假设textModel和imageModel分别是基于文本和图像训练好的模型

//假设testTextData和testImageData是待预测的文本和图像数据

INDArray textPredictions = textModel.output(testTextData);

INDArray imagePredictions = imageModel.output(testImageData);

//投票法示例,假设预测结果是类别索引

int[] textIndices = textPredictions.argMax(1).toIntVector();

int[] imageIndices = imagePredictions.argMax(1).toIntVector();

int[] finalPredictions = new int[textIndices.length];

for (int i = 0; i < textIndices.length; i++) {

if (textIndices[i] == imageIndices[i]) {

finalPredictions[i] = textIndices[i];

} else {

//简单处理,这里可以根据实际情况调整投票规则

finalPredictions[i] = textIndices[i];

}

}

2.2.6 混合融合

结合了早期融合和晚期融合的特点,先在某些阶段对部分模态进行早期融合,再在后续阶段结合其他模态进行晚期融合。由于实现较为复杂,此处暂不展开代码示例,但大致流程如下:

三、基于 Java 的多模态融合机器学习模型构建与训练

3.1 常见多模态融合机器学习模型介绍

常见的多模态融合机器学习模型有基于神经网络的融合模型,如多模态多层感知机(Multimodal MLP)、多模态卷积神经网络(Multimodal CNN)以及循环神经网络(RNN)的多模态扩展等。

3.1.1 多模态多层感知机

通过将不同模态的特征向量输入到一个全连接神经网络中进行学习,能够处理多种类型的输入数据。例如,在一个简单的情感分析任务中,将文本的词向量特征和图像的全局特征向量输入到多模态多层感知机中,经过多个全连接层的计算,输出情感类别预测结果。其网络结构可以简单表示为:

3.1.2 多模态卷积神经网络

则针对图像等结构化数据,在卷积层之前或之后进行多模态数据融合,充分利用卷积神经网络对图像特征的强大提取能力。例如,在图像 - 文本多模态情感分析任务中,先通过卷积神经网络提取图像的视觉特征,如颜色、纹理、物体形状等特征,同时利用自然语言处理技术提取文本中的语义特征,然后将两者特征进行融合,输入到后续的全连接层进行情感分类。以图像 - 文本融合为例,其结构如下:

3.1.3 循环神经网络(RNN)及其变体长短期记忆网络(LSTM)、门控循环单元(GRU)的多模态扩展

对于处理具有时间序列特性的多模态数据,如视频(包含随时间变化的图像序列和音频)、语音与对应的文字转录等非常有效。以视频动作识别为例,多模态 RNN 可以同时学习视频帧序列中的视觉信息以及对应的音频信息,通过记忆单元捕捉时间序列中的长期依赖关系,从而准确识别视频中的动作类别。以视频动作识别模型为例,其结构示意如下:

3.2 基于 Java 的多模态融合模型构建实例

我们以构建一个简单的图像 - 文本多模态分类模型为例,使用 Deeplearning4j 库在 Java 中实现。假设我们要对包含产品图片和产品描述的数据集进行分类,判断产品所属的类别(如电子产品、服装、食品等)。

首先,在项目的 pom.xml 文件中添加 Deeplearning4j 相关依赖:

<dependency>

<groupId>org.deeplearning4jgroupId>

<artifactId>deeplearning4j - nnartifactId>

<version>1.0.0 - beta7version>

dependency>

<dependency>

<groupId>org.deeplearning4jgroupId>

<artifactId>deeplearning4j - dataartifactId>

<version>1.0.0 - beta7version>

dependency>

<dependency>

<groupId>org.nd4jgroupId>

<artifactId>nd4j - native - platformartifactId>

<version>1.0.0 - beta7version>

dependency>

然后,进行数据加载与预处理。

3.2.1 图像数据加载与预处理

我们使用 ImageRecordReader 读取并进行预处理:

import org.deeplearning4j.datasets.iterator.impl.ImageRecordReader;

import org.nd4j.linalg.dataset.api.iterator.DataSetIterator;

import org.nd4j.linalg.dataset.api.preprocessor.DataNormalization;

import org.nd4j.linalg.dataset.api.preprocessor.ImagePreProcessingScaler;

public class ImageDataLoader {

public static DataSetIterator loadImageData(String dataDir, int batchSize, int height, int width, int channels) {

try {

ImageRecordReader recordReader = new ImageRecordReader(height, width, channels);

//初始化ImageRecordReader,传入数据目录

recordReader.initialize(new FileSplit(new File(dataDir)));

DataNormalization scaler = new ImagePreProcessingScaler(0, 1);

//创建数据集迭代器,设置标签索引为1,输出类别数为实际类别数(假设为3)

DataSetIterator dataIter = new RecordReaderDataSetIterator(recordReader, batchSize, 1, 3);

dataIter.setPreProcessor(scaler);

return dataIter;

} catch (IOException | InterruptedException e) {

e.printStackTrace();

return null;

}

}

}

3.2.2 文本数据加载与预处理

我们使用 SentenceDataSetIterator 进行加载和预处理,假设已经将文本数据转换为词向量表示(这里使用预训练的词向量模型,如 Word2Vec):

import org.deeplearning4j.datasets.iterator.impl.SentenceDataSetIterator;

import org.nd4j.linalg.api.ndarray.INDArray;

import org.nd4j.linalg.dataset.api.iterator.DataSetIterator;

import org.nd4j.linalg.factory.Nd4j;

import org.nd4j.linalg.indexing.NDArrayIndex;

import org.nd4j.linalg.ops.transforms.Transforms;

import java.io.BufferedReader;

import java.io.FileReader;

import java.io.IOException;

import java.util.ArrayList;

import java.util.List;

public class TextDataLoader {

public static DataSetIterator loadTextData(String dataFile, int batchSize, int vectorSize) {

List<INDArray> featuresList = new ArrayList<>();

List<INDArray> labelsList = new ArrayList<>();

try (BufferedReader br = new BufferedReader(new FileReader(dataFile))) {

String line;

while ((line = br.readLine())!= null) {

String[] parts = line.split("\t");

String text = parts[0];

int label = Integer.parseInt(parts[1]);

INDArray vector = getTextVector(text, vectorSize);

featuresList.add(vector);

INDArray labelArray = Nd4j.zeros(1, numClasses);

labelArray.putScalar(0, label, 1);

labelsList.add(labelArray);

}

} catch (IOException e) {

e.printStackTrace();

}

INDArray features = Nd4j.stack(0, featuresList.toArray(new INDArray[0]));

INDArray labels = Nd4j.stack(0, labelsList.toArray(new INDArray[0]));

return new SentenceDataSetIterator(features, labels, batchSize);

}

private static INDArray getTextVector(String text, int vectorSize) {

//这里使用简单的随机初始化向量模拟词向量,实际应用中需要根据具体的词向量模型实现

INDArray vector = Nd4j.randn(1, vectorSize);

return vector;

}

}

接下来构建多模态融合模型。我们采用早期融合方式,将图像特征和文本特征在输入层进行拼接:

import org.deeplearning4j.nn.conf.MultiLayerConfiguration;

import org.deeplearning4j.nn.conf.NeuralNetConfiguration;

import org.deeplearning4j.nn.conf.layers.DenseLayer;

import org.deeplearning4j.nn.conf.layers.OutputLayer;

import org.deeplearning4j.nn.multilayer.MultiLayerNetwork;

import org.nd4j.linalg.activations.Activation;

import org.nd4j.linalg.api.ndarray.INDArray;

import org.nd4j.linalg.dataset.DataSet;

import org.nd4j.linalg.dataset.api.iterator.DataSetIterator;

import org.nd4j.linalg.lossfunctions.LossFunctions;

public class MultimodalModelBuilder {

public static MultiLayerNetwork buildModel(int imageFeatureSize, int textFeatureSize, int numClasses) {

MultiLayerConfiguration conf = new NeuralNetConfiguration.Builder()

.seed(12345)

.updater(new Nesterovs(0.001, 0.9))

.list()

.layer(0, new DenseLayer.Builder()

.nIn(imageFeatureSize + textFeatureSize)

.nOut(100)

.activation(Activation.RELU)

.build())

.layer(1, new OutputLayer.Builder(LossFunctions.LossFunction.NEGATIVELOGLIKELIHOOD)

.nIn(100)

.nOut(numClasses)

.activation(Activation.SOFTMAX)

.build())

.build();

return new MultiLayerNetwork(conf);

}

}

最后进行模型训练:

public class ModelTrainer {

public static void trainModel(MultiLayerNetwork model, DataSetIterator imageIter, DataSetIterator textIter, int numEpochs) {

for (int i = 0; i < numEpochs; i++) {

while (imageIter.hasNext() && textIter.hasNext()) {

DataSet imageDs = imageIter.next();

DataSet textDs = textIter.next();

INDArray imageFeatures = imageDs.getFeatures();

INDArray textFeatures = textDs.getFeatures();

INDArray combinedFeatures = Nd4j.hstack(imageFeatures, textFeatures);

DataSet combinedDs = new DataSet(combinedFeatures, imageDs.getLabels());

model.fit(combinedDs);

}

imageIter.reset();

textIter.reset();

}

}

}

3.3 模型训练过程优化与调参

在模型训练过程中,优化与调参是提升模型性能的关键步骤。

3.3.1 优化算法

常见的优化算法如随机梯度下降(SGD)及其变种 Adagrad、Adadelta、RMSProp、Adam 等,在多模态融合模型训练中都有广泛应用。以 Adam 优化算法为例,在 Deeplearning4j 中只需在模型配置时指定即可:

MultiLayerConfiguration conf = new NeuralNetConfiguration.Builder()

.seed(12345)

.updater(new Adam(0.001))

//其他模型配置参数

.build();

3.3.2 调参方法

超参数如学习率、隐藏层节点数、正则化参数等对模型性能影响显著。可以使用网格搜索(Grid Search)或随机搜索(Random Search)方法来寻找最优超参数组合。以网格搜索为例,通过定义一个超参数值的网格,对每个组合进行模型训练和评估,选择性能最优的组合作为最终超参数:

import org.deeplearning4j.nn.conf.MultiLayerConfiguration;

import org.deeplearning4j.nn.conf.NeuralNetConfiguration;

import org.deeplearning4j.nn.conf.layers.DenseLayer;

import org.deeplearning4j.nn.conf.layers.OutputLayer;

import org.deeplearning4j.nn.multilayer.MultiLayerNetwork;

import org.deeplearning4j.nn.weights.WeightInit;

import org.deeplearning4j.optimize.listeners.ScoreIterationListener;

import org.nd4j.linalg.activations.Activation;

import org.nd4j.linalg.api.ndarray.INDArray;

import org.nd4j.linalg.dataset.DataSet;

import org.nd4j.linalg.dataset.api.iterator.DataSetIterator;

import org.nd4j.linalg.lossfunctions.LossFunctions;

import org.nd4j.linalg.ops.transforms.Transforms;

import java.util.ArrayList;

import java.util.HashMap;

import java.util.List;

import java.util.Map;

public class HyperparameterTuning {

// 假设的输入特征维度

private static final int inputSize = 10;

// 假设的输出类别数

private static final int outputSize = 2;

// 训练轮数

private static final int numEpochs = 10;

public static void main(String[] args) {

// 定义不同的隐藏层大小

int[] hiddenLayerSizes = {50, 100, 150};

// 定义不同的学习率

double[] learningRates = {0.001, 0.01, 0.1};

// 用于存储最佳超参数组合

Map<String, Double> bestParams = new HashMap<>();

// 用于存储最佳得分

double bestScore = Double.MAX_VALUE;

// 遍历不同的隐藏层大小

for (int hiddenSize : hiddenLayerSizes) {

// 遍历不同的学习率

for (double learningRate : learningRates) {

// 构建神经网络配置

MultiLayerConfiguration conf = new NeuralNetConfiguration.Builder()

.seed(12345)

.weightInit(WeightInit.XAVIER)

.updater(new org.nd4j.linalg.learning.config.Adam(learningRate))

.list()

.layer(0, new DenseLayer.Builder()

.nIn(inputSize)

.nOut(hiddenSize)

.activation(Activation.RELU)

.build())

.layer(1, new OutputLayer.Builder(LossFunctions.LossFunction.NEGATIVELOGLIKELIHOOD)

.nIn(hiddenSize)

.nOut(outputSize)

.activation(Activation.SOFTMAX)

.build())

.build();

// 根据配置初始化神经网络模型

MultiLayerNetwork model = new MultiLayerNetwork(conf);

model.init();

// 设置每10次迭代输出一次得分

model.setListeners(new ScoreIterationListener(10));

// 假设已有训练数据集迭代器trainIter和测试数据集迭代器testIter

DataSetIterator trainIter = getTrainIterator();

DataSetIterator testIter = getTestIterator();

// 训练模型

for (int i = 0; i < numEpochs; i++) {

model.fit(trainIter);

trainIter.reset();

}

// 评估模型

double score = evaluateModel(model, testIter);

if (score < bestScore) {

bestScore = score;

bestParams.put("hiddenSize", (double) hiddenSize);

bestParams.put("learningRate", learningRate);

}

testIter.reset();

}

}

System.out.println("Best hyperparameters: " + bestParams);

System.out.println("Best score: " + bestScore);

}

/**

* 评估模型

* @param model 神经网络模型

* @param testIter 测试数据集迭代器

* @return 模型的平均损失

*/

private static double evaluateModel(MultiLayerNetwork model, DataSetIterator testIter) {

double totalLoss = 0;

int totalExamples = 0;

while (testIter.hasNext()) {

DataSet ds = testIter.next();

INDArray output = model.output(ds.getFeatures());

double loss = model.score(ds);

totalLoss += loss * ds.getFeatures().size(0);

totalExamples += ds.getFeatures().size(0);

}

return totalLoss / totalExamples;

}

/**

* 获取训练数据集迭代器

* 此方法需要根据实际情况实现

* @return 训练数据集迭代器

*/

private static DataSetIterator getTrainIterator() {

// 实现训练数据集迭代器的创建逻辑

return null;

}

/**

* 获取测试数据集迭代器

* 此方法需要根据实际情况实现

* @return 测试数据集迭代器

*/

private static DataSetIterator getTestIterator() {

// 实现测试数据集迭代器的创建逻辑

return null;

}

}

四、多模态融合模型的评估与应用

4.1 多模态融合模型的评估指标

在评估多模态融合模型时,通常会使用与单模态模型类似的评估指标,但需要综合考虑不同模态数据的特点。

4.1.1 准确率(Accuracy)

是最常用的评估指标之一,它表示模型预测正确的样本数占总样本数的比例。在多模态分类任务中,准确率可以直观地反映模型整体的分类性能。例如,在一个包含图像和文本的产品分类任务中,如果总共有 100 个样本,模型正确分类了 80 个样本,那么准确率就是 80%。

import org.deeplearning4j.eval.Evaluation;

import org.nd4j.linalg.api.ndarray.INDArray;

import org.nd4j.linalg.dataset.DataSet;

import org.nd4j.linalg.dataset.api.iterator.DataSetIterator;

public class ModelEvaluator {

public static double calculateAccuracy(MultiLayerNetwork model, DataSetIterator testIter) {

Evaluation eval = new Evaluation();

while (testIter.hasNext()) {

DataSet ds = testIter.next();

INDArray output = model.output(ds.getFeatures());

eval.eval(ds.getLabels(), output);

}

return eval.accuracy();

}

}

4.1.2 精确率(Precision)、召回率(Recall)和 F1 值(F1 - score)

这些指标对于处理不平衡数据集非常有用。精确率表示模型预测为正类的样本中实际为正类的比例;召回率表示实际为正类的样本中被模型正确预测为正类的比例;F1 值是精确率和召回率的调和平均数,它综合考虑了精确率和召回率。

public class ModelMetrics {

public static void printMetrics(MultiLayerNetwork model, DataSetIterator testIter) {

Evaluation eval = new Evaluation();

while (testIter.hasNext()) {

DataSet ds = testIter.next();

INDArray output = model.output(ds.getFeatures());

eval.eval(ds.getLabels(), output);

}

System.out.println("Precision: " + eval.precision());

System.out.println("Recall: " + eval.recall());

System.out.println("F1 - score: " + eval.f1());

}

}

4.1.3 均方误差(Mean Squared Error, MSE)

在多模态回归任务中,均方误差是常用的评估指标,它衡量了模型预测值与真实值之间的平均平方误差。

import org.nd4j.linalg.activations.Activation;

import org.nd4j.linalg.lossfunctions.LossFunctions;

import org.deeplearning4j.nn.conf.MultiLayerConfiguration;

import org.deeplearning4j.nn.conf.NeuralNetConfiguration;

import org.deeplearning4j.nn.conf.layers.DenseLayer;

import org.deeplearning4j.nn.conf.layers.OutputLayer;

import org.deeplearning4j.nn.multilayer.MultiLayerNetwork;

import org.nd4j.linalg.api.ndarray.INDArray;

import org.nd4j.linalg.dataset.DataSet;

import org.nd4j.linalg.dataset.api.iterator.DataSetIterator;

import org.nd4j.linalg.ops.transforms.Transforms;

public class RegressionEvaluator {

public static double calculateMSE(MultiLayerNetwork model, DataSetIterator testIter) {

double totalMSE = 0;

int totalExamples = 0;

while (testIter.hasNext()) {

DataSet ds = testIter.next();

INDArray output = model.output(ds.getFeatures());

INDArray labels = ds.getLabels();

INDArray diff = output.sub(labels);

INDArray squaredDiff = Transforms.pow(diff, 2);

double mse = squaredDiff.meanNumber().doubleValue();

totalMSE += mse * ds.getFeatures().size(0);

totalExamples += ds.getFeatures().size(0);

}

return totalMSE / totalExamples;

}

}

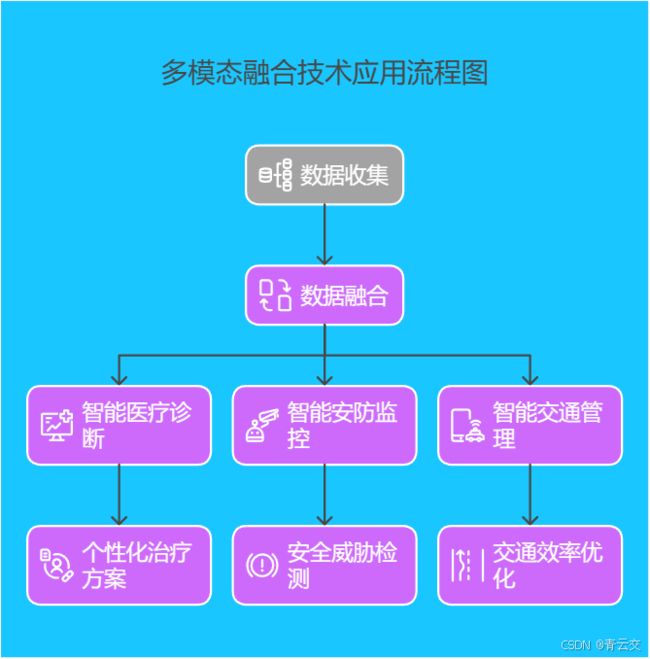

4.2 多模态融合模型在实际场景中的应用案例

4.2.1 智能医疗诊断

在医疗领域,多模态融合技术可以将患者的病历文本、医学影像(如 X 光、CT、MRI 等)以及基因测序数据进行融合分析。例如,通过分析病历文本可以了解患者的症状、病史和家族病史等信息;医学影像能够直观地显示身体内部的结构和病变情况;基因测序数据则可以揭示患者的遗传特征和潜在的疾病风险。将这些多模态数据融合后输入到机器学习模型中,医生可以更准确地进行疾病诊断、制定个性化的治疗方案。

4.2.2 智能安防监控

在安防监控场景中,多模态融合技术结合了视频监控图像、音频信息和传感器数据。视频图像可以实时捕捉监控区域内的人员活动和物体状态;音频信息可以检测异常声音,如呼喊声、警报声等;传感器数据可以提供环境参数,如温度、湿度、烟雾浓度等。通过融合这些多模态数据,安防系统能够更及时、准确地发现安全威胁,如入侵行为、火灾隐患等,并及时发出警报。

4.2.3 智能交通管理

在智能交通领域,多模态融合技术可以整合交通摄像头的视频图像、车辆传感器数据(如速度、加速度、位置信息等)以及交通流量统计数据。通过对这些多模态数据的分析,交通管理部门可以实时监测交通状况,预测交通拥堵情况,优化交通信号灯的控制策略,提高道路通行效率。

结束语:

亲爱的 Java 和 大数据爱好者们,基于 Java 的大数据机器学习模型的多模态融合技术在近年来取得了显著进展。随着数据采集技术不断进步,多模态数据获取变得更便捷,为技术发展提供了丰富资源。深度学习算法的持续创新,让多模态融合模型性能得以提升,在众多领域成功落地应用。然而,该技术仍面临多模态数据不一致、数据缺失与噪声、模型可解释性及计算效率等挑战。

未来,多模态融合技术有望朝着更深入融合方法发展,拓展跨领域应用,并与新兴技术紧密结合。但与此同时,必须着力解决数据隐私安全、模型可解释性及计算资源需求等难题。相信在科研人员与开发者的共同努力下,这项前沿技术将不断突破,为各行业带来更多创新变革机遇。

亲爱的 Java 和 大数据爱好者们,接下来,让我们满怀期待地迎接《大数据新视界》和《 Java 大视界》专栏联合推出的第三个三阶段系列的最后一篇文章《Java 大视界 – Java 大数据在智慧农业精准灌溉与施肥决策中的应用(144)》将聚焦智慧农业领域,探索 Java 大数据如何助力农业生产实现精准化管理。让我们共同期待在农业场景下,Java 大数据与多模态融合技术碰撞出的新火花。

亲爱的 Java 和 大数据爱好者们,对于多模态融合技术在实际应用中遇到的挑战,你认为哪个最亟待解决?欢迎在评论区或【青云交社区 – Java 大视界频道】分享你的看法。

诚邀各位参与投票,你认为多模态融合技术在未来哪个领域最具发展潜力?快来投出你的宝贵一票,点此链接投票 。

- Java 大视界 – Java 大数据在智能体育赛事直播数据分析与观众互动优化中的应用(142)(最新)

- Java 大视界 – Java 大数据中的知识图谱可视化与交互分析技术(141)(最新)

- Java 大视界 – Java 大数据在智能家居设备联动与场景自动化中的应用(140)(最新)

- Java 大视界 – 基于 Java 的大数据分布式存储系统的数据备份与恢复策略(139)(最新)

- Java 大视界 – Java 大数据在智能政务舆情引导与公共危机管理中的应用(138)(最新)

- Java 大视界 – Java 大数据机器学习模型的对抗攻击与防御技术研究(137)(最新)

- Java 大视界 – Java 大数据在智慧交通自动驾驶仿真与测试数据处理中的应用(136)(最新)

- Java 大视界 – 基于 Java 的大数据实时流处理中的窗口操作与时间语义详解(135)(最新)

- Java 大视界 – Java 大数据在智能金融资产定价与风险管理中的应用(134)(最新)

- Java 大视界 – Java 大数据中的异常检测算法在工业物联网中的应用与优化(133)(最新)

- Java 大视界 – Java 大数据在智能教育虚拟实验室建设与实验数据分析中的应用(132)(最新)

- Java 大视界 – Java 大数据分布式计算中的资源调度与优化策略(131)(最新)

- Java 大视界 – Java 大数据在智慧文旅虚拟导游与个性化推荐中的应用(130)(最新)

- Java 大视界 – 基于 Java 的大数据机器学习模型的迁移学习应用与实践(129)(最新)

- Java 大视界 – Java 大数据在智能安防视频摘要与检索技术中的应用(128)(最新)

- Java 大视界 – Java 大数据中的数据可视化大屏设计与开发实战(127)(最新)

- Java 大视界 – Java 大数据在智能医疗药品研发数据分析与决策支持中的应用(126)(最新)

- Java 大视界 – 基于 Java 的大数据分布式数据库架构设计与实践(125)(最新)

- Java 大视界 – Java 大数据在智慧农业农产品质量追溯与品牌建设中的应用(124)(最新)

- Java 大视界 – Java 大数据机器学习模型的在线评估与持续优化(123)(最新)

- Java 大视界 – Java 大数据在智能体育赛事运动员表现分析与训练优化中的应用(122)(最新)

- Java 大视界 – 基于 Java 的大数据实时数据处理框架性能评测与选型建议(121)(最新)

- Java 大视界 – Java 大数据在智能家居能源管理与节能优化中的应用(120)(最新)

- Java 大视界 – Java 大数据中的知识图谱补全技术与应用实践(119)(最新)

- 通义万相 2.1 携手蓝耘云平台:开启影视广告创意新纪元(最新)

- Java 大视界 – Java 大数据在智能政务公共服务资源优化配置中的应用(118)(最新)

- Java 大视界 – 基于 Java 的大数据分布式任务调度系统设计与实现(117)(最新)

- Java 大视界 – Java 大数据在智慧交通信号灯智能控制中的应用(116)(最新)

- Java 大视界 – Java 大数据机器学习模型的超参数优化技巧与实践(115)(最新)

- Java 大视界 – Java 大数据在智能金融反欺诈中的技术实现与案例分析(114)(最新)

- Java 大视界 – 基于 Java 的大数据流处理容错机制与恢复策略(113)(最新)

- Java 大视界 – Java 大数据在智能教育考试评估与学情分析中的应用(112)(最新)

- Java 大视界 – Java 大数据中的联邦学习激励机制设计与实践(111)(最新)

- Java 大视界 – Java 大数据在智慧文旅游客流量预测与景区运营优化中的应用(110)(最新)

- Java 大视界 – 基于 Java 的大数据分布式缓存一致性维护策略解析(109)(最新)

- Java 大视界 – Java 大数据在智能安防入侵检测与行为分析中的应用(108)(最新)

- Java 大视界 – Java 大数据机器学习模型的可解释性增强技术与应用(107)(最新)

- Java 大视界 – Java 大数据在智能医疗远程诊断中的技术支撑与挑战(106)(最新)

- Java 大视界 – 基于 Java 的大数据可视化交互设计与实现技巧(105)(最新)

- Java 大视界 – Java 大数据在智慧环保污染源监测与预警中的应用(104)(最新)

- Java 大视界 – Java 大数据中的时间序列数据异常检测算法对比与实践(103)(最新)

- Java 大视界 – Java 大数据在智能物流路径规划与车辆调度中的创新应用(102)(最新)

- Java 大视界 – Java 大数据分布式文件系统的性能调优实战(101)(最新)

- Java 大视界 – Java 大数据在智慧能源微电网能量管理中的关键技术(100)(最新)

- Java 大视界 – 基于 Java 的大数据机器学习模型压缩与部署优化(99)(最新)

- Java 大视界 – Java 大数据在智能零售动态定价策略中的应用实战(98)(最新)

- Java 大视界 – 深入剖析 Java 大数据实时 ETL 中的数据质量保障策略(97)(最新)

- Java 大视界 – 总结与展望:Java 大数据领域的新征程与无限可能(96)(最新)

- 技术逐梦十二载:CSDN 相伴,400 篇文章见证成长,展望新篇(最新)

- Java 大视界 – Java 大数据未来十年的技术蓝图与发展愿景(95)(最新)

- Java 大视界 – 国际竞争与合作:Java 大数据在全球市场的机遇与挑战(94)(最新)

- Java 大视界 – 企业数字化转型中的 Java 大数据战略与实践(93)(最新)

- Java 大视界 – 人才需求与培养:Java 大数据领域的职业发展路径(92)(最新)

- Java 大视界 – 开源社区对 Java 大数据发展的推动与贡献(91)(最新)

- Java 大视界 – 绿色大数据:Java 技术在节能减排中的应用与实践(90)(最新)

- Java 大视界 – 全球数据治理格局下 Java 大数据的发展路径(89)(最新)

- Java 大视界 – 量子计算时代 Java 大数据的潜在变革与应对策略(88)(最新)

- Java 大视界 – 大数据伦理与法律:Java 技术在合规中的作用与挑战(87)(最新)

- Java 大视界 – 云计算时代 Java 大数据的云原生架构与应用实践(86)(最新)

- Java 大视界 – 边缘计算与 Java 大数据协同发展的前景与挑战(85)(最新)

- Java 大视界 – 区块链赋能 Java 大数据:数据可信与价值流转(84)(最新)

- Java 大视界 – 人工智能驱动下 Java 大数据的技术革新与应用突破(83)(最新)

- Java 大视界 – 5G 与 Java 大数据融合的行业应用与发展趋势(82)(最新)

- Java 大视界 – 后疫情时代 Java 大数据在各行业的变革与机遇(81)(最新)

- Java 大视界 – Java 大数据在智能体育中的应用与赛事分析(80)(最新)

- Java 大视界 – Java 大数据在智能家居中的应用与场景构建(79)(最新)

- 解锁 DeepSeek 模型高效部署密码:蓝耘平台深度剖析与实战应用(最新)

- Java 大视界 – Java 大数据在智能政务中的应用与服务创新(78)(最新)

- Java 大视界 – Java 大数据在智能金融监管中的应用与实践(77)(最新)

- Java 大视界 – Java 大数据在智能供应链中的应用与优化(76)(最新)

- 解锁 DeepSeek 模型高效部署密码:蓝耘平台全解析(最新)

- Java 大视界 – Java 大数据在智能教育中的应用与个性化学习(75)(最新)

- Java 大视界 – Java 大数据在智慧文旅中的应用与体验优化(74)(最新)

- Java 大视界 – Java 大数据在智能安防中的应用与创新(73)(最新)

- Java 大视界 – Java 大数据在智能医疗影像诊断中的应用(72)(最新)

- Java 大视界 – Java 大数据在智能电网中的应用与发展趋势(71)(最新)

- Java 大视界 – Java 大数据在智慧农业中的应用与实践(70)(最新)

- Java 大视界 – Java 大数据在量子通信安全中的应用探索(69)(最新)

- Java 大视界 – Java 大数据在自动驾驶中的数据处理与决策支持(68)(最新)

- Java 大视界 – Java 大数据在生物信息学中的应用与挑战(67)(最新)

- Java 大视界 – Java 大数据与碳中和:能源数据管理与碳排放分析(66)(最新)

- Java 大视界 – Java 大数据在元宇宙中的关键技术与应用场景(65)(最新)

- Java 大视界 – Java 大数据中的隐私增强技术全景解析(64)(最新)

- Java 大视界 – Java 大数据中的自然语言生成技术与实践(63)(最新)

- Java 大视界 – Java 大数据中的知识图谱构建与应用(62)(最新)

- Java 大视界 – Java 大数据中的异常检测技术与应用(61)(最新)

- Java 大视界 – Java 大数据中的数据脱敏技术与合规实践(60)(最新)

- Java 大视界 – Java 大数据中的时间序列预测高级技术(59)(最新)

- Java 大视界 – Java 与大数据分布式机器学习平台搭建(58)(最新)

- Java 大视界 – Java 大数据中的强化学习算法实践与优化 (57)(最新)

- Java 大视界 – Java 大数据中的深度学习框架对比与选型(56)(最新)

- Java 大视界 – Java 大数据实时数仓的构建与运维实践(55)(最新)

- Java 大视界 – Java 与大数据联邦数据库:原理、架构与实现(54)(最新)

- Java 大视界 – Java 大数据中的图神经网络应用与实践(53)(最新)

- Java 大视界 – 深度洞察 Java 大数据安全多方计算的前沿趋势与应用革新(52)(最新)

- Java 大视界 – Java 与大数据流式机器学习:理论与实战(51)(最新)

- Java 大视界 – 基于 Java 的大数据分布式索引技术探秘(50)(最新)

- Java 大视界 – 深入剖析 Java 在大数据内存管理中的优化策略(49)(最新)

- Java 大数据未来展望:新兴技术与行业变革驱动(48)(最新)

- Java 大数据自动化数据管道构建:工具与最佳实践(47)(最新)

- Java 大数据实时数据同步:基于 CDC 技术的实现(46)(最新)

- Java 大数据与区块链的融合:数据可信共享与溯源(45)(最新)

- Java 大数据数据增强技术:提升数据质量与模型效果(44)(最新)

- Java 大数据模型部署与运维:生产环境的挑战与应对(43)(最新)

- Java 大数据无监督学习:聚类与降维算法应用(42)(最新)

- Java 大数据数据虚拟化:整合异构数据源的策略(41)(最新)

- Java 大数据可解释人工智能(XAI):模型解释工具与技术(40)(最新)

- Java 大数据高性能计算:利用多线程与并行计算框架(39)(最新)

- Java 大数据时空数据处理:地理信息系统与时间序列分析(38)(最新)

- Java 大数据图计算:基于 GraphX 与其他图数据库(37)(最新)

- Java 大数据自动化机器学习(AutoML):框架与应用案例(36)(最新)

- Java 与大数据隐私计算:联邦学习与安全多方计算应用(35)(最新)

- Java 驱动的大数据边缘计算:架构与实践(34)(最新)

- Java 与量子计算在大数据中的潜在融合:原理与展望(33)(最新)

- Java 大视界 – Java 大数据星辰大海中的团队协作之光:照亮高效开发之路(十六)(最新)

- Java 大视界 – Java 大数据性能监控与调优:全链路性能分析与优化(十五)(最新)

- Java 大视界 – Java 大数据数据治理:策略与工具实现(十四)(最新)

- Java 大视界 – Java 大数据云原生应用开发:容器化与无服务器计算(十三)(最新)

- Java 大视界 – Java 大数据数据湖架构:构建与管理基于 Java 的数据湖(十二)(最新)

- Java 大视界 – Java 大数据分布式事务处理:保障数据一致性(十一)(最新)

- Java 大视界 – Java 大数据文本分析与自然语言处理:从文本挖掘到智能对话(十)(最新)

- Java 大视界 – Java 大数据图像与视频处理:基于深度学习与大数据框架(九)(最新)

- Java 大视界 – Java 大数据物联网应用:数据处理与设备管理(八)(最新)

- Java 大视界 – Java 与大数据金融科技应用:风险评估与交易分析(七)(最新)

- 蓝耘元生代智算云:解锁百亿级产业变革的算力密码(最新)

- Java 大视界 – Java 大数据日志分析系统:基于 ELK 与 Java 技术栈(六)(最新)

- Java 大视界 – Java 大数据分布式缓存:提升数据访问性能(五)(最新)

- Java 大视界 – Java 与大数据智能推荐系统:算法实现与个性化推荐(四)(最新)

- Java 大视界 – Java 大数据机器学习应用:从数据预处理到模型训练与部署(三)(最新)

- Java 大视界 – Java 与大数据实时分析系统:构建低延迟的数据管道(二)(最新)

- Java 大视界 – Java 微服务架构在大数据应用中的实践:服务拆分与数据交互(一)(最新)

- Java 大视界 – Java 大数据项目架构演进:从传统到现代化的转变(十六)(最新)

- Java 大视界 – Java 与大数据云计算集成:AWS 与 Azure 实践(十五)(最新)

- Java 大视界 – Java 大数据平台迁移与升级策略:平滑过渡的方法(十四)(最新)

- Java 大视界 – Java 大数据分析算法库:常用算法实现与优化(十三)(最新)

- Java 大视界 – Java 大数据测试框架与实践:确保数据处理质量(十二)(最新)

- Java 大视界 – Java 分布式协调服务:Zookeeper 在大数据中的应用(十一)(最新)

- Java 大视界 – Java 与大数据存储优化:HBase 与 Cassandra 应用(十)(最新)

- Java 大视界 – Java 大数据可视化:从数据处理到图表绘制(九)(最新)

- Java 大视界 – Java 大数据安全框架:保障数据隐私与访问控制(八)(最新)

- Java 大视界 – Java 与 Hive:数据仓库操作与 UDF 开发(七)(最新)

- Java 大视界 – Java 驱动大数据流处理:Storm 与 Flink 入门(六)(最新)

- Java 大视界 – Java 与 Spark SQL:结构化数据处理与查询优化(五)(最新)

- Java 大视界 – Java 开发 Spark 应用:RDD 操作与数据转换(四)(最新)

- Java 大视界 – Java 实现 MapReduce 编程模型:基础原理与代码实践(三)(最新)

- Java 大视界 – 解锁 Java 与 Hadoop HDFS 交互的高效编程之道(二)(最新)

- Java 大视界 – Java 构建大数据开发环境:从 JDK 配置到大数据框架集成(一)(最新)

- 大数据新视界 – Hive 多租户资源分配与隔离(2 - 16 - 16)(最新)

- 大数据新视界 – Hive 多租户环境的搭建与管理(2 - 16 - 15)(最新)

- 技术征途的璀璨华章:青云交的砥砺奋进与感恩之心(最新)

- 大数据新视界 – Hive 集群性能监控与故障排查(2 - 16 - 14)(最新)

- 大数据新视界 – Hive 集群搭建与配置的最佳实践(2 - 16 - 13)(最新)

- 大数据新视界 – Hive 数据生命周期自动化管理(2 - 16 - 12)(最新)

- 大数据新视界 – Hive 数据生命周期管理:数据归档与删除策略(2 - 16 - 11)(最新)

- 大数据新视界 – Hive 流式数据处理框架与实践(2 - 16 - 10)(最新)

- 大数据新视界 – Hive 流式数据处理:实时数据的接入与处理(2 - 16 - 9)(最新)

- 大数据新视界 – Hive 事务管理的应用与限制(2 - 16 - 8)(最新)

- 大数据新视界 – Hive 事务与 ACID 特性的实现(2 - 16 - 7)(最新)

- 大数据新视界 – Hive 数据倾斜实战案例分析(2 - 16 - 6)(最新)

- 大数据新视界 – Hive 数据倾斜问题剖析与解决方案(2 - 16 - 5)(最新)

- 大数据新视界 – Hive 数据仓库设计的优化原则(2 - 16 - 4)(最新)

- 大数据新视界 – Hive 数据仓库设计模式:星型与雪花型架构(2 - 16 - 3)(最新)

- 大数据新视界 – Hive 数据抽样实战与结果评估(2 - 16 - 2)(最新)

- 大数据新视界 – Hive 数据抽样:高效数据探索的方法(2 - 16 - 1)(最新)

- 智创 AI 新视界 – 全球合作下的 AI 发展新机遇(16 - 16)(最新)

- 智创 AI 新视界 – 产学研合作推动 AI 技术创新的路径(16 - 15)(最新)

- 智创 AI 新视界 – 确保 AI 公平性的策略与挑战(16 - 14)(最新)

- 智创 AI 新视界 – AI 发展中的伦理困境与解决方案(16 - 13)(最新)

- 智创 AI 新视界 – 改进 AI 循环神经网络(RNN)的实践探索(16 - 12)(最新)

- 智创 AI 新视界 – 基于 Transformer 架构的 AI 模型优化(16 - 11)(最新)

- 智创 AI 新视界 – AI 助力金融风险管理的新策略(16 - 10)(最新)

- 智创 AI 新视界 – AI 在交通运输领域的智能优化应用(16 - 9)(最新)

- 智创 AI 新视界 – AIGC 对游戏产业的革命性影响(16 - 8)(最新)

- 智创 AI 新视界 – AIGC 重塑广告行业的创新力量(16 - 7)(最新)

- 智创 AI 新视界 – AI 引领下的未来社会变革预测(16 - 6)(最新)

- 智创 AI 新视界 – AI 与量子计算的未来融合前景(16 - 5)(最新)

- 智创 AI 新视界 – 防范 AI 模型被攻击的安全策略(16 - 4)(最新)

- 智创 AI 新视界 – AI 时代的数据隐私保护挑战与应对(16 - 3)(最新)

- 智创 AI 新视界 – 提升 AI 推理速度的高级方法(16 - 2)(最新)

- 智创 AI 新视界 – 优化 AI 模型训练效率的策略与技巧(16 - 1)(最新)

- 大数据新视界 – 大数据大厂之 Hive 临时表与视图的应用场景(下)(30 / 30)(最新)

- 大数据新视界 – 大数据大厂之 Hive 临时表与视图:灵活数据处理的技巧(上)(29 / 30)(最新)

- 大数据新视界 – 大数据大厂之 Hive 元数据管理工具与实践(下)(28 / 30)(最新)

- 大数据新视界 – 大数据大厂之 Hive 元数据管理:核心元数据的深度解析(上)(27 / 30)(最新)

- 大数据新视界 – 大数据大厂之 Hive 数据湖集成与数据治理(下)(26 / 30)(最新)

- 大数据新视界 – 大数据大厂之 Hive 数据湖架构中的角色与应用(上)(25 / 30)(最新)

- 大数据新视界 – 大数据大厂之 Hive MapReduce 性能调优实战(下)(24 / 30)(最新)

- 大数据新视界 – 大数据大厂之 Hive 基于 MapReduce 的执行原理(上)(23 / 30)(最新)

- 大数据新视界 – 大数据大厂之 Hive 窗口函数应用场景与实战(下)(22 / 30)(最新)

- 大数据新视界 – 大数据大厂之 Hive 窗口函数:强大的数据分析利器(上)(21 / 30)(最新)

- 大数据新视界 – 大数据大厂之 Hive 数据压缩算法对比与选择(下)(20 / 30)(最新)

- 大数据新视界 – 大数据大厂之 Hive 数据压缩:优化存储与传输的关键(上)(19/ 30)(最新)

- 大数据新视界 – 大数据大厂之 Hive 数据质量监控:实时监测异常数据(下)(18/ 30)(最新)

- 大数据新视界 – 大数据大厂之 Hive 数据质量保障:数据清洗与验证的策略(上)(17/ 30)(最新)

- 大数据新视界 – 大数据大厂之 Hive 数据安全:加密技术保障数据隐私(下)(16 / 30)(最新)

- 大数据新视界 – 大数据大厂之 Hive 数据安全:权限管理体系的深度解读(上)(15 / 30)(最新)

- 大数据新视界 – 大数据大厂之 Hive 与其他大数据工具的集成:协同作战的优势(下)(14/ 30)(最新)

- 大数据新视界 – 大数据大厂之 Hive 与其他大数据工具的集成:协同作战的优势(上)(13/ 30)(最新)

- 大数据新视界 – 大数据大厂之 Hive 函数应用:复杂数据转换的实战案例(下)(12/ 30)(最新)

- 大数据新视界 – 大数据大厂之 Hive 函数库:丰富函数助力数据处理(上)(11/ 30)(最新)

- 大数据新视界 – 大数据大厂之 Hive 数据桶:优化聚合查询的有效手段(下)(10/ 30)(最新)

- 大数据新视界 – 大数据大厂之 Hive 数据桶原理:均匀分布数据的智慧(上)(9/ 30)(最新)

- 大数据新视界 – 大数据大厂之 Hive 数据分区:提升查询效率的关键步骤(下)(8/ 30)(最新)

- 大数据新视界 – 大数据大厂之 Hive 数据分区:精细化管理的艺术与实践(上)(7/ 30)(最新)

- 大数据新视界 – 大数据大厂之 Hive 查询性能优化:索引技术的巧妙运用(下)(6/ 30)(最新)

- 大数据新视界 – 大数据大厂之 Hive 查询性能优化:基于成本模型的奥秘(上)(5/ 30)(最新)

- 大数据新视界 – 大数据大厂之 Hive 数据导入:优化数据摄取的高级技巧(下)(4/ 30)(最新)

- 大数据新视界 – 大数据大厂之 Hive 数据导入:多源数据集成的策略与实战(上)(3/ 30)(最新)

- 大数据新视界 – 大数据大厂之 Hive 数据仓库:构建高效数据存储的基石(下)(2/ 30)(最新)

- 大数据新视界 – 大数据大厂之 Hive 数据仓库:架构深度剖析与核心组件详解(上)(1 / 30)(最新)

- 大数据新视界 – 大数据大厂之 Impala 性能优化:量子计算启发下的数据加密与性能平衡(下)(30 / 30)(最新)

- 大数据新视界 – 大数据大厂之 Impala 性能优化:融合人工智能预测的资源预分配秘籍(上)(29 / 30)(最新)

- 大数据新视界 – 大数据大厂之 Impala 性能优化:分布式环境中的优化新视野(下)(28 / 30)(最新)

- 大数据新视界 – 大数据大厂之 Impala 性能优化:跨数据中心环境下的挑战与对策(上)(27 / 30)(最新)

- 大数据新视界 – 大数据大厂之 Impala 性能突破:处理特殊数据的高级技巧(下)(26 / 30)(最新)

- 大数据新视界 – 大数据大厂之 Impala 性能突破:复杂数据类型处理的优化路径(上)(25 / 30)(最新)

- 大数据新视界 – 大数据大厂之 Impala 性能优化:资源分配与负载均衡的协同(下)(24 / 30)(最新)

- 大数据新视界 – 大数据大厂之 Impala 性能优化:集群资源动态分配的智慧(上)(23 / 30)(最新)

- 大数据新视界 – 大数据大厂之 Impala 性能飞跃:分区修剪优化的应用案例(下)(22 / 30)(最新)

- 智创 AI 新视界 – AI 助力医疗影像诊断的新突破(最新)

- 智创 AI 新视界 – AI 在智能家居中的智能升级之路(最新)

- 大数据新视界 – 大数据大厂之 Impala 性能飞跃:动态分区调整的策略与方法(上)(21 / 30)(最新)

- 大数据新视界 – 大数据大厂之 Impala 存储格式转换:从原理到实践,开启大数据性能优化星际之旅(下)(20/30)(最新)

- 大数据新视界 – 大数据大厂之 Impala 性能优化:基于数据特征的存储格式选择(上)(19/30)(最新)

- 大数据新视界 – 大数据大厂之 Impala 性能提升:高级执行计划优化实战案例(下)(18/30)(最新)

- 大数据新视界 – 大数据大厂之 Impala 性能提升:解析执行计划优化的神秘面纱(上)(17/30)(最新)

- 大数据新视界 – 大数据大厂之 Impala 性能优化:优化数据加载的实战技巧(下)(16/30)(最新)

- 大数据新视界 – 大数据大厂之 Impala 性能优化:数据加载策略如何决定分析速度(上)(15/30)(最新)

- 大数据新视界 – 大数据大厂之 Impala 性能优化:为企业决策加速的核心力量(下)(14/30)(最新)

- 大数据新视界 – 大数据大厂之 Impala 在大数据架构中的性能优化全景洞察(上)(13/30)(最新)

- 大数据新视界 – 大数据大厂之 Impala 性能优化:新技术融合的无限可能(下)(12/30)(最新)

- 大数据新视界 – 大数据大厂之 Impala 性能优化:融合机器学习的未来之路(上 (2-2))(11/30)(最新)

- 大数据新视界 – 大数据大厂之 Impala 性能优化:融合机器学习的未来之路(上 (2-1))(11/30)(最新)

- 大数据新视界 – 大数据大厂之经典案例解析:广告公司 Impala 优化的成功之道(下)(10/30)(最新)

- 大数据新视界 – 大数据大厂之经典案例解析:电商企业如何靠 Impala性能优化逆袭(上)(9/30)(最新)

- 大数据新视界 – 大数据大厂之 Impala 性能优化:从数据压缩到分析加速(下)(8/30)(最新)

- 大数据新视界 – 大数据大厂之 Impala 性能优化:应对海量复杂数据的挑战(上)(7/30)(最新)

- 大数据新视界 – 大数据大厂之 Impala 资源管理:并发控制的策略与技巧(下)(6/30)(最新)

- 大数据新视界 – 大数据大厂之 Impala 与内存管理:如何避免资源瓶颈(上)(5/30)(最新)

- 大数据新视界 – 大数据大厂之提升 Impala 查询效率:重写查询语句的黄金法则(下)(4/30)(最新)

- 大数据新视界 – 大数据大厂之提升 Impala 查询效率:索引优化的秘籍大揭秘(上)(3/30)(最新)

- 大数据新视界 – 大数据大厂之 Impala 性能优化:数据存储分区的艺术与实践(下)(2/30)(最新)

- 大数据新视界 – 大数据大厂之 Impala 性能优化:解锁大数据分析的速度密码(上)(1/30)(最新)

- 大数据新视界 – 大数据大厂都在用的数据目录管理秘籍大揭秘,附海量代码和案例(最新)

- 大数据新视界 – 大数据大厂之数据质量管理全景洞察:从荆棘挑战到辉煌策略与前沿曙光(最新)

- 大数据新视界 – 大数据大厂之大数据环境下的网络安全态势感知(最新)

- 大数据新视界 – 大数据大厂之多因素认证在大数据安全中的关键作用(最新)

- 大数据新视界 – 大数据大厂之优化大数据计算框架 Tez 的实践指南(最新)

- 技术星河中的璀璨灯塔 —— 青云交的非凡成长之路(最新)

- 大数据新视界 – 大数据大厂之大数据重塑影视娱乐产业的未来(4 - 4)(最新)

- 大数据新视界 – 大数据大厂之大数据重塑影视娱乐产业的未来(4 - 3)(最新)

- 大数据新视界 – 大数据大厂之大数据重塑影视娱乐产业的未来(4 - 2)(最新)

- 大数据新视界 – 大数据大厂之大数据重塑影视娱乐产业的未来(4 - 1)(最新)

- 大数据新视界 – 大数据大厂之Cassandra 性能优化策略:大数据存储的高效之路(最新)

- 大数据新视界 – 大数据大厂之大数据在能源行业的智能优化变革与展望(最新)

- 智创 AI 新视界 – 探秘 AIGC 中的生成对抗网络(GAN)应用(最新)

- 大数据新视界 – 大数据大厂之大数据与虚拟现实的深度融合之旅(最新)

- 大数据新视界 – 大数据大厂之大数据与神经形态计算的融合:开启智能新纪元(最新)

- 智创 AI 新视界 – AIGC 背后的深度学习魔法:从原理到实践(最新)

- 大数据新视界 – 大数据大厂之大数据和增强现实(AR)结合:创造沉浸式数据体验(最新)

- 大数据新视界 – 大数据大厂之如何降低大数据存储成本:高效存储架构与技术选型(最新)

- 大数据新视界 --大数据大厂之大数据与区块链双链驱动:构建可信数据生态(最新)

- 大数据新视界 – 大数据大厂之 AI 驱动的大数据分析:智能决策的新引擎(最新)

- 大数据新视界 --大数据大厂之区块链技术:为大数据安全保驾护航(最新)

- 大数据新视界 --大数据大厂之 Snowflake 在大数据云存储和处理中的应用探索(最新)

- 大数据新视界 --大数据大厂之数据脱敏技术在大数据中的应用与挑战(最新)

- 大数据新视界 --大数据大厂之 Ray:分布式机器学习框架的崛起(最新)

- 大数据新视界 --大数据大厂之大数据在智慧城市建设中的应用:打造智能生活的基石(最新)

- 大数据新视界 --大数据大厂之 Dask:分布式大数据计算的黑马(最新)

- 大数据新视界 --大数据大厂之 Apache Beam:统一批流处理的大数据新贵(最新)

- 大数据新视界 --大数据大厂之图数据库与大数据:挖掘复杂关系的新视角(最新)

- 大数据新视界 --大数据大厂之 Serverless 架构下的大数据处理:简化与高效的新路径(最新)

- 大数据新视界 --大数据大厂之大数据与边缘计算的协同:实时分析的新前沿(最新)

- 大数据新视界 --大数据大厂之 Hadoop MapReduce 优化指南:释放数据潜能,引领科技浪潮(最新)

- 诺贝尔物理学奖新视野:机器学习与神经网络的璀璨华章(最新)

- 大数据新视界 --大数据大厂之 Volcano:大数据计算任务调度的新突破(最新)

- 大数据新视界 --大数据大厂之 Kubeflow 在大数据与机器学习融合中的应用探索(最新)

- 大数据新视界 --大数据大厂之大数据环境下的零信任安全架构:构建可靠防护体系(最新)

- 大数据新视界 --大数据大厂之差分隐私技术在大数据隐私保护中的实践(最新)

- 大数据新视界 --大数据大厂之 Dremio:改变大数据查询方式的创新引擎(最新)

- 大数据新视界 --大数据大厂之 ClickHouse:大数据分析领域的璀璨明星(最新)

- 大数据新视界 --大数据大厂之大数据驱动下的物流供应链优化:实时追踪与智能调配(最新)

- 大数据新视界 --大数据大厂之大数据如何重塑金融风险管理:精准预测与防控(最新)

- 大数据新视界 --大数据大厂之 GraphQL 在大数据查询中的创新应用:优化数据获取效率(最新)

- 大数据新视界 --大数据大厂之大数据与量子机器学习融合:突破智能分析极限(最新)

- 大数据新视界 --大数据大厂之 Hudi 数据湖框架性能提升:高效处理大数据变更(最新)

- 大数据新视界 --大数据大厂之 Presto 性能优化秘籍:加速大数据交互式查询(最新)

- 大数据新视界 --大数据大厂之大数据驱动智能客服 – 提升客户体验的核心动力(最新)

- 大数据新视界 --大数据大厂之大数据于基因测序分析的核心应用 - 洞悉生命信息的密钥(最新)

- 大数据新视界 --大数据大厂之 Ibis:独特架构赋能大数据分析高级抽象层(最新)

- 大数据新视界 --大数据大厂之 DataFusion:超越传统的大数据集成与处理创新工具(最新)

- 大数据新视界 --大数据大厂之 从 Druid 和 Kafka 到 Polars:大数据处理工具的传承与创新(最新)

- 大数据新视界 --大数据大厂之 Druid 查询性能提升:加速大数据实时分析的深度探索(最新)

- 大数据新视界 --大数据大厂之 Kafka 性能优化的进阶之道:应对海量数据的高效传输(最新)

- 大数据新视界 --大数据大厂之深度优化 Alluxio 分层架构:提升大数据缓存效率的全方位解析(最新)

- 大数据新视界 --大数据大厂之 Alluxio:解析数据缓存系统的分层架构(最新)

- 大数据新视界 --大数据大厂之 Alluxio 数据缓存系统在大数据中的应用与配置(最新)

- 大数据新视界 --大数据大厂之TeZ 大数据计算框架实战:高效处理大规模数据(最新)

- 大数据新视界 --大数据大厂之数据质量评估指标与方法:提升数据可信度(最新)

- 大数据新视界 --大数据大厂之 Sqoop 在大数据导入导出中的应用与技巧(最新)

- 大数据新视界 --大数据大厂之数据血缘追踪与治理:确保数据可追溯性(最新)

- 大数据新视界 --大数据大厂之Cassandra 分布式数据库在大数据中的应用与调优(最新)

- 大数据新视界 --大数据大厂之基于 MapReduce 的大数据并行计算实践(最新)

- 大数据新视界 --大数据大厂之数据压缩算法比较与应用:节省存储空间(最新)

- 大数据新视界 --大数据大厂之 Druid 实时数据分析平台在大数据中的应用(最新)

- 大数据新视界 --大数据大厂之数据清洗工具 OpenRefine 实战:清理与转换数据(最新)

- 大数据新视界 --大数据大厂之 Spark Streaming 实时数据处理框架:案例与实践(最新)

- 大数据新视界 --大数据大厂之 Kylin 多维分析引擎实战:构建数据立方体(最新)

- 大数据新视界 --大数据大厂之HBase 在大数据存储中的应用与表结构设计(最新)

- 大数据新视界 --大数据大厂之大数据实战指南:Apache Flume 数据采集的配置与优化秘籍(最新)

- 大数据新视界 --大数据大厂之大数据存储技术大比拼:选择最适合你的方案(最新)

- 大数据新视界 --大数据大厂之 Reactjs 在大数据应用开发中的优势与实践(最新)

- 大数据新视界 --大数据大厂之 Vue.js 与大数据可视化:打造惊艳的数据界面(最新)

- 大数据新视界 --大数据大厂之 Node.js 与大数据交互:实现高效数据处理(最新)

- 大数据新视界 --大数据大厂之JavaScript在大数据前端展示中的精彩应用(最新)

- 大数据新视界 --大数据大厂之AI 与大数据的融合:开创智能未来的新篇章(最新)

- 大数据新视界 --大数据大厂之算法在大数据中的核心作用:提升效率与智能决策(最新)

- 大数据新视界 --大数据大厂之DevOps与大数据:加速数据驱动的业务发展(最新)

- 大数据新视界 --大数据大厂之SaaS模式下的大数据应用:创新与变革(最新)

- 大数据新视界 --大数据大厂之Kubernetes与大数据:容器化部署的最佳实践(最新)

- 大数据新视界 --大数据大厂之探索ES:大数据时代的高效搜索引擎实战攻略(最新)

- 大数据新视界 --大数据大厂之Redis在缓存与分布式系统中的神奇应用(最新)

- 大数据新视界 --大数据大厂之数据驱动决策:如何利用大数据提升企业竞争力(最新)

- 大数据新视界 --大数据大厂之MongoDB与大数据:灵活文档数据库的应用场景(最新)

- 大数据新视界 --大数据大厂之数据科学项目实战:从问题定义到结果呈现的完整流程(最新)

- 大数据新视界 --大数据大厂之 Cassandra 分布式数据库:高可用数据存储的新选择(最新)

- 大数据新视界 --大数据大厂之数据安全策略:保护大数据资产的最佳实践(最新)

- 大数据新视界 --大数据大厂之Kafka消息队列实战:实现高吞吐量数据传输(最新)

- 大数据新视界 --大数据大厂之数据挖掘入门:用 R 语言开启数据宝藏的探索之旅(最新)

- 大数据新视界 --大数据大厂之HBase深度探寻:大规模数据存储与查询的卓越方案(最新)

- IBM 中国研发部裁员风暴,IT 行业何去何从?(最新)

- 大数据新视界 --大数据大厂之数据治理之道:构建高效大数据治理体系的关键步骤(最新)

- 大数据新视界 --大数据大厂之Flink强势崛起:大数据新视界的璀璨明珠(最新)

- 大数据新视界 --大数据大厂之数据可视化之美:用 Python 打造炫酷大数据可视化报表(最新)

- 大数据新视界 --大数据大厂之 Spark 性能优化秘籍:从配置到代码实践(最新)

- 大数据新视界 --大数据大厂之揭秘大数据时代 Excel 魔法:大厂数据分析师进阶秘籍(最新)

- 大数据新视界 --大数据大厂之Hive与大数据融合:构建强大数据仓库实战指南(最新)

- 大数据新视界–大数据大厂之Java 与大数据携手:打造高效实时日志分析系统的奥秘(最新)

- 大数据新视界–面向数据分析师的大数据大厂之MySQL基础秘籍:轻松创建数据库与表,踏入大数据殿堂(最新)

- 全栈性能优化秘籍–Linux 系统性能调优全攻略:多维度优化技巧大揭秘(最新)

- 大数据新视界–大数据大厂之MySQL数据库课程设计:揭秘 MySQL 集群架构负载均衡核心算法:从理论到 Java 代码实战,让你的数据库性能飙升!(最新)

- 大数据新视界–大数据大厂之MySQL数据库课程设计:MySQL集群架构负载均衡故障排除与解决方案(最新)

- 解锁编程高效密码:四大工具助你一飞冲天!(最新)

- 大数据新视界–大数据大厂之MySQL数据库课程设计:MySQL数据库高可用性架构探索(2-1)(最新)

- 大数据新视界–大数据大厂之MySQL数据库课程设计:MySQL集群架构负载均衡方法选择全攻略(2-2)(最新)

- 大数据新视界–大数据大厂之MySQL数据库课程设计:MySQL 数据库 SQL 语句调优方法详解(2-1)(最新)

- 大数据新视界–大数据大厂之MySQL 数据库课程设计:MySQL 数据库 SQL 语句调优的进阶策略与实际案例(2-2)(最新)

- 大数据新视界–大数据大厂之MySQL 数据库课程设计:数据安全深度剖析与未来展望(最新)

- 大数据新视界–大数据大厂之MySQL 数据库课程设计:开启数据宇宙的传奇之旅(最新)

- 大数据新视界–大数据大厂之大数据时代的璀璨导航星:Eureka 原理与实践深度探秘(最新)

- Java性能优化传奇之旅–Java万亿级性能优化之Java 性能优化逆袭:常见错误不再是阻碍(最新)

- Java性能优化传奇之旅–Java万亿级性能优化之Java 性能优化传奇:热门技术点亮高效之路(最新)

- Java性能优化传奇之旅–Java万亿级性能优化之电商平台高峰时段性能优化:多维度策略打造卓越体验(最新)

- Java性能优化传奇之旅–Java万亿级性能优化之电商平台高峰时段性能大作战:策略与趋势洞察(最新)

- JVM万亿性能密码–JVM性能优化之JVM 内存魔法:开启万亿级应用性能新纪元(最新)

- 十万流量耀前路,成长感悟谱新章(最新)

- AI 模型:全能与专精之辩 —— 一场科技界的 “超级大比拼”(最新)

- 国产游戏技术:挑战与机遇(最新)

- Java面试题–JVM大厂篇之JVM大厂面试题及答案解析(10)(最新)

- Java面试题–JVM大厂篇之JVM大厂面试题及答案解析(9)(最新)

- Java面试题–JVM大厂篇之JVM大厂面试题及答案解析(8)(最新)

- Java面试题–JVM大厂篇之JVM大厂面试题及答案解析(7)(最新)

- Java面试题–JVM大厂篇之JVM大厂面试题及答案解析(6)(最新)

- Java面试题–JVM大厂篇之JVM大厂面试题及答案解析(5)(最新)

- Java面试题–JVM大厂篇之JVM大厂面试题及答案解析(4)(最新)

- Java面试题–JVM大厂篇之JVM大厂面试题及答案解析(3)(最新)

- Java面试题–JVM大厂篇之JVM大厂面试题及答案解析(2)(最新)

- Java面试题–JVM大厂篇之JVM大厂面试题及答案解析(1)(最新)

- Java 面试题 ——JVM 大厂篇之 Java 工程师必备:顶尖工具助你全面监控和分析 CMS GC 性能(2)(最新)

- Java面试题–JVM大厂篇之Java工程师必备:顶尖工具助你全面监控和分析CMS GC性能(1)(最新)

- Java面试题–JVM大厂篇之未来已来:为什么ZGC是大规模Java应用的终极武器?(最新)

- AI 音乐风暴:创造与颠覆的交响(最新)

- 编程风暴:勇破挫折,铸就传奇(最新)

- Java面试题–JVM大厂篇之低停顿、高性能:深入解析ZGC的优势(最新)

- Java面试题–JVM大厂篇之解密ZGC:让你的Java应用高效飞驰(最新)

- Java面试题–JVM大厂篇之掌控Java未来:深入剖析ZGC的低停顿垃圾回收机制(最新)

- GPT-5 惊涛来袭:铸就智能新传奇(最新)

- AI 时代风暴:程序员的核心竞争力大揭秘(最新)

- Java面试题–JVM大厂篇之Java新神器ZGC:颠覆你的垃圾回收认知!(最新)

- Java面试题–JVM大厂篇之揭秘:如何通过优化 CMS GC 提升各行业服务器响应速度(最新)

- “低代码” 风暴:重塑软件开发新未来(最新)

- 程序员如何平衡日常编码工作与提升式学习?–编程之路:平衡与成长的艺术(最新)

- 编程学习笔记秘籍:开启高效学习之旅(最新)

- Java面试题–JVM大厂篇之高并发Java应用的秘密武器:深入剖析GC优化实战案例(最新)

- Java面试题–JVM大厂篇之实战解析:如何通过CMS GC优化大规模Java应用的响应时间(最新)

- Java面试题–JVM大厂篇(1-10)

- Java面试题–JVM大厂篇之Java虚拟机(JVM)面试题:涨知识,拿大厂Offer(11-20)

- Java面试题–JVM大厂篇之JVM面试指南:掌握这10个问题,大厂Offer轻松拿

- Java面试题–JVM大厂篇之Java程序员必学:JVM架构完全解读

- Java面试题–JVM大厂篇之以JVM新特性看Java的进化之路:从Loom到Amber的技术篇章

- Java面试题–JVM大厂篇之深入探索JVM:大厂面试官心中的那些秘密题库

- Java面试题–JVM大厂篇之高级Java开发者的自我修养:深入剖析JVM垃圾回收机制及面试要点

- Java面试题–JVM大厂篇之从新手到专家:深入探索JVM垃圾回收–开端篇

- Java面试题–JVM大厂篇之Java性能优化:垃圾回收算法的神秘面纱揭开!

- Java面试题–JVM大厂篇之揭秘Java世界的清洁工——JVM垃圾回收机制

- Java面试题–JVM大厂篇之掌握JVM性能优化:选择合适的垃圾回收器

- Java面试题–JVM大厂篇之深入了解Java虚拟机(JVM):工作机制与优化策略

- Java面试题–JVM大厂篇之深入解析JVM运行时数据区:Java开发者必读

- Java面试题–JVM大厂篇之从零开始掌握JVM:解锁Java程序的强大潜力

- Java面试题–JVM大厂篇之深入了解G1 GC:大型Java应用的性能优化利器

- Java面试题–JVM大厂篇之深入了解G1 GC:高并发、响应时间敏感应用的最佳选择

- Java面试题–JVM大厂篇之G1 GC的分区管理方式如何减少应用线程的影响

- Java面试题–JVM大厂篇之深入解析G1 GC——革新Java垃圾回收机制

- Java面试题–JVM大厂篇之深入探讨Serial GC的应用场景

- Java面试题–JVM大厂篇之Serial GC在JVM中有哪些优点和局限性

- Java面试题–JVM大厂篇之深入解析JVM中的Serial GC:工作原理与代际区别

- Java面试题–JVM大厂篇之通过参数配置来优化Serial GC的性能

- Java面试题–JVM大厂篇之深入分析Parallel GC:从原理到优化

- Java面试题–JVM大厂篇之破解Java性能瓶颈!深入理解Parallel GC并优化你的应用

- Java面试题–JVM大厂篇之全面掌握Parallel GC参数配置:实战指南

- Java面试题–JVM大厂篇之Parallel GC与其他垃圾回收器的对比与选择

- Java面试题–JVM大厂篇之Java中Parallel GC的调优技巧与最佳实践

- Java面试题–JVM大厂篇之JVM监控与GC日志分析:优化Parallel GC性能的重要工具

- Java面试题–JVM大厂篇之针对频繁的Minor GC问题,有哪些优化对象创建与使用的技巧可以分享?

- Java面试题–JVM大厂篇之JVM 内存管理深度探秘:原理与实战

- Java面试题–JVM大厂篇之破解 JVM 性能瓶颈:实战优化策略大全

- Java面试题–JVM大厂篇之JVM 垃圾回收器大比拼:谁是最佳选择

- Java面试题–JVM大厂篇之从原理到实践:JVM 字节码优化秘籍

- Java面试题–JVM大厂篇之揭开CMS GC的神秘面纱:从原理到应用,一文带你全面掌握

- Java面试题–JVM大厂篇之JVM 调优实战:让你的应用飞起来

- Java面试题–JVM大厂篇之CMS GC调优宝典:从默认配置到高级技巧,Java性能提升的终极指南

- Java面试题–JVM大厂篇之CMS GC的前世今生:为什么它曾是Java的王者,又为何将被G1取代

- Java就业-学习路线–突破性能瓶颈: Java 22 的性能提升之旅

- Java就业-学习路线–透视Java发展:从 Java 19 至 Java 22 的飞跃

- Java就业-学习路线–Java技术:2024年开发者必须了解的10个要点

- Java就业-学习路线–Java技术栈前瞻:未来技术趋势与创新

- Java就业-学习路线–Java技术栈模块化的七大优势,你了解多少?

- Spring框架-Java学习路线课程第一课:Spring核心

- Spring框架-Java学习路线课程:Spring的扩展配置

- Springboot框架-Java学习路线课程:Springboot框架的搭建之maven的配置

- Java进阶-Java学习路线课程第一课:Java集合框架-ArrayList和LinkedList的使用

- Java进阶-Java学习路线课程第二课:Java集合框架-HashSet的使用及去重原理

- JavaWEB-Java学习路线课程:使用MyEclipse工具新建第一个JavaWeb项目(一)

- JavaWEB-Java学习路线课程:使用MyEclipse工具新建项目时配置Tomcat服务器的方式(二)

- Java学习:在给学生演示用Myeclipse10.7.1工具生成War时,意外报错:SECURITY: INTEGRITY CHECK ERROR

- 使用Jquery发送Ajax请求的几种异步刷新方式

- Idea Springboot启动时内嵌tomcat报错- An incompatible version [1.1.33] of the APR based Apache Tomcat Native

- Java入门-Java学习路线课程第一课:初识JAVA

- Java入门-Java学习路线课程第二课:变量与数据类型

- Java入门-Java学习路线课程第三课:选择结构

- Java入门-Java学习路线课程第四课:循环结构

- Java入门-Java学习路线课程第五课:一维数组

- Java入门-Java学习路线课程第六课:二维数组

- Java入门-Java学习路线课程第七课:类和对象

- Java入门-Java学习路线课程第八课:方法和方法重载

- Java入门-Java学习路线扩展课程:equals的使用

- Java入门-Java学习路线课程面试篇:取商 / 和取余(模) % 符号的使用

️参与投票和与我联系: