Python爬虫基础教程详解:原理、常用库与抓取股票数据可视化案例

引言

对于绝大多数想要学习Python的朋友而言,爬虫绝对是学习Python的最好的骑手和入门方式。

我当时选择Python学习,也是瞄准了Python爬虫,因为爬虫思维模式固定,编程模式也相对简单,一般在细节处理上积累一些经验都可以成功。

一、认识爬虫

1. 理解网络爬虫

网络爬虫是一种自动化程序,用于抓取互联网上的信息。其工作原理类似于搜索引擎的爬虫,它们通过遍历网页并提取所需信息来构建数据集。Python提供了多种强大的库来实现网络爬虫,其中最流行的是Beautiful Soup和Scrapy。

(1)使用Beautiful Soup

Beautiful Soup是一个Python库,用于从HTML和XML文件中提取数据。以下是一个简单的示例,演示如何使用Beautiful Soup来抓取网页中的标题:

from bs4 import BeautifulSoup

import requests

url = ''

response = requests.get(url)

soup = BeautifulSoup(response.text, 'html.parser')

title = soup.title.string

print("网页标题:", title)

(2)使用Scrapy

Scrapy是一个强大的Python框架,用于快速构建网络爬虫。它提供了一个灵活的架构,可用于处理复杂的爬取任务。以下是一个简单的示例,演示如何使用Scrapy来爬取网页中的链接:

import scrapy

class LinkSpider(scrapy.Spider):

name = 'linkspider'

start_urls = ['']

def parse(self, response):

for link in response.css('a::attr(href)').getall():

print("链接:", link)

2.数据抓取与处理

一旦我们成功地从网页中抓取了数据,接下来的步骤是对数据进行处理和分析。Python提供了丰富的数据处理库,如Pandas和NumPy,使得数据的清洗、转换和分析变得轻而易举。

(1)使用Pandas进行数据处理

Pandas是一个功能强大的数据处理库,提供了灵活的数据结构和丰富的数据操作功能。以下是一个简单的示例,演示如何使用Pandas加载数据并进行基本的数据操作:

import pandas as pd

# 加载CSV文件

data = pd.read_csv('data.csv')

# 显示前5行数据

print(data.head())

(2)使用NumPy进行数据分析

NumPy是Python的一个核心库,用于科学计算和数值操作。它提供了高效的数组操作和数学函数,非常适合处理大规模数据。以下是一个简单的示例,演示如何使用NumPy计算数据的均值和标准差:

import numpy as np

# 创建一个数组

data = np.array([1, 2, 3, 4, 5])

# 计算均值和标准差

mean = np.mean(data)

std_dev = np.std(data)

print("均值:", mean)

print("标准差:", std_dev)

3.小试牛刀:抓取股票数据

为了更具体地展示Python网络爬虫和数据抓取的应用,我就以介绍一个实践案例:抓取股票数据便于大家快速入门。我们将使用Beautiful Soup来抓取股票价格,并使用Pandas对数据进行处理和分析。

import requests

from bs4 import BeautifulSoup

import pandas as pd

# 抓取股票数据

def get_stock_price(symbol):

url = f'ote/{symbol}?p={symbol}&.tsrc=fin-srch'

response = requests.get(url)

soup = BeautifulSoup(response.text, 'html.parser')

price = soup.find('div', {'class': 'D(ib) Mend(20px)'}).find('span').text

return price

# 示例:抓取公司(AAPL)的股票价格

stock_price = get_stock_price('AAPL')

print("公司股票价格:", stock_price)

4.数据可视化与洞察

数据抓取和处理是解锁数据价值的第一步,但数据的真正力量在于其可视化和洞察。Python提供了众多优秀的数据可视化工具,如Matplotlib和Seaborn,帮助用户以直观的方式探索数据并发现隐藏的模式和趋势。

(1)使用Matplotlib创建图表

Matplotlib是Python的一个2D绘图库,可以生成各种类型的图表,包括折线图、散点图、柱状图等。以下是一个简单的示例,演示如何使用Matplotlib绘制股票价格的折线图:

import matplotlib.pyplot as plt

# 示例数据

dates = ['2024-01-01', '2024-01-02', '2024-01-03', '2024-01-04', '2024-01-05']

prices = [100, 110, 105, 115, 120]

# 绘制折线图

plt.plot(dates, prices)

plt.title('Stock Prices Over Time')

plt.xlabel('Date')

plt.ylabel('Price')

plt.xticks(rotation=45)

plt.show()

(2)使用Seaborn创建统计图表

Seaborn是基于Matplotlib的Python数据可视化库,提供了更高级的统计图表和美观的默认样式。以下是一个简单的示例,演示如何使用Seaborn创建股票价格的分布图:

import seaborn as sns

# 示例数据

prices = [100, 110, 105, 115, 120]

# 绘制分布图

sns.histplot(prices, kde=True)

plt.title('Distribution of Stock Prices')

plt.xlabel('Price')

plt.ylabel('Frequency')

plt.show()

5.高级技术与挑战

在实际应用中,网络爬虫和数据抓取可能会面临各种挑战和限制。例如,网站可能会采取反爬虫措施来阻止爬虫访问数据,或者数据量可能过大导致性能问题。为了克服这些挑战,需要使用一些高级技术,如IP代理、用户代理轮换、分布式爬虫等。

6.遵循最佳实践和道德准则

在进行网络爬虫和数据抓取时,遵循最佳实践和道德准则至关重要。这不仅可以保护您自己,还可以确保您的行为符合法律和伦理要求,避免对其他网站和用户造成不必要的影响。

(1)尊重网站的Robots.txt文件

Robots.txt是网站所有者用来指示搜索引擎爬虫哪些页面可以被抓取的文件。在进行网络爬虫之前,务必查看网站的Robots.txt文件,并遵守其中的规则。尊重网站的Robots.txt文件可以避免触发反爬虫措施,保护自己和其他用户的权益。

(2)设置适当的爬取速率

过于频繁的爬取请求可能会对网站的服务器造成负担,甚至导致服务器崩溃。因此,建议设置适当的爬取速率,以避免对网站造成不必要的压力。您可以使用延迟和限速等技术来控制爬取速率,确保与网站服务器之间的友好合作。

(3)遵守法律和隐私规定

在进行网络爬虫和数据抓取时,务必遵守适用的法律和隐私规定。不要抓取受版权保护的内容,也不要侵犯个人隐私。确保您的行为符合法律要求,并尊重数据所有者的权利和隐私。

7.实践建议:保持学习和更新

网络爬虫和数据抓取是一个不断发展的领域,新的技术和工具不断涌现。因此,建议保持学习和更新,关注最新的技术趋势和最佳实践。参与在线社区、阅读相关文档和教程、参加培训课程等方式都可以帮助你不断提升技能,保持竞争力。

此外,建议你加入相关的专业组织或社区,与其他爬虫爱好者和专家交流经验和观点。通过分享和讨论,可以获得更多的启发和帮助,加速自己在网络爬虫和数据抓取领域的成长和发展。

8.未来发展趋势:机器学习与自动化

随着数据量的不断增加和数据分析需求的增加,未来网络爬虫和数据抓取领域将会朝着机器学习和自动化方向发展。机器学习技术可以帮助爬虫更智能地发现和抓取有用的数据,提高数据抓取的效率和准确性。

(1)基于机器学习的内容解析

传统的网络爬虫通常依赖于规则或模板来解析网页内容,但这种方法可能会受到网页结构变化的影响。基于机器学习的内容解析技术可以更灵活地识别和提取网页中的信息,不受网页结构变化的影响,从而提高数据抓取的稳定性和可靠性。

(2)自动化爬虫管理和优化

随着爬虫数量的增加和任务复杂度的提高,手动管理和优化爬虫已经变得越来越困难。因此,未来将会出现更多自动化的爬虫管理和优化工具,帮助用户更有效地管理和运行爬虫,提高爬取效率和性能。

(3)数据抓取与知识图谱

未来网络爬虫和数据抓取不仅仅是简单地收集数据,更多地是将数据转化为知识,并构建起知识图谱。通过将抓取的数据与其他数据源和知识库进行关联和整合,可以发现更深层次的联系和模式,为数据分析和决策提供更多的价值和洞察。

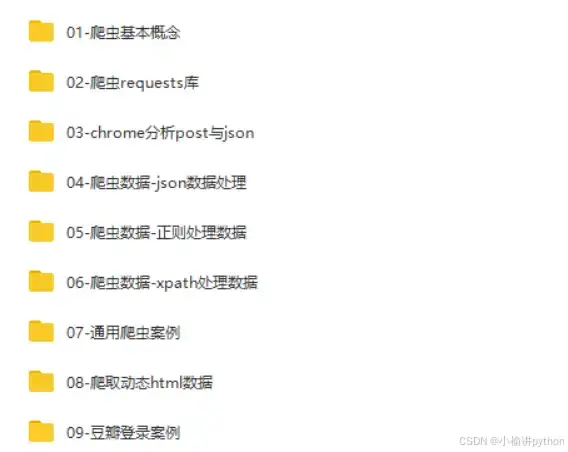

二、爬虫学习路线

作为一名资深的Python爬虫迷,我觉得无论学习任何一件事情,都应该要做到兴趣入门,持之以恒,最后才能真正出师。

在刚开始入门爬虫时,你甚至不需要去学习python的类、多线程、模块之类的略难内容。而是一切按照自己的能力来,基于你学习的目的,工作、爱好、甚至于你想要在后续阶段成长为一名Python爬虫大神。

基于python爬虫,我整理了一个完整的学习框架,把每个阶段需要学习的具体内容列举出来,希望能帮助初学者少走一些弯路。

如果你对以上知识点有一定的了解,学习 Python 爬虫就会相对容易。当然,实际操作过程中可能会遇到一些问题,如反爬虫策略、动态加载内容、登录验证等,这些需要你根据实际情况进行解决。

三、爬虫工具

学习爬虫需要借助以下工具:

1、Python编程语言:需要掌握Python的基本语法和常用的库。

2、爬虫框架:需要学习使用一些爬虫框架,如Scrapy、BeautifulSoup等。

3、浏览器抓包工具:需要学习使用抓包工具,如Fiddler、Wireshark等。

4、代理IP池:需要使用代理IP池来避免被封IP。

5、验证码识别技术:需要了解验证码的种类和识别方法。

6、数据存储工具:需要使用数据存储工具来存储爬取到的数据,如数据库、文件等。

7、数据清洗工具:需要使用数据清洗工具来清洗、去重、格式化等处理爬取到的数据

总结

综上所述,要掌握 Python 爬虫,最重要的是进行大量实践。理论知识固然重要,但只有通过实践才能真正理解爬虫的工作原理。你可以尝试:

- 简单的爬虫项目:从简单的网站开始,如抓取天气预报、新闻头条、图片网、电影等信息。

- 增加难度:随着技能的提高,可以尝试对动态加载内容的网站进行爬取,了解 JavaScript 是如何与页面交互的。

- 参与开源项目:在 GitHub 上寻找开源爬虫项目,参与其中,不仅能提高技术,还能与其他开发者交流。

通过不断的实践和总结经验,你将会在 Python 爬虫的道路上越走越远。

以上就是学习Python爬虫路线,更多关于Python爬虫的资料可以丝我,免费提供Python基础的学习资料。