使用curl实现多线程

使用curl实现多线程

curl一般用来抓取网页,第二种就是get或者post数据,第三种应用就是实现PHP的多线程任务

下面来实现多线程的

可以返回:

- URLINFO_EFFECTIVE_URL – 最后一个有效的URL地址

- CURLINFO_HTTP_CODE – 最后一个收到的HTTP代码

- CURLINFO_FILETIME – 远程获取文档的时间,如果无法获取,则返回值为“-1”

- CURLINFO_TOTAL_TIME – 最后一次传输所消耗的时间

- CURLINFO_NAMELOOKUP_TIME – 名称解析所消耗的时间

- CURLINFO_CONNECT_TIME – 建立连接所消耗的时间

- CURLINFO_PRETRANSFER_TIME – 从建立连接到准备传输所使用的时间

- CURLINFO_STARTTRANSFER_TIME – 从建立连接到传输开始所使用的时间

- CURLINFO_REDIRECT_TIME – 在事务传输开始前重定向所使用的时间

- CURLINFO_SIZE_UPLOAD – 上传数据量的总值

- CURLINFO_SIZE_DOWNLOAD – 下载数据量的总值

- CURLINFO_SPEED_DOWNLOAD – 平均下载速度

- CURLINFO_SPEED_UPLOAD – 平均上传速度

- CURLINFO_HEADER_SIZE – header部分的大小

- CURLINFO_HEADER_OUT – 发送请求的字符串

- CURLINFO_REQUEST_SIZE – 在HTTP请求中有问题的请求的大小

- CURLINFO_SSL_VERIFYRESULT – 通过设置CURLOPT_SSL_VERIFYPEER返回的SSL证书验证请求的结果

- CURLINFO_CONTENT_LENGTH_DOWNLOAD – 从Content-Length: field中读取的下载内容长度

- CURLINFO_CONTENT_LENGTH_UPLOAD – 上传内容大小的说明

- CURLINFO_CONTENT_TYPE – 下载内容的Content-Type:值,NULL表示服务器没有发送有效的Content-Type: header

<?php

/*

curl 多线程抓取

*/

/**

* curl 多线程

*

* @param array $array 并行网址

* @param int $timeout 超时时间

* @return array

*/

function Curl_http($array,$timeout){

$res = array();

$mh = curl_multi_init();//创建多个curl语柄

$startime = getmicrotime();

foreach($array as $k=>$url){

$conn[$k]=curl_init($url);

curl_setopt($conn[$k], CURLOPT_TIMEOUT, $timeout);//设置超时时间

curl_setopt($conn[$k], CURLOPT_USERAGENT, 'Mozilla/5.0 (compatible; MSIE 5.01; Windows NT 5.0)');

curl_setopt($conn[$k], CURLOPT_MAXREDIRS, 7);//HTTp定向级别

curl_setopt($conn[$k], CURLOPT_HEADER, 0);//这里不要header,加块效率

curl_setopt($conn[$k], CURLOPT_FOLLOWLOCATION, 1); // 302 redirect

curl_setopt($conn[$k],CURLOPT_RETURNTRANSFER,1);

curl_multi_add_handle ($mh,$conn[$k]);

}

//防止死循环耗死cpu 这段是根据网上的写法

do {

$mrc = curl_multi_exec($mh,$active);//当无数据,active=true

} while ($mrc == CURLM_CALL_MULTI_PERFORM);//当正在接受数据时

while ($active and $mrc == CURLM_OK) {//当无数据时或请求暂停时,active=true

if (curl_multi_select($mh) != -1) {

do {

$mrc = curl_multi_exec($mh, $active);

} while ($mrc == CURLM_CALL_MULTI_PERFORM);

}

}

foreach ($array as $k => $url) {

curl_error($conn[$k]);

$res[$k]=curl_multi_getcontent($conn[$k]);//获得返回信息

$header[$k]=curl_getinfo($conn[$k]);//返回头信息

curl_close($conn[$k]);//关闭语柄

curl_multi_remove_handle($mh , $conn[$k]); //释放资源

}

curl_multi_close($mh);

$endtime = getmicrotime();

$diff_time = $endtime - $startime;

return array('diff_time'=>$diff_time,

'return'=>$res,

'header'=>$header

);

}

//计算当前时间

function getmicrotime() {

list($usec, $sec) = explode(" ",microtime());

return ((float)$usec + (float)$sec);

}

//测试一下,curl 三个网址

$array = array(

"http://www.weibo.com/",

"http://www.renren.com/",

"http://www.qq.com/"

);

$data = Curl_http($array,'10');//调用

var_dump($data);//输出

?>

关于do while的那段解释:

因为$active要等全部url数据接受完毕才变成false,所以这里用到了curl_multi_exec的返回值判断是否还有数据,

当有数 据的时候就不停调用curl_multi_exec,暂时没有数据就进入select阶段,新数据一来就可以被唤醒继续执行。

这里的好处就是CPU的无谓 消耗没有了。更详细的说明:http://hi.baidu.com/%D4%C2%D2%B9%C4%FD%ED%F8/blog/item/9dfcf4fbe6b84374024f563d.html

这个多线程的写法步骤:

第一步:调用curl_multi_init

第二步:循环调用curl_multi_add_handle

这一步需要注意的是,curl_multi_add_handle的第二个参数是由curl_init而来的子handle。

第三步:持续调用curl_multi_exec

第四步:根据需要循环调用curl_multi_getcontent获取结果

第五步:调用curl_multi_remove_handle,并为每个字handle调用curl_close

第六步:调用curl_multi_close

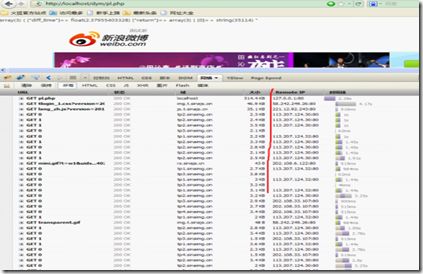

多线程的测试效果图:

总结:36个http请求,从执行的是时间顺序上来看,三个网站的ip交叉,说明是同时并发的!