Nexus1000v 在 VMware5.5中的 部署 使用 简易 实验 自留备用

Nexus1000v 在 VMware5.5中的 部署 使用 简易 实验 自留备用

本文使用命令行方式:明教教主使用过命令行 和 gui工具 两种方式;

有用链接后补:

最近要用到Nexus1000v,发现这个有点小复杂,自己最后做了个小实验,仅供参考,个人水平有限,不尽之处,请多指教。。。

说下环境:看过以前文章的朋友应该知道,我用的是台笔记本电脑,这次我折腾的彻底了,把THINKPAD T430 的35w i5 换成了 45W i7(功率加大,性能无敌,因为T430是双铜管散热,所以敢这么做),16G内存,64G固态硬盘+500G 7200转 日立

我用的四层虚拟化;物理主机――》win7――》VMware workstation――》esxi――》虚拟机;这次我终于把esxi――》虚拟机这一层弄通了,不会像上一次出现无法继续下去的情况了,

我原来是这么干的,workstation虚拟出2个esxi(4cpu+6g)组成集群,安装server08(域控)vcsa 1000v 实验主机,后来发现vcsa实在太占用资源了,这样做非常的慢

最后的方法,只虚拟出一个esxi 上装域控(其实这个不装也行,不影响你做实验的), vcsa(给8g内存,要不没法用,5.5真的很耗资源),1000v(3个e1000的网卡,少一个也不行,2g内存,再少就不启动了。。。),测试主机一台

你可能会问我为什么不在物理主机上装server08(这样域控不就有了,节省资源) 而用 win7,因为,如果你这样做,域控上安装不了vsphere client 实验初期无法进行 除非你还有别的主机发起,直到安装了vcsa你可以用web client,这都不是重点,重点是:server08装域控很费资源,我固态硬盘有时候都有点问题,你懂的,而且网络环境复杂,经常变更,dns服务器出了点问题。。。

我之前的环境已经做好了ovf文件(workstation虚拟出的一个esxi,上面有AD vcsa 1000v ubuntu10.04实验机),可以直接部署,需要的朋友可以找我要10g呢,从零开始很费时间的。。。

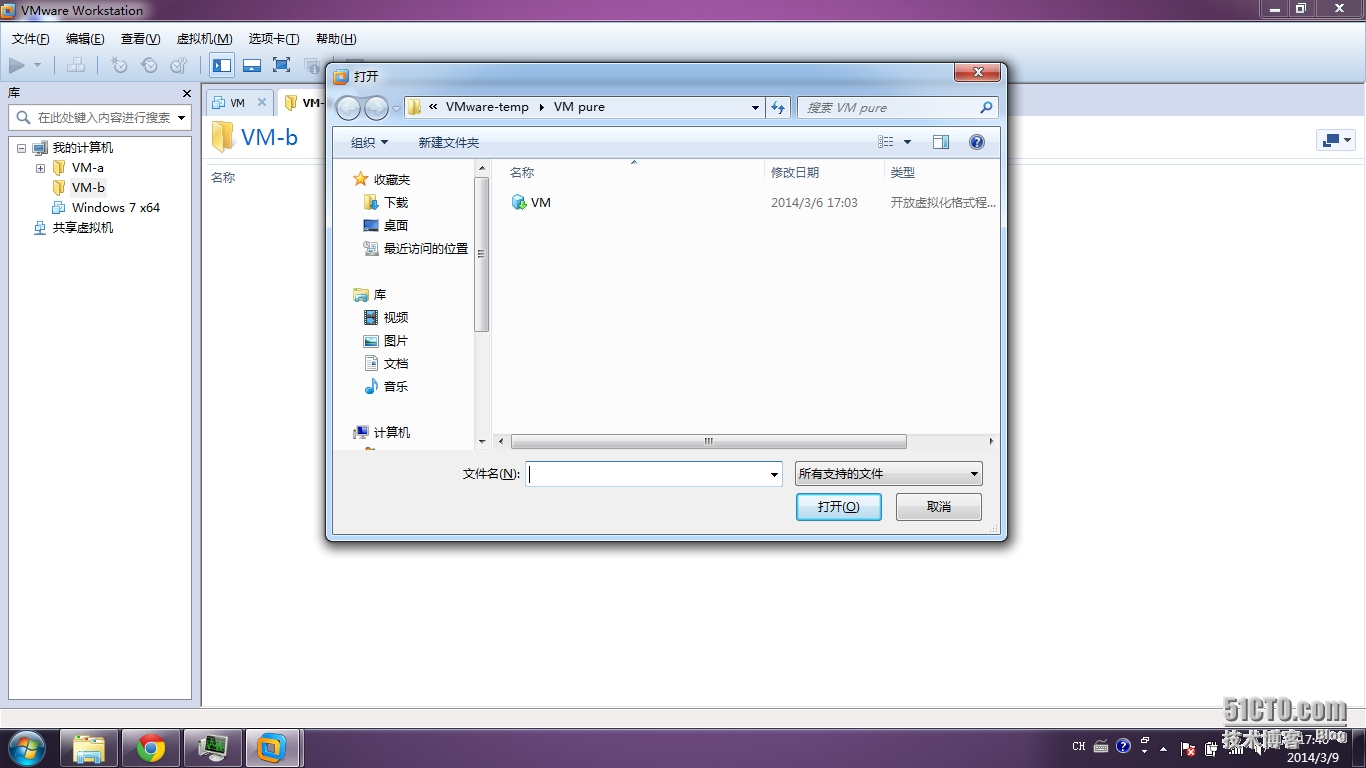

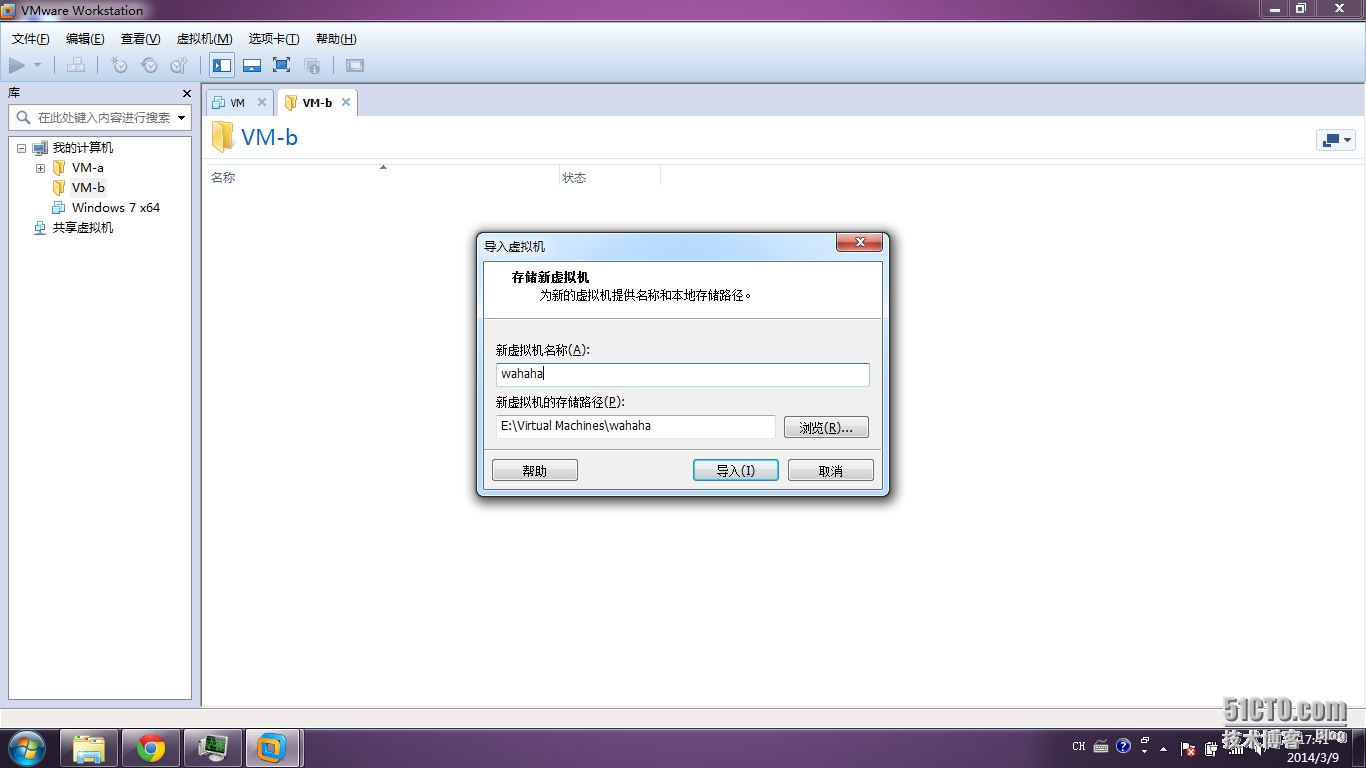

导入

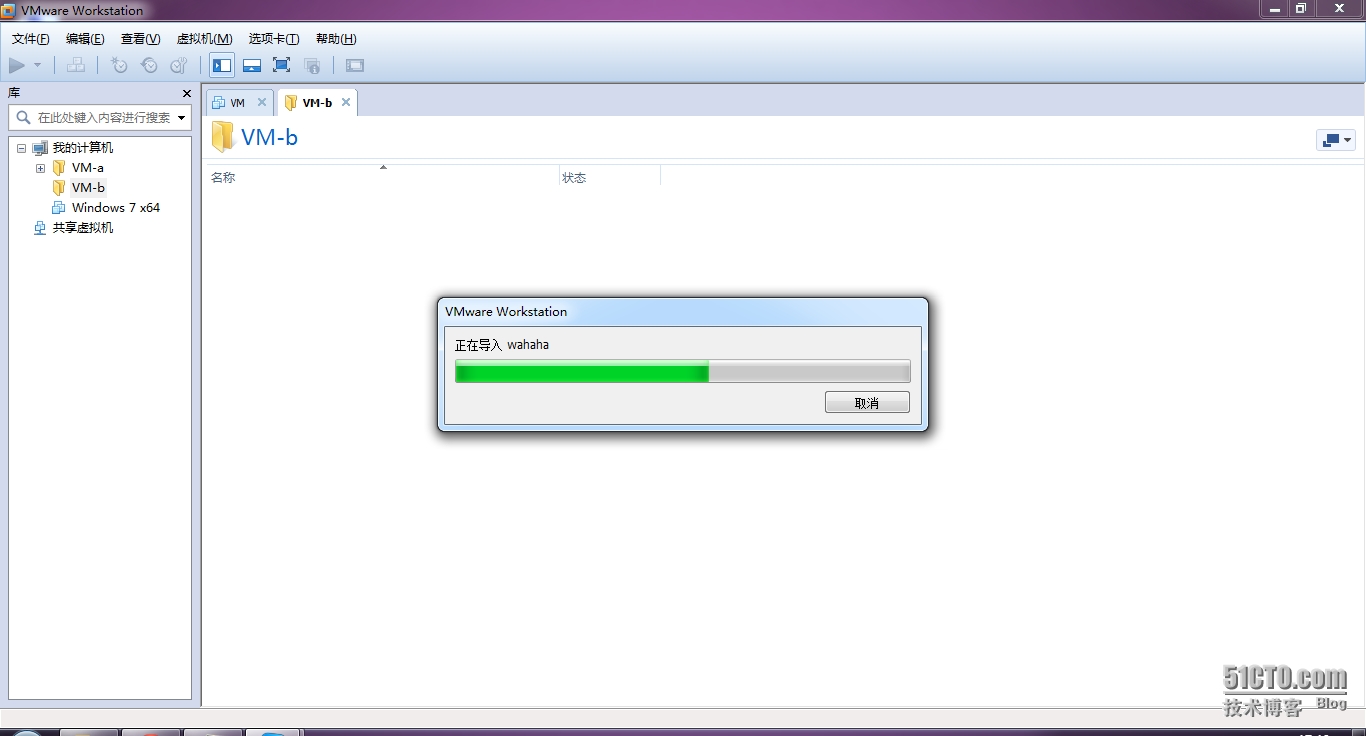

执行中。。。

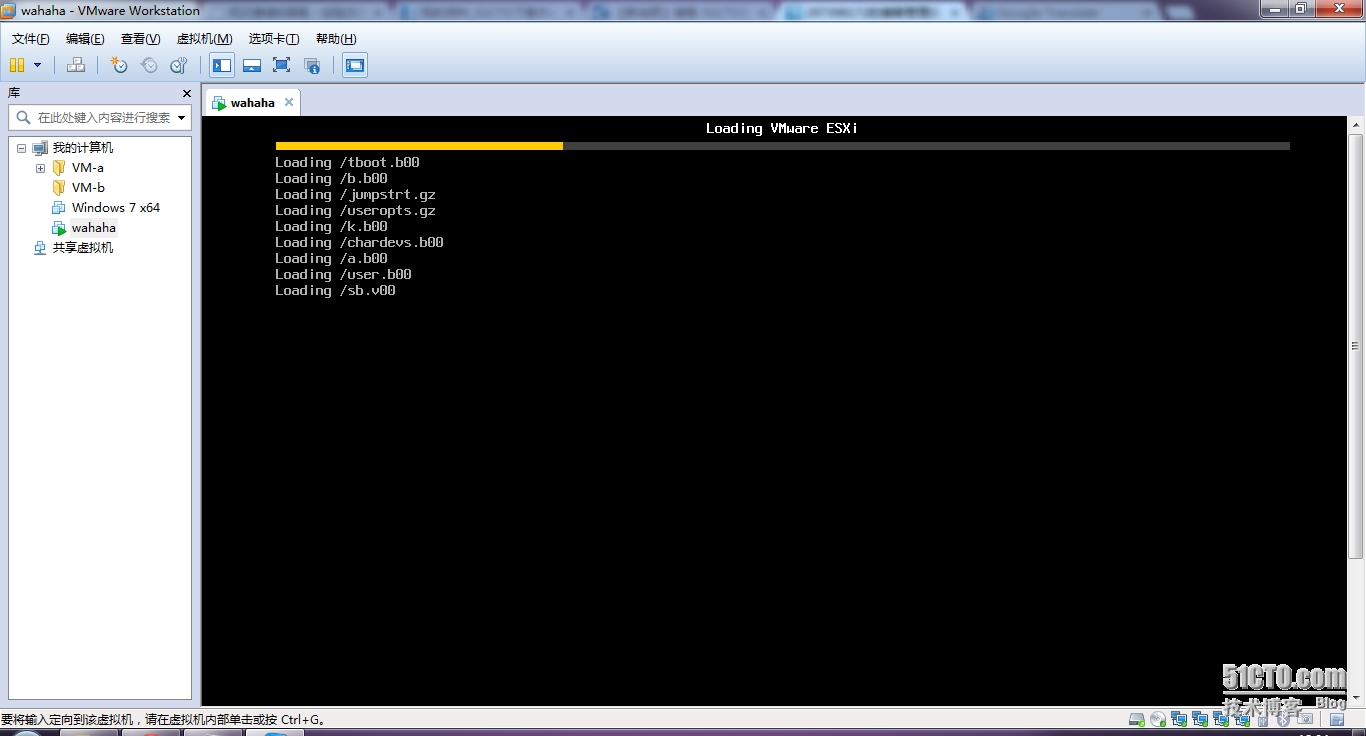

开启,注意如果你以后在这个esxi上安装虚机报esxi错误,请编辑他的设置――》cpi――》勾选VT-D选项。。。

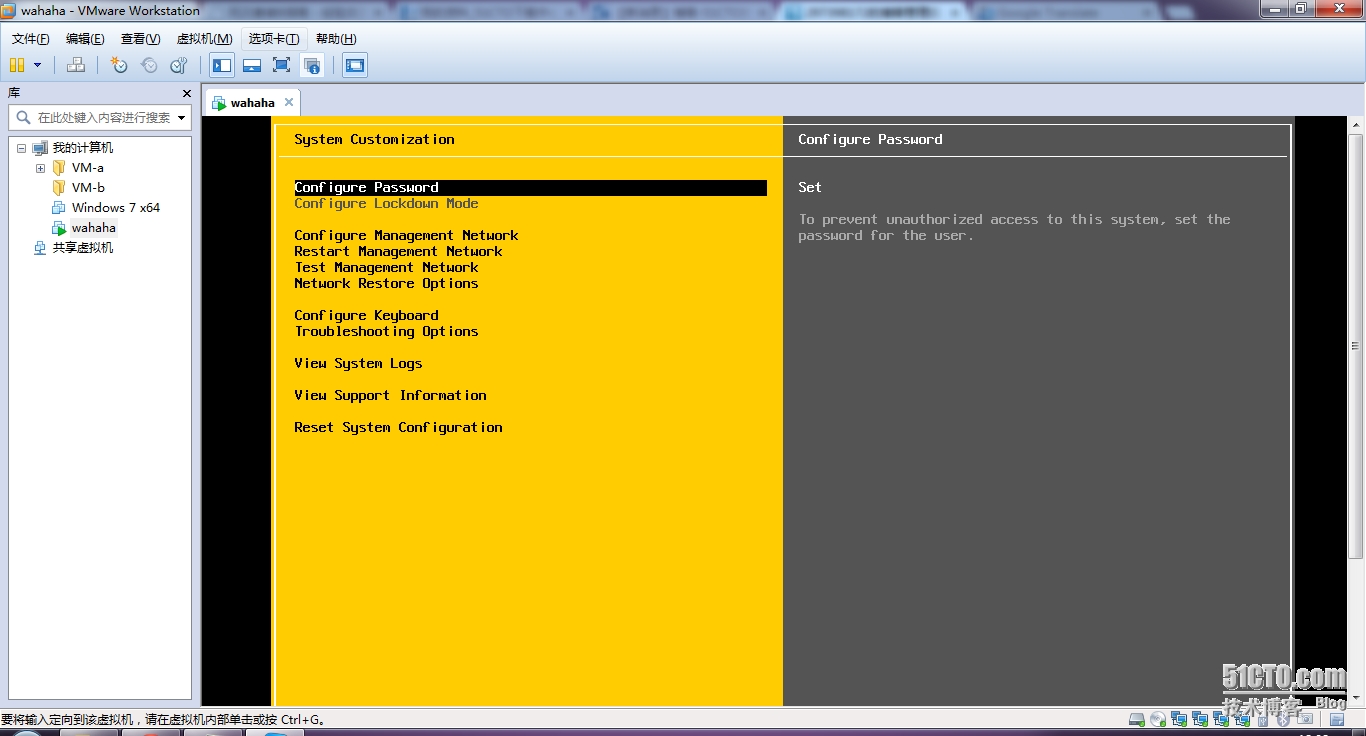

配置一下network

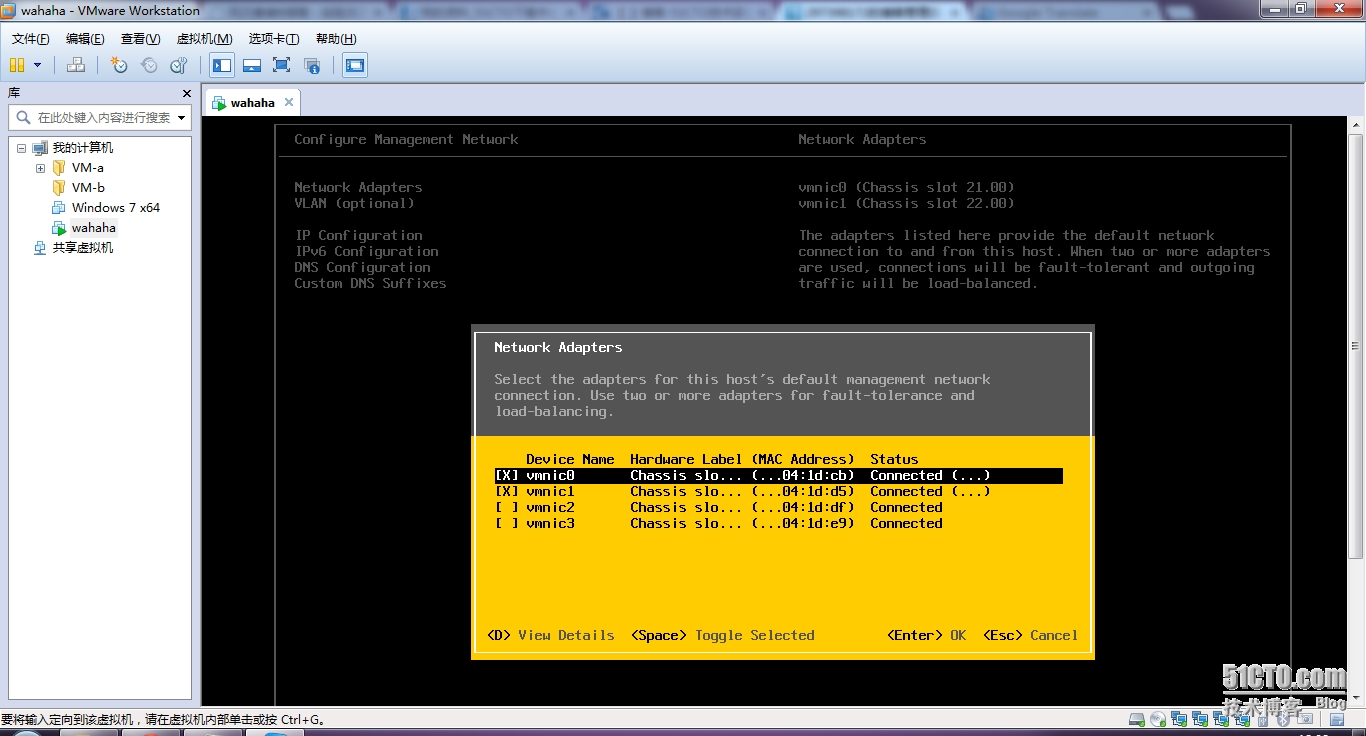

一如既往4块网卡2块给管理。。。后面我会把vmnic3给1000v,vmnic2给自带的分布式交换机。。。

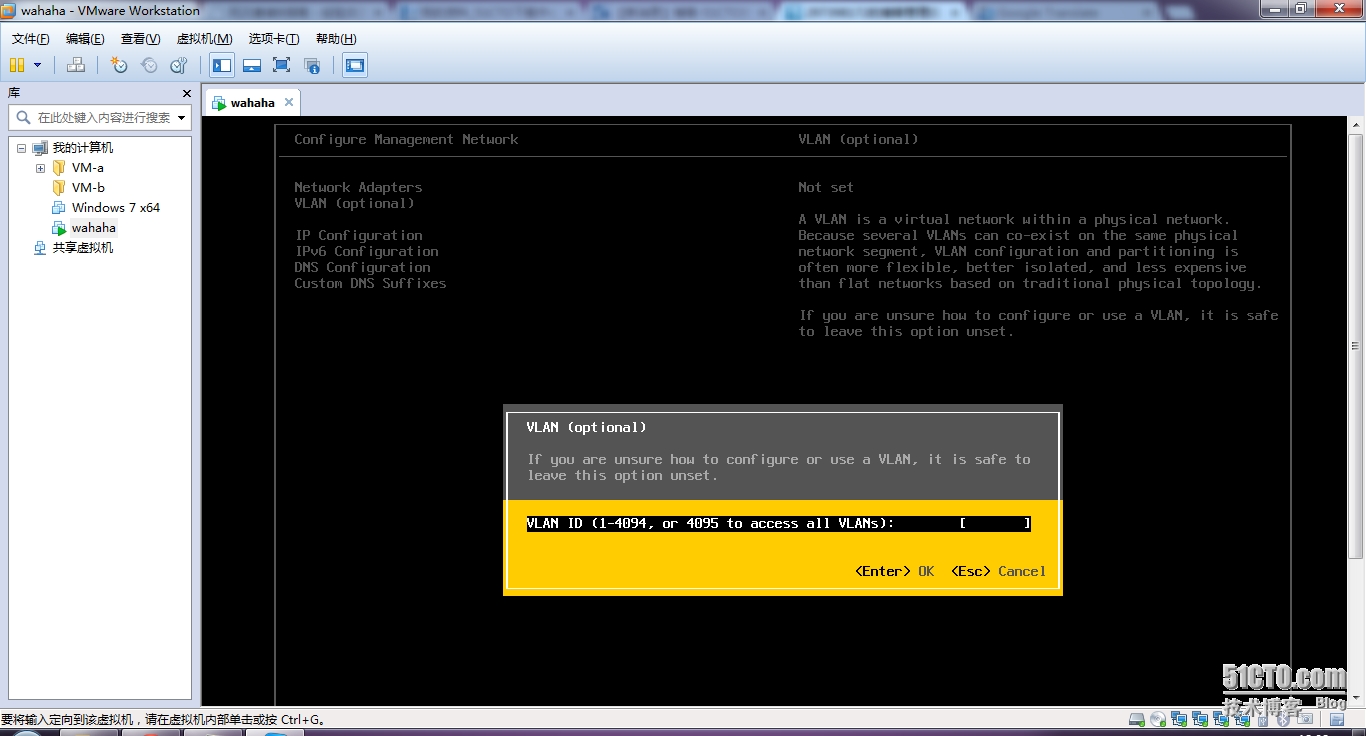

vlan设置,这是重点的,这里实验环境全部设置为default 也就是vlan1,以后的1000v的control,mgmt,packet3块网卡也都归属vlan1,以后的提供服务的端口组也是vlan1,,,uplink口也是vlan1.。。。

当然这样不是cisco推荐的,生产中,MGMT是VLAN11,control是vlan12,packet是vlan13,让他们个走个的吧,个端口组,提供服务的,分属各自vlan,如提供网页服务的分配给vlan14,提供oa的分配给vlan15,这样他们的上行uplink口必须是trunk

我这里直接就是默认的no set 。。。

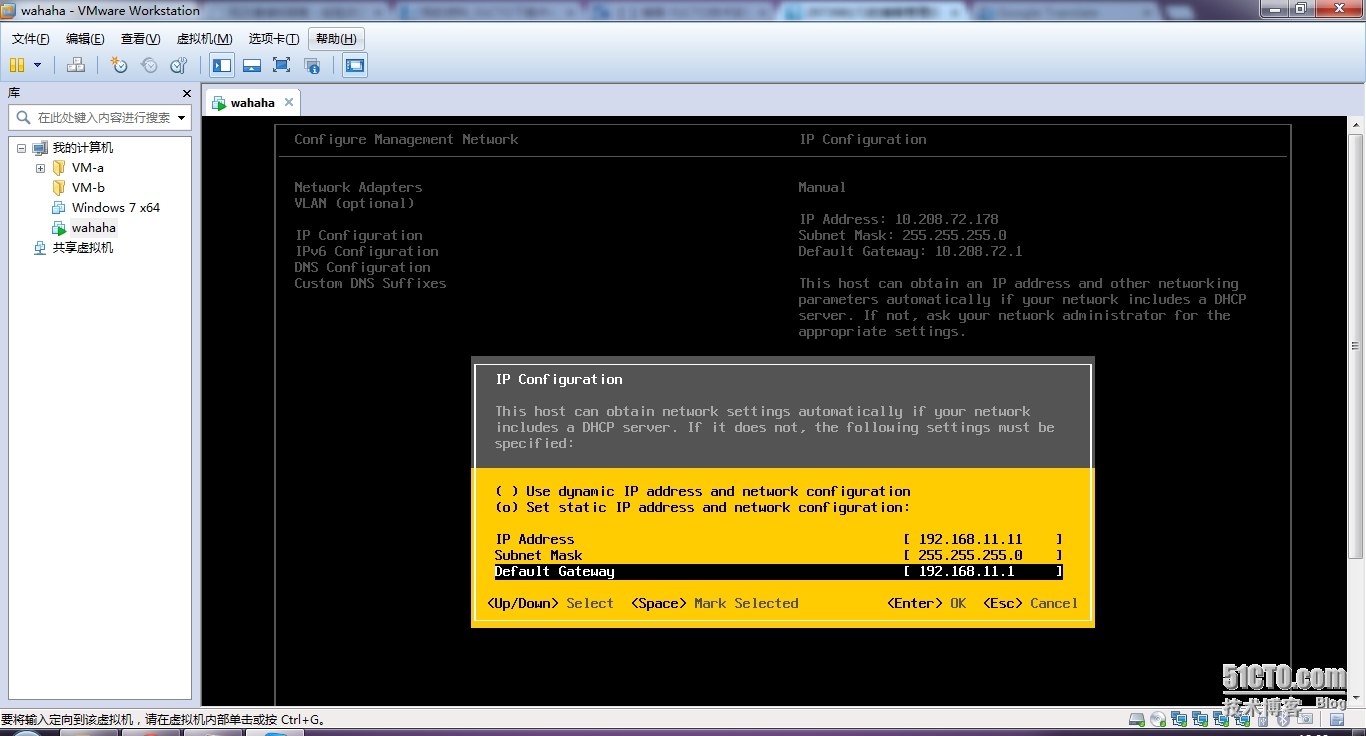

设置ip,gw

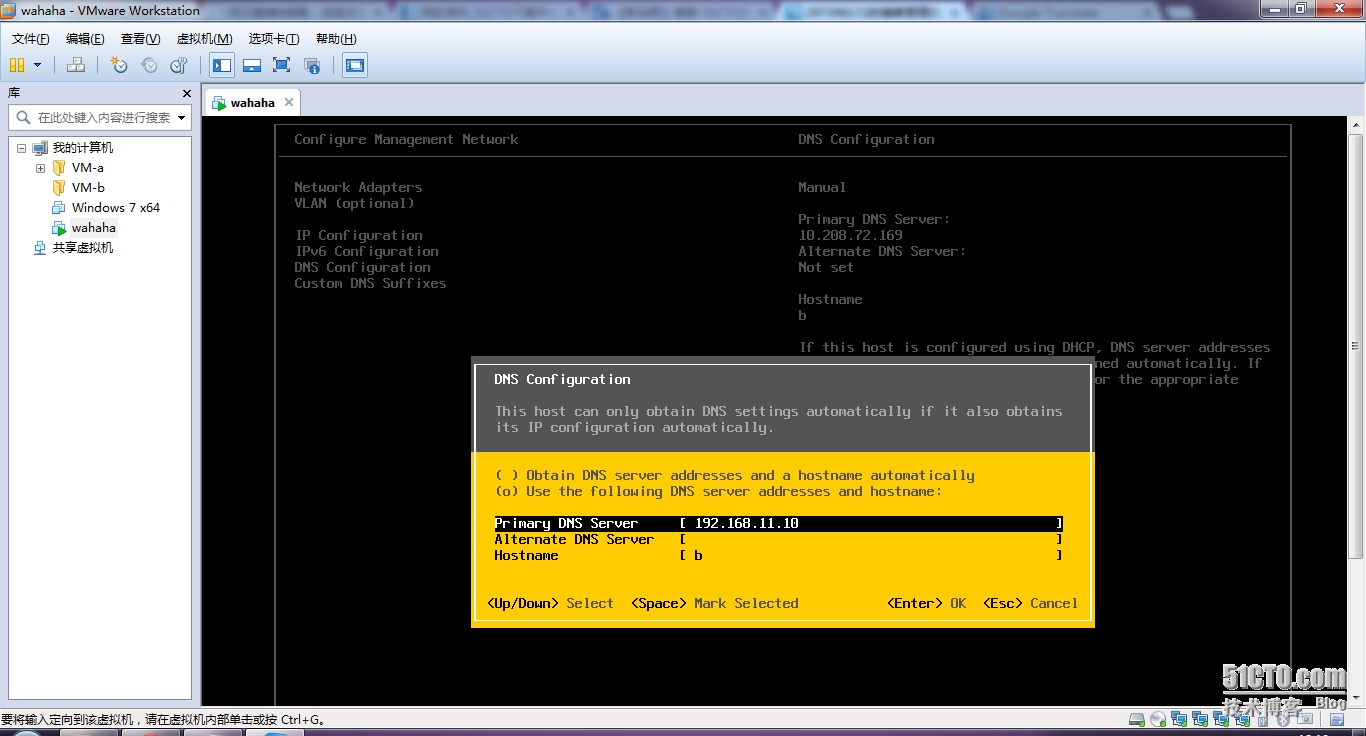

设置dns,hostname

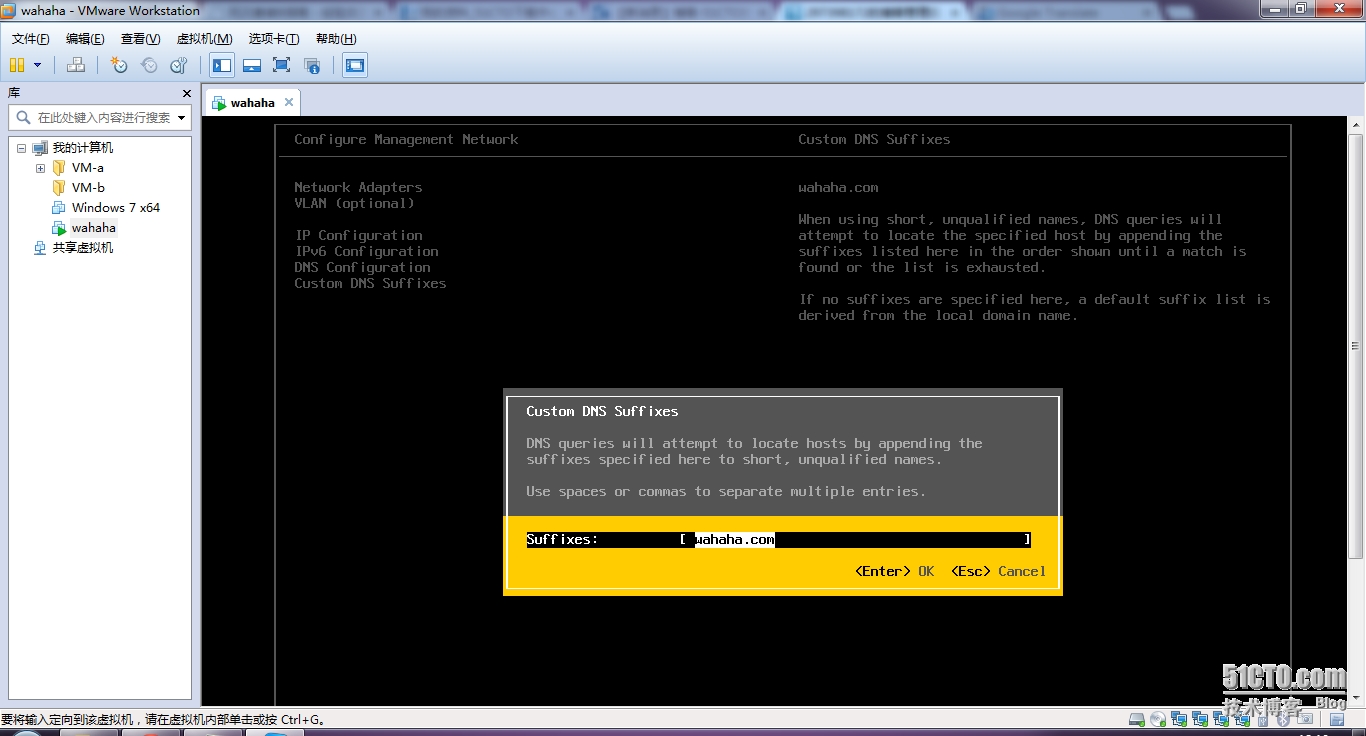

设置dns前缀

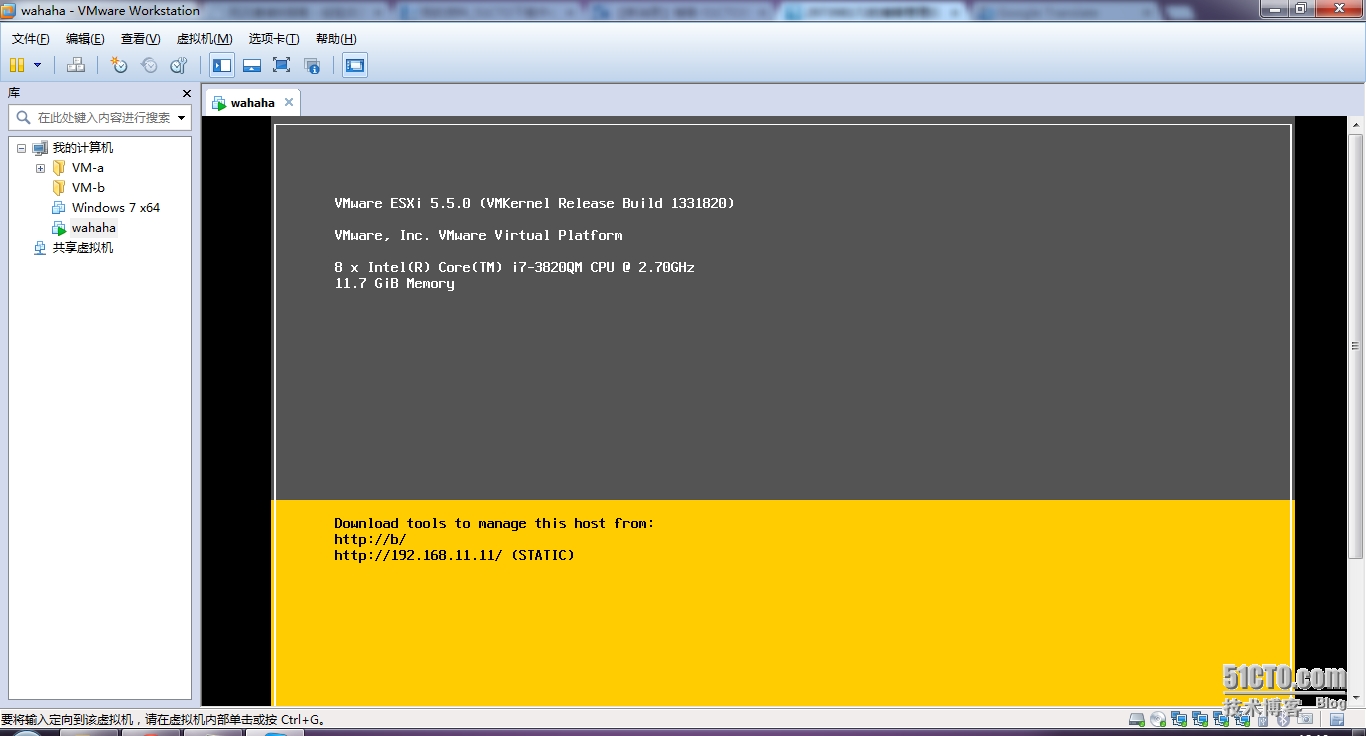

一切ok

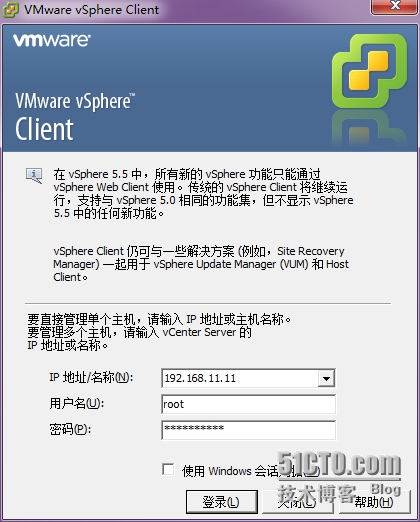

开始连接。。。

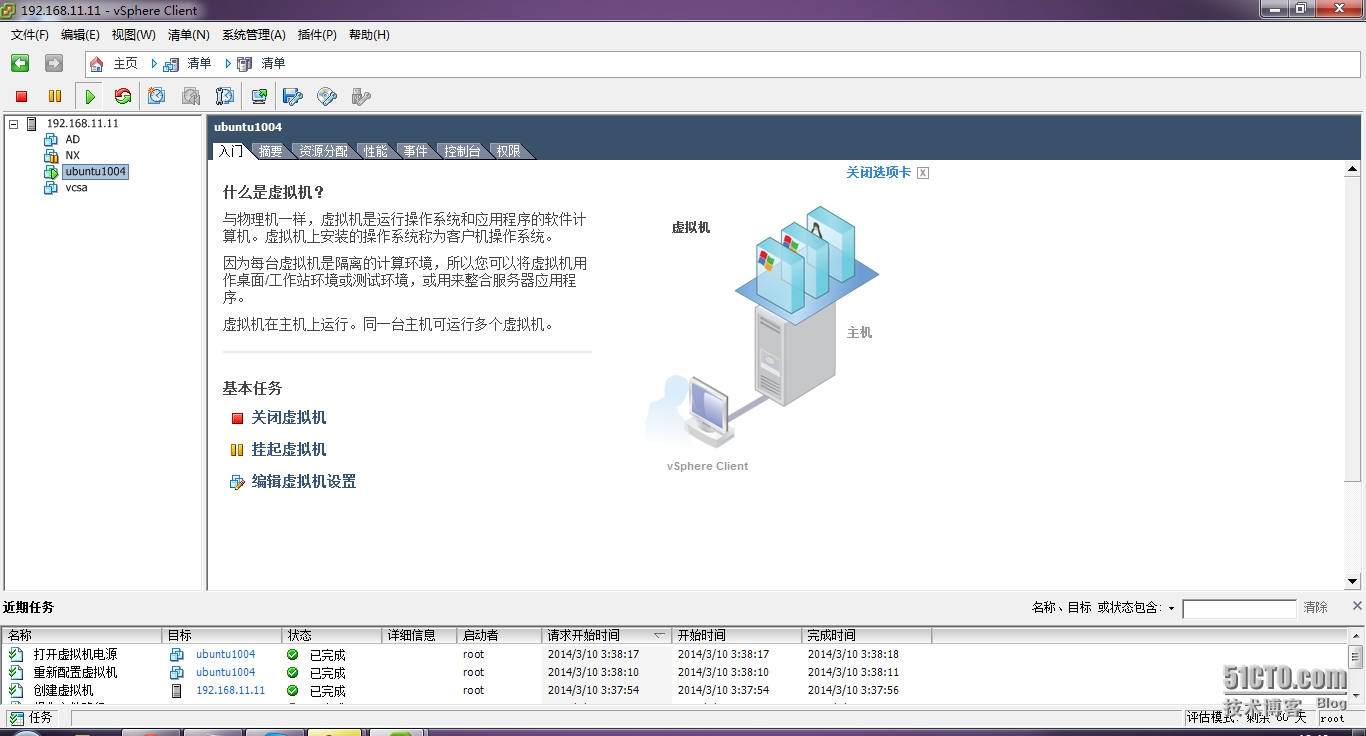

连接上了。。。里面4个都有,AD vcsa Nexus1000v ubuntu10.04试验机

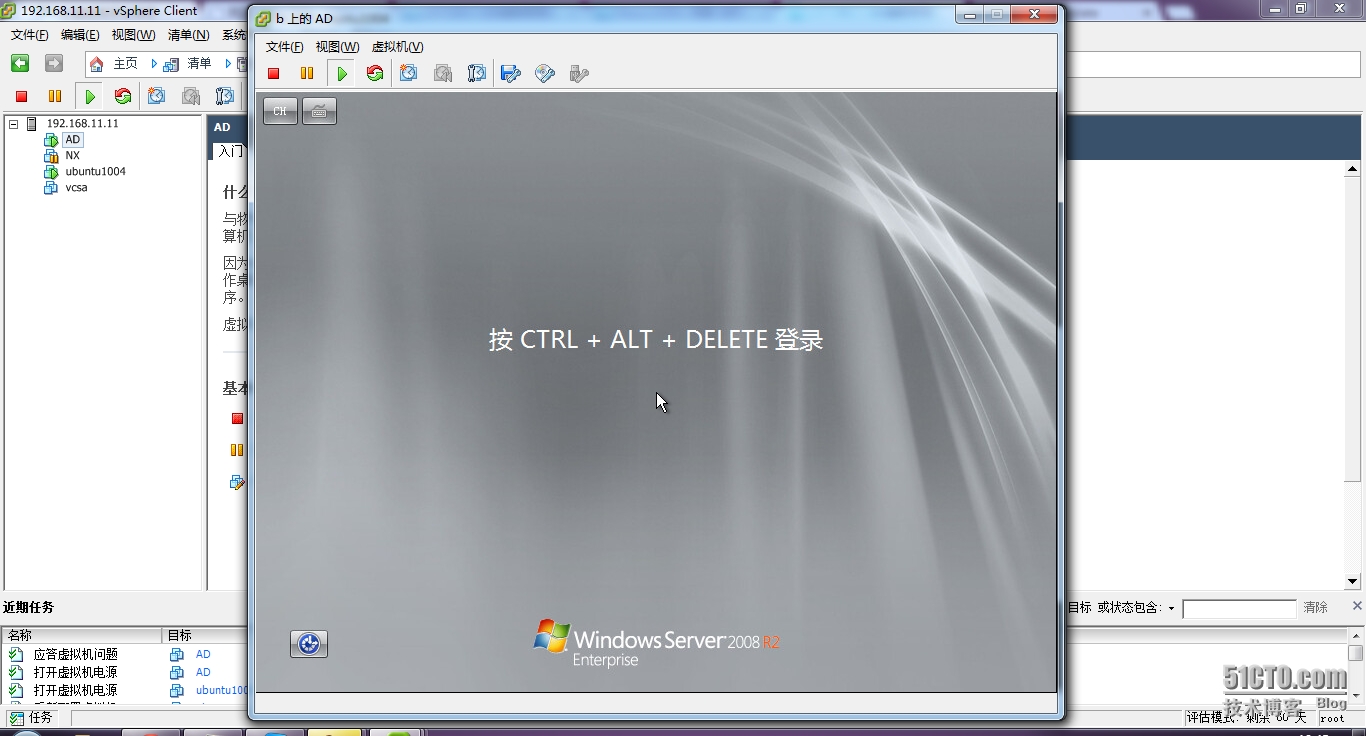

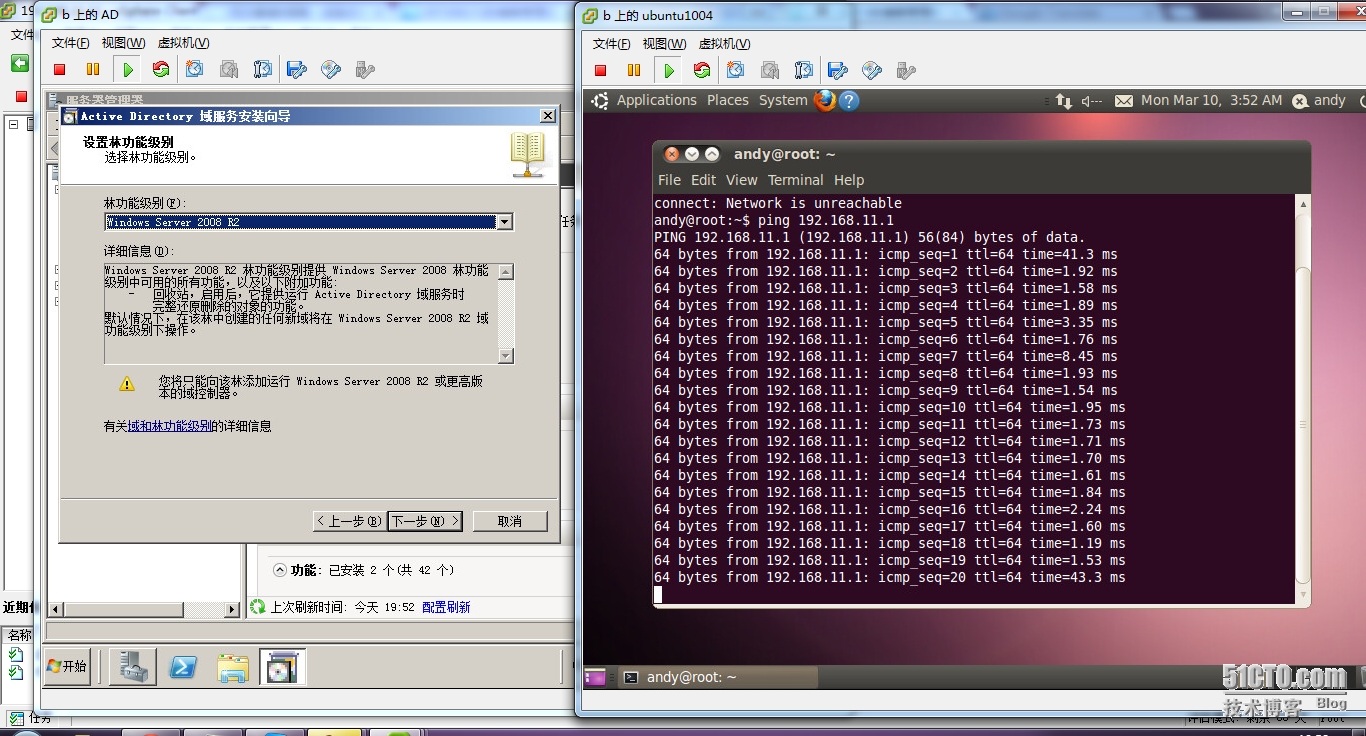

先配置AD

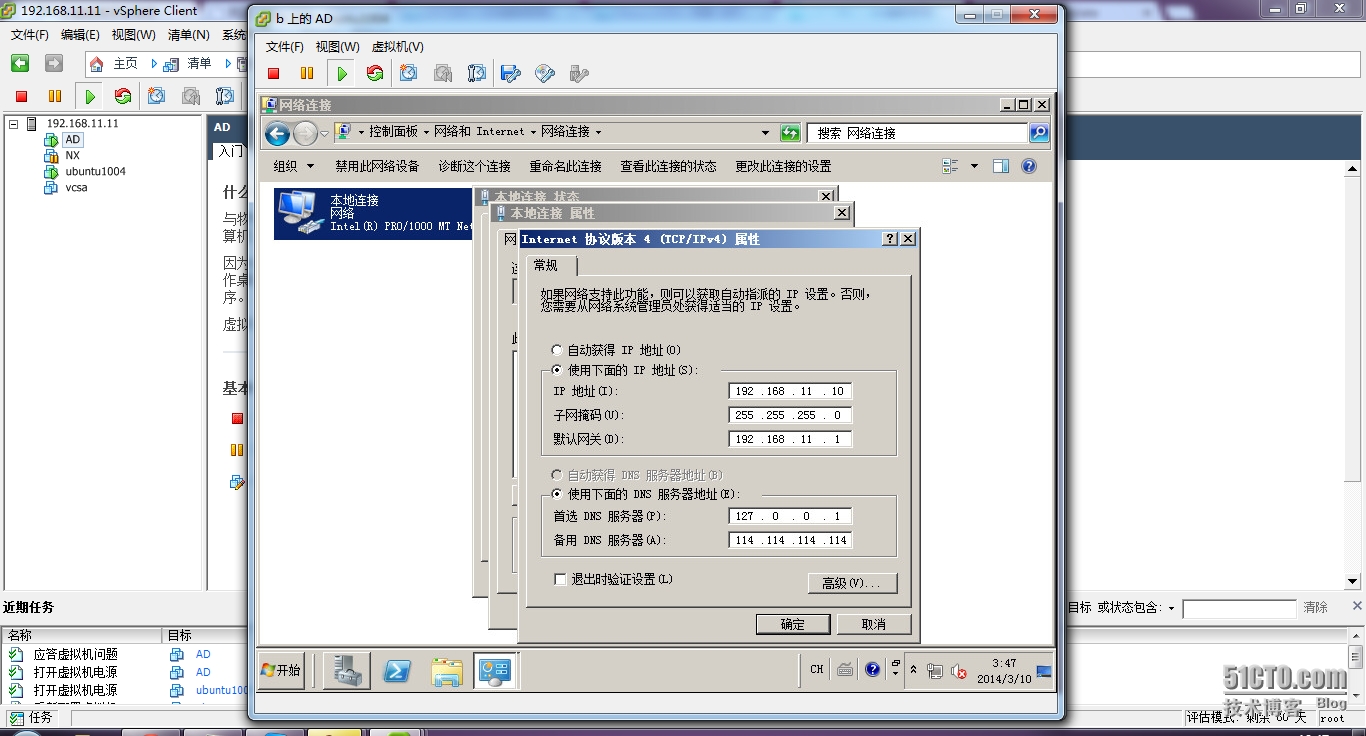

设置ip,我的AD是10

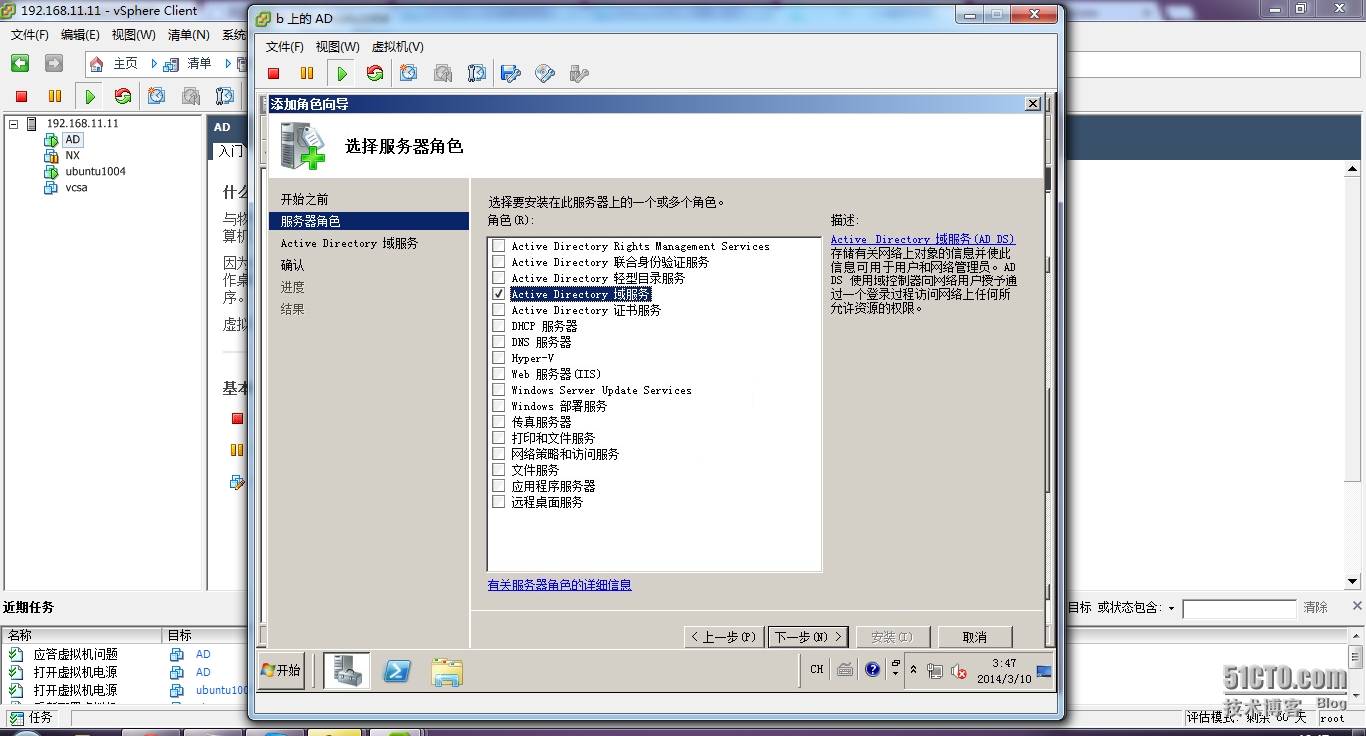

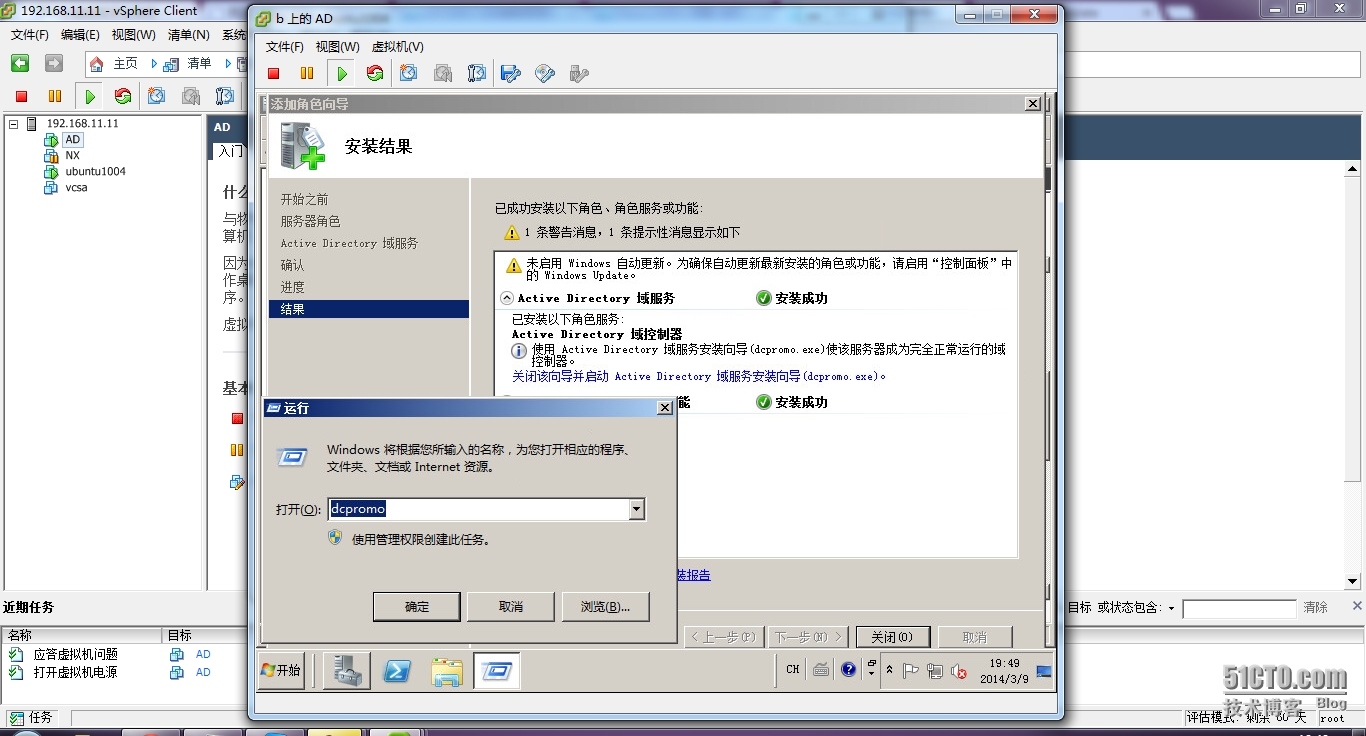

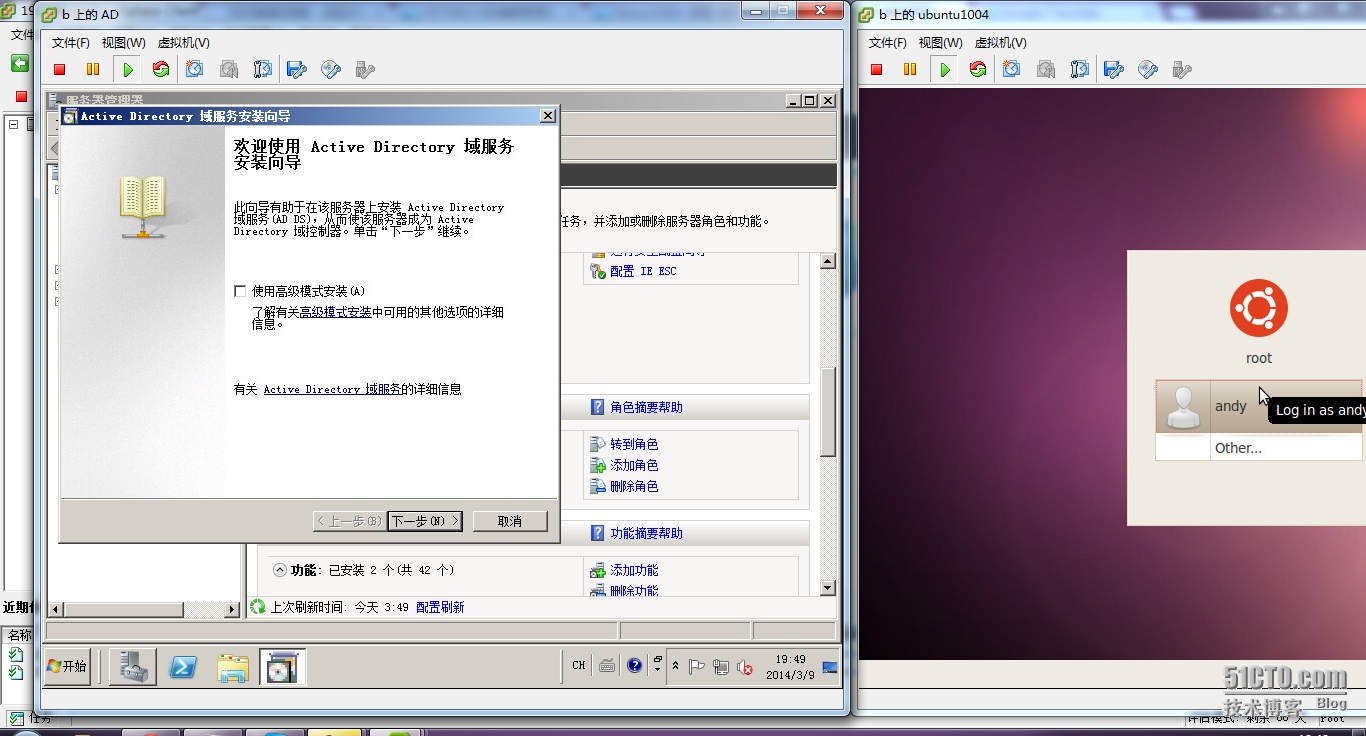

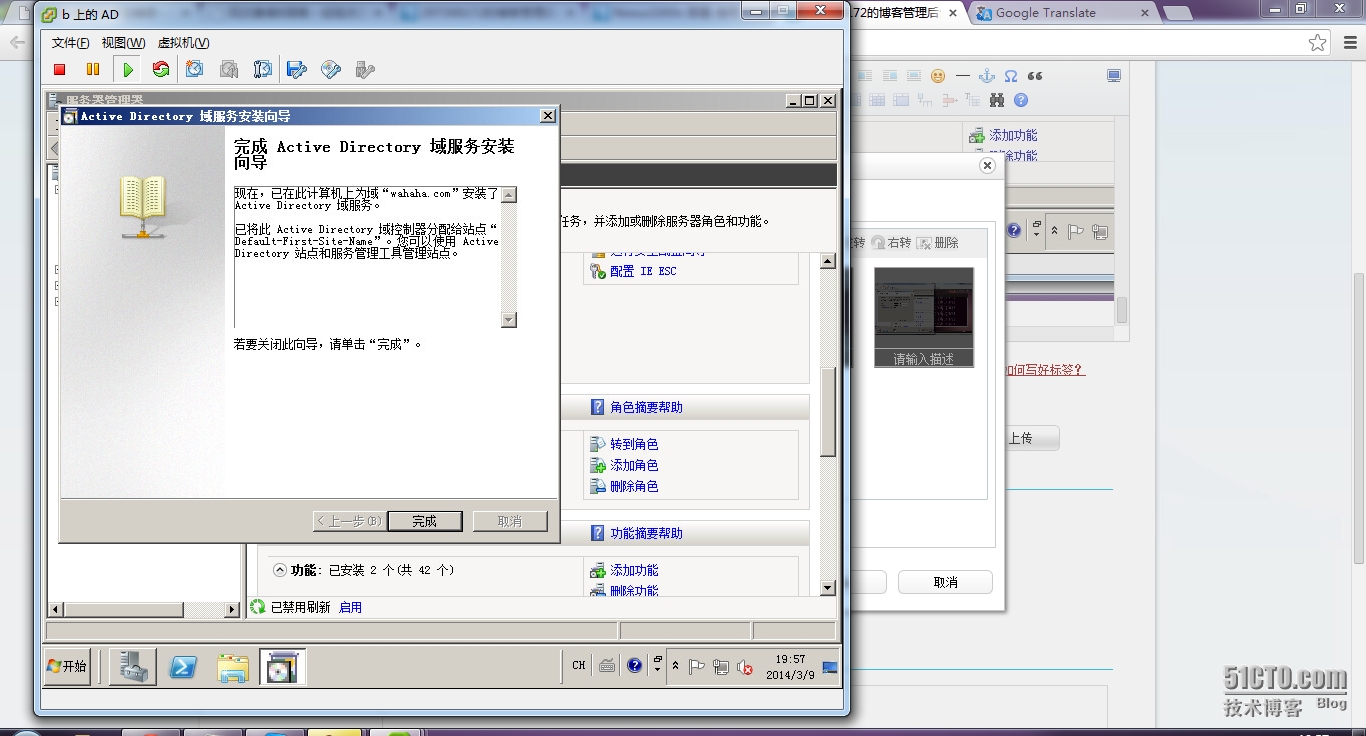

配置域控

配置域控

下一步

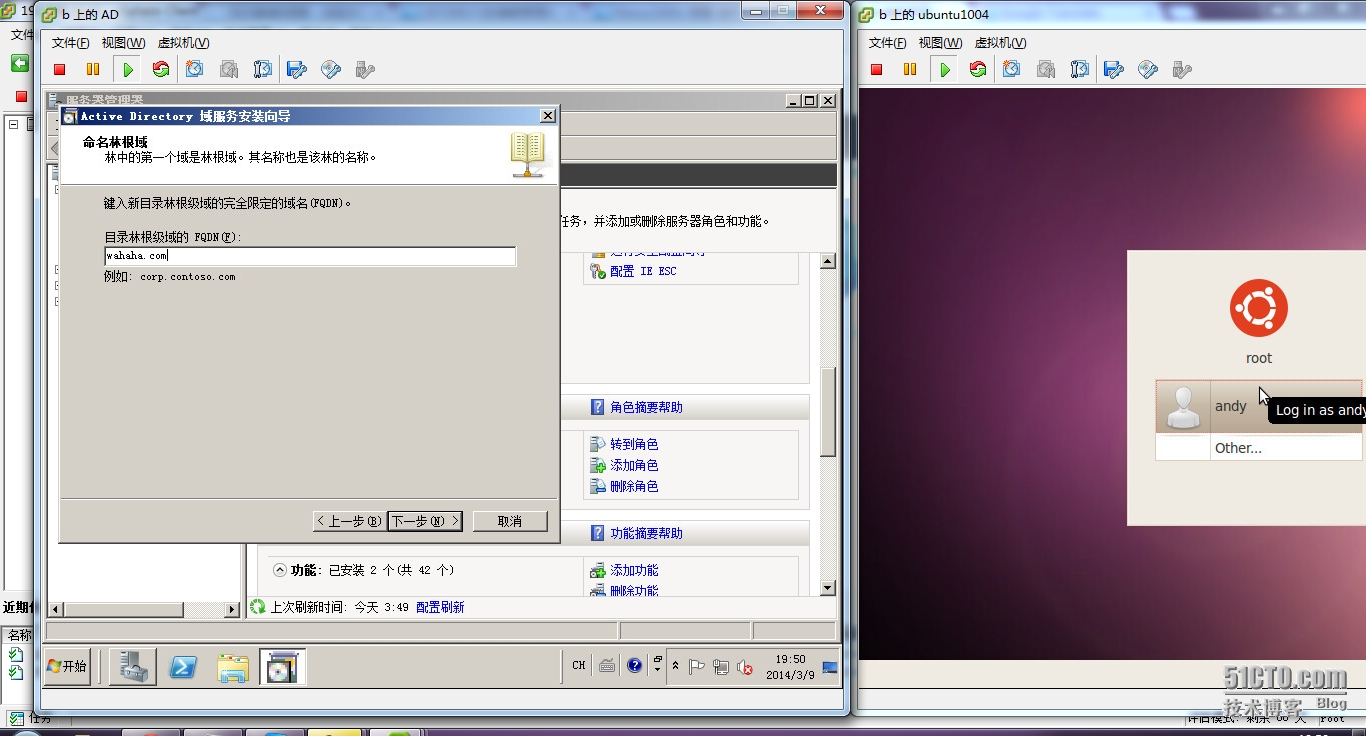

域名

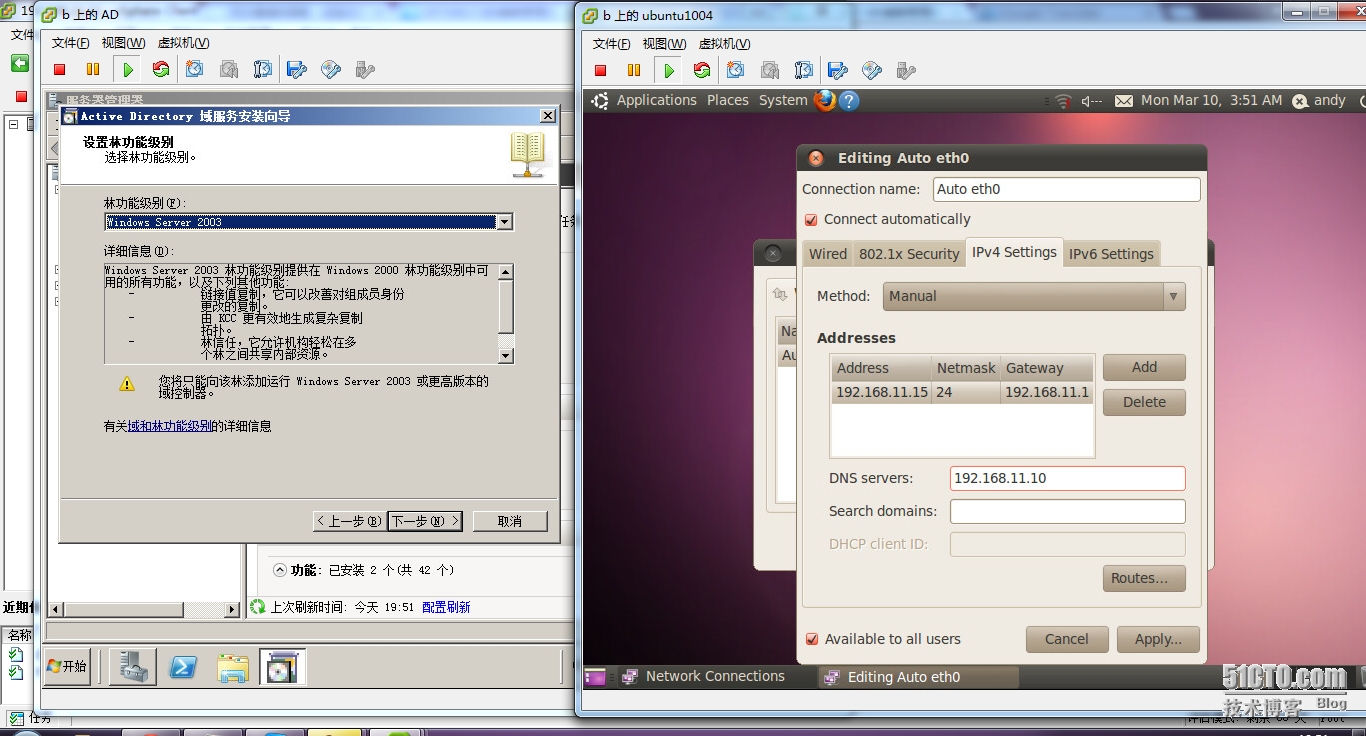

只有08没有03

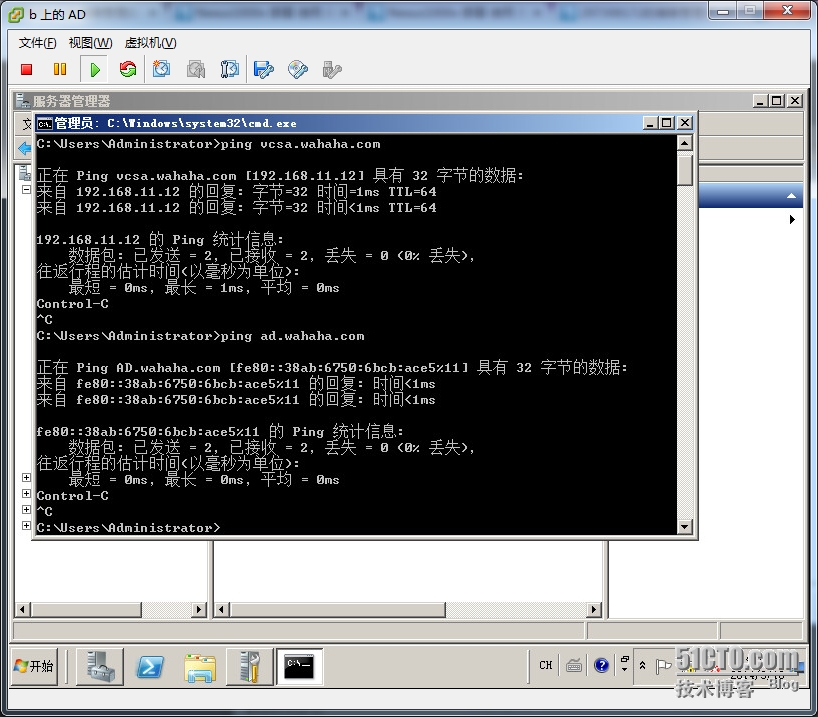

四层嵌套都能ping通 ok

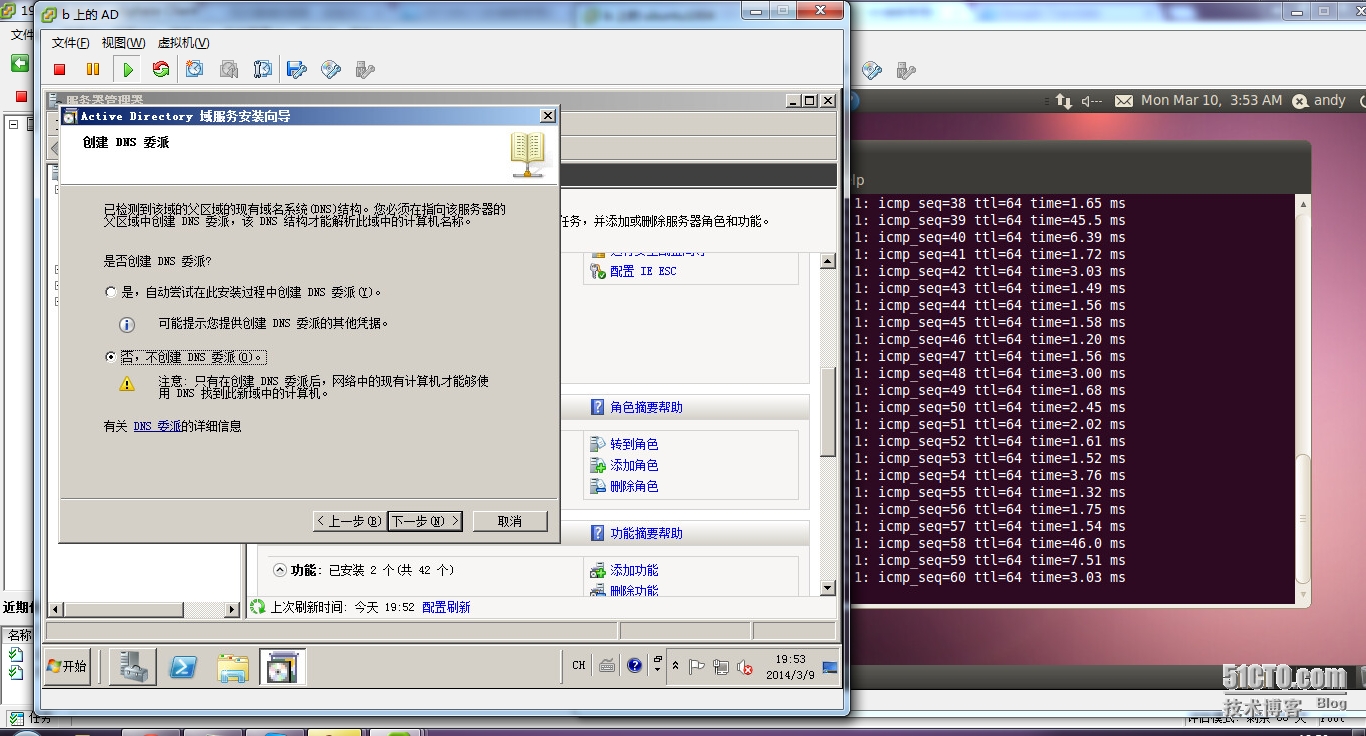

内网不要委派。。。

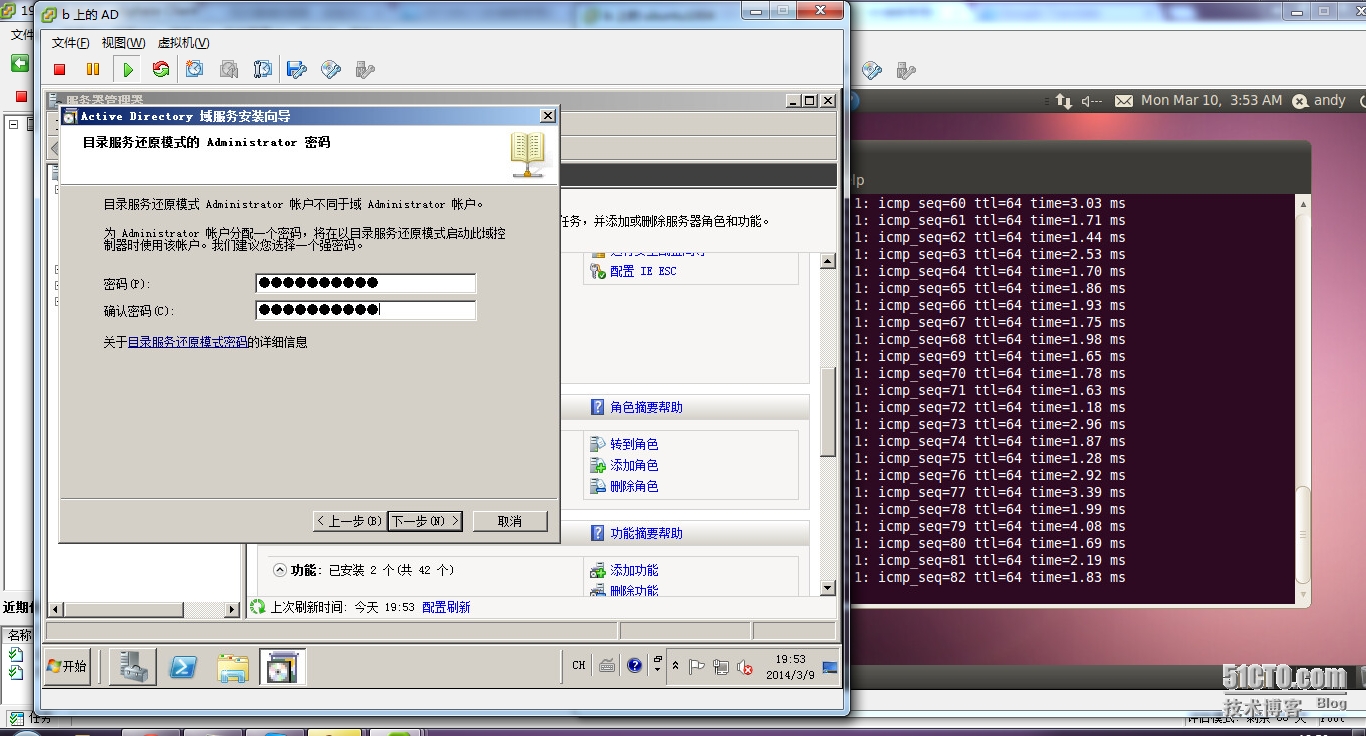

输入密码

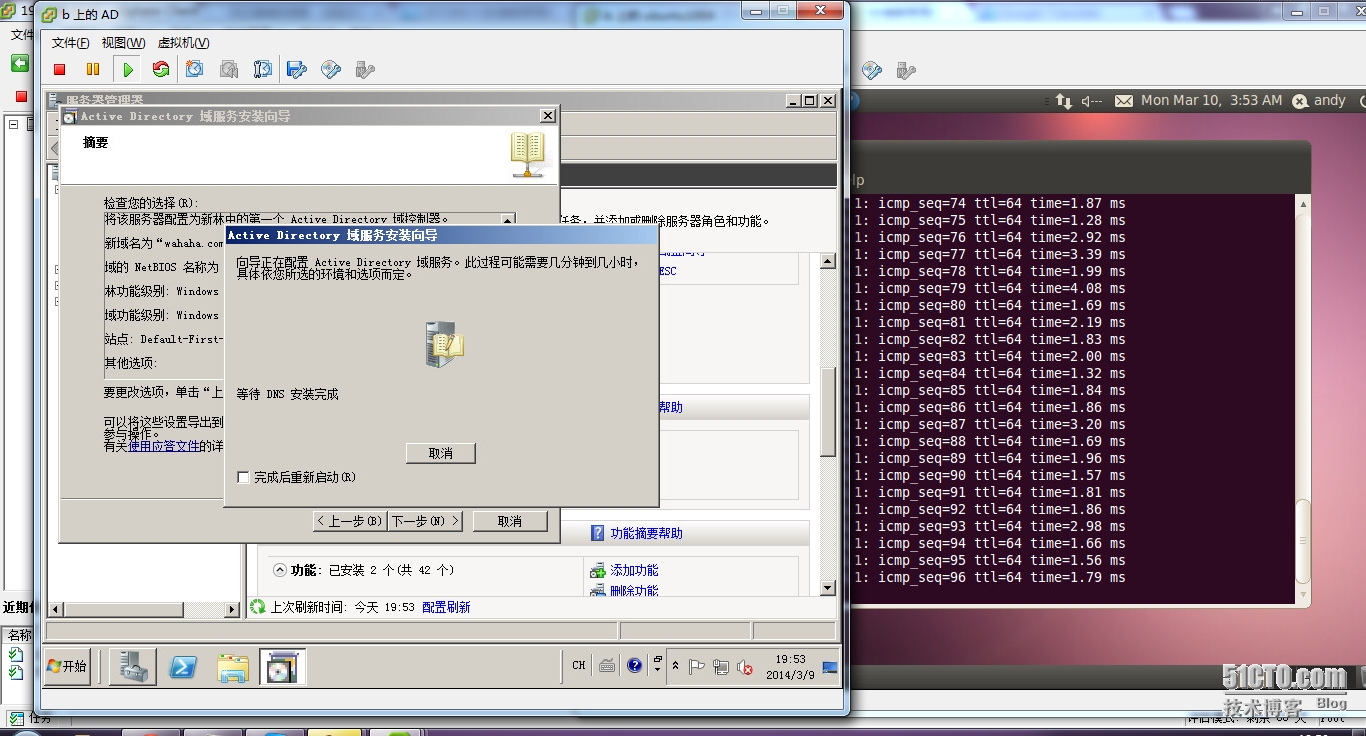

进行中,然后重启,

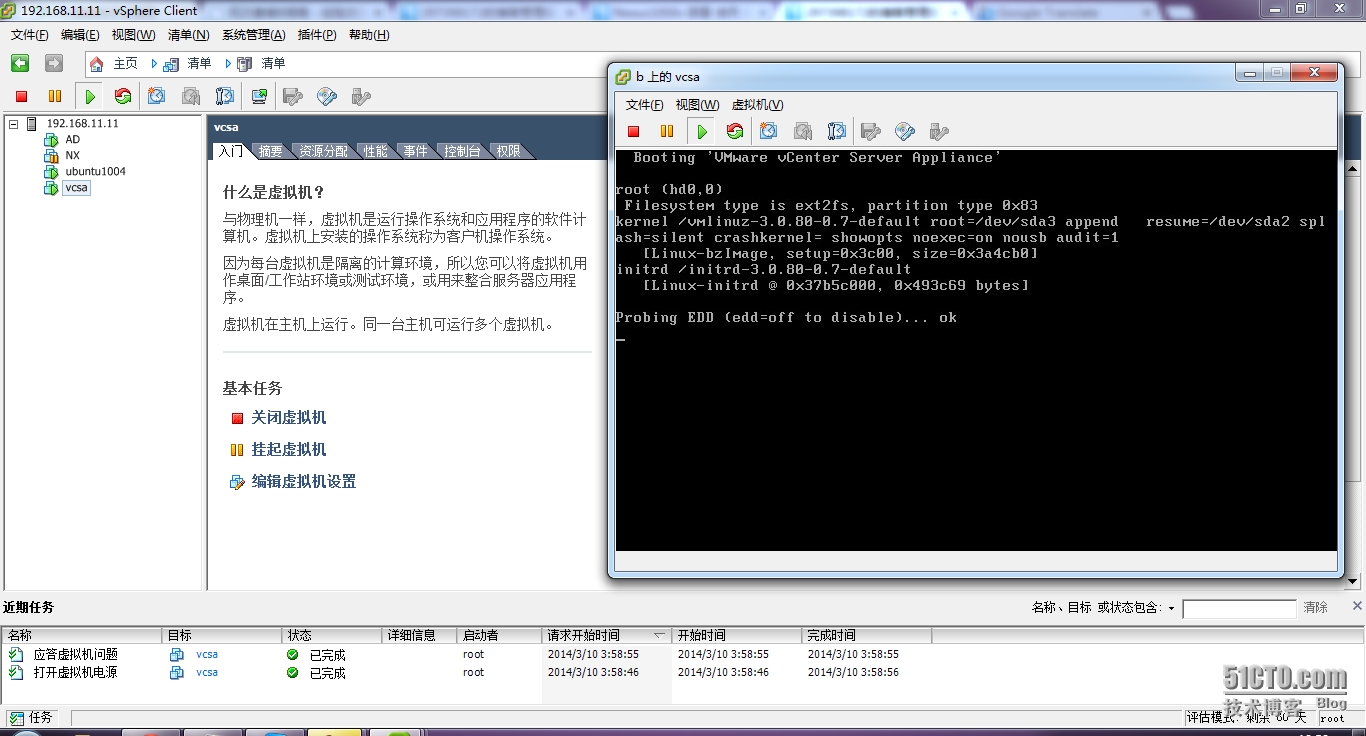

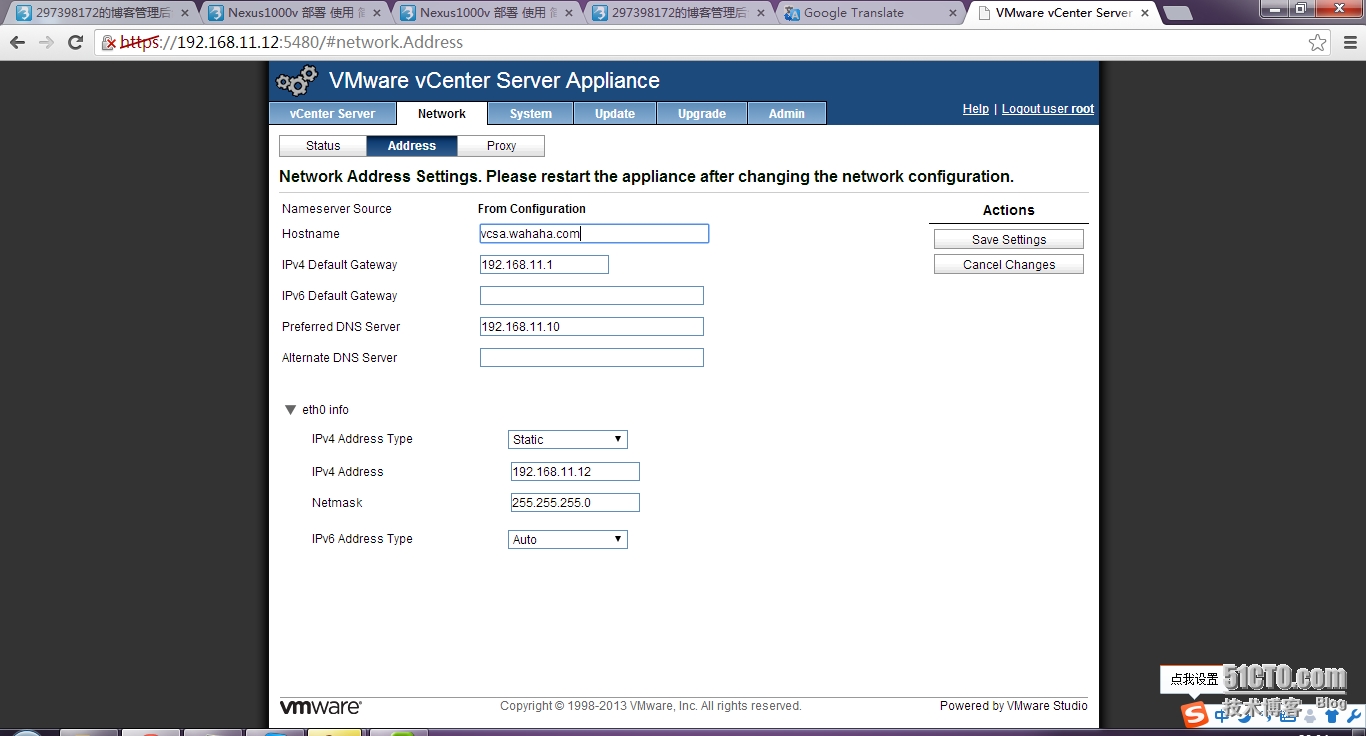

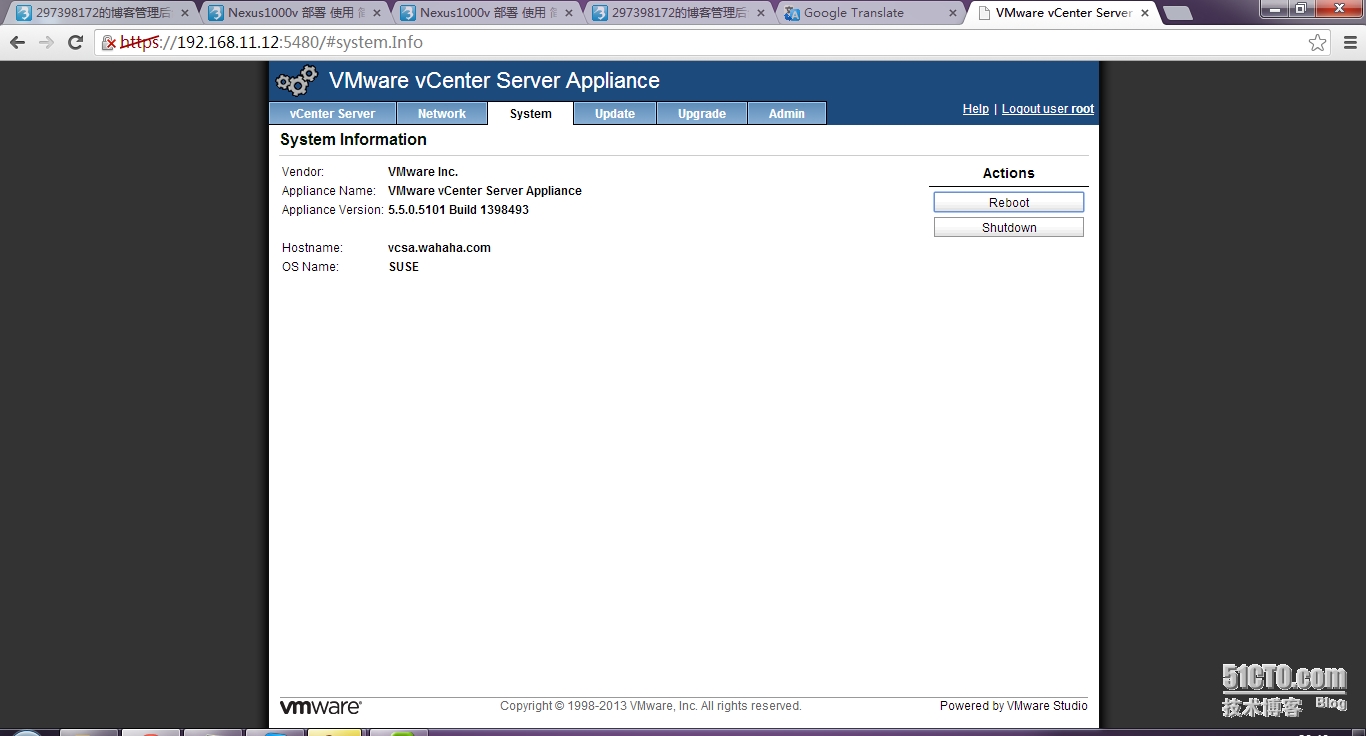

配置vcsa

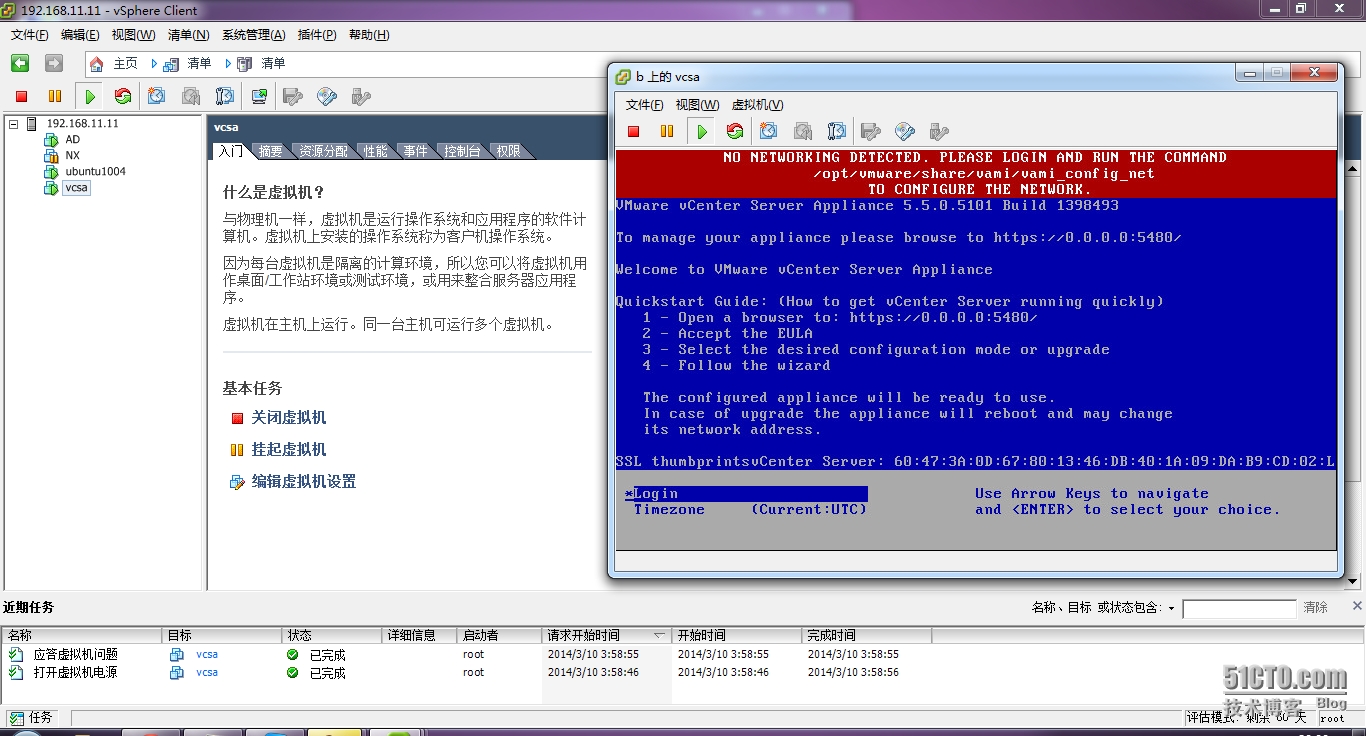

启动需要时间,报错,因为没有地址,没有dhcp。。。

手动这样只能暂时的,然后进入web模式改才能永久,当然要是cli好的话,直接进suse里面改文件配置,可惜我对里面的文件配置不了解。。。

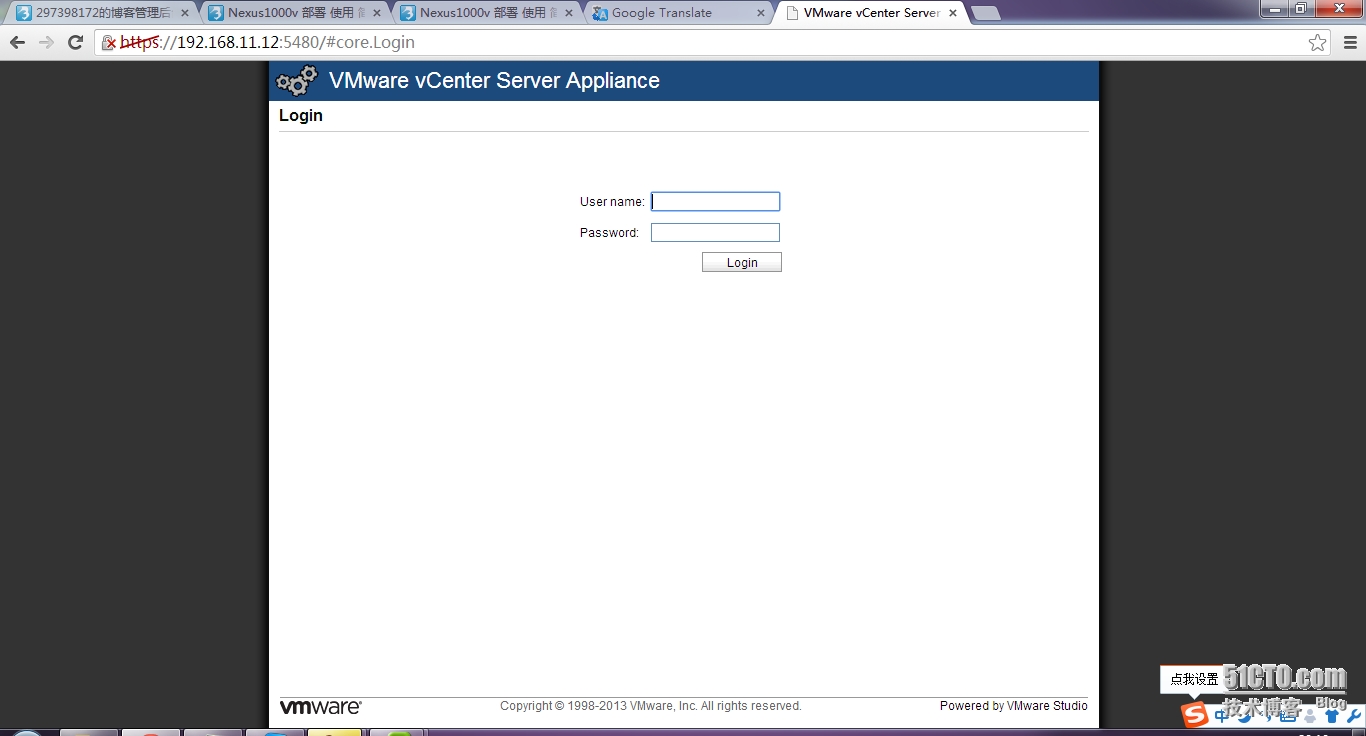

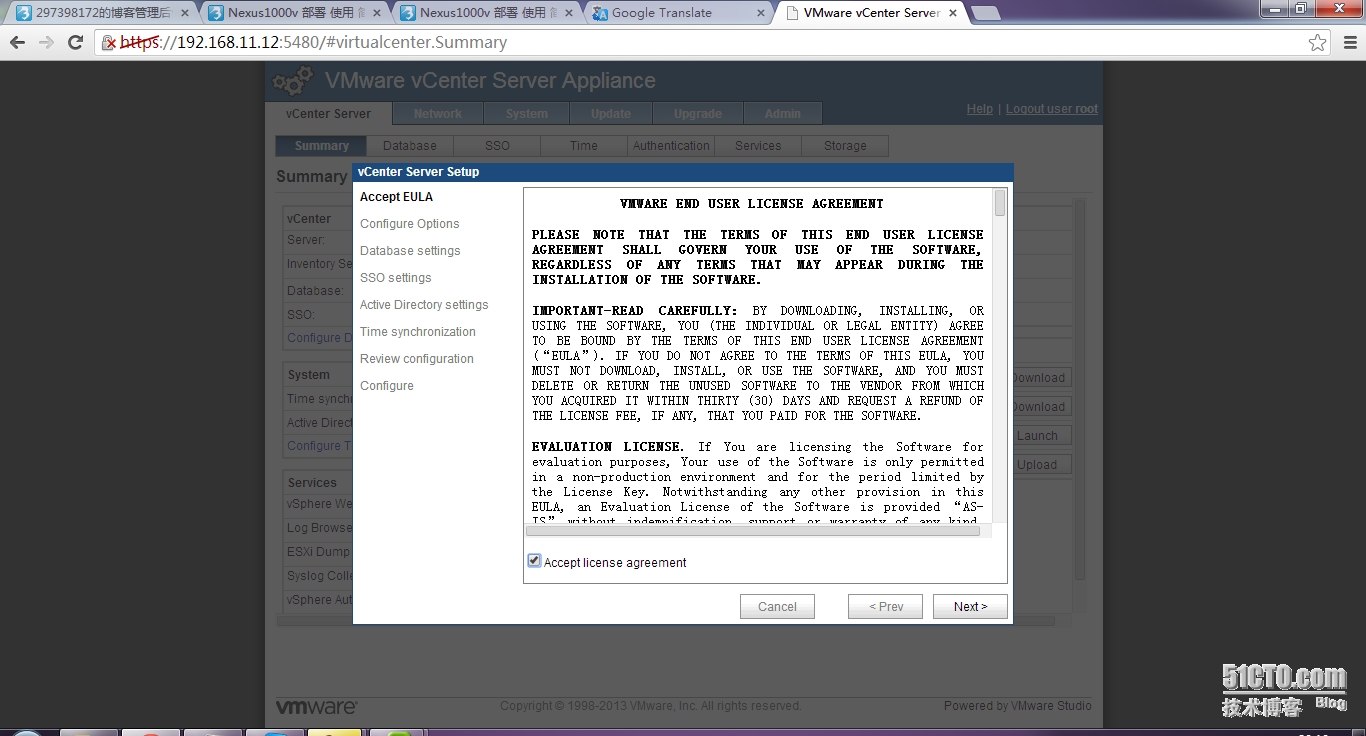

输入https://192.168.11.12:5480

接受

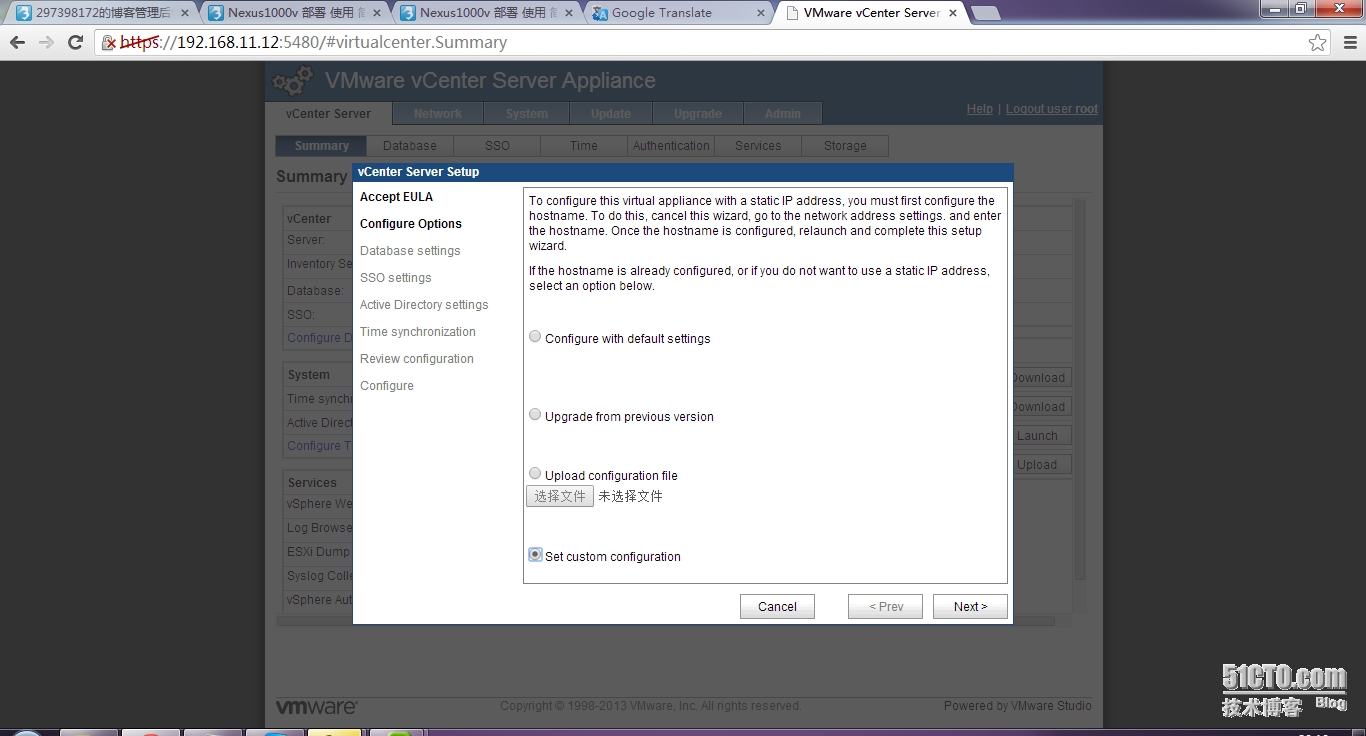

自定义

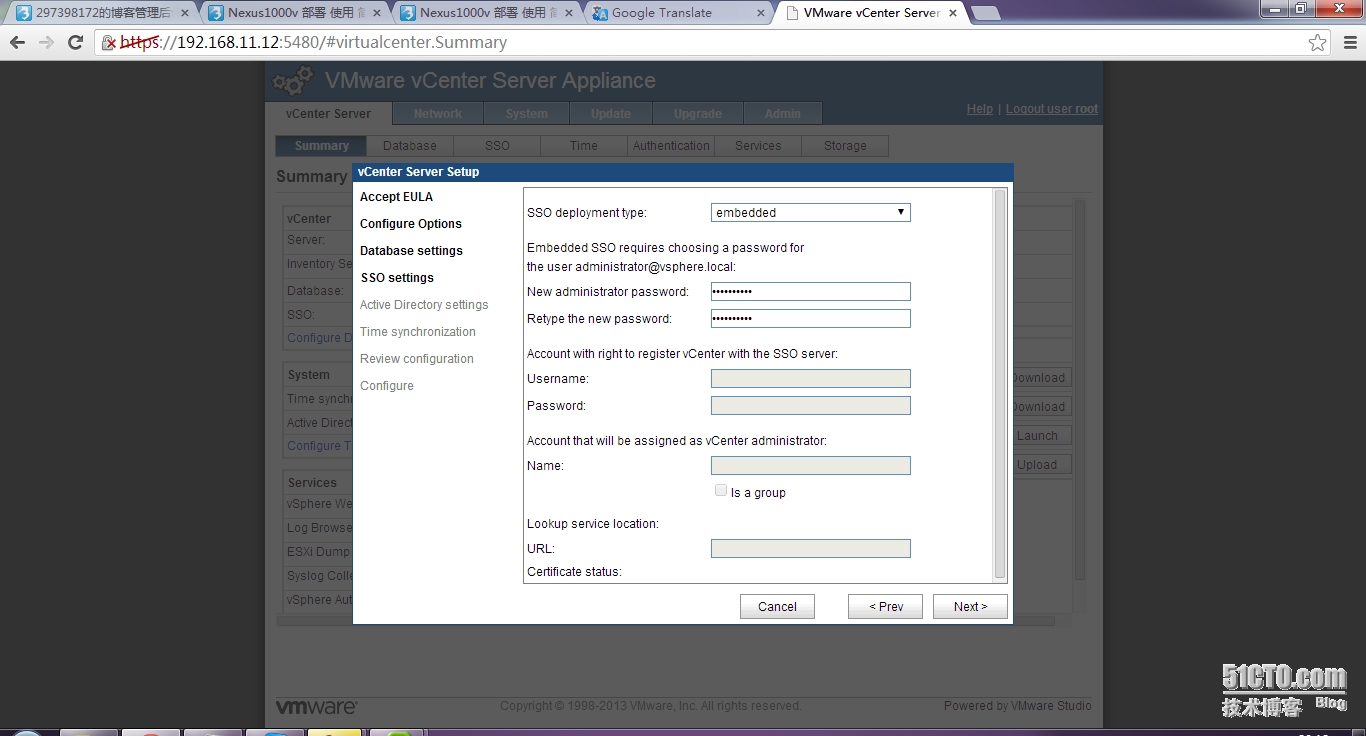

sso密码

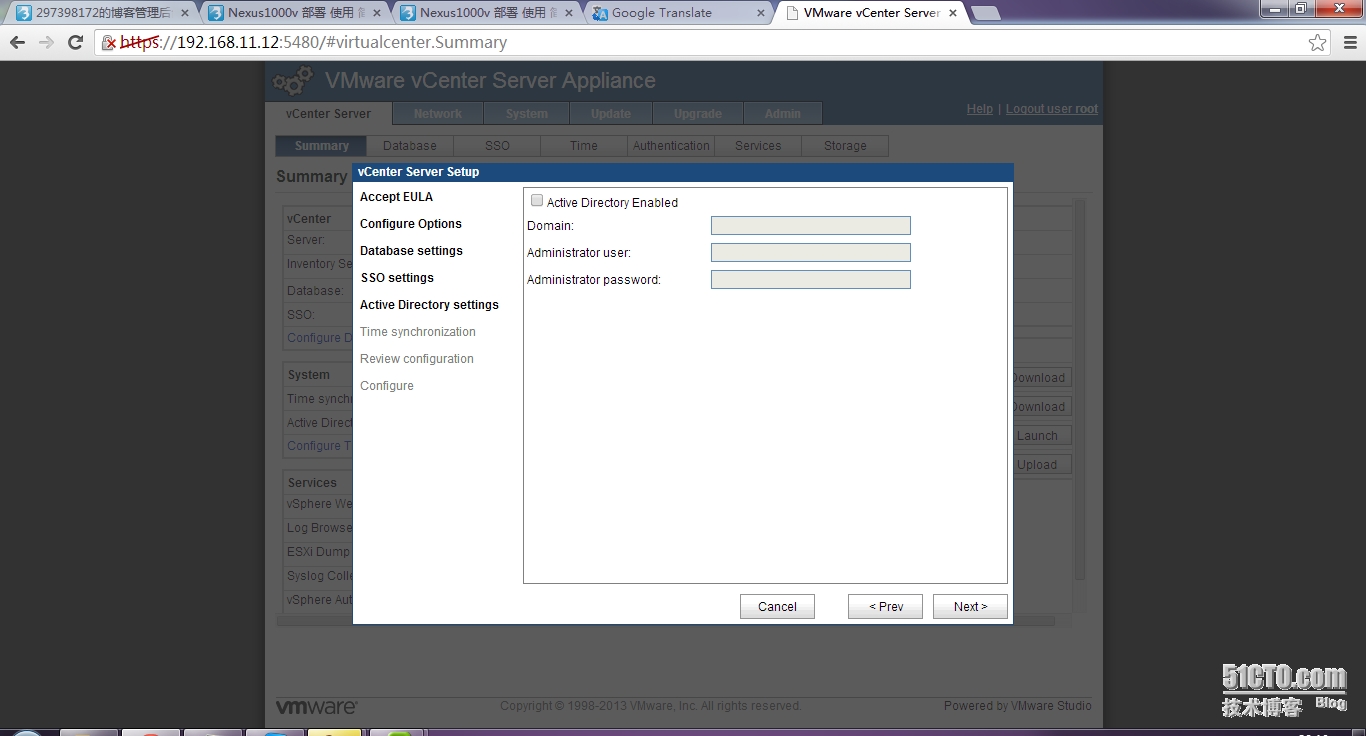

这里不要设置域控。。。以后设置方便些

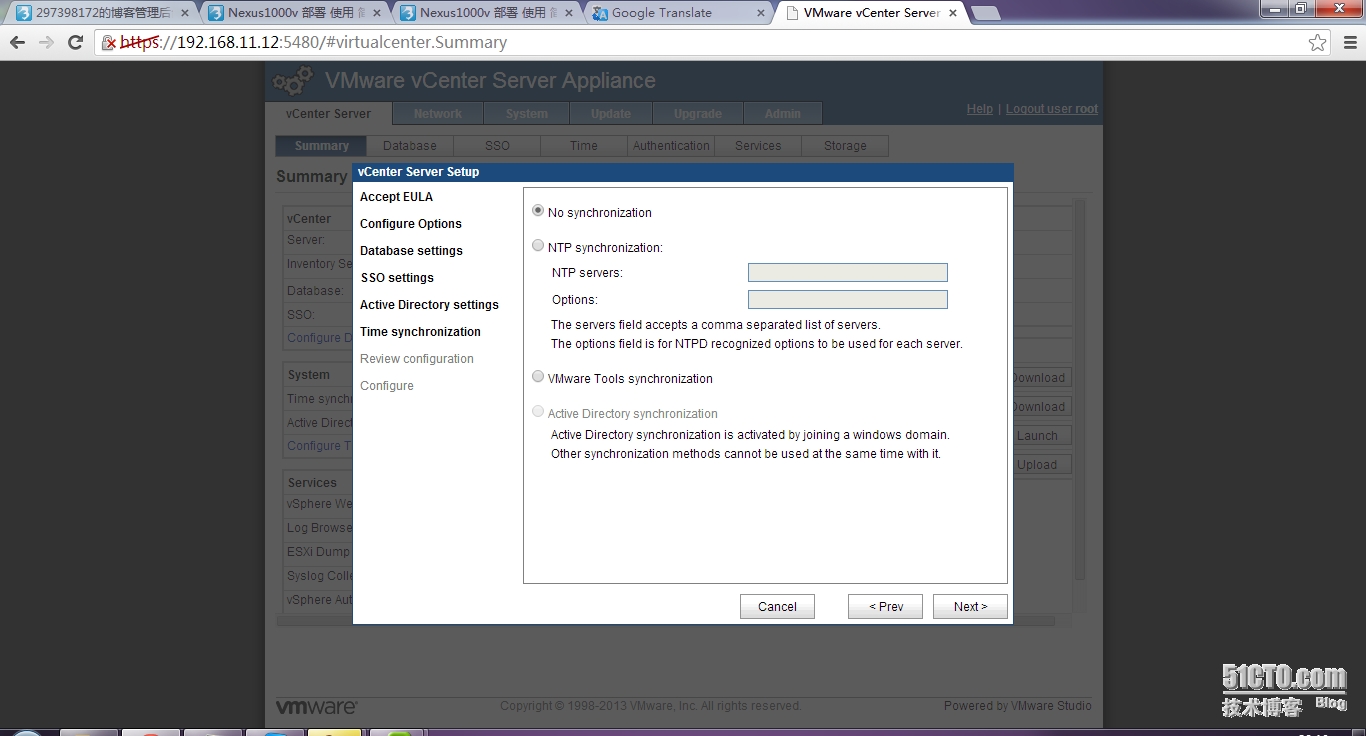

不要设置ntp,以后和域控设置

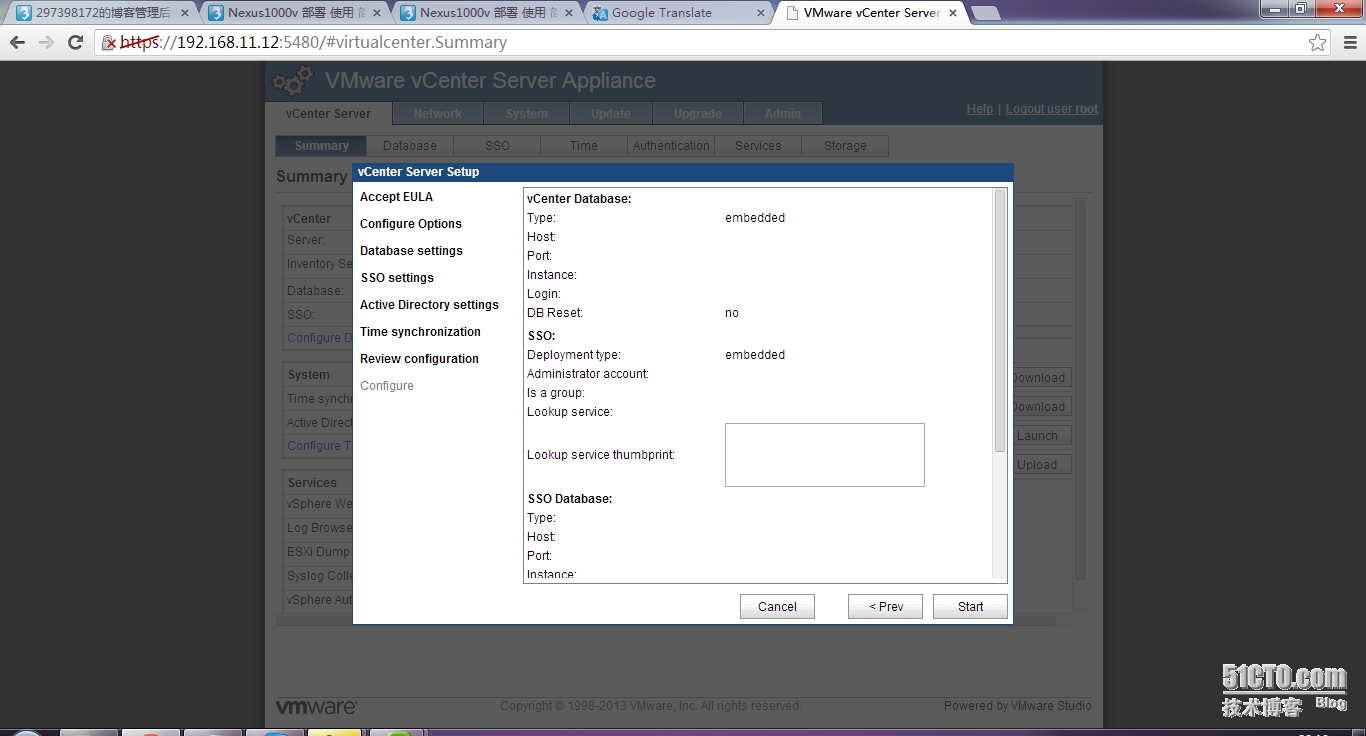

汇总

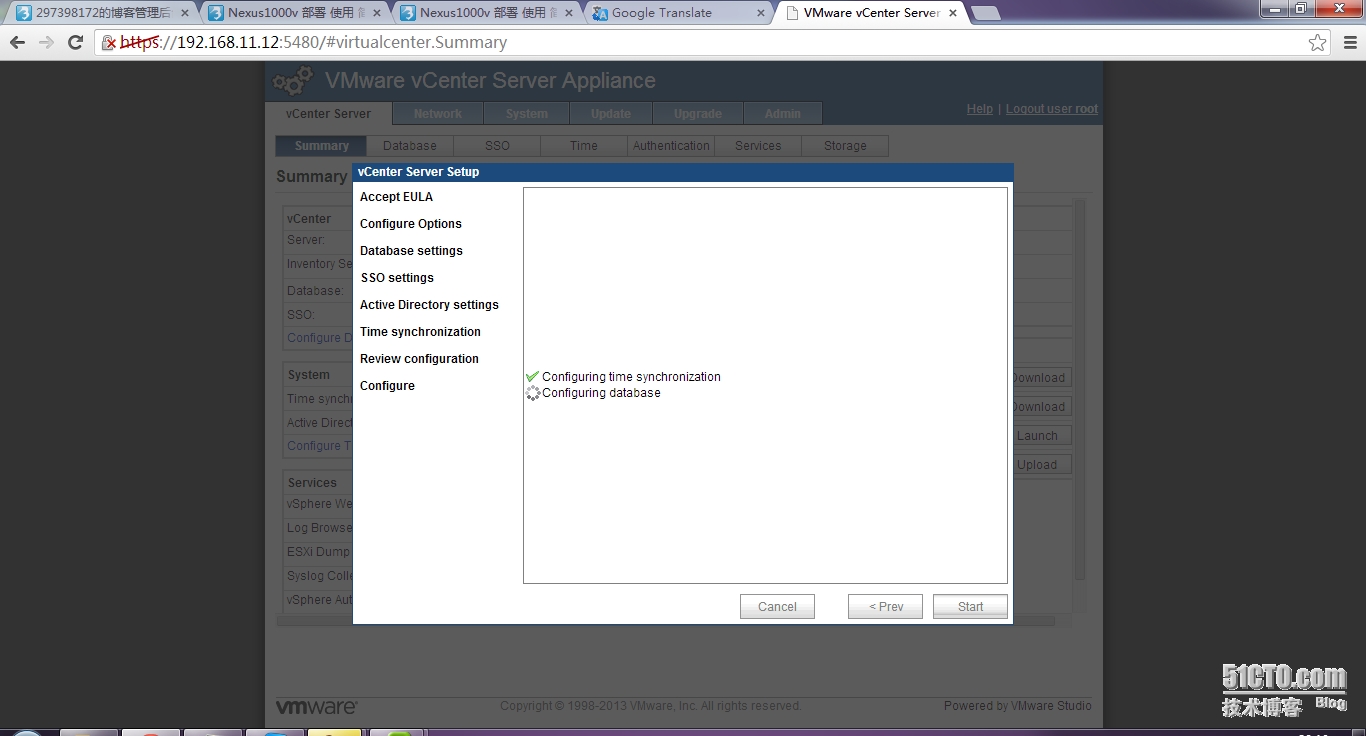

等待

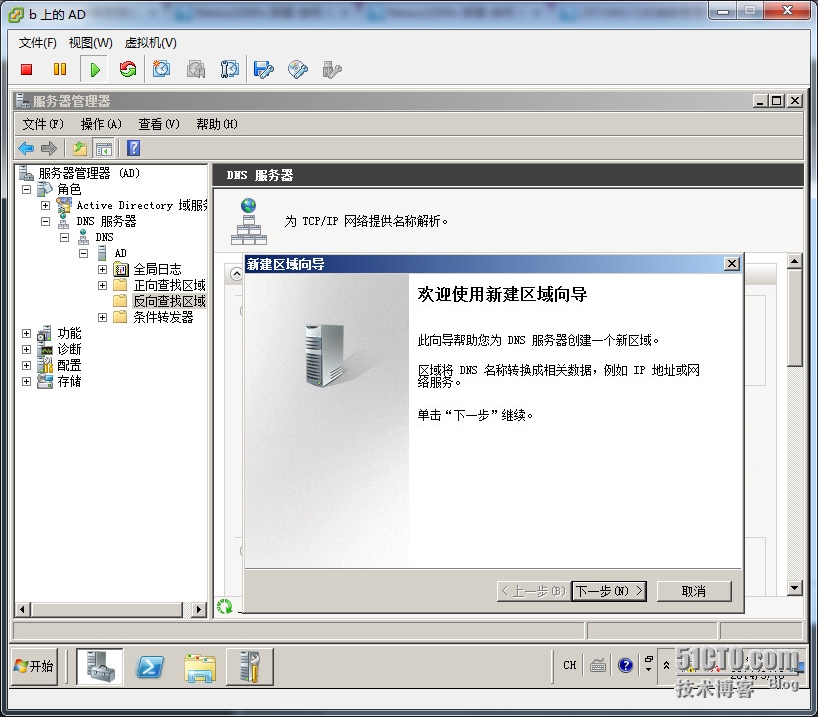

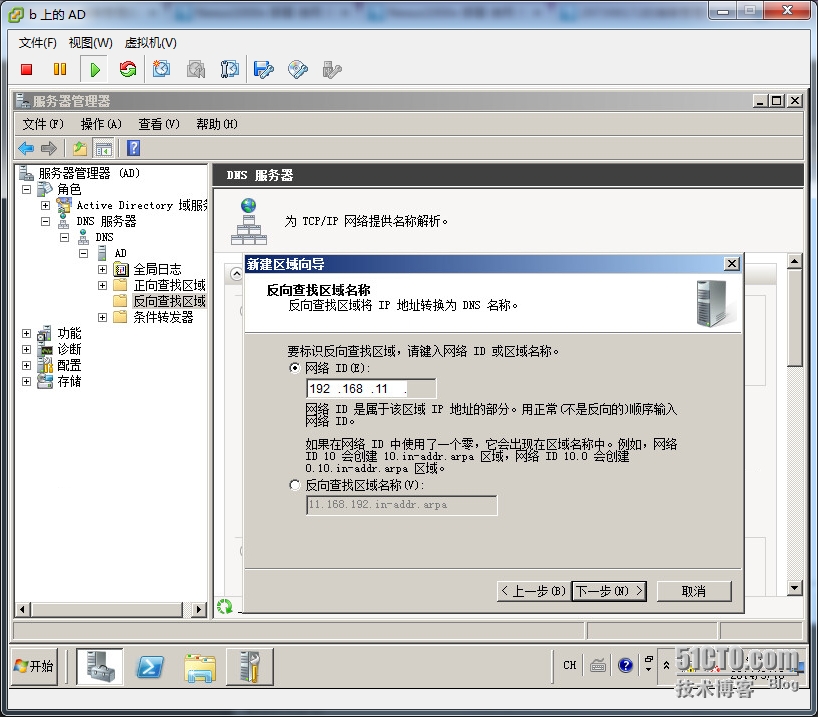

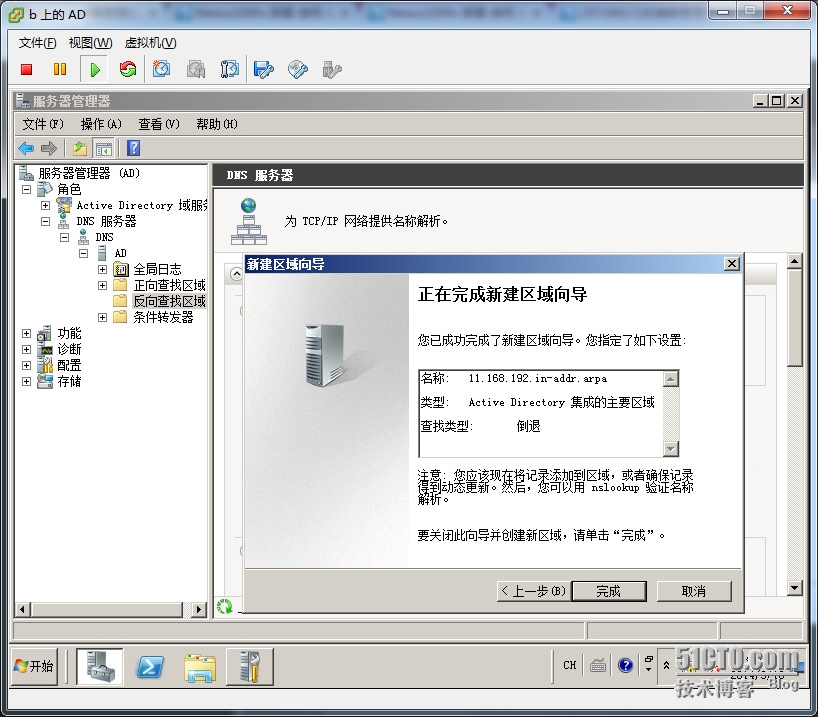

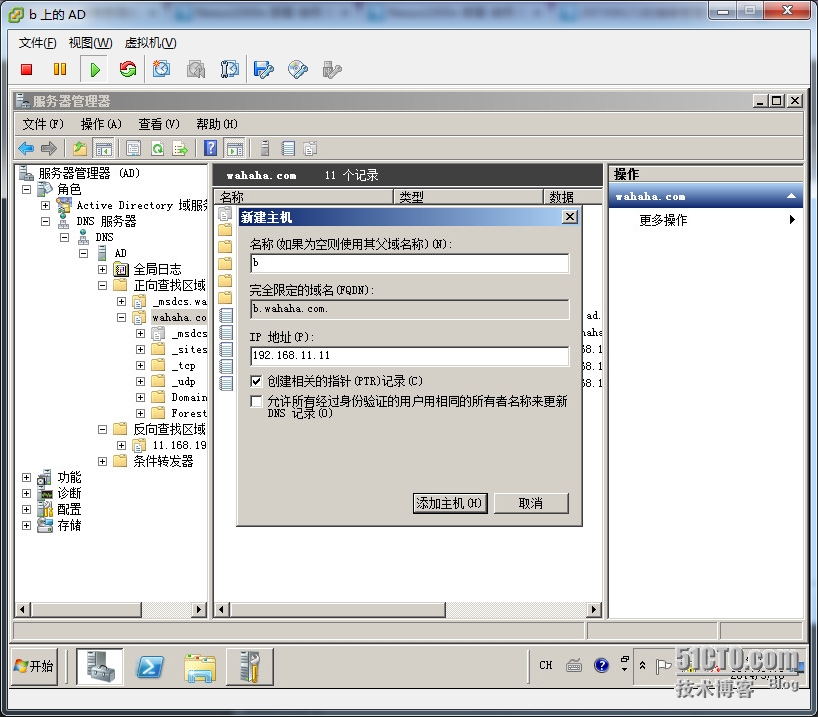

添加AD中记录。。。先加个反向记录

一直下一步。输入网段

完成

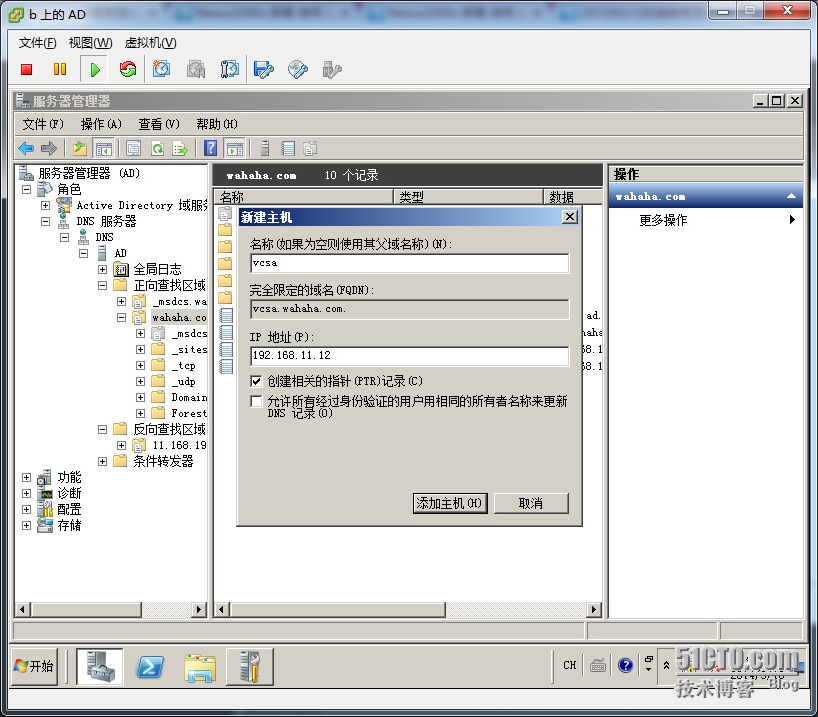

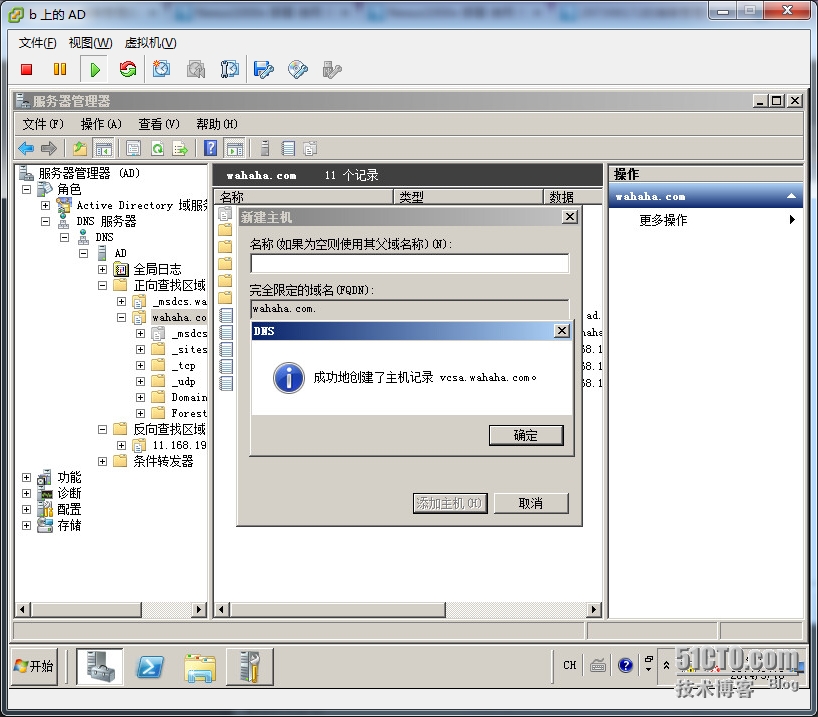

添加主机vcsa---192.168.11.12 勾选ptr,自动创建反向记录

ok

给esxi主机创建记录。。。b-192.168.11.11

ping域名都通,可以用域名访问了,上面有vspherre client端下载。。。

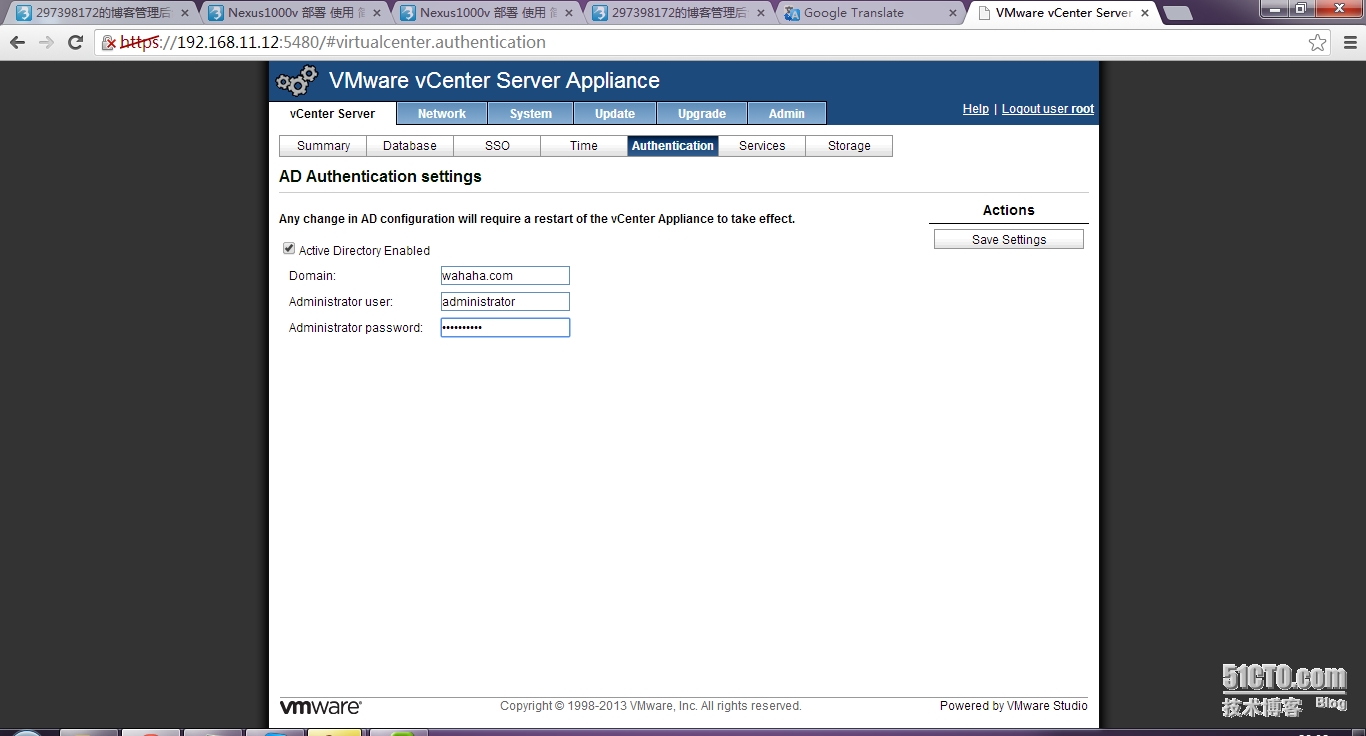

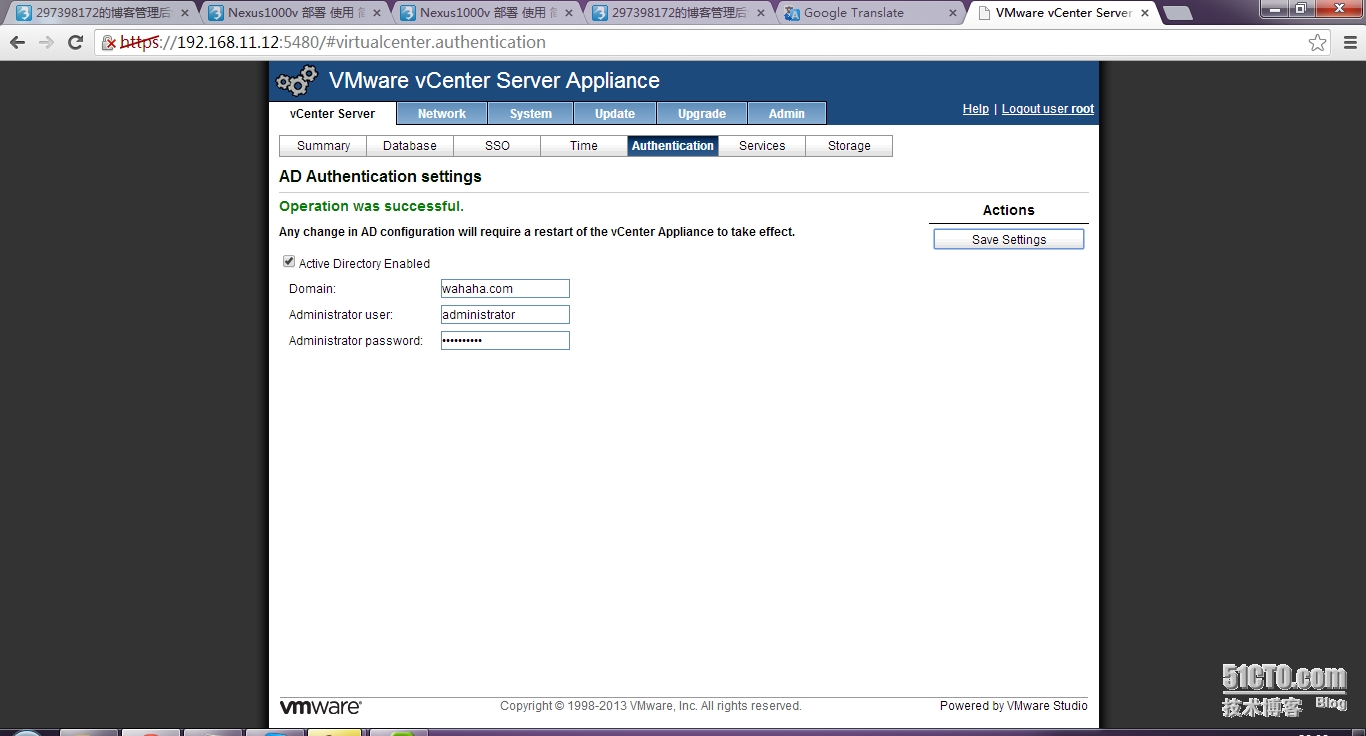

现在有了域控,可以配置vcsa的域设置和ntp了。。。(不知道为什么,生产环境中有域控,多数情况下我不跳过直接配置的时候,都报错。。。很无语)

先设置ip dns gw 以前的ifconfig不能直接写入,一重启就没了。。。

设置域控,完后就不用设置ntp了,域控好了,ntp自动变成从域读取数据,域控务器本身就是ntp服务器

save。。。成功

要重启,才能全部生效

准备了这么多,现在开始Nexus1000

由于我的这个环境是我事先吧AD vcsa 1000v ubuntu都装在esxi上,然后关机,然后做成ovf的,这样我以后部署会很省事。。。所以我就不演示怎么安装1000v了,其实非常简单,

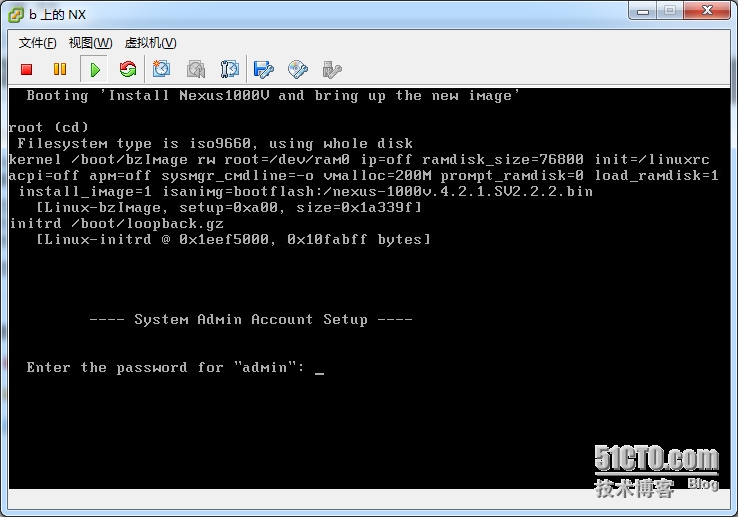

cisco官网现在他,里面有个vsm文件,里面有2个ova 你随便部署吧,可能都部署不上,应为不匹配,我是用iso直接装,秒秒钟就好,只要记住一定给他3个e1000的网卡,其他的他不认,内存要大于2G

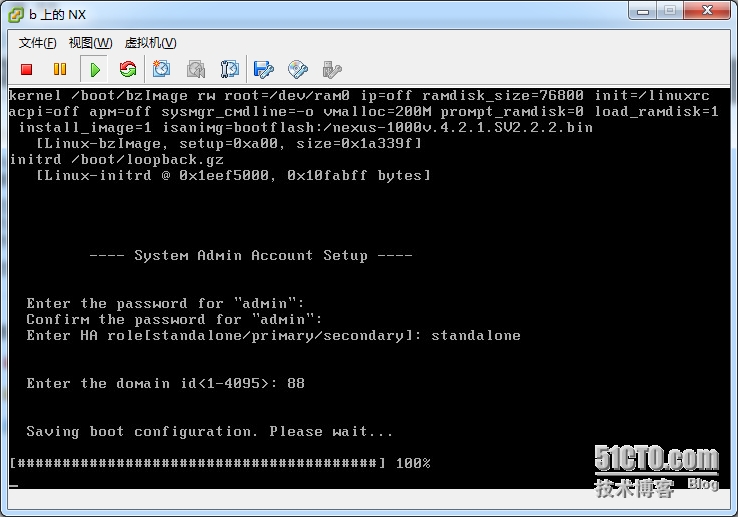

默认用户是admin,这是个root用户,输入自己的密码 并确认,

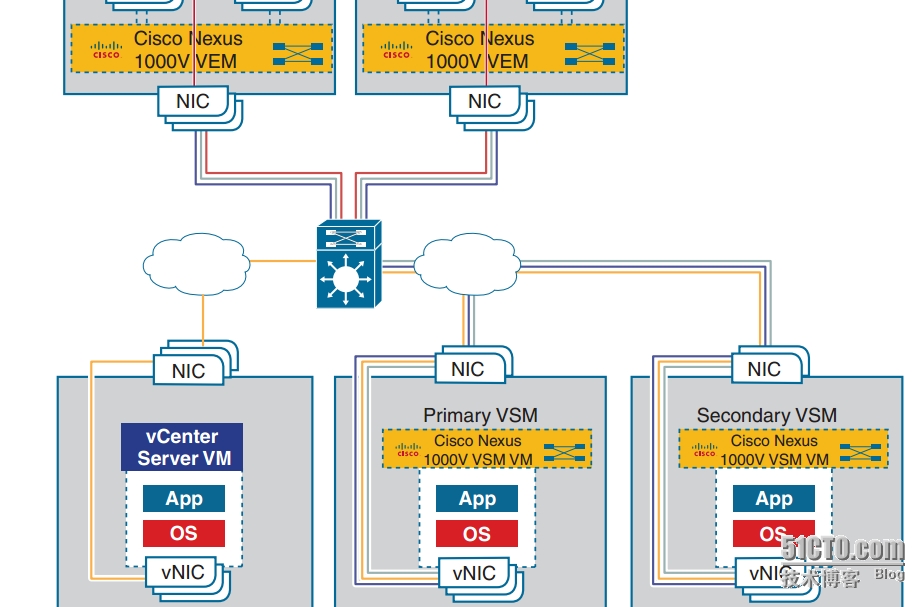

这里问我只单机模式 还是 双机热备(主机、备机),我当然是单机模式了

我的资源太少,不能掩饰双机热备,如果你要用双机热备,主机原理和下面一样,之前选择primary就可以了,备直接选择secondary,输个id就行,几乎不用配置。。。

输入domain id 随便吧,但如果是双机热备必须要一样,否则无法组成

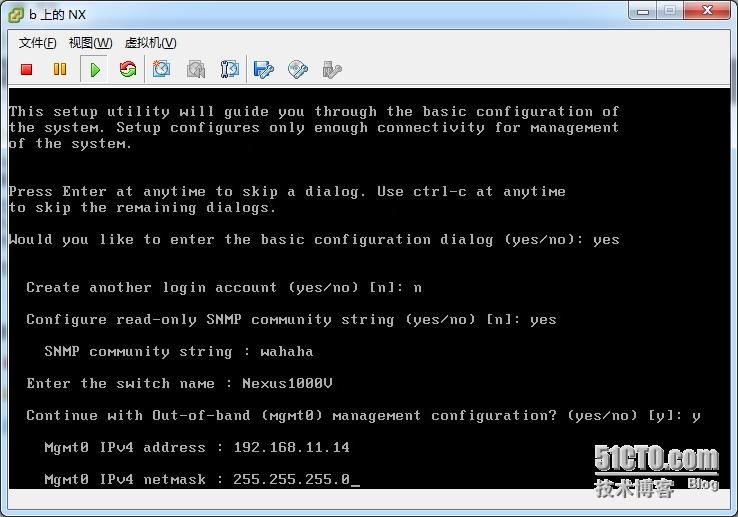

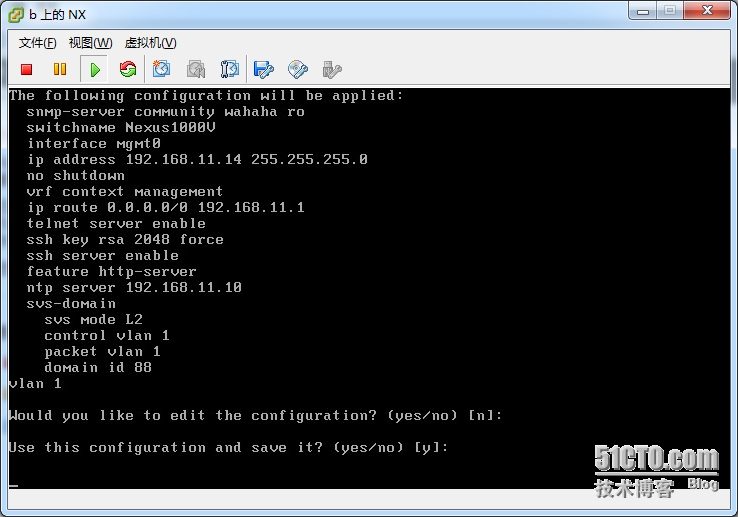

以下为:进行基础配置(NX-os有点不一样,命令行不太会使,所以偷个懒,不过以后排除故障还是得学会NX-os。。。)――――――不设置其他账户――――――设置snmp(为了zabbix能监控到每一个虚机的数据,消除盲点,我需要snmp。。。)

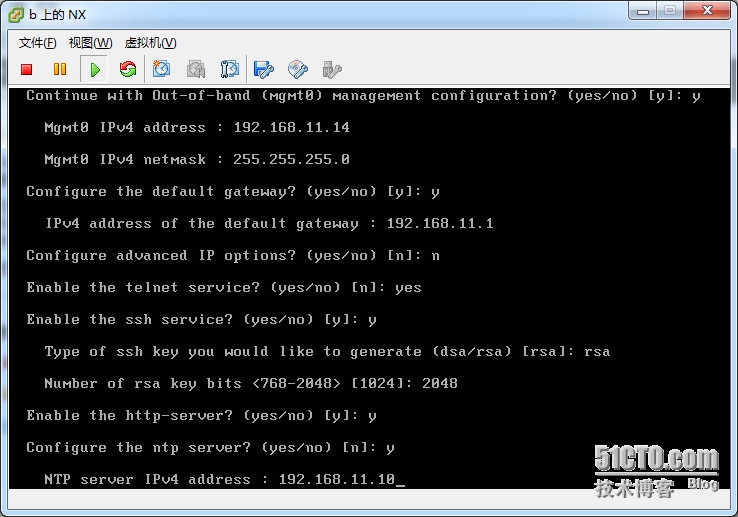

设置mgmt ip ――――――设置gw――――开启telnet(这样不安全)――――设置ssh 秘钥rsa 2048位――――设置ntp(这个可以不设置,我设置的我的域控同步)

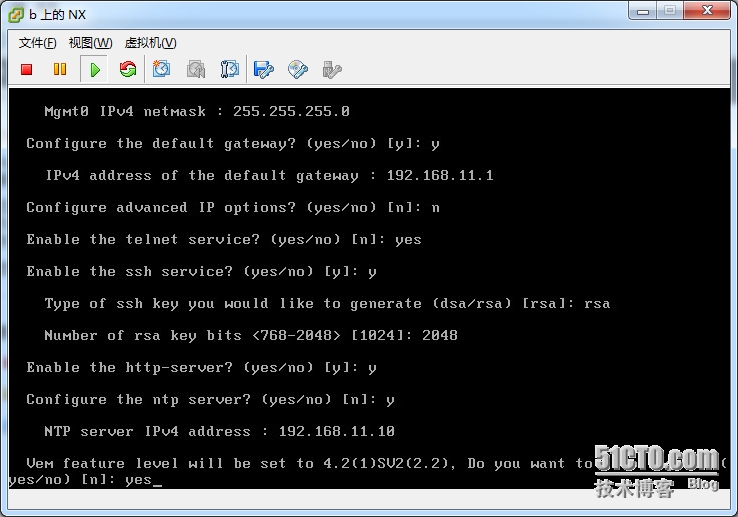

看最后一行vem 功能,这一项折腾了我一个礼拜,这是重点。。。

vem是安装在esxi上的,相当于交换机的板卡,vsm就是我们正在设置的这个,是交换机的引擎,所有的数据都要从板卡到引擎。。。(走的是esxi的基础网络,标准交换机(我这个是的),也可能是其他,看你怎么配置了)

vem feature 是vem的功能 有两个选项L2 L3 ,对于我等�潘康那�别就是,L2能立刻通,L3会出现uplink口通,端口组则会port blocked by admin,

原因是原理不一样:他们的区别貌似是L3封装格式为udp等,

而且貌似L3要让端口组能通要建一个vkenel使他和mgmt怎么弄一下,才可以,否则不通,累死你,我现在还没弄明白,

所以先选L2吧, L3再强我的先弄弄。。。再说

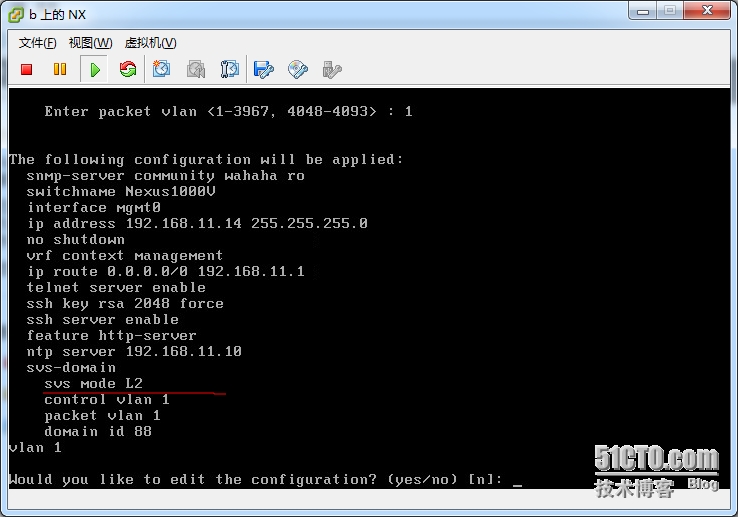

还记得我上面说的,实验环境和生产环境吗? 在我这个实验环境 一切都是vlan1 packet control mgmt uplink 端口组。。。注意我的划红线,进去后 show running 可以看到

相信到这里 dvs svs 等等一系列已经让我糊涂了。。。呵呵,以后会注明的

不在配置――――全部保存

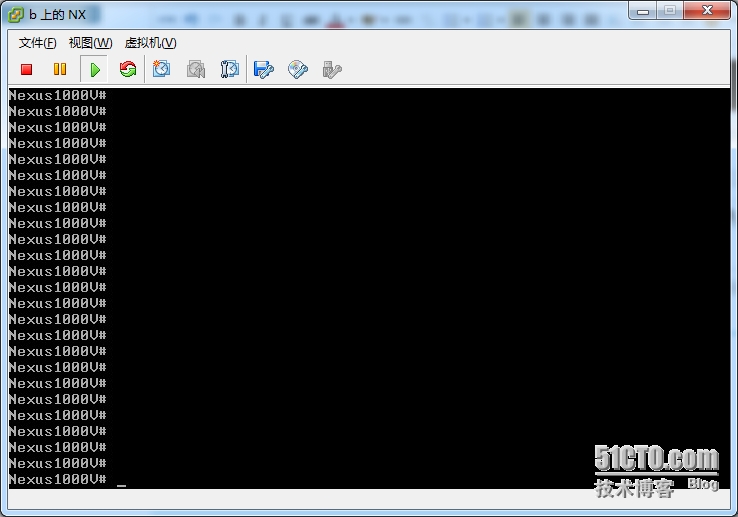

一切ok,我可以用crt登陆他了

现在vsm刚建立,先不配置,建立完vem在在配置

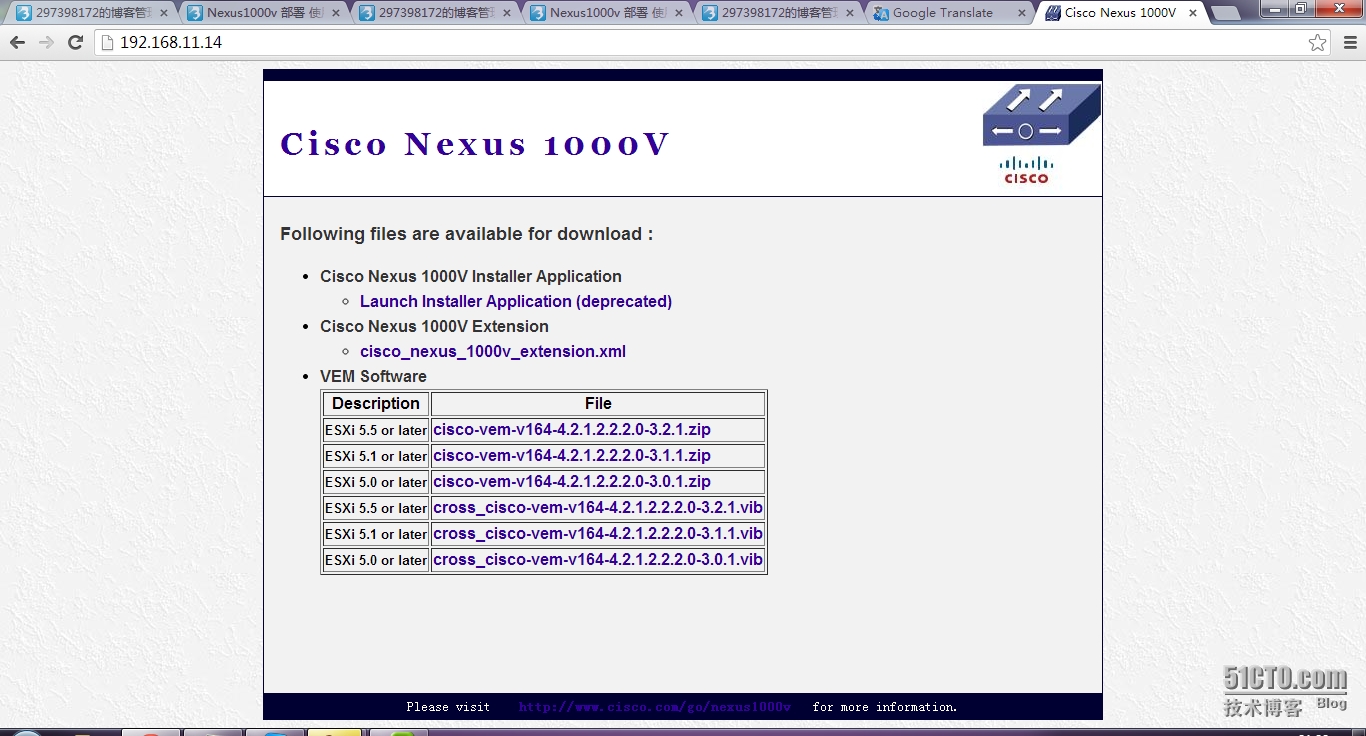

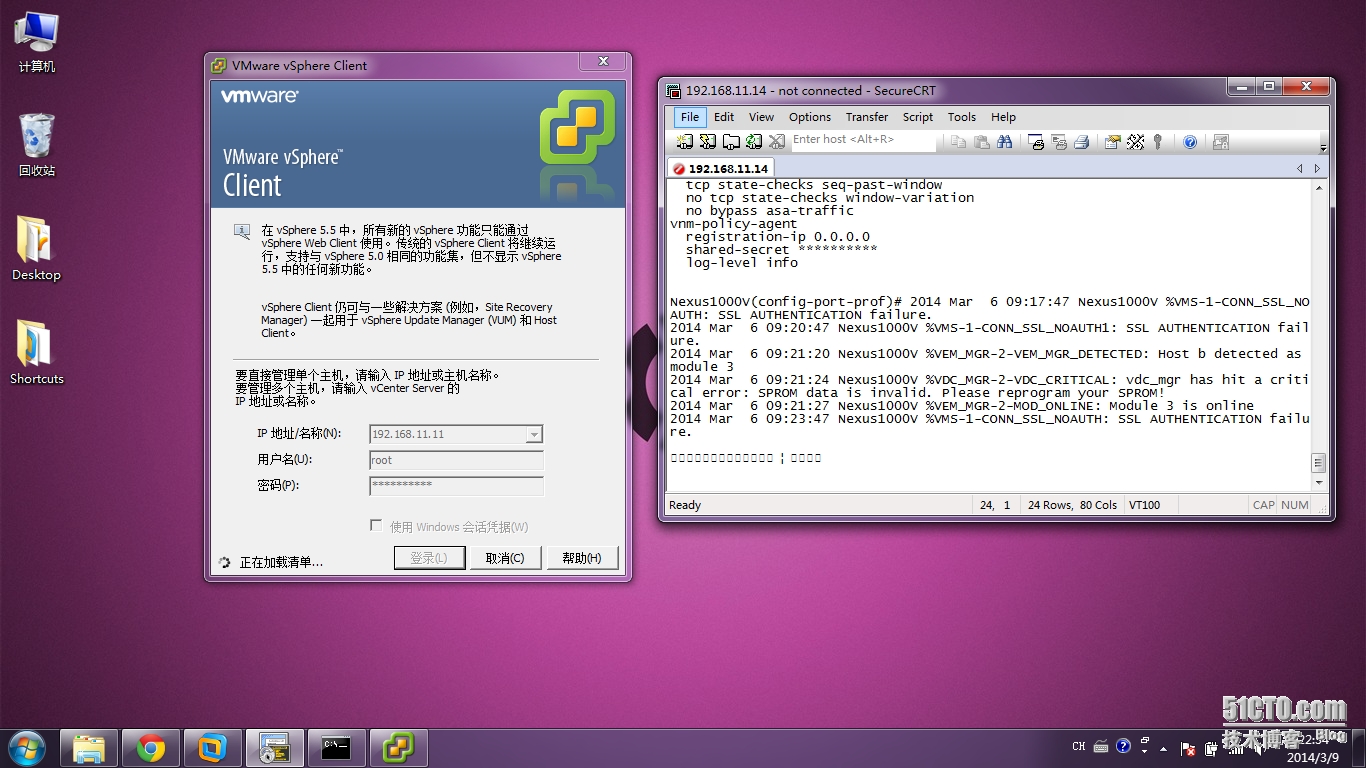

注册插件 192.168.11.14

cisco_nexus_1000v_extension.xml 另存为 到桌面

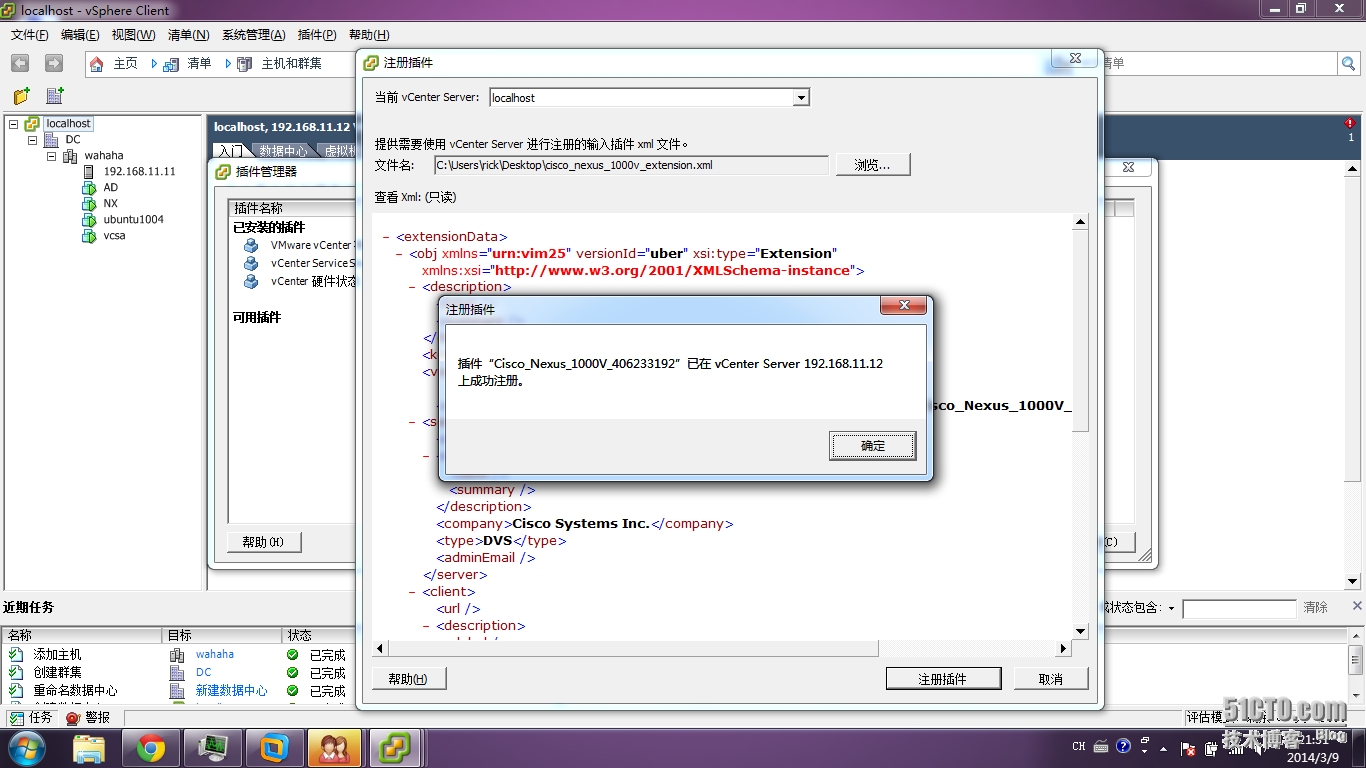

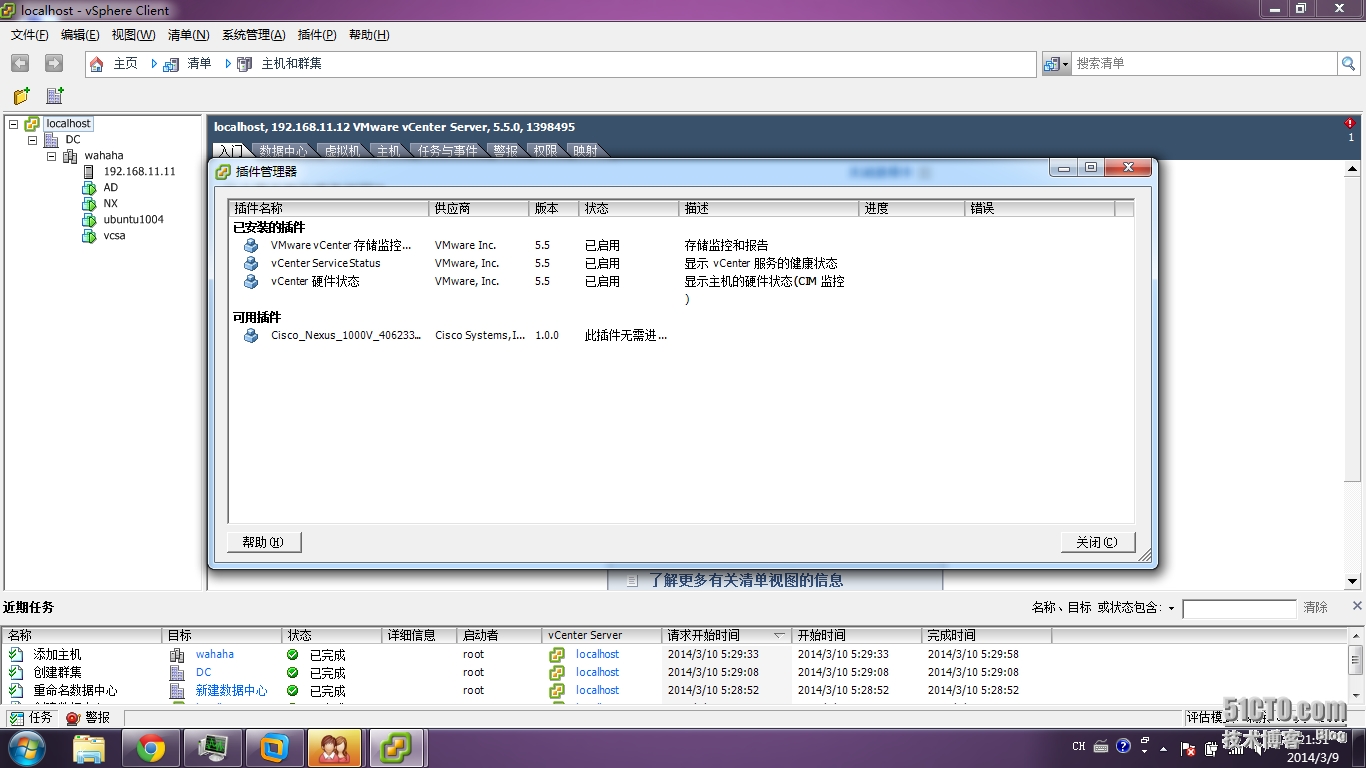

安装插件,登陆vcsa 192.168.11.12

插件――――管理插件――――右键 新建――――选择桌面cisco_nexus_1000v_extension.xml

注册――――忽略――――成功

然后在esxi上安装vem

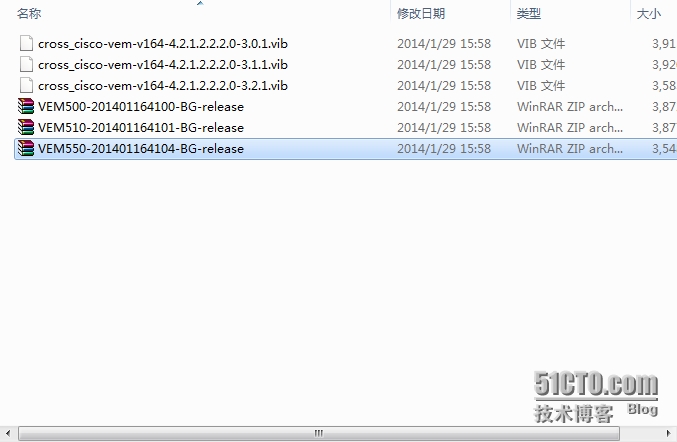

上面192.168.11.14的这个cisco-vem-v164-4.2.1.2.2.2.0-3.2.1.zip也许能用,没试过,我用的是下面的cisco官网下载的里面有个vem包,注意选对版本啊。5.5

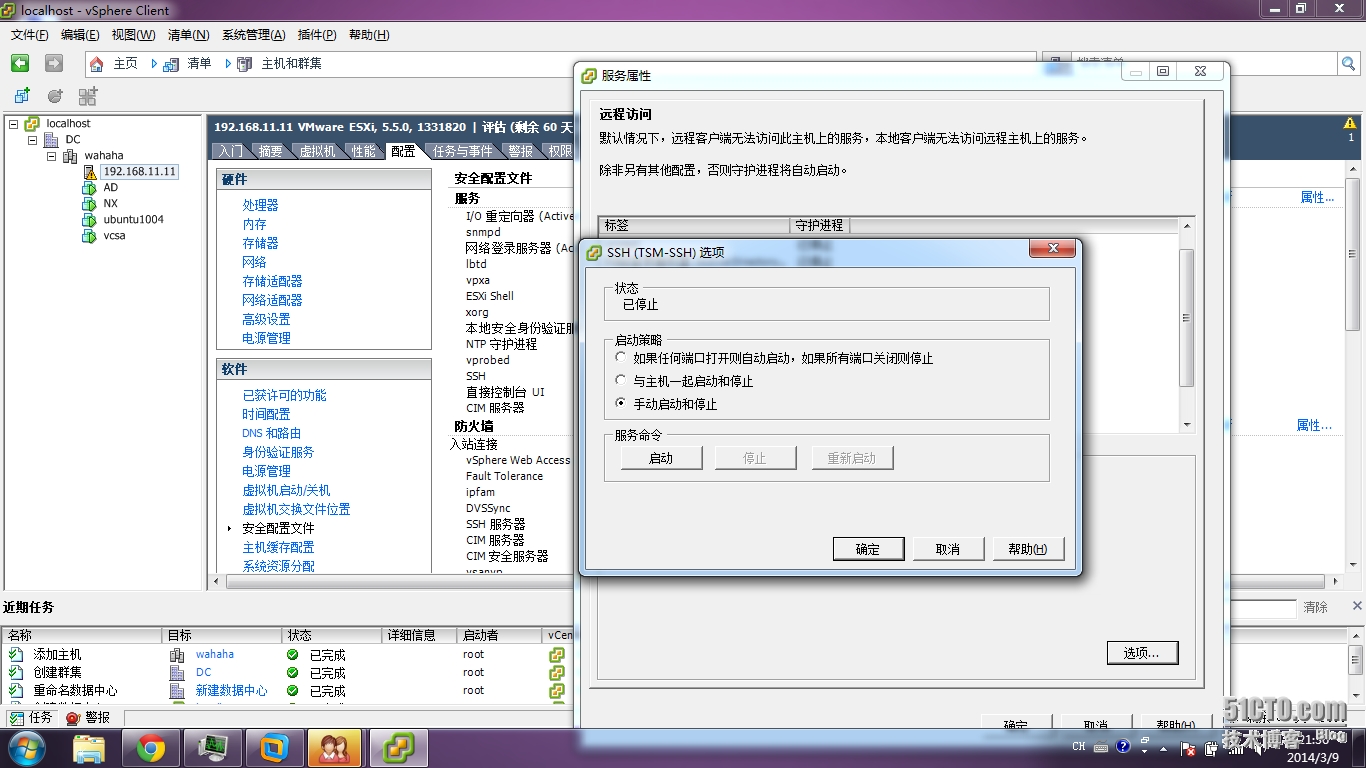

开启esxi的ssh功能

选定主机――――配置――――安全配置文件――――服务――――属性――――ssh――――选项――――启动

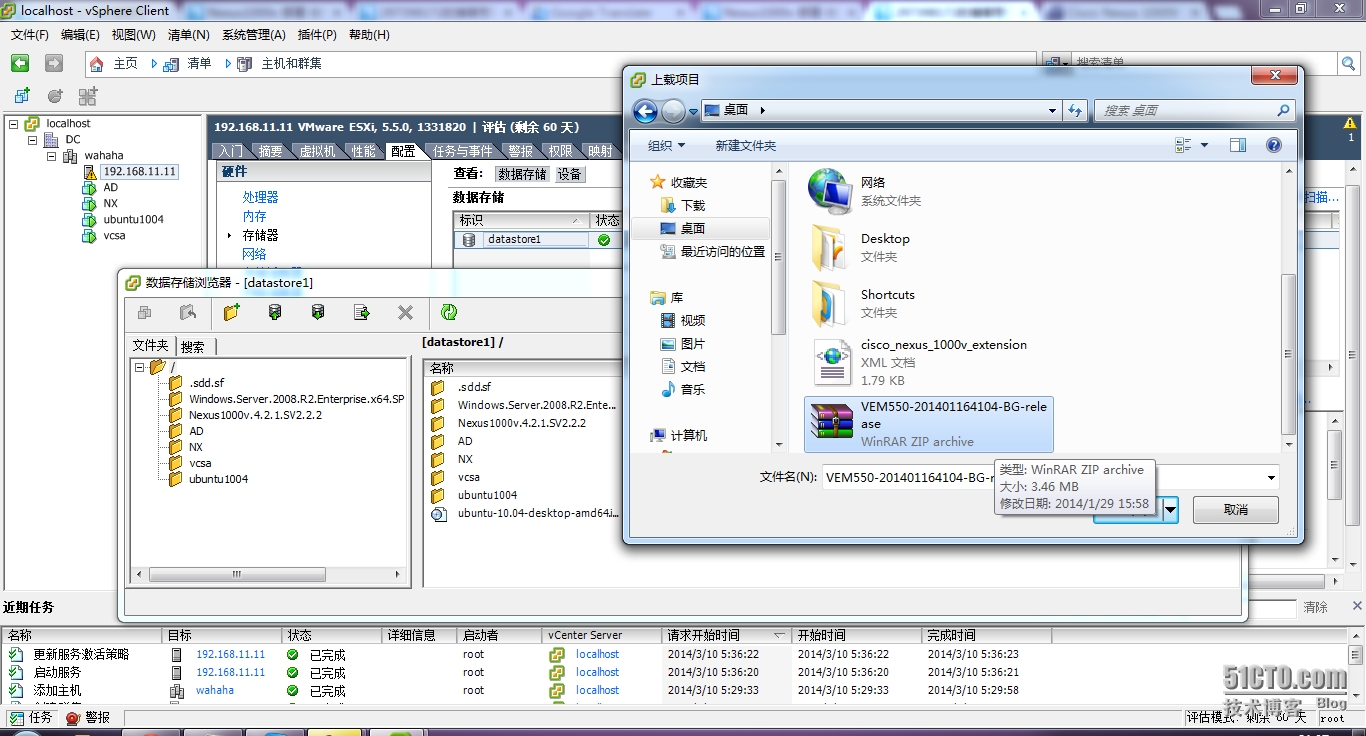

上传到esxi的存储上

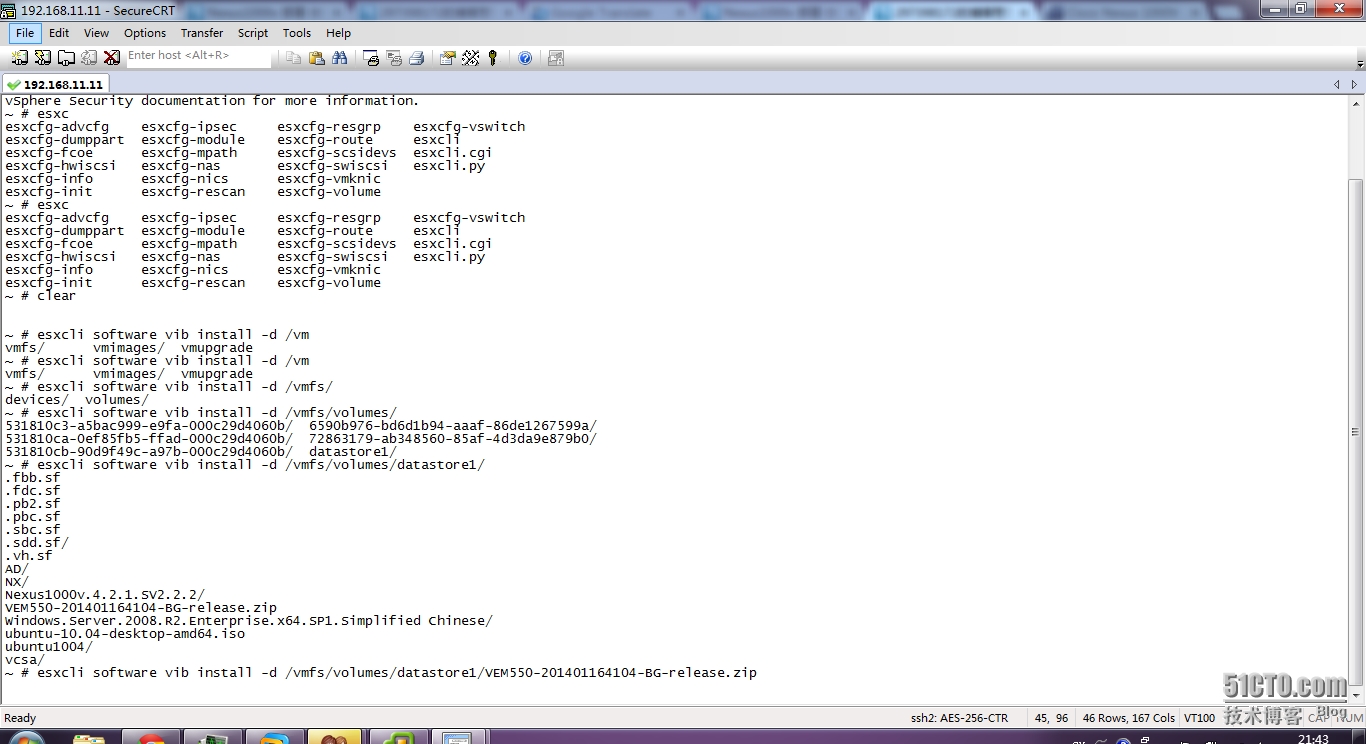

crt登陆到esxi

上传的安装文件在 /vmfs/volumes/datastore1/VEM550-201401164104-BG-release.zip 你可以ls 找到一定用/xxx/xxx/xxx绝对路径,

直接装vem

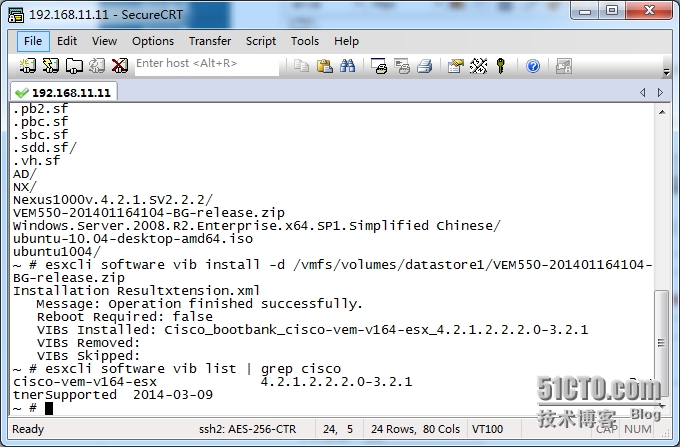

esxcli software vib install -d /vmfs/volumes/datastore1/VEM550-201401164104-BG-release.zip

esxcli software vib list | grep cisco 检查安装上没

最后一步,开始在vsm上配置 见上一篇常用配置命令。。。

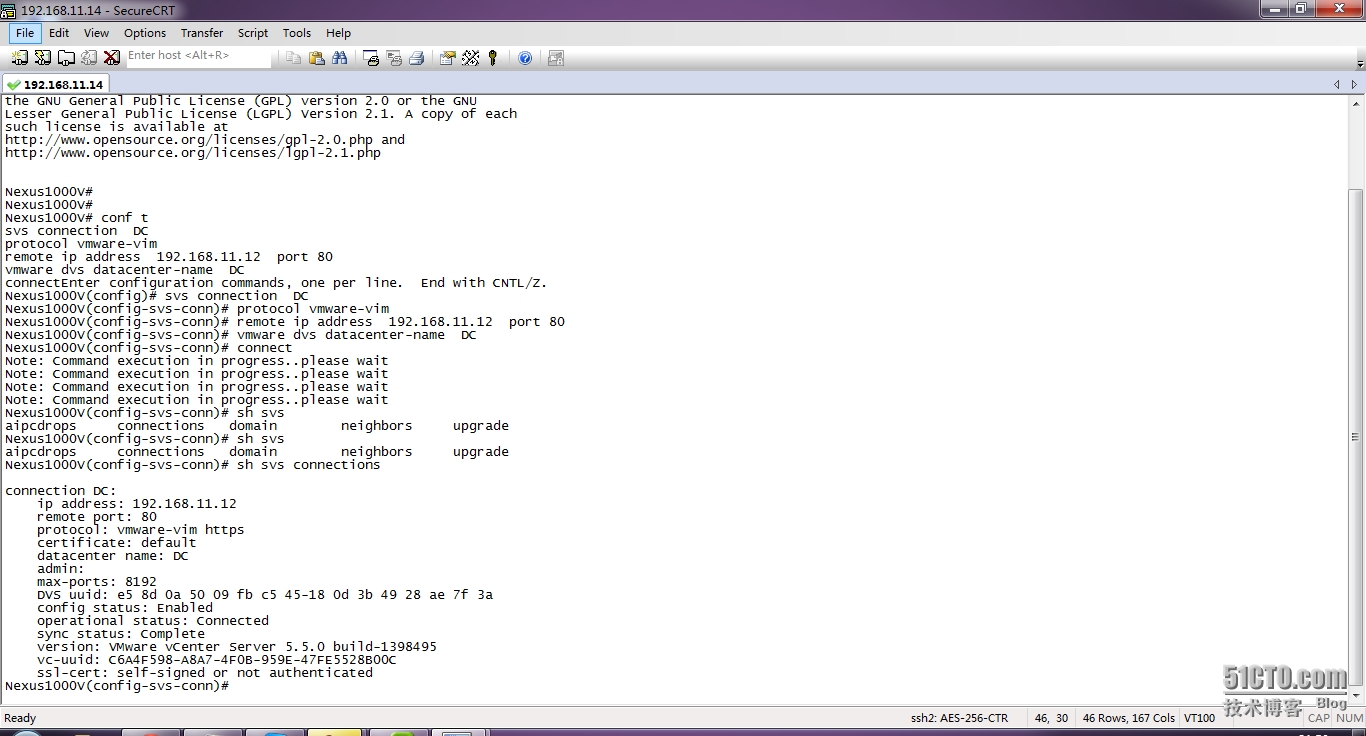

vmware dvs datacenter-name DC这个名字一定得是自己数据中心的名字,我的就是DC

conf t

svs connection DC

protocol vmware-vim

remote ip address 192.168.11.12 port 80

vmware dvs datacenter-name DC

connect

show svs connections 看svs状态,connect complete 才行

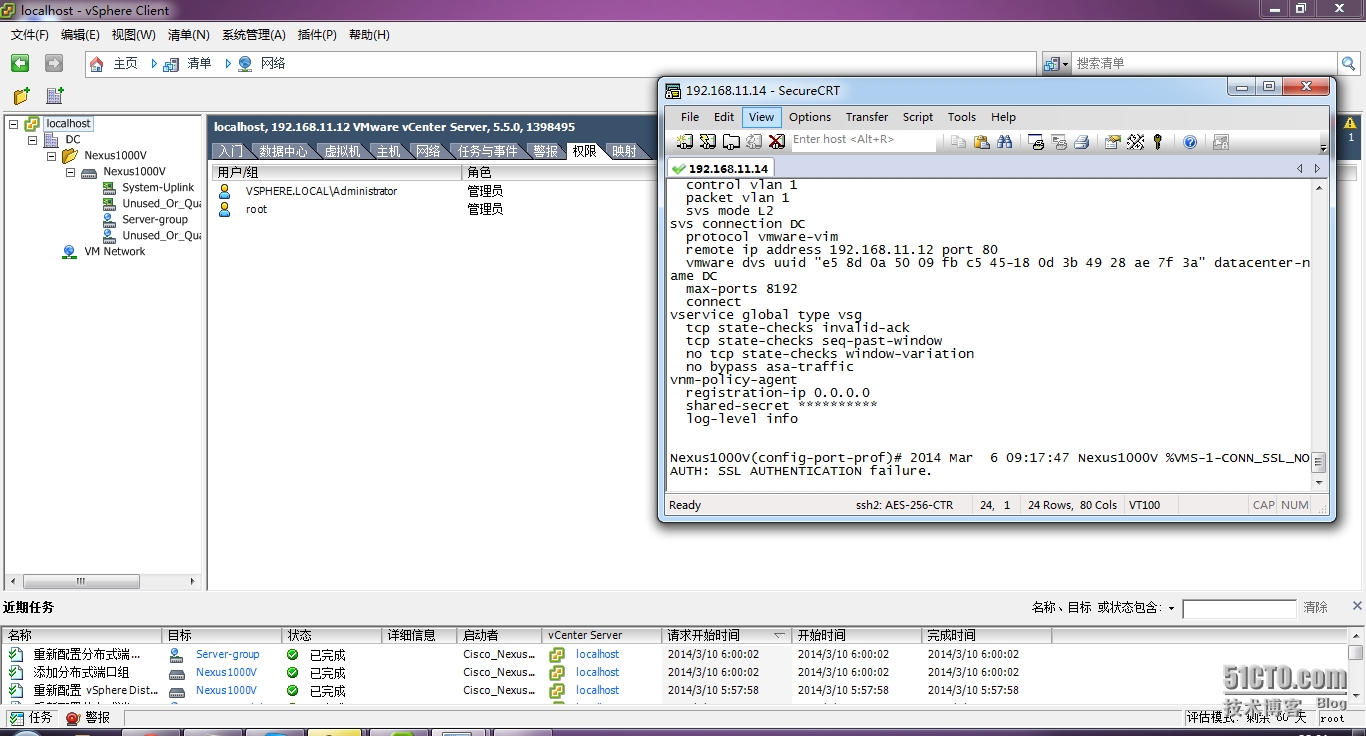

创建uplink

port-profile type ethernet System-Uplink

vmware port-group

switchport mode trunk

switchport trunk allowed vlan all

no shutdown

system vlan 1

state enabled

如果不no shut 就输入system vlan 1 是不可以的。。。

创建端口组

port-profile type vethernet Server-group

vmware port-group

switchport mode access

switchport access vlan 1

no shutdown

state enabled

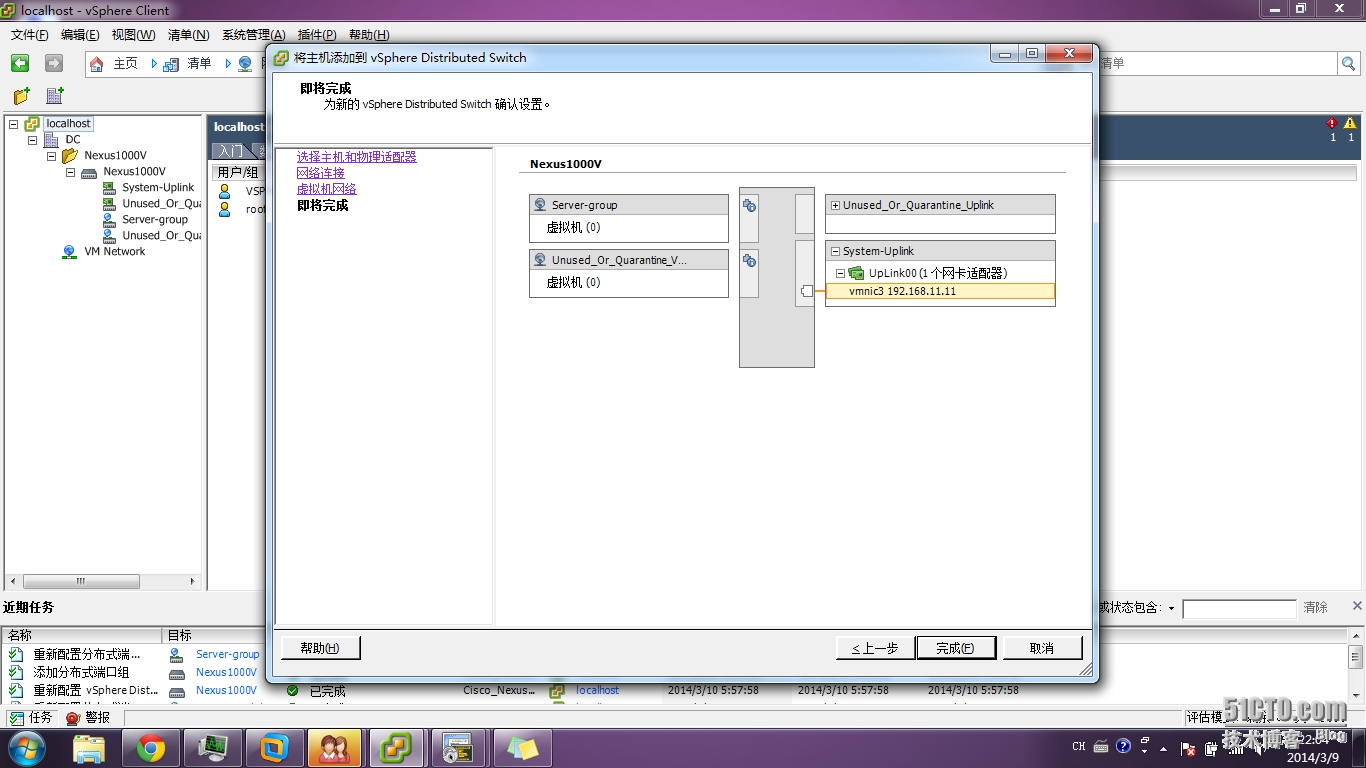

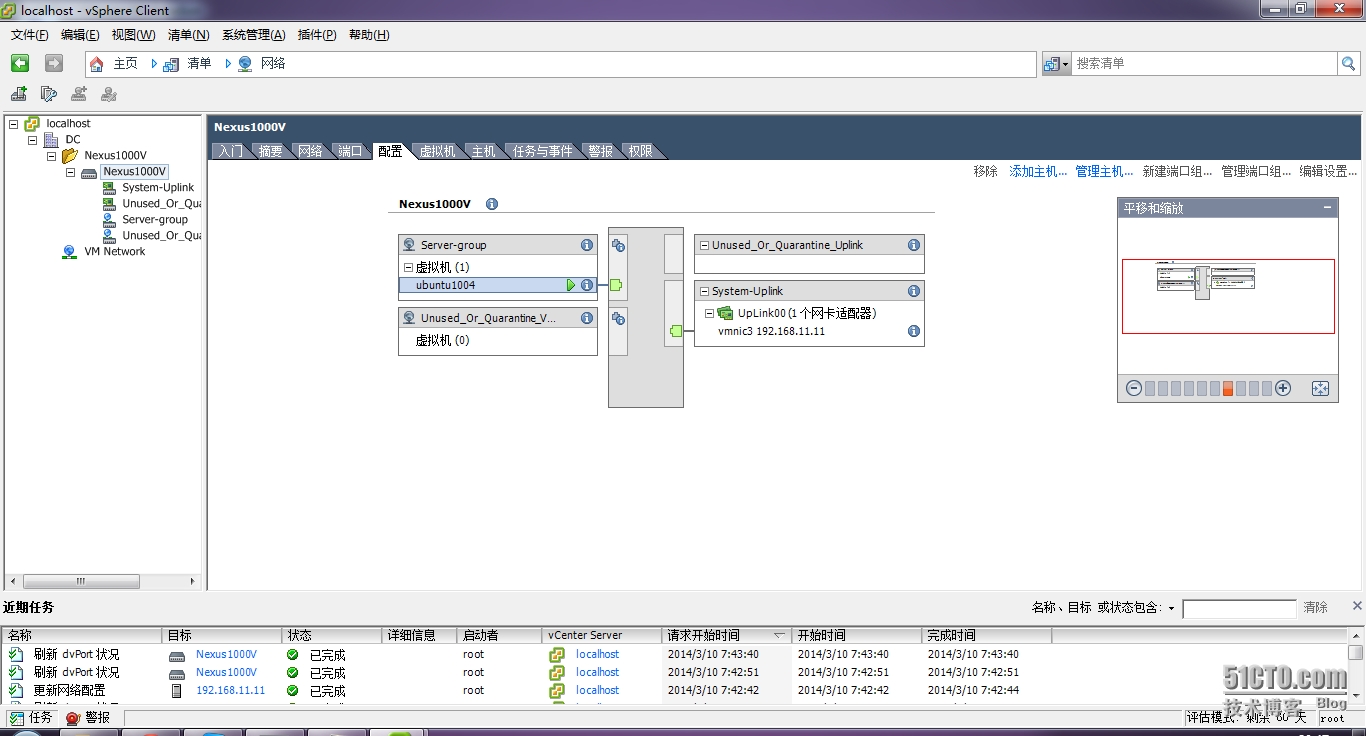

你看见了,创建一个就会多在vcsa的network中有显示,network中unused是默认的建立的两个

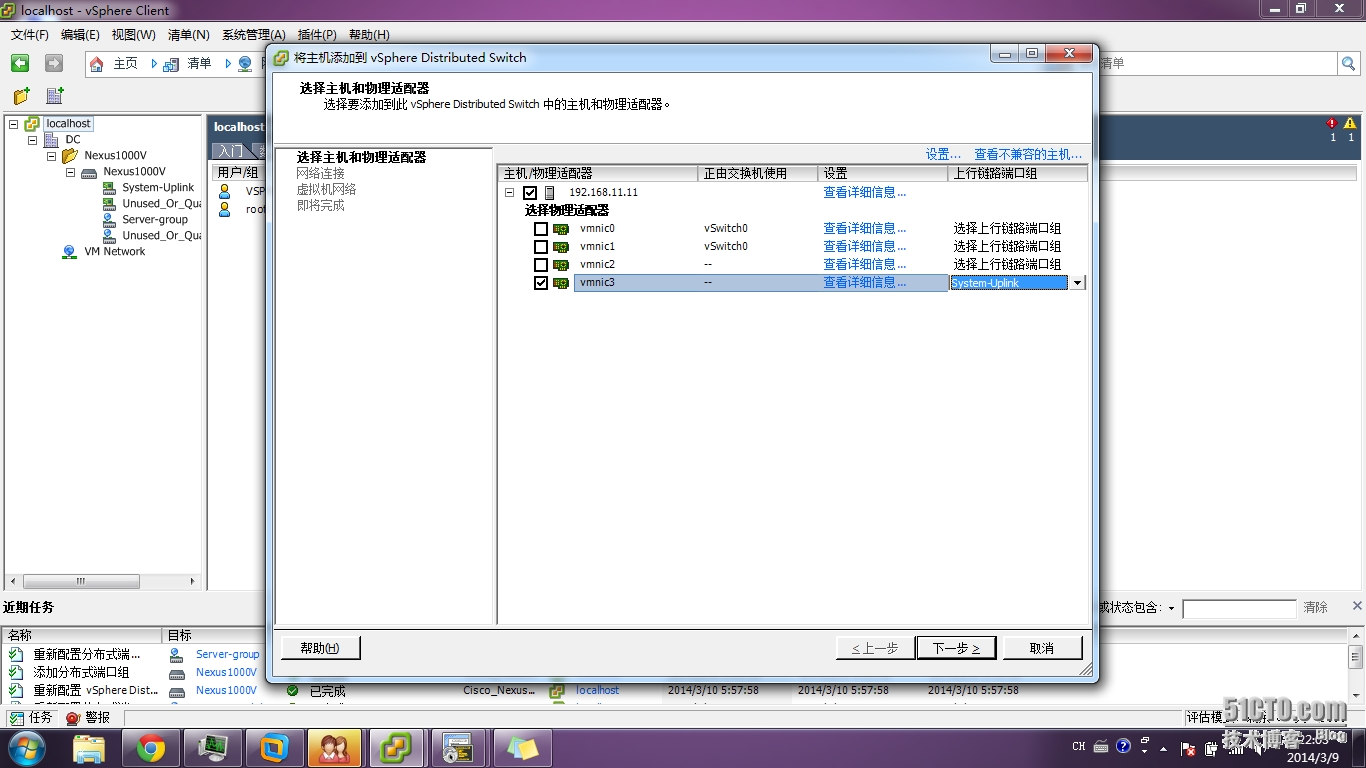

现在吧主机加到1000v中

Nexus1000V 右键 添加主机选vic3 上联口选 system-uplink

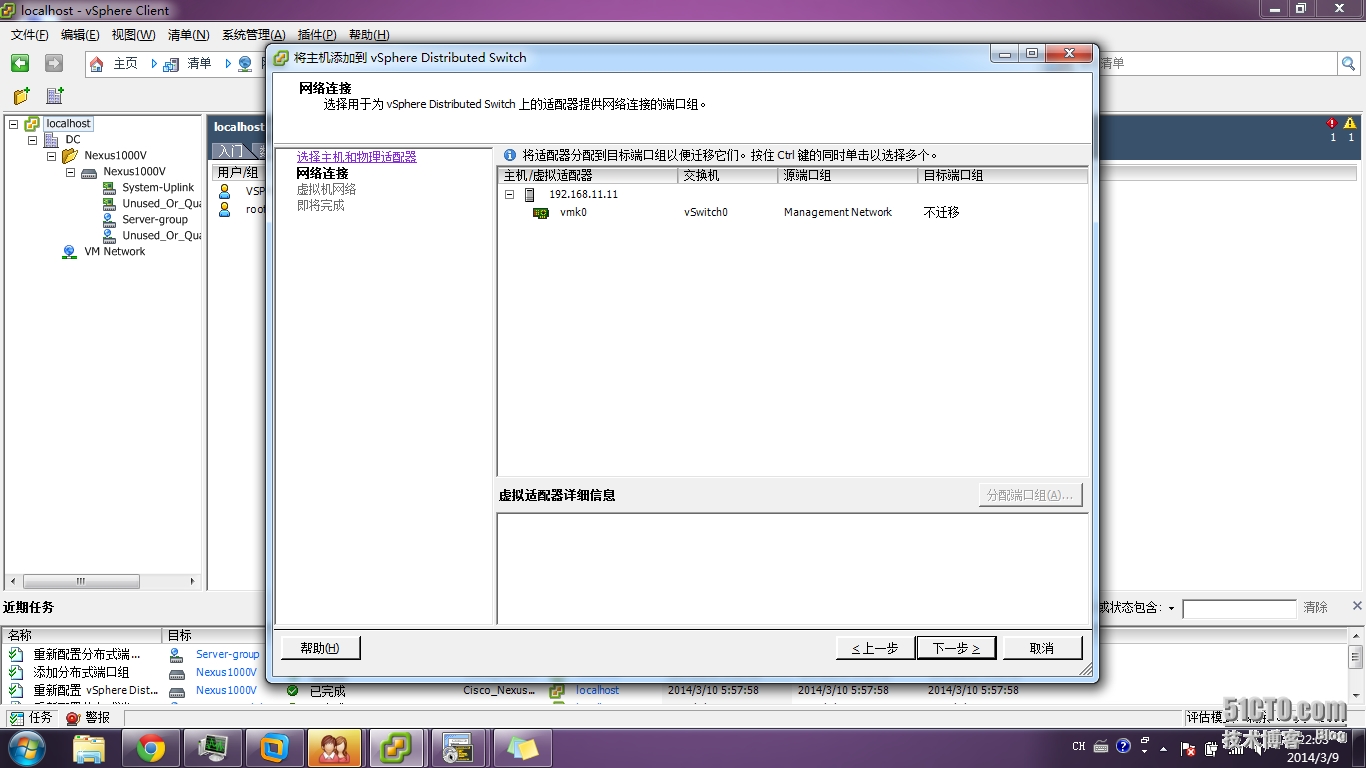

这个L2模式应该不用管

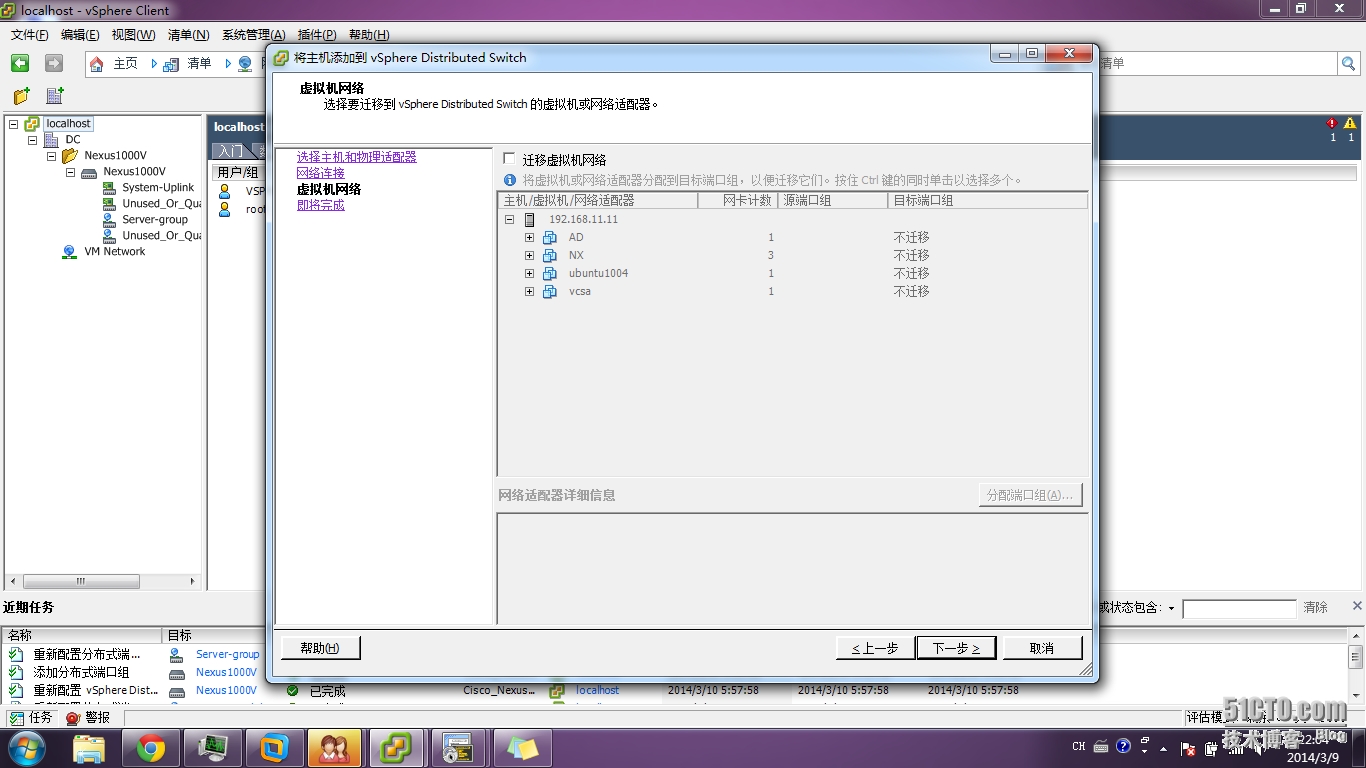

暂不迁移,一会我手动安全,你会看到丢不丢包。。。

完成

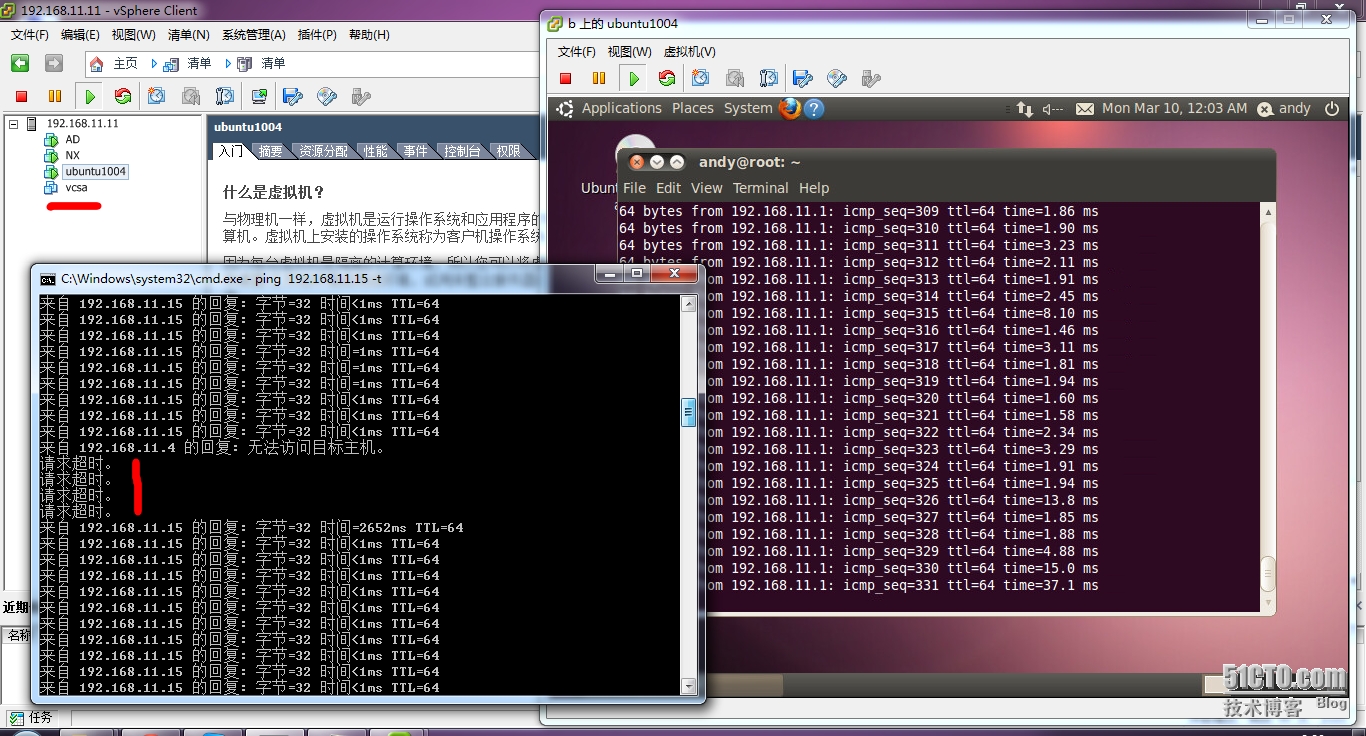

手动切换

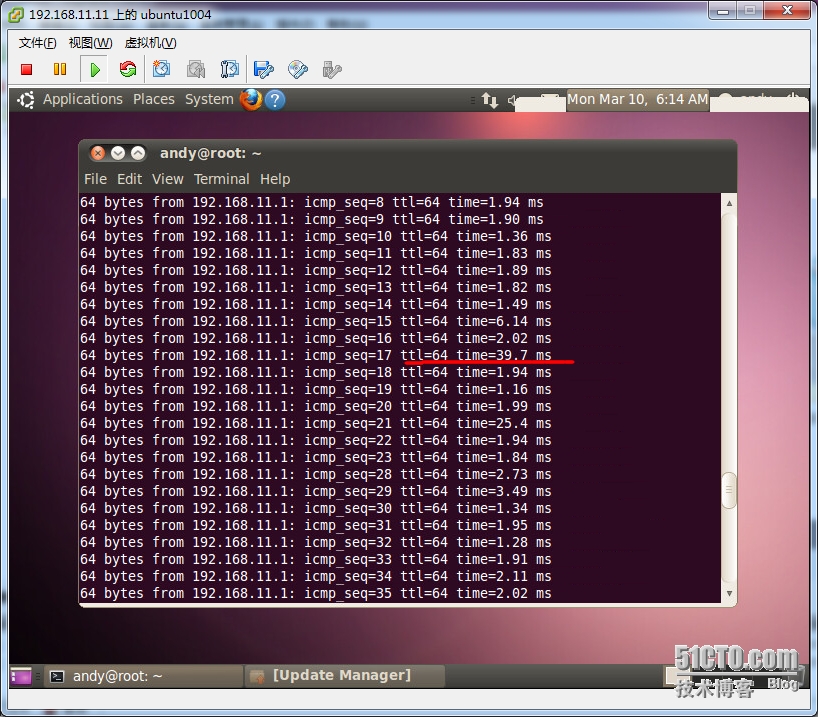

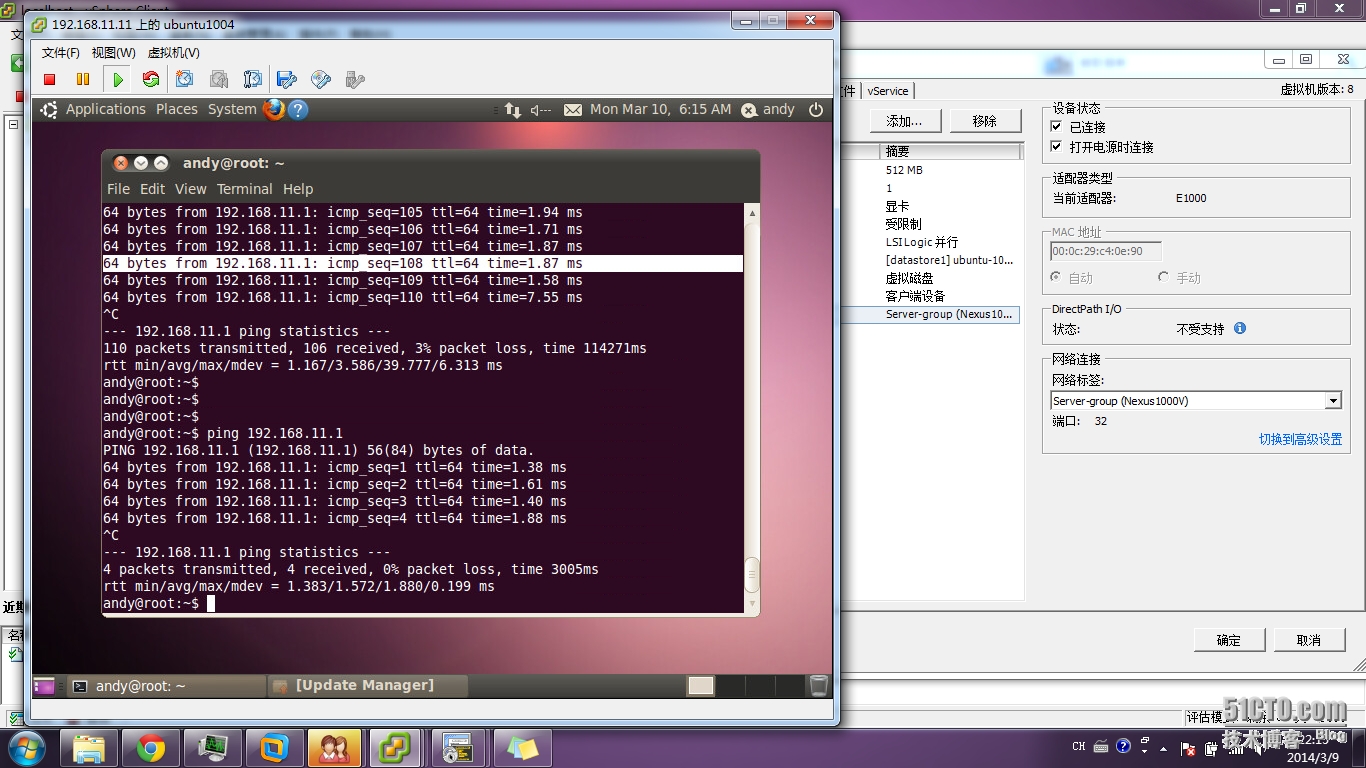

红线处看到了吧 不丢包只是延迟大点,标准交换机――》1000v,1000v――――》标准交换机,自带分布式交换机――――》1000v,1000v――――》自带分布式交换机,

一切ok都不丢包

最后玩一个,你说把vcsa停掉 1000v包括上面的虚机还通吗,

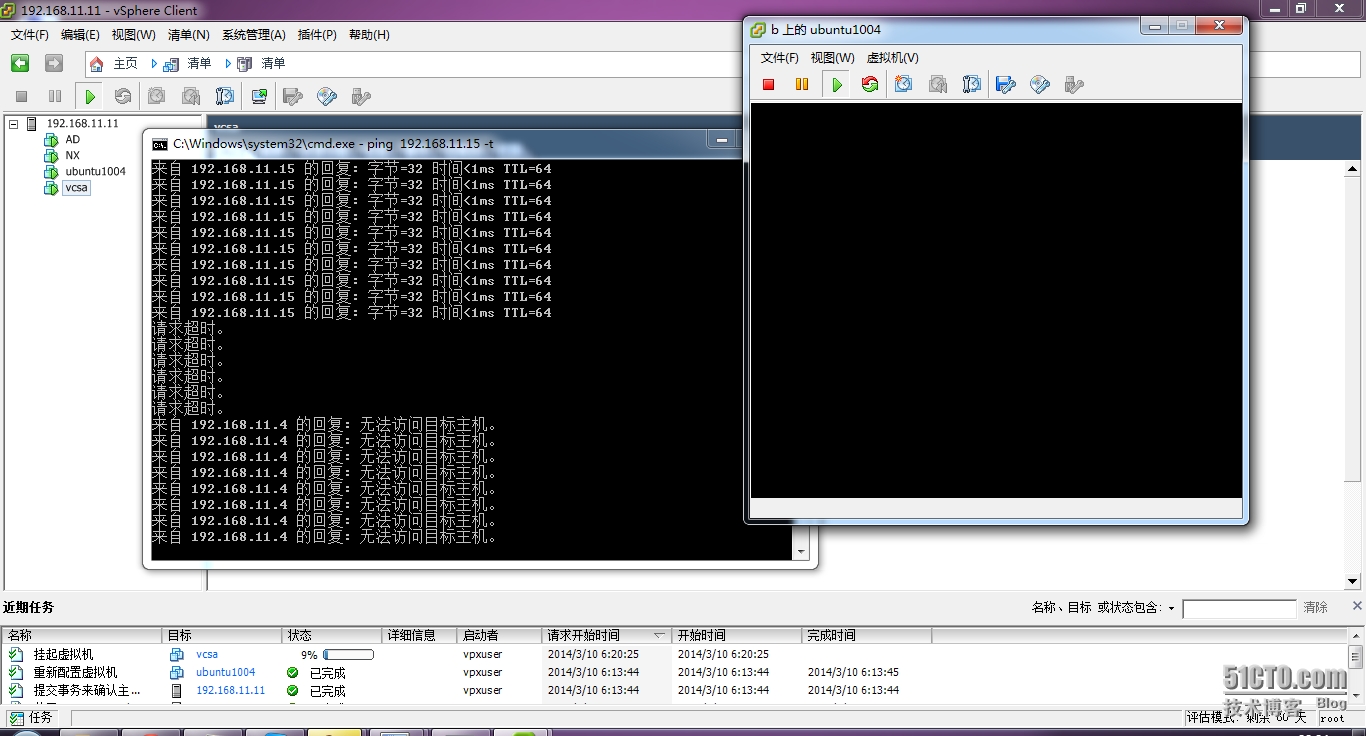

vcsa已挂起 不能登上了,只能登上esxi看结果

结果是,顿时就不同了,1000v上的主机都不同了,而且1000v自己也不通了

我想这能说明1000v的交换机制。。。

现在我不能再截图了, 因为你懂的。。。我刚才挂起vcsa直接导致esxi崩溃,什么有没有了。。。

要引以为戒啊,esxi崩溃了!!!

但不要下结论,看下面的情况

可是。。。可是。。。下图都是我崩溃的场景,连esxi都崩溃了,当我再次启动它,再次关闭vcsa,发现,1000v的端口组会断开,可以过一会又好了,怎么个情况,然后主机ping虚机就断断续续,

虚机ping主机一直都好。。。

几分钟后全通了。。。然后出现规律性丢包,然后又通,然后又规律性丢包。。。

难道1000v底层网络(用于虚机间)只跟esxi有关,与vcsa无关,这是结论吗???那为什么丢包呢???关vcsa后立刻不通,过一会又通,是vcsa把网络转交给esxi吗???继续在官方文档中找答案吧,还是得懂点原理。。。真相后附。。。

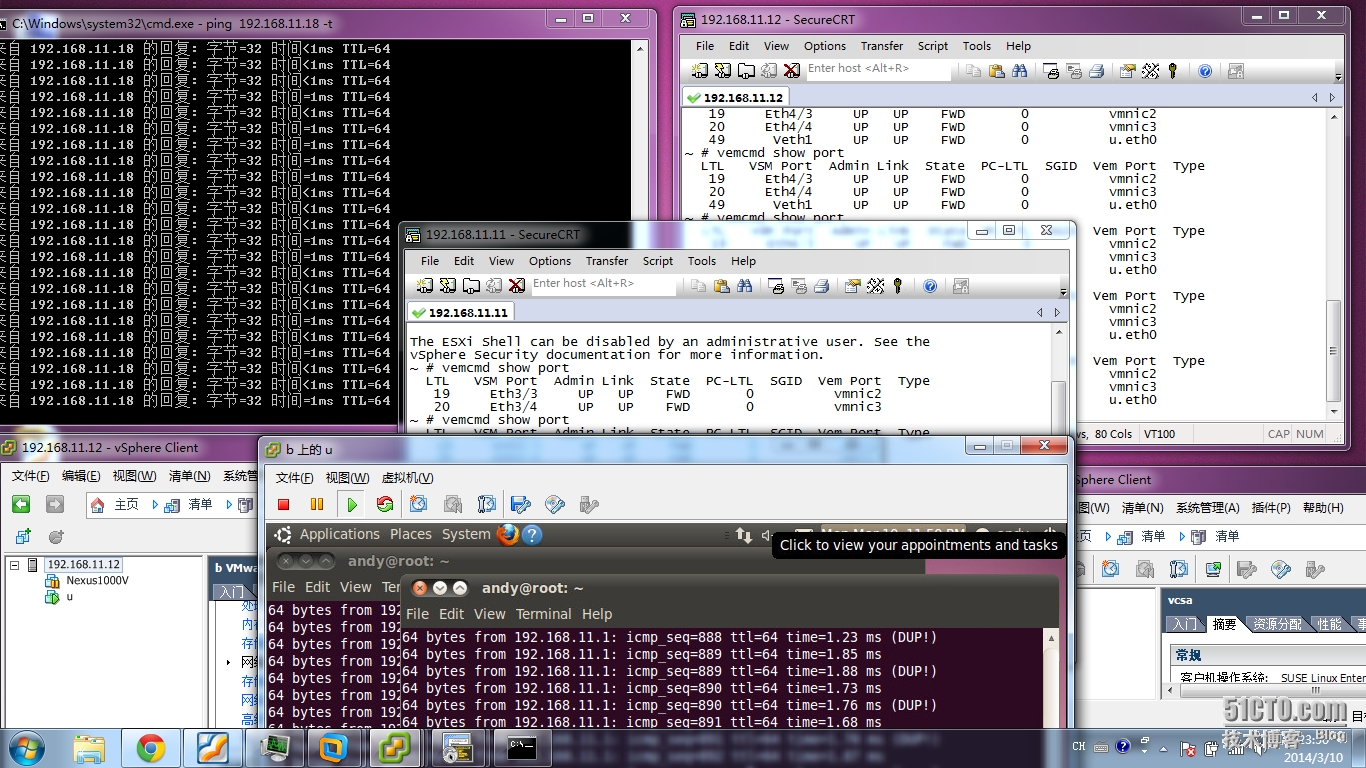

挂起vcsa后

全部断开 esxi也都登不上去了 但esxi还能ping通。。。仅此而已了

全部重启以后关闭vcsa。。。居然。。。

猜测的真相是:

mgmt是 上联交换机 与 vsm 与vcsa 三者之间的事

data 是 vem 与 上联交换机 两者之间的事

control 与 packet 是 上了交换机 与 vsm 与vem 三者之间的事

后面测试,如果关闭vcsa 和 vsm 照样数据流正常通信,control packet mgmt 不一定,

而且连acl访控策略都照常工作

附上效果图,和原理图

实验可以这么做,

生产中可别这么干啊,而且切换vcsa的时候你可想清楚怎么迁移1000v啊

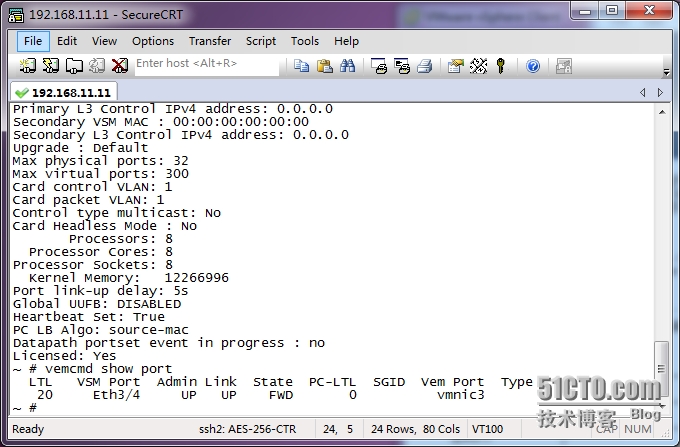

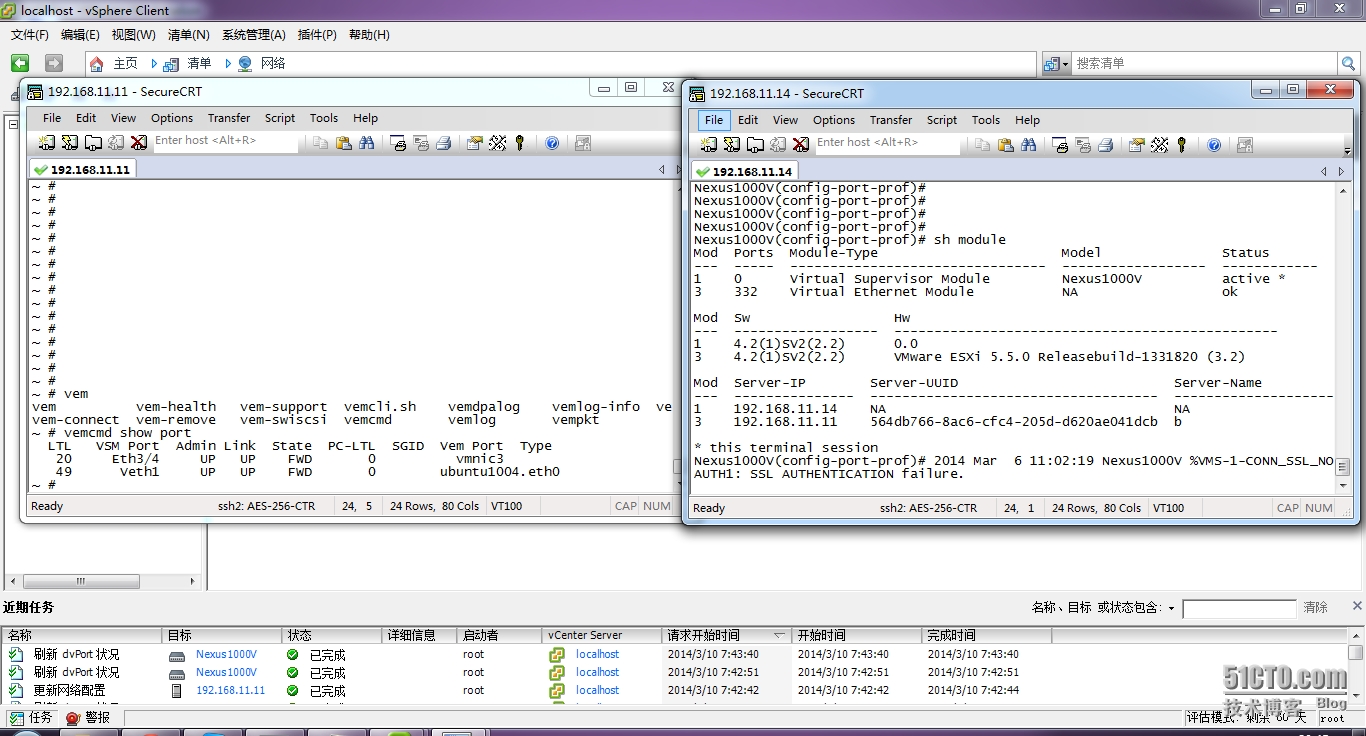

给张esxi上的图片 vmcmd show port

你看一定要有vsm port 否则就没有作用 另外你可以在 vcsa 的 network 端口 看到 uplink 和 端口组,和他们的状态,在1000v上shoe module 一定有 vem 板卡 否则不能通信。。。

再来两张排错图

在esxi上vemcmd show port 一定要有vsm port 否则没有通信上

在1000v上是module 一定有vem 否则没有通信上

vcs network 配置上 两个端口都是绿的,不是叉,叉就blocked down by admin了

主机上会显示esxi的地址

最后有个问题 L2 和 L3 的区别是什么,L3怎么配置才能让端口组通 而不是block by admin

哪位大神告诉小弟啊???