压缩感知重构算法之广义正交匹配追踪(gOMP)

题目:压缩感知重构算法之广义正交匹配追踪(gOMP)

广义正交匹配追踪(Generalized OMP, gOMP)算法可以看作为OMP算法的一种推广,由文献[1]提出,第1作者本硕为哈工大毕业,发表此论文时在Korea University攻读博士学位。OMP每次只选择与残差相关最大的一个,而gOMP则是简单地选择最大的S个。之所以这里表述为“简单地选择”是相比于ROMP之类算法的,不进行任何其它处理,只是选择最大的S个而已。

0、符号说明如下:

压缩观测y=Φx,其中y为观测所得向量M×1,x为原信号N×1(M<<N)。x一般不是稀疏的,但在某个变换域Ψ是稀疏的,即x=Ψθ,其中θ为K稀疏的,即θ只有K个非零项。此时y=ΦΨθ,令A=ΦΨ,则y=Aθ。

(1) y为观测所得向量,大小为M×1

(2)x为原信号,大小为N×1

(3)θ为K稀疏的,是信号在x在某变换域的稀疏表示

(4) Φ称为观测矩阵、测量矩阵、测量基,大小为M×N

(5) Ψ称为变换矩阵、变换基、稀疏矩阵、稀疏基、正交基字典矩阵,大小为N×N

(6)A称为测度矩阵、传感矩阵、CS信息算子,大小为M×N

上式中,一般有K<<M<<N,后面三个矩阵各个文献的叫法不一,以后我将Φ称为测量矩阵、将Ψ称为稀疏矩阵、将A称为传感矩阵。

注意:这里的稀疏表示模型为x=Ψθ,所以传感矩阵A=ΦΨ;而有些文献中稀疏模型为θ=Ψx,而一般Ψ为Hermite矩阵(实矩阵时称为正交矩阵),所以Ψ-1=ΨH (实矩阵时为Ψ-1=ΨT),即x=ΨHθ,所以传感矩阵A=ΦΨH,例如沙威的OMP例程中就是如此。

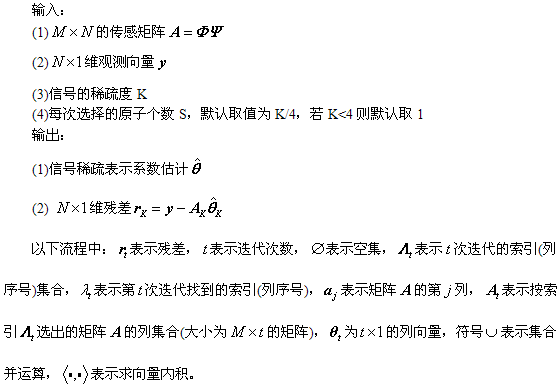

1、gOMP重构算法流程:

2、广义正交匹配追踪(gOMP)MATLAB代码(CS_gOMP.m)

本代码完全是为了保证和前面的各算法代法格式一致,可以直接使用该实验室网站提供的代码[2]压缩包中的islsp_EstgOMP.m。

function [ theta ] = CS_gOMP( y,A,K,S )

%CS_gOMP Summary of this function goes here

%Version: 1.0 written by jbb0523 @2015-05-08

% Detailed explanation goes here

% y = Phi * x

% x = Psi * theta

% y = Phi*Psi * theta

% 令 A = Phi*Psi, 则y=A*theta

% 现在已知y和A,求theta

% Reference: Jian Wang, Seokbeop Kwon, Byonghyo Shim. Generalized

% orthogonal matching pursuit, IEEE Transactions on Signal Processing,

% vol. 60, no. 12, pp. 6202-6216, Dec. 2012.

% Available at: http://islab.snu.ac.kr/paper/tsp_gOMP.pdf

if nargin < 4

S = round(max(K/4, 1));

end

[y_rows,y_columns] = size(y);

if y_rows<y_columns

y = y';%y should be a column vector

end

[M,N] = size(A);%传感矩阵A为M*N矩阵

theta = zeros(N,1);%用来存储恢复的theta(列向量)

Pos_theta = [];%用来迭代过程中存储A被选择的列序号

r_n = y;%初始化残差(residual)为y

for ii=1:K%迭代K次,K为稀疏度

product = A'*r_n;%传感矩阵A各列与残差的内积

[val,pos]=sort(abs(product),'descend');%降序排列

Sk = union(Pos_theta,pos(1:S));%选出最大的S个

if length(Sk)==length(Pos_theta)

if ii == 1

theta_ls = 0;

end

break;

end

if length(Sk)>M

if ii == 1

theta_ls = 0;

end

break;

end

At = A(:,Sk);%将A的这几列组成矩阵At

%y=At*theta,以下求theta的最小二乘解(Least Square)

theta_ls = (At'*At)^(-1)*At'*y;%最小二乘解

%At*theta_ls是y在At)列空间上的正交投影

r_n = y - At*theta_ls;%更新残差

Pos_theta = Sk;

if norm(r_n)<1e-6

break;%quit the iteration

end

end

theta(Pos_theta)=theta_ls;%恢复出的theta

end

3、gOMP单次重构测试代码(CS_Reconstuction_Test.m)

以下测试代码基本与OMP单次重构测试代码一样。也可参考该实验室网站提供的代码[2]压缩包中的Test_gOMP.m。

%压缩感知重构算法测试

clear all;close all;clc;

M = 128;%观测值个数

N = 256;%信号x的长度

K = 30;%信号x的稀疏度

Index_K = randperm(N);

x = zeros(N,1);

x(Index_K(1:K)) = 5*randn(K,1);%x为K稀疏的,且位置是随机的

Psi = eye(N);%x本身是稀疏的,定义稀疏矩阵为单位阵x=Psi*theta

Phi = randn(M,N)/sqrt(M);%测量矩阵为高斯矩阵

A = Phi * Psi;%传感矩阵

y = Phi * x;%得到观测向量y

%% 恢复重构信号x

tic

theta = CS_gOMP( y,A,K);

x_r = Psi * theta;% x=Psi * theta

toc

%% 绘图

figure;

plot(x_r,'k.-');%绘出x的恢复信号

hold on;

plot(x,'r');%绘出原信号x

hold off;

legend('Recovery','Original')

fprintf('\n恢复残差:');

norm(x_r-x)%恢复残差

运行结果如下:(信号为随机生成,所以每次结果均不一样)

1) 图:

2)Command windows

Elapsedtime is 0.155937 seconds.

恢复残差:

ans=

2.3426e-014

4、信号稀疏度K与重构成功概率关系曲线绘制例程代码

以下测试代码为了与文献[1]的Fig.1作比较。由于暂未研究学习LP算法,所以相比于文献[1]的Fig.1)缺少LP算法曲线,加入了SP算法。以下测试代码与SAMP相应的测试代码基本一致,可以合并在一起运行,只须在主循环内多加几种算法重构就行。

%压缩感知重构算法测试CS_Reconstuction_KtoPercentagegOMP.m

% 绘制参考文献中的Fig.1

% Reference: Jian Wang, Seokbeop Kwon, Byonghyo Shim. Generalized

% orthogonal matching pursuit, IEEE Transactions on Signal Processing,

% vol. 60, no. 12, pp. 6202-6216, Dec. 2012.

% Available at: http://islab.snu.ac.kr/paper/tsp_gOMP.pdf

% Elapsed time is 798.718246 seconds.(@20150509pm)

clear all;close all;clc;

%% 参数配置初始化

CNT = 1000;%对于每组(K,M,N),重复迭代次数

N = 256;%信号x的长度

Psi = eye(N);%x本身是稀疏的,定义稀疏矩阵为单位阵x=Psi*theta

M_set = [128];%测量值集合

KIND = ['OMP ';'ROMP ';'StOMP ';'SP ';'CoSaMP ';...

'gOMP(s=3)';'gOMP(s=6)';'gOMP(s=9)'];

Percentage = zeros(N,length(M_set),size(KIND,1));%存储恢复成功概率

%% 主循环,遍历每组(K,M,N)

tic

for mm = 1:length(M_set)

M = M_set(mm);%本次测量值个数

K_set = 5:5:70;%信号x的稀疏度K没必要全部遍历,每隔5测试一个就可以了

%存储此测量值M下不同K的恢复成功概率

PercentageM = zeros(size(KIND,1),length(K_set));

for kk = 1:length(K_set)

K = K_set(kk);%本次信号x的稀疏度K

P = zeros(1,size(KIND,1));

fprintf('M=%d,K=%d\n',M,K);

for cnt = 1:CNT %每个观测值个数均运行CNT次

Index_K = randperm(N);

x = zeros(N,1);

x(Index_K(1:K)) = 5*randn(K,1);%x为K稀疏的,且位置是随机的

Phi = randn(M,N)/sqrt(M);%测量矩阵为高斯矩阵

A = Phi * Psi;%传感矩阵

y = Phi * x;%得到观测向量y

%(1)OMP

theta = CS_OMP(y,A,K);%恢复重构信号theta

x_r = Psi * theta;% x=Psi * theta

if norm(x_r-x)<1e-6%如果残差小于1e-6则认为恢复成功

P(1) = P(1) + 1;

end

%(2)ROMP

theta = CS_ROMP(y,A,K);%恢复重构信号theta

x_r = Psi * theta;% x=Psi * theta

if norm(x_r-x)<1e-6%如果残差小于1e-6则认为恢复成功

P(2) = P(2) + 1;

end

%(3)StOMP

theta = CS_StOMP(y,A);%恢复重构信号theta

x_r = Psi * theta;% x=Psi * theta

if norm(x_r-x)<1e-6%如果残差小于1e-6则认为恢复成功

P(3) = P(3) + 1;

end

%(4)SP

theta = CS_SP(y,A,K);%恢复重构信号theta

x_r = Psi * theta;% x=Psi * theta

if norm(x_r-x)<1e-6%如果残差小于1e-6则认为恢复成功

P(4) = P(4) + 1;

end

%(5)CoSaMP

theta = CS_CoSaMP(y,A,K);%恢复重构信号theta

x_r = Psi * theta;% x=Psi * theta

if norm(x_r-x)<1e-6%如果残差小于1e-6则认为恢复成功

P(5) = P(5) + 1;

end

%(6)gOMP,S=3

theta = CS_gOMP(y,A,K,3);%恢复重构信号theta

x_r = Psi * theta;% x=Psi * theta

if norm(x_r-x)<1e-6%如果残差小于1e-6则认为恢复成功

P(6) = P(6) + 1;

end

%(7)gOMP,S=6

theta = CS_gOMP(y,A,K,6);%恢复重构信号theta

x_r = Psi * theta;% x=Psi * theta

if norm(x_r-x)<1e-6%如果残差小于1e-6则认为恢复成功

P(7) = P(7) + 1;

end

%(8)gOMP,S=9

theta = CS_gOMP(y,A,K,9);%恢复重构信号theta

x_r = Psi * theta;% x=Psi * theta

if norm(x_r-x)<1e-6%如果残差小于1e-6则认为恢复成功

P(8) = P(8) + 1;

end

end

for iii = 1:size(KIND,1)

PercentageM(iii,kk) = P(iii)/CNT*100;%计算恢复概率

end

end

for jjj = 1:size(KIND,1)

Percentage(1:length(K_set),mm,jjj) = PercentageM(jjj,:);

end

end

toc

save KtoPercentage1000gOMP %运行一次不容易,把变量全部存储下来

%% 绘图

S = ['-ks';'-ko';'-yd';'-gv';'-b*';'-r.';'-rx';'-r+'];

figure;

for mm = 1:length(M_set)

M = M_set(mm);

K_set = 5:5:70;

L_Kset = length(K_set);

for ii = 1:size(KIND,1)

plot(K_set,Percentage(1:L_Kset,mm,ii),S(ii,:));%绘出x的恢复信号

hold on;

end

end

hold off;

xlim([5 70]);

legend('OMP','ROMP','StOMP','SP','CoSaMP',...

'gOMP(s=3)','gOMP(s=6)','gOMP(s=9)');

xlabel('Sparsity level K');

ylabel('The Probability of Exact Reconstruction');

title('Prob. of exact recovery vs. the signal sparsity K(M=128,N=256)(Gaussian)');

本程序在联想ThinkPadE430C笔记本(4GB DDR3内存,i5-3210)上运行共耗时798.718246秒,程序中将所有数据均通过“save KtoPercentage1000gOMP”存储了下来,以后可以再对数据进行分析,只需“load KtoPercentage1000gOMP”即可。

本程序运行结果:

文献[1]中的Fig.1:

5、结语

我很好奇:为什么相比于OMP算法就是简单每次多选几列,重构效果为什么这么好?居然比复杂的ROMP、CoSaMP、StOMP效果还要好……

该课题组还提出了MMP算法,可参见文献[3]。更多关于该课题组的信息可去官方网站查询:http://islab.snu.ac.kr/,也可直接查看发表的文章:http://islab.snu.ac.kr/publication.html。

文献[1]最后有两个TABLE,分别是算法的流程和复杂度总结:

谁能告诉我TABLE I表头中的DELETE在这里是什么意思啊?不是删除的意思么?

6、参考文献

【1】Jian Wang, Seokbeop Kwon,Byonghyo Shim. Generalized orthogonalmatching pursuit, IEEE Transactions on Signal Processing, vol. 60, no. 12, pp.6202-6216, Dec. 2012.

Available at: http://islab.snu.ac.kr/paper/tsp_gOMP.pdf

【2】http://islab.snu.ac.kr/paper/gOMP.zip

【3】S. Kwon, J. Wang andB. Shim, Multipath matching pursuit, IEEE Transactions on Information Theory,vol. 60, no. 5, pp. 2986-3001, May 2014.

Available at: http://islab.snu.ac.kr/paper/TIT_MMP2014.pdf