Hadoop初识--Hadoop安装和环境配置

本人hadoop菜鸟,刚刚开始接触hadoop,或者说是刚刚接触大数据这个名词不久,这几天花时间整理了一下Hadoop的相关知识,写在这里做个笔记。

在参考网上的hadoop安装过程对hadoop进行安装的过程中发生了一些小情况,我做了一个整理。相信大家已经对hadoop的一些初级知识已经比较清楚了。

Hadoop的创建一般有三种模式:单机模式、伪分布模式和全分布模式。我现在还没有对hadoop很了解,所以只是创建了一个单机模式玩玩。

单机模式操作是hadoop的默认操作模式,当首次解压hadoop的源码包时,Hadoop无法了解硬件安装环境,会保守地选择最小配置,即单机模式。该模式主要用于开发调试MapReduce程序的应用逻辑,而不会和守护进行交互,避免增加额外的复杂性。(这段话是网上摘抄的,说的不错。)

在Ubuntu 12.04上创建hadoop单机模式(网上摘抄,改进了一小部分):

Step1:创建Hadoop用户组:

~$ sudo addgroup hadoop

Step2:创建Hadoop用户:

~$ sudo adduser -ingroup hadoop hadoop

回车后会提示输入密码,这是新建Hadoop的密码,输入两次密码敲回车即可。如下图所示:

Step3:为Hadoop用户添加权限:

~$ sudo gedit /etc/sudoers

点击回车后,打开sudoers文件,在

root ALL=(ALL:ALL) ALL

后添加:

hadoop ALL=(ALL:ALL) ALL

注意:“hadoop” 后为"\t",而不是一个空格,一旦sudoers修改错误会引起很严重的后果(比如导致sudo命令无法正常使用,这时候只能通过root权限进行复原)。修改后的sudoers文件如下图所示: Step4:切换到hadoop用户操作一下步骤:

~$ su hadoop

输入密码即可。

Step5:安装Hadoop通信需要的SSH: ~$ sudo apt-get install openssh-server

安装完以后,启动服务:

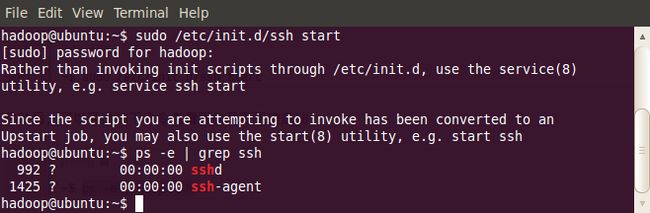

~$ sudo /etc/init.d/ssh start

启动后,可以通过如下命令来确认服务是否正确启动:

~$ ps -e | grep ssh

如下图所示:

然而在我的Ubuntu上并没有看到“ssh-agent”这个服务,这个方面暂时不是太懂,不过最后配置完了之后发现也并没有什么问题,hadoop运行的好好的,所以暂时我们不去纠结这个问题。我的如下图所示:

作为一个安全通信协议,使用时需要密码,因此我们要设置成免密码登录,生成私钥和公钥:

~$ ssh-keygen -t rsa -P ""

如下图所示:

此时会在/home/hadoop/.ssh下生成两个文件:id_rsa和id_rsa.pub,前者为私钥,后者为公钥。现在我们将公钥追加到authorized_keys中(authorized_keys用于保存所有允许以当前用户身份登录到ssh客户端用户的公钥内容):

~$ cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys

现在可以登入ssh确认以后登录时不用输入密码:

~$ ssh localhost

退出:

~$ exit

Step6:安装Java(自己按照提示安装完整):~$ sudo apt-get install openjdk-6-jdk

Step7:安装Hadoop:1)下载:

目前最新版本为2.7.0,可以根据自己的需要,安装不同版本的Hadoop,下载地址:请点击这里

2)解压(如果是默认下载,Ubuntu系统会默认下载到文件夹“下载/”中,而此时的登录账户是hadoop,因此看不到这个文件夹,可以另启一个Terminal使用系统默认账户进行解压和复制操作。完成本步操作后记得重新回到原Terminal窗口使用hadoop账户进行操作即可。):

~$ sudo tar xzf hadoop-2.7.2.tar.gz

3)将hadoop移动到 /usr/local/hadoop目录下:

~$ sudo mv hadoop-2.7.2 /usr/local/hadoop

4)要确保所有的操作都是在用户hadoop下完成的:

~$ sudo chown -R hadoop:hadoop /usr/local/hadoop

Step8:配置Hadoop:

1)配置.bashrc:

配置该文件,需要知道Java的安装路径,可以通过下面的代码查看:

~$ update-alternatives --config java

执行结果如下:

完整的路径为:/usr/lib/jvm/java-7-openjdk-amd64/jre/bin/java,我们只取前面的部分 /usr/lib/jvm/java-7-openjdk-amd64。

修改.bashrc文件:

~$ sudo gedit ~/.bashrc

该命令会打开该文件的编辑窗口,在文件末尾追加下面内容,然后保存,关闭编辑窗口。

#HADOOP VARIABLES START

export JAVA_HOME=/usr/lib/jvm/java-7-openjdk-amd64

export HADOOP_INSTALL=/usr/local/hadoop

export PATH=PATH:HADOOP_INSTALL/bin

export PATH="usr/sbin:usr/bin:usr/local/bin:usr/local/sbin:/bin:/sbin"

export HADOOP_MAPRED_HOME=$HADOOP_INSTALL

export HADOOP_COMMON_HOME=$HADOOP_INSTALL

export HADOOP_HDFS_HOME=$HADOOP_INSTALL

export YARN_HOME=$HADOOP_INSTALL

export HADOOP_COMMON_LIB_NATIVE_DIR=$HADOOP_INSTALL/lib/native

export HADOOP_OPTS="-Djava.library.path=$HADOOP_INSTALL/lib"

#HADOOP VARIABLES END

使添加的环境变量生效:

~$ source ~/.bashrc

2)配置hadoop-env.sh

打开hadoop-env.sh文件:

~$ sudo gedit /usr/local/hadoop/etc/hadoop/hadoop-env.sh

找到JAVA_HOME变量,按如下进行修改:

~$ export JAVA_HOME=/usr/lib/jvm/java-7-openjdk-amd64

修改后的hadoop-env.sh文件如下所示:

最后使配置生效:~$ source /usr/local/hadoop/etc/hadoop/hadoop-env.sh

到这里,单机模式的hadoop就全部安装完毕了。

Step9:测试hadoop是否安装完成:为了测试Hadoop安装在正确性,我们可以用在带的例子(比如WordCount)进行测试。

1) 在/usr/local/hadoop路径下创建input文件夹

~$ mkdir input

2)拷贝 README.txt 到 input 文件夹

~$ cp README.txt input

3)执行WordCount程序实例

~$ bin/hadoop jar share/hadoop/mapreduce/sources/hadoop-mapreduce-examples-2.7.0-sources.jar org.apache.hadoop.examples.WordCount input output

如果看到这些内容,那么恭喜你,这说明你的Hadoop已经安装成功了。

(完)