Hadoop1.2.1完全分布式部署

首先确保各个节点主机之间能够SSH无密码访问,关于SSH无密码登陆的配置方法,参考 http://blog.csdn.net/spring292713/article/details/14000737

| IP地址 | 节点名称 |

| 192.168.85.152 | Master |

| 192.168.85.153 | Slave |

只在Master节点上配置,然后拷贝给其他节点,下面是master的详细配置。

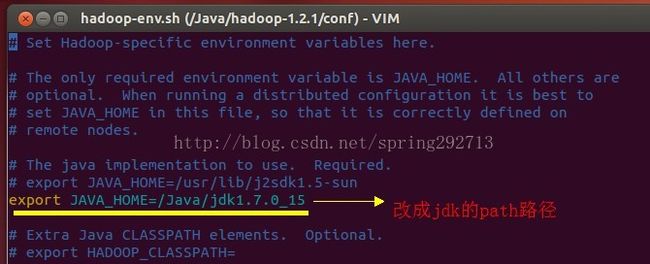

1) 首先,需要配置的是在conf文件夹下找到hadood-env.sh这个文件,然后使用命令vi hadood-env.sh编辑此文件并取消注释的JAVA HOME,然后配上我们自己的的JDK路径,截图如下 :

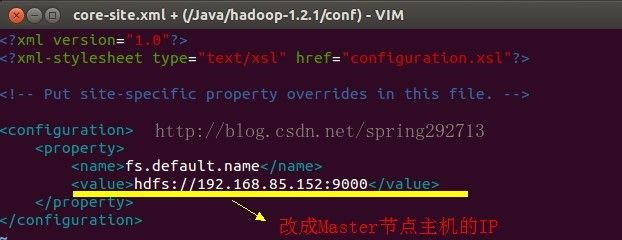

2) 第二我们需要配置的是conf下的core.site.xml这个文件 ,添加 :

<property> <name>fs.default.name</name> <value>hdfs://192.168.85.152:9000</value> </property>其中,192.168.85.152是Master主机的IP; 截图如下:

3) 第三我们需要配置的是hdfs.site.xml这个文件,因为Salve机器的有1个Slave,所以

节点数写1就可以了,注意默认是3

<property> <name>dfs.replication</name> <value>1</value> </property>截图如下 :

4) 第四我们需要配置conf下的mapred-site.xml文件

<property> <name>mapred.job.tracker</name> <value>192.168.85.152:9001</value> </property>其中,192.168.85.152是Master主机的IP; 截图如下:

5) 第五我们需要配置conf下的master文件,直接把主节点的IP,加入其中即可,截图如下:

6) 第六我们需要配置conf下的slave文件,直接把子节点的IP,加入其中即可,截图如下:

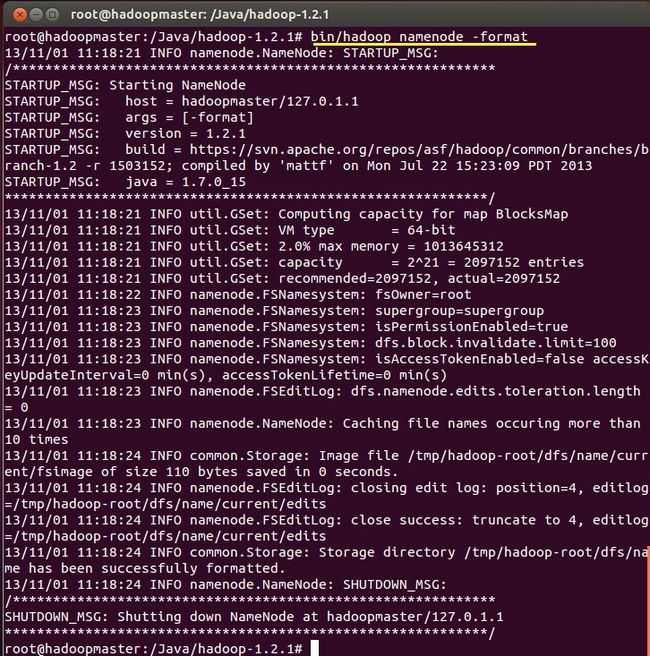

7) 配置完成之后,我们在主节点上,执行bin/hadoop namenode -format 进行格式化,如图:

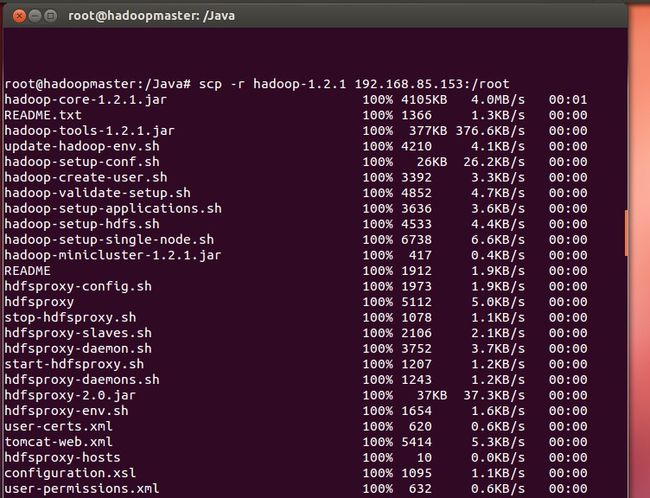

8) 格式化完毕之后,就可以通过scp进行远程拷贝到子节点了,截图如下:

9) 然后就可以在master节点上,执行启动命令:bin/start-all.sh,

启动成功之后,可以使用jps命令在各个节点上,查看端口情况,截图如下:

至此,我们的完全分布式集群部署,已经搭建完毕,停掉集群的命令是bin/stop-all.sh。

原文章来源:http://qindongliang1922.iteye.com/blog/1964852