Win7中使用Eclipse连接虚拟机中的Ubuntu中的Hadoop2.7.1经验总结

本文的目的:

Win7中使用Eclipse连接虚拟机中的Ubuntu中的Hadoop2.7

版本:Hadoop2.7.1

hadoop安装模式:伪分布式

本文主要解决的问题:

检查点:

1. 配置文件是否正确,localhost是否需要替换成hadoop master的IP

2. 集群是否启动

3. 是否关闭防火墙

4. hosts中主机名和地址是否映射

5. 虚拟机的IP是否设置成桥接模式静态ip, 检查虚拟机和主机是否可以互相ping通;

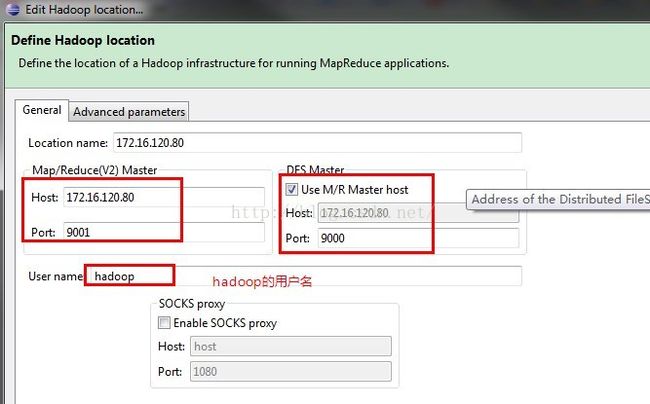

6. eclipse hadoop连接配置是否正确, 端口是否与core-site.xml配置文件一致;

修改hadoop location参数,在advanced parameter选项卡中,hadoop.tmp.dir: /usr/local/hadoop/tmp 与core-site.xml保持一致;

配置:

core-site.xml

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://<hadoop master ip地址>:9000</value> <!--这里网上有人说localhost会出错,测试如此,更换为<pre name="code" class="html">hadoop master ip地址-->

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>file:/usr/local/hadoop/tmp</value>

<description>A base for other temporary directories.</description>

</property>

</configuration>

注意fs.defaultFS 的配置

hdfs-site.xml

<configuration> <property> <name>dfs.replication</name> <value>1</value> </property> <property> <name>dfs.namenode.name.dir</name> <value>file:/usr/local/hadoop/tmp/dfs/name</value> </property> <property> <name>dfs.datanode.data.dir</name> <value>file:/usr/local/hadoop/tmp/dfs/data</value> </property> <property> <name>dfs.webhdfs.enabled</name> <value>true</value> </property> <property> <name>dfs.permissions</name> <value>false</value> <!-- 这里需要增加 --> </property> </configuration>

打开conf/hdfs-site.xml,增加dfs.permissions的配置,取消hadoop hdfs的用户权限检查

mapred-site.xml

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

</configuration>

hadoop 2.7.1的mapreduce交给yarn管理

yarn-site.xml

<configuration> <!-- Site specific YARN configuration properties --> <property> <name>yarn.resourcemanager.hostname</name> <value>z10</value> <!--记得配置主机名--> </property> <property> <name>yarn.nodemanager.aux-services</name> <value>mapreduce_shuffle</value> </property> </configuration>

<span style="font-weight: bold; font-family: Arial, Helvetica, sans-serif; background-color: rgb(255, 255, 255);">更改hadoop集群master的hosts</span>

root@z10:~# cat /etc/hosts 127.0.0.1 localhost z10 127.0.1.1 ubuntu

关闭防火墙(ubuntu)

1.关闭ubuntu的防火墙 ufw disable 2.卸载了iptables apt-get remove iptables 3. 查看防火墙状态 sudo ufw status 4.启用: sudo ufw enable sudo ufw default deny

启动集群

hadoop namenode -format

{HADOOP_HOME}/sbin/start-all.sh

jps 查看是否启动成功

18850 DataNode

19362 NodeManager

19045 SecondaryNameNode

19708 Jps

19228 ResourceManager

18717 NameNode

创建hdfs input output文件夹

hadoop fs -mkdir /input hadoop fs -mkdir /onput

可以跑一个wordcount的例子测试hadoop集群是否启动成功

hadoop fs -mkdir /input hadoop fs -put README.txt /input hadoop fs -ls /input hadoop fs -cat /input/README.txt hadoop jar hadoop-mapreduce-examples-2.7.1.jar wordcount /input /output hadoop fs -cat /output/part-r-00000

window7上:

关闭防火墙;

下载对应hadoop2.7.1版本的eclipse 插件 hadoop-eclipse-plugin-2.7.1.jar;

将hadoop-eclipse-plugin-2.7.1.jar拷贝到\eclipse\plugins目录下,重启eclipse;

在apache hadoop官网上下载对应hadoop2.7.1,解压置于E:\Hadoop\hadoop-2.7.1 ,主要为eclipse上hadoop程序开发提供jar包;

在eclipse Window->preference, 配置hadoop路径E:\Hadoop\hadoop-2.7.1 ;

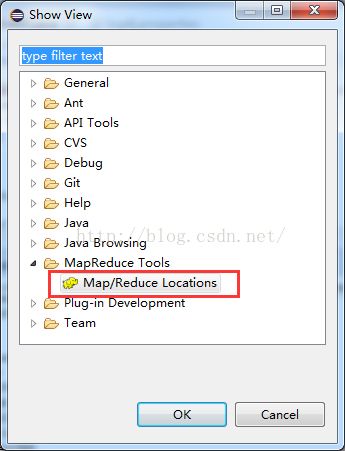

显示Hadoop连接配置窗口:Window--Show View--Other-MapReduce Tools,如下图所示:

配置连接Hadoop,如下图所示:

查看DFS Location

即可

发现了另一篇不错的文章,分享:http://www.cnblogs.com/xia520pi/archive/2012/05/20/2510723.html