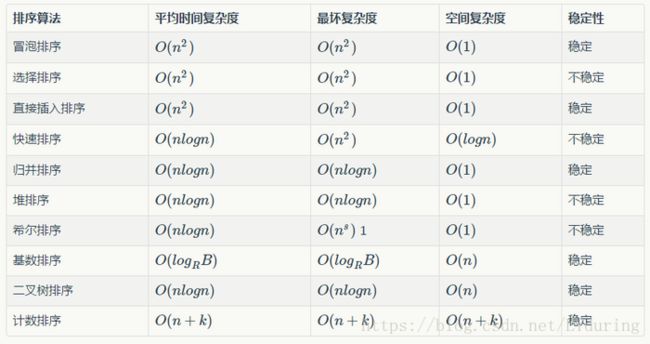

8大排序算法思路及实现

排序算法稳定性定义

假定在待排序的记录序列中,存在多个具有相同的关键字的记录,若经过排序,这些记录的相对次序保持不变,即在原序列中,ri=rj,且ri在rj之前,而在排序后的序列中,ri仍在rj之前,则称这种排序算法是稳定的;否则称为不稳定的。

1、直接插入排序算法

插入排序是在一个已经有序的小序列的基础上,一次插入一个元素。当然,刚开始这个有序的小序列只有1个元素,就是第一个元素。比较是从有序序列的末尾开 始,也就是想要插入的元素和已经有序的最大者开始比起,如果比它大则直接插入在其后面,否则一直往前找直到找到它该插入的位置。如果碰见一个和插入元素相 等的,那么插入元素把想插入的元素放在相等元素的后面。所以,相等元素的前后顺序没有改变,从原无序序列出去的顺序就是排好序后的顺序,所以插入排序是稳 定的。

void insertion_sort(int arr[], int len)

{

int i,j,temp;

for (i = 1 ; i < len ; i++)

{

temp = arr[i];

for (j = i; j > 0 && arr[j-1] > temp; j--) //寻找插入位置

{

arr[j] = arr[j-1]; //记录后移

}

arr[j] = temp;

}

}如果目标是把n个元素的序列升序排列,那么采用插入排序存在最好情况和最坏情况。最好情况就是,序列已经是升序排列了,在这种情况下,需要进行的比较操作需n-1次即可。最坏情况就是,序列是降序排列,那么此时需要进行的比较共有1/2*n(n-1)次。插入排序的赋值操作是比较操作的次数减去n-1次(因为n-1次循环中,每一次循环的比较都比赋值多一个,多在最后那一次比较并不带来赋值)。平均来说插入排序算法复杂度为O(n^2)。因而,插入排序不适合对于数据量比较大的排序应用。但是,如果需要排序的数据量很小,例如,量级小于千;或者若已知输入元素大致上按照顺序排列,那么插入排序还是一个不错的选择。

2、冒泡排序

冒泡排序就是把小的元素往前调或者把大的元素往后调。相邻的两个元素进行比较,交换也发生在这两个元素之间。所以,如果相邻两个元素相等,就不需交换;如果两个相等的元素没有相邻,那么即使通过前面的两两交换把两个相邻起来,这时候也不会交换,所以相同元素的前后顺序并没有改 变,所以冒泡排序是一种稳定排序算法。

void bubble_sort(int arr[], int len) {

int i, j, temp;

for (i = 0; i < len - 1; i++)

for (j = 0; j < len - 1 - i; j++)

if (arr[j] > arr[j + 1]) {

temp = arr[j];

arr[j] = arr[j + 1];

arr[j + 1] = temp;

}

}冒泡排序在最好的情况下,待排序为正序,算法只执行一趟,进行了n-1次比较,时间复杂度为O(n);在最坏的情况下,待排序为反序,算法执行n-1趟,第i趟执行了n-i次比较和n-i次交换,因此时间复杂度为O(n^2)。在平均情况下,时间复杂度也为O(n^2)。

3、希尔排序

希尔排序是对直接插入排序的改进。基本思路是:先将整个待排序序列分割成若干个子序列,在子序列内分别进行直接插入排序,待整个序列基本有序时,再对整体进行一次直接插入排序。希尔排序通过将比较的全部元素分为几个区域来提升插入排序的性能。这样可以让一个元素可以一次性地朝最终位置前进一大步。然后算法再取越来越小的步长进行排序,算法的最后一步就是普通的插入排序,但是到了这步,需排序的数据几乎是已排好的了(此时插入排序较快)。由于多次插入排序,我们知道一次插入排序是稳定的,不会改变相同元 素的相对顺序,但在不同的插入排序过程中,相同的元素可能在各自的插入排序中移动,最后其稳定性就会被打乱,所以希尔排序是不稳定的。

void shell_sort(int arr[], int len) {

int gap, i, j;

int temp;

for (gap = len >> 1; gap > 0; gap >>= 1) //gap为步长

for (i = gap; i < len; i++) {

temp = arr[i];

for (j = i - gap; j >= 0 && arr[j] > temp; j -= gap)

arr[j + gap] = arr[j];

arr[j + gap] = temp;

}

}希尔排序的时间性能在和O(n log n)之间。

4、快速排序

快速排序是对冒泡排序的改进,使用分治法(Divide and conquer)策略来把一个序列(list)分为两个子序列(sub-lists),是不稳定的算法。

步骤为:

- 从数列中挑出一个元素,称为"基准"(pivot),

- 重新排序数列,所有比基准值小的元素摆放在基准前面,所有比基准值大的元素摆在基准后面(相同的数可以到任何一边)。在这个分区结束之后,该基准就处于数列的中间位置。这个称为分区(partition)操作。

- 递归地(recursively)把小于基准值元素的子数列和大于基准值元素的子数列排序。

void quick_sort(int s[], int low, int high) //low, high分别为数组的最小下标和最大下标{if (low < high){int i = low, j = high, pivot = s[low];while (i < j){while(i < j && s[j] >= pivot) // 从右向左找第一个小于pivot的数j--;if(i < j)s[i++] = s[j];while(i < j && s[i] < pivot) // 从左向右找第一个大于等于pivot的数i++;if(i < j)s[j--] = s[i];}s[i] = pivot;quick_sort(s, low, i - 1); // 递归调用quick_sort(s, i + 1, high);}}

即使如果我们无法随机地选择基准数值,对于它的输入之所有可能排列,快速排序仍然只需要nlogn时间。因为这个平均是简单地将输入之所有可能排列的时间加总起来,除以n这个因数,相当于从输入之中选择一个随机的排列。当我们这样作,基准值本质上就是随机的,导致这个算法与随机数快速排序有一样的运行时间。

更精确地说,对于输入顺序之所有排列情形的平均比较次数,可以借由解出这个递归关系式可以精确地算出来。

。

在这里,n-1是分区所使用的比较次数。因为基准值是相当均匀地落在排列好的数列次序之任何地方,总和就是所有可能分区的平均。

这个意思是,平均上快速排序比理想的比较次数,也就是最好情况下,只大约比较糟39%。这意味着,它比最坏情况较接近最好情况。这个快速的平均运行时间,是快速排序比其他排序算法有实际的优势之另一个原因。

5、选择排序

选择排序是一种简单直观的排序算法。它的工作原理如下。首先在未排序序列中找到最小(大)元素,存放到排序序列的起始位置,然后,再从剩余未排序元素中继续寻找最小(大)元素,然后放到已排序序列的末尾。以此类推,直到所有元素均排序完毕。

void swap(int *a,int *b) //交换两个数的位置

{

int temp = *a;

*a = *b;

*b = temp;

}

void selection_sort(int arr[], int len)

{

int i,j;

for (i = 0 ; i < len - 1 ; i++)

{

int min = i;

for (j = i + 1; j < len; j++) //走访未排序的元素

if (arr[j] < arr[min]) //找到目前最小值

min = j; //记录最小值

swap(&arr[min], &arr[i]); //做交換

}

}选择排序的交换操作介于0和n-1次之间。选择排序的比较操作为n(n-2)/2次。选择排序的赋值操作介于0和3(n-1)次之间。

比较次数O(n^2),比较次数与关键字的初始状态无关,总的比较次数。交换次数O(n),最好情况是,已经有序,交换0次;最坏情况是,逆序,交换n-1次。交换次数比冒泡排序较少,由于交换所需CPU时间比比较所需的CPU时间多,n值较小时,选择排序比冒泡排序快。

原地操作几乎是选择排序的唯一优点,当空间复杂度要求较高时,可以考虑选择排序;实际适用的场合非常罕见。

6、堆排序

堆排序是对选择排序的改进,指利用堆这种数据结构所设计的一种排序算法。在堆的数据结构中,堆中的最大值总是位于根节点(在优先队列中使用堆的话堆中的最小值位于根节点)。堆中定义以下几种操作:- 最大堆调整(Max_Heapify):将堆的末端子节点作调整,使得子节点永远小于父节点

- 创建最大堆(Build_Max_Heap):将堆所有数据重新排序

- 堆排序(HeapSort):移除位在第一个数据的根节点,并做最大堆调整的递归运算

void swap(int* a, int* b) {

int temp = *b;

*b = *a;

*a = temp;

}

void max_heapify(int arr[], int start, int end) {

//建立父节点和子节点指标

int dad = start;

int son = dad * 2 + 1;

while (son <= end) { //若子节点在范围内才能做比较

if (son + 1 <= end && arr[son] < arr[son + 1]) //先比较两个子节点的大小,选择最大的

son++;

if (arr[dad] > arr[son]) //如果父节点大于子节点则调整完毕,直接跳出函數

return;

else { //否则交换父子内容再继续子节点和孙节点比较

swap(&arr[dad], &arr[son]);

dad = son;

son = dad * 2 + 1;

}

}

}

void heap_sort(int arr[], int len) {

int i;

//初始化,i从最后一个父节点开始调整

for (i = len / 2 - 1; i >= 0; i--)

max_heapify(arr, i, len - 1);

//先将第一个元素和已排好元素前一位做交换,再重新调整,直到排序完毕

for (i = len - 1; i > 0; i--) {

swap(&arr[0], &arr[i]);

max_heapify(arr, 0, i - 1);

}

}7、归并排序

递归法

- 申请空间,使其大小为两个已经排序序列之和,该空间用来存放合并后的序列

- 设定两个指针,最初位置分别为两个已经排序序列的起始位置

- 比较两个指针所指向的元素,选择相对小的元素放入到合并空间,并移动指针到下一位置

- 重复步骤3直到某一指针到达序列尾

- 将另一序列剩下的所有元素直接复制到合并序列尾

原理如下(假设序列共有{\displaystyle n}个元素):

- 将序列每相邻两个数字进行归并操作,形成{\displaystyle ceil(n/2)}个序列,排序后每个序列包含两/一个元素

- 若此时序列数不是1个则将上述序列再次归并,形成{\displaystyle ceil(n/4)}个序列,每个序列包含四/三个元素

- 重复步骤2,直到所有元素排序完毕,即序列数为1

迭代版:

int min(int x, int y) {

return x < y ? x : y;

}

void merge_sort(int arr[], int len) {

int* a = arr;

int* b = (int*) malloc(len * sizeof(int));

int seg, start;

for (seg = 1; seg < len; seg += seg) {

for (start = 0; start < len; start += seg + seg) {

int low = start, mid = min(start + seg, len), high = min(start + seg + seg, len);

int k = low;

int start1 = low, end1 = mid;

int start2 = mid, end2 = high;

while (start1 < end1 && start2 < end2)

b[k++] = a[start1] < a[start2] ? a[start1++] : a[start2++];

while (start1 < end1)

b[k++] = a[start1++];

while (start2 < end2)

b[k++] = a[start2++];

}

int* temp = a;

a = b;

b = temp;

}

if (a != arr) {

int i;

for (i = 0; i < len; i++)

b[i] = a[i];

b = a;

}

free(b);

}递归版:

void merge_sort_recursive(int arr[], int reg[], int start, int end) {

if (start >= end)

return;

int len = end - start, mid = (len >> 1) + start;

int start1 = start, end1 = mid;

int start2 = mid + 1, end2 = end;

merge_sort_recursive(arr, reg, start1, end1);

merge_sort_recursive(arr, reg, start2, end2);

int k = start;

while (start1 <= end1 && start2 <= end2)

reg[k++] = arr[start1] < arr[start2] ? arr[start1++] : arr[start2++];

while (start1 <= end1)

reg[k++] = arr[start1++];

while (start2 <= end2)

reg[k++] = arr[start2++];

for (k = start; k <= end; k++)

arr[k] = reg[k];

}

void merge_sort(int arr[], const int len) {

int reg[len];

merge_sort_recursive(arr, reg, 0, len - 1);

}8、基数排序

基数排序是这样实现的:将所有待比较数值(正整数)统一为同样的数位长度,数位较短的数前面补零。然后,从最低位开始,依次进行一次排序。这样从最低位排序一直到最高位排序完成以后,数列就变成一个有序序列。void radixsort(int *a, int n) {

int i, b[MAX], m = a[0], exp = 1;

for (i = 1; i < n; i++) {

if (a[i] > m) {

m = a[i];

}

}

while (m / exp > 0) {

int bucket[BASE] = { 0 };

for (i = 0; i < n; i++) {

bucket[(a[i] / exp) % BASE]++;

}

for (i = 1; i < BASE; i++) {

bucket[i] += bucket[i - 1];

}

for (i = n - 1; i >= 0; i--) {

b[--bucket[(a[i] / exp) % BASE]] = a[i];

}

for (i = 0; i < n; i++) {

a[i] = b[i];

}

exp *= BASE;

}

}基数排序的时间复杂度是O(kn),其中n是排序元素个数,k是数字位数。注意这不是说这个时间复杂度一定优于O(nlogn),k的大小取决于数字位的选择(比如比特位数),和待排序数据所属数据类型的全集的大小;k决定了进行多少轮处理,而n是每轮处理的操作数目。