【云星数据---Apache Flink实战系列(精品版)】:Apache Flink批处理API详解与编程实战004--DateSet实用API详解004

DateSet的API详解四

mapPartition

def mapPartition[R](fun: (Iterator[T]) ⇒

TraversableOnce[R])(implicit arg0: TypeInformation[R], arg1: ClassTag[R]): DataSet[R]

def mapPartition[R](fun: (Iterator[T], Collector[R]) ⇒

Unit)(implicit arg0: TypeInformation[R], arg1: ClassTag[R]): DataSet[R]

def mapPartition[R](partitionMapper: MapPartitionFunction[T, R])

(implicit arg0: TypeInformation[R], arg1: ClassTag[R]): DataSet[R]

Creates a new DataSet by applying the given function to each parallel partition of the DataSet.

和map类似,不同它的处理单位是partition,而非element。执行程序:

//1.创建一个 DataSet其元素为String类型

val input: DataSet[String] = benv.fromElements("zhangsan boy", "lisi is a girl so sex")

//2.获取partition的个数

val result=input.mapPartition{in => Some(in.size)}

//3.将结果显示出来

result.collect执行结果:

res49: Seq[Int] = Buffer(2)filter

def filter(fun: (T) ⇒ Boolean): DataSet[T]

def filter(filter: FilterFunction[T]): DataSet[T]

Creates a new DataSet that contains only the elements satisfying the given filter predicate.

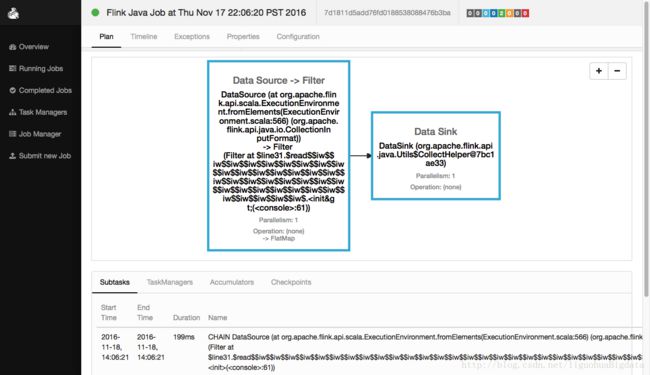

过滤满足添加的元素,不满足条件的元素将被丢弃!filter示例一

执行程序:

//1.创建一个 DataSet其元素为String类型

val input: DataSet[String] = benv.fromElements("zhangsan boy", "lisi is a girl so sex","wangwu boy")

//2.过滤出包含'boy'字样的元素

val result=input.filter{_.contains("boy")} //也可以写成filter(_.contains("boy"))

//3.将结果显示出来

result.collect执行结果:

res50: Seq[String] = Buffer(zhangsan boy, wangwu boy)filter示例二

执行程序:

//1.创建一个DataSet[Int]

val intNumbers: DataSet[Int] = benv.fromElements(2,4,6,2,3,7)

//2.过滤偶数

val naturalNumbers = intNumbers.filter { _ %2== 0 }

//3.显示结果

naturalNumbers.collect程序解析:

res51: Seq[Int] = Buffer(2, 4, 6, 2)reduce

def reduce(fun: (T, T) ⇒ T): DataSet[T]

def reduce(reducer: ReduceFunction[T]): DataSet[T]

Creates a new DataSet by merging the elements of this DataSet using an associative reduce function.

根据一定的条件和方式来合并DataSet。执行程序:

//Int类型的DataSet做reduce

val a: DataSet[Int] = benv.fromElements(2,5,9,8,7,3)

val b: DataSet[Int] = a.reduce { _ + _ }

b.collect

//String类型的DataSet做reduce

val a: DataSet[String] = benv.fromElements("zhangsan boy", " lisi girl")

val b:DataSet[String] = a.reduce { _ + _ }

b.collect程序解析:

//1.创建一个 DataSet其元素为Int类型

Scala-Flink> val a: DataSet[Int] = benv.fromElements(2,5,9,8,7,3)

a: org.apache.flink.api.scala.DataSet[Int] = org.apache.flink.api.scala.DataSet@c7ac49c

//2.将DataSet中的元素,reduce起来

Scala-Flink> val b: DataSet[Int] = a.reduce { _ + _ }

b: org.apache.flink.api.scala.DataSet[Int] = org.apache.flink.api.scala.DataSet@487bc869

//3.显示计算结果

Scala-Flink> b.collect

res6: Seq[Int] = Buffer(34)

//1.创建一个 DataSet其元素为String类型

Scala-Flink> val a: DataSet[String] = benv.fromElements("zhangsan boy", " lisi girl")

a: org.apache.flink.api.scala.DataSet[String] = org.apache.flink.api.scala.DataSet@67426220

//2.将DataSet中的元素,reduce起来

Scala-Flink> val b:DataSet[String] = a.reduce { _ + _ }

b: org.apache.flink.api.scala.DataSet[String] = org.apache.flink.api.scala.DataSet@762d65de

//3.显示计算结果

Scala-Flink> b.collect

res8: Seq[String] = Buffer(zhangsan boy lisi girl)