hadoop完全分布式基础上搭建spark集群

此部分内容是建立在前面的hadoop集群搭建基础之上的,具体参考:centos7+hadoop2.8.0+VMware搭建完全分布式集群,但是要注意的是因为后面重新搭建了一次hadoop,用的jdk版本改成了jdk1.8.0_171,所以在安装时要注意统一!

步骤

一、在master上安装Spark依赖的Scala并配置环境变量

二、在master上下载和解压缩Spark并配置相关文件

三、将相关文件传送给slave1和slave2节点,配置spark集群

四、启动spark集群并测试

Scala下载链接:https://downloads.lightbend.com/scala/2.11.6/scala-2.11.6.tgz

spark下载链接:http://d3kbcqa49mib13.cloudfront.net/spark-2.1.0-bin-hadoop2.6.tgz

一、在master上安装Spark依赖的Scala并配置环境变量

1.1 在master主机的/opt/hadoop目录下创建文件夹spark,用来存放scala和spark的安装包

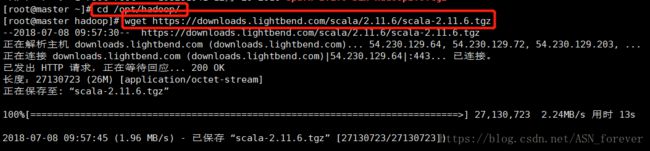

1.2 进入master主机的/opt/hadoop目录,下载scala压缩文件

下载命令:wget https://downloads.lightbend.com/scala/2.11.6/scala-2.11.6.tgz

1.3 解压scala压缩文件,解压命令:tar xvf scala-2.11.6.tgz,并将解压后的文件移动到/opt/hadoop/spark目录下,

命令为:mv scala-2.11.6 /opt/hadoop/spark

1.4 修改profile文件,我的scala安装包路径为/opt/hadoop/spark/scala-2.11.6,因此在/etc/profile文件中添加如下两行内容:

保存后source /etc/profile使其生效

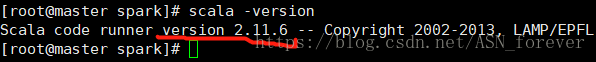

1.5 查看Scala版本:scala -version

二、在master上下载和解压缩Spark并配置相关文件

2.1 与下载scala步骤一样,cd进/opt/hadoop目录下,执行下载命令,然后解压并移动到/opt/hadoop/spark目录下

下载命令:wget http://d3kbcqa49mib13.cloudfront.net/spark-2.1.0-bin-hadoop2.6.tgz

解压命令:tar -zxvf spark-2.1.0-bin-hadoop2.6.tgz

2.2 修改profile并使之生效

在/etc/profile文件中添加如下两行内容,保存后source使其生效

2.3 启动spark-shell交互界面

输入spark-shell命令后大概会出现如下内容,说明spark安装好了,但是要与hadoop关联还需要进一步设置,下面会说

2.4 配置spark-env.sh文件

spark的配置文件所在目录为/opt/hadoop/spark/spark-2.1.0-bin-hadoop2.6/conf/,刚安装完后里面只有一些文件模板,因此要复制模板并重命名

命令为:cp spark-env.sh.template spark-env.sh

编辑spark-env.sh文件,添加如下内容:

export JAVA_HOME=/opt/java/jdk1.8.0_171

export SCALA_HOME=/opt/hadoop/spark/scala-2.11.6

export HADOOP_HOME=/opt/hadoop/hadoop-2.8.0

export HADOOP_CONF_DIR=/opt/hadoop/hadoop-2.8.0/etc/hadoop

export SPARK_MASTER_IP=192.168.89.134

export SPARK_MASTER_HOST=192.168.89.134

export SPARK_MASTER_PORT=7077

export SPARK_LOCAL_IP=192.168.89.134//后面传送完spark到各个节点后,这个地方要改成各个节点自己的ip

export SPARK_WORKER_MEMORY=1g

export SPARK_WORKER_CORES=2

export SPARK_HOME=/opt/hadoop/spark/spark-2.1.0-bin-hadoop2.6

export SPARK_DIST_CLASSPATH=$(/opt/hadoop/hadoop-2.8.0/bin/hadoop classpath)jdk1.8.0_171

export SCALA_HOME=/opt/hadoop/spark/scala-2.11.6

export HADOOP_HOME=/opt/hadoop/hadoop-2.8.0

export HADOOP_CONF_DIR=/opt/hadoop/hadoop-2.8.0/etc/hadoop

export SPARK_MASTER_IP=192.168.89.134

export SPARK_MASTER_HOST=192.168.89.134

export SPARK_MASTER_PORT=7077

export SPARK_LOCAL_IP=192.168.89.134//后面传送完spark到各个节点后,这个地方要改成各个节点自己的ip

export SPARK_WORKER_MEMORY=1g

export SPARK_WORKER_CORES=2

export SPARK_HOME=/opt/hadoop/spark/spark-2.1.0-bin-hadoop2.6

export SPARK_DIST_CLASSPATH=$(/opt/hadoop/hadoop-2.8.0/bin/hadoop classpath)

2.5 配置slaves文件

执行命令:cp slaves.template slaves

修改slaves文件,注释或删除掉localhost,然后添加节点名

三、将相关文件传送给slave1和slave2节点,配置spark集群

3.1 压缩spark文件夹,并传送给slave1和slave2节点

spark文件夹存放的是scala和spark安装包,并在上一节做好了配置,因此可以直接将其压缩后发送到各节点

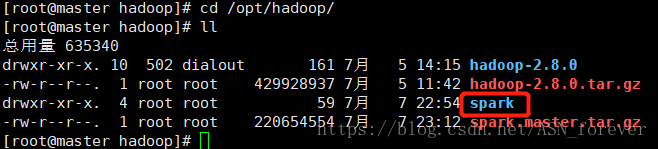

首先压缩在spark文件夹,在/opt/hadoop/目录下执行命令:tar -zcf ./spark.master.tar.gz ./spark

然后执行命令将压缩文件传送到各个节点:

[root@master hadoop]#scp ./spark.master.tar.gz slave1:/opt/hadoop

[root@master hadoop]#scp ./spark.master.tar.gz slave2:/opt/hadoop

3.2 在slave1和slave2中分别解压缩spark文件夹

在两个节点中执行命令:

[root@master hadoop]# tar -zxf /opt/hadoop/spark.master.tar.gz -C /opt/hadoop

此时会发现/opt/hadoop目录下多了spark文件夹

(注意:需要在各节点修改spark-env.sh文件的export SPARK_LOCAL_IP的值为各自的ip)

至此,hadoop+spark分布式集群搭建完成

四、启动spark集群并测试

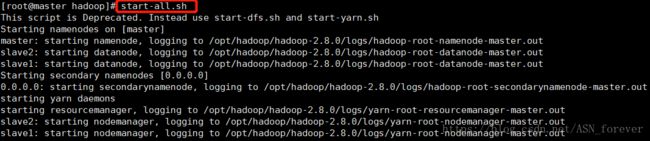

4.1 启动Hadoop集群

启动Spark集群前,要先启动Hadoop集群,在Master节点上运行如下命令启动hadoop集群:

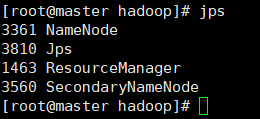

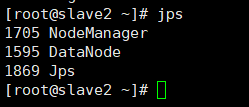

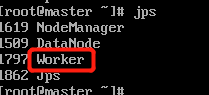

分别在master和slave中运行jps,查看进程启动情况

master

slave1

slave2

说明hadoop集群启动成功

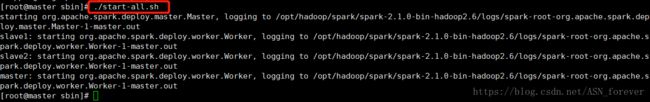

4.2 启动spark集群

进入/opt/hadoop/spark/spark-2.1.0-bin-hadoop2.6/sbin,执行命令./start-all.sh,启动集群。

(注意,一定要加“./”,要不然会启动hadoop的start-all.sh命令)

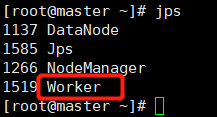

启动完成后,再次在master和slave节点执行jps查看进程,发现多了master和worker进程

master

slave1

slave2

最后在浏览器中访问http://192.168.89.134:8080/,可以看到集群信息,至此spark集群搭建完成!

最后,发现一个比较好的博客,大数据人工智能方面的,可以学习:http://www.cnblogs.com/zlslch/