Spark广播变量和累加器详解

一、概述

在spark程序中,当一个传递给Spark操作(例如map和reduce)的函数在远程节点上面运行时,Spark操作实际上操作的是这个函数所用变量的一个独立副本。这些变量会被复制到每台机器上,并且这些变量在远程机器上的所有更新都不会传递回驱动程序。通常跨任务的读写变量是低效的,但是,Spark还是为两种常见的使用模式提供了两种有限的共享变量:广播变(broadcast variable)和累加器(accumulator)

二、广播变量broadcast variable

2.1 为什么要将变量定义成广播变量?

如果我们要在分布式计算里面分发大对象,例如:字典,集合,黑白名单等,这个都会由Driver端进行分发,一般来讲,如果这个变量不是广播变量,那么每个task就会分发一份,这在task数目十分多的情况下Driver的带宽会成为系统的瓶颈,而且会大量消耗task服务器上的资源,如果将这个变量声明为广播变量,那么在每个executor拥有一份变量副本,这个executor启动的所有的task会共享这个变量,节省了通信的成本和服务器的资源。

2.2 广播变量图解

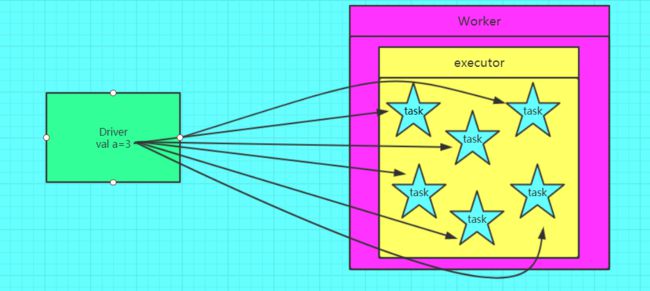

如果不使用广播变量在Executor中有多少task就有多少Driver端的变量副本:

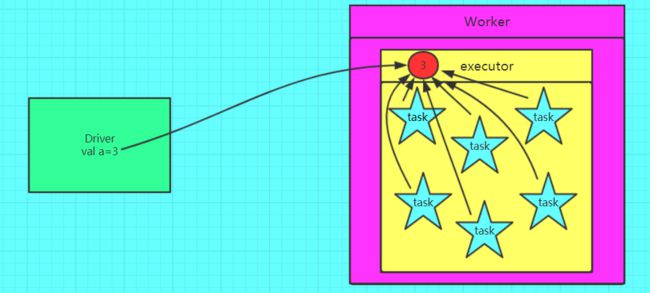

正使用广播变量,在每个Executor中只有一份Driver端的变量副本:

2.3 如何定义一个广播变量?

1.调用SparkContext.broadcast方法创建一个Broadcast[T]对象。 任何序列化的类型都可以这么实现。

2.通过value属性访问改对象的值(Java之中为value()方法)

3.变量只会被发送到各个节点一次,应作为只读值处理(修改这个值不会影响到别的节点)val a = 3

val broadcast = sc.broadcast(a)

2.4 如何还原一个广播变量?

val c = broadcast.value

2.5 定义广播变量需要的注意点?

变量一旦被定义为一个广播变量,那么这个变量只能读,不能修改

2.6 注意事项

1、能不能将一个RDD使用广播变量广播出去?

不能,因为RDD是不存储数据的。可以将RDD的结果广播出去。

2、 广播变量只能在Driver端定义,不能在Executor端定义。

3、 在Driver端可以修改广播变量的值,在Executor端无法修改广播变量的值。

4、如果executor端用到了Driver的变量,如果不使用广播变量在Executor中有多少task就有多少Driver端的变量副本。

5、如果Executor端用到了Driver的变量,如果使用广播变量在每个Executor中只有一份Driver端的变量副本。

2.7 广播变量代码

val conf = new SparkConf()

conf.setMaster("local").setAppName("brocast")

val sc = new SparkContext(conf)

val list = List("hello xasxt")

val broadCast = sc.broadcast(list)

val lineRDD = sc.textFile("./words.txt")

lineRDD.filter { x => broadCast.value.contains(x) }.foreach { println}

sc.stop()

三、累加器

3.1 为什么要将一个变量定义为一个累加器?

在spark应用程序中,我们经常会有这样的需求,如异常监控,调试,记录符合某特性的数据的数目,这种需求都需要用到计数器,如果一个变量不被声明为一个累加器,那么它将在被改变时不会在driver端进行全局汇总,即在分布式运行时在每个task上运行的只是原始变量的一个副本,并不能改变原始变量的值,但是当这个变量被声明为累加器后,该变量就会有分布式计数的功能。

3.2 图解累加器

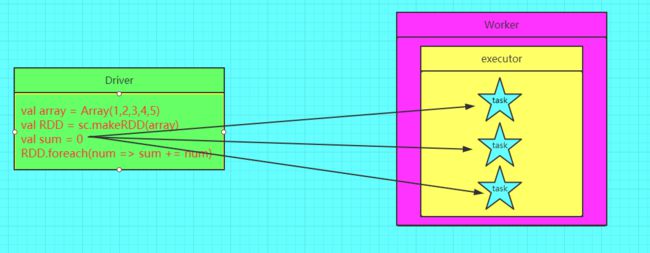

错误的使用方式:

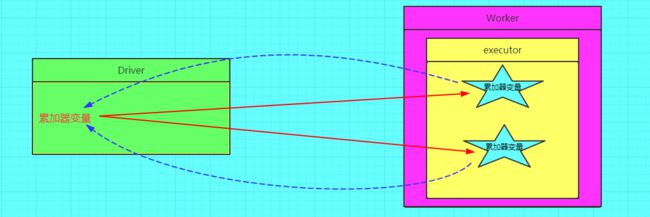

正确的使用方式:

3.3 如何定义一个累加器?

val a = sc.accumulator(0)

3.4 如何还原一个累加器?

val b = a.value

3.5 注意事项

1、 累加器在Driver端定义赋初始值,累加器只能在Driver端读取最后的值,在Excutor端更新。

2、累加器不是一个调优的操作,因为如果不这样做,结果是错的

4.代码

package com.Streaming

import java.util

import org.apache.spark.streaming.{Duration, StreamingContext}

import org.apache.spark.{Accumulable, Accumulator, SparkContext, SparkConf}

import org.apache.spark.broadcast.Broadcast

/**

* Created by lxh on 2016/6/30.

*/

object BroadcastAccumulatorStreaming {

/**

* 声明一个广播和累加器!

*/

private var broadcastList:Broadcast[List[String]] = _

private var accumulator:Accumulator[Int] = _

def main(args: Array[String]) {

val sparkConf = new SparkConf().setMaster("local[4]").setAppName("broadcasttest")

val sc = new SparkContext(sparkConf)

/**

* duration是ms

*/

val ssc = new StreamingContext(sc,Duration(2000))

// broadcastList = ssc.sparkContext.broadcast(util.Arrays.asList("Hadoop","Spark"))

broadcastList = ssc.sparkContext.broadcast(List("Hadoop","Spark"))

accumulator= ssc.sparkContext.accumulator(0,"broadcasttest")

/**

* 获取数据!

*/

val lines = ssc.socketTextStream("localhost",9999)

/**

* 1.flatmap把行分割成词。

* 2.map把词变成tuple(word,1)

* 3.reducebykey累加value

* (4.sortBykey排名)

* 4.进行过滤。 value是否在累加器中。

* 5.打印显示。

*/

val words = lines.flatMap(line => line.split(" "))

val wordpair = words.map(word => (word,1))

wordpair.filter(record => {broadcastList.value.contains(record._1)})

val pair = wordpair.reduceByKey(_+_)

/**

* 这个pair 是PairDStream

* 查看这个id是否在黑名单中,如果是的话,累加器就+1

*/

/* pair.foreachRDD(rdd => {

rdd.filter(record => {

if (broadcastList.value.contains(record._1)) {

accumulator.add(1)

return true

} else {

return false

}

})

})*/

val filtedpair = pair.filter(record => {

if (broadcastList.value.contains(record._1)) {

accumulator.add(record._2)

true

} else {

false

}

}).print

println("累加器的值"+accumulator.value)

// pair.filter(record => {broadcastList.value.contains(record._1)})

/* val keypair = pair.map(pair => (pair._2,pair._1))*/

/**

* 如果DStream自己没有某个算子操作。就通过转化transform!

*/

/* keypair.transform(rdd => {

rdd.sortByKey(false)//TODO

})*/

pair.print()

ssc.start()

ssc.awaitTermination()

}

}