统计学习方法-第二章课后习题答案整理

2.1Minsky和Papert指出:

感知机因为是线性模型,

所以不能表示复杂的函数,如异或。

验证感知机为什么不能表示异或

参考链接:

https://blog.csdn.net/yangfeisc/article/details/45486067

2.2,换下数据即可,具体代码实现参考:

https://blog.csdn.net/appleyuchi/article/details/82928881

2.3

样本集线性可分的充分必要条件是:

正实例点集构成的凸壳与负实例点集所构成的凸壳互不相交

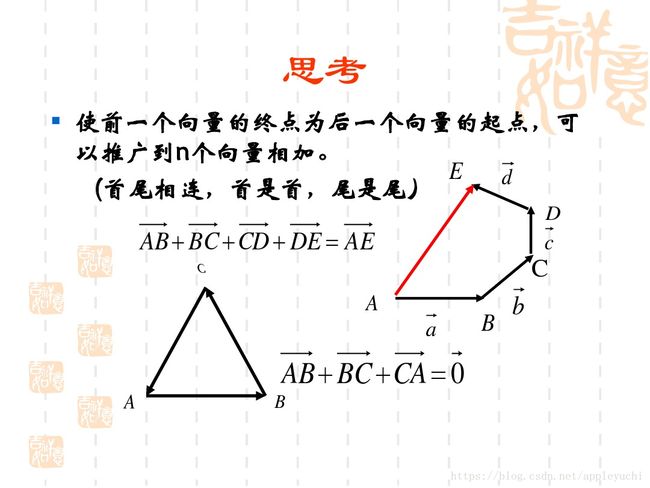

首先是概念:

这里的凸壳≠凸集。

“相交”的意思是:一个样本点,既属于凸壳A,也属于凸壳B,

也就是说,某个样本点同时满足两个集合的约束条件。

凸壳到底是一个什么鬼?????

看下面的初中数学课件回顾一下:

证明如下:

必要性:线性可分->凸壳不相交

设数据集T中的正例点集为 S + S_{+} S+,

S + S_{+} S+的凸壳为 c o n v ( S + ) conv(S_{+}) conv(S+),

负实例点集为 S − S_{-} S−,

S − S_{-} S−的凸壳为 c o n v ( S − ) conv(S_{-}) conv(S−),

若T是线性可分的,则存在一个超平面: w ⋅ x + b = 0 w\cdot x +b =0 w⋅x+b=0能够将 S + S_{+} S+和 S − S_{-} S−

完全分离。

假设对于所有的正例点 x i x_{i} xi,有:

w ⋅ x i + b = ε i w\cdot x_{i}+b=\varepsilon_{i} w⋅xi+b=εi易知 ε i > 0 , i = 1 , 2 , ⋯ , ∣ S + ∣ \varepsilon_{i}>0,i=1,2,\cdots,|S_{+}| εi>0,i=1,2,⋯,∣S+∣。

若 c o n v ( S + ) conv(S_{+}) conv(S+)和 c o n v ( S − ) conv(S_{-}) conv(S−)相交,即存在某个元素s,

同时满足 s ∈ c o n v ( S + ) 和 s ∈ c o n v ( S − ) s\in{conv(S_{+})}和s\in{conv(S_{-})} s∈conv(S+)和s∈conv(S−)。

对于 c o n v ( S + ) conv(S_{+}) conv(S+)中的元素 s + s^{+} s+

有 w ⋅ s + = w ⋅ ∑ i = 1 k λ i x i = ∑ i = 1 k λ i ( ε i − b ) = ∑ i = 1 k ( λ i ε i − b λ i ) w\cdot s^{+}=w\cdot \sum^{k}_{i=1}\lambda_{i}x_{i}=\sum^{k}_{i=1}\lambda_{i}(\varepsilon_{i}-b)=\sum^{k}_{i=1}(\lambda_{i}\varepsilon_{i}-b\lambda_{i}) w⋅s+=w⋅i=1∑kλixi=i=1∑kλi(εi−b)=i=1∑k(λiεi−bλi)

注意,这里因为凸壳(convex hull)的性质,有:

∑ i = 1 k λ i = 1 \sum_{i=1}^{k}\lambda_{i}=1 ∑i=1kλi=1

所以上面的结果是:

∑ i = 1 k ( λ i ε i ) − b \sum^{k}_{i=1}(\lambda_{i}\varepsilon_{i})-b i=1∑k(λiεi)−b

因此 w ⋅ s + + b = ∑ i = 1 k λ i ε i > 0 w\cdot s^{+}+b=\sum^{k}_{i=1}\lambda_{i}\varepsilon_{i}>0 w⋅s++b=∑i=1kλiεi>0,

同理对于 S − S_{-} S−中的元素 s − s^{-} s−有

w ⋅ s − + b = ∑ i = 1 k λ i ε i < 0 w\cdot s^{-}+b=\sum^{k}_{i=1}\lambda_{i}\varepsilon_{i}<0 w⋅s−+b=∑i=1kλiεi<0,

线性可分条件下,假设两个凸壳相交,那么存在样本点s同时满足

s ∈ c o n v ( S + ) s\in{conv(S_{+})} s∈conv(S+)且 s ∈ c o n v ( S − ) s\in{conv(S_{-})} s∈conv(S−)

则 w ⋅ s + + b = w ⋅ s + b = ∑ i = 1 k λ i ε i > 0 ① w\cdot s^{+}+b=w\cdot s+b=\sum^{k}_{i=1}\lambda_{i}\varepsilon_{i}>0① w⋅s++b=w⋅s+b=∑i=1kλiεi>0①

且 w ⋅ s − + b = w ⋅ s + b = ∑ i = 1 k λ i ε i > 0 ② w\cdot s^{-}+b=w\cdot s+b=\sum^{k}_{i=1}\lambda_{i}\varepsilon_{i}>0② w⋅s−+b=w⋅s+b=∑i=1kλiεi>0②

②违反了假设的前提:线性可分。

因为线性可分时,必须有②<0

所以假设不成立,因此 c o n v ( S + ) conv(S_{+}) conv(S+)和 c o n v ( S − ) conv(S_{-}) conv(S−)必不相交

从而推出必要性:线性可分->凸壳不相交

充分性:凸壳不相交->线性可分

设数据集T中的正例点集为 S + , S + S_{+},S_{+} S+,S+的凸壳为 c o n v ( S + ) conv(S_{+}) conv(S+),负实例点集为 S − , S − S_{-},S_{-} S−,S−的凸壳为 c o n v ( S − ) , 且 c o n v ( S + ) 与 c o n v ( S − ) conv(S_{-}),且conv(S_{+})与conv(S_{-}) conv(S−),且conv(S+)与conv(S−)不相交,

定义两个点 x 1 , x 2 x_{1},x_{2} x1,x2的距离为

d i s t ( x 1 , x 2 ) = ∣ ∣ x 1 − x 2 ∣ ∣ 2 = ( x 1 − x 2 ) ⋅ ( x 1 − x 2 ) dist(x_{1},x_{2})=||x_{1}-x_{2}||_{2}=\sqrt {(x_{1}-x_{2})\cdot (x_{1}-x_{2})} dist(x1,x2)=∣∣x1−x2∣∣2=(x1−x2)⋅(x1−x2)

定义 c o n v ( S + ) 与 c o n v ( S − ) conv(S_{+})与conv(S_{-}) conv(S+)与conv(S−)的距离为,

d i s t ( c o n v ( S + ) , c o n v ( S − ) ) = min ∣ ∣ s + − s − ∣ ∣ , s + ∈ c o n v ( S + ) , s − ∈ c o n v ( S − ) dist(conv(S_{+}),conv(S_{-}))= \min||s_{+}-s_{-}||, s_{+}\in conv(S_{+}),s_{-}\in conv(S_{-}) dist(conv(S+),conv(S−))=min∣∣s+−s−∣∣,s+∈conv(S+),s−∈conv(S−)

设 x + ∈ c o n v ( S + ) , x − ∈ c o n v ( S − ) x_{+}\in conv(S_{+}),x_{-}\in conv(S_{-}) x+∈conv(S+),x−∈conv(S−)且 d i s t ( x + , x − ) = d i s t ( c o n v ( S + ) , c o n v ( S − ) ) dist(x_{+},x_{-})=dist(conv(S_{+}),conv(S_{-})) dist(x+,x−)=dist(conv(S+),conv(S−))。

则对于任意正例点x有 d i s t ( x , x − ) ≥ d i s t ( x + , x − ) dist(x,x_{-})\geq dist(x_{+},x_{-}) dist(x,x−)≥dist(x+,x−)。

注意,这里的 ( x + , x − ) (x_{+},x_{-}) (x+,x−)是用来代表 S + S_{+} S+和 S − S_{-} S−最近距离的两个点。

同理,对于所有的负例点x有 d i s t ( x , x + ) ≥ d i s t ( x , x − ) dist(x,x_{+})\geq dist(x,x_{-}) dist(x,x+)≥dist(x,x−)。

存在超平面 w ⋅ x + b = 0 w\cdot x+b=0 w⋅x+b=0其中

w = x + − x − w=x_{+}-x_{-} w=x+−x−

b = − x + ⋅ x + − x − ⋅ x − 2 b=-\frac{x_{+}\cdot x_{+} - x_{-}\cdot x_{-}}{2} b=−2x+⋅x+−x−⋅x−

(以上就是两个技巧)

则对于所有的正例点x(易知 w ⋅ x + + b > 0 w·x_{+} +b>0 w⋅x++b>0,因此若 x + x_{+} x+属于正例点,则令 x + ≠ x x_{+}\neq x x+̸=x),

w ⋅ x + b w\cdot x +b w⋅x+b

= ( x + − x − ) ⋅ x − x + ⋅ x + − x − ⋅ x − 2 =(x_{+}-x_{-})\cdot x-\frac{x_{+}\cdot x_{+} - x_{-}\cdot x_{-}}{2} =(x+−x−)⋅x−2x+⋅x+−x−⋅x−

= x + ⋅ x − x − ⋅ x − x + ⋅ x + − x − ⋅ x − 2 =x_{+}\cdot x -x_{-}\cdot x - \frac{x_{+}\cdot x_{+}-x_{-}\cdot x_{-}}{2} =x+⋅x−x−⋅x−2x+⋅x+−x−⋅x−

= ∣ ∣ x − − x ∣ ∣ 2 2 − ∣ ∣ x + − x ∣ ∣ 2 2 2 =\frac{||x_{-}-x||_{2}^{2}-||x_{+}-x||_{2}^{2}}{2} =2∣∣x−−x∣∣22−∣∣x+−x∣∣22

= d i s t ( x , x − ) 2 − d i s t ( x , x + ) 2 2 =\frac{dist(x,x_{-})^2-dist(x,x_{+})^2}{2} =2dist(x,x−)2−dist(x,x+)2

(这里我觉得不用搞得跟下面一样麻烦,只要分别在两个凸壳中各自取一个点,就能说明上面的式子的符号想相反的了,然后就得证了。)

若 d i s t ( x , x − ) ≤ d i s t ( x , x + ) dist(x,x_{-})\leq dist(x,x_{+}) dist(x,x−)≤dist(x,x+),

则 d i s t ( x , x − ) ≤ d i s t ( x , x + ) ≤ d i s t ( x − , x + ) dist(x,x_{-})\leq dist(x,x_{+}) \leq dist(x_{-},x_{+}) dist(x,x−)≤dist(x,x+)≤dist(x−,x+),

那么 d i s t ( S + , S − ) < d i s t ( x + , x − ) dist(S_{+},S_{-})< dist(x_{+},x_{-}) dist(S+,S−)<dist(x+,x−)(注:证明过程见下方),

推出矛盾。

因此对所有的正例点, w ⋅ x + b > 0 w·x +b >0 w⋅x+b>0成立。

同理,对所有的负例点, w ⋅ x + b < 0 w·x +b <0 w⋅x+b<0成立。

至此,充分性:凸壳不相交->线性可分

补充:用反正法证明 d i s t ( x , x − ) > d i s t ( x , x + ) dist(x,x_{-})> dist(x,x_{+}) dist(x,x−)>dist(x,x+)

证明:若 d i s t ( x , x − ) ≤ d i s t ( x , x + ) dist(x,x_{-})\leq dist(x,x_{+}) dist(x,x−)≤dist(x,x+),

则存在 t = ( x − − x + ) ⋅ ( x − x + ) ∣ ∣ x − x + ∣ ∣ 2 2 t=\frac{(x_{-}-x_{+})\cdot (x-x_{+})}{||x-x_{+}||_{2}^{2}} t=∣∣x−x+∣∣22(x−−x+)⋅(x−x+),

令 x ′ = t x + ( 1 − t ) x + x^{'}=tx+(1-t)x_{+} x′=tx+(1−t)x+,则 ( x − − x ′ ) ⋅ ( x + − x ) = 0 (x_{-}-x^{'})· (x_{+}-x)=0 (x−−x′)⋅(x+−x)=0。

易知 t ≤ 1 t\leq 1 t≤1先证明0

由上文知 d i s t ( x , x + ) ≥ d i s t ( x , x − ) ≥ d i s t ( x − , x + ) dist(x,x_{+})\geq dist(x,x_{-})\geq dist(x_{-},x_{+}) dist(x,x+)≥dist(x,x−)≥dist(x−,x+)

根据三角形的大边对应大角这一特性,很容易可以看出

$x_{+}-x与x_{+}-x_{-}之间的夹角小于90度,

因此t>0。

那么

d i s t ( x ′ , x − ) < d i s t ( x + , x − ) dist(x^{'},x_{-})<dist(x_{+},x_{-}) dist(x′,x−)<dist(x+,x−),

又因为 x ′ x^{'} x′必在 c o n v ( S + ) conv(S_{+}) conv(S+)内部,

所以推出矛盾。

本文来自 蓝色骨头零号 的CSDN 博客 ,全文地址请点击:https://blog.csdn.net/y954877035/article/details/52210734?utm_source=copy