聊聊Focal Loss及其反向传播

Focal Loss: Focal Loss for Dense Object Detection 论文链接:https://arxiv.org/abs/1708.02002

我们都知道,当前的目标检测(Objece Detection)算法主要分为两大类:two-stage detector和one-stage detector。two-stage detector主要包括rcnn、fast-rcnn、faster-rcnn和rfcn等,one-stage detector主要包括yolo和ssd等,前者精度高但检测速度较慢,后者精度低些但速度很快。

对于two-stage detector而言,通常先由RPN生成proposals,再由RCNN对proposals进行Classifcation和Bounding Box Regression。这样做的一个好处是有利于样本和模型之间的feature alignment,从而使Classification和Bounding Box Regression更容易些;此外,RPN和RCNN中存在正负样本不均衡的问题,RPN直接限制正负样本的比例为1:1,对于固定的rpn_batch_size,正样本不足的情况下才用负样本来填充,RCNN则是直接限制了正负样本的比例为1:3或者采用OHEM。

对于one-stage detector而言,样本和模型之间的feature alignment只能通过reception field来实现,且直接通过回归方式进行预测,存在这严重的正负样本数据不均衡(1:1000)的问题,负样本的比例过高,占据了loss的绝大部分,且大多数是容易分类的,这使得模型的训练朝着不希望的方向前进。作者认为这种数据的严重不均衡是造成one-stage detector精度低的主要原因,因此提出Focal Loss来解决这一问题。

通过人工控制正负样本比例或者OHEM能够一定程度解决数据不均衡问题,但这两种方法都比较粗暴,采用这种“一刀切”的方式有可能把一些hard examples忽略掉。因此,作者提出了一种新的损失函数Focal Loss,不忽略任何样本,同时又能让模型训练时更加专注在hard examples上。简单说明下Focal loss的原理。

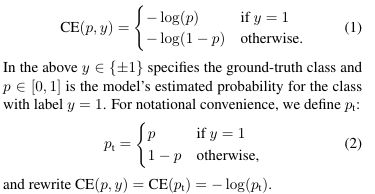

Focal Loss是在标准的交叉熵损失的基础上改进而来。以二分类为例,标准的交叉熵损失函数为

针对类别不均衡,针对对不同类别对loss的贡献进行控制即可,也就是加一个控制权重αt,那么改进后的balanced cross entropy loss为

但是balanced cross entropy loss没办法让训练时专注在hard examples上。实际上,样本的正确分类概率pt越大,那么往往说明这个样本越易分。所以,最终的Focal Loss为

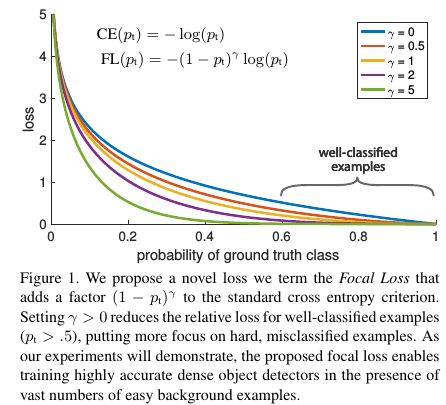

Focal Loss存在这两个超参数(hyperparameter),不同的αt和γ,对于的loss如Figure 1所示。从Figure 4, 我们可以看到γ的变化对正(forground)样本的累积误差的影响并不大,但是对于负(background)样本的累积误差的影响还是很大的(γ=2时,将近99%的background样本的损失都非常小)。

接下来看下实验结果,为了验证Focal Loss,作者提出了一种新的one-stage detector架构RetinaNet,采用的是resnet_fpn,同时scales增加到15个,如Figure 3所示

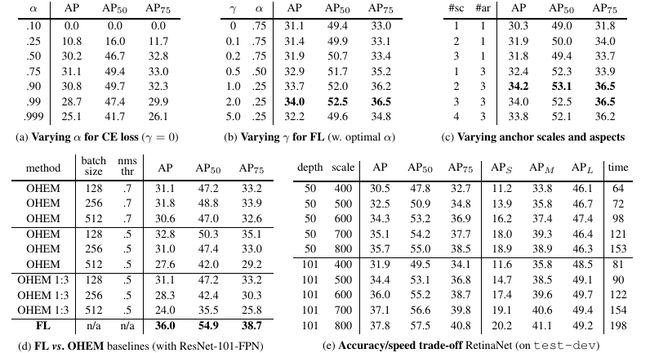

Table 1给出了RetinaNet和Focal Loss的一些实验结果,从中我们看出增加α-类别均衡,AP提高了0.9,再增加了γ控制,AP达到了37.8.Focal Local相比于OHEM,AP提高了3.2。从Table 2可以看出,增加训练时间并采用scale jitter,AP最终那达到39.1。

Focal Loss的原理分析和实验结果至此结束了,那么,我们接下来看下Focal Loss的反向传播。首先给出Softmax Activation的反向梯度传播公式,为

有了Softmax Activation的反向梯度传播公式,根据链式法则,Focal Loss的反向梯度传播公式为

总结:Focal Loss主要用于解决数据不均衡问题,可以看做是OHEM算法的延伸。作者是将Focal Loss用于one-stage detector,但实际上这种解决数据不均衡的方法对于two-stage detector来讲同样有效。

相关链接:

Focal Loss

Focal Loss论文阅读笔记

手打例子一步一步带你看懂softmax函数以及相关求导过程

如何评价kaiming的Focal Loss for Dense Object Detection?