Python爬虫入门笔记:urllib库的使用

上次我们说到网页下载是爬虫的重要部分,并提到几种实用的下载器模块,今天我们先说urlib库的使用,这个是Python官方基础模块,具体相关细节知识,大家可以自行去了解,这里我们只说主要的使用方法:

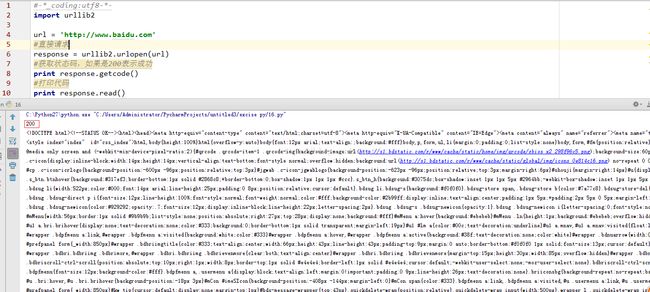

1、直接访问

import urllib2

url = 'http://www.baidu.com'

#直接请求

response = urllib2.urlopen(url)

#获取状态码,如果是200表示成功

print response.getcode()

#打印代码

print response.read()2、构造request,这是比较规范的格式,有时需要传送数据,建议这么写

import urllib2

url = 'http://www.baidu.com'

#创建request对象

request = urllib2.Request(url)

#发送请求

response = urllib2.urlopen(request)

#获取状态码,如果是200表示成功

print response.getcode()

#打印代码

print response.read()3、headers验证,不是所有的URL可以直接访问的,比如糗事百科

import urllib2

url = 'http://www.qiushibaike.com'

request = urllib2.Request(url)

response = urllib2.urlopen(request)

print response.getcode()raise BadStatusLine(line)

httplib.BadStatusLine: ''

这是因为该网站不支持程序访问,我们可以模拟浏览器访问,添加headers验证

import urllib2

url = 'http://www.qiushibaike.com/hot/page/1'

#设置请求身份agent

user_agent = 'Mozilla/4.0 (compatible; MSIE 5.5; Windows NT)'

#添加headers

headers = {'User-Agent' : user_agent}

request = urllib2.Request(url,headers = headers)

response = urllib2.urlopen(request)

print response.getcode()

print response.read()另外,我们还有对付”反盗链”的方式,对付防盗链,服务器会识别headers中的referer是不是它自己,如果不是,有的服务器不会响应,所以我们还可以在headers中加入referer

headers = { 'User-Agent' : 'Mozilla/4.0 (compatible; MSIE 5.5; Windows NT)' ,

'Referer':'http://www.zhihu.com/articles' } 4、Proxy的设置,urllib2 默认会使用环境变量 http_proxy 来设置 HTTP Proxy。假如一个网站它会检测某一段时间某个IP 的访问次数,如果访问次数过多,它会禁止你的访问。所以你可以设置一些代理服务器来帮助你做工作,每隔一段时间换一个代理,来防止被禁止访问。

下面一段代码说明了代理的设置用法

import urllib2

enable_proxy = True

proxy_handler = urllib2.ProxyHandler({"http" : 'http://some-proxy.com:8080'})

null_proxy_handler = urllib2.ProxyHandler({})

if enable_proxy:

opener = urllib2.build_opener(proxy_handler)

else:

opener = urllib2.build_opener(null_proxy_handler)

urllib2.install_opener(opener)