Tensorflow的迭代次数到底应该设为多少?

用Tensorflow设计神经网络需要固定一个迭代次数,比如做minst数据集迭代次数可以设置为20000,但问题是为什么不能设置为30000或者20万?

在《学习率对神经网络的影响-乙烷,乙烯,乙炔的分子模型试验数据对比》中得到了一个公式

Y是输出比如0.5081

X就是迭代次数

如果把学习率加到这个方式里面

Y=(-k*ln(x*r2/r1))+b

K,b都是常数可以由已知数值代出来,r1=0.1 ,r2是学习率

并得到图像

表明迭代次数X对神经网络的输出Y影响巨大,所以迭代次数应该是决定神经网络性能的一个几乎是决定性的因素。

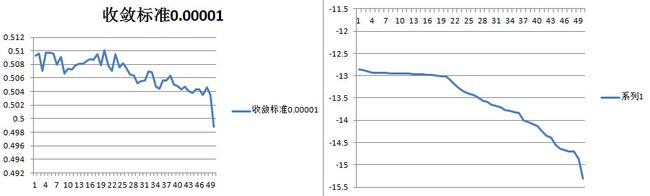

本文用乙烯状的网络对不同的收敛标准做了实验

While(Math.abs(h-s))<0.0001---s1

While(Math.abs(h-s))<0.00001---s2

While(Math.abs(h-s))<0.000001---s3

得到图像

可以看到随着收敛标准越发苛刻网络性能表现的越平稳越可预期,同时网络的输出Y与迭代得数-ln(x)高度相关。

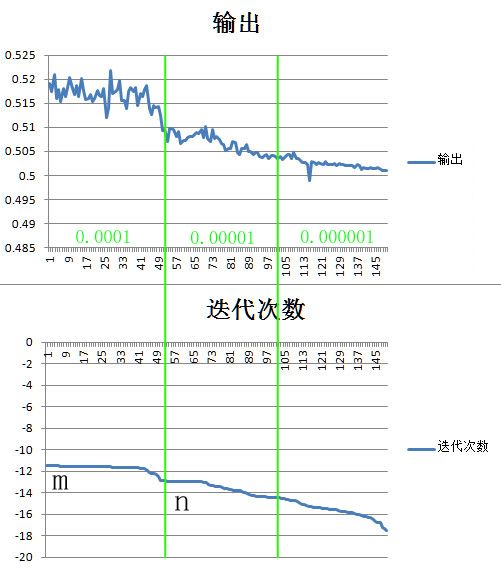

将三幅图组合到一起

可以看到收敛标准的改变是可以改变网络的特征输出的,由此可以得出对于特定输入,特定结构,特定收敛标准的网络的输出是特征的。

如果把输出曲线近似的看成是一条直线,由公式

Y=(-k*ln(x*r2/r1))+b------1

可以很容易的计算若是收敛标准改变网络的特征输出大概是多少

比如当收敛标准s1=0.0001时的

边界第50个点的值-ln(x)=n,左边界第一个点-ln(x)=m

则当s1改变为s2时网络的特征输出Yt就是

Yt=[n+(n-m) *(2*log(s1/s2)-1)/2] *k+b---------2

从这两个公式和图片可以看出学习率r使输出曲线上下波动,收敛标准s使输出曲线左右波动。

同时这条曲线越往右稳定性越强可预期性越强,越往左波动性越大随机性越大、所以设定TensorFlow的 迭代次数可以根据网络的输出曲线将迭代次数设定在10^-5或者10^-6区间,这样可以保证网络的总体性能更加稳定可预期,否则如果设定在10^-4区间对于这个网络是9.5万-26万之间,由于对于特定区间的输出是特定的,所以无论用多么小的学习率都不会改变图像的形态,只是用了更多的迭代次数,无论把学习率调到多小对于这个网络只要迭代次数在9.5-26万之间都是剧烈波动高度随机不可预期的。

如果把迭代次数设在10^-6区间对于这个网络是38-445万之间,网络的性能就会稳定的多。

*** ***

后经大量实验证实神经网络输出值与迭代次数之间的关系在收敛标准,学习率,权重初始化方式固定的情况下更接近

输出值=系数a*ln(迭代次数)

y=a.ln(n)

将收敛精度由0.1提高到0.01迭代次数翻53倍,由0.01提高到0.001要翻94倍,

对于大型的网络可以先测低收敛精度的迭代次数再通过比例放大去估算所需精度的可能收敛迭代次数。

固定收敛标准的神经网络的收敛迭代次数像物理上的半衰期,测量基数足够大时规律会更明显。

在2018年11月16日 《收敛标准对迭代次数影响》里面有详细的数据

*** ***

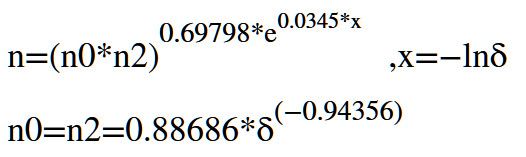

在2018年12月29日《神经网络收敛标准与准确率之间的数学关系》

得到了对应一个带卷积核分类0和2的网络,迭代次数n,收敛标准δ,神经网络的准确率p-max之间的一组数学表达式

可用于推算对应准确率p-max小于0.995时需要的迭代次数和时间。

具体数据。

(为了加快速度这个程序与《学习率对神经网络的影响-乙烷,乙烯,乙炔的分子模型试验数据对比》中的程序有区别,特征值不一样,但只影响k和b的值,趋势是一样的)

| 输出 | 迭代次数 | |||

| 1 | 0.519145 | 95384 | 1 | -11.4657 |

| 1 | 0.517366 | 95519 | 2 | -11.4671 |

| 1 | 0.521007 | 96570 | 3 | -11.478 |

| 1 | 0.515995 | 97237 | 4 | -11.4849 |

| 1 | 0.51779 | 97860 | 5 | -11.4913 |

| 1 | 0.515367 | 98687 | 6 | -11.4997 |

| 1 | 0.518125 | 101388 | 7 | -11.5267 |

| 1 | 0.51642 | 101713 | 8 | -11.5299 |

| 1 | 0.518258 | 101792 | 9 | -11.5307 |

| 1 | 0.520261 | 102643 | 10 | -11.539 |

| 1 | 0.518114 | 102968 | 11 | -11.5422 |

| 1 | 0.516798 | 102969 | 12 | -11.5422 |

| 1 | 0.518629 | 103839 | 13 | -11.5506 |

| 1 | 0.51629 | 104245 | 14 | -11.5545 |

| 1 | 0.520042 | 104468 | 15 | -11.5566 |

| 1 | 0.517567 | 104778 | 16 | -11.5596 |

| 1 | 0.515846 | 104799 | 17 | -11.5598 |

| 1 | 0.515865 | 105221 | 18 | -11.5638 |

| 1 | 0.516792 | 106761 | 19 | -11.5783 |

| 1 | 0.515333 | 106895 | 20 | -11.5796 |

| 1 | 0.515982 | 107135 | 21 | -11.5818 |

| 1 | 0.517728 | 107504 | 22 | -11.5853 |

| 1 | 0.51667 | 108496 | 23 | -11.5945 |

| 1 | 0.516331 | 109355 | 24 | -11.6024 |

| 1 | 0.518111 | 109615 | 25 | -11.6047 |

| 1 | 0.511998 | 109718 | 26 | -11.6057 |

| 1 | 0.514129 | 109733 | 27 | -11.6058 |

| 1 | 0.521731 | 109916 | 28 | -11.6075 |

| 1 | 0.516926 | 110223 | 29 | -11.6103 |

| 1 | 0.5175 | 112450 | 30 | -11.6303 |

| 1 | 0.517877 | 112839 | 31 | -11.6337 |

| 1 | 0.519691 | 113231 | 32 | -11.6372 |

| 1 | 0.515625 | 113565 | 33 | -11.6401 |

| 1 | 0.515639 | 113917 | 34 | -11.6432 |

| 1 | 0.513849 | 115053 | 35 | -11.6531 |

| 1 | 0.517363 | 115481 | 36 | -11.6569 |

| 1 | 0.518278 | 116278 | 37 | -11.6637 |

| 1 | 0.517469 | 116522 | 38 | -11.6658 |

| 1 | 0.518217 | 116953 | 39 | -11.6695 |

| 1 | 0.51451 | 117781 | 40 | -11.6766 |

| 1 | 0.51699 | 121418 | 41 | -11.707 |

| 1 | 0.516391 | 123261 | 42 | -11.7221 |

| 1 | 0.517829 | 126865 | 43 | -11.7509 |

| 1 | 0.518721 | 130235 | 44 | -11.7771 |

| 1 | 0.513979 | 149211 | 45 | -11.9131 |

| 1 | 0.512571 | 186448 | 46 | -12.1359 |

| 1 | 0.51454 | 196496 | 47 | -12.1884 |

| 1 | 0.514146 | 209615 | 48 | -12.253 |

| 1 | 0.51422 | 223214 | 49 | -12.3159 |

| 1 | 0.512343 | 263827 | 50 | -12.483 |

| 2 | 0.509299 | 385070 | 1 | -12.8612 |

| 2 | 0.509587 | 390133 | 2 | -12.8742 |

| 2 | 0.5071 | 401371 | 3 | -12.9026 |

| 2 | 0.509743 | 414714 | 4 | -12.9353 |

| 2 | 0.509687 | 414834 | 5 | -12.9356 |

| 2 | 0.509612 | 416680 | 6 | -12.9401 |

| 2 | 0.508023 | 417546 | 7 | -12.9421 |

| 2 | 0.509075 | 418182 | 8 | -12.9437 |

| 2 | 0.506652 | 418547 | 9 | -12.9445 |

| 2 | 0.507339 | 420637 | 10 | -12.9495 |

| 2 | 0.50732 | 422469 | 11 | -12.9539 |

| 2 | 0.507837 | 424256 | 12 | -12.9581 |

| 2 | 0.508078 | 425987 | 13 | -12.9622 |

| 2 | 0.508132 | 428399 | 14 | -12.9678 |

| 2 | 0.508504 | 430053 | 15 | -12.9717 |

| 2 | 0.508837 | 431846 | 16 | -12.9758 |

| 2 | 0.508694 | 432445 | 17 | -12.9772 |

| 2 | 0.50948 | 440847 | 18 | -12.9965 |

| 2 | 0.50791 | 444696 | 19 | -13.0051 |

| 2 | 0.510156 | 450407 | 20 | -13.0179 |

| 2 | 0.50776 | 481205 | 21 | -13.084 |

| 2 | 0.507055 | 543345 | 22 | -13.2055 |

| 2 | 0.509497 | 593743 | 23 | -13.2942 |

| 2 | 0.5076 | 624993 | 24 | -13.3455 |

| 2 | 0.508141 | 656326 | 25 | -13.3944 |

| 2 | 0.50747 | 680281 | 26 | -13.4303 |

| 2 | 0.506559 | 710591 | 27 | -13.4739 |

| 2 | 0.506336 | 769857 | 28 | -13.554 |

| 2 | 0.505188 | 792498 | 29 | -13.5829 |

| 2 | 0.505506 | 848075 | 30 | -13.6507 |

| 2 | 0.505668 | 877413 | 31 | -13.6847 |

| 2 | 0.506971 | 894319 | 32 | -13.7038 |

| 2 | 0.50687 | 959986 | 33 | -13.7747 |

| 2 | 0.504709 | 971492 | 34 | -13.7866 |

| 2 | 0.50443 | 998693 | 35 | -13.8142 |

| 2 | 0.505614 | 1015744 | 36 | -13.8311 |

| 2 | 0.505651 | 1200156 | 37 | -13.998 |

| 2 | 0.506365 | 1239126 | 38 | -14.0299 |

| 2 | 0.505056 | 1311868 | 39 | -14.087 |

| 2 | 0.504861 | 1367832 | 40 | -14.1287 |

| 2 | 0.504283 | 1515202 | 41 | -14.2311 |

| 3 | 0.504684 | 1523758 | 1 | -14.2367 |

| 2 | 0.504715 | 1704787 | 42 | -14.349 |

| 3 | 0.503862 | 1730914 | 2 | -14.3642 |

| 3 | 0.503662 | 1759525 | 3 | -14.3806 |

| 2 | 0.504092 | 1773853 | 43 | -14.3887 |

| 3 | 0.504362 | 1797641 | 4 | -14.402 |

| 3 | 0.503497 | 1807224 | 5 | -14.4073 |

| 3 | 0.504222 | 1870060 | 6 | -14.4415 |

| 3 | 0.504066 | 1873321 | 7 | -14.4432 |

| 3 | 0.503871 | 1876162 | 8 | -14.4447 |

| 3 | 0.503604 | 1934341 | 9 | -14.4753 |

| 3 | 0.503887 | 1934343 | 10 | -14.4753 |

| 3 | 0.50337 | 2003323 | 11 | -14.5103 |

| 2 | 0.503775 | 2060992 | 44 | -14.5387 |

| 2 | 0.504305 | 2259123 | 45 | -14.6305 |

| 2 | 0.50431 | 2334501 | 46 | -14.6633 |

| 2 | 0.50355 | 2405667 | 47 | -14.6933 |

| 2 | 0.504655 | 2421855 | 48 | -14.7 |

| 3 | 0.503417 | 2426453 | 12 | -14.7019 |

| 2 | 0.503506 | 2866216 | 49 | -14.8685 |

| 3 | 0.503097 | 3262642 | 13 | -14.998 |

| 3 | 0.50259 | 3542804 | 14 | -15.0804 |

| 3 | 0.502631 | 3764201 | 15 | -15.141 |

| 3 | 0.502326 | 3888634 | 16 | -15.1736 |

| 2 | 0.498833 | 4459034 | 50 | -15.3104 |

| 3 | 0.502975 | 4552828 | 17 | -15.3313 |

| 3 | 0.502596 | 4885742 | 18 | -15.4018 |

| 3 | 0.502206 | 4886907 | 19 | -15.4021 |

| 3 | 0.502656 | 4964395 | 20 | -15.4178 |

| 3 | 0.502427 | 5006541 | 21 | -15.4263 |

| 3 | 0.502285 | 5042936 | 22 | -15.4335 |

| 3 | 0.502792 | 5070941 | 23 | -15.439 |

| 3 | 0.502251 | 5092757 | 24 | -15.4433 |

| 3 | 0.502159 | 5690920 | 25 | -15.5544 |

| 3 | 0.502344 | 5738014 | 26 | -15.5626 |

| 3 | 0.502551 | 5759395 | 27 | -15.5663 |

| 3 | 0.50202 | 6010623 | 28 | -15.609 |

| 3 | 0.502503 | 6475722 | 29 | -15.6836 |

| 3 | 0.502298 | 6757249 | 30 | -15.7261 |

| 3 | 0.502295 | 6917842 | 31 | -15.7496 |

| 3 | 0.502142 | 7257896 | 32 | -15.7976 |

| 3 | 0.501999 | 7391528 | 33 | -15.8158 |

| 3 | 0.501976 | 7612727 | 34 | -15.8453 |

| 3 | 0.502034 | 7616080 | 35 | -15.8458 |

| 3 | 0.50155 | 8236494 | 36 | -15.9241 |

| 3 | 0.502199 | 8860897 | 37 | -15.9972 |

| 3 | 0.501999 | 9483846 | 38 | -16.0651 |

| 3 | 0.501278 | 10538303 | 39 | -16.1705 |

| 3 | 0.50167 | 11221105 | 40 | -16.2333 |

| 3 | 0.50148 | 11471397 | 41 | -16.2554 |

| 3 | 0.501467 | 11804481 | 42 | -16.284 |

| 3 | 0.501606 | 12425605 | 43 | -16.3353 |

| 3 | 0.501417 | 15025228 | 44 | -16.5252 |

| 3 | 0.5015 | 17329778 | 45 | -16.6679 |

| 3 | 0.501611 | 19010209 | 46 | -16.7605 |

| 3 | 0.50145 | 19645397 | 47 | -16.7934 |

| 3 | 0.501081 | 30562878 | 48 | -17.2353 |

| 3 | 0.50101 | 33547749 | 49 | -17.3285 |

| 3 | 0.500982 | 40156426 | 50 | -17.5083 |