深度学习框架TensorFlow学习与应用(一)——基本概念与简单示例

TensorFlow基本概念

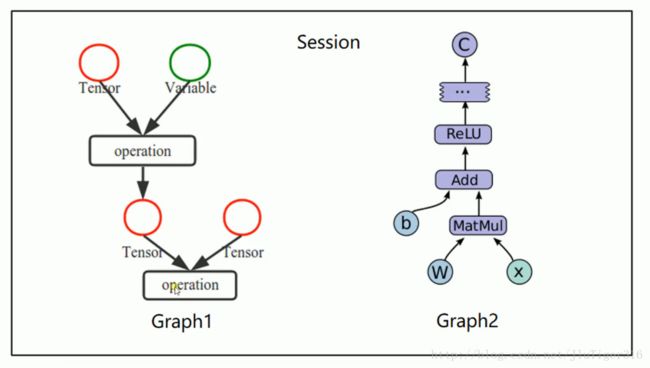

- 使用图(graphs)来表示计算任务

- 在被称之为会话(Session)的上下文(context)中执行图

- 使用tensor表示数据

- 通过变量(Variable)维护状态

- 使用feed和fetch可以为任意的操作赋值或者从其中获取数据

TensorFlow是一个编程系统,使用图(graphs)来表示计算任务,图(graphs)中的节点称之为op(operation),一个op获得0个或多个Tensor,执行计算,产生0个或多个Tensor。Tensor看作是一个n维的数组或列表。图必须在会话(Session)里被启动。

TensorFlow结构

创建图,启动图

import tensorflow as tf

#创建一个常量op

m1 = tf.constant([[3,3]])

#创建一个常量op

m2 = tf.constant([[2],[3]])

#创建一个矩阵乘法op,把m1和m2传入

product = tf.matmul(m1,m2)

print(product)直接print会出现:

Tensor(“MatMul_1:0”, shape=(1, 1), dtype=int32)这是因为图必须在会话中执行。

所以继续:

#定义一个会话,启动默认图

sess=tf.Session()

#调用sess的run方法来执行矩阵乘法op

#run(product)触发了图中3个op

result=sess.run(product)

print(result)

sess.close()得到结果:

[[15]]

也可以使用(就可以不用.close):

with tf.Session() as sess:

#调用sess的run方法来执行矩阵乘法op

#run(product)触发了图中3个op

result=sess.run(product)

print(result)变量

#1.

import tensorflow as tf

x=tf.Variable([1,2])

a=tf.constant([3,3])

#增加一个减法op

sub=tf.subtract(x,a)

#增加一个加法op

add=tf.add(x,sub)

#初始化所有变量

init=tf.global_variables_initializer()

with tf.Session() as sess:

sess.run(init)#变量初始化操作

print(sess.run(sub))

print(sess.run(add))得到:

[-2 -1]

[-1 1]

#2.

#创建一个变量初始化为零

state=tf.Variable(0,name='counter')

#创建一个op,作用是使state加1

new_value=tf.add(state,1)

#赋值op

update=tf.assign(state,new_value)

#变量初始化

init=tf.global_variables_initializer()

with tf.Session() as sess:

sess.run(init)

print(sess.run(state))

for _ in range(5):

sess.run(update)

print(sess.run(state))得到:

0

1

2

3

4

5

Fetch and Feed

import tensorflow as tf

#Fetch 可以同时运行多个op

input1=tf.constant(3.0)

input2=tf.constant(2.0)

input3=tf.constant(5.0)

add=tf.add(input2,input3)

mul=tf.multiply(input1,add)

with tf.Session() as sess:

result=sess.run([mul,add])#运行两个op

print(result)得到:

[21.0, 7.0]

#Feed

#创建占位符

input1=tf.placeholder(tf.float32)

input2=tf.placeholder(tf.float32)

output=tf.multiply(input1,input2)

with tf.Session() as sess:

#feed的数据以字典的形式传入

print(sess.run(output,feed_dict={input1:[7.0],input2:[2.0]}))得到:

[ 14.]

TensorFlow简单示例

import tensorflow as tf

import numpy as np

#使用numpy生成100个随机点

x_data=np.random.rand(100)

y_data=x_data*0.1+0.2

#构建一个线性模型

b=tf.Variable(0.)

k=tf.Variable(0.)

y=k*x_data+b

#二次代价函数

loss=tf.reduce_mean(tf.square(y_data-y))#误差的平方再求平均值

#定义一个梯度下降法来进行训练的优化器

optimizer=tf.train.GradientDescentOptimizer(0.2)#学习率设置为0.2

#最小化代价函数

train=optimizer.minimize(loss)

init=tf.global_variables_initializer()

with tf.Session() as sess:

sess.run(init)

for step in range(201):#迭代201次

sess.run(train)

if step%20 ==0:#每20次打印出来数据

print(step,sess.run([k,b]))结果:

0 [0.053385686, 0.10005315]

20 [0.10320079, 0.19828629]

40 [0.10191195, 0.1989764]

60 [0.10114207, 0.19938858]

80 [0.10068219, 0.19963478]

100 [0.10040749, 0.19978184]

120 [0.1002434, 0.19986968]

140 [0.10014539, 0.19992216]

160 [0.10008686, 0.1999535]

180 [0.10005189, 0.19997223]

200 [0.10003098, 0.19998342]