今天分享:

(1)目前最好的用于文本摘要的RNN模型;

(2)讨论 softmax 与 sigmoid 之间的关系;

(3)利用 TensorFlow 进行文本分类的框架设计;

(4)多语言词向量的融合;

(5)基于路径信息的 LSTM 编码;

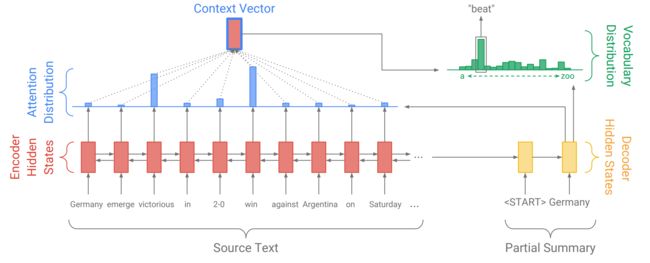

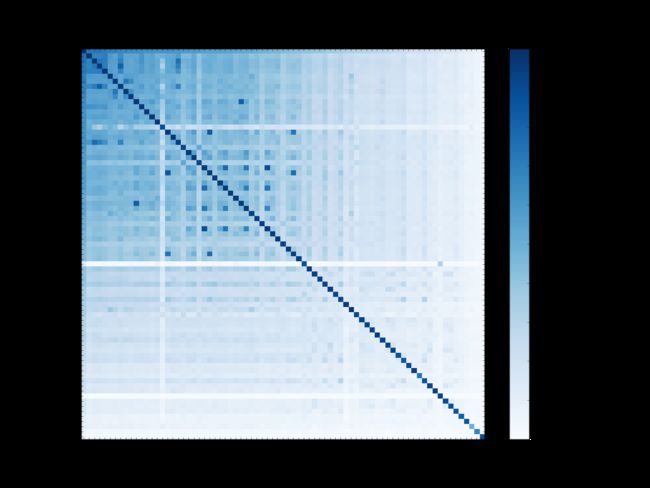

1.【博客】Taming Recurrent Neural Networks for Better Summarization

简介:

这是一篇关于我们最新论文 Get To The Point: Summarization with Pointer-Generator Networks 的一个简单介绍,该论文奖出现在 ACL 2017.

互联网时代已经将无数大量的信息带到了我们的身边,如果我们有很多的时间阅读它们,那么这将是一个很大的优势。但是我们并没有那么多的时间,所以经常会感到困惑。因此,自动文本摘要 - 将文本自动缩小为较短版本的任务正变得越来越重要。

本论文提出的模型优于目前的模型。

原文链接:http://www.abigailsee.com/2017/04/16/taming-rnns-for-better-summarization.html

2.【博客】Deriving the Softmax from First Principles

简介:

这个文章的最初目的是讨论 softmax 与 sigmoid 函数之间的关系。事实上,两者之间的关系很难去整理归纳。因此,这篇文章首先讨论了 sigmoid 是 softmax 的特殊情况,以及 Gibbs 分布,因子模型和概率图模型中的每一个基础。接下来,我们再讨论这个模型如何自然地扩展,以及定义,如 softmax 回归,条件随机字段,朴素贝叶斯和隐马尔可夫模型。

原文链接:http://willwolf.io/2017/04/19/deriving-the-softmax-from-first-principles/

3.【博客】Big Picture Machine Learning: Classifying Text with Neural Networks and TensorFlow

原文链接:

在这篇文章中,我们将学习如何设计一个机器学习模型去做文本分类任务,具体的步骤如下:

- How TensorFlow works

- What is a machine learning model

- What is a Neural Network

- How the Neural Network learns

- How to manipulate data and pass it to the Neural Network inputs

- How to run the model and get the prediction results

你会学习很多的新东西哦,一起来吧!

原文链接:https://medium.freecodecamp.com/big-picture-machine-learning-classifying-text-with-neural-networks-and-tensorflow-d94036ac2274

4.【代码】fastText_multilingual

简介:

fasttext 推出78种语言的混合词向量。

原文链接:https://github.com/Babylonpartners/fastText_multilingual

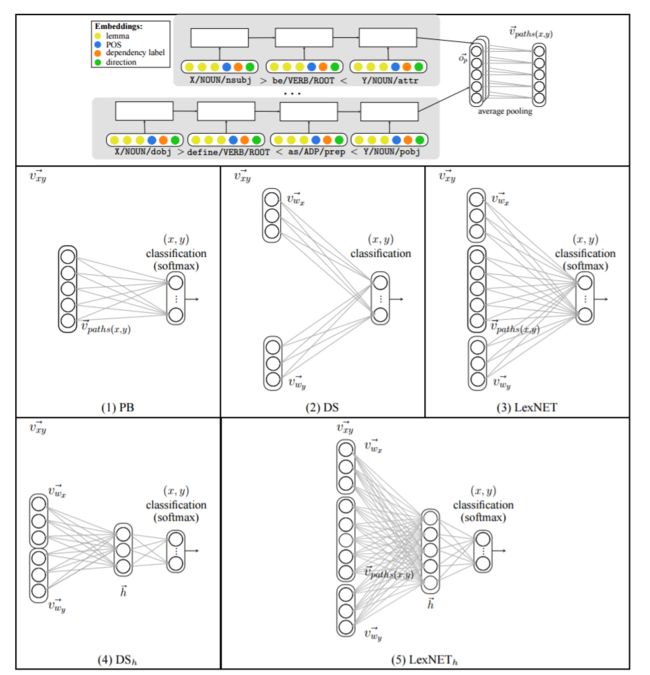

5.【代码】LexNET: Integrated Path-based and Distributional Method for Lexical Semantic Relation Classification

简介:

LexNET是用于术语对之间的语义关系进行分类的开源框架。它使用每个术语的分布信息,以及使用基于路径信息的LSTM编码。

原文链接:https://github.com/vered1986/LexNET