【论文笔记】DenseNet

介绍

卷积神经网络(CNNs)已成为视觉物体识别领域占据主导的机器学习方法。虽然訪方法最初于20年前提出,但直到最近由于硬件性能和网络结构上的改善才真正意义上实现深层的CNNs训练。

随着CNNs层次越来越深,新的问题随之出现。输入信息或者说梯度当经过众多层到达网络底端后会消失。这篇论文提出了一种新的连接模式:为最大化网络之间的信息流动,我们将网络中的每一层与其它层直接相连。每一层都从它之前的所有层中接收额外的输入,并将訪层的输出(feature-maps)传递给其后的所有层中。

DenseNets

- ResNets

传统的卷积前馈网络,第l次的输出作为(l+1)层的输入,訪过程可以用以下公式表述。

残差网络(ResNets)增加了一个跳跃连接(skip-connection),从而旁路非线性转换层。

- Dense connectivity

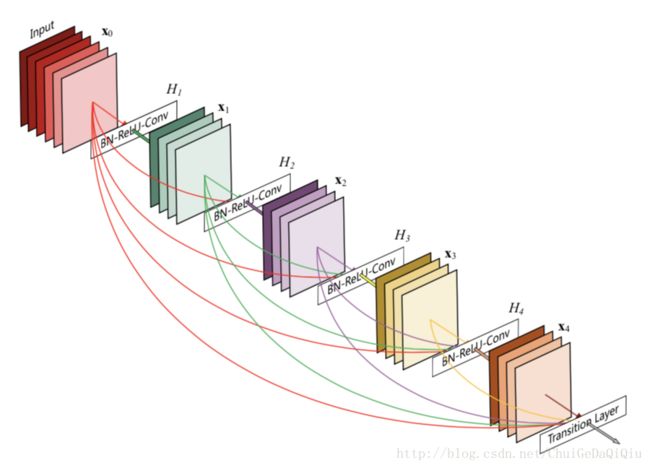

为进一步增加网络层之间的信息流动,我们提出了一种新的连接形式:将每一层与其后续层直连。

也就是说第l层会从它之前的所有层中接受feature-maps,公式表示如下:

Xl是表示第l层的输入,[x0,x1,...]表示将第0,1..(l-1)层的feature-maps进行组合。

- Composite function

回到上面的公式,这不还有一个Hl么,它是一复合函数。包含三个连续的操作:BN + ReLU + Conv(3x3)。

- Pooling layers

公式中的X0,X1...X(l-1)要能够拼接,则必需保证X0,X1..X(l-1)的大小是一样的。卷积神经网络中的一大核心部件就是降采样层,它能改变feature-maps的大小。为便于实现降采样,将DenseNet分解成由多个稠密块(dense blocks)连接的网络。块与块之间的网络层称之为转换层(transition layers),它将作卷积和池化的操作。在DenseNet中,转换层包含一个BN(batch normalization)层,一个1x1卷积层和一个2x2的平均池化层。

dense block的实现可参考以下代码。

def bn_act_conv_drp(current, num_outputs, kernel_size, scope='block'):

current = slim.batch_norm(current, scope=scope + '_bn')

current = tf.nn.relu(current)

current = slim.conv2d(current, num_outputs, kernel_size, scope=scope + '_conv')

current = slim.dropout(current, scope=scope + '_dropout')

return current

def block(net, layers, growth, scope='block'):

for idx in range(layers):

"""

BN-ReLU-Conv(1x1)-BN-ReLU-Conv(3x3)

"""

bottleneck = bn_act_conv_drp(net, 4 * growth, [1, 1],

scope=scope + '_conv1x1' + str(idx))

tmp = bn_act_conv_drp(bottleneck, growth, [3, 3],

scope=scope + '_conv3x3' + str(idx))

net = tf.concat(axis=3, values=[net, tmp])

return net- Growth rate

假设每个Hl产生k个feature-maps,那么第l层的输入feature-maps数为:k0 + k*(l-1),k0为输入层通道数。DenseNet和其它网络结构相比一个重要的区别就是它的层数非常的少,例如:k = 12。k作为一个超参数,我们将其称之为网络的增长率(growth rate)。实验表明一个较小的增长率就可以取得极好的结果。

- Bottleneck layers

虽然每一层只产生k个feature-maps,但是输入信息会越来越多。相关文献研究指出在每个3x3的卷积层之前引入一个1x1的卷积层作为瓶颈层可以提高计算效率。我们发现这个设计对于DenseNet来说特别有效。因此,在DenseNet中我们也引入了这样一个瓶颈层:BN-ReLU-Conv(1x1)-BN-ReLU-Conv(3x3)。由此形成的网络结构我们称之为DenseNet-B。

- Compression

为进一步提高网络的紧密度,我们可以在转换层(transition layers)减少feature-maps的数量。我们引入一个压缩因子,当输入feature-maps数为m时,输出为![]() 。压缩因子小于1的DenseNet我们称为DenseNet-C。

。压缩因子小于1的DenseNet我们称为DenseNet-C。

- Implementation Details

除ImageNet这个数据集以外,我们实验所用的DenseNet含有3个dense blocks,每个dense block包含相同的层数。进入第一个dense block之前,对于输入图像做一个输出通道数为16(对于DenseNet-BC,为增长率的2倍)的卷积操作。对于所有卷积层,卷积核的大小为3x3,对输入做一个1像素的0填充以保证feature-map大小固定。转换层我们使用一个1x1的卷积加上一个2x2的平均池化。在最后一个dense block之后做一个全局池化,其输出进入softmax分类器。在3个dense block中feature-map的大小分别为32x32,16x16和8x8。对于基本的DenseNet,配置为{L=40,k=12},{L=100,k=12},{L=100,k=24}。而DenseNet-BC,配置为{L=100,k=12},{L=250,k=24}和{L=190,k=40}。

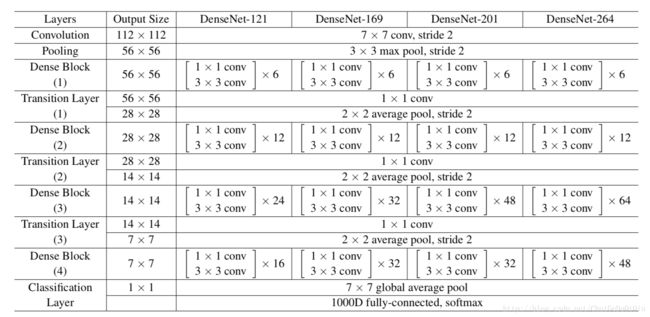

ImageNet数据集使用了DenseNet-BC,含4个dense block。初始卷积层2k个大小为为7x7,步长为2的卷积。详细配置参数见下表。