- SQL条件判断语句嵌套window子句的应用【易错点】--HiveSql面试题25

莫叫石榴姐

SQLBOY1000题sqlHiveSql面试题sql

目录0需求分析1数据准备3数据分析4小结0需求分析需求:表如下user_idgood_namegoods_typerk1hadoop1011hive1221sqoop2631hbase1041spark1351flink2661kafka1471oozie108以上数据中,goods_type列,假设26代表是广告,现在有个需求,想获取每个用户每次搜索下非广告类型的商品位置自然排序,如果下效果:u

- HiveSQL——条件判断语句嵌套windows子句的应用

爱吃辣条byte

#HIveSQL大数据数据仓库

注:参考文章:SQL条件判断语句嵌套window子句的应用【易错点】--HiveSql面试题25_sql剁成嵌套判断-CSDN博客文章浏览阅读920次,点赞4次,收藏4次。0需求分析需求:表如下user_idgood_namegoods_typerk1hadoop1011hive1221sqoop2631hbase1041spark1351flink2661kafka1471oozie108以上数

- 6月11日第二十八次早课(sqoop)

ly稻草

1.sqoop是什么?主要用于在Hadoop与RDBMS间进行数据的传递2.sqoop分为哪两个分支,各最新版本是什么?sqoop1:1.4.7sqoop2:1.99.73.在工作中我们用的最多的是sqoop1,那么导入和导出,谁给谁的导入是RDBMS到Hadoop导出是Hadoop到RDBMS4.假如输入一个命令找不到notfound,你们觉得该怎么办?(老生常谈)先看打错了没有,再看PATH有

- sqoop 安装与使用

麦香鸡翅

hadoop

sqoop安装:安装在一台节点上就可以了。1.上传sqoop2.安装和配置在添加sqoop到环境变量将数据库连接驱动拷贝到$SQOOP_HOME/lib里3.使用第一类:数据库中的数据导入到HDFS上sqoopimport--connectjdbc:mysql://192.168.1.10:3306/itcast--usernameroot--password123--tabletrade_det

- hue集成遇到的问题

101之歌

sqoop报错:Couldnotgetconnectors拷贝sqoop.properties文件至/etc/sqoop2/conf目录sqoop报错:Couldnotstartjob.报错:Couldnotstartjob.exceptionERROR{"message":null,"error-code-class":"org.apache.sqoop.error.code.GenericJd

- sqoop笔记(安装、配置及使用)

小小哭包

大数据sqoop笔记hadoop

sqoop简介----sqoop是一个用来在hadoop体系和关系型数据库之间进行数据互导的工具----实质就是将导入导出命令转换成mapreduce程序来实现sqoop安装:安装在一台节点上就可以了。1.上传sqoop2.安装和配置----修改配置文件sqoop-env.sh#Setpathtowherebin/hadoopisavailableexportHADOOP_COMMON_HOME=

- sqoop安装以及使用(保会)

小枫ov

hadoophdfsmysql

sqoop安装及使用1.上传并解压tar-zxvfsqoop-1.4.6.bin__hadoop-2.0.4-alpha.tar.gz创建软连接Ln-ssqoop............sqoop2.修改配置文件1)切换到sqoop配置文件目录cd/home/hadoop/app/sqoop/conf2)复制配置文件并重命名cpsqoop-env-template.shsqoop-env.sh3)

- 【大数据】Hadoop 生态系统及其组件

G皮T

#Hadoophadoopbigdata大数据hdfshivemapreduceyarn

Hadoop生态系统及其组件1.Hadoop生态系统的组成2.Hadoop生态系统简介2.1HDFS2.2MapReduce2.3YARN2.4Hive2.5Pig2.6HBase2.7HCatalog2.8Avro2.9Thrift2.10Drill2.11Mahout2.12Sqoop2.13Flume2.14Ambari2.15Zookeeper2.16Oozie1.Hadoop生态系统的组

- SQOOP2 使用报错分析与解决

lostar01

大数据hadoopsqoopetl

项目场景:Hadoop版本:3.1.2SQOOP2版本:1.99.7关系型数据库:Mariadb10.3.15项目目的:使用sqoop2进行从关系型数据库导入HDFS中。问题描述:问题一:ExceptionhasoccurredduringprocessingcommandException:org.apache.sqoop.common.SqoopExceptionMessage:GENERIC

- sqoop1.4.7和hadoop的兼容性,sqoop的安装和使用

Cynicism_Kevin

hadoopsqoop

sqoop1.4.7兼容hadoop2.6以上所有版本1下载并解压1)下载地址:http://mirrors.hust.edu.cn/apache/sqoop2)上传安装包sqoop-1.4.7.bin__hadoop-2.6.0.tar.gz到服务器3)解压sqoop安装包tar-zxfsqoop-1.4.7.bin__hadoop-2.6.0.tar.gz4)添加环境变量2修改配置文件1)进入

- Hadoop sqoop

请给我一串代码好吗

hadoopsqoop大数据

0目录1.安装sqoop2.补充sqoop流程1.安装sqoop解压、改名[root@kb129install]#tar-xvf./sqoop-1.4.7.tar.gz-C/opt/soft/[root@kb129soft]#mvsqoop-1.4.7/sqoop147拷贝配置文件[root@kb129conf]#pwd/opt/soft/sqoop147/conf[root@kb129conf]

- sqoop

zdkdchao

sqoophadoophive

一、bg可以在关系型数据库和hdfs、hive、hbase之间导数导入:从RDBMS到hdfs、hive、hbase导出:相反sqoop1和sqoop2(1.99.x)不兼容,sqoop2并没有生产的稳定版本,Sqoop1import原理(导入)从传统数据库获取元数据信息(schema、table、field、fieldtype),把导入功能转换为只有Map的Mapreduce作业,在Mapred

- 大数据ETL工具kettle与sqoop对比分析

tomalun

大数据数据同步kettlesqoop大数据

sqoop有两个版本:sqoop1和sqoop2,sqoop2功能比sqoop强一些,但sqoop2产品不成熟,不适合生产环境使用,且CDH和AmbariHDP都默认集成sqoop1,所以不考虑sqoop2。本文仅比较kettle和sqoop1:对比项KettleSqoop1适用场景数据ETL,简单或复杂的数据抽取、数据转换、数据清洗、数据过滤、数据同步。支持丰富的数据源和数据输出形式,适用于多种

- Hue:Hadoop 图形化用户界面

victory0508

hadoop/hive

Hue是一个能够与ApacheHadoop交互的Web应用程序。一个开源的ApacheHadoopUI。特性:一个HDFS的文件浏览器,一个MapReduce/YARN的Job浏览器,一个HBas的浏览器,Hive,Pig,ClouderaImpala和Sqoop2的查询编辑器。它还附带了一个Oozie的应用程序,用于创建和监控工作流程,一个Zookeeper浏览器和SDK。1.向Hadoop载入

- 2018-06-14 Morning Study — Day031

LY_babc

1.来来来谈谈你们自认为零基础班hive要掌握哪些东西?2.hive的元数据我们存储在哪?数据存储在哪?3.udf函数临时生效和永久生效会不会?4.sqoop是mrjob?5.我们常用的是sqoop1,那么对比sqoop2,这两者区别6.sqoop导入,可以根据SQL导吗?7.(拓展题)sqoop如何全量,如何每天增量导数据到hive(这块你们去调研看看增量)8.提醒各位:sqoop在mysql导

- 数仓4.0(二)------ 业务数据采集平台

JiaXingNashishua

数据库数据仓库hive

目录一:电商业务简介1.1电商业务流程1.2电商常识二:业务数据采集模块2.1安装MySQL及配置2.2业务数据生成2.2.1连接Mysql以及建表2.2.2生成业务数据2.3安装Sqoop2.3.1安装2.3.2修改配置文件2.3.3拷贝JDBC驱动2.3.4验证Sqoop2.3.5测试Sqoop是否能够成功连接数据库2.3.6Sqoop基本使用2.4同步策略2.4.1全量同步策略2.5业务数据

- sqoop2 配置

天堂宝宝_V

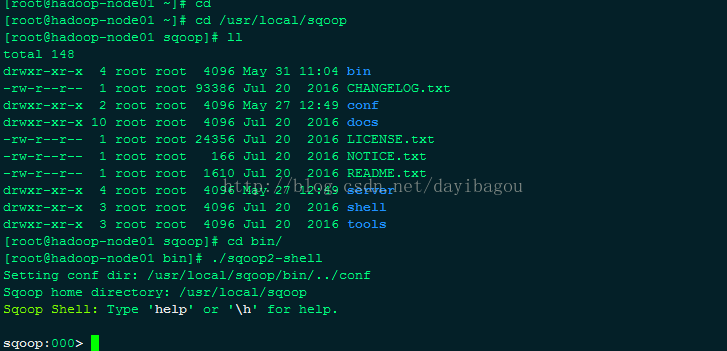

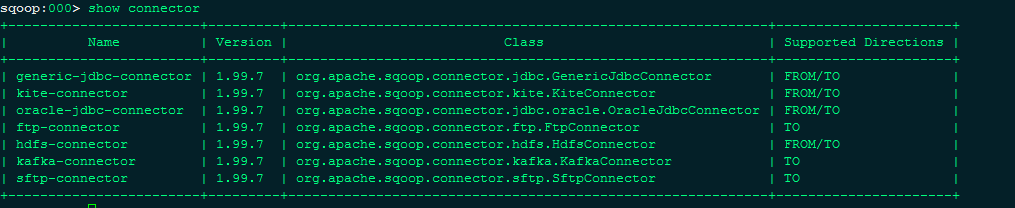

title:sqoop2配置tags:sqoop2,环境配置,1.99.7,官网grammar_cjkRuby:true1Serverinstallationsqoop2官网下载2解压到/usr/tools文件夹下tar-zxvfsqoop-1.99.7-bin-hadoop200.tar.gz-C/usr/tools3HadoopdependenciesIftheenvironment$HADO

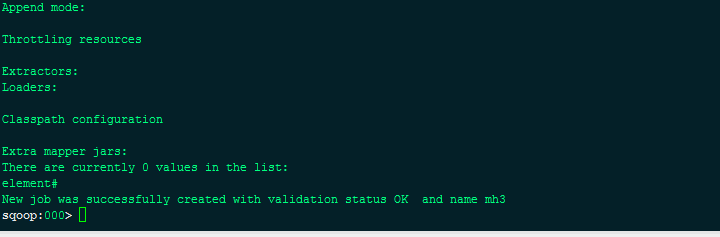

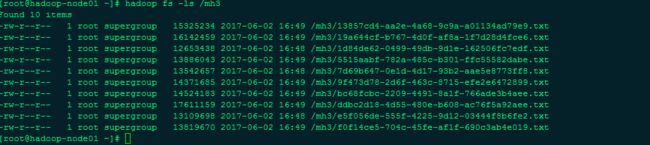

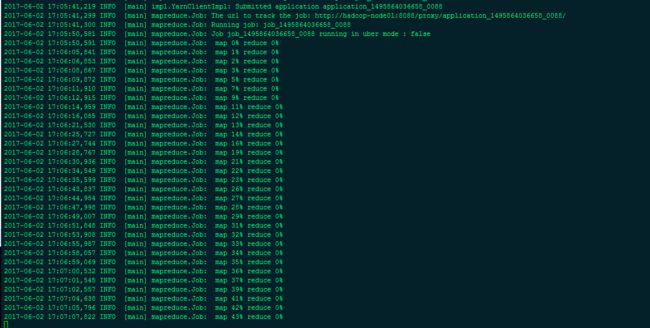

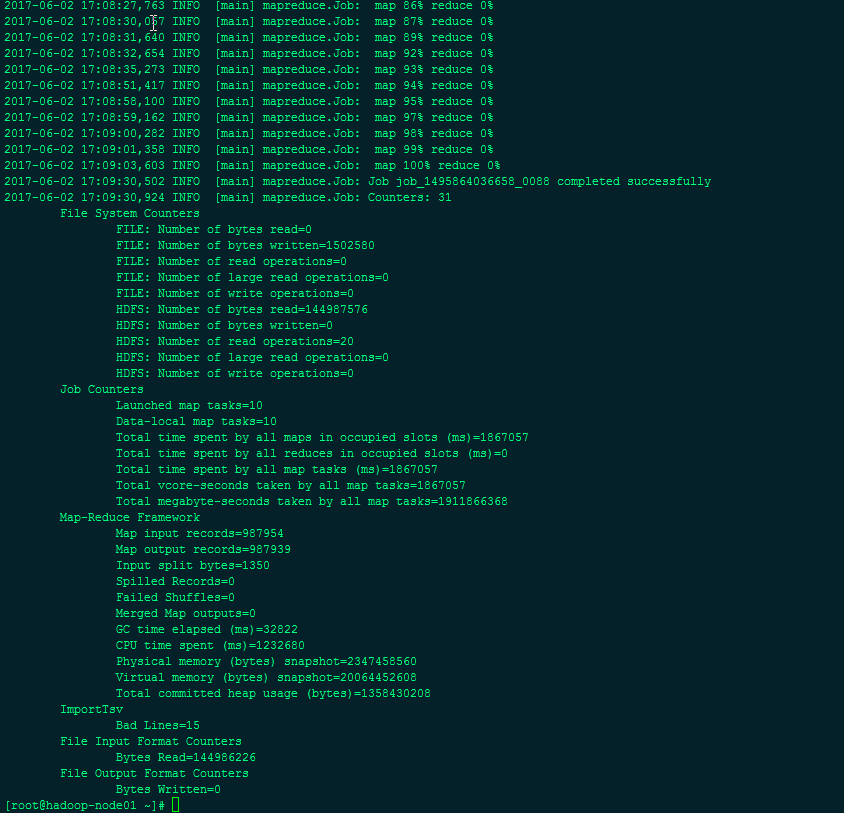

- 教你如何使用FusionInsight SqoopShell

摘要:Sqoop-shell是一个Loader的shell工具,其所有功能都是通过执行脚本“sqoop2-shell”来实现的。本文分享自华为云社区《FusionInsightSqoopShell使用案例》,作者:Jia装大佬。1SqoopShell使用简介sqoop-shell是一个Loader的shell工具,其所有功能都是通过执行脚本“sqoop2-shell”来实现的。sqoop-shel

- sqoop安装部署问题事项

UpdateCw

主要用于在Hadoop(Hive)与传统的数据库(mysql、postgresql...)间进行数据的传递,可以将一个关系型数据库(例如:MySQL,Oracle,Postgres等)中的数据导进到Hadoop的HDFS中,也可以将HDFS的数据导进到关系型数据库中sqoop主要有两个版本:1.4.x、1.99.x;sqoop1和sqoop2两个版本。环境变量配置无问题。【以下问题是1.99.6版

- 如何在 Hue 3.10 中提交 Sqoop1 作业?

大数据之心

前言本来认为这块是很简单的事儿,不想单独记录下来,恐怖的是花了2小时时间才调通(之前踩过的坑又踩了一遍),所以想下还是用记录下来罢。为什么使用Sqoop1而不是Sqoop2?这个,很尴尬,Hue3.10+Sqoop2+SSL一直没有调通,SqoopTransfer界面一直报:Sqooperror:Couldnotgetconnectors,避免耽误进度,所以没有使用。准备工作有两块需要注意,一个是

- 20180614早课记录31-Sqoop

K_un

1.来来来谈谈你们自认为零基础班hive要掌握哪些东西?编译搭建DDLDML动态分区静态分区函数2.hive的元数据我们存储在哪?数据存储在哪?MySQLHDFS3.udf函数临时生效和永久生效会不会?还没具体做4.sqoop是mrjob?是mrjob5.我们常用的是sqoop1,那么对比sqoop2,这两者区别两个不同版本,完全不兼容6.sqoop导入,可以根据SQL导吗?可以7.(拓展题)sq

- 20180611早课记录28-Sqoop

K_un

1.sqoop是什么?主要用于在Hadoop与RDBMS间进行数据的传递2.sqoop分为哪两个分支,各最新版本是什么?sqoop1:1.4.7sqoop2:1.99.73.在工作中我们用的最多的是sqoop1,那么导入和导出,谁给谁的导入是RDBMS到Hadoop导出是Hadoop到RDBMS4.假如输入一个命令找不到notfound,你们觉得该怎么办?(老生常谈)先看打错了没有,再看PATH有

- Sqoop Learn Use

楠风

sqoop

1.1Sqoop简介sqoop即SQLtoHadoop,是一款方便的在传统关系数据库与Hadoop之间进行数据迁移的工具,充分利用MapReduce并行特点以批处理的方式加快数据传输,发展至今主要演化了二大版本,sqoop1和sqoop2。sqoop:clouder公司开发生产背景mysql导入HadoopHadoop导入mysql注:以上Hadoop指Hive、HBase、HDFS等1.2Sqo

- Sqoop Learn Use

楠风

sqoop

1.1Sqoop简介sqoop即SQLtoHadoop,是一款方便的在传统关系数据库与Hadoop之间进行数据迁移的工具,充分利用MapReduce并行特点以批处理的方式加快数据传输,发展至今主要演化了二大版本,sqoop1和sqoop2。sqoop:clouder公司开发生产背景mysql导入HadoopHadoop导入mysql注:以上Hadoop指Hive、HBase、HDFS等1.2Sqo

- sqoop建表_Sqoop基础教程

weixin_39625305

sqoop建表

1,什么是Sqoop?官网定义如下:ApacheSqoop大白话理解:一个用来将数据Hdoop上的数据和结构化存储(数据库数据)实现互相传输的工具另外注意的是,上面文字最后一行,Sqoop1(1.4X)和Sqoop2(1.99X)完全不兼容,生产上建议Sqoop1,Sqoop2有点不稳定2,Sqoop的安装下载好Sqoop之后,我的是Cdh版本,sqoop-1.4.6-cdh5.16.2在Sqoo

- 报错:Sqoop2 Exception: java.lang.NoSuchMethodError Message: org.apache.hadoop.security.authentication....

weixin_30883311

大数据java

报错过程:进入sqoop2之后,输入命令:showconnector,报错报错现象:ExceptionhasoccurredduringprocessingcommandException:java.lang.NoSuchMethodErrorMessage:org.apache.hadoop.security.authentication.client.Authenticator.setConn

- 【sqoop】sqoop1和sqoop2环境安装

yang63515074

Sqoop

sqoop2版本:sqoop-1.99.6安装目录:/usr/local/sqoop参考博文https://blog.csdn.net/zhexcel/article/details/52192770https://blog.csdn.net/gamer_gyt/article/details/55225700安装步骤解压软件包tar-zxvfsqoop-1.99.6-bin-hadoop200.

- sqoop2 使用实例

iteye_17645

hadoopsqoop2

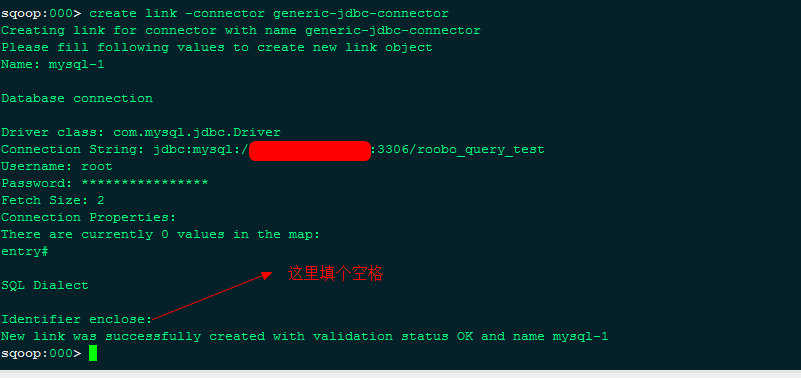

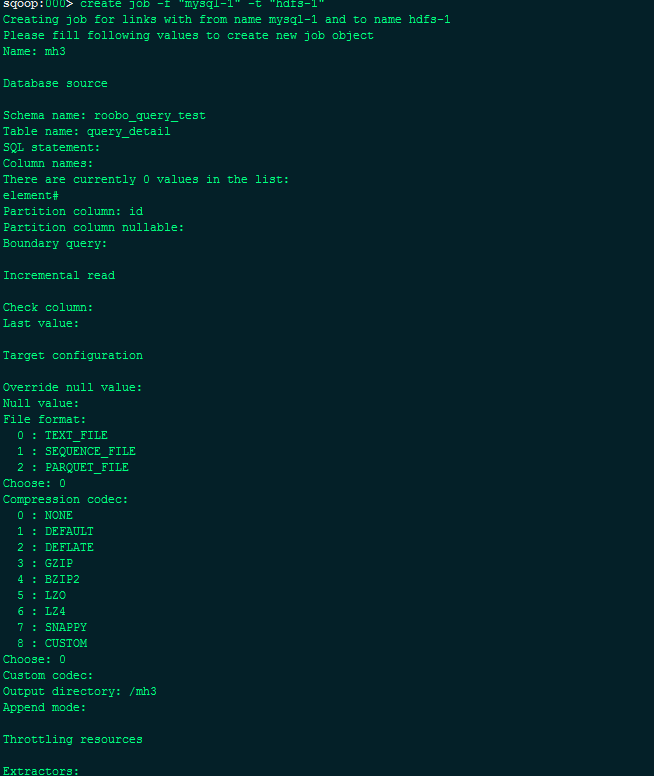

启动Client/usr/hadoop/sqoop-1.99.5-cdh5.5.1-bin-hadoop200/bin/sqoop.shclient为客户端配置服务器:setserver--hostnode3--port12000--webappsqoop【红色部分为本机hostname主机名和端口号】sqoop:000>setserver--hostnode3--port12000--webap

- HDP 2.5集成Sqoop2

风格lu

大数据分布式

前言HDP2.5默认只有Sqoop1,而sqoop1只有客户端,没有服务端,也不能通过JavaApi来进行操作,所以需要集成一下Sqoop2,其实这里我们只需要启动Sqoop2的Server端即可。环境CentOS7.xHDP2.5JDK1.8Sqoop1.99.7注:sqoop1.99.7其实就是Sqoop2配置配置很简单,下载好sqoop2后,解压到一个路径,如:/usr/lib/进入解压后的

- Alex 的 Hadoop 菜鸟教程: 第7课 Sqoop2 导入教程

javastart

大数据

Alex的Hadoop菜鸟教程:第7课Sqoop2导入教程时间2014-11-2617:13:36CSDN博客原文http://blog.csdn.net/nsrainbow/article/details/41518451主题数据库HadoopHDFS具体的安装和jdbc的驱动准备你们看第6课。现在我用一个例子讲解sqoop2的具体使用方法数据准备有一个mysql的表叫worker,里面有三条数

- JAVA中的Enum

周凡杨

javaenum枚举

Enum是计算机编程语言中的一种数据类型---枚举类型。 在实际问题中,有些变量的取值被限定在一个有限的范围内。 例如,一个星期内只有七天 我们通常这样实现上面的定义:

public String monday;

public String tuesday;

public String wensday;

public String thursday

- 赶集网mysql开发36条军规

Bill_chen

mysql业务架构设计mysql调优mysql性能优化

(一)核心军规 (1)不在数据库做运算 cpu计算务必移至业务层; (2)控制单表数据量 int型不超过1000w,含char则不超过500w; 合理分表; 限制单库表数量在300以内; (3)控制列数量 字段少而精,字段数建议在20以内

- Shell test命令

daizj

shell字符串test数字文件比较

Shell test命令

Shell中的 test 命令用于检查某个条件是否成立,它可以进行数值、字符和文件三个方面的测试。 数值测试 参数 说明 -eq 等于则为真 -ne 不等于则为真 -gt 大于则为真 -ge 大于等于则为真 -lt 小于则为真 -le 小于等于则为真

实例演示:

num1=100

num2=100if test $[num1]

- XFire框架实现WebService(二)

周凡杨

javawebservice

有了XFire框架实现WebService(一),就可以继续开发WebService的简单应用。

Webservice的服务端(WEB工程):

两个java bean类:

Course.java

package cn.com.bean;

public class Course {

private

- 重绘之画图板

朱辉辉33

画图板

上次博客讲的五子棋重绘比较简单,因为只要在重写系统重绘方法paint()时加入棋盘和棋子的绘制。这次我想说说画图板的重绘。

画图板重绘难在需要重绘的类型很多,比如说里面有矩形,园,直线之类的,所以我们要想办法将里面的图形加入一个队列中,这样在重绘时就

- Java的IO流

西蜀石兰

java

刚学Java的IO流时,被各种inputStream流弄的很迷糊,看老罗视频时说想象成插在文件上的一根管道,当初听时觉得自己很明白,可到自己用时,有不知道怎么代码了。。。

每当遇到这种问题时,我习惯性的从头开始理逻辑,会问自己一些很简单的问题,把这些简单的问题想明白了,再看代码时才不会迷糊。

IO流作用是什么?

答:实现对文件的读写,这里的文件是广义的;

Java如何实现程序到文件

- No matching PlatformTransactionManager bean found for qualifier 'add' - neither

林鹤霄

java.lang.IllegalStateException: No matching PlatformTransactionManager bean found for qualifier 'add' - neither qualifier match nor bean name match!

网上找了好多的资料没能解决,后来发现:项目中使用的是xml配置的方式配置事务,但是

- Row size too large (> 8126). Changing some columns to TEXT or BLOB

aigo

column

原文:http://stackoverflow.com/questions/15585602/change-limit-for-mysql-row-size-too-large

异常信息:

Row size too large (> 8126). Changing some columns to TEXT or BLOB or using ROW_FORMAT=DYNAM

- JS 格式化时间

alxw4616

JavaScript

/**

* 格式化时间 2013/6/13 by 半仙

[email protected]

* 需要 pad 函数

* 接收可用的时间值.

* 返回替换时间占位符后的字符串

*

* 时间占位符:年 Y 月 M 日 D 小时 h 分 m 秒 s 重复次数表示占位数

* 如 YYYY 4占4位 YY 占2位<p></p>

* MM DD hh mm

- 队列中数据的移除问题

百合不是茶

队列移除

队列的移除一般都是使用的remov();都可以移除的,但是在昨天做线程移除的时候出现了点问题,没有将遍历出来的全部移除, 代码如下;

//

package com.Thread0715.com;

import java.util.ArrayList;

public class Threa

- Runnable接口使用实例

bijian1013

javathreadRunnablejava多线程

Runnable接口

a. 该接口只有一个方法:public void run();

b. 实现该接口的类必须覆盖该run方法

c. 实现了Runnable接口的类并不具有任何天

- oracle里的extend详解

bijian1013

oracle数据库extend

扩展已知的数组空间,例:

DECLARE

TYPE CourseList IS TABLE OF VARCHAR2(10);

courses CourseList;

BEGIN

-- 初始化数组元素,大小为3

courses := CourseList('Biol 4412 ', 'Psyc 3112 ', 'Anth 3001 ');

--

- 【httpclient】httpclient发送表单POST请求

bit1129

httpclient

浏览器Form Post请求

浏览器可以通过提交表单的方式向服务器发起POST请求,这种形式的POST请求不同于一般的POST请求

1. 一般的POST请求,将请求数据放置于请求体中,服务器端以二进制流的方式读取数据,HttpServletRequest.getInputStream()。这种方式的请求可以处理任意数据形式的POST请求,比如请求数据是字符串或者是二进制数据

2. Form

- 【Hive十三】Hive读写Avro格式的数据

bit1129

hive

1. 原始数据

hive> select * from word;

OK

1 MSN

10 QQ

100 Gtalk

1000 Skype

2. 创建avro格式的数据表

hive> CREATE TABLE avro_table(age INT, name STRING)STORE

- nginx+lua+redis自动识别封解禁频繁访问IP

ronin47

在站点遇到攻击且无明显攻击特征,造成站点访问慢,nginx不断返回502等错误时,可利用nginx+lua+redis实现在指定的时间段 内,若单IP的请求量达到指定的数量后对该IP进行封禁,nginx返回403禁止访问。利用redis的expire命令设置封禁IP的过期时间达到在 指定的封禁时间后实行自动解封的目的。

一、安装环境:

CentOS x64 release 6.4(Fin

- java-二叉树的遍历-先序、中序、后序(递归和非递归)、层次遍历

bylijinnan

java

import java.util.LinkedList;

import java.util.List;

import java.util.Stack;

public class BinTreeTraverse {

//private int[] array={ 1, 2, 3, 4, 5, 6, 7, 8, 9 };

private int[] array={ 10,6,

- Spring源码学习-XML 配置方式的IoC容器启动过程分析

bylijinnan

javaspringIOC

以FileSystemXmlApplicationContext为例,把Spring IoC容器的初始化流程走一遍:

ApplicationContext context = new FileSystemXmlApplicationContext

("C:/Users/ZARA/workspace/HelloSpring/src/Beans.xml&q

- [科研与项目]民营企业请慎重参与军事科技工程

comsci

企业

军事科研工程和项目 并非要用最先进,最时髦的技术,而是要做到“万无一失”

而民营科技企业在搞科技创新工程的时候,往往考虑的是技术的先进性,而对先进技术带来的风险考虑得不够,在今天提倡军民融合发展的大环境下,这种“万无一失”和“时髦性”的矛盾会日益凸显。。。。。。所以请大家在参与任何重大的军事和政府项目之前,对

- spring 定时器-两种方式

cuityang

springquartz定时器

方式一:

间隔一定时间 运行

<bean id="updateSessionIdTask" class="com.yang.iprms.common.UpdateSessionTask" autowire="byName" />

<bean id="updateSessionIdSchedule

- 简述一下关于BroadView站点的相关设计

damoqiongqiu

view

终于弄上线了,累趴,戳这里http://www.broadview.com.cn

简述一下相关的技术点

前端:jQuery+BootStrap3.2+HandleBars,全站Ajax(貌似对SEO的影响很大啊!怎么破?),用Grunt对全部JS做了压缩处理,对部分JS和CSS做了合并(模块间存在很多依赖,全部合并比较繁琐,待完善)。

后端:U

- 运维 PHP问题汇总

dcj3sjt126com

windows2003

1、Dede(织梦)发表文章时,内容自动添加关键字显示空白页

解决方法:

后台>系统>系统基本参数>核心设置>关键字替换(是/否),这里选择“是”。

后台>系统>系统基本参数>其他选项>自动提取关键字,这里选择“是”。

2、解决PHP168超级管理员上传图片提示你的空间不足

网站是用PHP168做的,反映使用管理员在后台无法

- mac 下 安装php扩展 - mcrypt

dcj3sjt126com

PHP

MCrypt是一个功能强大的加密算法扩展库,它包括有22种算法,phpMyAdmin依赖这个PHP扩展,具体如下:

下载并解压libmcrypt-2.5.8.tar.gz。

在终端执行如下命令: tar zxvf libmcrypt-2.5.8.tar.gz cd libmcrypt-2.5.8/ ./configure --disable-posix-threads --

- MongoDB更新文档 [四]

eksliang

mongodbMongodb更新文档

MongoDB更新文档

转载请出自出处:http://eksliang.iteye.com/blog/2174104

MongoDB对文档的CURD,前面的博客简单介绍了,但是对文档更新篇幅比较大,所以这里单独拿出来。

语法结构如下:

db.collection.update( criteria, objNew, upsert, multi)

参数含义 参数

- Linux下的解压,移除,复制,查看tomcat命令

y806839048

tomcat

重复myeclipse生成webservice有问题删除以前的,干净

1、先切换到:cd usr/local/tomcat5/logs

2、tail -f catalina.out

3、这样运行时就可以实时查看运行日志了

Ctrl+c 是退出tail命令。

有问题不明的先注掉

cp /opt/tomcat-6.0.44/webapps/g

- Spring之使用事务缘由(3-XML实现)

ihuning

spring

用事务通知声明式地管理事务

事务管理是一种横切关注点。为了在 Spring 2.x 中启用声明式事务管理,可以通过 tx Schema 中定义的 <tx:advice> 元素声明事务通知,为此必须事先将这个 Schema 定义添加到 <beans> 根元素中去。声明了事务通知后,就需要将它与切入点关联起来。由于事务通知是在 <aop:

- GCD使用经验与技巧浅谈

啸笑天

GC

前言

GCD(Grand Central Dispatch)可以说是Mac、iOS开发中的一大“利器”,本文就总结一些有关使用GCD的经验与技巧。

dispatch_once_t必须是全局或static变量

这一条算是“老生常谈”了,但我认为还是有必要强调一次,毕竟非全局或非static的dispatch_once_t变量在使用时会导致非常不好排查的bug,正确的如下: 1

- linux(Ubuntu)下常用命令备忘录1

macroli

linux工作ubuntu

在使用下面的命令是可以通过--help来获取更多的信息1,查询当前目录文件列表:ls

ls命令默认状态下将按首字母升序列出你当前文件夹下面的所有内容,但这样直接运行所得到的信息也是比较少的,通常它可以结合以下这些参数运行以查询更多的信息:

ls / 显示/.下的所有文件和目录

ls -l 给出文件或者文件夹的详细信息

ls -a 显示所有文件,包括隐藏文

- nodejs同步操作mysql

qiaolevip

学习永无止境每天进步一点点mysqlnodejs

// db-util.js

var mysql = require('mysql');

var pool = mysql.createPool({

connectionLimit : 10,

host: 'localhost',

user: 'root',

password: '',

database: 'test',

port: 3306

});

- 一起学Hive系列文章

superlxw1234

hiveHive入门

[一起学Hive]系列文章 目录贴,入门Hive,持续更新中。

[一起学Hive]之一—Hive概述,Hive是什么

[一起学Hive]之二—Hive函数大全-完整版

[一起学Hive]之三—Hive中的数据库(Database)和表(Table)

[一起学Hive]之四-Hive的安装配置

[一起学Hive]之五-Hive的视图和分区

[一起学Hive

- Spring开发利器:Spring Tool Suite 3.7.0 发布

wiselyman

spring

Spring Tool Suite(简称STS)是基于Eclipse,专门针对Spring开发者提供大量的便捷功能的优秀开发工具。

在3.7.0版本主要做了如下的更新:

将eclipse版本更新至Eclipse Mars 4.5 GA

Spring Boot(JavaEE开发的颠覆者集大成者,推荐大家学习)的配置语言YAML编辑器的支持(包含自动提示,