今天我们来说一下,在Windows环境下,如何编译Hadoop1.2.1的eclipse插件。

0x00 准备工作

Eclipse、hadoop-1.2.1.tar.gz

eclipse-plugin所在目录:hadoop-1.2.1\src\contrib\eclipse-plugin

0x01 导入Eclipse工程

Import-->Existing Projects into Workspace-->Select root directory:

选中我们刚才提到的eclipse-plugin目录-->finish

然后工程就导入成功了。

0x02 修改三个配置文件

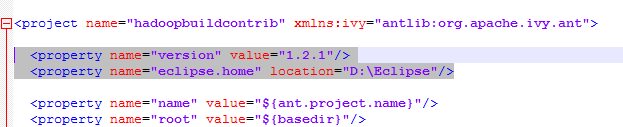

[1]build-contrib.xml (所在目录:hadoop-1.2.1\src\contrib)

添加如下高亮的两行:

注:其中location的值为eclipse所在目录

[2]build.xml (所在目录:hadoop-1.2.1\src\contrib\eclipse-plugin)

原来是有两行copy的,修改为上图高亮的六行。图好像不太清晰,我放下面了,记得加copy字段。

file="${hadoop.root}/hadoop-core-${version}.jar" tofile="${build.dir}/lib/hadoop-core.jar" verbose="true"

file="${hadoop.root}/lib/commons-configuration-${commons-configuration.version}.jar" todir="${build.dir}/lib" verbose="true"

file="${hadoop.root}/lib/commons-cli-${commons-cli.version}.jar" todir="${build.dir}/lib" verbose="true"

file="${hadoop.root}/lib/commons-lang-${commons-lang.version}.jar" todir="${build.dir}/lib" verbose="true"

file="${hadoop.root}/lib/jackson-mapper-asl-1.8.8.jar" todir="${build.dir}/lib" verbose="true"

file="${hadoop.root}/lib/jackson-core-asl-1.8.8.jar" todir="${build.dir}/lib" verbose="true"

注:主要作用是从lib目录下复制几个jar包。

[3]MANIFEST.MF (所在目录:hadoop-1.2.1\src\contrib\eclipse-plugin\META-INF)

将其中的Bundle-ClassPath改为:

Bundle-ClassPath: classes/,lib/hadoop-core.jar,/lib/commons-cli-1.2.jar,/lib/commons-configuration-1.6.jar,/lib/commons-lang-2.4.jar,/lib/jackson-core-asl-1.8.8.jar,/lib/jackson-mapper-asl-1.8.8.jar

注:Bundle-ClassPath值里面的jar包要跟我们前面在build.xml文件中配置的相同。

0x03 配置Eclipse

[1]将hadoop-1.2.1目录下的几个jar包复制到Eclipse的plugins目录下:

hadoop-ant-1.2.1.jar

hadoop-client-1.2.1.jar

hadoop-core-1.2.1.jar

hadoop-minicluster-1.2.1.jar

hadoop-tools-1.2.1.jar

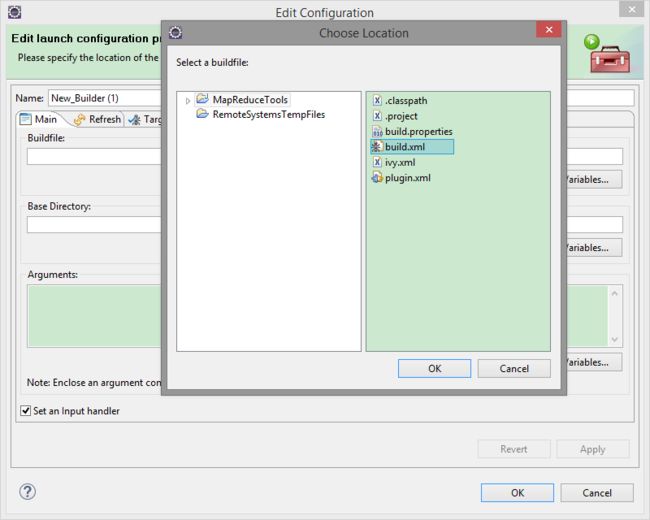

[2]Builders配置成Ant Builder

选中我们刚才导入的工程文件夹:

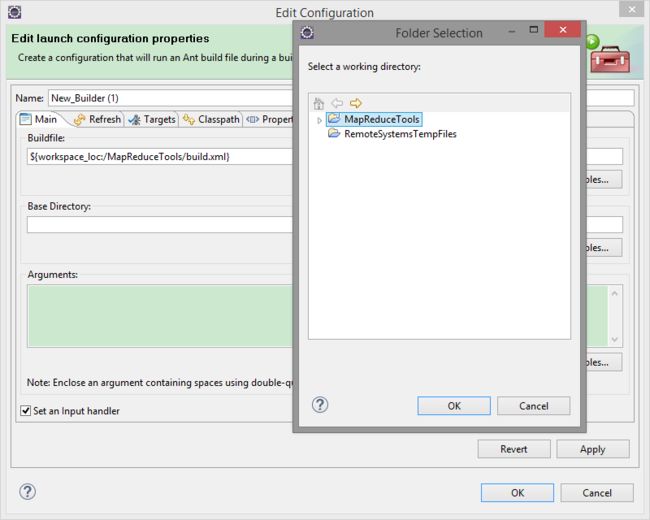

MapReduceTools-->Properties-->Builder-->取消原来打勾的,然后新建一个New-->Ant Builder

Buildfile选择我们配置的文件build.xml

Base Directory选择MapReduceTools

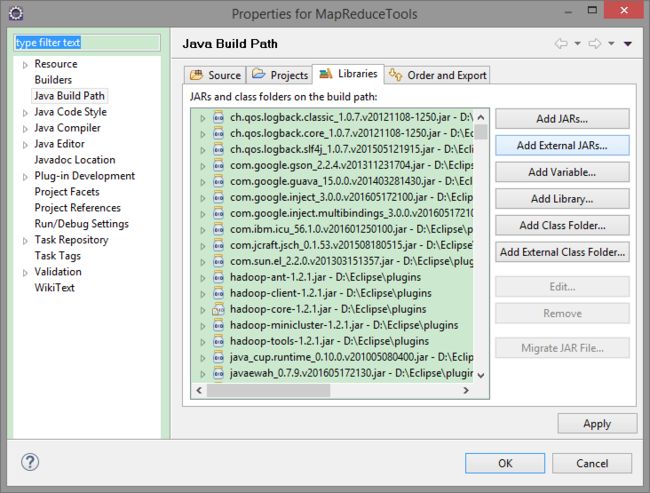

[3]配置Java Build Path

Libraries-->Add External JARs

选择Eclipse plugin目录下所有的jar包,导入。

注:由于我们刚才手动复制过hadoop-core-1.2.1.jar到plugin目录,Eclipse会报有两个jar包是一样的错误。删除其中一个就行了。

0x04 编译

上面的都配置好之后,我们就可以Build了。

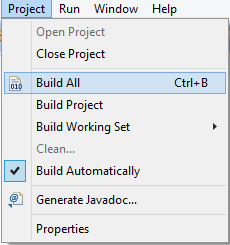

Project-->Build All

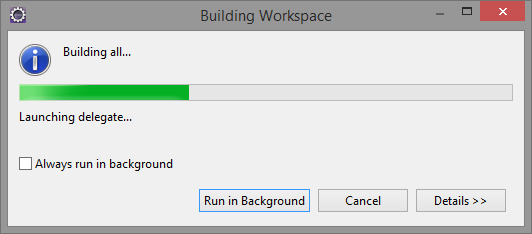

等个十几秒钟就编译好了!

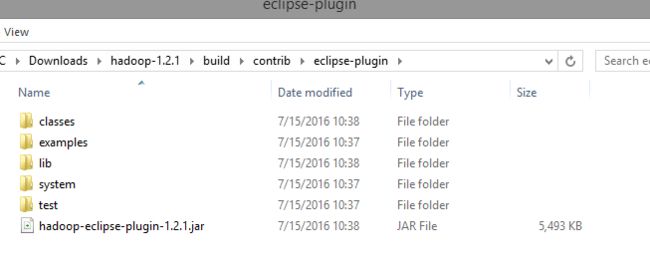

然后你就能在hadoop-1.2.1\build\contrib\eclipse-plugin目录下,看到生成的jar包了。

将这个jar拷贝到Eclipse的plugin目录下,重启Eclipse就行了!

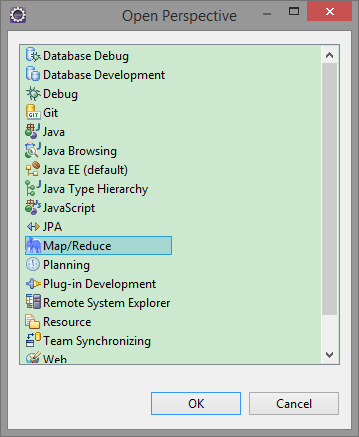

0x05 使用Eclipse连接Hadoop

hostname一栏最好写IP地址,Map/Reduce Master(就是JobTracker节点)的Port默认是9001,DFS Master(就是NameNode节点)的Port默认是9000。User name适情况而填,如果是root用户,你就填root,其他用户则填写相应的用户名。

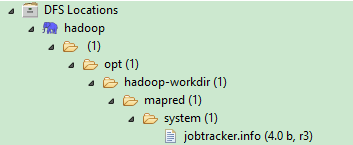

连接上的效果如下图:

注:如果连接的时候有错误,请检查以下几个部分:

1. 插件是否编译完整。(展开文件夹报An internal error occurred during: "Connecting to DFS MyHadoop".org/apache/commons/lang/StringUtils类似这样错误的,一般是你插件没有编译好,缺少了某些个jar包!请认真检查前面几个配置文件,尤其是build.xml文件中copy的那一部分!)

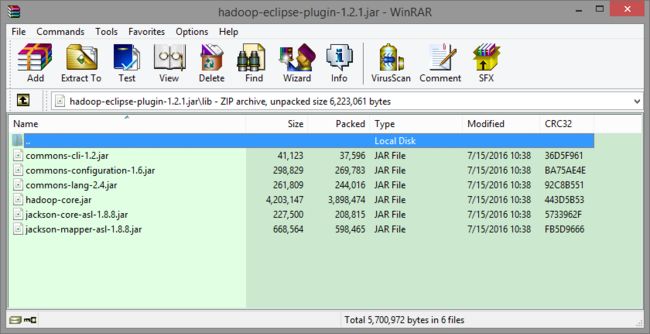

用解压软件打开那个插件的jar包,在lib目录下是有我们前面build.xml文件中copy的六个jar包的!

2. Connection Refused

类似于Error: Call to *******:9000,failed to connection exception:java.net.ConnectException:Connection refused:no further information。

首先要确认Hadoop正常运行,9000端口正常打开,并处于监听状态!

再者把Linux的防火墙关闭。

关闭Windows上的防火墙。

还是不行的话,在core-site.xml文件中的配置用IP代替其中hostname。

总之,采用排除法一步一步排除错误就好了!

3. 关于展开文件夹报Permissions错误

在hdfs-site.xml中添加个property就好了:

我在使用的过程中,暂未遇到其他错误!如果有其他错误,欢迎大家一块交流、探讨!

不足之处,请批评指正。

如有问题,请私信联系。

谢谢!