- 腾讯云技术深度探索:构建高效云原生微服务架构

我的运维人生

云原生架构腾讯云运维开发技术共享

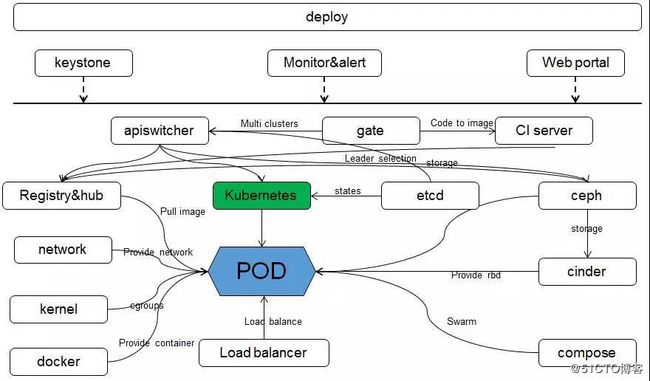

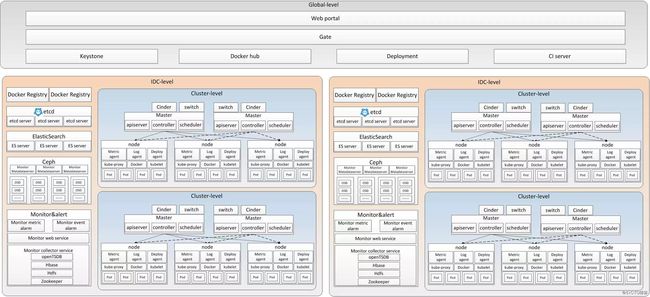

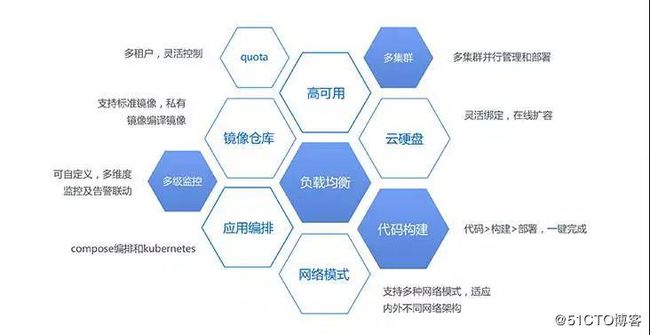

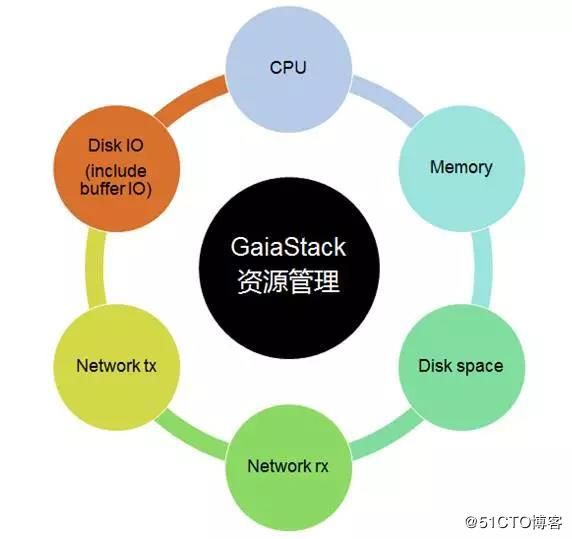

腾讯云技术深度探索:构建高效云原生微服务架构在当今快速发展的技术环境中,云原生技术已成为企业数字化转型的关键驱动力。腾讯云作为行业领先的云服务提供商,不断推出创新的产品和技术,助力企业构建高效、可扩展的云原生微服务架构。本文将深入探讨腾讯云在微服务领域的最新进展,并通过一个实际案例展示如何在腾讯云平台上构建云原生应用。腾讯云微服务架构概览腾讯云微服务架构基于云原生理念,旨在帮助企业快速实现应用的容

- 四章-32-点要素的聚合

彩云飘过

本文基于腾讯课堂老胡的课《跟我学Openlayers--基础实例详解》做的学习笔记,使用的openlayers5.3.xapi。源码见1032.html,对应的官网示例https://openlayers.org/en/latest/examples/cluster.htmlhttps://openlayers.org/en/latest/examples/earthquake-clusters.

- 一分钟学会刷牙,受用终生!

好易康

讲真,刷了十几二十年牙,没刷对过一次......来来来,划重点,更重要的是执行:①每天刷牙2次,②每次刷牙2~3分钟,③每3个月更换牙刷。最后,请使用正确的刷牙方法:巴氏(BASS)刷牙法undefined_腾讯视频视频来源ADA美国牙医协会巴氏刷牙法又称龈沟清扫法或水平颤动法。是由美国牙科协会推荐的一种有效去除龈缘附近及龈沟内菌斑的方法。刷牙不仅是刷牙齿,同时也要刷牙龈。因为口腔与细菌的战场就在

- 抱怨很廉价,别做空想家

Fang2023

今天在整理浏览器收藏夹的时候,看到一个很多年前保存的一个网页,上面是一支央视公益广告的视频,《我创故我在》。思绪一下子回到了好几年前。还记得第一次无意中在电视上看到这支广告,喜悦之情溢于言表。抱怨很廉价,别做空想家,这句歌词尤其喜欢。听着歌曲,仿佛那时候的潮气蓬勃、意气风发,又回来了,即使此时感到疲惫。【公益】央视公益广告歌曲《我创故我在》_腾讯视频

- 新能源汽车 BMS 学习笔记篇—BMS 基本定义及分类

WPG大大通

其他笔记汽车BMS经验分享新能源电池

一、BMS定义1、概念:BMS(BatteryManagementSystem)即电池管理系统,其管理对象是二次电池(充电电池或蓄电池),其主要目的是电池的利用率,防止电池出现过度充电和过度放电,可应用于电动汽车、电瓶车、机器人、无人机等图片来源:腾讯网https://new.qq.com《标准普尔警告,电动汽车电池生产面临供应链和地缘政治风险》2、四大功能①感知和测量:检测电池的电压、电流、温度

- 是“王者荣耀”还是“王者农药”?

颓废思物者

近些日子,王者又双叒叕火了。而腾讯公司的老总马化腾也跟着他的游戏在人声鼎沸的汪洋中飘荡——我最先是在公众号文章《腾讯推出游戏未保“双减双打”新措施》中看见了未成年人将减少在线时长限制,非节假日从1.5小时降低至1小时,节假日从3小时减到2小时。心中不由掀起一丝波澜:又有家长对游戏出手了。不过大家心中你知我知,在这场纷争中,必定也带着市场的挤压和变化。除去这些市场变化,我们来探讨几个问题:1.没有游

- 「鲸灵」获数千万美元B+轮融资,旗下日日团打造团购电商新时代

想想再说可以吗

小编获悉,社交电商鲸灵集团(以下简称鲸灵)已完成数千万美元B+轮融资,由启明创投领投,IDG资本联合领投,老股东跟投。鲸灵刚于7月完成数亿元B轮融资,由腾讯领投,IDG资本、险峰长青、元璟资本跟投。据小编了解,鲸灵旗下的日日团业务单日交易额已突破100万元。鲸灵创始人&CEO邬强强(花名:鬼谷)曾在阿里巴巴任职9年,曾任聚划算事业部总经理、淘宝开放平台创始人。针对本轮融资,邬强强告诉小编:“社交电

- 腾讯发表多模态综述,一文详解多模态大模型

存内计算开发者社区

多模态大模型人工智能chatgptAIGC量子计算AI-nativegptagi

多模态大语言模型(MLLM)是近年来兴起的一个新的研究热点,它利用强大的大语言模型作为大脑来执行多模态任务。MLLM令人惊讶的新兴能力,如基于图像写故事和无OCR的数学推理,在传统方法中是罕见的,这表明了一条通往人工通用智能的潜在道路。在本文中,追踪多模态大模型最新热点,讨论多模态关键技术以及现有在情绪识别上的应用。腾讯AILab发表了一篇关于多模态大模型的最新综述《MM-LLMs:RecentA

- 互联网大咖分享:三个日常生活细节决定了你能否成为一名产品经理

三不小青年

生活中的细节和习惯决定了你将来适合从事什么类型的职业乔布斯乔布斯说:“生活中的点点滴滴,在将来的某一天会不自觉的串联起来”,这句话对产品经理这个职业来说最适合不过了。互联网大咖在做分享腾讯高级产品经理在馒头商学院分享,行业型产品经理要具备三点项目思维。实际上,这需要我们在日常生活中都要养成这样的习惯。1项目化管理你的工作时间时间观念一定要强,可以按照李开复的时间管理法则,把事情按照“重要,不重要,

- 哪些网站用python开发

hakesashou

python基础知识python

国内的话,知乎,网易,腾讯,搜狐,金山,豆瓣这些属于用Python比较知名的。大型的项目的话,网易的许多游戏,腾讯的某些网站,搜狐的邮箱,金山的测试框架等等都是或多或少使用了Python。YouTube-视频分享网站,在某些功能上使用到python。Quora-社交问答网站。Google-谷歌在很多项目中用python作为网络应用的后端,如GoogleGroups、Gmail、GoogleMaps

- 电信星卡19元套餐详情(电信星卡19元流量套餐资费详情介绍)

全网优惠分享

电信星卡19元套餐详情(电信星卡19元流量套餐资费详情介绍)关注微•信•公•众•号"卡泡泡"就知道啦!首先套餐包含30GB本地流量和5GB全国通用流量,还可以选择自己的号码和归属地,非常适合有需求的用户。运气好的话,可以得到一个昵称。而且这些流量可以满足用户日常生活和工作的需求,月租也比较低,下面详细介绍。1.每月基本费用:39元,套餐内包含:30GB爱奇艺、腾讯视频、优酷视频、西瓜视频、抖音短视

- Python国内常用镜像源和使用方法

wfqlt163

Python基础操作python开发语言

常用的镜像源:1、企业镜像:豆瓣https://pypi.doubanio.com/simple/网易https://mirrors.163.com/pypi/simple/阿里云https://mirrors.aliyun.com/pypi/simple/腾讯云https://mirrors.cloud.tencent.com/pypi/simple2、高校镜像:清华大学(推荐):https:/

- 数组拷贝Arraycopy

xing2516

Arraycopyjava

packageqing;//数组拷贝publicclassArraycopy{publicstaticvoidmain(String[]args){//一维数组拷贝Stringa[]={"小米","华为","阿里","腾讯","百度"};String[]aBak=newString[6];//从a数组第0个copy到数组aBak0个开始,长度是a数组长度System.arraycopy(a,0,a

- 云服务业界动态简报-20180128

Captain7

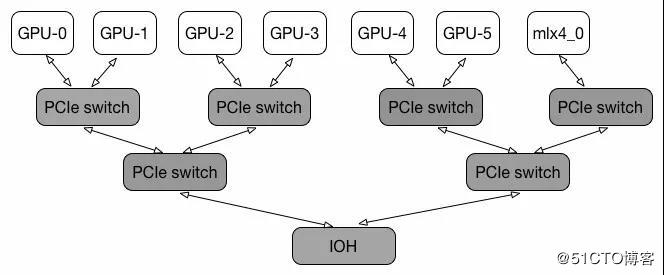

一、青云青云QingCloud推出深度学习平台DeepLearningonQingCloud,包含了主流的深度学习框架及数据科学工具包,通过QingCloudAppCenter一键部署交付,可以让算法工程师和数据科学家快速构建深度学习开发环境,将更多的精力放在模型和算法调优。二、腾讯云1.腾讯云正式发布腾讯专有云TCE(TencentCloudEnterprise)矩阵,涵盖企业版、大数据版、AI

- nginx部署前端项目的一些配置【刚入门】

weixin_30847271

运维前端ViewUI

前期准备:在linux上安装nginx,我用的是腾讯云centos7服务器,具体的安装过程可以到腾讯云的开发者实验室里体验,自己先试试水。修改nginx.conf配置文件,我用到的修改只是以下的部分。1.端口号2.项目的存放位置server{listen8088default_server;#访问的端口号。listen[::]:8088default_server;server_name_;#ro

- 地铁播报壹

星月妹妹

听歌照镜子把刘海剪坏的傻逼是我今日地铁播报:今天路上竟然没有堵车,七点三十多出门八点零几分就到了地铁站。今天下车让小灰灰亲我一下。我以前可是没有这么肉麻啊。哎呀呀。人今天还是好多。人挤人的没点点空间。站在最前面那个带珍珠耳环头发几乎都白的大妈,正在玩着消消乐,消消乐真是腾讯开发一款打发时间的游戏。上海的大妈真的好时尚,有时候还能见到六七十岁老爷爷塞耳机呢。旁边卷发女孩很年轻应该刚毕业不久,侧面看长

- 苹果的“AI茅”之路只走了一半

美股研究社

人工智能

今年苹果发布会最大的亮点,也许是和华为“撞档”,又或者是替腾讯“发布”新手游,但肯定不是iPhone16。9月10日,苹果秋季新品发布会与华为见非凡品牌盛典相继举行,iPhone16系列也与HUAWEIMateXT同日发布。不过,两大厂商的新品卖点各不相同,华为更加强调三折叠屏手机的“引领性、创新性、颠覆性”;苹果备受关注的则是苹果人工智能(AppleIntelligence)。首席执行官蒂姆·库

- 云手机虚拟服务器地址和端口,手机服务器地址端口号

粢范团

云手机虚拟服务器地址和端口

手机服务器地址端口号内容精选换一换当后台重新配置邮箱服务器等信息后,手机端WeLink一定要退出重新登录一次。我们常用的邮箱,比如:QQ邮箱、163邮箱、腾讯企业邮箱、网易企业邮箱、263企业邮箱等常见邮箱,可以参考常见问题>客户端-邮件里的“常见的IMAP邮箱配置方法”,里面有详细的配置截图。如果是企业自己的邮箱,需要联系自家企业的IT管理员,确定自家企业邮箱的服务私网NAT网关创建后,通过添加

- 腾讯2018半年报基础分析

莫莫小熊

一.基础数据季度收入同比增长30%至736亿人民币,毛利同比增长22%至344亿人民币,但环比下降7%。半年收入同比增长39%至1472亿人民币,毛利同比增长33%至714亿人民币。二.战略解析腾讯对最近几月的重大战略列举如下:1.小程序小程序生态进一步加强,重点强调与微信支付(2亿日活跃账户消费者基础)等数字工具整合,扩大功能及用途。立足于原生移动应用的补充,想象空间巨大,预计会在用户体验、企业

- 腾讯武侠手游哪些好玩?腾讯出品的武侠手游排行榜2024

会飞滴鱼儿

如今,众多游戏厂商加入竞相推出各种武侠手游大作的潮流,其中腾讯公司凭借其创新能力和品牌力,成功推出一系列高质量的武侠手游。在这里,我们将为您推荐2024年腾讯推出的最热门武侠手游,助您畅享激战江湖的快感。但由于目前很多武侠一类的手游,完全就是靠对数值来取胜,导致很多经典武侠手游,都成为了牺牲品,尤其是游戏圈中近段时间出现的一系列事件,成为了导火索,很多游戏平台出现的内部福利号成为了焦点,下满小编就

- 【2023年】云计算金砖牛刀小试4

geekgold

云计算linux容器jenkinskubernetes

容器云问题1.Kubernetes集群支持Pod优先级抢占,通过抢占式调度策略来实现同一个Node节点内部的Pod对象抢占。在master节点/root目录下编写YAML文件schedule.yaml创建一个抢占式调度策略,具体要求如下:(1)抢占式调度策略名称:high-scheduling;(2)优先级为1000000;(3)不要将该调度策略设置为默认优先调度策略。vischedule.yam

- 新年古言第一推:《嫣语赋》定档!

季月十三

无论是什么时代,自强自立的人总是会被人高看一眼。因为人总是对强者心怀敬佩,无论性别。这可能也是大男主大女主剧永不过时的原因之一吧~这不,正月初五,也就是2月5日定档的这部剧,大家一定也会感兴趣。古装小甜剧《嫣语赋》定档,是惊喜还是会被吐槽?喜欢看古装小甜剧的海外朋友们记得及时启动快帆,它会带你第一时间穿梭回国,解除腾讯视频的播放限制。一起来期待《嫣语赋》的精彩内容~《嫣语赋》由徐正溪、乔欣、刘芮麟

- 权力的游戏:凛冬将至手游,网友评论可能超过王者

夏七七wow

相信很多小伙伴都看过权力的游戏,而到第8季大结局的时候,无论是国外还是国内一片骂声,甚至还有很多的观众要求最后一季重拍,感觉这最后一季并没有画上一个完美的句号。当时已经有上百万的网友在网上签名,向团队申请重新拍摄最后一季,而就在这个时候我们的腾讯大哥站了出来向广大的网友宣布自己已经开启了手游权力的游戏凛冬将至的高级测试。当这款游戏的手游版本上线时,网友测试之后回答,这款游戏可以说是骚操作最多的游戏

- 注册阿里云新用户有什么优惠?2023年阿里云新用户最新优惠政策

阿里云最新优惠和活动汇总

不管是阿里云还是腾讯云或者华为云,这些云服务商都是非常喜欢新用户的,云服务商之间为了争取新用户,都会推出各种各样优惠政策,作为国内知名度最高的云服务商,阿里云自然会为新用户提供很多优惠政策。本文整理汇总了2023年阿里云新用户最新优惠政策,了解这些优惠政策可帮助我们在选购阿里云产品时少走很多弯路,最大化的享受优惠政策带来的福利。阿里云针对新用户的优惠,从注册账号、试用云产品、正式购买云产品等各个环

- 教你如何了解情绪、掌控情绪,成为自我沟通高手

知课ZOKO

学会思维革命,提高人生效率_腾讯视频视频老师:戴维制片人:唐|监制:唐、顾|策划:顾◆你是否常常找不到工作的动力,如陷泥潭,举步艰难?◆你是否常常被负能量所困扰,不知如何与周围人相处?◆你是否常常在沟通时词不达意,不知用什么方法敞开心扉?◆你是否常常在生活中心烦意乱,总有一股压抑堵在心头?通过能量意识进行思维革命,释放生活中的负能量,打破大脑的枷锁,开拓全新的视野,邂逅更好的自己吧!戴维老师的亲身

- 愿你心花朵朵怒放,心灵四季如春(二)

家庭教育CEO

“版权声明本文首发于腾讯QQ日志——达尔文主义Darwin请注意:无需授权即可转载;甚至无需保留以上版权声明;知识传播的越远,越有价值……”谢坤山1958年出生于台湾台东,父母都是文盲。母亲主要在家打理家务,闲时帮人做点零活,贴补家用;父亲主要是走街窜巷回收废旧物品等赚钱,家里经常吃了上顿没下顿。其父认为,除了起码的温饱外,对于让孩子接受教育是可有可无的事,因此,谢昆山小学毕业后,就被父亲安排到工

- 分享梦溪石小说《千秋》经典语录一

叽叽喳喳话人间

这部小说最近也被制作成动漫《山河剑心》,在腾讯播放。双男主、耽美、武侠小说,先表明我的立场,武侠好看、真爱难寻、无关性别,不喜勿喷。这部小说不长,大概63万字,我花了2天时间,就看完了,里面太多很有意思的台词,众所周知,老宴是个怼天怼地的骚男,今天把他和沈峤的一些对话,分享给大家。晏无师:你既已醒了,明日便上路。沈峤(无奈):我能有别的选择么?晏无师:你可以选择趁现在伤势还好,自己走;又或者我们现

- 暑期破防实录——捡漏腾讯

沈七QWQ

沈七杂谈前端程序人生面试

序经历了整整三个月的折磨,暑期实习终于尘埃落定。其实还没收到offer的时候,还会想着到时候录用了该怎么大写特写小作文,但真到了这一天,只剩下一种解脱感,一种摆脱了漫长的焦虑与压抑的淡淡喜悦。或许就像久病之人终于重获健康那样,虽然治愈了,但已然疲惫不堪。现在,我只渴望休息,去睡一个漫长而安稳的觉,能安心的赖床而不自责。不用再机械地刷新牛客动态,而不知道自己到底想要什么。原来就只是这种感觉,周围的一

- 初中级PHP面试基础汇总

PHP9年架构师

这是我整理的一套面试题,老铁们看看就当复习了哦概述感觉现在发面试题有些冷门,就跟昨天德国那场似的,不过看看当提前复习了。提前备战。这2个月出门面试的童鞋可注意不要中暑哦。10年架构师领你架构-成长之路-(附面试题(含答案))(腾讯T3-T4)打造互联网PHP架构师教程目录大全,只要你看完,薪资立马提升2倍(持续更新)点击与我交流企鹅群说几个你所知道的设计模式单例模式保证一个类仅有一个实例,并提供一

- python中括号的作用_python中中括号

weixin_39936792

python中括号的作用

广告关闭腾讯云11.11云上盛惠,精选热门产品助力上云,云服务器首年88元起,买的越多返的越多,最高返5000元!在python语言中最常见的括号有三种,分别是:小括号()、中括号:代表list列表数据类型,列表是一种可变序列。创建方法既简单又特别。3、python中的花括号{}:代表dict字典数据类型,字典是python中唯一内建的映射类型。字典中的值没有特殊的顺序,但都是存储在一个特定的键(

- 关于旗正规则引擎规则中的上传和下载问题

何必如此

文件下载压缩jsp文件上传

文件的上传下载都是数据流的输入输出,大致流程都是一样的。

一、文件打包下载

1.文件写入压缩包

string mainPath="D:\upload\"; 下载路径

string tmpfileName=jar.zip; &n

- 【Spark九十九】Spark Streaming的batch interval时间内的数据流转源码分析

bit1129

Stream

以如下代码为例(SocketInputDStream):

Spark Streaming从Socket读取数据的代码是在SocketReceiver的receive方法中,撇开异常情况不谈(Receiver有重连机制,restart方法,默认情况下在Receiver挂了之后,间隔两秒钟重新建立Socket连接),读取到的数据通过调用store(textRead)方法进行存储。数据

- spark master web ui 端口8080被占用解决方法

daizj

8080端口占用sparkmaster web ui

spark master web ui 默认端口为8080,当系统有其它程序也在使用该接口时,启动master时也不会报错,spark自己会改用其它端口,自动端口号加1,但为了可以控制到指定的端口,我们可以自行设置,修改方法:

1、cd SPARK_HOME/sbin

2、vi start-master.sh

3、定位到下面部分

- oracle_执行计划_谓词信息和数据获取

周凡杨

oracle执行计划

oracle_执行计划_谓词信息和数据获取(上)

一:简要说明

在查看执行计划的信息中,经常会看到两个谓词filter和access,它们的区别是什么,理解了这两个词对我们解读Oracle的执行计划信息会有所帮助。

简单说,执行计划如果显示是access,就表示这个谓词条件的值将会影响数据的访问路径(表还是索引),而filter表示谓词条件的值并不会影响数据访问路径,只起到

- spring中datasource配置

g21121

dataSource

datasource配置有很多种,我介绍的一种是采用c3p0的,它的百科地址是:

http://baike.baidu.com/view/920062.htm

<!-- spring加载资源文件 -->

<bean name="propertiesConfig"

class="org.springframework.b

- web报表工具FineReport使用中遇到的常见报错及解决办法(三)

老A不折腾

finereportFAQ报表软件

这里写点抛砖引玉,希望大家能把自己整理的问题及解决方法晾出来,Mark一下,利人利己。

出现问题先搜一下文档上有没有,再看看度娘有没有,再看看论坛有没有。有报错要看日志。下面简单罗列下常见的问题,大多文档上都有提到的。

1、repeated column width is largerthan paper width:

这个看这段话应该是很好理解的。比如做的模板页面宽度只能放

- mysql 用户管理

墙头上一根草

linuxmysqluser

1.新建用户 //登录MYSQL@>mysql -u root -p@>密码//创建用户mysql> insert into mysql.user(Host,User,Password) values(‘localhost’,'jeecn’,password(‘jeecn’));//刷新系统权限表mysql>flush privileges;这样就创建了一个名为:

- 关于使用Spring导致c3p0数据库死锁问题

aijuans

springSpring 入门Spring 实例Spring3Spring 教程

这个问题我实在是为整个 springsource 的员工蒙羞

如果大家使用 spring 控制事务,使用 Open Session In View 模式,

com.mchange.v2.resourcepool.TimeoutException: A client timed out while waiting to acquire a resource from com.mchange.

- 百度词库联想

annan211

百度

<!DOCTYPE html>

<html>

<head>

<meta http-equiv="Content-Type" content="text/html; charset=UTF-8">

<title>RunJS</title&g

- int数据与byte之间的相互转换实现代码

百合不是茶

位移int转bytebyte转int基本数据类型的实现

在BMP文件和文件压缩时需要用到的int与byte转换,现将理解的贴出来;

主要是要理解;位移等概念 http://baihe747.iteye.com/blog/2078029

int转byte;

byte转int;

/**

* 字节转成int,int转成字节

* @author Administrator

*

- 简单模拟实现数据库连接池

bijian1013

javathreadjava多线程简单模拟实现数据库连接池

简单模拟实现数据库连接池

实例1:

package com.bijian.thread;

public class DB {

//private static final int MAX_COUNT = 10;

private static final DB instance = new DB();

private int count = 0;

private i

- 一种基于Weblogic容器的鉴权设计

bijian1013

javaweblogic

服务器对请求的鉴权可以在请求头中加Authorization之类的key,将用户名、密码保存到此key对应的value中,当然对于用户名、密码这种高机密的信息,应该对其进行加砂加密等,最简单的方法如下:

String vuser_id = "weblogic";

String vuse

- 【RPC框架Hessian二】Hessian 对象序列化和反序列化

bit1129

hessian

任何一个对象从一个JVM传输到另一个JVM,都要经过序列化为二进制数据(或者字符串等其他格式,比如JSON),然后在反序列化为Java对象,这最后都是通过二进制的数据在不同的JVM之间传输(一般是通过Socket和二进制的数据传输),本文定义一个比较符合工作中。

1. 定义三个POJO

Person类

package com.tom.hes

- 【Hadoop十四】Hadoop提供的脚本的功能

bit1129

hadoop

1. hadoop-daemon.sh

1.1 启动HDFS

./hadoop-daemon.sh start namenode

./hadoop-daemon.sh start datanode

通过这种逐步启动的方式,比start-all.sh方式少了一个SecondaryNameNode进程,这不影响Hadoop的使用,其实在 Hadoop2.0中,SecondaryNa

- 中国互联网走在“灰度”上

ronin47

管理 灰度

中国互联网走在“灰度”上(转)

文/孕峰

第一次听说灰度这个词,是任正非说新型管理者所需要的素质。第二次听说是来自马化腾。似乎其他人包括马云也用不同的语言说过类似的意思。

灰度这个词所包含的意义和视野是广远的。要理解这个词,可能同样要用“灰度”的心态。灰度的反面,是规规矩矩,清清楚楚,泾渭分明,严谨条理,是决不妥协,不转弯,认死理。黑白分明不是灰度,像彩虹那样

- java-51-输入一个矩阵,按照从外向里以顺时针的顺序依次打印出每一个数字。

bylijinnan

java

public class PrintMatrixClockwisely {

/**

* Q51.输入一个矩阵,按照从外向里以顺时针的顺序依次打印出每一个数字。

例如:如果输入如下矩阵:

1 2 3 4

5 6 7 8

9

- mongoDB 用户管理

开窍的石头

mongoDB用户管理

1:添加用户

第一次设置用户需要进入admin数据库下设置超级用户(use admin)

db.addUsr({user:'useName',pwd:'111111',roles:[readWrite,dbAdmin]});

第一个参数用户的名字

第二个参数

- [游戏与生活]玩暗黑破坏神3的一些问题

comsci

生活

暗黑破坏神3是有史以来最让人激动的游戏。。。。但是有几个问题需要我们注意

玩这个游戏的时间,每天不要超过一个小时,且每次玩游戏最好在白天

结束游戏之后,最好在太阳下面来晒一下身上的暗黑气息,让自己恢复人的生气

&nb

- java 二维数组如何存入数据库

cuiyadll

java

using System;

using System.Linq;

using System.Text;

using System.Windows.Forms;

using System.Xml;

using System.Xml.Serialization;

using System.IO;

namespace WindowsFormsApplication1

{

- 本地事务和全局事务Local Transaction and Global Transaction(JTA)

darrenzhu

javaspringlocalglobaltransaction

Configuring Spring and JTA without full Java EE

http://spring.io/blog/2011/08/15/configuring-spring-and-jta-without-full-java-ee/

Spring doc -Transaction Management

http://docs.spring.io/spri

- Linux命令之alias - 设置命令的别名,让 Linux 命令更简练

dcj3sjt126com

linuxalias

用途说明

设置命令的别名。在linux系统中如果命令太长又不符合用户的习惯,那么我们可以为它指定一个别名。虽然可以为命令建立“链接”解决长文件名的问 题,但对于带命令行参数的命令,链接就无能为力了。而指定别名则可以解决此类所有问题【1】。常用别名来简化ssh登录【见示例三】,使长命令变短,使常 用的长命令行变短,强制执行命令时询问等。

常用参数

格式:alias

格式:ali

- yii2 restful web服务[格式响应]

dcj3sjt126com

PHPyii2

响应格式

当处理一个 RESTful API 请求时, 一个应用程序通常需要如下步骤 来处理响应格式:

确定可能影响响应格式的各种因素, 例如媒介类型, 语言, 版本, 等等。 这个过程也被称为 content negotiation。

资源对象转换为数组, 如在 Resources 部分中所描述的。 通过 [[yii\rest\Serializer]]

- MongoDB索引调优(2)——[十]

eksliang

mongodbMongoDB索引优化

转载请出自出处:http://eksliang.iteye.com/blog/2178555 一、概述

上一篇文档中也说明了,MongoDB的索引几乎与关系型数据库的索引一模一样,优化关系型数据库的技巧通用适合MongoDB,所有这里只讲MongoDB需要注意的地方 二、索引内嵌文档

可以在嵌套文档的键上建立索引,方式与正常

- 当滑动到顶部和底部时,实现Item的分离效果的ListView

gundumw100

android

拉动ListView,Item之间的间距会变大,释放后恢复原样;

package cn.tangdada.tangbang.widget;

import android.annotation.TargetApi;

import android.content.Context;

import android.content.res.TypedArray;

import andr

- 程序员用HTML5制作的爱心树表白动画

ini

JavaScriptjqueryWebhtml5css

体验效果:http://keleyi.com/keleyi/phtml/html5/31.htmHTML代码如下:

<!DOCTYPE html>

<html xmlns="http://www.w3.org/1999/xhtml"><head><meta charset="UTF-8" >

<ti

- 预装windows 8 系统GPT模式的ThinkPad T440改装64位 windows 7旗舰版

kakajw

ThinkPad预装改装windows 7windows 8

该教程具有普遍参考性,特别适用于联想的机器,其他品牌机器的处理过程也大同小异。

该教程是个人多次尝试和总结的结果,实用性强,推荐给需要的人!

缘由

小弟最近入手笔记本ThinkPad T440,但是特别不能习惯笔记本出厂预装的Windows 8系统,而且厂商自作聪明地预装了一堆没用的应用软件,消耗不少的系统资源(本本的内存为4G,系统启动完成时,物理内存占用比

- Nginx学习笔记

mcj8089

nginx

一、安装nginx 1、在nginx官方网站下载一个包,下载地址是:

http://nginx.org/download/nginx-1.4.2.tar.gz

2、WinSCP(ftp上传工

- mongodb 聚合查询每天论坛链接点击次数

qiaolevip

每天进步一点点学习永无止境mongodb纵观千象

/* 18 */

{

"_id" : ObjectId("5596414cbe4d73a327e50274"),

"msgType" : "text",

"sendTime" : ISODate("2015-07-03T08:01:16.000Z"

- java术语(PO/POJO/VO/BO/DAO/DTO)

Luob.

DAOPOJODTOpoVO BO

PO(persistant object) 持久对象

在o/r 映射的时候出现的概念,如果没有o/r映射,就没有这个概念存在了.通常对应数据模型(数据库),本身还有部分业务逻辑的处理.可以看成是与数据库中的表相映射的java对象.最简单的PO就是对应数据库中某个表中的一条记录,多个记录可以用PO的集合.PO中应该不包含任何对数据库的操作.

VO(value object) 值对象

通

- 算法复杂度

Wuaner

Algorithm

Time Complexity & Big-O:

http://stackoverflow.com/questions/487258/plain-english-explanation-of-big-o

http://bigocheatsheet.com/

http://www.sitepoint.com/time-complexity-algorithms/