手把手教你在百度aistuio训练人工智能模型

我在上文中介绍了百度的在线AI模型创建平台aistudio(博客地址:https://blog.csdn.net/BEYONDMA/article/details/101762116),我们知道深度学习的入门一个最大的门槛就是搭建编程环境,今天我们就来用aistio我们就来训练第一个人工智能模型。

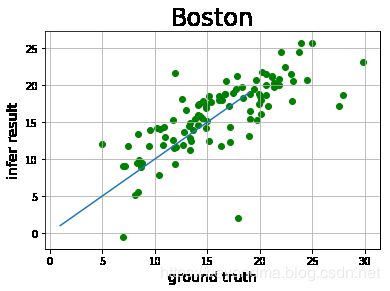

波士顿房价预测

其实波士顿房价本来非常具有代表意义,他是《Deep learning with keras》中的第一个例程,堪称深度学习界的hello world学习明白了这个也就是基本入门了人工智能,而本文就来介绍一下如何这个模型是如何训练又是如何被预测的。

一、我们有哪些数据我们可以看到训练数据包含404个点,每个数据点包含13个特征。

这些特征包括:

1.人均犯罪率

2.在25000平方英尺上住房的比例

3.每个镇上平均的非零售企业比例

4.是否为查尔斯河景房(= 1代表就在河边; 0则代表非河景))

5.一氧化氮的浓度,单位是千万分之一

6.每个住所的平均房间数

7.1940年以前自己修的建筑比例

8.到波士顿五个就业中心的加权距离

9.到公路适应性指标

10.每10000的税率的完全价值

11.镇上的学生-老师比例

12.黑人人口的比例(这一域在sklearn的数据集中已经删除了,不过依旧保留在了某它框架中)

12低地位人口比例

我们接下来要做的就是从这些点学习到相应的模型来预测波士顿其它地方的房价,这里首先我们先对于一些基本概念进行说明。

假设函数:本项目只是一个机器学习的入门,所以我倍用线性模型进行回归预测,也就是我们的假设函数为 Y’= wX+b ,其中,Y’表示模型的预测结果(预测房价),用来和真实的Y区分。模型要学习的参数即:w,b。

损失函数:假如函数预测的结果Y’与真实值Y之间的误差。这个差距越小预测越准确,而人工智能模型,本质上就是一个不断修正参数w,b,使预测值Y’尽可能地接近真实值Y。这个实值通常用来反映模型误差的大小。对于线性模型来讲,最常用的损失函数就是均方误差。

优化算法:模型训练其实等价于调整参数使得损失函数值不断变小的过程所以,优化算法就是微调变量w和b的算法,一般我们采用的优化算法有随机梯度下降法(SGD)、Adam算法等等

接下来我们就进入代码的环节了:

1.载入相应包,读入数据,代码及注释如下:

import paddle.fluid as fluid

import paddle

import numpy as np

import os

import matplotlib.pyplot as plt

BUF_SIZE=500

BATCH_SIZE=20

#用于训练的数据提供器,每次从缓存中随机读取批次大小的数据

train_reader = paddle.batch(

paddle.reader.shuffle(paddle.dataset.uci_housing.train(),

buf_size=BUF_SIZE),

batch_size=BATCH_SIZE)

#用于测试的数据提供器,每次从缓存中随机读取批次大小的数据

test_reader = paddle.batch(

paddle.reader.shuffle(paddle.dataset.uci_housing.test(),

buf_size=BUF_SIZE),

batch_size=BATCH_SIZE) 2.训练前的准备,其代码及注释如下:

train_data=paddle.dataset.uci_housing.train();

sampledata=next(train_data())

print(sampledata)

#定义张量变量x,表示13维的特征值

x = fluid.layers.data(name='x', shape=[13], dtype='float32')

#定义张量y,表示目标值

y = fluid.layers.data(name='y', shape=[1], dtype='float32')

#定义一个简单的线性网络,连接输入和输出的全连接层

#input:输入tensor;

#size:该层输出单元的数目

#act:激活函数

y_predict=fluid.layers.fc(input=x,size=1,act=None)

cost = fluid.layers.square_error_cost(input=y_predict, label=y) #求一个batch的损失值

avg_cost = fluid.layers.mean(cost) #对损失值求平均值

optimizer = fluid.optimizer.SGDOptimizer(learning_rate=0.1)

opts = optimizer.minimize(avg_cost)

place = fluid.CPUPlace() #定义运算场所为cpu

exe = fluid.Executor(place) #创建一个Executor实例exe

exe.run(fluid.default_startup_program()) #Executor的run()方法执行startup_program(),进行参数初始化

# 定义输入数据维度

feeder = fluid.DataFeeder(place=place, feed_list=[x, y])#feed_list:向模型输入的变量表或变量表名

iter=0;

iters=[]

train_costs=[]

#绘制训练进程函数

def draw_train_process(iters,train_costs):

title="training cost"

plt.title(title, fontsize=24)

plt.xlabel("iter", fontsize=14)

plt.ylabel("cost", fontsize=14)

plt.plot(iters, train_costs,color='red',label='training cost')

plt.grid()

plt.show()3.训练模型

EPOCH_NUM=10

model_save_dir = "/home/aistudio/data/fit_a_line.inference.model"

for pass_id in range(EPOCH_NUM): #训练EPOCH_NUM轮

# 开始训练并输出最后一个batch的损失值

train_cost = 0

for batch_id, data in enumerate(train_reader()): #遍历train_reader迭代器

train_cost = exe.run(program=fluid.default_main_program(),#运行主程序

feed=feeder.feed(data), #喂入一个batch的训练数据,根据feed_list和data提供的信息,将输入数据转成一种特殊的数据结构

fetch_list=[avg_cost])

print("Pass:%d, Cost:%0.5f" % (pass_id, train_cost[0][0])) #打印最后一个batch的损失值

iter=iter+BATCH_SIZE

iters.append(iter)

train_costs.append(train_cost[0][0])

# 开始测试并输出最后一个batch的损失值

test_cost = 0

for batch_id, data in enumerate(test_reader()): #遍历test_reader迭代器

test_cost = exe.run(program=fluid.default_main_program(), #运行测试cheng

feed=feeder.feed(data), #喂入一个batch的测试数据

fetch_list=[avg_cost]) #fetch均方误差

print('Test:%d, Cost:%0.5f' % (pass_id, test_cost[0][0])) #打印最后一个batch的损失值

#保存模型

# 如果保存路径不存在就创建

if not os.path.exists(model_save_dir):

os.makedirs(model_save_dir)

print ('save models to %s' % (model_save_dir))

#保存训练参数到指定路径中,构建一个专门用预测的program

fluid.io.save_inference_model(model_save_dir, #保存推理model的路径

['x'], #推理(inference)需要 feed 的数据

[y_predict], #保存推理(inference)结果的 Variables

exe) #exe 保存 inference model

draw_train_process(iters,train_costs)

infer_exe = fluid.Executor(place) #创建推测用的executor

inference_scope = fluid.core.Scope() #Scope指定作用域

infer_results=[]

groud_truths=[]

#绘制真实值和预测值对比图

def draw_infer_result(groud_truths,infer_results):

title='Boston'

plt.title(title, fontsize=24)

x = np.arange(1,20)

y = x

plt.plot(x, y)

plt.xlabel('ground truth', fontsize=14)

plt.ylabel('infer result', fontsize=14)

plt.scatter(groud_truths, infer_results,color='green',label='training cost')

plt.grid()

plt.show()4.预测模型

model_save_dir = "/home/aistudio/data/fit_a_line.inference.model"

with fluid.scope_guard(inference_scope):#修改全局/默认作用域(scope), 运行时中的所有变量都将分配给新的scope。

#从指定目录中加载 推理model(inference model)

[inference_program,feed_target_names,fetch_targets] = fluid.io.load_inference_model(#fetch_targets: 推断结果

model_save_dir, #model_save_dir:模型训练路径

infer_exe) #infer_exe: 预测用executor

#获取预测数据

infer_reader = paddle.batch(paddle.dataset.uci_housing.test(), #获取uci_housing的测试数据

batch_size=200) #从测试数据中读取一个大小为10的batch数据

#从test_reader中分割x

test_data = next(infer_reader())

test_x = np.array([data[0] for data in test_data]).astype("float32")

test_y= np.array([data[1] for data in test_data]).astype("float32")

results = infer_exe.run(inference_program, #预测模型

feed={feed_target_names[0]: np.array(test_x)}, #喂入要预测的x值

fetch_list=fetch_targets) #得到推测结果

print("infer results: (House Price)")

for idx, val in enumerate(results[0]):

print("%d: %.2f" % (idx, val))

infer_results.append(val)

print("ground truth:")

for idx, val in enumerate(test_y):

print("%d: %.2f" % (idx, val))

groud_truths.append(val)

draw_infer_result(groud_truths,infer_results)

from openpyxl import load_workbook

wb = load_workbook(filename = 'work/Top250.xlsx')

sheet_ranges = wb['Top250']

#将第一列的前几行打印出来

for i in range (1,8):

print(sheet_ranges['A'+i.__str__()].value)

#如果没有问题, 就将该工作表转为dataframe格式

df = DataFrame(sheet_ranges.values)将上述代码合并在一起执行即可,我们可以看到训练的过程

并得到最终的预测结果和实际的比对

用aistudio最大的方便之处在于不需要自己搭建任何python及深度学习的开发环境,全部都是准备好的,而且现在也还免费,所以大家完全可以趁十一,赶快用过来。