Kaggle入门:Digit Recognizer

Kaggle入门:Digit Recognizer

数据是经典的lecun大神的mnist手写数字数据集。

一、下载数据

数据格式和lecun网站的数据格式有所不同,这里所给的数据为csv格式每一张数字图片为28*28像素的灰度图,文件每一行代表756个像素点。

二、数据读取

这里使用pandas库读取数据, 由于灰度图像像素值在0-255之间,所以将其转化为uint8类型。

mnist.py

import pandas as pd

import numpy as np

train_data_file = 'train.csv'

test_data_file = 'test.csv'

train_data = pd.read_csv(train_data_file).as_matrix().astype(np.uint8)

test_data = pd.read_csv(test_data_file).as_matrix().astype(np.uint8)

def extract_images_and_labels(dataset, validation = False):

#需要将数据转化为[image_num, x, y, depth]格式

images = dataset[:, 1:].reshape(-1, 28, 28, 1)

#由于label为0~9,将其转化为一个向量.如将0 转换为 [1,0,0,0,0,0,0,0,0,0]

labels_dense = dataset[:, 0]

num_labels = labels_dense.shape[0]

index_offset = np.arange(num_labels) * 10

labels_one_hot = np.zeros((num_labels, 10))

labels_one_hot.flat[index_offset + labels_dense.ravel()] = 1

if validation:

num_images = images.shape[0]

divider = num_images - 200

return images[:divider], labels_one_hot[:divider], images[divider+1:], labels_one_hot[divider+1:]

else:

return images, labels_one_hot

def extract_images(dataset):

return dataset.reshape(-1, 28*28)

train_images, train_labels, val_images, val_labels = extract_images_and_labels(train_data, validation=True)

test_images = extract_images(test_data)

这里使用tensorflow库中的DataSet类,将images与labels传入生成DataSet对象,该对象可以直接生成mini-batch便于后续训练数据集。

train = DataSet(train_images,

train_labels,

dtype = np.float32,

reshape = True)

validation = DataSet(val_images,

val_labels,

dtype = np.float32,

reshape = True)

test = test_imagestrain,validation,test分别保存训练、交叉验证、测试数据集

三、训练数据

这里可以参考tensorflow mnist数据集教程

Deep MNIST for Experts

train.py:

import tensorflow as tf

from mnist import train, validation, test

"""为了创建这个模型,我们需要创建大量的权重和偏置项。这个模型中的权重在初始化时应该加入少量的噪声来打破对称性以及避免0梯度。

由于我们使用的是ReLU神经元,因此比较好的做法是用一个较小的正数来初始化偏置项,以避免神经元节点输出恒为0的问题(dead neurons)。

为了不在建立模型的时候反复做初始化操作,我们定义两个函数用于初始化。"""

def weight_variable(shape):

initial = tf.truncated_normal(shape, stddev=0.1)

return tf.Variable(initial)

def bias_variable(shape):

initial = tf.constant(0.1,shape=shape)

return tf.Variable(initial)

"""TensorFlow在卷积和池化上有很强的灵活性。我们怎么处理边界?步长应该设多大?在这个实例里,我们会一直使用vanilla版本。

我们的卷积使用1步长(stride size),0边距(padding size)的模板,保证输出和输入是同一个大小。

我们的池化用简单传统的2x2大小的模板做max pooling。为了代码更简洁,我们把这部分抽象成一个函数。"""

def conv2d(x,W):

return tf.nn.conv2d(x,W,strides=[1,1,1,1],padding='SAME')

def max_pool_2x2(x):

return tf.nn.max_pool(x,ksize=[1,2,2,1], strides=[1,2,2,1],padding='SAME')

"""

测试数据时feed全部数据可能会造成Out of memory 异常,这里将test集拆解为mini-batch

"""

def get_batchs(data, batch_size):

size = data.shape[0]

for i in range(size//batch_size):

if (i+1)*batch_size > size:

yield data[i*batch_size:]

else:

yield data[i*batch_size:(i+1)*batch_size]

x = tf.placeholder(tf.float32, shape=[None, 784])

y_ = tf.placeholder(tf.float32, shape=[None, 10])

"""

现在我们可以开始实现第一层了。它由一个卷积接一个max pooling完成。

卷积在每个5x5的patch中算出32个特征。

卷积的权重张量形状是[5, 5, 1, 32],前两个维度是patch的大小,接着是输入的通道数目,最后是输出的通道数目。

而对于每一个输出通道都有一个对应的偏置量。

"""

W_conv1 = weight_variable([5,5,1,32])

b_conv1 = bias_variable([32])

"""为了用这一层,我们把x变成一个4d向量,其第2、第3维对应图片的宽、高,最后一维代表图片的颜色通道数(因为是灰度图所以这里的通道数为1,如果是rgb彩色图,则为3)。"""

x_image = tf.reshape(x, [-1,28,28,1])

"""我们把x_image和权值向量进行卷积,加上偏置项,然后应用ReLU激活函数,最后进行max pooling。"""

h_conv1 = tf.nn.relu(conv2d(x_image, W_conv1) + b_conv1)

h_pool1 = max_pool_2x2(h_conv1)

"""为了构建一个更深的网络,我们会把几个类似的层堆叠起来。第二层中,每个5x5的patch会得到64个特征。"""

W_conv2 = weight_variable([5,5,32,64])

b_conv2 = bias_variable([64])

h_conv2 = tf.nn.relu(conv2d(h_pool1, W_conv2) + b_conv2)

h_pool2 = max_pool_2x2(h_conv2)

"""

全连接层

现在,图片尺寸减小到7x7,我们加入一个有1024个神经元的全连接层,用于处理整个图片。我们把池化层输出的张量reshape成一些向量,乘上权重矩阵,加上偏置,然后对其使用ReLU。

"""

W_fc1 = weight_variable([7*7*64, 1024])

b_fc1 = bias_variable([1024])

h_pool2_flat = tf.reshape(h_pool2, [-1, 7*7*64])

h_fc1 = tf.nn.relu(tf.matmul(h_pool2_flat, W_fc1) + b_fc1)

"""

为了减少过拟合,我们在输出层之前加入dropout。我们用一个placeholder来代表一个神经元的输出在dropout中保持不变的概率。

这样我们可以在训练过程中启用dropout,在测试过程中关闭dropout

。 TensorFlow的tf.nn.dropout操作除了可以屏蔽神经元的输出外,还会自动处理神经元输出值的scale。

所以用dropout的时候可以不用考虑scale。

"""

keep_prob = tf.placeholder(tf.float32)

h_fc1_drop = tf.nn.dropout(h_fc1, keep_prob)

"""

输出层

最后,我们添加一个softmax层,就像前面的单层softmax regression一样。

"""

W_fc2 = weight_variable([1024, 10])

b_fc2 = bias_variable([10])

y_conv = tf.matmul(h_fc1_drop, W_fc2) + b_fc2

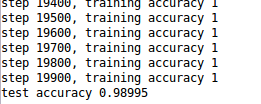

"""

为了进行训练和评估,在feed_dict中加入额外的参数keep_prob来控制dropout比例。然后每100次迭代输出一次日志。

"""

cross_entropy = tf.reduce_mean(

tf.nn.softmax_cross_entropy_with_logits(labels=y_, logits=y_conv))

train_step = tf.train.AdamOptimizer(1e-4).minimize(cross_entropy)

correct_prediction = tf.equal(tf.argmax(y_conv,1), tf.argmax(y_,1))

accuracy = tf.reduce_mean(tf.cast(correct_prediction, tf.float32))

sess = tf.InteractiveSession()

sess.run(tf.global_variables_initializer())

for i in range(20000):

batch = train.next_batch(50)

if i%100 == 0:

train_accuracy = accuracy.eval(feed_dict={

x:batch[0], y_: batch[1], keep_prob: 1.0})

print("step %d, training accuracy %g"%(i, train_accuracy))

train_step.run(feed_dict={x: batch[0], y_: batch[1], keep_prob: 0.5})

print("test accuracy %g"%accuracy.eval(feed_dict={

x: validation.images, y_: validation.labels, keep_prob: 1.0}))

由于测试集没有标签,只有images,将test结果写入prediction.csv,格式参考sample_submission.txt

"""

输出我们预测的测试集标签

"""

f = open('prediction.txt', 'w+')

f.write('ImageId,Label\n')

batchs = get_batchs(test, 50)

i = 1

for test_image in batchs:

prediction = tf.argmax(y_conv, 1)

test_labels = prediction.eval(feed_dict={x: test_image, keep_prob: 1.0})

for label in test_labels:

f.write(str(i) + ',' +str(label) + '\n')

i += 1

f.close()四、提交结果到kaggle

代码可以从我的github中找到。

Kaggle-DigitRecognizer