谷歌发布轻量级视觉架构MobileNetV2,速度快准确率高

林鳞 编译自 Google Research Blog

量子位 出品 | 公众号 QbitAI

深度学习在移动端部署的挑战仍在。

虽然深度学习在图像分类、检测等任务上颇具优势,但提升模型精度对能耗和存储空间的要求很高,移动设备通常难以达到要求。

别怕。昨天,谷歌发布了新一代移动架构MobileNetV2。

这是一种为移动设备设计的通用计算机视觉神经网络,支持图像分类和检测等任务,结果比上一代模型有显著提升。在个人移动设备上运行深度网络能时能提升体验,让用户能在任何时间和地点进行访问,在安全、隐私和能耗上还有额外优势。

新特性

基于去年发布的MobileNetV1的构建思路,新模型将深度可分离的卷积作为有效构建模块。在架构上,MobileNetV2引入了两个新特性:一是层与层之间的线性瓶颈(linear bottlenecks),二是瓶颈之间的快捷连接。基本结构如下图所示:

△ MobileNetV2架构概览 | 蓝色块表示复合卷积架构模块

△ MobileNetV2架构概览 | 蓝色块表示复合卷积架构模块

性能增强

总体来说,MobileNetV2能以更快的速度达到与V1相同的精度。

尤其值得注意的是,新模型减少了一半运算,所需参数减少30%,在谷歌Pixel手机上速度比MobileNetV1快了30-40%,同时实现了更高的精度。

△ MobileNetV2提高了速度(降低了延迟)并增加了ImageNet的Top 1的精度

△ MobileNetV2提高了速度(降低了延迟)并增加了ImageNet的Top 1的精度

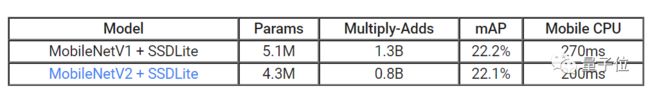

在对象检测和分割任务中,MobileNetV2是种非常有效的特征提取器。例如当与新引入的SSDLite配对时,达到与MobileNetV1相同准确度时速度快了35%。目前研究人员已经在Tensorflow对象检测API下开放了这个模型。

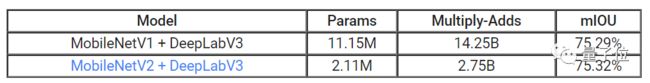

为了实现设备上的语义分割,研究人员将MobileNetV2作为一个特征提取器,简化了用移动语义分割模型DeepLabv3构建新的Mobile DeepLabv3的过程。

在语义分割基准上,PASCAL VOC 2012结果模型达到与使用MobileNetV1作为特征提取器相似的性能,但所需参数减少了5.3倍,所需运算减少了5.2倍。

总体来说,MobileNetV2提供了一个高效的移动导向模型,可作为许多视觉识别任务的基础。

资源下载

目前,MobileNetV2作为TensorFlow-Slim图像分类库的一部分发布,用户也可在Colaboratory中开始探索使用。

此外,MobileNetV2也可作为TF-Hub上的模块,能在GitHub中找到预先训练的检查点。

官方博客介绍:

https://research.googleblog.com/2018/04/mobilenetv2-next-generation-of-on.html

相关论文:

https://128.84.21.199/abs/1801.04381

代码地址:

https://github.com/tensorflow/models/tree/master/research/slim/nets/mobilenet

TensorFlow-Slim图像分类库:

https://github.com/tensorflow/models/blob/master/research/slim/README.md

Colaboratory地址:

https://colab.research.google.com/github/tensorflow/models/blob/master/research/slim/nets/mobilenet/mobilenet_example.ipynb

作者系网易新闻·网易号“各有态度”签约作者

— 完 —

活动报名

加入社群

量子位AI社群15群开始招募啦,欢迎对AI感兴趣的同学,加小助手微信qbitbot6入群;

此外,量子位专业细分群(自动驾驶、CV、NLP、机器学习等)正在招募,面向正在从事相关领域的工程师及研究人员。

进群请加小助手微信号qbitbot6,并务必备注相应群的关键词~通过审核后我们将邀请进群。(专业群审核较严,敬请谅解)

诚挚招聘

量子位正在招募编辑/记者,工作地点在北京中关村。期待有才气、有热情的同学加入我们!相关细节,请在量子位公众号(QbitAI)对话界面,回复“招聘”两个字。

量子位 QbitAI · 头条号签约作者

վ'ᴗ' ի 追踪AI技术和产品新动态